長視頻生成再突破!高質量連貫達600幀 | ConFiner:專家鏈加持的免訓練長視頻生成器

論文鏈接:https://arxiv.org/pdf/2408.13423

git鏈接:???https://github.com/Confiner2025/Confiner2025??

亮點直擊

- 創新性解耦策略:ConFiner框架通過將視頻生成任務解耦為三個獨立的子任務,顯著優化了生成過程。該方法利用了三種現有的擴散模型專家,每個專家專注于一個特定的任務,從而降低了模型的計算負擔,同時提升了生成的質量與速度。

- 協調去噪技術:該技術在視頻生成過程中引入了協作機制,使得使用不同噪聲調度器的兩個專家能夠實現逐步協作,有效提升了視頻生成的精細度與一致性。

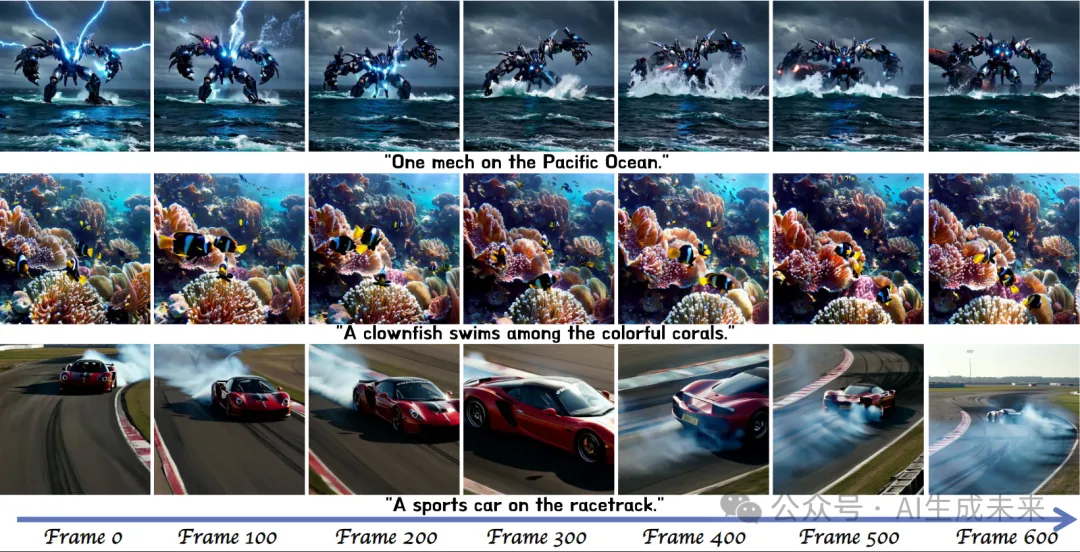

- 長視頻生成突破:在ConFiner框架基礎上,ConFiner-Long通過三種策略實現了高質量、連貫的長視頻生成。該框架能夠生成長達600幀的連貫視頻,標志著長視頻生成技術的顯著進步。

效果一覽

解決的問題

- 視頻生成質量低:難以同時實現高質量的時間和空間建模。

- 生成過程耗時:通常需要數百次推理步驟,時間成本較高。

- 生成視頻長度短:由于VRAM限制,生成視頻的長度通常只有2-3秒。

- 模型負擔重:單一模型處理復雜的多維度視頻生成任務,難以兼顧所有需求。

提出的方案

- ConFiner框架:將視頻生成任務解耦為三個子任務(結構控制、時間細化和空間細化),并使用三個專門的擴散模型專家分別處理這些任務。

- ConFiner-Long框架:在ConFiner基礎上引入三種策略(片段一致性初始化、一致性引導、交錯細化)以生成更長的連貫視頻。

應用的技術

- 協調去噪技術:解決不同擴散模型之間噪聲調度器不一致的問題,使空間和時間專家能夠協同工作。

- 片段一致性初始化:通過共享基礎噪聲,確保不同視頻片段初始噪聲的一致性。

- 一致性引導策略:利用片段間的噪聲差異梯度引導去噪方向,增強去噪的一致性。

- 交錯細化策略:在片段交界處將控制階段和細化階段交錯處理,避免片段拼接處的閃爍問題。

達到的效果

- 提高視頻生成質量:通過將任務分解并交給專門模型處理,減少了單一模型的負擔,提高了生成的質量。

- 加快生成速度:ConFiner框架只需9次采樣步驟即可超越其他模型在100次采樣中的表現,生成時間顯著減少。

- 生成更長的視頻:ConFiner-Long框架能生成長達600幀的高質量且連貫的視頻片段。

- 無需額外訓練成本:利用現成的擴散模型專家,不需要額外的訓練成本。

方法

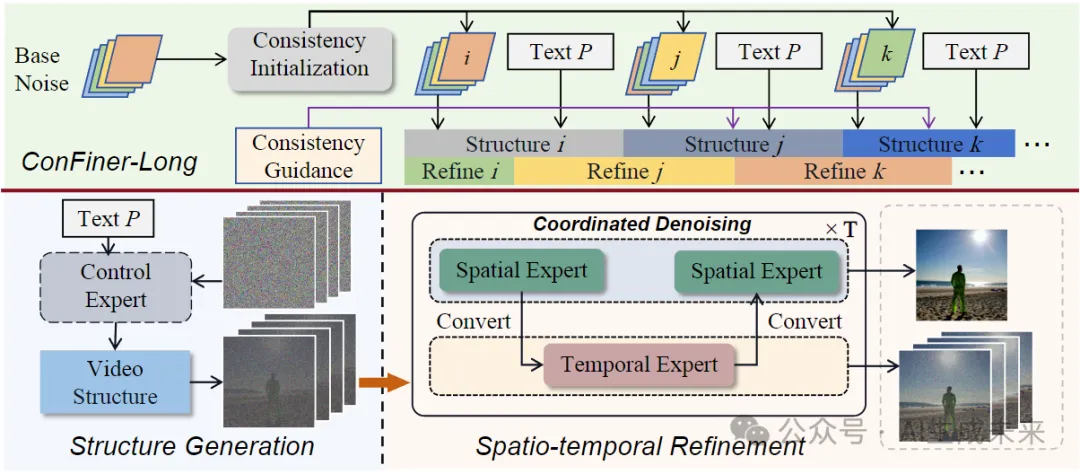

ConFiner由兩個階段組成:控制階段和精煉階段。在控制階段,它生成一個包含粗粒度時空信息的視頻結構,該結構決定了最終視頻的整體結構和情節。在細化階段,它根據視頻結構細化空間和時間細節。在這個階段,作者提出了協調去噪,以實現空間專家和時間專家的合作。基于ConFiner,引入了ConFiner Long框架,用于制作連貫一致的長視頻。

ConFiner和ConFiner Long的pineline見下圖:

ConFiner 框架

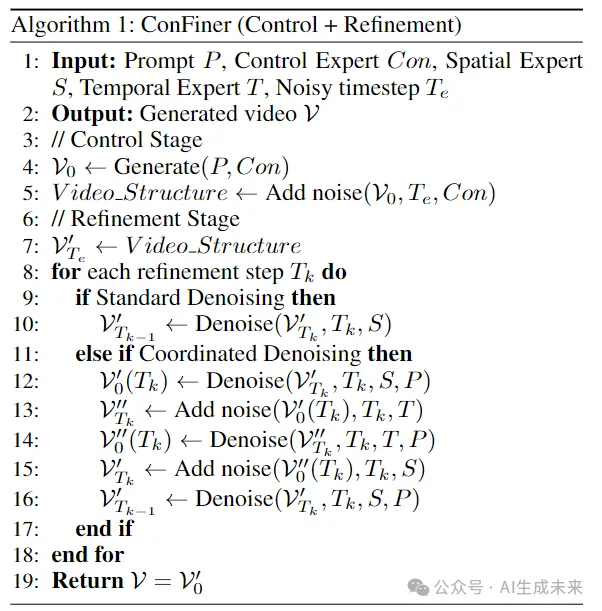

ConFiner將視頻生成過程解耦。首先,控制專家生成視頻結構。隨后,時間和空間專家對時空細節進行了細化。空間和時間專家在細化階段與我們的協調去噪合作。具體算法如下:

ConFiner-Long 框架

- 一致性初始化策略:

- 設計一致性初始化策略來提高視頻片段之間的一致性。首先采樣一個基礎噪聲 ,然后對其進行幀級打亂,以獲得每個片段的初始噪聲。共享基礎噪聲有助于提高片段之間的一致性,同時打亂操作保持了一定的隨機性。

- 交錯細化機制:

- 在生成長視頻時,采用交錯的控制階段和細化階段處理方法。具體來說,將前一個視頻片段的后半部分與下一個片段的前半部分作為同一次細化處理的輸入,從而實現更自然的片段過渡。這種方法有助于減少過渡處的斷裂感。

- 一致性引導機制:

- 引入一致性引導機制來促進生成內容與前一個片段的一致性。在視頻片段的采樣過程中,利用L2損失的梯度來引導采樣方向。L2損失計算當前片段噪聲與前一個片段噪聲之間的差異,并通過調整噪聲預測來提高片段間的一致性。

總結而言,這些方法通過空間和時間專家的交替處理和一致性策略,旨在提高視頻生成的質量和一致性,特別是在長視頻生成過程中,確保了視頻片段之間的平滑過渡和連貫性。

快來看,ConFiner Long方法僅用9個推理步驟生成的視頻:

實驗

效果對比

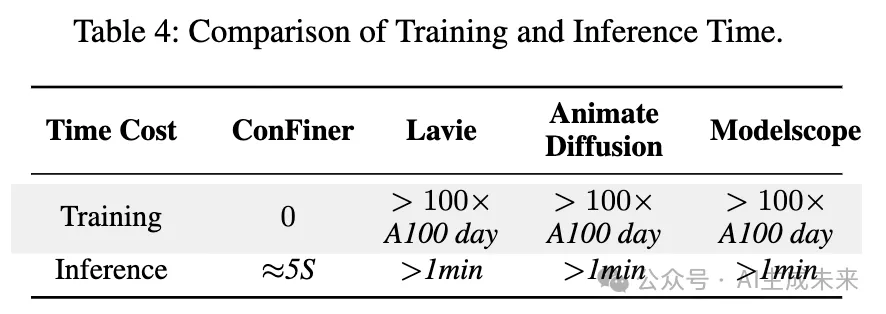

ConFiner 與其他視頻擴散模型的訓練和推理成本。結果展示在下表 4 中。

研究者們使用了 AnimateDiff-Lightning 作為控制專家,Stable Diffusion 1.5作為空間專家。Lavie和 Modelscope兩個開源模型為時間專家。

客觀評價

作者使用了前沿基準測試工具 Vbench在客觀評價實驗中。Vbench 提供了 800 個提示,用于測試視頻生成模型的各種能力。在我們的實驗中,每個模型生成了 800 個視頻,并使用四個指標評估視頻的時間質量和逐幀質量。

- 時間質量指標:主觀一致性(Subject Consistency)和運動平滑度(Motion Smoothness)。

- 逐幀質量指標:美學質量(Aesthetic Quality)和成像質量(Imaging Quality)。

使用了 AnimateDiff-Lightning、Lavie 和 Modelscope T2V,分別生成了 10、20、50 和 100 步的總時間步數的視頻。然后,使用 ConFiner 進行生成,設置為 9(4+5)步和 18(8+10)步,其中 Te 設置為 100。所有評價結果展示在表 1 中。每個實驗在單個 RTX 4090 上可以完成,耗時 3-5 小時。每個實驗重復進行了五次,使用不同的隨機種子。

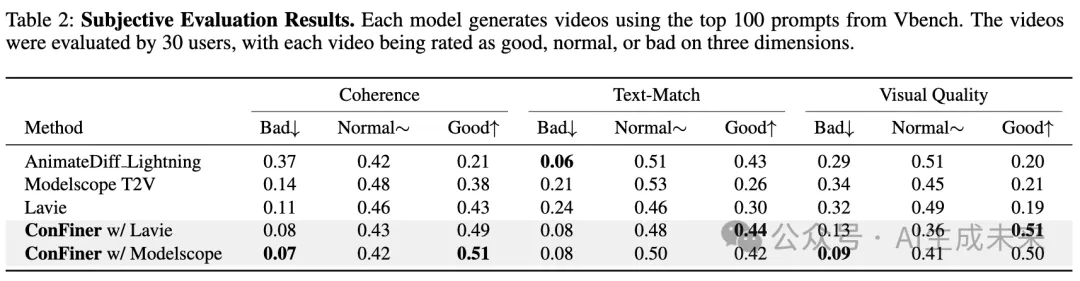

主觀評價

使用 ConFiner 生成了 18 步推理的視頻,使用 Vbench 中的前 100 個提示。這些視頻與由 AnimateDiff-Lightning、Modelscope T2V 和 Lavie(50 步推理)生成的視頻一起,由 30 名用戶進行評估。用戶在以下三個維度上對每個視頻進行了評分:連貫性(coherence)、文本匹配(text-match)和視覺質量(visual quality),每個維度分為三個等級:好(good)、正常(normal)和差(bad)。評分結果展示在下表 2 中。

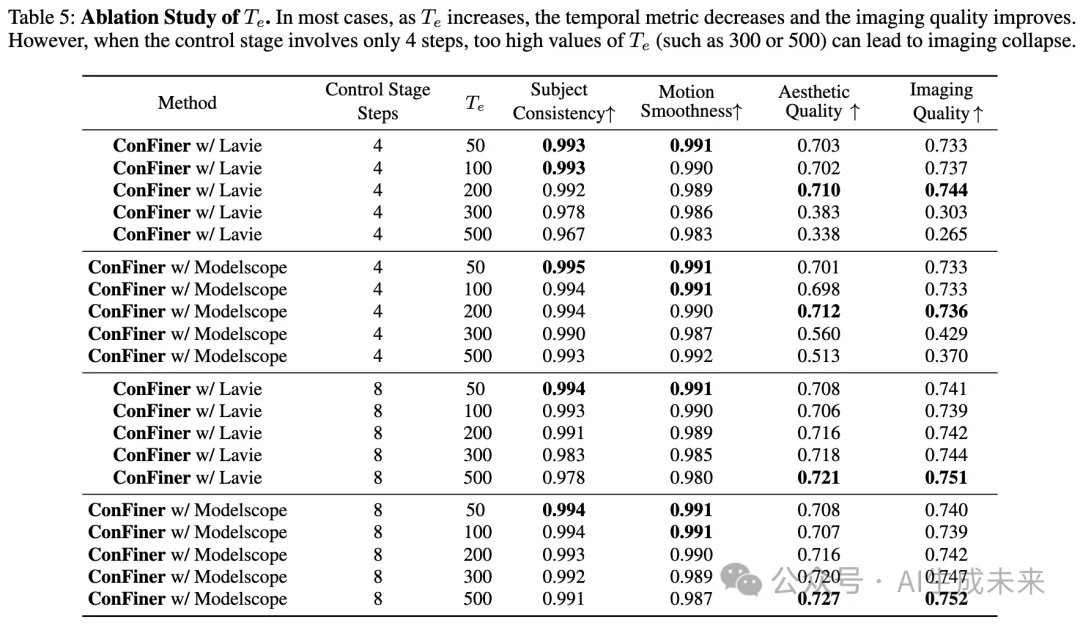

控制和細化階段的消融研究

根據公式(6),在控制階段對生成的視頻應用了步噪聲,以創建細化階段的優化空間。較大的值增加了細化階段的影響。我們將設置為 50、100、200、300 和 500,與客觀實驗中的其他實驗設置一致。性能比較結果展示在下表5中。

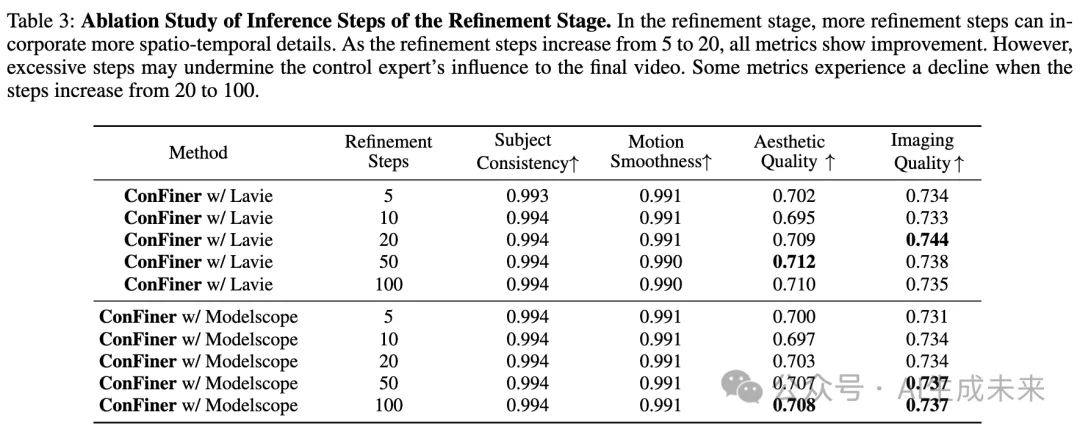

此外,在之前的實驗中,當控制階段使用了 4 步快速采樣時,細化階段始終使用了 5 步推理。為了檢查細化步驟數量的影響,同時保持為 100,使用 Modelscope T2V 和 Lavie 作為時間專家,選擇了 5、10、20、50 和 100 步的總推理步驟。結果的性能指標展示在下表 3 中。

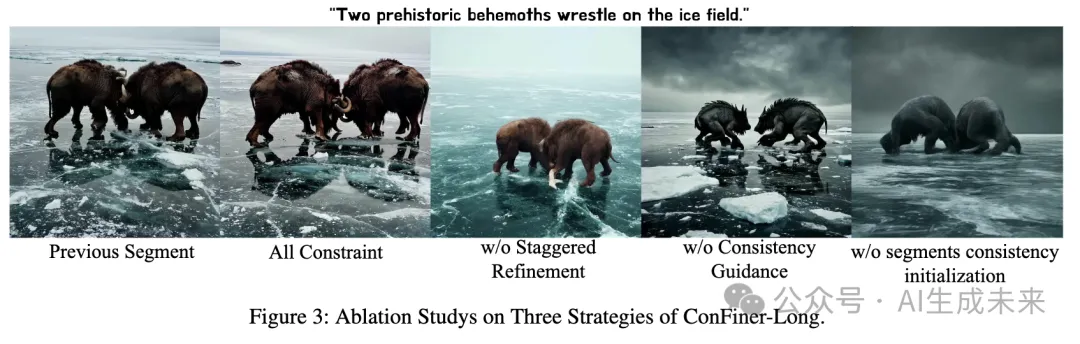

ConFiner-Long 策略的消融研究

研究者們對 ConFiner-Long 框架中的三種策略進行了消融實驗。使用相同的前段視頻段生成后續的視頻段,比較了使用所有三種策略與僅使用兩種策略的結果。四個視頻段與前一個視頻段的視覺比較結果展示在下圖 3 中。

創新性及應用領域

ConFiner這個創新框架,旨在生成高質量的視頻,而無需額外的訓練過程。ConFiner 將視頻生成任務分解為三個核心組件:結構控制、空間細化和時間細化。每個組件由專門的現成擴散專家處理,這些專家在各自領域內具有優勢。此外,還提出了一種協調去噪的方法,允許兩個專家在去噪過程中進行有效協作。

為了進一步提升生成視頻的長度和連貫性,論文中還設計了 ConFiner-Long 框架,該框架能夠生成最長達 600 幀的連貫視頻。實驗結果表明,ConFiner 在提升視頻美學和連貫性的同時,顯著減少了采樣時間。ConFiner-Long 框架的成功應用為電影制作、動畫創作和視頻編輯等領域開辟了成本效益更高的新可能性。

本文轉自 AI生成未來 ,作者:AI生成未來