靠Scaling Laws煉出4D版視頻生成模型,多倫多大學北交大等攜手開源81K高質(zhì)量數(shù)據(jù)集

只需幾分鐘、一張圖或一句話,就能完成時空一致的4D內(nèi)容生成。

注意看,這些生成的3D物體,是帶有動作變化的那種。也就是在3D物體的基礎之上,增加了時間維度的運動變化。

這一成果,名為Diffusion4D,來自多倫多大學、北京交通大學、德克薩斯大學奧斯汀分校和劍橋大學團隊。

具體而言,Diffusion4D整理篩選了約81K個4D assets,利用8卡GPU共16線程,花費超30天渲染得到了約400萬張圖片,包括靜態(tài)3D物體環(huán)拍、動態(tài)3D物體環(huán)拍,以及動態(tài)3D物體前景視頻。

作者表示,該方法是首個利用大規(guī)模數(shù)據(jù)集,訓練視頻生成模型生成4D內(nèi)容的框架,目前項目已經(jīng)開源所有渲染的4D數(shù)據(jù)集以及渲染腳本。

研究背景

過去的方法采用了2D、3D預訓練模型在4D(動態(tài)3D)內(nèi)容生成上取得了一定的突破,但這些方法主要依賴于分數(shù)蒸餾采樣(SDS)或者生成的偽標簽進行優(yōu)化,同時利用多個預訓練模型獲得監(jiān)督不可避免的導致時空上的不一致性以及優(yōu)化速度慢的問題。

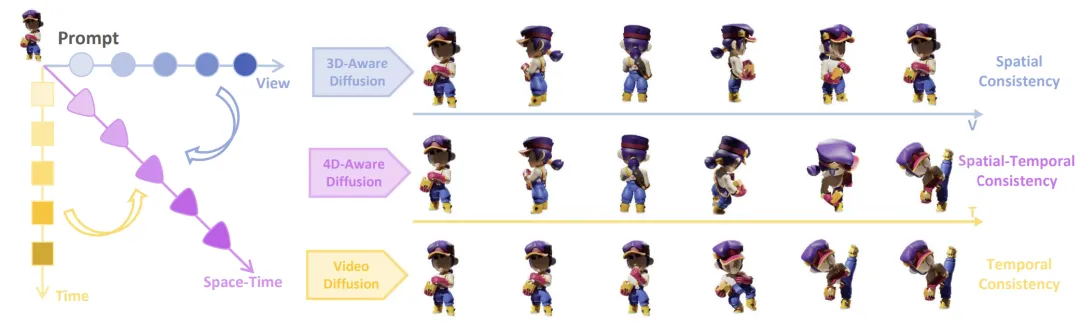

4D內(nèi)容生成的一致性包含了時間上和空間上的一致性,它們分別在視頻生成模型和多視圖生成模型中被探索過。基于這個洞見,Diffusion4D將時空的一致性嵌入在一個模型中,并且一次性獲得多時間戳的跨視角監(jiān)督。

具體來說,使用仔細收集篩選的高質(zhì)量4D數(shù)據(jù)集,Diffusion4D訓練了一個可以生成動態(tài)3D物體環(huán)拍視圖的擴散模型,而后利用已有的4DGS算法得到顯性的4D表征,該方法實現(xiàn)了基于文本、單張圖像、3D到4D內(nèi)容的生成。

△Text-to-4D

4D數(shù)據(jù)集

為了訓練4D視頻擴散模型,Diffusion4D收集篩選了高質(zhì)量的4D數(shù)據(jù)集。

已開源的Objaverse-1.0包含了42K運動的3D物體,在Objaverse-xl中包含323K動態(tài)3D物體。然而這些數(shù)據(jù)包含著大量低質(zhì)量的樣本。對此,研究者們設計了運動程度檢測、邊界溢出檢查等篩選方法,選取了共81K的高質(zhì)量4D資產(chǎn)。

對于每一個4D資產(chǎn),渲染得到了24個靜態(tài)視角的圖(上圖第一行),24個動態(tài)視角的環(huán)拍圖(上圖第二行),以及24個正面動態(tài)圖(上圖第三行)。總計得到了超過四百萬張圖片,總渲染消耗約300 GPU天。

其他數(shù)據(jù)集細節(jié)可以參考項目主頁(文末附上),目前所有渲染完的數(shù)據(jù)集和原始渲染腳本已開源。

方法

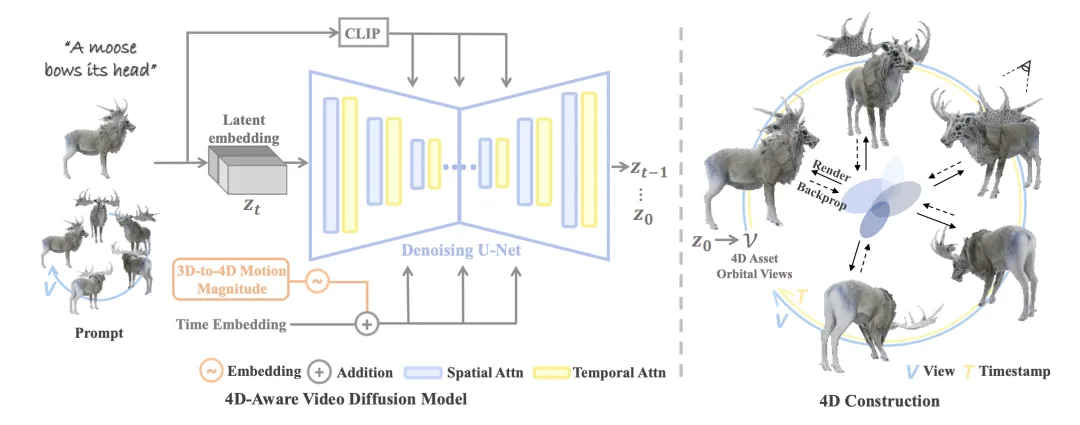

有了4D數(shù)據(jù)集之后,Diffusion4D訓練具有4D感知的視頻擴散模型(4D-aware video diffusion model)。

過去的視頻生成模型通常不具備3D幾何先驗信息,但近期工作如SV3D,VideoMV等探索了利用視頻生成模型得到靜態(tài)3D物體的多視圖,因此Diffusion4D選用了VideoMV作為基礎模型進行微調(diào)訓練,使得模型能夠輸出動態(tài)環(huán)拍視頻。此外設計了如運動強度(motion magnitude)控制模塊、3D-aware classifier-free guidance等模塊增強運動程度和幾何質(zhì)量。得益于視頻模態(tài)具備更強的連貫性優(yōu)勢,輸出的結果具有很強的時空一致性。

輸出得到動態(tài)視角環(huán)拍視頻后,Diffusion4D借助已有的4D重建算法將視頻建模得到4D表達。具體來說采用了4DGS的表征形式,以及使用粗粒度、細粒度的兩階段優(yōu)化策略得到最終的4D內(nèi)容。從生產(chǎn)環(huán)拍視頻到重建4D內(nèi)容的兩個步驟僅需花費數(shù)分鐘時間,顯著快于過去需要數(shù)小時的借助SDS的優(yōu)化式方法。

結果

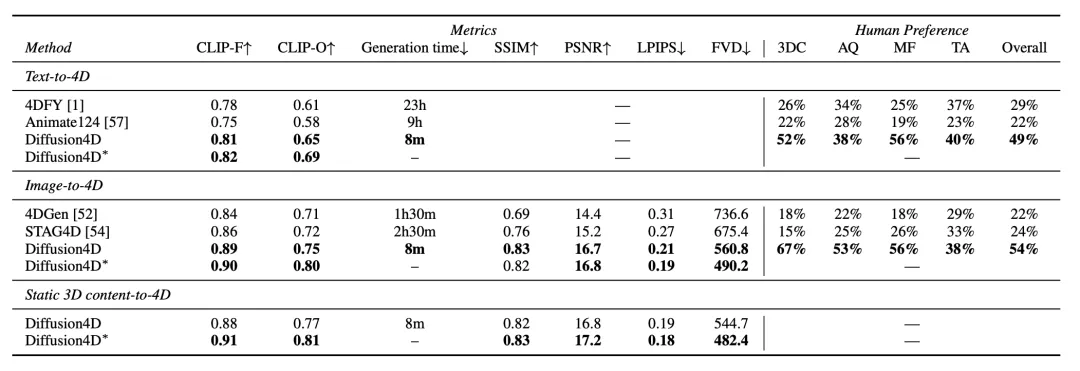

根據(jù)提示信息的模態(tài),Diffusion4D可以實現(xiàn)從文本、圖像、3D到4D內(nèi)容的生成,在定量指標和user study上顯著優(yōu)于過往方法。

在生成質(zhì)量上,Diffusion4D有著更好的細節(jié),更為合理的幾何信息以及更豐富的動作。更多可視化結果可以參考項目主頁。

總結

Diffusion4D是首個利用視頻生成模型來實現(xiàn)4D內(nèi)容生成的框架,通過使用超81K的數(shù)據(jù)集、以及精心設計的模型架構實現(xiàn)了快速且高質(zhì)量的4D內(nèi)容。未來,如何最大程度發(fā)揮4D數(shù)據(jù)集價值,如何生成多物體、復雜場景的4D內(nèi)容仍有很大的探索空間!

項目地址:??https://vita-group.github.io/Diffusion4D/???

論文地址:???https://arxiv.org/abs/2405.16645??

本文轉(zhuǎn)自量子位 ,作者:量子位