硬件不給力,如何窮玩深度神經網絡?

深度學習的力量為其在真實世界的應用創造出了巨大的機會。但深度學習的訓練往往需要巨大的計算能力,有時候我們卻沒法(或沒錢)去使用強大的服務器或 NVIDIA 的 Jetson 那樣的嵌入式加速平臺。假如你需要使用一塊樹莓派開發板為你家的小院子開發一個目標跟蹤器呢?換句話說,如果你需要在沒有加速器的 ARM CPU 上運行一個 CNN,你該怎么做?德國 BuddyGuard GmbH 的機器學習工程師 Dmytro Prylipko 近日在 LinkedIn 上發表了一篇文章,分享了他在弱硬件上運行深度神經網絡的經驗方法。

機器學習社區已經在加速神經網絡推理上進行了很長一段時間的研究了,也已經出現了大量可能有效的解決方案。在這篇文章中,我將嘗試回答一個簡單的問題:什么軟件庫/工具包/框架可以幫助改善我們訓練好的模型的推理時間?出于文章篇幅的考慮,這篇文章我不會考慮修改網絡架構(盡管這確實是一個好方法,比如 SqeezeNet),而是僅僅探討那些已經可以在 ARM 設備上投入生產并且提供了 C/C++ 接口(因為我們很少在嵌入式設備上使用 Lua 或 Python)的工具包和軟件庫。所以在這里我僅僅實驗了 Caffe、TensorFlow 和 MXNet。

我們可以做什么

要加速你的計算,我們有兩個主要的大方向:1)修改模型;2)加速框架。當然,也可能是將這兩者結合起來(而且確實是不錯的想法)。前一種方法往往需要使用更低的權重精度(也被稱為量化(quantization))和/或權重剪枝(weights pruning)。剪枝背后的思想是深度學習模型中的重要參數化冗余,而低精度方法(為浮點數使用了定點或動態定點表示)則利用了這樣一個事實——即推理過程并不需要高精度:因為運算的線性本質和非線性的動態范圍壓縮(dynamic range compression),量化誤差(quantization errors)往往傾向于亞線性地(sub-linearly)傳播,而不會引起數值不穩定性(Vanhoucke, V., Senior, A., & Mao, M. (2011). Improving the speed of neural networks on CPUs)。此外,我們甚至可以使用低精度乘法來訓練模型。結合 SIMD 指令(比如 SSE3),參數量化可以實現非常有效的計算加速。但是目前我們還很難找到同時使用了這兩者的解決方案。比如 Ristretto 可以執行自動量化,但它卻并沒有利用其來降低計算成本。TensorFlow 也可以執行量化,但其推理時間實際上卻增加了 5 到 20 倍,因為其向圖(graph)中還引入了輔助量化/去量化節點(auxiliary quantize/dequantize nodes)。所以,如果空間上的考慮很重要,那么實際上我們可以將量化僅僅看作是一種壓縮網絡權重的方法。至少對于當前的狀態而言,我們可以這樣考慮。

另一方面,我們也有用于框架的加速執行時間(execution time)的方法,而不會影響到模型參數。這些方法基本上都是試圖優化矩陣之間的乘法(GEMM)的通用計算技巧,并因此會同時影響卷積層(其計算通常是 im2col + GEMM)和全連接層。除此之外是 NNPACK:一個用于深度學習框架的加速包。這個加速包還曾得到過 Yann LeCun 的推薦!就我所知,NNPACK 使用了 FFT 來將時間域中的卷積運算替換成了頻域中的乘法計算。

另一個方法是將網絡定義和權重翻譯成針對目標進行優化過的代碼,而不是將它們運行在同樣一個框架內。這種方法的典型案例是 TensorRT。還有 CaffePresso 可以將 Caffe prototxt 翻譯成針對各種不同后端的更低級的規格。但是,TensorRT 的運行需要 CUDA,而且只能在 NVIDIA GPU 上使用,而 CaffePresso 也需要某種硬件加速器(DSP、FPGA 或 NoC),所以這兩種都不適合用于我的測試硬件——樹莓派。

相關鏈接:

- Ristretto:http://lepsucd.com/?page_id=621

- NNPACK:http://github.com/Maratyszcza/NNPACK

- TensorRT:http://developer.nvidia.com/tensorrt

- CaffePresso:http://github.com/gplhegde/caffepresso

調測配置

當謹慎地評估現存的解決辦法后,我發現下列方法能夠加速當前流行的可用模型的推理:

- 如果你的構架使用了 OpenBLAS,你可以嘗試其為深度學習進行過優化的分支:http://github.com/xianyi/OpenBLAS/tree/optimized_for_deeplearning

- NNPACK 能和其他一些框架(包括 Torch、Caffe 和 MXNet)聯合使用:http://github.com/Maratyszcza/NNPACK

- 當在樹莓派上使用 TensorFlow 時,你可以使用 NEON 指令集提供一些 optimization flags:http://github.com/tensorflow/tensorflow/tree/master/tensorflow/contrib/makefile#raspberry-pi

通過這些,我能列出以下調測配置:

- 帶有 OpenBLAS 主分支(master branch)的 Caffe 作為后端(caffe-openblas)

- 帶有 OpenBLAS 的深度學習優化分支(caffe-openblas-dl)的 Caffe

- 使用 OPTFLAGS="-Os" (tf-vanilla) 編譯的 TensorFlow

- 使用 OPTFLAGS="-Os -mfpu=neon-vfpv4 -funsafe-math-optimizations -ftree-vectorize" (tf-neon-vfpv4) 編譯的 TensorFlow

- 帶有用于線性代數計算的 OpenBLAS (mxnet-openblas) 的 Vanilla MXNet

- 帶有 OpenBLAS 的深度學習優化分支 (mxnet-openblas-dl) 的 MXNet

你可能會疑惑:配置中怎么沒有 NNPACK?這確實有點復雜,由 ajtulloch 制作的 Caffe 分支提供了使用 NNPACK 的最直接的方法。然而自從它被集成進去以后,NNPACK API 就已經改變了,并且目前我們不能編譯它)。Caffe2 對 NNPACK 有原生支持,但我不會考慮 Caffe2,因為它處于實驗性階段并且幾乎對 Caffe 進行了重構,相關的文檔也不多。另外一個選項就是使用 Maratyszcza/caffe-nnpack,雖然它比較老舊且沒有什么維護。

另外一個問題就是 NNPACK 自身。它并不提供在 Linux/ARM 上的交叉編譯(cross-compilation)配置,只有在 Android/ARM 上的交叉編譯(cross-compilation)配置。我的實驗性構建在與 MXNet 結合的目標平臺上無法工作。我只能在臺式電腦上運行它,但是我并沒有看到使用 OpenBLAS 會有更優秀的表現。由于我的目標是評估已經可用的解決方法,所以我只能以后再做 NNPACK 的實驗了。

相關鏈接:

- ajtulloch 制作的 Caffe 分支:http://github.com/ajtulloch/caffe/tree/nnpack-pr

- NNPACK API 編譯問題:https://github.com/Maratyszcza/NNPACK/issues/1#issuecomment-266416638

- Maratyszcza/caffe-nnpack:http://github.com/Maratyszcza/caffe-nnpack

- NNPACK Linux/ARM 問題:https://github.com/Maratyszcza/NNPACK/issues/35

硬件

所有的這些評估都是在四核 1.3 GHz CPU 和 1 GB RAM 的樹莓派 3 上執行。操作系統是 32 位的 Raspbian,所以 CPU 不是 ARMv8 架構,而是 ARMv7 架構。

- model name : ARMv7 Processor rev 4 (v7l)

- BogoMIPS : 38.40

- Features : half thumb fastmult vfp edsp neon vfpv3 tls vfpv4 idiva idivt vfpd32 lpae evtstrm crc32

- CPU implementer : 0x41

- CPU architecture: 7

- CPU variant : 0x0

- CPU part : 0xd03

- CPU revision : 4

測試草案

為了評估上述每個配置的性能,我們會使用相同的神經網絡。也就是一個有 3 個卷積層和兩個全連接層且在頂部有 softmax 的微型卷積神經網絡:

- conv1: 16@7x7

- relu1pool1: MAX POOL 2x2conv2: 48@6x6

- relu2pool2: MAX POOL 3x3conv3: 96@5x5

- relu3fc1: 128 unitsfc2: 848 units

- softmax

該卷積神經網絡有 1039744 個參數。雖然非常小,但它足夠處理許多計算機視覺任務。

該網絡使用 Caffe 進行訓練人臉識別任務,并將其轉換為 TensorFlow 和 MXNet 格式從而使用這些框架進行評估。為了評估前向通過時間(forward pass time),從 1 到 256 的批大小都進行了測試,因為批大小對性能有很大的影響。而對于每個批大小,網絡執行了 100 次前向通過,并為每一張圖像計算了平均時間。

評估結果和討論

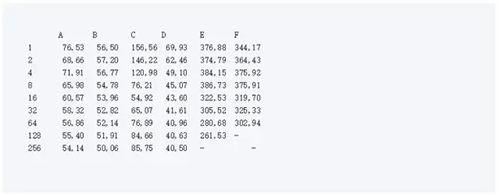

在下面的表格中,列出了平均前向通過的時間。其中,A 是 caffe-openblas, B 是 caffe-openblas-dl, C 代表 tf-vanilla, D 是 tf-neon-vfpv4, E 是 mxnet-openblas, F 是 mxnet-openblas-dl。

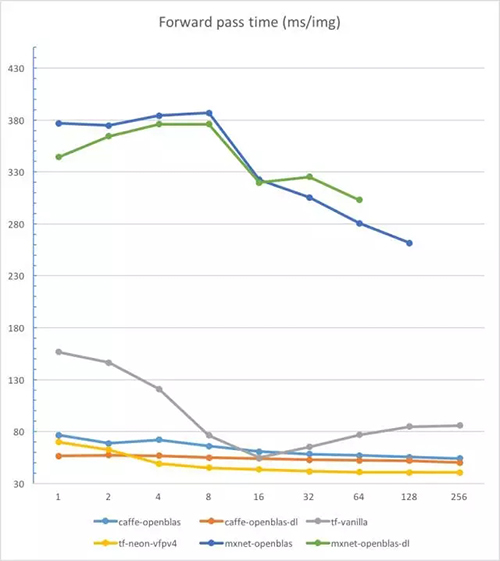

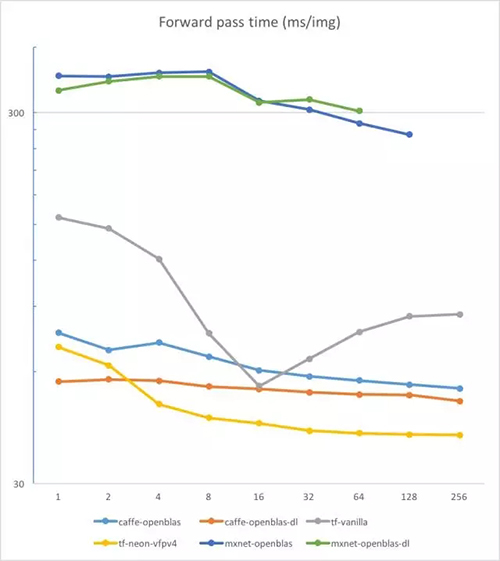

在對數尺度(logarithmic scale)尺度上我們來看一下:

這些結果讓我大吃一驚。首先,我沒有預料到在 CPU 上運行 MXNet 有如此差的表現。但這看起來已經是一個眾所周知的問題。此外,因為存儲限制,它無法運行 256 張圖片的 batch。第二個驚奇是優化過的 TensorFlow 竟有如此好的表現。它甚至比 Caffe 的表現還好(在超過 2 的批大小上);光是從原始框架上看是很難預料這個結果的。但小心:不保證你能在任意 ARM 設備上使用這些 flags。

眾所周知,Caffe 的速度非常快。如果你要一張接一張地處理圖片,使用優化過的 OpenBLAS 的 Caffe 將會是你***的選擇。想要有 10ms 的改進,你所要做的就只是簡單的輸入:

- cd OpenBLAS

- git checkout optimized_for_deeplearning

為了將我的小研究轉變成正式的東西,我仍需要做大量的工作:評估更多的模型,集成 NNPACK,以及研究更多的框架與 BLAS 后端的結合。但我希望它能幫助你了解目前***的解決方案的推理速度。

原文:https://www.linkedin.com/pulse/how-run-deep-neural-networks-weak-hardware-dmytro-prylipko

【本文是51CTO專欄機構“機器之心”的原創譯文,微信公眾號“機器之心( id: almosthuman2014)”】