Spark Submit的ClassPath問題

需求場景:

我們的產品需要與客戶的權限系統對接,即在登錄時使用客戶的認證系統進行認證。集成認證的方式是調用客戶提供的jar包,調用userService的authenticate方法。同時,還需要在classpath中提供密鑰的key文件。

從需求看,這個集成并不復雜,且客戶也提供了較翔實的接口文檔與示例案例,開發工作量非常小。***的阻礙是客戶有安全要求,內部的Jar包及其他文件都不能拷貝出來,而我們的開發環境是不能連接客戶內網的。客戶提供的Jar包并沒有通過Maven來管理,我們只能采用直接導入的方式。在我們的Scala項目中,可以直接將要依賴的jar包放在module的lib文件夾下,在使用sbt執行編譯和打包任務時,會自動將lib下的jar包放入classpath中。

那么,需要解決的***個問題是:由于客戶的jar包不能拷貝到我的開發環境中,該如何處理該依賴?

既然在開發環境下拿不到這個jar包,那就做一個mock包吧。幸而需要編寫的代碼僅僅牽涉到ServiceConfig、ServiceManager與UserService三個類以及這些類的少數方法。其中ServiceConfig提供了認證需要的屬性值,并通過set方法進行設置。因為最終需要調用的其實是UserService的authenticate方法,只需要為其提供一個簡單的實現,并定義好其他相關的類型與方法,保證編譯能夠通過即可。

***個問題輕松解決。

由于我們使用了sbt assembly,并編寫了對應的腳本來支持整個產品的打包工作,最終打包的結果是一個完整的mort.jar包。換言之,我們要依賴的外部Jar包也將被打包到最終的jar文件中。故而,第二個問題接踵而來:既然程序代碼與外部jar包都被打包到最終的部署包中,當我們將該包拷貝到客戶的部署環境中后,該如何將之前的mock包替換為真正的實現呢?

實際上,sbt assembly并不會將所有依賴的外部包都裝配到最終的部署包中,只要在sbt的依賴中添加provided,就能保證第三方依賴包不被包含進部署包中。因此,我們可以改寫sbt腳本,當執行assembly時,排除這個mock包,這是首要解決的方案。方法是在build.sbt中添加如下腳本:

- excludedJars in assembly := {

- val cp = (fullClasspath in assembly).value

- cp filter {_.data.getName == "customer_provided_mock.jar" }

- }

部署包確實不再包含這個外部依賴包了,但是在部署時,我們還得將真實的jar包放入到部署環境的classpath中。然而事與愿違,當我們將真正的jar包放在本地的classpath中時,運行時卻找不到這個jar包。問題出現在哪里?

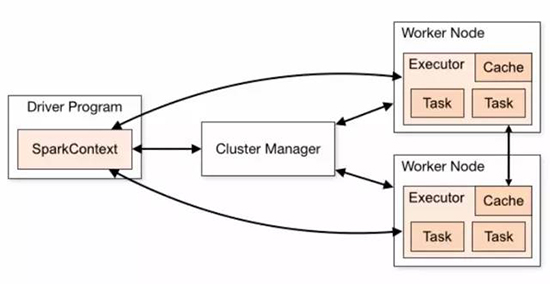

原因在于我們的程序并非一個普通的java程序,而是一個spark application,部署環境則為集群環境,運行該程序是通過spark submit的方式,將部署包提交到spark的cluster manager。這就需要分析spark submit的工作原理,如下圖所示:

在集群部署模式下,Driver端通過spark-submit將spark application提交到集群,然后分發到Job到Worker節點。我們系統的主程序入口為com.bigeyedata.mort.Main,程序的運行是通過spark-submit去調用部署包的Main,即在spark driver下運行,而非在本地通過java啟動虛擬機執行mort.jar。

這就是在本地設置classpath不生效的根本原因。

我注意到spark-submit提供了--jar參數,除了spark application這個jar包之外的其他jar包,都可以通過這個參數指定包,從而將其自動傳送給集群。注意,若--jar指定了多個jar包,則通過分隔符,分隔,這與--driver-class-path的分隔符不同,后者使用:。因此,我修改了啟動程序的腳本,將其設置為:

- exec $SPARK_HOME/bin/spark-submit \

- --class com.bigeyedata.mort.Main \

- --driver-class-path $MORT_HOME/libs/*.jar \

- --master yarn-client \

- --deploy-mode cluster \

- --jars /appcom/mort/thirdparty_jars/customer_provided.jar \

- --queue queue_0100_01 \

- $MORT_HOME/mort.jar > $MORT_HOME/mort.log 2>&1

還有一個問題需要解決:如何放置用戶認證需要的密鑰key文件?

該文件仍然不能作為內嵌的資源文件打包到部署包中。因為這個文件的內容需要區分測試環境和生產環境。在部署到生產環境中時,需要替換為另一個key文件。客戶的文檔說明,需要將該文件(不是jar文件)放到運行的classpath中。

解決辦法如前,仍然不能直接將key文件放入到本地的classpath中,而是利用spark-submit的--files參數。故而需要在前面的腳本中,為spark-submit添加如下內容:

- --files /appcom/mort/thirdparty_jars/clientKey.pk \

三個問題給我制造了一定的麻煩,尤其是第二個問題的解決,又讓我溫習了spark submit的工作原理,了解相關參數的作用。雖然花費了一些時間,但問題的解決還是頗有價值的。

【本文為51CTO專欄作者“張逸”原創稿件,轉載請聯系原作者】