為什么深度學習沒有局部最小值?

這篇文章主要回答量化問題。量化問題主要包括以下情況:

“據我所知,每個方向0的衍生機率很低。除此之外,還有其他原因嗎?”

理論上,這個問題是可以驗證的,而且這幾十年間也有很多研究人員一直在致力于驗證它。

首先,我想指出無論如何這個問題已在實踐中得到了驗證。這個觀點最初由LeCun在他早期的著作中提出。現在David G. Stork, Peter E. Hart, 和 Richard O. Duda合著的“小紅書”《圖形分類》中有討論。

20年前旋轉玻璃研究中這個問題已在濃縮物質物理學中被大量解釋。

最基礎的項目由Parisi通過一個類似的非現實形式開發研究:

以靜態的觀點表現TAP的自由能量

后來采用了無規矩陣理論實證的正確可行的方法論證。LeCun所談及的結果如下:

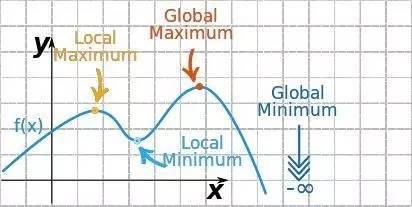

高維景觀的關鍵點

我來總結一下Parisi的方法:

他研究隨機哈密爾敦函數的其中一種——平均場自旋玻璃,被稱作P狀旋轉的球狀旋轉玻璃。他發現:

1.得出TAP自由能量的分析表達式(當T>0時)TAP(索利斯安德森帕爾默)理論是研究旋轉玻璃的一般方法,而且能應用于RBMs(可參閱《使用物理化學提高RMBs》)

2.可計算構形的平均信息量,除此之外,還有復雜性度量——通過統計學理論的方法計算關鍵點的數量。

3.為了在能量水平E時計算關鍵點數量,可延伸這一結論到T=0的能量景觀。Paris得出的普適結果是所有本地最小化能量“集中(靜態上)”在輕微高于地球表面的一小部分地帶中。

一直未解釋的是為什么在研究旋轉玻璃中這是一個重要問題以及為什么P形球狀旋轉玻璃是研究目標,除了它是一個已被論證的模型以及有大量深度學習研究人員可得出的硬性設想。

此外,在深度學習研究中,T=0能量觀景與T>0能量觀景之間沒有區別,雖然在傳統的方法中如RBMs和VAEs是假設T=1。

最近有更多的結論可嘗試直接應用于深度學習研究中:

不存在極少的局部最小值的深度學習

這一結論進一步假設SGD解決者實際中無法分辨鞍點與局部最小值的區別,因為Hessian理論的假設是很有問題的。LeCun最近的數值計算研究證實了這一點。他的研究顯示Hessian理論假設有很多0值。

偏向性梯度下降至谷底

我個人認為這一結論還不完整,而且對于物理化學家,例如沃利尼斯*彼特來說,這方面的問題還有大量研究工作。這個議題在被稱作“亞當的肋骨”現象以及關聯的在真實結構性玻璃出現的平均信息量危機的極冷玻璃理論中一個讓人非常迷惑的現象。這個題目很深奧,但足以說明P旋轉球狀旋轉玻璃非常有趣的原因是這是一個簡單的旋轉玻璃模型,具有大量的真實能量觀景。它表現了平均信息量危機。事實上,我設想深網也將表現出平均信息量危機,例如:當深網被過度訓練后他們會呈現出很多假設性的平均信息量。

由于過度訓練而引發的平均信息量危機將呈現為高聳的山峰,因為它已偏離假設性平均信息量,類似于LeCun在他的關于平均信息量SGD論著中提及的。而且這一現象最近在RBMs被觀察到。

[1612.01.1717] 具有二元突觸的限制性波爾茲曼機器的非監控特征的統計力學

這些漏斗狀的觀景可從蛋白質折疊中觀察到。

那么,為什么深度學習可行呢?

我在UC 伯克利大學的2016夏季MDDS 討論中談及了這些問題 (可點擊 閱讀原文 查看視頻)。