AI看圖說話首超人類!微軟認知AI團隊提出視覺詞表預訓練超越Transformer

能看圖會說話的AI,表現還超過了人類?最近,Azure悄然上線了一個新的人工智能服務,能精準的說出圖片中的內容。而背后的視覺詞表技術,更是超越了基于Transformer的前輩們,拿到nocaps挑戰賽冠軍。

有沒有發現,搜索出來的圖片有時相關性很差?

現在很多搜索引擎都是基于圖片的文本標簽,但是我們的世界每天產生不計其數的照片,很多都沒有標記直接傳到了網上,給圖片搜索帶來了很多混亂。

如果系統能自動給圖片加上精準的描述,圖像搜索的效率將大為提高。

看圖說話的AI:基于模板和Transformer都不盡如人意

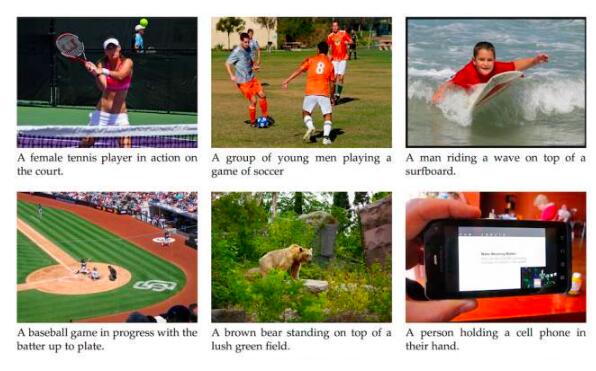

看圖說話(或者叫圖像描述),近年來受到了很多關注,它可以自動生成圖片描述。但是目前無論是學術界還是工業界,做的效果都差強人意。

看圖說話系統一方面需要計算機視覺進行圖像的識別,另一方面需要自然語言來描述識別到的物體。帶標簽的圖片可以針對性訓練,那如果出現了從未標注的新物體,系統是不是就失效了?

這個問題困擾了人們很久,即描述清楚一個新出現的東西。

人工智能領域驗證一個模型的好壞,通常會用一個基準測試。比如NLP方向會用GLUE、SuperGLUE等,圖像識別會用ImageNet等。

為了測試模型能否在沒有訓練數據的情況下完成看圖說話,nocaps應運而生。nocaps可以衡量模型能否準確描述未出現過的物體。

傳統的看圖說話方法主要有兩種:一種是模板生成,一種是基于 Transformer 的圖像文本交互預訓練。

模板生成方法,在簡單場景下可以使用,但無法捕捉深層次的圖像文本關系,而基于Transformer的模型又需要海量的標注數據,所以不適合nocaps。

為解決這些問題,微軟認知服務團隊的研究人員提出了一種名為視覺詞表預訓練(Visual Vocabulary Pre-training,簡稱VIVO)的解決方案。

無需配對圖文數據,VIVO看圖說話奪冠nocaps首次超越人類

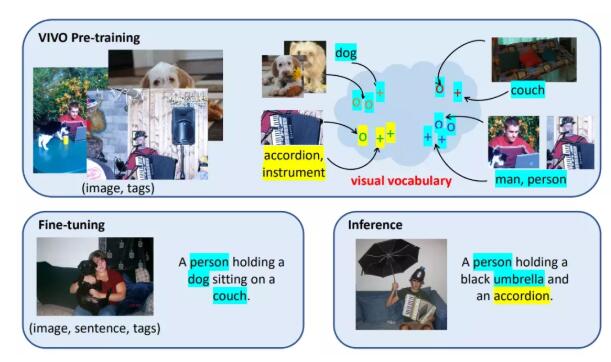

VIVO可以在沒有文本標簽的數據上進行文本和圖像的多模態預訓練,擺脫了對配對圖文數據的依賴,可以直接利用ImageNet等數據集的類別標簽。借助VIVO,模型可以學習到物體的視覺外表和語義之間的關系,建立視覺詞表。

這個視覺詞表是啥呢?其實就是一個圖像和文本的聯合特征空間,在這個特征空間中,語義相近的詞會聚類到一起,如金毛和牧羊犬,手風琴和樂器等。

預訓練建好詞表后,模型只需在有少量共同物體的配對圖文的數據上進行微調,模型就能自動生成通用的模板語句,使用時,即使出現沒見過的詞,也能從容應對,相當于把圖片和描述的各部分解耦了。

所以VIVO既能利用預訓練強大的物體識別能力,也能夠利用模板的通用性,從而應對新出現的物體。

Azure AI 認知服務首席技術官黃學東解釋說,視覺詞表的預訓練類似于讓孩子們先用一本圖畫書來閱讀,這本圖畫書將單個單詞與圖像聯系起來,比如一個蘋果的圖片下面有個單詞apple,一只貓的圖片下面有個單詞cat。

視覺詞表的預訓練本質上就是訓練系統完成這種動作記憶。

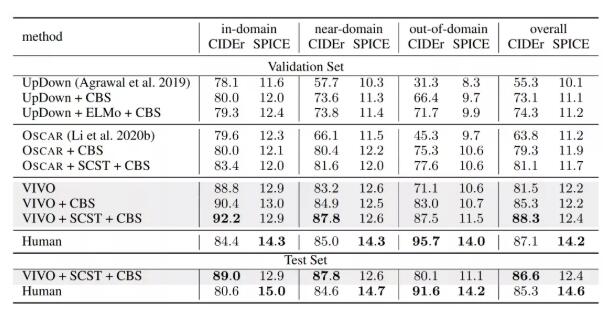

目前,VIVO 在 nocaps 挑戰中取得了 SOTA效果,并首次超越人類表現。

VIVO取得成功可不僅僅是挑戰賽的SOTA,目前已經有了實際應用。

看圖說話SOTA已上線,AI不能一直處于灰色的迭代

據世界衛生組織統計,各年齡段視力受損的人數估計有2.85億人,其中3900萬人是盲人。

實力受損的用戶想要獲取圖片和視頻中的信息,就要依靠自動生成的圖片描述或字幕(或者進一步轉化為語音),他們非常相信這些自動生成的描述,不管字幕是否有意義。

「理想情況下,每個人都應該在文檔、網絡、社交媒體中給圖片添加描述,因為這樣可以讓盲人訪問內容并參與對話。」但是,這很不現實,很多圖片都沒有對應的文本。

Azure AI 認知服務公司首席技術官黃學東說: 「看圖說話是計算機視覺的核心能力之一,可以提供廣泛的服務」。

現在VIVO看圖說話的能力已經集成到了Azure AI中,任何人都可以將它集成到自己的視覺AI應用中。

黃學東認為, 把VIVO的突破帶到 Azure 上,為更廣泛的客戶群服務,不僅是研究上的突破,更重要的是將這一突破轉化為 Azure 上的產品所花費的時間。

基于VIVO的小程序Seeing AI在蘋果應用商店已經可以使用了,Azure也已經上線了免費API,供盲人或者視障人士免費使用。如果再加上Azure的翻譯服務,看圖說話可以支持80多種語言。

的確,有太多的實驗室SOTA技術倒在了灰色的不斷迭代中,沒能完成它最初的使命。

看圖說話只是認知智能的一小步,受古登堡印刷機啟發開創新魔法

近年來,微軟一直在尋求超越現有技術的人工智能。

作為 Azure 認知服務的首席技術官,黃學東所在的團隊一直在探索,如何更全面、更人性化地來學習和理解這個世界。

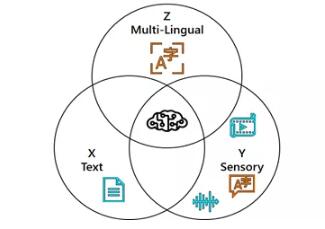

他認為要想獲得更好的認知能力,三個要素至關重要,單語言文本(X)、音頻或視覺等感覺信號(Y)和多語言(Z)。

在這三者的交匯處,有一種新魔法ーー XYZ-Code,可以創造出更強大的人工智能,能夠更好地聽、說、看和理解人類。

「我們相信 XYZ-Code正在實現我們的長期愿景: 跨領域、跨模式和跨語言學習。我們的目標是建立預先訓練好的模型,這些模型可以學習大范圍的下游人工智能任務的表示,就像今天人類所做的那樣。」

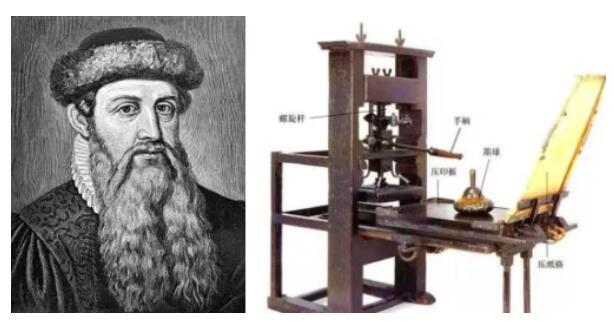

黃學東團隊從德國發明家約翰內斯·古登堡那里獲得靈感,他在1440年發明了印刷機,使人類能夠快速、大量地分享知識。作為歷史上最重要的發明之一,古登堡的印刷機徹底改變了社會進化的方式。

古登堡和他發明的印刷機

在今天的數字時代,認知智能的愿景也是開發一種能夠像人一樣學習和推理的技術,對各種情況和意圖做出精準推斷,進而做出合理的決策。

在過去的五年里,我們已經在人工智能的很多領域實現了人類的平等地位,包括語音識別對話、機器翻譯、問答對話、機器閱讀理解和看圖說話。

這五個突破讓我們更有信心實現人工智能的飛躍,XYZ-Code將成為多感官和多語言學習的重要組成部分,最終讓人工智能更像人類。

正如古登堡的印刷機革命性地改變了通信的過程,認知智能將幫助我們實現人工智能的偉大復興。

看圖說話體驗鏈接:

https://apps.apple.com/us/app/seeing-ai/id999062298