自監(jiān)督深度估計(jì)算法,比肩有監(jiān)督,泛化性能更佳

室內(nèi)環(huán)境的自監(jiān)督深度估計(jì)向來比室外環(huán)境更具挑戰(zhàn)性,OPPO提出了一種新穎的單目自監(jiān)督深度估計(jì)模型:MonoIndoor,通過深度因子化模塊和殘差姿態(tài)估計(jì)模塊,提高了室內(nèi)環(huán)境中自監(jiān)督單目深度估計(jì)的性能。目前,該成果已被ICCV 2021接收。ICCV是計(jì)算機(jī)視覺方向的三大頂級(jí)會(huì)議之一,今年論文接收率為25.9%。

根據(jù)單張圖像估計(jì)深度信息是計(jì)算機(jī)視覺領(lǐng)域的經(jīng)典問題,也是一項(xiàng)具有挑戰(zhàn)的難題。由于單目圖像的尺度不確定,傳統(tǒng)方法無法計(jì)算深度值。

隨著深度學(xué)習(xí)技術(shù)的發(fā)展,該范式已經(jīng)成為了估計(jì)單目圖像的深度信息的一種解決方案。早期的深度估計(jì)方法大多是有監(jiān)督的,即要求數(shù)據(jù)集包含單目圖像和對(duì)應(yīng)的深度真值支撐網(wǎng)絡(luò)模型訓(xùn)練。

要想讓圖像含深度真值非常困難,一般需要精密的深度測量設(shè)備和移動(dòng)平臺(tái)“捕獲”。因此,高昂的成本導(dǎo)致數(shù)據(jù)集的數(shù)據(jù)量較小,也意味著有監(jiān)督學(xué)習(xí)的深度估計(jì)方式不適用于大規(guī)模的工業(yè)場景。

近日,OPPO提出了一種新穎的單目自監(jiān)督深度估計(jì)模型:MonoIndoor。該方法能夠在訓(xùn)練深度網(wǎng)絡(luò)時(shí)僅使用圖像本身作為監(jiān)督信息, 無需圖像顯式的目標(biāo)深度值,在降低對(duì)訓(xùn)練數(shù)據(jù)集要求的同時(shí), 提升了深度估計(jì)的適應(yīng)性和魯棒性。目前,該成果已被ICCV 2021接收,相關(guān)技術(shù)已申請(qǐng)專利。

論文地址:https://arxiv.org/pdf/2107.12429.pdf

具體而言,該論文研究了更具挑戰(zhàn)性、場景更復(fù)雜的室內(nèi)場景自監(jiān)督深度估計(jì),在三個(gè)公開數(shù)據(jù)集:EuRoC、NYUv2、7-Scenes上進(jìn)行測試時(shí),其性能優(yōu)于Monodepth2等方法,達(dá)到了自監(jiān)督深度估計(jì)領(lǐng)域內(nèi)的最佳性能。

如何實(shí)現(xiàn)室內(nèi)場景深度估計(jì)?

雖然對(duì)于自監(jiān)督深度估計(jì)已經(jīng)有了不少研究,其性能已經(jīng)可以與有監(jiān)督方法相媲美,但是這些自監(jiān)督方法的性能評(píng)估要么只在戶外進(jìn)行,要么在室內(nèi)表現(xiàn)不佳。

對(duì)于原因,OPPO研究院的研究員認(rèn)為:同戶外場景相比,室內(nèi)場景通常缺少顯著的局部或全局視覺特征。具體而言:

1. 室內(nèi)場景景深變化劇烈,使得神經(jīng)網(wǎng)絡(luò)很難推演出一致的深度線索。

2. 室內(nèi)場景下,相機(jī)運(yùn)動(dòng)通常會(huì)包含大量的旋轉(zhuǎn),從而給相機(jī)姿態(tài)網(wǎng)絡(luò)造成困難。

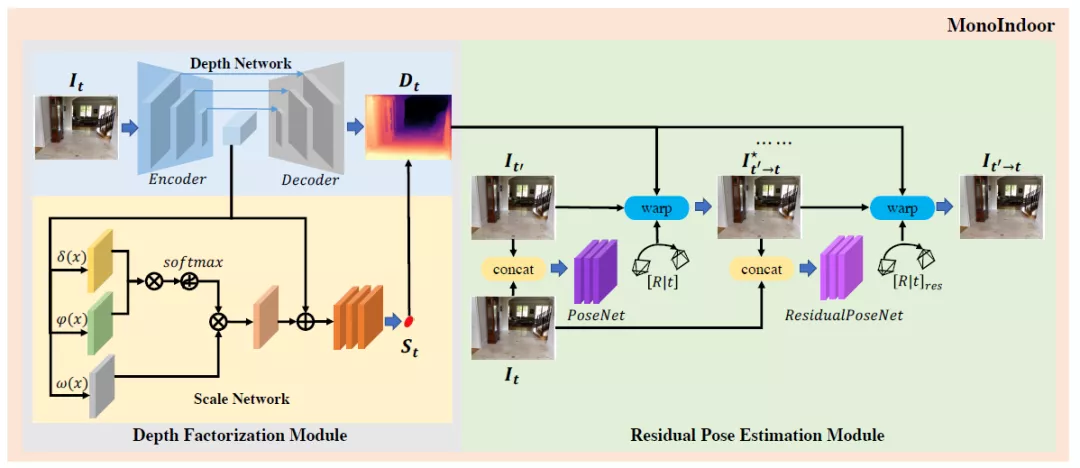

基于以上觀察,研究員提出兩個(gè)新的模塊嘗試解決上述兩個(gè)困難。其中,深度因子化模塊(Depth Factorization)旨在克服景深劇烈變化給深度估計(jì)造成的困難;殘差姿態(tài)估計(jì)模塊(Residual Pose Estimation)能夠提高室內(nèi)場景下相機(jī)旋轉(zhuǎn)的估計(jì),進(jìn)而提升深度質(zhì)量。

圖注:MonoIndoor模型架構(gòu)一覽

模型工作原理如上圖所示,深度因子化模塊采用編解碼器的深度網(wǎng)絡(luò)來估計(jì)相對(duì)深度圖,使用非局部標(biāo)度網(wǎng)絡(luò)(non-local scale network)估計(jì)全局標(biāo)度因子(global scale factor);殘差姿態(tài)估計(jì)模塊用姿態(tài)網(wǎng)絡(luò)估計(jì)一對(duì)幀的初始攝像機(jī)姿勢(shì),然后根據(jù)初始姿勢(shì),用殘差姿態(tài)網(wǎng)絡(luò)迭代估計(jì)殘差相機(jī)姿勢(shì)。

模型架構(gòu)之深度因子化模塊

深度因子化模塊的骨干模型是Monodepth2,它的自動(dòng)掩碼機(jī)制可以忽略那些在單目訓(xùn)練中相對(duì)攝像機(jī)靜止的像素;同時(shí)采用多尺度光度一致性損失,以輸入分辨率執(zhí)行所有圖像采樣,減少了深度失真。

在Monodepth2的基礎(chǔ)上,研究員提出了自注意指導(dǎo)的標(biāo)度回歸網(wǎng)絡(luò)(self-attention-guided scale regression network)對(duì)當(dāng)前視點(diǎn)的全局尺度因子進(jìn)行估計(jì)。

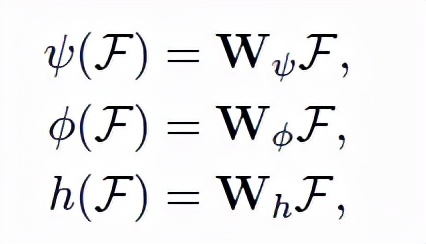

標(biāo)度網(wǎng)絡(luò)作為深度因子化模塊的另一個(gè)分支,其以彩色圖像為輸入,全局標(biāo)度因子為輸出。由于全局標(biāo)度因子和圖像局部區(qū)域密切相關(guān),研究員在網(wǎng)絡(luò)中加入了自注意塊,以期指導(dǎo)網(wǎng)絡(luò)更多地“關(guān)注”某信息豐富的區(qū)域,從而推導(dǎo)出深度因子。公式如下,給定圖像特征輸入,輸出為Query、鍵(key)、值(values)。

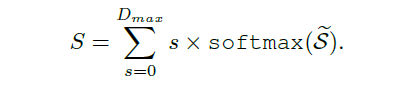

此外,為了穩(wěn)定估計(jì)全局標(biāo)度因子,研究員還在網(wǎng)絡(luò)中添加了概率標(biāo)度回歸頭(Probabilistic Scale Regression Head)。公式如下,全局標(biāo)度是每一標(biāo)度的加權(quán)概率求和:

模型架構(gòu)之殘差姿態(tài)估計(jì)模塊

與已有方法在數(shù)據(jù)預(yù)處理過程中專注于“去除”或“減少”旋轉(zhuǎn)成分(rotational components)不同,OPPO研究員提出的殘差姿態(tài)估計(jì)模塊,可以用迭代的方式學(xué)習(xí)目標(biāo)和源圖像之間的相對(duì)相機(jī)姿態(tài)。

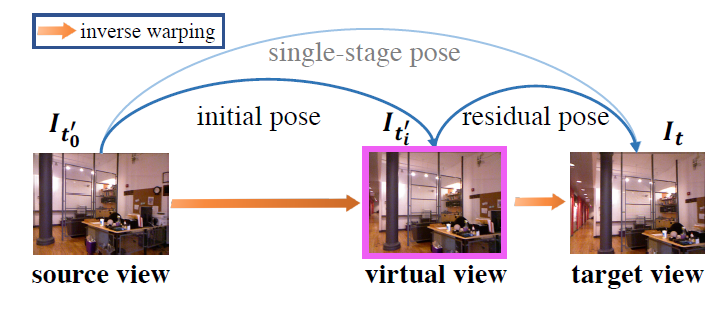

圖注:一次姿態(tài)估計(jì)分解為兩次姿態(tài)估計(jì)的示例

第一步:姿態(tài)網(wǎng)絡(luò)將目標(biāo)圖像和源圖像作為輸入,并估計(jì)初始相機(jī)姿態(tài)。

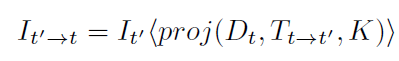

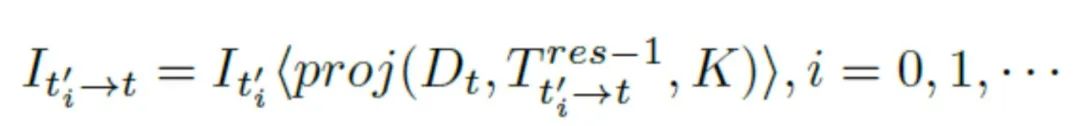

第二步:用上述公式從源圖像進(jìn)行雙線性采樣,重建一個(gè)虛擬視圖。

第三步:利用殘差姿態(tài)網(wǎng)絡(luò),將目標(biāo)圖像和合成視圖作為輸入,并輸出殘差相機(jī)姿態(tài)(residual camera pose)。其中,殘差相機(jī)姿態(tài)指的是合成視圖和目標(biāo)圖像之間的相機(jī)姿態(tài)。

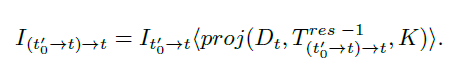

第四步,從合成圖像進(jìn)行雙線性采樣,公式如上↑。

最后,獲得新合成視圖之后,繼續(xù)估計(jì)下一個(gè)的殘差姿態(tài)。此時(shí),雙線性采樣公式的一般化為↓:

多次估計(jì)之后,殘差姿態(tài)可以動(dòng)態(tài)的寫為↓:

綜上,通過迭代法估計(jì)殘差姿態(tài),能夠獲得更準(zhǔn)確的相機(jī)姿態(tài),更好的進(jìn)行深度估計(jì)。具體實(shí)驗(yàn)效果如下一部分所述。

性能評(píng)估

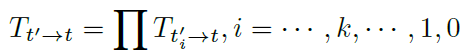

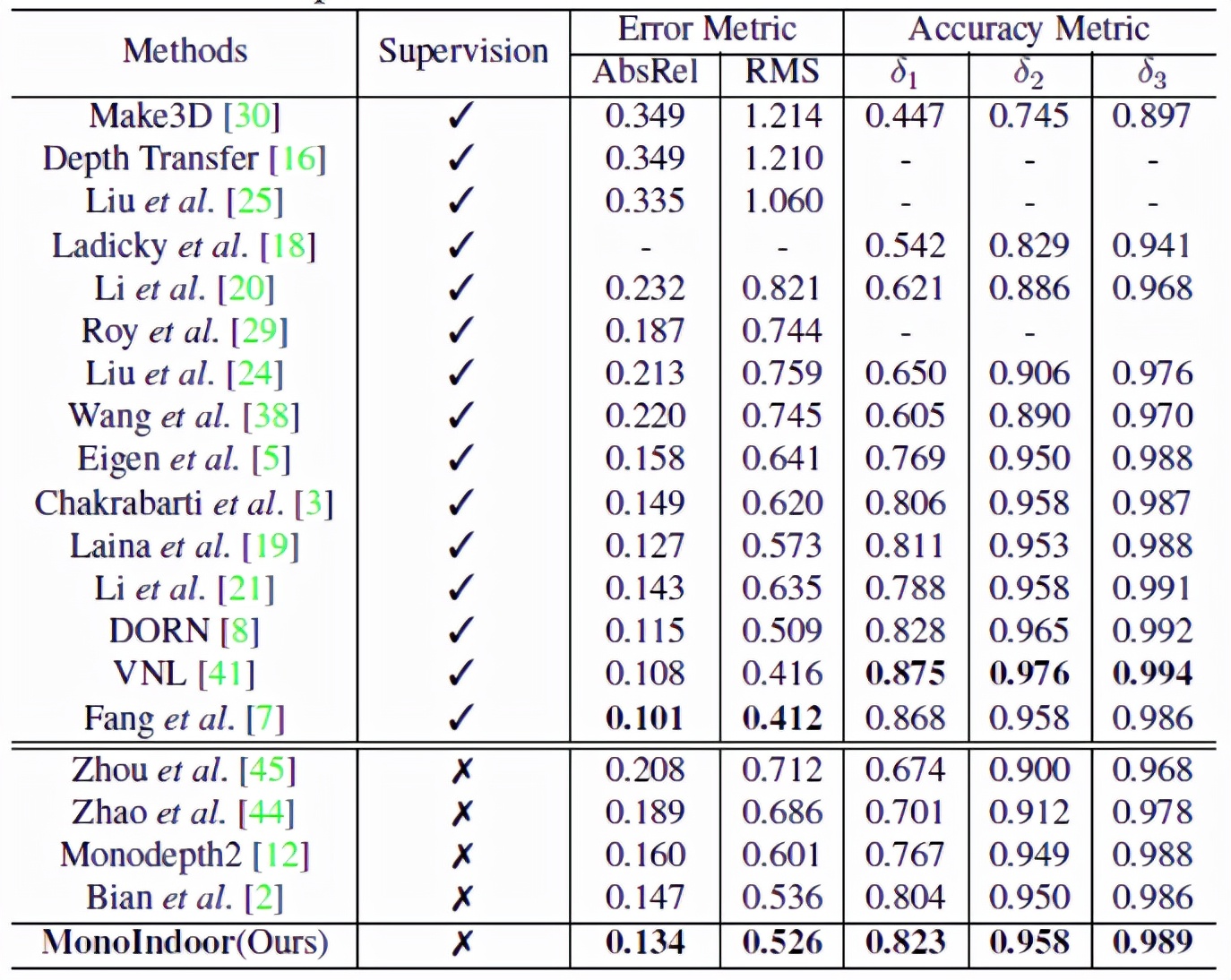

為了說明模型MonoIndoor的效果,研究員在EuRoC MAV、NYUv2、RGBD 7-Scenes三個(gè)權(quán)威數(shù)據(jù)集上進(jìn)行了評(píng)估。采用業(yè)界通用的單目深度估計(jì)量化指標(biāo):絕對(duì)相對(duì)差(AbsRel)、均方根誤差(RMSE);以及三個(gè)常用的閾值thr=1.25,1.25^2,1.25^3下的準(zhǔn)確度。

具體到實(shí)驗(yàn)配置,研究員使用PyTorch實(shí)現(xiàn)模型,每個(gè)實(shí)驗(yàn)用Adam優(yōu)化器訓(xùn)練40個(gè)epochs,在前20個(gè)epochs學(xué)習(xí)率設(shè)置為10^-4,另外20個(gè)設(shè)置為10^-5;平滑項(xiàng)和consistency term分別設(shè)置為0.001和0.05。

實(shí)驗(yàn)結(jié)果之EuRoC MAV

將Monodepth2作為基線模型進(jìn)行對(duì)比,結(jié)果如上表所示,深度因子化模塊能夠AbsRel從15.7%降低到14.9%;殘差姿態(tài)估計(jì)模塊將AbsRel降低到14.1%,整個(gè)模型在所有評(píng)估指標(biāo)中都實(shí)現(xiàn)了最佳性能。

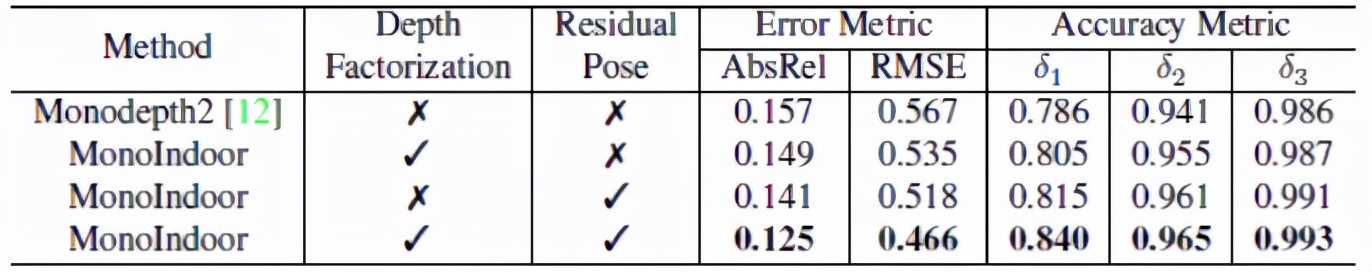

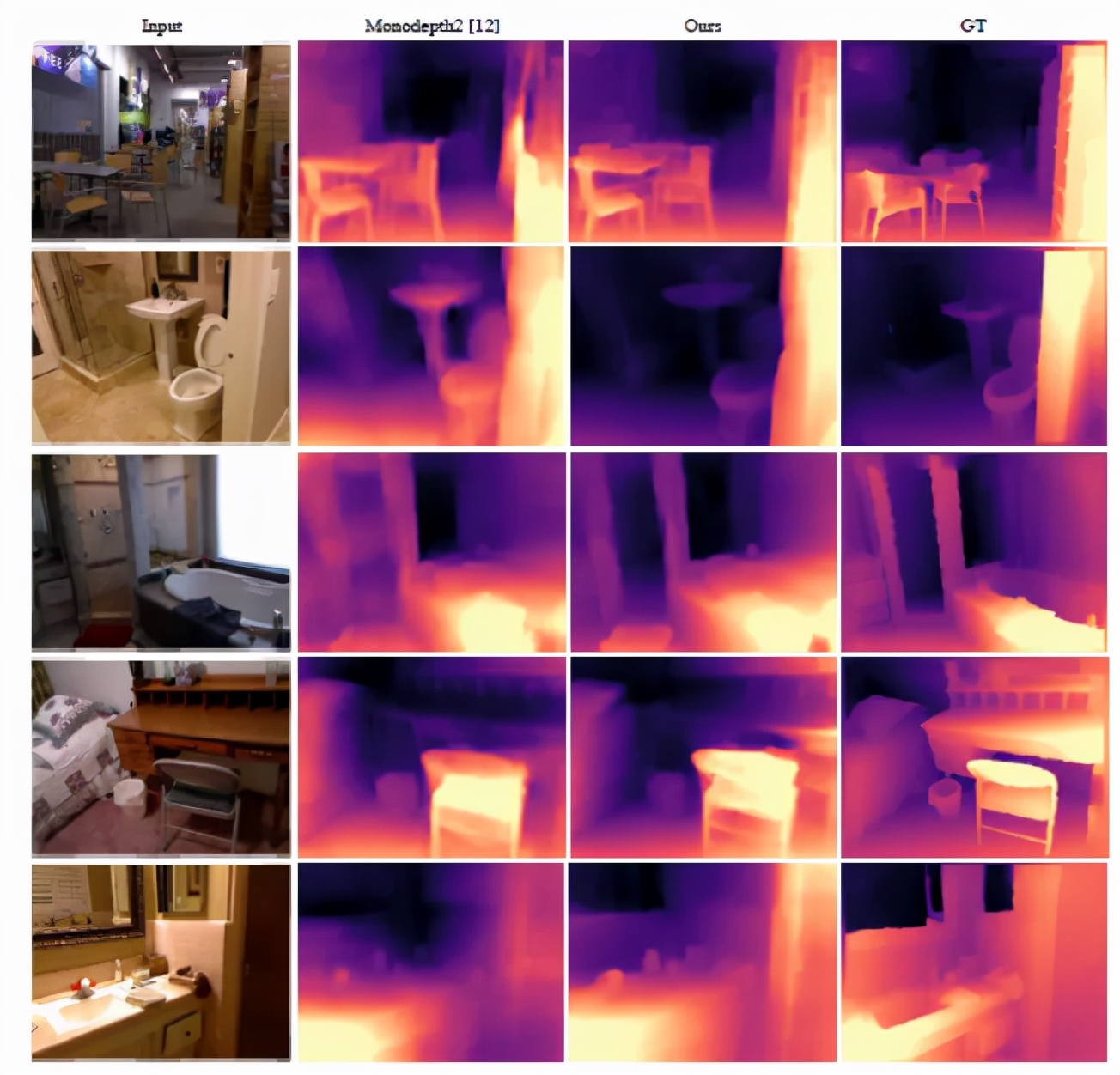

通過上圖,我們可以定性的發(fā)現(xiàn),MonoIndoor 做出的深度估計(jì)比Monoepth2要好得多。例如,在第一行中,MonoIndoor可以估計(jì)圖片右下角的“洞區(qū)域”的精確深度,而Monoepth2顯然無法估計(jì)。

實(shí)驗(yàn)結(jié)果之NYUv2

MonoIndoor 與最新的SOTA監(jiān)督和自監(jiān)督方法性能對(duì)比結(jié)果如上表所示,在自監(jiān)督方面,能夠在各項(xiàng)指標(biāo)上達(dá)到最佳,在與有監(jiān)督方法對(duì)比方面,也能夠“打敗”一組,從而縮小了自監(jiān)督和有監(jiān)督方法之間的差距。

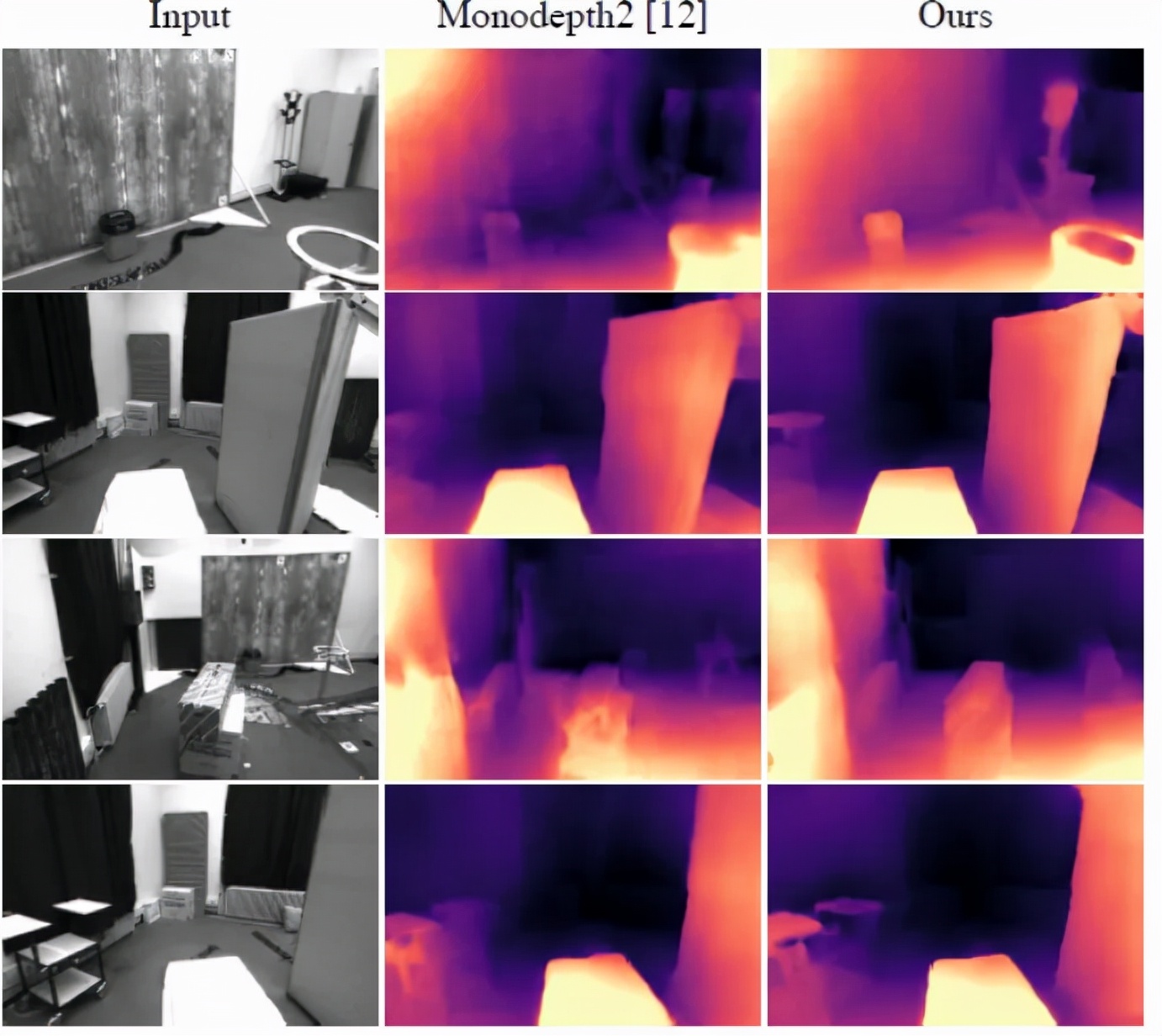

上圖可視化了NYUv2上的深度估計(jì)效果。與Monoepth2的結(jié)果相比,MonoIndoor的深度估計(jì)更加接近真實(shí)情況。例如,第一行的第三列,MonoIndoor對(duì)椅子區(qū)域的深度估計(jì)更加精準(zhǔn)。

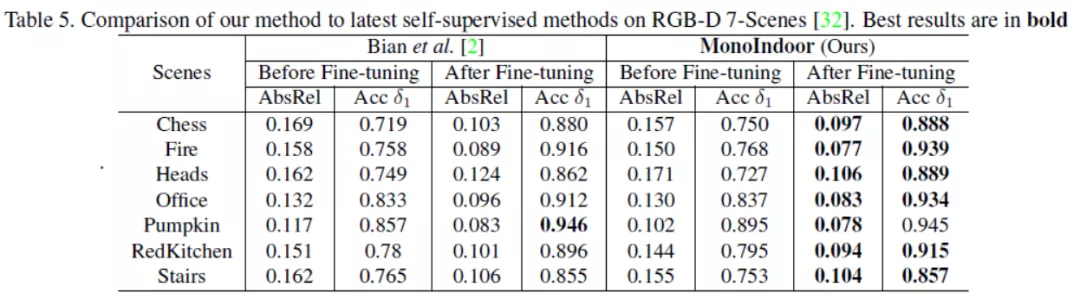

實(shí)驗(yàn)結(jié)果之RGB-D 7-Scenes

上表給出了MonoIndoor微調(diào)前與微調(diào)后在RGB-D 7-Scenes數(shù)據(jù)集上的測試結(jié)果,通過在各個(gè)場景給出的各個(gè)指標(biāo),顯示了MonoIndoor更好的泛化能力和魯棒性。例如,在場景“Fire”上,MonoIndoor減少了1.2%的AbsRel;在場景“Heads”上,MonoIndoor減少了1.8%的AbsRel。

結(jié)語

近年來,人工智能產(chǎn)品在各個(gè)行業(yè)迅猛發(fā)展,機(jī)器人學(xué)、三維重建、目標(biāo)追蹤等領(lǐng)域?qū)ι疃裙烙?jì)技術(shù)的準(zhǔn)確性和效率要求越來越高。然而目前主流的深度估計(jì)方法常由于外界環(huán)境或是成本原因,很難在工程上得以應(yīng)用并達(dá)到相關(guān)需求。

另一方面,目前關(guān)于圖像深度估計(jì)研究很多,可用的公共數(shù)據(jù)集卻相對(duì)較少,且公共數(shù)據(jù)集中的場景相對(duì)不夠豐富,大大限制了深度估計(jì)算法的泛化能力。

OPPO通過自研無監(jiān)督算法,設(shè)計(jì)了適合室內(nèi)場景的模型,能夠在不依賴數(shù)據(jù)標(biāo)注的情況下,顯著提升神經(jīng)網(wǎng)絡(luò)在室內(nèi)場景下的深度估計(jì)效果。這一方面體現(xiàn)了OPPO對(duì)人工智能應(yīng)用場景的理解,也說明了它對(duì)人工智能前沿學(xué)術(shù)問題的獨(dú)特把握。