Apollo Lite三周年:純視覺L4級無人駕駛技術挑戰復雜城市場景

以下內容為百度智能駕駛事業群組技術委員會2020年底發布的內容,原標題《Apollo Lite兩周年:純視覺L4級無人駕駛技術挑戰復雜城市場景》。我們拿出這篇一年前的文章,目的是讓大家更了解百度自動駕駛技術的主要思想,同時與今年的進展做一個比較,會發現,Apollo從技術看上并沒有變化,只是按照既定的規劃推進各方面的落地,諸如威馬W6量產應用AVP、robotaxi正式商業化運行等。

以下為原文全部內容:

編者按:

百度背叛激光雷達路線了嗎?2019年夏的CVPR,純視覺方案Apollo Lite第一次亮相開始,這種猜疑就沒停過。一年后,自動駕駛江湖中的兩條路,愈加清晰分明。

一方面,自動駕駛公司紛紛增加車端激光雷達數量,提升雷達掃描密度,傳感器“軍備競賽”趨勢延續。另一方面,車企基于純視覺方案的“全自動”駕駛功能交付無期。

而百度Apollo Lite,成為了國內唯一純視覺L4級城市道路自動駕駛解決方案。并且Apollo Lite還以自主泊車產品AVP和領航輔助駕駛產品ANP,實現了L4能力的降維商用。

這條純視覺路線背后,百度Apollo究竟有何邏輯?技術和產品上有哪些不為人知的考量?未來又如何落地發展?

在Apollo Lite誕生兩周年之際,沒有人比百度Apollo技術委員會自身,更適合揭秘了。我們邀請他們以第一親歷者身份,完整講訴Apollo Lite相關的一切。

01 為什么是視覺方案?

2019年美國長灘,面對臺下聽眾關于Apollo Lite誕生是否意味著百度將放棄其現有激光雷達技術方案的提問,Apollo技術委員會主席王亮表達了百度的技術主張:“在L4級自動駕駛傳感器選型上,激光雷達和攝像頭不是排它的,也不是單純的從屬或互補關系,從安全性考慮,二者具備相同的重要性和不可替代性,缺一不可。”

談論純視覺方案,一個繞不過去的話題是自動駕駛領域長期存在的路線之爭,一方是以Waymo為代表的Robotaxi陣營,選擇用相對昂貴的旋轉式激光雷達輔以多路攝像頭和毫米波雷達直接落地L4級自動駕駛。

另一邊是以Tesla為代表的漸進式陣營,志在依托海量數據和深度學習從輔助駕駛起步跨越無人鴻溝,其商業模式決定了純視覺方案是兼顧駕駛體驗和成本的產品最優解。

一年后,百度的技術主張發生變化了嗎?長跑途中,百度將如何站隊又選擇了什么技術路線呢?

針對技術路線問題,王亮給出了百度的思考:無人駕駛的規模化落地是一次長征,除有篤定的信念支撐,更要基于正確的路線才能到達目的地。

何謂“正確”?百度眼中,路線設定既不是權衡利弊后的選擇站隊,也不是簡單一句“各取所長,避之所短”,百度尋求的是一條符合國情同時也最適合百度的技術路線。

Robotaxi商業模式驗證途中最大的技術挑戰是 「無人」(去掉安全員),過程中要平衡的兩個關鍵因素是“能力”和“規模”,二者相輔相成,不具備過硬的駕駛能力無法在擴展規模同時保證安全,反之規模跟不上,駕駛系統無法獲得充分驗證。

百度內部牽引研發的兩大核心指標是「安全」和「成本」,安全保障結合有競爭力的成本能夠助力百度盡早跨入規模化運營階段,逐步實現拿掉安全員的終局目標。

為何在激光雷達技術方案進展順利的同時轉向發力純視覺技術?背后的邏輯,與百度的實踐經驗和技術主張密不可分。

激光雷達 – 擁抱生態

年初Waymo推出其第五代自動駕駛傳感器套件,包括對其自研激光雷達的全方位升級。大洋彼岸的Cruise、Argo、Aurora等頭部公司也通過「收購+自研」布局未來的激光雷達產品。

而百度選擇了一種「不一樣」的路線,王亮表示:“Apollo從第一天起就明確走開放道路,百度選擇聚焦自己擅長的事情,我們充分信任合作伙伴的設計制造能力和創新速度,用開放共贏的心態擁抱生態。

與全自研或借收購押注某類原型產品相比,我們相信擁有大規模用戶和成熟供應鏈體系的生態合作伙伴必將迭代出性價比更優的產品,百度愿意在攀峰途中與合作伙伴緊密配合共同成長。

選擇自由 – 拿到視覺船票

激光雷達市場百花齊放,誰家能跑贏Robotaxi商業化階段的規模化量產尚不清晰,缺少自研抓手又如何緊隨行業趨勢適配前沿雷達產品呢?面對不確定性,百度也有自己的思考和應對。

“在我們的技術規劃中,未來百度在激光雷達的選擇上要更從容。重度依賴激光雷達的感知系統面臨的問題之一便是雷達技術的更新換代。當今基于三維點云的環境感知算法已全面擁抱Learning化和數據驅動,感知效果飛速提升同時對標注數據的累積也更加倚重,不輕易更換雷達的顧慮,部分來自傳感器數據變更后給現有感知模型的復用和泛化帶來的挑戰,前期構筑的數據壁壘優勢也難以保持。相比成像原理和時空采樣密度各異的激光雷達,視覺成像技術的發展趨勢清晰,視覺感知在數據標注、數據復用和模型泛化技術上都更加成熟可控。”

百度對視覺技術的布局意圖清晰,通過壓強視覺技術研發獲得純視覺L4級閉環能力意味著拿到了一張船票,讓百度在激烈的自動駕駛技術競爭中保持成本和數據優勢,對激光雷達的選擇更敏捷自由。

冗余 – 做正確的事

使用單傳感器解決復雜的環境感知問題總會遇到短期無法跨越的深溝固壘,對「傳感器融合」五字的理解實踐,業內也不盡相同。

起跑階段,百度和大多數同行今天的做法類似,面對困難選擇做容易的事情,從快速解決問題的目標出發設計融合策略,難免避重就輕地利用異構傳感器各自的優勢進行取長補短,快速收斂問題背后的代價是系統實現維護難度的增加和對安全問題自身可解釋性的忽視,長此以往,借助疊加厚重策略和參數假設解決長尾問題的路徑步履維艱。

在追求自動駕駛安全的實踐中百度對傳感器融合的認知也在發生變化,概率上保證感知結果的可解釋性和完備性意味著多套能夠支撐自動駕駛的感知系統獨立工作相互校驗,融合端減少策略深度耦合引入的數據依賴與人為假設。

大道至簡的思想背后,傳感器間的「主次」概念逐漸淡化,新理念也對單傳感器感知能力提出了更高要求。對于視覺感知,對其作用的定位不再局限于為激光雷達查漏補缺或者解決某些子任務,轉而追求獨當一面的全棧能力。

(完整視頻詳見公眾號)

02 Apollo Lite兩周年畫像

2019年初Apollo Lite啟動了在北京稻香湖路網內的開放道路測試,經過長期實測,對稻香湖道路環境駕輕就熟的Apollo Lite選擇挑戰更復雜的城市道路場景,將2020年的測試區域選在了北京亦莊。

亦莊測試區是當前國內開放的最大規模的L4級別自動駕駛路網,覆蓋了復雜城市道路多種典型場景,包含工業區、生活區、商超等多種城市功能區域,道路場景涵蓋快速路,主干路,次干路、支路和輕軌鐵路等,路網里程322公里,涵蓋110多條道路。

對比稻香湖測試區域,亦莊道路覆蓋里程提升近20倍,站點數量提升50倍,機動車和人流平均密度提升2倍。

經過近一年的技術迭代,Apollo視覺感知能力穩步提升,如今兩周歲的Apollo Lite具備了僅使用10顆攝像頭應對中國復雜城市道路環境的自動駕駛能力。

與一年前相比,純視覺配置的測試車輛規模提升3倍,累計L4閉環測試里程增加18倍,平均送達(無人為干預的點到點自動駕駛)成功率提升60%。

純視覺感知方案有多難?

自動駕駛系統涉及的眾多軟硬件中,傳感器決定了環境建模的方法和效果,對駕駛能力有直接的影響。近年來各家自動駕駛公司持續刷新無人車上路速度和演示難度,他們均采用高線數機械旋轉式激光雷達充當無人車的眼睛,與之相比,打造一套純視覺方案的難度有多高,技術含金量如何體現?

無人駕駛的大腦 – 車輛軌跡速度的決策規劃計算離不開感知模塊實時構建的三維環境,對障礙物位置、尺寸、速度和朝向等屬性的準確性、時空穩定性都有極高的要求。激光雷達作為「主動」成像(Active sensing)傳感器,與攝像頭相比最大的優勢在于其強大的三維測距能力,通過飛行時間(Time-of-Flight)原理能夠在100毫秒內完成對其周邊360°環境的實時建模,測距精度達厘米級。精準的三維信息為物體檢測、跟蹤、分類等任務帶來了便利,大幅度簡化了感知算法的設計實現。

與激光雷達不同,攝像頭成像是“被動”式的(Passive sensing),感光元件僅接收物體表面反射的環境光,三維世界經投影變換(Projective transformation)被“壓縮”到二維相平面上,成像過程中場景“深度”(景深)信息丟失了。

當算法再試圖從二維圖像中恢復目標物體原本在三維空間中所處的位置時,面對的是一個欠約束的“逆問題”(ill-posed inverse problem),其難度可直觀理解為用2個方程式求解3個未知數。

由一張二維圖像恢復場景中的三維信息(「2D-to-3D」)是計算機視覺學科誕生之初定義的經典問題之一,時至今日仍是視覺界熱門研究方向,也是使用攝像頭代替激光雷達為無人駕駛提供感知結果所面臨的核心技術挑戰。

進入技術分享前,先看一段一鏡到底的日常Apollo Lite亦莊路測視頻。視頻中測試區域處于亦莊中心繁華路段,包含兩條路線,累計自動駕駛行駛時長接近60分鐘,全程無接管。

從視頻中可以看出,主車以40公里/小時左右的速度行駛,寬闊道路行駛時速度可提升至55公里/小時以上(亦莊道路限速為60公里/小時)。行駛過程中,主車與其他車輛,行人,自行車和電動車等道路參與者交互頻繁,在成功處理切車、變道、過路口、掉頭、等城市道路基礎交通場景之外,車輛也展示了出色的通行能力和與道路參與者的交互能力,視頻中呈現了其在路樁擺放密集的狹窄路段、施工區域以及雙向單車道上的通行能力,車輛能夠合理避讓車流中橫穿道路的行人和在車流中穿梭的摩托車和電動車。可視化來自車端實時感知結果,視頻內容未經任何剪輯加工,力求客觀真實的呈現完整測試過程。

03 Apollo Lite視覺感知技術揭秘

百度在近一年視覺感知攻堅過程中積累了豐富的實踐經驗并沉淀了有效的方法論,總結下來,三個關鍵技術層面的深耕突破成就了Apollo Lite駕駛能力迅速提升。

2D-to-3D難題

近年來,視覺目標檢測任務伴隨深度學習技術的進步取得了突飛猛進的發展。今天,經對人工標注數據進行監督學習,在圖像上將目標物體(如車輛、行人、自行車等)2D框選出來已經不是視覺感知的頭部難題,單純2D框檢測無法支持3D空間中的車輛規劃控制,打造一套純視覺感知系統,解決2D-to-3D問題首當其沖。

傳統算法計算2D檢測框的框底中心后通過道路平面假設和幾何推理物體深度信息,這類方法簡單輕量,但對2D框檢測完整性和道路的坡度曲率等有較強的依賴假設,對遮擋和車輛顛簸比較敏感,算法欠缺魯棒性,不足以應對復雜城市道路上的3D檢測任務。Apollo Lite延續「模型學習+幾何推理」框架同時對方法細節進行了大量打磨升級。

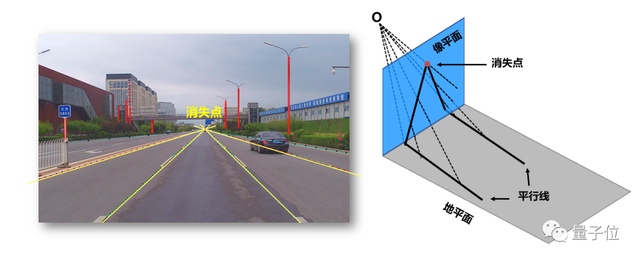

傳統基于地平面假設和相似關系計算2D-to-3D的方法

模型學習 – 數據和學習層面,利用激光雷達的點云數據將2D標注框和3D檢測框關聯,在標注階段為每個2D包圍框賦予了物理世界中的距離、尺寸、朝向、遮擋狀態/比例等信息。

通過從安裝相同攝像頭(Camera configuration)并配備高線數激光雷達的百度L4自動駕駛車隊獲取海量時空對齊的「圖像+點云」數據,訓練階段DNN(Deep neural networks)網絡模型從圖像appearance信息做障礙物端到端的三維屬性預測,模型端完成從僅預測2D結果到學習2D+3D信息的升級,將傳統“幾何推理”后處理模塊的任務大程度向模型端前置,“深度學習+數據驅動”為提升預測效果提供了便捷有效的路徑和更高的天花板。

在添加模型端3D預測能力外,為給后續幾何約束階段提供豐富的圖像線索,針對不同位置/朝向相機的安裝觀測特性,模型從學習障礙物矩形包圍框拓展到預測更多維度更細粒度的特征,如車輪和車底接地輪廓線。

幾何推理– 將模型輸出的圖像視覺特征作為觀測值,障礙物空間位置朝向和尺寸作為未知參數,基于相機姿態和經典投影幾何(Projective geometry)可計算3D到2D的投影。

理想條件下3D元素投影到相機的坐標和2D特征觀測應該重合,由于3D信息預測誤差的存在,模型輸出3D投影和2D圖像觀測會存在一定偏差, 幾何推理的作用是通過場景先驗和視覺幾何原理對模型輸出的障礙物3D初值進行優化,以此得到2D-to-3D的精確結果。

投影計算方程依賴對相機的姿態進行實時估計,理想情況假設相機水平安裝,視線與路面平行,俯仰角接近為0°。車輛行駛中,受地面坡度起伏影響,相機相對地面的姿態不斷變化,精準估計車輛運動中相機俯仰角是求解3D-to-2D投影的必要條件,我們稱這個步驟在線標定。

Apollo Lite在線標定算法并不依賴高精地圖,通過學習道路上線狀特征如車道線和馬路邊沿,擬合出多條空間中的平行線在圖像投影上的交點 — 消失點(Vanishing point),基于透視幾何原理,可精確估計車輛行駛中相機俯仰角的實時變化的情況。

基于車道線和視覺幾何的消失點估計

鎖定相機姿態后,障礙物尺寸是影響3D距離估計的另一關鍵因素。透視投影過程中可解釋成像結果的 “距離x尺寸” 組合并不唯一,因遮擋和圖像截斷存在,從局部2D框學習障礙物尺寸的難度較大,Apollo Lite轉而從 「分類」 視角尋求突破,物理世界中車輛種類(轎車,SUV,公交、卡車……)和其對應物理尺寸是可枚舉的,通過歸納構建維護了一個種類豐富的車輛 “類型x尺寸” 模板庫,模型學習的類型和尺寸信息結合模板庫搜索為障礙物尺寸初值提供了有效約束。

Apollo-lite細分類(fine-grained)車輛模板庫

經過精細化打磨的2D-to-3D算法顯著提升了Apollo Lite在復雜城市道路下的自動駕駛能力和乘坐體驗,因“3D位置估計不準”衍生的駕駛策略缺陷如碰撞風險、急剎等事件發生頻率大幅降低,與之相關的接管頻次和急剎頻次指標分別下降90%和80%,200m內車輛距離估計平均相對距離誤差低于4.5%,行人與非機動車平均相對距離誤差低于5%。

場景語義理解

解決2D-to-3D問題夯實了感知「看見」和「看準」的基礎能力,復雜城市道路對系統「看懂」場景的能力提出了更進一步的要求,根據轉向燈和剎車燈狀態預測前車行為,通過錐筒擺放判斷道路施工并提前繞行,在紅綠燈被前方大車遮擋時根據周邊車輛行為判斷信號燈顏色狀態等都屬讀懂場景的能力,視覺感知系統從像素中挖掘圖像內蘊含的深層信息對提升駕駛智能性和通過性至關重要。

下面重點以交通信號燈識別任務為例,介紹Apollo Lite為應對復雜城市路況所做的部分感知技術升級。

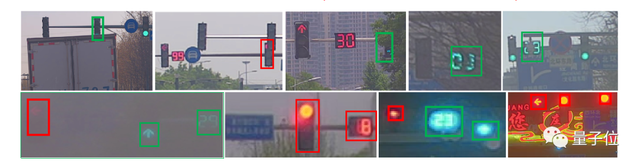

動態語義識別 – 紅綠燈檢測依賴高精地圖為路網內每個燈提供靜態語義標注信息(如3D位置與尺寸,方向控制,車道的綁定關系等),重地圖先驗的模式變相降低了線上感知算法難度,但難以應對信號燈故障和高頻的設備維護和道路變更。

Apollo Lite為此擴充了紅綠燈動態語義識別能力,在不依賴地圖前提下,一方面支持檢測場景中出現的各類臨時紅綠燈,輸出2D燈桿/燈框、距離、燈頭顏色等屬性,另一方面,擴充了語義理解的維度,在此前單一單幀燈色識別基礎上把時序燈色變化過程蘊含的語義考慮進來,新增加倒計時、轉向燈、燈色閃爍模式、故障燈語義等場景理解能力,不依賴地圖實時更新亦能第一時間適應道路上的變更,為決策規劃提供信號燈全語義輸出。

紅綠燈動態語義識別(移動紅綠燈,多語義燈,故障燈等)

可通行性推理 – 行駛在復雜城市道路中,交通信號燈在相機中全程可見難以獲得保證,遮擋、逆光、雨霧模糊等情況下要求感知系統具備人類司機的推理邏輯,為此Apollo Lite感知補充了信號燈推理功能。

紅綠燈通行性推理場景(動靜態遮擋,霧天/雨天/夜晚/背景干擾問題等)

首先,增加算法對自身感知結果置信度的精準評估能力,在觀測量不完全或者攝像頭成像不理想情況下,切換到推理模式。該模式下算法結合車身周邊障礙物運動信息提取車流軌跡,配合 對路口其它高置信可見燈的狀態和語義分析,通過融合多路信息學習路口可通行性,預測燈色,有效保證了在觀測數據不完整情況下信號燈顏色仍能被正確識別。

得益于以上場景語義解讀能力的升級,Apollo Lite在城市道路的通行能力獲得進一步提高,單位測試里程內,因信號燈被遮擋導致的主車急剎和不合理停滯等問題減少近3倍,因信號燈感知錯誤造成的路口通過失敗問題減少近10倍。

數據驅動的迭代模式

數據閉環自動化是近年業內高頻提及的概念,“數據驅動算法”、“自動化解決問題”、“跨量級降低L4成本”等傳播數據即能力的理念流傳甚廣,行業對數據的預期水漲船高。

是否擁有了海量數據就等同于能自動邁進完全無人駕駛?一個靠數據驅動的系統如何打造?拋開技術理念與愿景,下面從「數據實踐」和「數據組織能力建設」的角度跟讀者分享百度在邁向「數據轉化成駕駛能力」道路上的經驗認知。

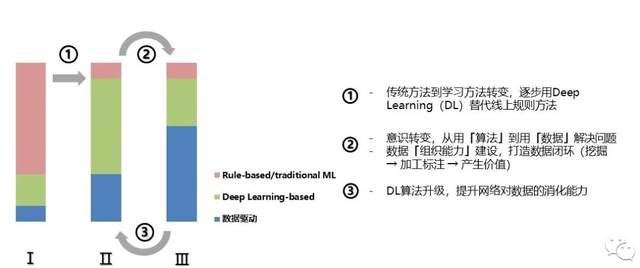

回顧百度7年自動駕駛技術發展歷程,我們將研發迭代模式定義成三階段,每個階段對應的場景,對人才結構和組織能力的需求不盡相同。

研發模式迭代定義三階段,從基于規則和傳統機器學習方法逐步向數據驅動演進

階段Ⅰ – 此時數據基礎設施建設相對薄弱,系統內Deep Learning化模塊/功能占比較低,研發主力是已在某領域經過長期系統化訓練的算法專家,他們用計算機語言將掌握的專業知識轉化為功能性確定的代碼,我們內部稱這類初期算法「Rule-based」和「Traditional Machine Learning」方法。

“Rule”中包含人為設定的規則和對物理世界的經驗假設,以車道線檢測任務為例,經典計算機視覺算法能夠不依賴標注數據,僅使用梯度計算,邊緣檢測算子和曲線擬合等經典技術完成車道線提取。

Rule-based方法優勢是不依賴數據的積累標注,過擬合有限場景比較有效,算法從研發到上路速度快,適用于prototype演示階段的研發迭代。

另一方面,規則假設引入大量人工參數和判斷條件,不利于業務需求增加測試規模擴大后的技術泛化以及場景拓展。

Traditional Machine Learning方法如SVM和Random Forest等開始利用數據解決問題,這類方法對特征設計依賴強,研發人員需要具備對數據特征較強的直覺和洞察力。

此外,它們的淺層模型結構對數據的消化能力有限,大數據在任務上存在過擬合,并不能很好的解決復雜的自動駕駛問題。

階段Ⅱ– 這一階段圍繞數據所做的基礎設施建設趨于完善,數據采集流程和標注規則明確,配套的數據標注工具和標注分發體系使用穩定,數據質量以及數據獲取效率相比Ⅰ階段有質的提升。

此時研發人員有意識的用深度學習思想重新審視線上Rule-based和Traditional Machine Learning方法,積極嘗試用神經網絡(DNN)對舊方法進行改造替換。

數據獲取的便捷讓技術人員在面對新需求新任務時更多轉向深度學習,過去系統內基于規則和傳統學習方法實現的算法逐漸被深度學習擠壓取代,特別是人工設計的后處理步驟大幅減少,策略和參數被「固化」,規避依靠頻繁刪減策略和調參解決問題。

搭建規模化機器學習系統 – 高效率消化規模化測試中產生的海量數據

人才結構方面,研發主力為有經驗的深度學習專家,此階段研發人員的核心工作可歸納為兩方面:

1)根據任務制定標注規則,提出數據采集標注需求,完成網絡結構選擇或設計,訓練并部署復雜的深度學習模型;

2)無人駕駛對計算實時性有著嚴苛要求,車載計算資源有限,鑒于DNN計算量大,算法上線前需要壓縮模型以減小對于計算時間和空間的消耗。

數據在第二階段起到更重要的作用,增加訓練數據量可有效提升模型效果。數據獲取方式以定制化采集任務為主,重視數據規模和廣度,如視覺感知數據可按地理位置、時間、天氣等若干維度組合采樣,保證訓練數據對應用場景的全面均勻覆蓋。

階段Ⅲ – 經過長時間規模化道路測試,各類任務對應的模型網絡結構相對固定,模型預測頭部問題收斂到特定的場景。

此時,技術團隊工作的重心轉入對數據鏈路的精細化管理、對數據多樣性和數據分布合理性的深耕以及對數據平臺化能力的建設上。這一階段要求研發人員的思維模式發生轉變,從「設計算法解決問題」過渡至「用數據解決問題」。

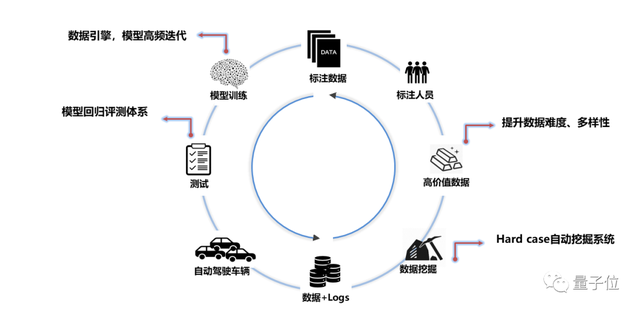

思維工作模式的變化帶來對組織能力更高的要求。促成數據到模型能力的高效流轉首先需要搭建一套中心化框架平臺,將工程團隊擅長的自動化、分布式和高并發與算法團隊長期沉淀的經驗與代碼相結合,從車端數據logging系統設計,到有效數據的挖掘清洗和離線標注,最后到模型的訓練迭代和評測部署,構成一個閉環結構。

借助平臺,算法人員的精力最大化投入到數據分析和標注策略設計中,新團隊成員通過使用平臺提供的功能接口也能更高效的產出模型,減少學習成本,人員的單體經驗差異被抹平,數據組織能力上升到一個新高度。

精準數據挖掘– 進入第三階段,單純追求訓練數據規模已無法有效提升網絡性能,Apollo Lite視覺感知10路攝像頭每秒共產生大于1GB的圖像數據,若不加選擇的收集使用,不僅存儲標注成本巨大,從模型迭代效率考慮同樣不現實。如果把數據比喻成深度學習的原礦石,該階段我們需要設計一套「煉金術」從中提煉出對模型迭代最有效的信息。

Apollo Lite提煉數據背后思想簡單有效 – 「Cross checking」 ,真實物理世界是連續的,物體不會憑空出現或消失,不同位置類型傳感器間的觀測應是「自洽」的。

當感知系統的觀測違背基本物理假設時,大概率對應這一時刻的模型輸出缺陷。基于Cross checking原理,Apollo Lite視覺感知系統內設計實現了多層次挖掘策略,從單幀到連續幀時序,從單攝像頭到多相機融合,從感知結果到地圖標注和安全員行為校驗,每一環節都能夠通過觀測量間的自洽性判斷精準定位線上模型的潛在缺陷,發掘長尾數據,通過logging標簽自動映射數據和對應的模型任務。

今天,參與Apollo Lite關鍵感知模型迭代的新增數據中超過80%來自線上數據挖掘,是一年前的3倍。Cross checking本身是一個在圖像區域內定位問題的過程,挖掘數據配套的標注策略不需面向全幀,從而更輕量經濟,帶來近6倍標注效率提升。

高效規模化機器學習– 路測產生的海量數據配合精準挖掘與高度Learning化的感知框架是Apollo Lite持續進化的基礎。Apollo Lite視覺系統由31個深度神經網絡構成,能夠實時處理10路高清視頻數據,并輸出超過200組感知信息。

為了在車載計算單元的有限算力上完成如此龐大的視覺信息處理任務,Apollo Lite充分發掘子任務之間的相關性,設計出層次化的特征共享結構,采用共享子網絡的方式來降低計算量。

Apollo Lite視覺神經網絡系統

共享特征網絡在提升推理效率的同時,也增加了感知任務之間的耦合度。而不同感知任務在數據規模、輸入輸出形式、優化目標等方面都存在不同程度的差異,這給離線訓練帶來了巨大挑戰。

為解決異構數據的訓練問題,Apollo Lite搭建了一套分布式多任務模型訓練框架,自適應采樣不同任務的數據送入訓練,激活其對應的網絡子集并計算損失,然后統一更新共享的網絡參數。

Apollo Lite多任務訓練框架

依托強大的機器學習基礎設施以及持續、精準的數據,Apollo Lite關鍵模型迭代效率相比19年初提升了近4倍,千萬量級訓練數據上的多任務模型同步更新能夠在1周之內完成。

回到本節開篇的問題 – 是否擁有了海量數據就等同于自動邁進完全無人駕駛?

04 結尾與展望

再先進的技術長時間脫離產品和用戶也是孤立的,在領航輔助駕駛產品競爭白熱化的今天,百度將Apollo Lite視覺感知技術從L4應用降維至L2+級領航輔助駕駛,打造覆蓋“泊車域+行車域”的城市全場景智能駕駛一體化解決方案 – Apollo智駕產品ANP(Apollo Navigation Pilot)。

我們并不想急于下結論,畢竟數據的想象空間巨大有待深入挖掘,但可以肯定并和讀者分享的是實踐求真的道路并非一些技術文案描寫的那樣一蹴而就。

數據閉環對業務產生的價值是技術持續跟蹤的指標。以數據挖掘環節為例,除關注新模型在此前挖掘積累的bad case上的累計修復率外,測試車輛在挖掘規則固定前提下的挖掘量也是考核閉環效果的重要參考。我們希望看到模型迭代帶動修復率攀升,同時規模化路測階段同類問題的復現率持續走低。

通過指標跟蹤分析,能夠看到數據閉環價值在一部分感知任務上呈現了明顯的增長趨勢。但也存在一部分任務進入了依靠單純灌入數據已無法維持收益增長的階段,此時研發人員需重新審視數據鏈條上的環節,從階段Ⅲ退回到階段Ⅱ,回歸到對標注規則的研究或新的網絡結構設計這些偏基礎的工作中。

相信如何有效獲取數據并將之轉化成可被感知的駕駛能力會是伴隨Apollo Lite成長的長期技術問題,需要技術團隊沉下心來通過實踐逐步打通這條數據通路。

Apollo Lite兩輕一強的技術特點可以極好的融入產品,「輕傳感器、輕算力」面對規模量產無懼成本壓力,同時「強感知能力」能夠助力ANP應對城市道路駕駛中的各類復雜場景。

自動駕駛是公認的智能汽車決勝點,正引領新一輪體驗升級。

在ANP廣州發布之后,國內也有媒體評價說,百度Apollo的純視覺自動駕駛產品發布,對特斯拉是一次“奇襲”,因為Apollo生態開放的特性,可以更快實現特斯拉一樣的智能駕駛能力,類似于Apollo+車廠的安卓生態,會跟特斯拉FSD封閉的iOS生態形成抗衡。

雖然這樣的類比可以讓更多人形象的看到業態,但坦率的說,Apollo Lite更主要的是提供了特斯拉FSD和Mobileye之外的國產選擇,或許“三足鼎立”更合適。

雖然今天的Apollo Lite只有兩歲,但它無疑已經站在了潮頭浪尖。