觸覺從未如此真實!兩位南加州大學華人博士革新「觸覺感知」算法

電子技術的發展,讓我們可以隨時隨地享受一場「視聽盛宴」,人類的聽覺和視覺從此徹底解放。

近幾年,給設備裝上「觸覺」逐漸成了新的研究熱點,尤其是在「元宇宙」概念的加持下,加上觸感無疑能讓虛擬世界的真實感大大提升。

當下觸覺感知技術主要是通過「數據驅動」的模式來模擬和渲染觸感,模型首先記錄下用戶與真實紋理交互的信號,然后將信號輸入到紋理生成部分,并用振動的方式將觸感「回放」給用戶。

最近一些方法大多基于用戶交互運動和高頻振動信號來對紋理的特征進行建模,比如摩擦和微觀表面特征。

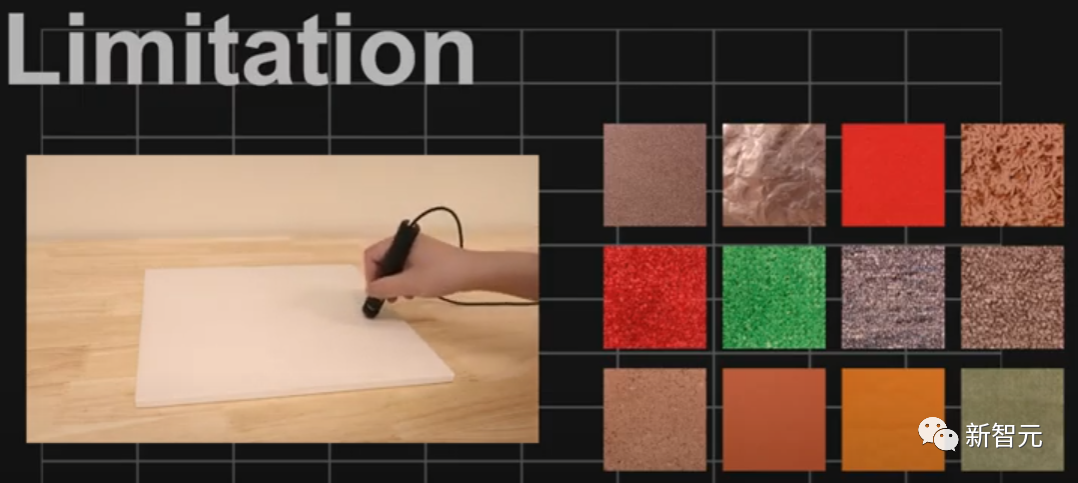

雖說數據驅動極大提升了模擬的真實感,但仍然存在諸多限制。

比如世界上的紋理可以說是有「無數種」,如果每種紋理都記錄一遍,所需的人力、物力都不可想象,也無法滿足一些小眾用戶的需求。

人類對于觸覺的感知相當敏感,不同的人對于相同物體的感覺也不同,數據驅動的方式無法從根本上消除從紋理記錄到紋理渲染的感知不匹配問題。

最近,南加州大學維特比工程學院的三個博士生提出了一種全新的「偏好驅動」模型框架,利用人類分辨紋理細節的能力對生成的虛擬感知進行調整,最終可以達到相當逼真的觸覺感知,論文發表在IEEE Transactions on Haptics.

論文鏈接:https://ieeexplore.ieee.org/document/9772285

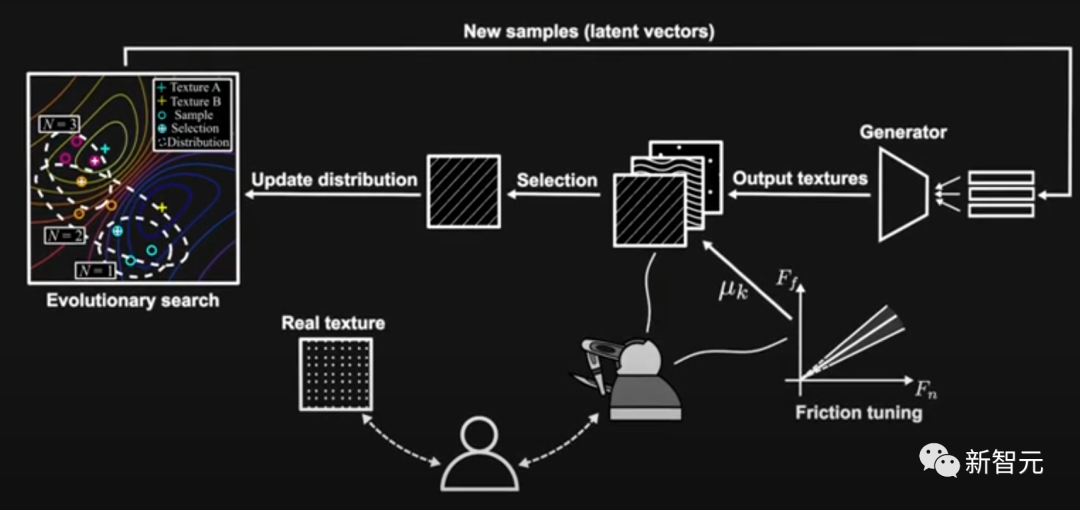

偏好驅動的模型首先會給用戶一個真實的觸摸紋理,然后模型會使用幾十個變量隨機生成三個虛擬紋理,然后用戶可以從中選擇摸起來與真實物體最相似的一個紋理。

隨著不斷地試錯和反饋,模型會通過搜索不斷優化變量的分布,使得生成的紋理更接近用戶的偏好。這種方法比直接記錄、回放紋理具有明顯優勢,因為計算機讀取的內容和人類的真實感受之間總是存在差距。

這個流程實際上跟「甲方乙方」差不多,我們作為感知者(甲方),如果覺得觸摸感不對勁,就打回去,讓算法(乙方)修改重新生成,直到生成的效果滿意為止。

這樣做實際上很合理,因為不同的人摸相同的物體都會有不同的感覺,但計算機釋放的信號卻是相同的,所以根據每個人進行觸感定制,很有必要!

整個系統由兩個模塊組成,首先是一個深度卷積生成對抗網絡(DCGAN),用于將潛空間的向量映射到紋理模型,在UPenn Haptic Texture Toolkit (HaTT)上進行訓練。

第二個模塊是一個基于比較的進化算法:一組生成的紋理模型中,協方差矩陣適應進化策略(CMA-ES)會根據用戶的偏好反饋創建一個新的紋理模型以進化。

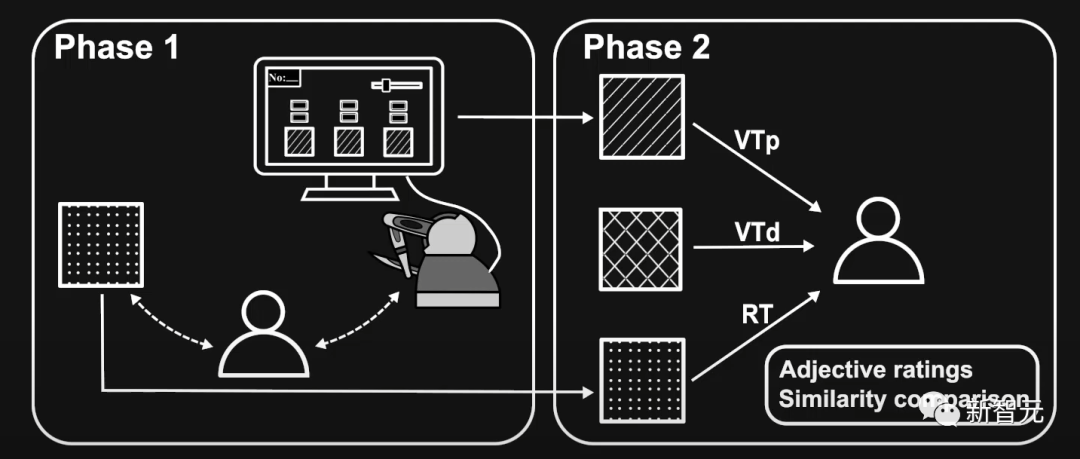

為了模擬真實紋理,研究人員首先會要求用戶使用定制工具來觸摸真實紋理,然后使用觸覺設備觸摸一組虛擬紋理候選,其中觸覺反饋通過連接到設備觸控筆的Haptuator來傳輸。

用戶唯一需要做的就是選擇最接近真實紋理的虛擬紋理,并使用簡單的滑塊接口來調整摩擦量(amount of friction),因為摩擦對于紋理觸感來說至關重要,也可能因人而異。

然后所有的虛擬紋理將根據用戶的選擇按照進化策略進行更新,然后用戶再次進行選擇和調整。

重復上述過程,直到用戶找到他們認為的接近真實紋理的虛擬紋理并保存,或者找不到更接近的虛擬紋理為止。

研究人員將評估過程分為兩個階段,每個階段分別有一組參與者。

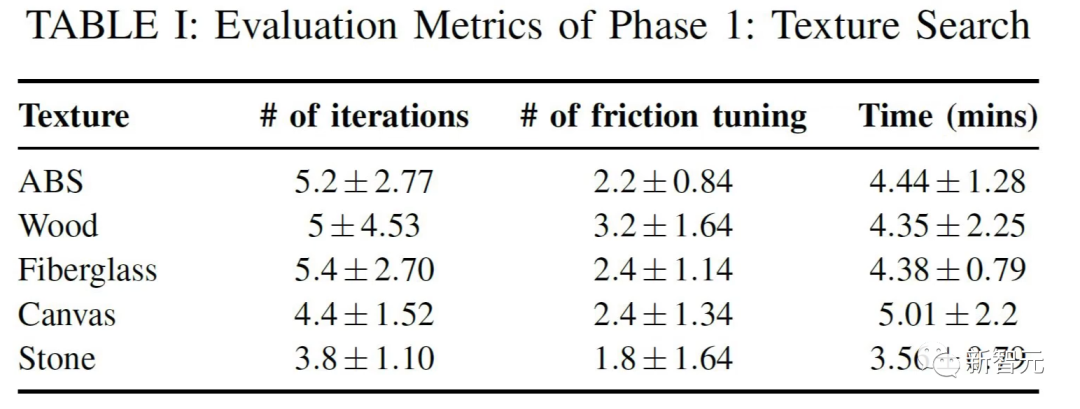

在第一階段,五名參與者分別為5個真實紋理生成和搜索虛擬紋理。

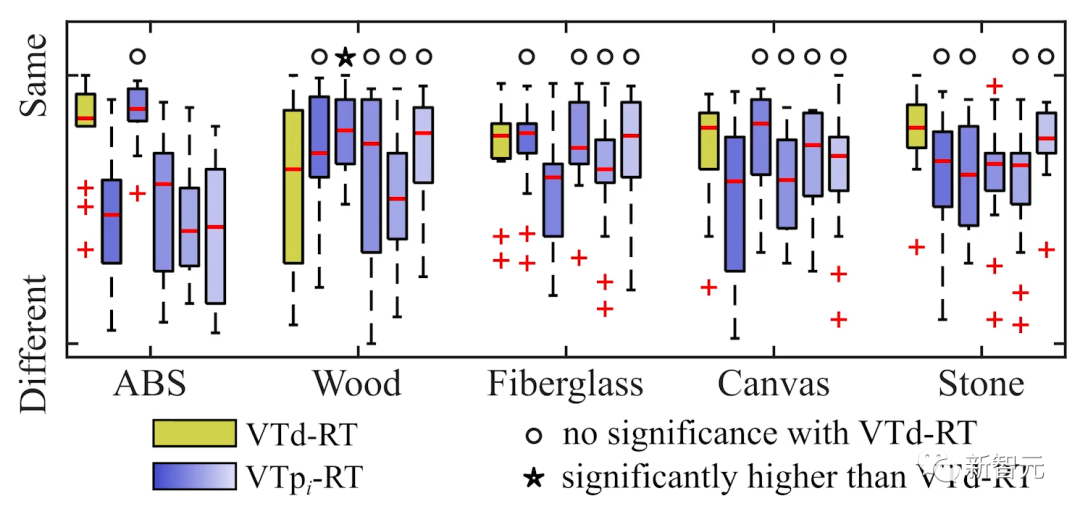

第二階段則是評估最終保存的偏好驅動紋理(VTp)及其相應的真實紋理(RT)之間的差距。

評估的方式主要采用形容詞評價(adjective rating)的方式,對包括粗糙度、硬度和光滑度等感知維度進行評估。

并且在VTp、RT和數據驅動的紋理(VTd)之間的相似性進行比較。

實驗結果也表明遵循進化的過程,用戶能夠有效地找到一個虛擬紋理模型,真實程度超過數據驅動模型。

此外,超過80%的參與者認為偏好驅動模型生成的虛擬紋理評級要優于數據驅動模型。

觸覺設備在視頻游戲、時裝設計和手術模擬中越來越受歡迎,即使在家里,我們也開始看到用戶使用與筆記本電腦一樣流行的那些觸覺設備。

比如第一人稱視頻游戲加入觸覺以后,會極大提升玩家的真實感。

論文作者表示,當我們通過工具與環境交互時,觸覺反饋只是一種形式,一種感官反饋,音頻是另一種感官反饋,兩者都非常重要。

除了游戲外,這項工作成果對于用于牙科或手術培訓的虛擬紋理尤其有用,這些虛擬紋理需要非常準確。

「外科訓練絕對是一個巨大的領域,需要非常逼真的紋理和觸覺反饋;裝修設計還需要在開發過程中對質地進行高度精確地模擬,然后再進行制造。」

從電子游戲到時裝設計,一切都在集成觸覺技術,而現有的虛擬紋理數據庫可以通過這種用戶偏好方法得到改進。

紋理搜索模型還可以讓用戶從數據庫中提取虛擬紋理,例如賓夕法尼亞大學的觸覺紋理工具包,可以對其進行改進,直到獲得他們想要的結果。

這項技術與紋理搜索模型一結合,那你就可以使用之前別人已經記錄完成的虛擬紋理,然后根據策略來優化紋理。

作者暢想,在未來,模型甚至可能不需要真實的紋理。

我們生活中的一些常見事物的感覺是非常直觀的,我們天生就可以通過查看照片來微調自己的感官,而無需參考真實的紋理。

比如當我們看到一張桌子時,我們可以想象一旦觸摸到這張桌子會有什么感覺,利用我們對表面的這種先驗知識,就可以向用戶提供視覺反饋,并允許他們選擇匹配的內容。

文章的第一作者Shihan Lu目前是南加州大學計算機科學學院的博士研究生,之前在沉浸式技術方面做過聲音方面的相關工作,即通過在工具與其交互時引入匹配的聲音,使虛擬紋理更加身臨其境。

文章的的第二作者Mianlun Zheng(鄭棉侖)是南加州大學計算機科學學院的博士研究生,本科和碩士畢業于武漢大學。

? ?