Google AI年終總結(jié)第六彈:沒(méi)有波士頓動(dòng)力的谷歌機(jī)器人,發(fā)展得怎么樣了?

波士頓動(dòng)力的一個(gè)后空翻,讓我們看到了人造機(jī)器人所帶來(lái)的無(wú)限可能。?

盡管谷歌已于2017年把波士頓動(dòng)力出手了,但谷歌仍然繼續(xù)他們的機(jī)器人開(kāi)發(fā)之路,不只是在「身體」上逼近人類,在「智力」也追求更好的理解人類指令。

由Jeff Dean領(lǐng)銜的Google Research年終總結(jié)系列「Google Research, 2022 & beyond」已經(jīng)更新到第六期,本期的主題是「機(jī)器人」,作者為高級(jí)產(chǎn)品經(jīng)理 Kendra Byrne和谷歌機(jī)器人研究科學(xué)家Jie Tan

?在我們的有生之年,一定能看到機(jī)器人技術(shù)參與到人類的日常生活中,幫助提高人類的生產(chǎn)力和生活質(zhì)量。

在機(jī)器人技術(shù)廣泛應(yīng)用于以人為中心的空間(即為人而設(shè)計(jì)的空間,而不是機(jī)器)中的日常實(shí)際工作之前,需要確保它們能夠安全地為人們提供幫助。

在2022年,谷歌關(guān)注的挑戰(zhàn)是使機(jī)器人更有助于人類:

- 讓機(jī)器人和人類更有效和自然地交流;

- 使機(jī)器人能夠理解和應(yīng)用現(xiàn)實(shí)世界中的常識(shí)知識(shí);

- 擴(kuò)大機(jī)器人在非結(jié)構(gòu)化環(huán)境中有效執(zhí)行任務(wù)所需的低層次技能的數(shù)量。

當(dāng)LLM遇上機(jī)器人

大型語(yǔ)言模型(LLM)的一個(gè)特性是能夠?qū)⒚枋龊蜕舷挛木幋a成「人和機(jī)器都能理解」的格式。

當(dāng)把LLM應(yīng)用到機(jī)器人技術(shù)中時(shí),可以讓用戶僅通過(guò)自然語(yǔ)言指令就能給機(jī)器人分配任務(wù);當(dāng)與視覺(jué)模型和機(jī)器人學(xué)習(xí)方法相結(jié)合時(shí),LLM 為機(jī)器人提供了一種理解用戶請(qǐng)求的上下文的方法,并能夠?qū)ν瓿烧?qǐng)求所采取的行動(dòng)進(jìn)行規(guī)劃。

其中一個(gè)基本方法是使用 LLM 來(lái)提示其他預(yù)先訓(xùn)練的模型獲取信息,以構(gòu)建場(chǎng)景中正在發(fā)生的事情的上下文,并對(duì)多模態(tài)任務(wù)進(jìn)行預(yù)測(cè)。整個(gè)過(guò)程類似于蘇格拉底式的教學(xué)方法,教師問(wèn)學(xué)生問(wèn)題,引導(dǎo)他們通過(guò)一個(gè)理性的思維過(guò)程來(lái)解答。

在「蘇格拉底模型」中,研究人員證明了這種方法可以在zero-shot圖像描述和視頻文本檢索任務(wù)中實(shí)現(xiàn)最先進(jìn)的性能,并且還能支持新的功能,比如回答關(guān)于視頻的free-form問(wèn)題和預(yù)測(cè)未來(lái)的活動(dòng),多模態(tài)輔助對(duì)話,以及機(jī)器人感知和規(guī)劃。

論文鏈接:https://arxiv.org/abs/2204.00598

在「邁向有益的機(jī)器人: 機(jī)器人可用性的基礎(chǔ)語(yǔ)言」一文中,研究人員與Everyday Robots合作,在機(jī)器人可用性模型中基于PaLM語(yǔ)言模型規(guī)劃長(zhǎng)期任務(wù)。

博客鏈接:https://ai.googleblog.com/2022/08/towards-helpful-robots-grounding.html

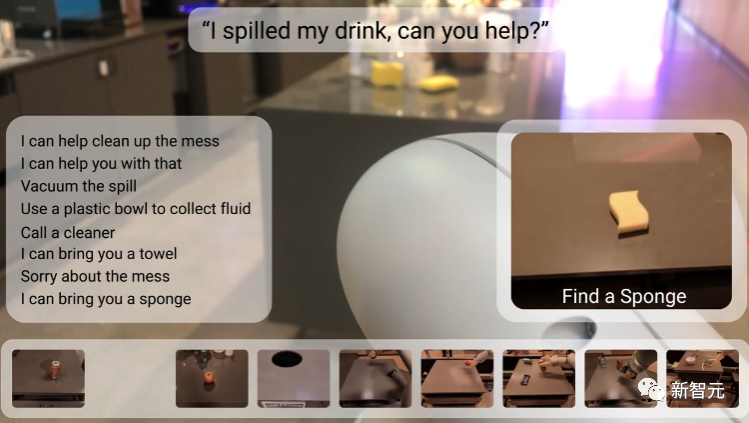

在之前的機(jī)器學(xué)習(xí)方法中,機(jī)器人只能接受諸如「撿起海綿」等簡(jiǎn)短的硬編碼命令,并且難以推理完成任務(wù)所需的步驟,如果任務(wù)是一個(gè)抽象的目標(biāo),比如「你能幫忙清理這些灑出來(lái)的東西嗎?」,就更難處理了。

研究人員選擇使用 LLM 來(lái)預(yù)測(cè)完成長(zhǎng)期任務(wù)的步驟順序,以及一個(gè)表示機(jī)器人在給定情況下實(shí)際能夠完成的技能的affordance 模型。

強(qiáng)化學(xué)習(xí)模型中的價(jià)值函數(shù)可以用來(lái)建立affordance 模型,即一個(gè)機(jī)器人在不同狀態(tài)下可以執(zhí)行的動(dòng)作的抽象表示,從而將現(xiàn)實(shí)世界中的長(zhǎng)期任務(wù),如「整理臥室」與完成任務(wù)所需的短期技能,如正確挑選、放置和安排物品等聯(lián)系起來(lái)。

論文鏈接:https://arxiv.org/abs/2111.03189

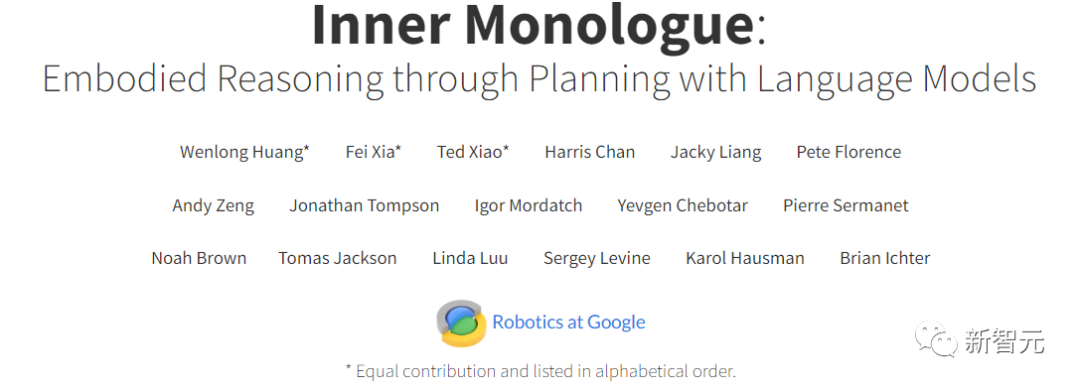

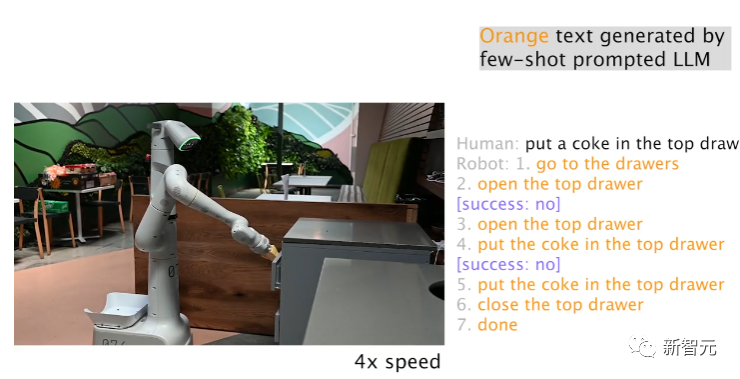

同時(shí)擁有 LLM 和affordance 模型并不意味著機(jī)器人能夠成功地完成任務(wù),通過(guò)內(nèi)心獨(dú)白( Inner Monologue),可以結(jié)束基于 LLM 的任務(wù)規(guī)劃中的循環(huán);利用其他信息來(lái)源,如人工反饋或場(chǎng)景理解,可以檢測(cè)機(jī)器人何時(shí)無(wú)法正確完成任務(wù)。

論文鏈接:https://arxiv.org/abs/2207.05608

利用Everyday Robots中的一個(gè)機(jī)器人,研究人員發(fā)現(xiàn) LLM 可以有效地重新規(guī)劃當(dāng)前或以前的失敗計(jì)劃步,機(jī)器人可以從失敗中恢復(fù)并完成復(fù)雜的任務(wù),比如「把一個(gè)可樂(lè)放在最上面的抽屜里」。

在基于 LLM 的任務(wù)規(guī)劃中,其中一個(gè)突出能力就是機(jī)器人可以對(duì)高級(jí)目標(biāo)中間任務(wù)的變化做出反應(yīng):例如,用戶可以告訴機(jī)器人在發(fā)生的事,通過(guò)提供快速糾正或重定向機(jī)器人到另一個(gè)任務(wù),從而可以改變已經(jīng)規(guī)劃好的行動(dòng),對(duì)于讓用戶交互式地控制和定制機(jī)器人任務(wù)特別有用。

雖然自然語(yǔ)言使人們更容易指定和修改機(jī)器人的任務(wù),但還有一個(gè)挑戰(zhàn)是對(duì)人類描述做出實(shí)時(shí)反應(yīng)。

研究人員提出了一個(gè)大規(guī)模的模仿學(xué)習(xí)框架,用于生產(chǎn)實(shí)時(shí)的、開(kāi)放詞匯的、以語(yǔ)言為條件的機(jī)器人,能夠處理超過(guò)87,000個(gè)獨(dú)特的指令,估計(jì)平均成功率為93.5% ;作為該項(xiàng)目的一部分,谷歌還發(fā)布了當(dāng)下規(guī)模最大的語(yǔ)言標(biāo)注機(jī)器人數(shù)據(jù)集 Language-Table

論文鏈接:https://arxiv.org/pdf/2210.06407.pdf

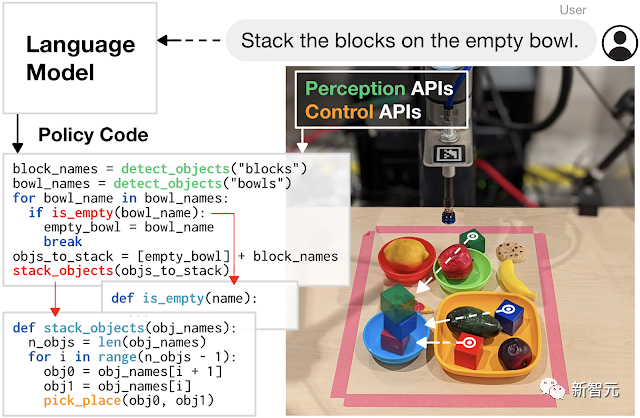

并且,用LLM 編寫代碼來(lái)控制機(jī)器人動(dòng)作也是一個(gè)有前景的研究方向。

研究人員開(kāi)發(fā)的代碼編寫方法展示了增加任務(wù)復(fù)雜性的潛力,機(jī)器人可以通過(guò)自主生成新代碼來(lái)重新組合 API 調(diào)用,合成新函數(shù),并表達(dá)反饋循環(huán)來(lái)在運(yùn)行時(shí)合成為新行為。

論文鏈接:https://arxiv.org/abs/2209.07753

將機(jī)器人學(xué)習(xí)轉(zhuǎn)化為一個(gè)可擴(kuò)展的數(shù)據(jù)問(wèn)題

大型語(yǔ)言和多模態(tài)模型可以幫助機(jī)器人理解他們操作的環(huán)境,比如場(chǎng)景中發(fā)生了什么以及機(jī)器人應(yīng)該做什么;但是機(jī)器人也需要低層次的物理技能來(lái)完成物理世界中的任務(wù),比如拾起和精確放置物體。

雖然人類經(jīng)常認(rèn)為這些身體技能是理所當(dāng)然的,無(wú)需思考的情況下就能完成各種動(dòng)作,但對(duì)機(jī)器人來(lái)說(shuō)卻是個(gè)難題。

比如,機(jī)器人在拾取物體時(shí),需要感知和理解環(huán)境,推導(dǎo)出手爪與物體之間的空間關(guān)系和接觸動(dòng)力學(xué),精確地驅(qū)動(dòng)高自由度手臂,并施加適當(dāng)?shù)牧α恳苑€(wěn)定地抓取物體而不破壞物體。

學(xué)習(xí)到這些低層次技能的難題被稱為莫拉維克悖論:推理只需要很少的計(jì)算,但感覺(jué)運(yùn)動(dòng)和知覺(jué)技能需要大量的計(jì)算資源。

受到 LLM 的成功啟發(fā),研究人員采用一種數(shù)據(jù)驅(qū)動(dòng)的方法,將學(xué)習(xí)低層次物理技能的問(wèn)題轉(zhuǎn)變?yōu)橐粋€(gè)可擴(kuò)展的數(shù)據(jù)問(wèn)題:LLM 表明,大型Transformer模型的通用性和性能隨著數(shù)據(jù)量的增加而增加。

論文鏈接:https://robotics-transformer.github.io/assets/rt1.pdf

研究人員提出機(jī)器人Transformer -1 (RT-1) 模型,訓(xùn)練了一個(gè)機(jī)器人操作策略,用到的訓(xùn)練數(shù)據(jù)為13萬(wàn)個(gè)episodes的大規(guī)模現(xiàn)實(shí)世界的機(jī)器人數(shù)據(jù)集,使用了來(lái)自Everyday Robots的13個(gè)機(jī)器人,覆蓋了700多個(gè)任務(wù),并顯示了機(jī)器人技術(shù)的相同趨勢(shì),即增加數(shù)據(jù)的規(guī)模和多樣性可以提高模型對(duì)新任務(wù)、環(huán)境和對(duì)象的泛化。

在語(yǔ)言模型和機(jī)器人學(xué)習(xí)方法(如 RT-1)的背后,都是 Transformer模型基于互聯(lián)網(wǎng)規(guī)模的數(shù)據(jù)訓(xùn)練得到的;但與 LLM 不同的是,機(jī)器人學(xué)面臨著不斷變化的環(huán)境和有限計(jì)算的多模態(tài)表示的挑戰(zhàn)。

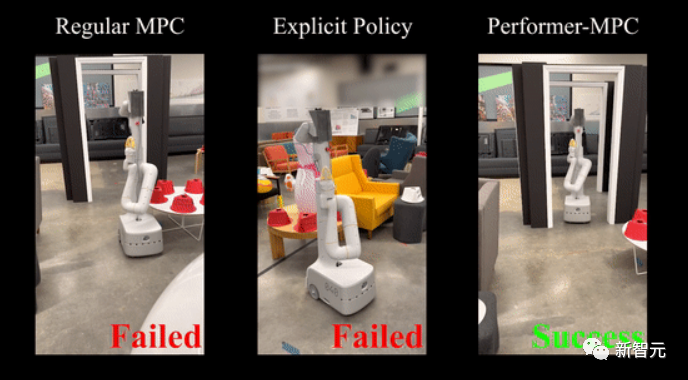

2020年,谷歌提出了一種能夠提高Transformer計(jì)算效率的方法Performers,影響到包括機(jī)器人技術(shù)在內(nèi)的多個(gè)應(yīng)用場(chǎng)景。

最近研究人員擴(kuò)展該方法,引入一類新的隱式控制策略,結(jié)合了模擬學(xué)習(xí)的優(yōu)勢(shì)和對(duì)系統(tǒng)約束的魯棒處理(模型預(yù)估計(jì)控制的約束)。

論文鏈接:https://performermpc.github.io/

與標(biāo)準(zhǔn)的 MPC 策略相比,實(shí)驗(yàn)結(jié)果顯示機(jī)器人在實(shí)現(xiàn)目標(biāo)方面有40% 以上的進(jìn)步,在人類周圍導(dǎo)航時(shí),social指標(biāo)上有65% 以上的提升;Performance-MPC 為8.3 M 參數(shù)模型的延遲僅為8毫秒,使得在機(jī)器人上部署Transformer變得可行。

谷歌的研究團(tuán)隊(duì)還證明,數(shù)據(jù)驅(qū)動(dòng)方法通常適用于不同環(huán)境中的不同機(jī)器人平臺(tái),以學(xué)習(xí)范圍廣泛的任務(wù),包括移動(dòng)操作、導(dǎo)航、運(yùn)動(dòng)和乒乓球等,也為學(xué)習(xí)低層次機(jī)器人技能指明了一條明確的道路:可擴(kuò)展的數(shù)據(jù)收集。

與互聯(lián)網(wǎng)上豐富的視頻和文本數(shù)據(jù)不同,機(jī)器人數(shù)據(jù)極其稀缺,難以獲取,收集和有效使用代表真實(shí)世界交互的豐富數(shù)據(jù)集的方法是數(shù)據(jù)驅(qū)動(dòng)方法的關(guān)鍵。

仿真是一種快速、安全和易于并行化的選擇,但是在仿真中很難復(fù)制完整的環(huán)境,特別是物理環(huán)境和人機(jī)交互環(huán)境。

論文鏈接:https://arxiv.org/abs/2207.06572

在 i-Sim2Real 中,研究人員展示了一種方法,通過(guò)從簡(jiǎn)單的人類行為模型中自舉,并在模擬訓(xùn)練和在現(xiàn)實(shí)世界中部署之間交替進(jìn)行,來(lái)解決仿真與現(xiàn)實(shí)之間的不匹配問(wèn)題,并學(xué)習(xí)與人類對(duì)手打乒乓球,在每次迭代中,人類行為模型和策略都會(huì)得到細(xì)化。

雖然模擬可以輔助收集數(shù)據(jù),但是在現(xiàn)實(shí)世界中收集數(shù)據(jù)對(duì)于微調(diào)模擬策略或在新環(huán)境中適應(yīng)現(xiàn)有策略至關(guān)重要。

在學(xué)習(xí)過(guò)程中,機(jī)器人很容易失敗,并可能會(huì)對(duì)它自身和周圍環(huán)境造成損害,特別是在探索如何與世界互動(dòng)的早期學(xué)習(xí)階段,需要安全地收集訓(xùn)練數(shù)據(jù),使得機(jī)器人不僅學(xué)習(xí)技能,還可以從故障中自主恢復(fù)。

論文鏈接:https://arxiv.org/abs/2110.05457

研究人員提出了一個(gè)安全的 RL 框架,在「學(xué)習(xí)者策略」和「安全恢復(fù)策略」之間進(jìn)行切換,前者優(yōu)化為執(zhí)行所需任務(wù),后者防止機(jī)器人處于不安全狀態(tài);訓(xùn)練了一個(gè)復(fù)位策略,這樣機(jī)器人就能從失敗中恢復(fù)過(guò)來(lái),比如在跌倒后學(xué)會(huì)自己站起來(lái)。

雖然機(jī)器人的數(shù)據(jù)很少,但是人類執(zhí)行不同任務(wù)的視頻卻很多,當(dāng)然機(jī)器人和人的構(gòu)造有不同之處,因此讓機(jī)器人向人類學(xué)習(xí)的想法引發(fā)了「 跨不同實(shí)體遷移學(xué)習(xí)」的問(wèn)題。

論文鏈接:https://arxiv.org/pdf/2106.03911.pdf

研究人員開(kāi)發(fā)了交叉具身反向強(qiáng)化學(xué)習(xí)(Cross-Embodiment Inverse Reinforcement Learning),通過(guò)觀察人類來(lái)學(xué)習(xí)新的任務(wù),并非是試圖像人類那樣精確地復(fù)制任務(wù),而是學(xué)習(xí)高層次的任務(wù)目標(biāo),并以獎(jiǎng)勵(lì)函數(shù)的形式總結(jié)這些知識(shí),示范學(xué)習(xí)可以讓機(jī)器人通過(guò)觀看互聯(lián)網(wǎng)上隨時(shí)可用的視頻來(lái)學(xué)習(xí)技能。

另一個(gè)方向是提高學(xué)習(xí)算法的數(shù)據(jù)效率,這樣就不再僅僅依賴于擴(kuò)展數(shù)據(jù)收集:通過(guò)合并先驗(yàn)信息,包括預(yù)測(cè)信息、對(duì)抗性動(dòng)作先驗(yàn)和指導(dǎo)策略,提高了 RL 方法的效率。

論文鏈接:https://arxiv.org/abs/2210.10865

利用一種新的結(jié)構(gòu)化動(dòng)力系統(tǒng)體系結(jié)構(gòu),將 RL 與軌跡優(yōu)化相結(jié)合,在新型求解器的支持下,得到了進(jìn)一步的改進(jìn),先驗(yàn)信息有助于緩解勘探的挑戰(zhàn),更好地規(guī)范數(shù)據(jù),并大大減少了所需的數(shù)據(jù)量。

此外,機(jī)器人團(tuán)隊(duì)還投入了大量的資金在更有效的數(shù)據(jù)模擬學(xué)習(xí)上,實(shí)驗(yàn)證明了一種簡(jiǎn)單的模仿學(xué)習(xí)方法 BC-Z 可以對(duì)訓(xùn)練中沒(méi)有看到的新任務(wù)進(jìn)行zero-shot泛化。

論文鏈接:https://arxiv.org/pdf/2210.02343.pdf

并且還引入了一個(gè)迭代模仿學(xué)習(xí)算法 GoalsEye,從游戲中學(xué)習(xí)和目標(biāo)條件行為克隆相結(jié)合,用于高速高精度的乒乓球游戲。

論文鏈接:https://sites.google.com/view/goals-eye

在理論方面,研究人員研究了表征模擬學(xué)習(xí)樣本復(fù)雜性的動(dòng)態(tài)系統(tǒng)穩(wěn)定性,以及捕獲演示數(shù)據(jù)中的失效和恢復(fù)以更好地調(diào)節(jié)小數(shù)據(jù)集離線學(xué)習(xí)的作用。

論文鏈接:https://proceedings.mlr.press/v168/tu22a.html

總結(jié)

人工智能領(lǐng)域大型模型的進(jìn)步促進(jìn)了機(jī)器人學(xué)習(xí)能力的飛躍。

在過(guò)去的一年里,可以看到 LLM 中捕捉到的上下文感覺(jué)和事件順序幫助解決機(jī)器人技術(shù)的長(zhǎng)期規(guī)劃,并使機(jī)器人更容易與人互動(dòng)和完成任務(wù)。還可以看到用可擴(kuò)展的路徑來(lái)學(xué)習(xí)魯棒性和泛化機(jī)器人行為,通過(guò)應(yīng)用Transformer模型架構(gòu)的機(jī)器人學(xué)習(xí)。

谷歌承諾將繼續(xù)開(kāi)放源代碼數(shù)據(jù)集,在新的一年繼續(xù)發(fā)展有用的機(jī)器人。