首次:微軟用GPT-4做大模型指令微調,新任務零樣本性能再提升

我們知道,從谷歌 T5 模型到 OpenAI GPT 系列大模型,大語言模型(LLMs)已經展現出了令人印象深刻的泛化能力,比如上下文學習和思維鏈推理。同時為了使得 LLMs 遵循自然語言指令和完成真實世界任務,研究人員一直在探索 LLMs 的指令微調方法。實現方式有兩種:一是使用人類標注的 prompt 和反饋在廣泛任務上微調模型,二是使用通過手動或自動生成指令增強的公共基準和數據集來監督微調。?

在這些方法中,Self-Instruct 微調是一種簡單有效的方法,它從 SOTA 指令微調的教師 LLMs 生成的指令遵循數據中學習,使得 LLMs 與人類意圖對齊。事實證明,指令微調已經成為提升 LLMs 零樣本和小樣本泛化能力的有效手段。?

最近,ChatGPT 和 GPT-4 的成功為使用指令微調來改進開源 LLMs 提供了巨大的機遇。Meta LLaMA 是一系列開源 LLMs,其性能與 GPT-3 等專有 LLMs 相媲美。為了教 LLaMA 遵循指令,Self-Instruct 因其卓越性能和低成本被快速采用。比如斯坦福的 Alpaca 模型使用由 GPT-3.5 生成的 52k 指令遵循樣本,Vicuna 模型使用約 70k 來自 ShareGPT 的指令遵循樣本。?

為了推進 LLMs 指令微調的 SOTA 水平,微軟研究院在其論文《Instruction Tuning with GPT-4》中首次使用 GPT-4 作為教師模型進行 self-intruct 微調。

- 論文地址:https://arxiv.org/pdf/2304.03277.pdf

- 項目地址:https://instruction-tuning-with-gpt-4.github.io/

- GitHub 地址:https://github.com/Instruction-Tuning-with-GPT-4/GPT-4-LLM?

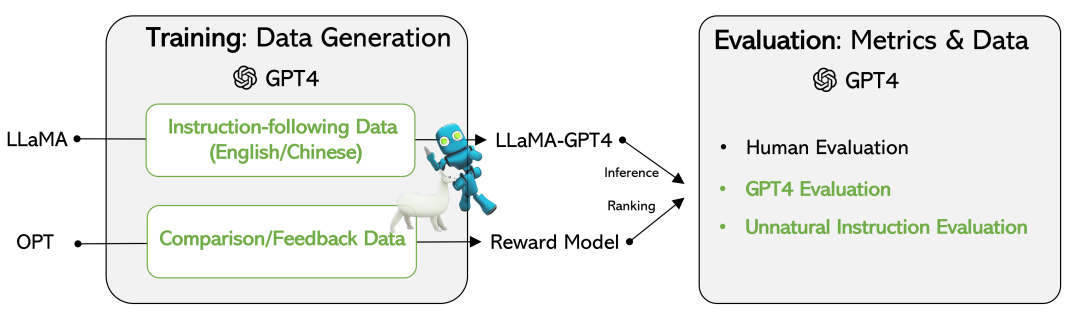

研究者一方面發布了 GPT-4 生成的數據,包括中英文的 52k 指令遵循數據集、GPT-4 生成的對三種指令微調模型的輸出進行評級的反饋數據。 ?

另一方面基于 GPT-4 生成的數據開發了指令微調的 LLaMA 模型和獎勵模型。為了評估指令微調 LLMs 的質量,研究者使用三個指標對測試樣本進行評估:對三個對齊標準的人工評估、基于 GPT-4 反饋的自動評估以及非自然指令的 ROUGE-L(自動文摘評測方法之一)。?

實驗結果驗證了使用 GPT-4 生成的數據進行 LLMs 指令微調的有效性。GPT-4 生成的 52k 中英指令遵循數據在新任務上實現了較以往 SOTA 模型更好的零樣本性能。目前,研究者已經公開了使用 GPT-4 生成的數據以及相關代碼。

數據集?

該研究使用 GPT-4 生成以下四個數據集:

- 英語指令遵循數據集(English Instruction-Following Data):對于從 Alpaca 收集到的 52K 指令,每個指令都提供了一個英文 GPT-4 答案。該數據集主要用來探索和比較 GPT-4 答案和 GPT-3 答案的數據統計。

- 中文指令遵循數據集(Chinese Instruction-Following Data):該研究使用 ChatGPT 將 52K 指令翻譯成中文,并要求 GPT-4 用中文回答。

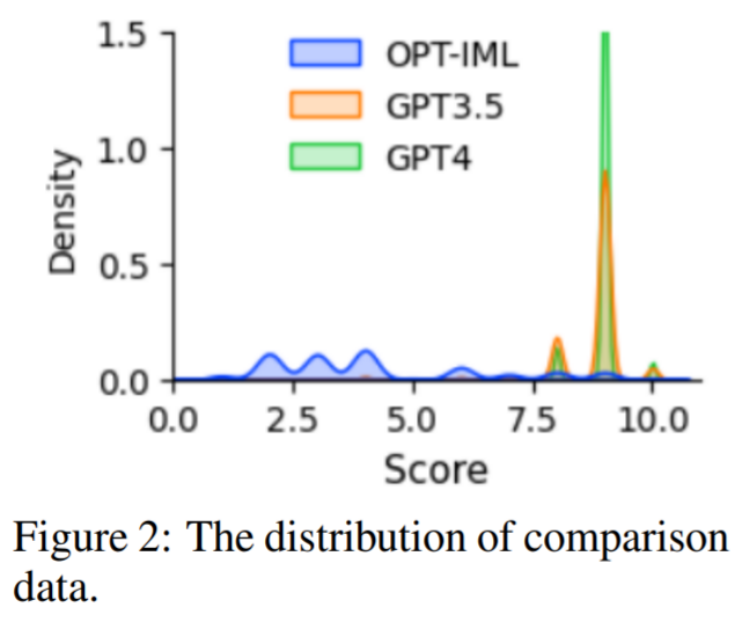

- 比較數據(Comparison Data):讓 GPT-4 給自己的反應打分,分數范圍從 1 到 10。此外,該研究還要求 GPT-4 對 GPT-4、GPT-3.5 和 OPT-IML 三種模型的響應進行比較和評分。這一數據集主要用來訓練獎勵模型。

- 非自然指令的回答(Answers on Unnatural Instructions):GPT-4 的回答在 68K 指令 - 輸入 - 輸出三組核心數據集上解碼。該子集用于量化 GPT-4 與指令微調模型之間的差距。?

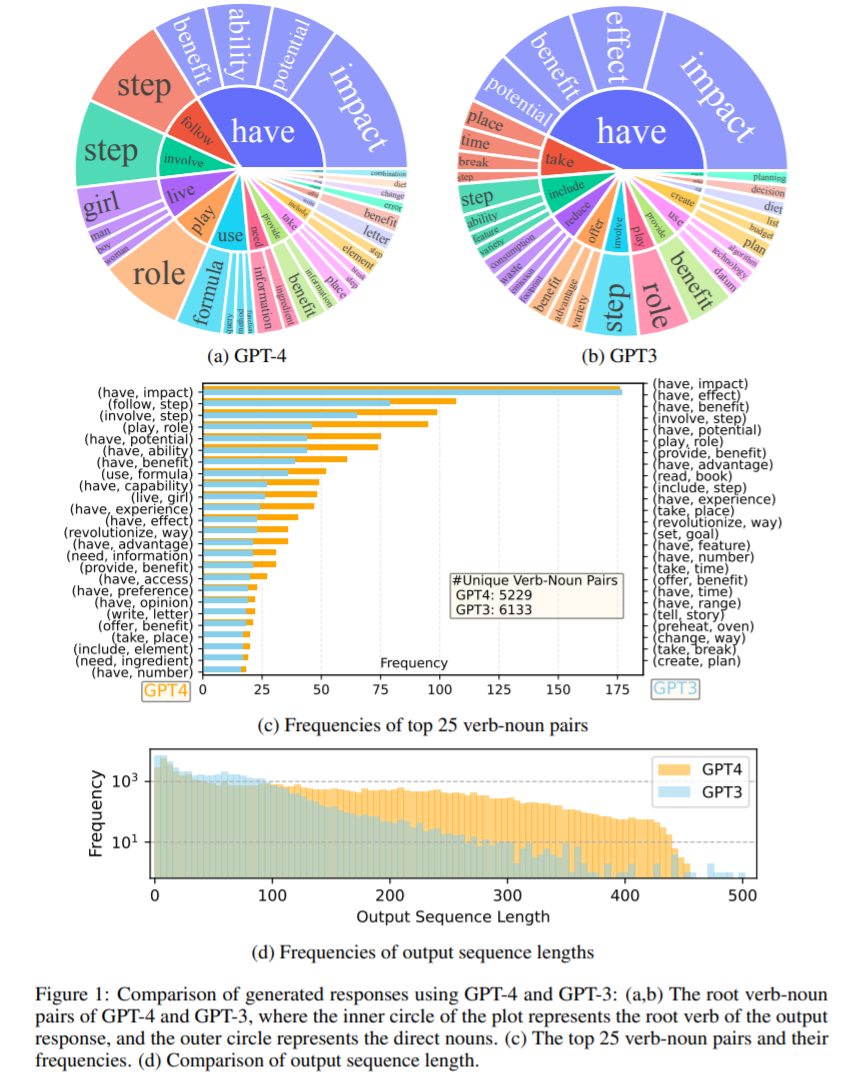

圖 1 比較了 GPT-4 和 GPT-3.5 的英文輸出響應集。圖 1 (a) 和 (b) 顯示了兩個輸出集合頻率高于 10 的動 - 名詞對(verb-noun pairs),圖 1 (c) 比較了兩個集合中出現頻率最高的 25 對單詞,圖 1 (d) 比較了序列長度的頻率分布,結果顯示,GPT-4 傾向于生成比 GPT-3.5 更長的序列。

指令微調語言模型?

該研究基于 LLaMA 7B checkpoint、并使用監督微調訓練了兩個模型:(i) LLaMA-GPT4 ,在 GPT-4 生成的 52K 英語指令遵循數據上訓練。(ii) LLaMA-GPT4-CN,在來自 GPT-4 生成的 52K 中文指令遵循數據上訓練完成。

獎勵模型

人類反饋強化學習 (RLHF) 旨在使 LLM 行為與人類偏好保持一致,獎勵建模是其關鍵部分之一,這一問題被往往公式化為回歸任務,以預測給定提示和響應之間的獎勵。但這種方法通常需要大規模的比較數據,現有開源模型如 Alpaca、Vicuna 和 Dolly 由于標注比較數據成本很高,因此不涉及 RLHF。與此同時,最近的研究表明,GPT-4 能夠識別和修復自己的錯誤,并準確判斷響應的質量。因此,為了促進 RLHF 的研究,該研究使用 GPT-4 創建了比較數據,如上文所述。

為了評估數據質量,該研究還訓練了一個基于 OPT 1.3B 的獎勵模型進行該數據集的評估。比較數據的分布如圖 2 所示。

實驗?

該研究利用以下三種類型進行評估:人類評估、GPT-4 以及非自然指令評估。結果證實,與其他機器生成的數據相比,使用 GPT-4 生成的數據是進行 LLM 指令微調的一種高效且有效的方法。接下來我們看看具體實驗過程。

人類評估?

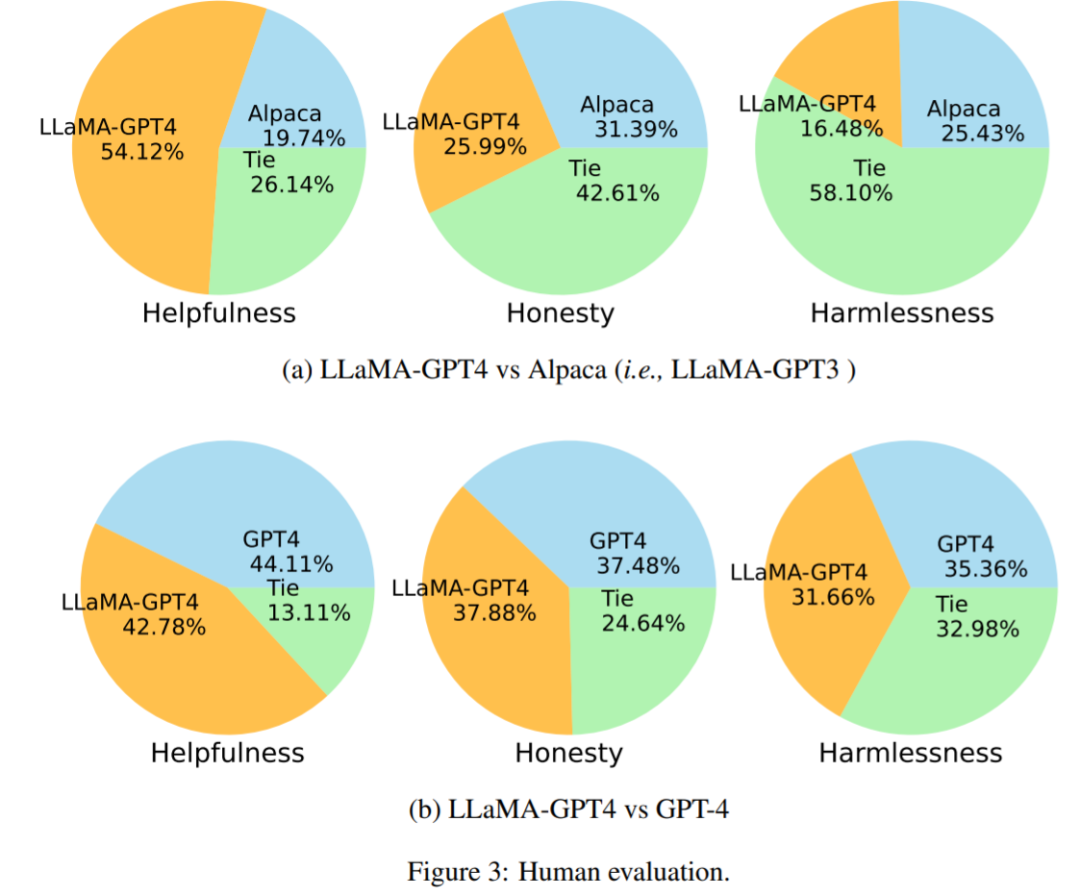

圖 3 (a) 為 LLaMA-GPT4 vs Alpaca 比較結果,實驗表明在 Helpfulness 這一指標下,GPT-4 以 54.12% 的得分勝出。圖 3 (b) 為 LLaMA-GPT4 vs GPT-4 比較結果,表明 GPT-4 指令微調的 LLaMA 的性能與原始的 GPT-4 類似。

與使用自動求值的 SOTA 進行比較?

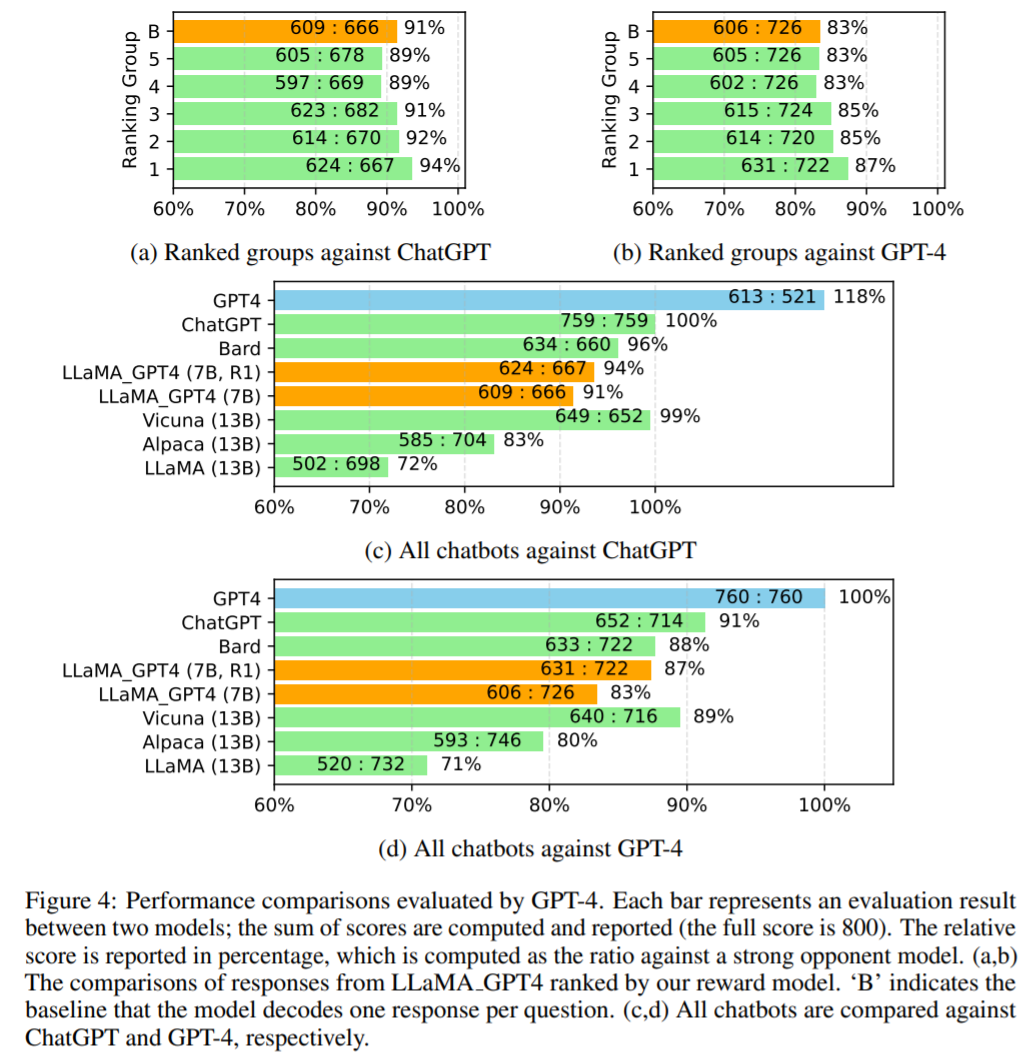

該研究使用 GPT-4 對不同模型在 80 個未見問題上的回答進行自動評估。首先從 LLaMA-GPT-4 (7B) 和 GPT-4 兩個聊天機器人中收集答案,并使用其他聊天機器人發布答案,包括 LLaMA (13B),Alpaca (13B),Vicuna (13B),Bard (谷歌,2023) 和 ChatGPT。對于每次評估,該研究要求 GPT-4 對兩個模型之間的響應質量進行評分,評分范圍從 1 到 10。結果如圖 4 所示。

圖 4 (c,d) 比較了所有聊天機器人。LLaMA_GPT4 性能更高:7B LLaMA GPT4 的性能優于 13B Alpaca 和 LLaMA。然而,LLaMA_GPT4 與 GPT-4 等大型商業聊天機器人相比,仍有差距。?

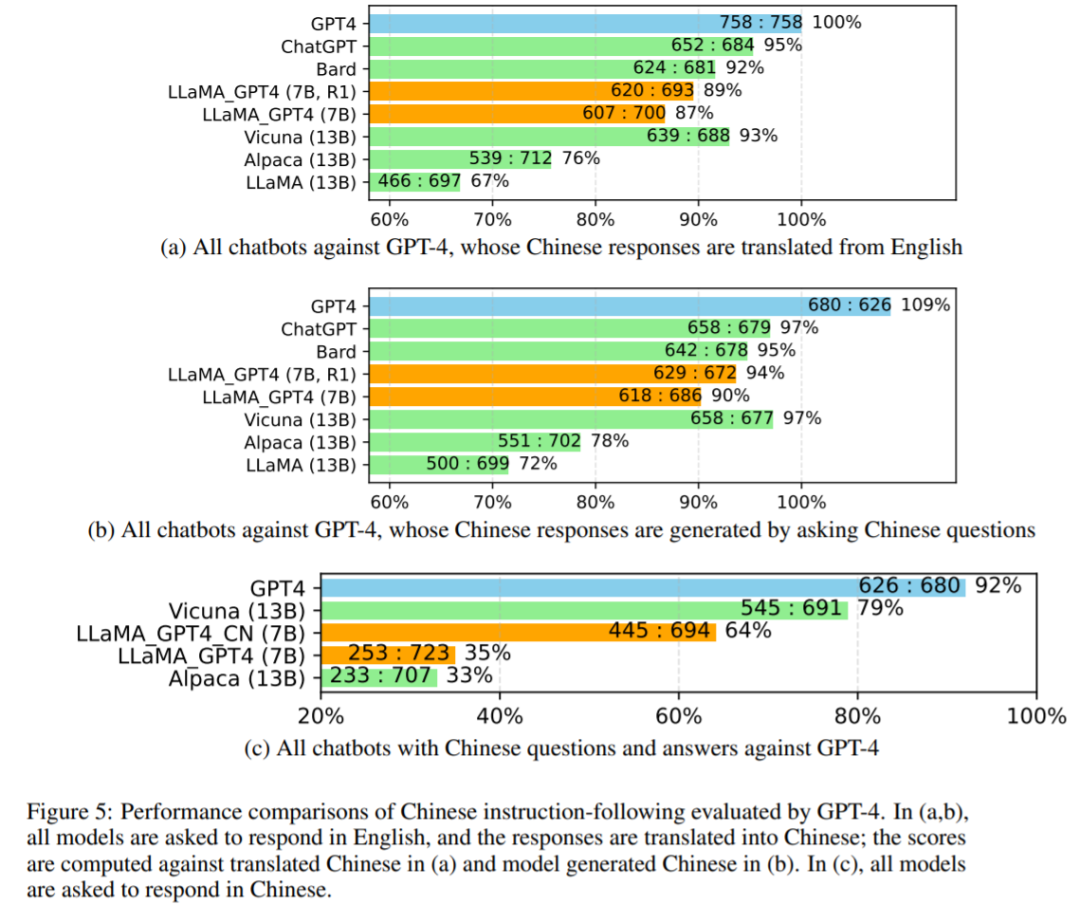

研究者在下圖 5 中進一步研究了所有聊天機器人的性能。首先使用 GPT-4 將聊天機器人的英文響應翻譯成中文,接著使用 GPT-4 將英文問題翻譯成中文以獲得答案。與 GPT-4 翻譯和生成的中文響應的比較如 5 (a) 和 5 (b) 所示,5 (c) 中顯示了所有被要求用中文回答的模型結果。

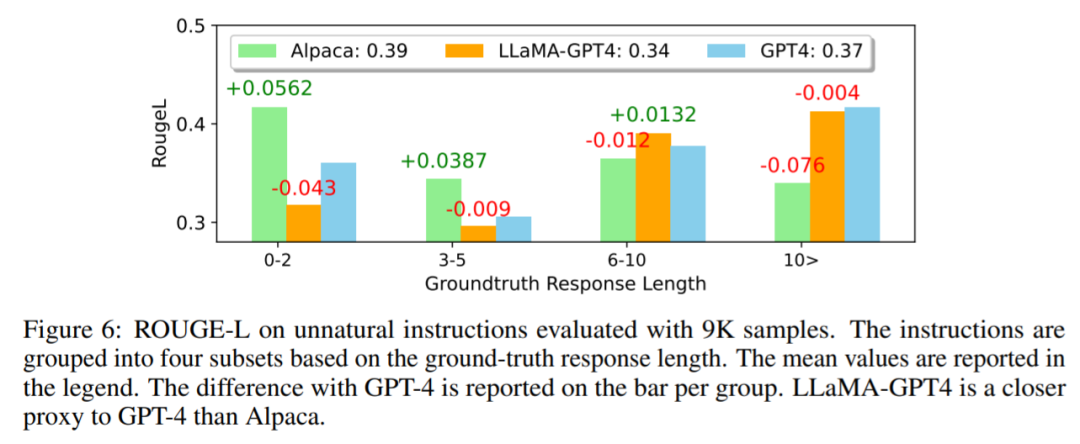

在下圖 6 中,研究者將 LLaMA-GPT4 與 GPT-4、Alpaca 非自然指令進行比較。結果顯示,LLaMA-GPT4 和 GPT-4 隨 ground truth 響應長度的增加表現更好。這意味著當場景更具創意時,它們可以更好地遵循指令。當序列長度較短時,LLaMA-GPT4 和 GPT-4 都能生成包含簡單 ground truth 答案的響應,并且添加額外單詞可以使響應更像聊天。

更多技術和實驗細節請參閱原論文。