視頻分割大結局!浙大最新發布SAM-Track:通用智能視頻分割一鍵直達

近期,浙江大學ReLER實驗室將SAM與視頻分割進行深度結合,發布Segment-and-Track Anything (SAM-Track)。

SAM-Track賦予了SAM對視頻目標進行跟蹤的能力,并支持多種方式(點、畫筆、文字)進行交互。

在此基礎上,SAM-Track統一了多個傳統視頻分割任務,達成了一鍵分割追蹤任意視頻中的任意目標,將傳統視頻分割外推至通用視頻分割。

SAM-Track具有卓越的性能,在復雜場景下僅需單卡就能高質量地穩定跟蹤數百個目標。

項目地址:https://github.com/z-x-yang/Segment-and-Track-Anything

論文地址:https://arxiv.org/abs/2305.06558

效果展示

SAM-Track支持語言輸入作為Prompt。比如,給定類別文本「熊貓」,便可一鍵實例級分割追蹤所有屬于「熊貓」這一類別的目標。

也可進一步給出更詳細的描述,比如輸入文字「最左邊的熊貓」,SAM-Track可以定位至特定目標進行分割追蹤。

相較于傳統視頻追蹤算法,SAM-Track的另一個強大之處在于可對大量目標同時進行跟蹤分割,并自動檢測新出現的物體。

SAM-Track還支持多種交互方式組合使用,用戶可根據實際需求搭配。比如使用畫筆來框定與人體緊密連接的滑板,防止分割多余物體,而后使用點擊選擇人體。

全自動視頻目標分割與追蹤自然也不在話下,各種應用場景包括街景、航拍、AR、動畫、醫學圖像等,均可一鍵分割追蹤并自動檢測新出現的物體。

如果對自動分割結果不滿意,用戶可在此基礎上進行編輯修正,例如使用點擊來修正過分割的電車。

同時最新版本的SAM-Track支持對追蹤結果進行在線瀏覽,可選擇中間任意一幀的分割結果進行修改和新增目標,并再次追蹤。

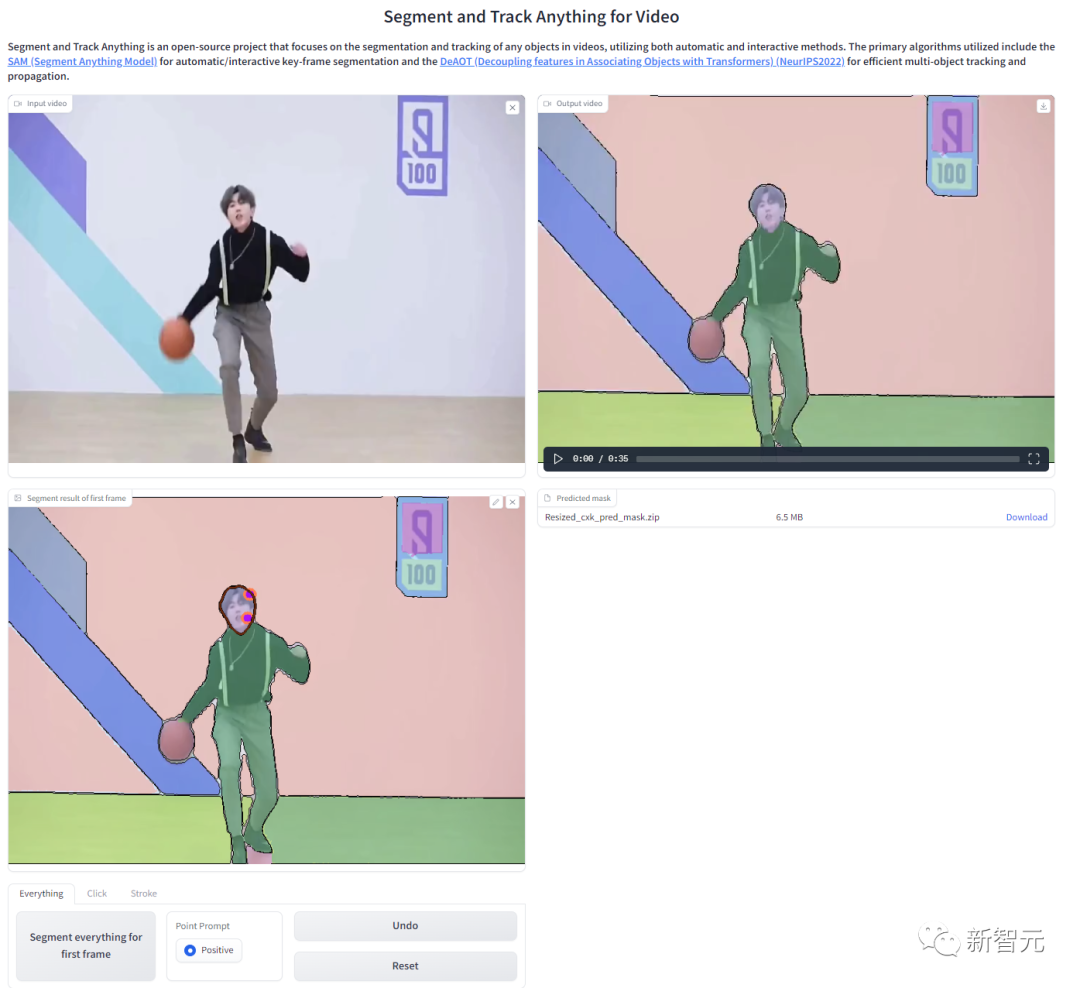

為了方便用戶線上體驗,項目提供了WebUI,可通過Colab一鍵部署:

模型組成

SAM-Track模型基于ECCV'22 VOT Workshop四個賽道的冠軍方案DeAOT。

DeAOT是一個高效的多目標VOS模型,在給定首幀物體標注的情況下,可以對視頻其余幀中的物體進行追蹤分割。

DeAOT采用一種識別機制,將一個視頻中的多個目標嵌入到同一高維空間中,從而實現了同時對多個物體進行追蹤。

DeAOT在多物體追蹤方面的速度表現能夠與其他針對單個物體追蹤的VOS方法相媲美。

此外,通過基于分層的Transformer的傳播機制,DeAOT更好地聚合了長時序和短時序信息,表現出了優異的追蹤性能。

由于DeAOT需要參考幀的標注來初始化,為了提高便捷性,SAM-Track使用了最近在圖像分割領域大放異彩的Segment Anything Model(SAM)模型來獲取標注信息。

利用SAM出色的零樣本遷移能力,以及多種交互方式,SAM-Track能高效地為DeAOT獲取高質量的參考幀標注信息。

雖然SAM模型在圖像分割領域表現出色,但它無法輸出語義標簽,且文本提示也不能很好地支持Referring Object Segmentation及其他依賴深層語義理解的任務。

因此,SAM-Track模型進一步集成了Grounding-DINO,實現了高精度的語言引導的視頻分割。Grounding DINO是一個開放集合目標檢測模型,具有很好的語言理解能力。

根據輸入的類別或目標對象的詳細描述,Grounding-DINO可以檢測到目標并返回位置框。

SAM-Track模型架構

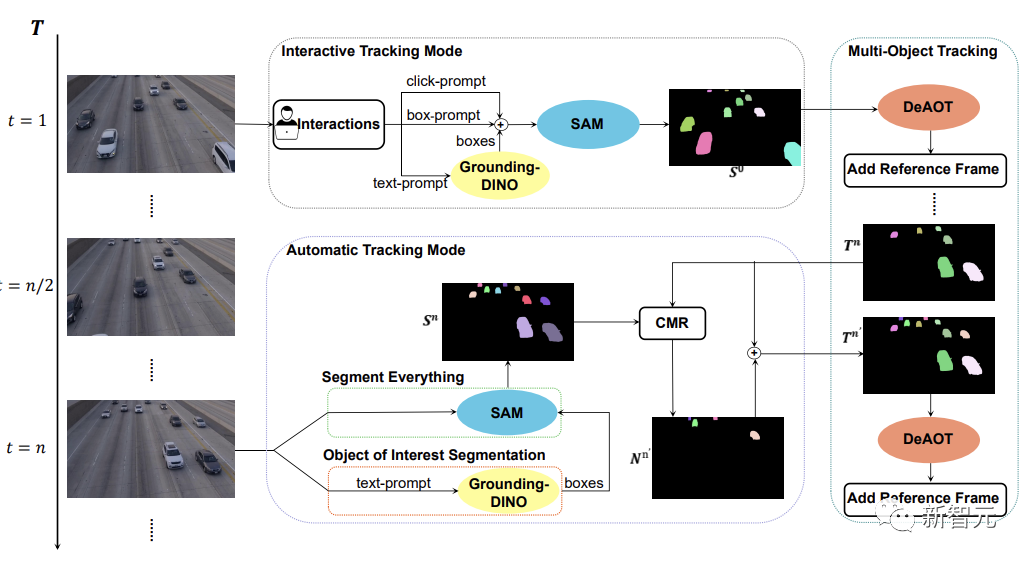

如下圖所示,SAM-Track模型支持了三種物體跟蹤模式,分別為交互跟蹤模式、自動跟蹤模式以及融合模式。

對于交互跟蹤模式,SAM-Track模型首先會應用SAM,在參考幀中利用點擊或畫框的方式選中目標,直到得到用戶滿意的交互分割結果。

如果想要實現語言引導的視頻物體分割,SAM-Track則會調用Grounding-DINO根據輸入的文本,先得到目標物體的位置框,并在此基礎上通過SAM得到感興趣物體的分割結果。

最后DeAOT將交互分割結果作為參考幀,對選中的目標進行追蹤。在追蹤的過程中,DeAOT會將過去幀中的視覺嵌入和高維ID嵌入分層傳播到當前幀中,實現逐幀追蹤分割多個目標對象。因此,SAM-Track能過支持多模態的交互方式來追蹤分割視頻中的感興趣物體。

然而,交互跟蹤模式無法處理視頻中出現的新出現的物體。限制了SAM-Track在特定領域的應用,例如,自動駕駛,智慧城市等。

為了進一步拓展SAM-Track的應用范圍和性能,SAM-Track實現了自動跟蹤模式,對視頻中出現的新物體進行追蹤。

自動跟蹤模式通過Segment Everything和Object of Interest Segmentation兩種方式來獲得每n幀中新出現的物體的注釋。對于新出現的物體的ID分配問題,SAM-Track采用了比較掩碼模塊(CMR)來確定新的對象的ID。

融合模式則是把交互跟蹤模式和自動跟蹤模式相結合。通過交互式跟蹤模式用戶可以很方便地獲取視頻中第一幀的注釋,而自動跟蹤模式則可以處理視頻后續幀中出現的未被選中的新對象。追蹤方法的組合擴大了SAM-Track的應用范圍,增加了SAM-Track的實用性。