知識可遷移圖神經網絡及其在金融風險預測中的應用

一、圖遷移學習概要介紹

首先,來介紹一下圖遷移學習相關的背景知識,以及一些典型的應用場景。

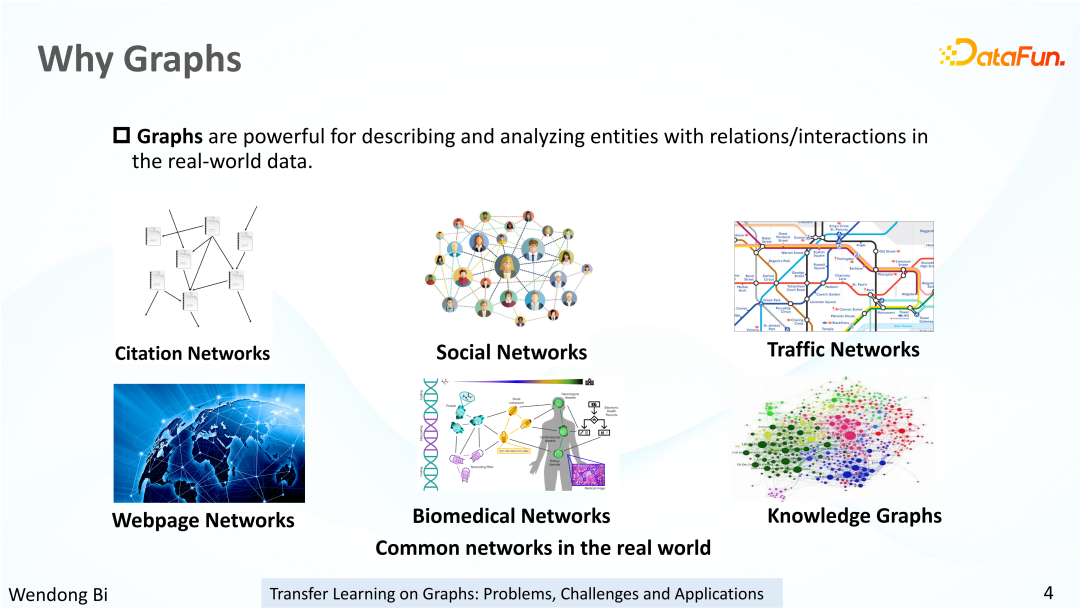

1、什么是圖數據

圖數據是一種非歐空間數據,通常由節點和節點之間的邊構成。圖數據廣泛存在于真實世界的各個場景當中,例如引文網絡、社交網絡、交通網絡、分子圖、蛋白質網絡、知識圖譜等等。圖結構如此普遍,對圖結構的建模是非常重要的。

2、圖表示學習

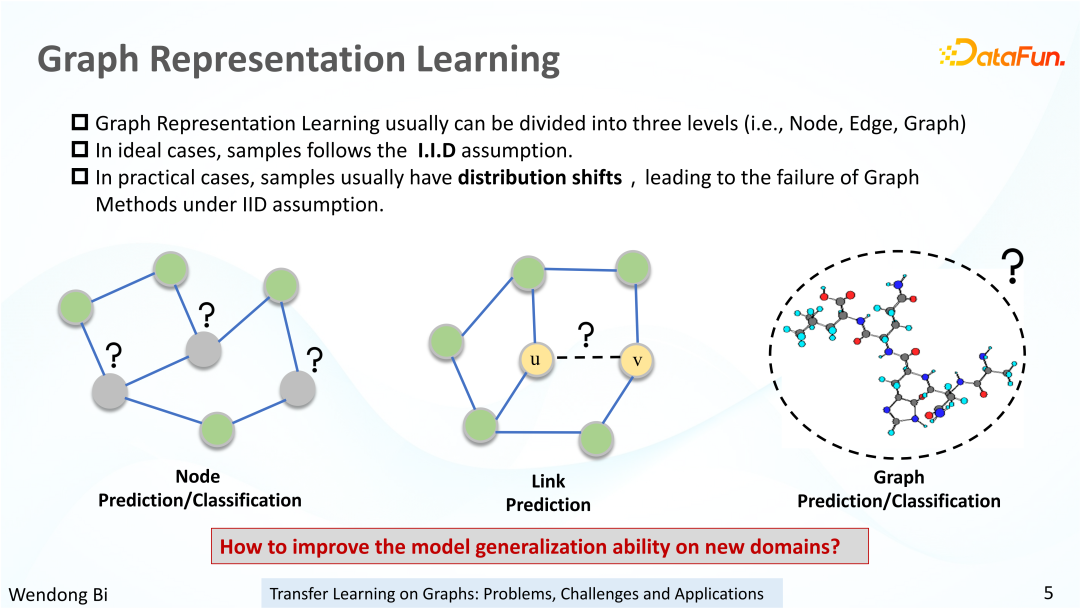

圖表示學習是當前主流的圖學習方法之一,例如 network、embedding、圖神經網絡(GNN)等圖算法。它們為圖上的節點學習低維向量表示,并把學到的節點表示用于一系列下游任務。圖表示學習的下游任務通常根據圖上的組成元素被分為 3 個level,分別是:

(1)節點級別任務,比如節點分類和節點性質預測。

(2)邊級別任務,比如連接預測。

(3)圖級別任務,比如圖分類和圖性質預測。

然而,目前的很多圖表示學習算法都是建立在獨立同分布圖的理想情況下,也就是圖數據的樣本數據分布服從獨立同分布,但這在實際應用場景當中通常是很難滿足的,真實的樣本之間往往存在著分布的遷移。在遷移學習領域大家常常稱這些分布不同的節點屬于不同的 domain。我們也可以認為在同一個 domain 下的樣本,是服從 IID 假設的。而不同 domain 下的樣本則不服從 IID 假設。對于 None-IID 的圖,傳統圖表示學習算法的效果往往會明顯下降。

這也促使我們去思考如何使算法對不同 domain 的數據是魯棒的,或者能夠提升圖表示學習模型在新的 domain 上的泛化能力。

3、傳統遷移學習

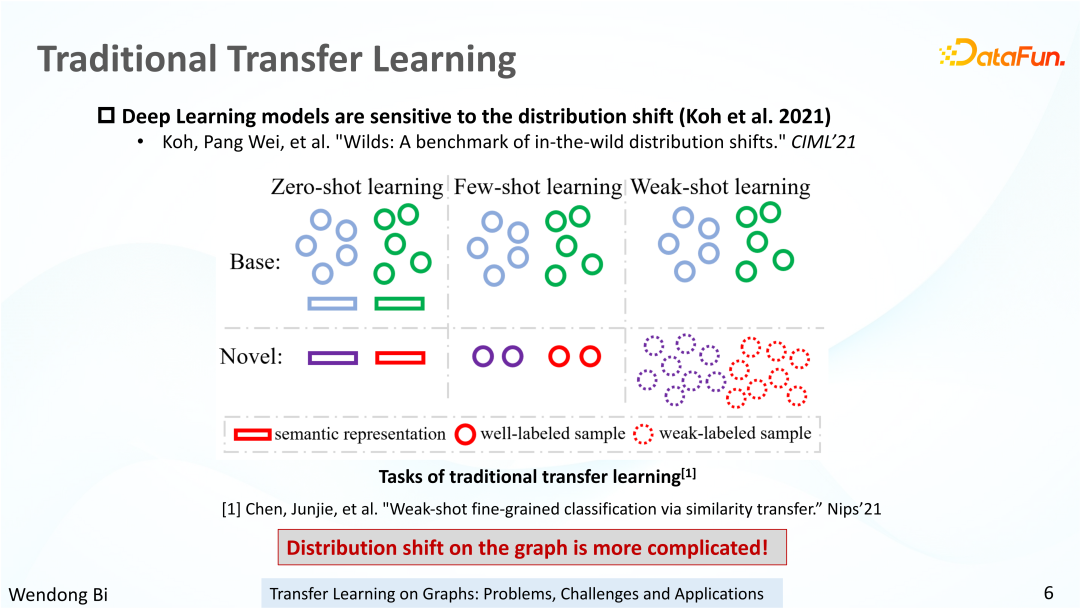

已有的研究也表明,深度學習方法對數據的 distribution shift 問題是十分敏感的。有關 distribution shift 的問題,大家可以參考圖中的 paper,其中詳細討論了各種 distribution shift 問題以及一些可行的解決方案。遷移學習是當前解決 distribution shift 問題的一個主流做法,在 CV/NLP 領域也已經被廣泛研究。

傳統的遷移學習通常將數據分成 source domain 和 target domain,而根據在訓練階段可以使用的標簽數量或者質量,我們進一步將遷移學習分成幾個子問題,分別是零樣本學習(Zero-shot learning)、少樣本學習 (Few-shot learning)和弱樣本學習(Weak-shot learning)。其中零樣本學習是在訓練階段不使用任何 target domain 的標簽;少樣本學習是在模型訓練階段使用少量的標簽;而 Weak-shot learning 強調的不是 target domain 下樣本的標簽數量的多少,而是強調 target domain 樣本 標簽的質量差、有噪聲。不同于歐式數據,圖上的分布遷移問題其實是更加復雜的,因為圖上的構成元素本身也是更復雜的。

4、圖中的分布偏移

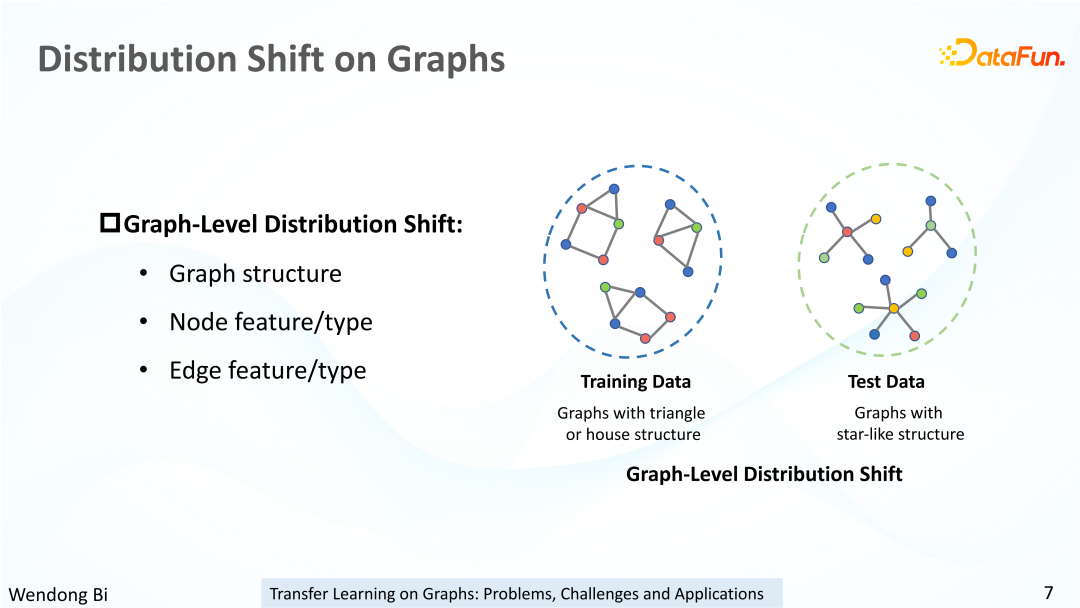

首先來講一下圖上的分布式如何定義,以及圖上的分布遷移。前面提到圖表示學習的任務通常分為 3 個 level:節點級、邊級別、圖級別。這里按照由粗到細的順序來介紹圖數據上的數據分布。

首先是圖級別的樣本分布。對于一個圖而言,如果圖結構信息不同,那么幾何結構會有完全不同的性質。比如這里給了一個例子,在訓練集當中,圖數據都是這種三角結構的,測試集里面的圖結構是一些星形的圖結構,這就造成了 source domain 和 target domain 在圖結構上的分布差異。此外,對于圖而言,其中的節點和邊可能有額外的屬性或者類別特征。即使是同樣的圖結構,如果圖上的結點或者邊的屬性,亦或是類別的分布不同,同樣也會導致圖數據的 distribution shift 問題。

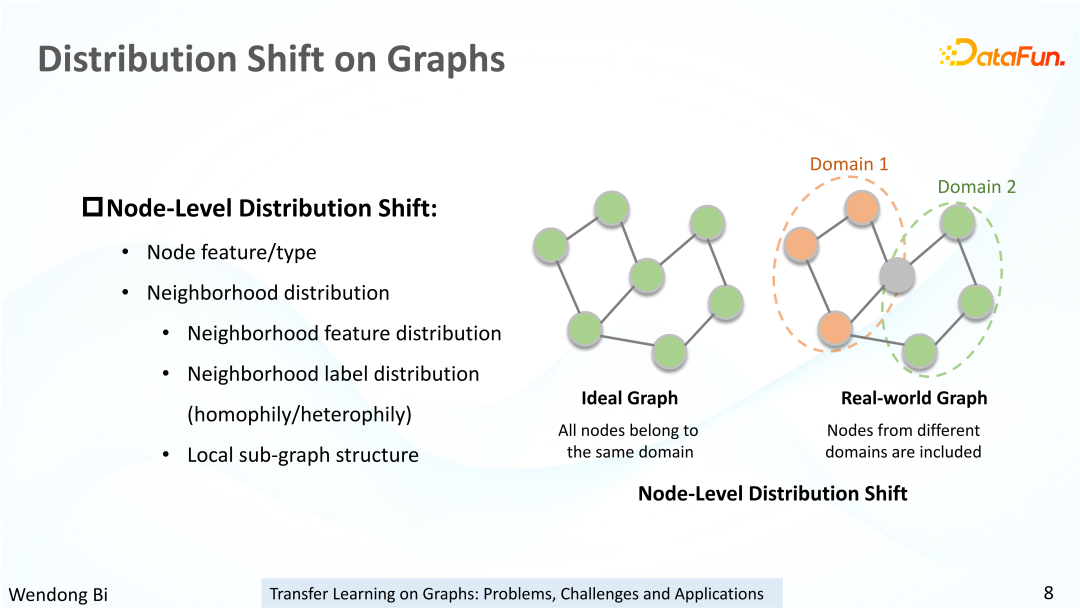

除了圖級別的分布遷移,可以進一步細分圖中的每一個節點,也可以作為一個樣本,也會存在節點級別的分布遷移問題。

首先,圖中的節點是可以有屬性特征的,不同節點的屬性特征可能是非獨立同分布的。而圖數據一個最大的特點就在于節點之間不是相互獨立的,而是通過邊相互連接在一起。因此,相比于圖片這種樣本之間彼此相互沒有聯系的情況,圖中的節點就有了鄰居的概念。因而除了節點自身的屬性分布之外,還有鄰居的屬性分布。鄰居的分布又可以進一步細分成鄰居的特征分布,鄰居節點的標簽分布,以及局部節點特征。對于鄰居的特征分布,有很多種衡量的方式,例如最簡單的 GCN 用了均值聚合的策略。鄰居特征的均值就是一種最簡單的一階的分布統計量。

除此之外,鄰居的標簽分布也是一個很重要的性質。有大量研究表明,graph 的平滑性跟 GNN 模型的表現是密切相關的。比如這里提到的 homophily 或 heterophily 的性質,其實就是描述鄰居節點與當前節點標簽相同的節點的占比,這是一種鄰居標簽分布的度量方式,而標簽分布不同的節點在圖中也是經常存在的。

最后還有節點的局部結構性質,比如以某一個節點為中心,采樣一個局部的 Ego network 結構,對于節點表示的學習以及區分節點的不同 label 往往也是非常重要的。比如社交網絡里面的 popular node,通常它們的度會非常大。相比之下,另外一種 unpopular node,它的 degree 就會比較小,甚至是接近 0 的。這樣一種以節點為中心的局部結構的分布遷移,在圖中也是常常發生的。

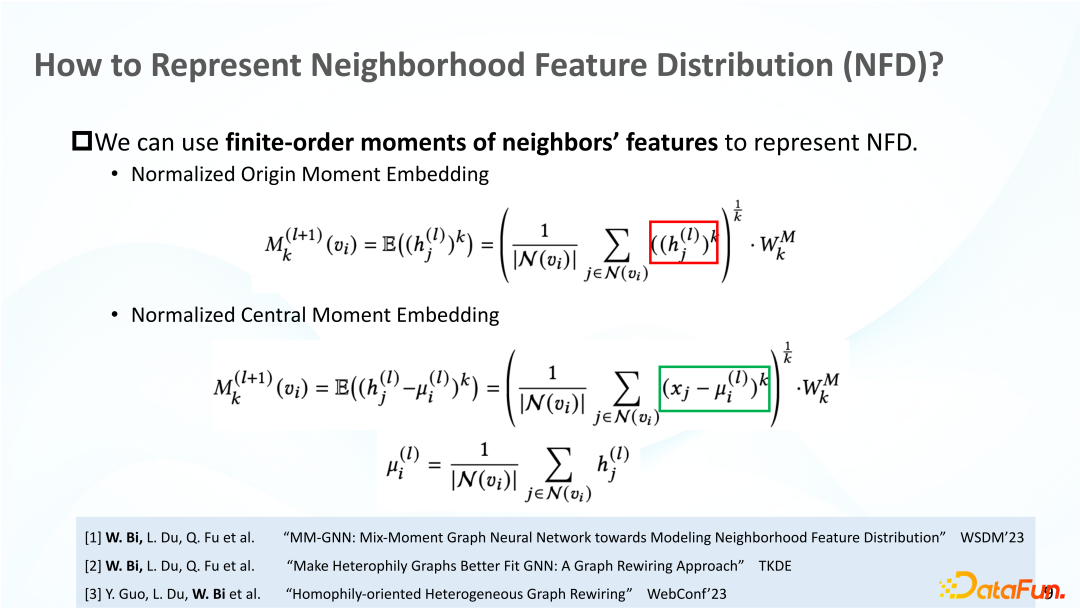

5、如何表示鄰域特征分布(NFD)?

這里分享一個我們之前在學習節點鄰居分布表征上的嘗試。正如前面提到的,鄰居節點的特征對應節點的鄰居特征分布。如何表征一個鄰居特征分布呢?比如 GCN 采用鄰居的均值,其實就是鄰居特征分布的一階統計量。但是僅僅一階統計量往往不足以表示一個節點的鄰居的分布。比如最簡單的高斯分布,它的自由度是 2,所以它最少需要均值和方差這兩個統計量才能確定這樣一個分布。再加上大多數的圖本身是比較稀疏的,我們沒有辦法保證鄰居的分布近似為高斯分布。

所以我們需要一種更復雜的特征函數來表示一個分布。我們的嘗試是采用鄰居節點特征的多階矩來表示分布。有關鄰居分布表征的內容,大家可以參考上圖列出的 paper。此外,我們的另外兩個工作當中也涉及了鄰居分布的表征學習,大家感興趣的話也可以去閱讀一下。

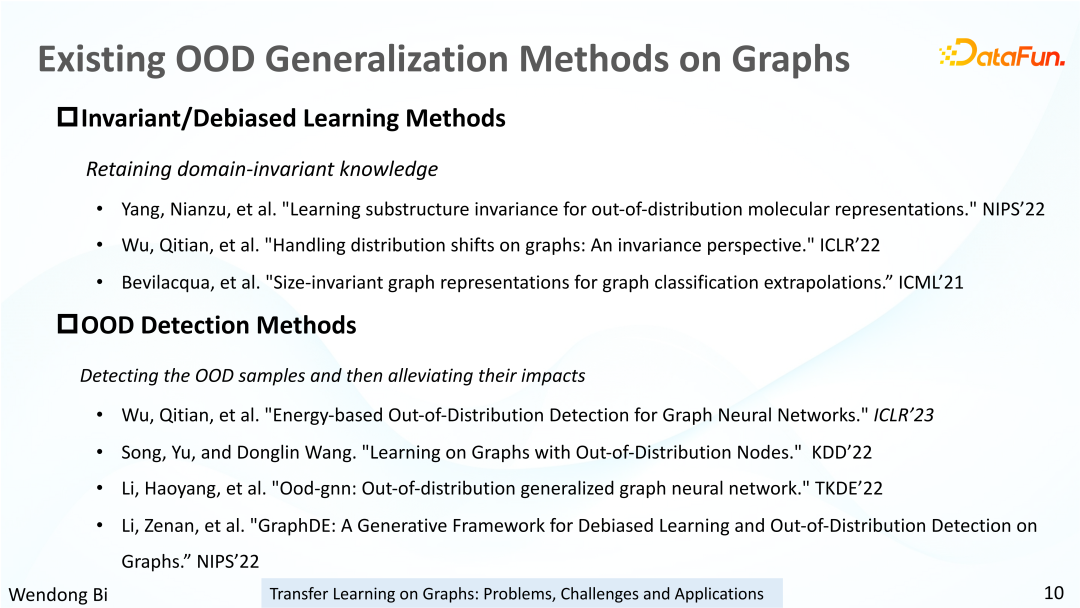

6、圖上現有的 OOD 泛化方法

已有一些相關工作研究了圖上的 distribution shift 問題,也提出了一些圖上的遷移學習方法。上圖中列出了最具代表性并且研究熱度比較高的兩種圖上的遷移學習方法。

一種是基于 invariant learning 不變性學習的方法。這種方法旨在學習 domain invariant 知識,從而可以在已知的 domain 上訓練模型。保留 domain invariant 的信息。從而可以更好地泛化到未知的或者信息量更少的 domain 上面。

另外一種研究比較多的方法是 OOD detection 方法。這種方法通常不是區分 source domain 或者 target domain,而是區分 in distribution 和 out distribution 的樣本。而且通常會假設數據集內大多數樣本是 in distribution 的。通過檢測出數據中的 out of distribution 的樣本,并削弱它們的影響,從而使得模型在訓練過程當中更加關注 in distribution 的樣本,來達到增強模型魯棒性的目的。相關的工作也列了一部分在這里,大家感興趣也可以去閱讀調研。

有關圖遷移學習的背景知識就先介紹到這里,接下來分享我們基于真實世界數據發現的圖遷移學習領域的一個新問題,相關論文已經被國際會議 ACM WebConference2023 接收。

二、VS-Graph:圖遷移學習新場景

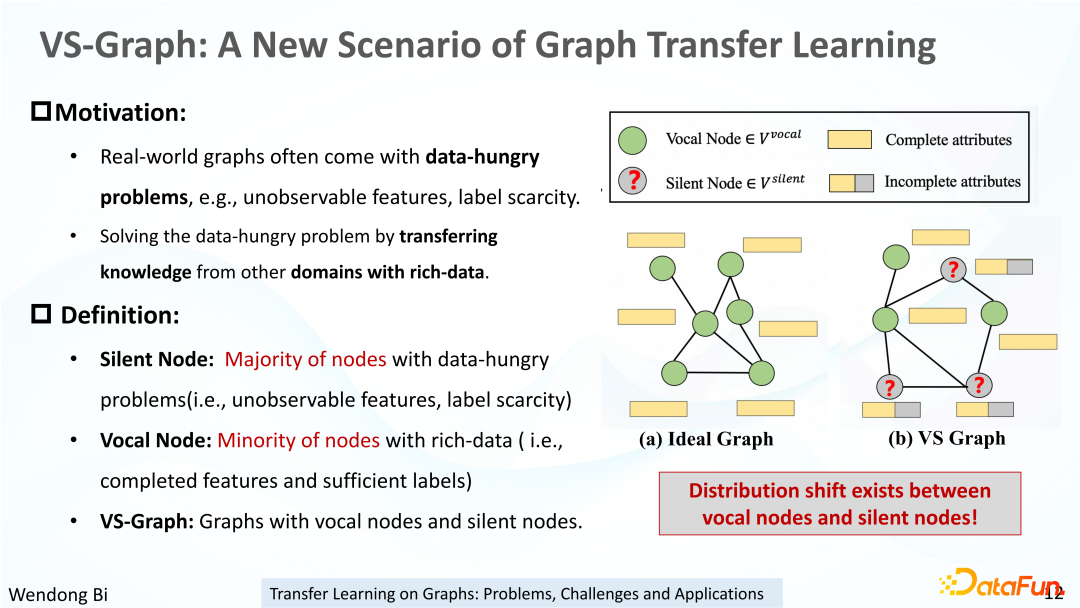

這一章節中將介紹圖遷移學習中節點級任務的新場景,在這一新場景中,我們定義了一種全新的圖結構:VS-Graph。

在真實的場景當中,訓練數據通常是不完美的,往往會伴隨 data-hungry 的問題。例如有些樣本可能存在缺失特征,或者訓練標簽非常少。而且 data-hungry 問題也是非常普遍的。如果通過補充數據來緩解 data-hungry 問題是非常困難的。

其一,是因為有些數據根本觀測不到。其二,就算可以獲取到這些數據,仍然需要花費大量的時間、金錢去獲取這些數據。所以我們采用了一種折中的方式,最大化地利用已有其它類型或其他來源的數據,并通過知識遷移的手段,把其它領域質量相對較好的數據中的知識,通過技術手段遷移到質量較差的數據當中,從而改善模型在這些質量差的樣本上的效果。

基于這樣一個背景,我們提出了 VS-Graph 這樣一個全新的場景。VS-Graph 全稱為 Vocal Silent Graph。顧名思義,VS-Graph 上有兩類節點,一類節點我們稱之為 silent node,也叫小 v 節點;對應的另一類就是 vocal node,也叫大 v 節點。類似于現實生活中,大 v 或者明星節點是數量比較少的,而小 v 通常占據了大多數。此外,大 v 節點通常是比較 popular 的,它們的信息量更全。而小 v 節點通常是 unpopular 的,信息量更少。例如我們在檢索網站中去搜索一個明星,可以搜到很多結果,但如果搜索一個普通人可能就搜不到。對應到 VS-Graph 里面,大 v 節點的 feature 和 label 是非常充足的,而小 v 節點的 feature 可能存在缺失或者不可觀測的情況,它們的 label 也是比較少的。

此外,大 v 節點和小 v 節點的屬性特征之間往往存在顯著的分布遷移。比如一個明星的日常活動跟一個普通人的日常活動的差別是非常大的。就像上圖中子圖(b)展示的一樣,其中綠色節點就代表大 v 節點,它有完全可觀測的屬性特征和已知的節點 label。而灰色的小 v 節點,只有少量的節點 label 以及一部分不可觀測的屬性特征。

我們把同時包括大 v 節點和小 v 節點這樣的圖結構稱之為 VS-Graph。我們的目標就是預測在 VS-Graph 上小 v 節點這樣的標簽,同時通過從大 v 節點向小 v 節點傳遞知識的方式,來提升模型在小 v 節點上的分類性能。

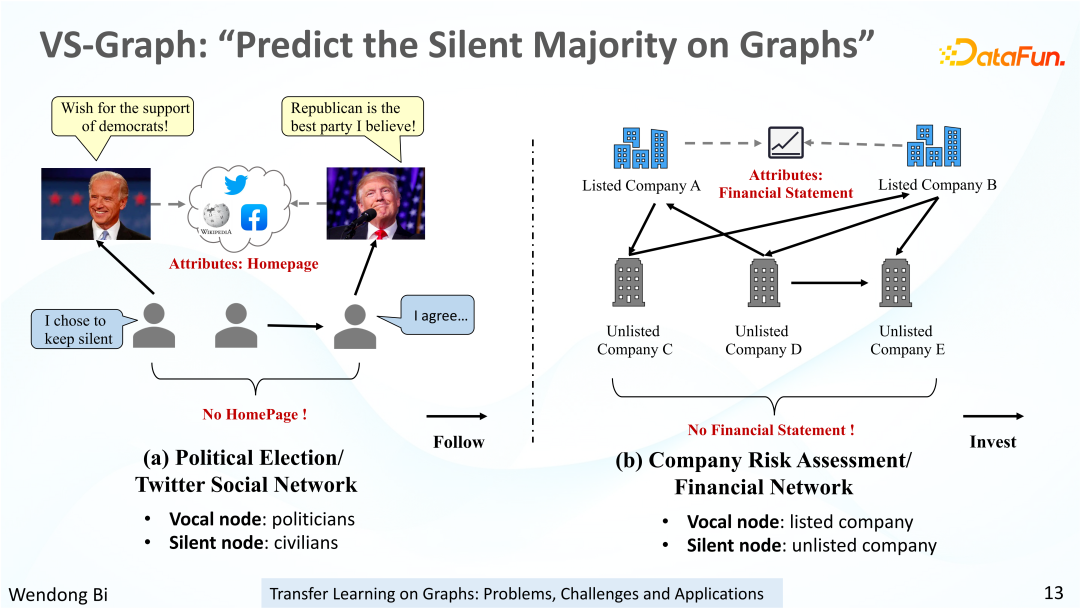

VS-Graph 在現實中是非常常見的,接下來以兩個現實應用場景為例,來介紹 VS-Graph。

1、VS-Graph:“預測圖上沉默的大多數”

第一個例子是政治選舉的社交網絡的場景。在 Twitter 社交網絡中,存在兩類用戶,一類是像特朗普、拜登這樣的政治家,另一類是一些普通用戶。這兩類用戶日常都會在 Twitter 上去發言,而他們發表的文字可以作為各自的特征。但是通過其它方式還可以獲取到政治家們更全面的個人信息,例如他們的個人主頁或者在維基百科中搜索的結果。對于普通用戶,這些是獲取不到的,但是普通用戶的數量遠高于政治家。所以在這樣一個場景下,我們希望預測普通用戶的政治傾向,也就是他是民主黨還是共和黨。大部分普通用戶的政治傾向是不明確的,因此我們只能獲得其中少量的具有明確政治傾向的用戶標簽。所以可以基于 Twitter 的社交網絡去構建一個 VS-Graph。大 v 節點就是政治家,小 v 節點就是普通用戶。而節點之間的邊則表示 Twitter 用戶之間的 follow 關系。

除了社交網絡的場景,還有金融場景下的 VS-Graph。比如公司的投資網絡上面存在著上市公司和非上市公司這兩類不同類型的公司,而上市公司的規模更大,非上市公司的規模較小,所以這兩種公司的特征數據分布往往是存在顯著的分布偏移的。此外,上市公司每年每季度都會公布他們的財務報表,我們可以通過財務報表來獲取上市公司的財務信息。而非上市公司沒有披露財務報表的義務,我們就無法獲取到一部分信息。此外,上市公司受到新聞媒體的關注度也是比較高的,他們的風險事件和風險標簽是比較透明的。但是對于非上市公司,他們的風險標簽則不易獲取。在金融場景下的公司風險評估任務當中,上市公司可以作為大 v 節點,而非上市公司則可以作為小 v 節點。他們之間的投資關系則可以作為 VS-Graph 的邊,進而我們可以通過從上市公司向非上市公司遷移知識來提升模型在非上市公司風險評估任務上的表現。

在 VS-Graph 上,我們的最終目標是預測小 v 節點,所以給這一任務也取了一個比較有意思的名字,就是在圖上去預測沉默的大多數。我們基于這兩個場景,分別用從真實應用場景中的獲取數據構造了 VS-Graph,并做了一系列的分析和實驗。

2、基于真實世界 VS-Graph 的數據分析

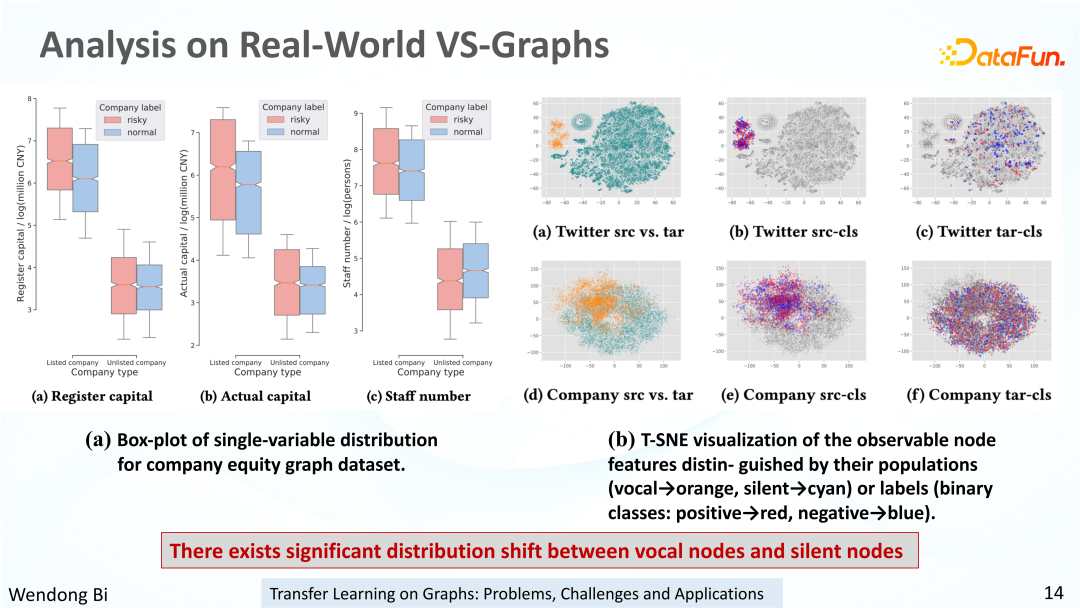

在剛才提到的兩個場景當中,小 v 節點屬性不可觀測以及標簽稀少的問題是天然存在的,所以我們主要是證明大 v 節點和小 v 節點在共有的屬性特征上,確實存在著明顯的分布遷移問題。

上圖中的圖(a)展示了公司風險場景下 VS-Graph 的節點屬性分布,這三幅箱型圖對應三個屬性,分別是公司的注冊資本、真實資本以及核心的員工人數。x 軸區分了上市公司和非上市公司。紅色和藍色分別代表有風險和無風險,也就是對應正負利益標簽。從圖中可以看出來兩個事情,一個是上市公司和非上市公司之間確實存在著非常顯著的分布差異,另一個則是有風險公司和無風險公司在屬性分布上也表現出一定的相關性。

第二幅圖是 Twitter 社交網絡和 company 公司網絡上對大 v 節點和小 v 節點的共有特征做的一個 T-SNE 的可視化分析。圖 (a) 和 圖 (d) 展示了大 v 節點和小 v 節點的分布差異,橙色點和青色點分別對應大 v 節點和小 v 節點。圖 (b) 和圖 (e) 分別是區分大 v 節點中的正例和負例,紅色和藍色分別代表正例和負例。圖 (c) 和 (f) 則是小 v 節點的正例和負例。

從這兩幅圖中能說明的一個問題就是,在 VS-Graph 的場景下,大 v 節點和小 v 節點的特征確實存在著非常顯著的分布差異。在 Twitter 社交網絡的場景下,主要是由于政治家和普通用戶的發言內容及主題差異導致的。而在 company 金融數據網絡上,主要是由于公司的規模大小差異,導致上市公司和非上市公司這兩種類型的公司的數據分布存在一個數據分布的遷移問題。

三、知識可遷移圖神經網絡

接下來介紹我們基于 VS-Graph 提出的一種新型的知識可遷移圖神經網絡模型,最后我們也會分享我們的論文和代碼鏈接。

1、在 VS-Graph 上的知識轉移

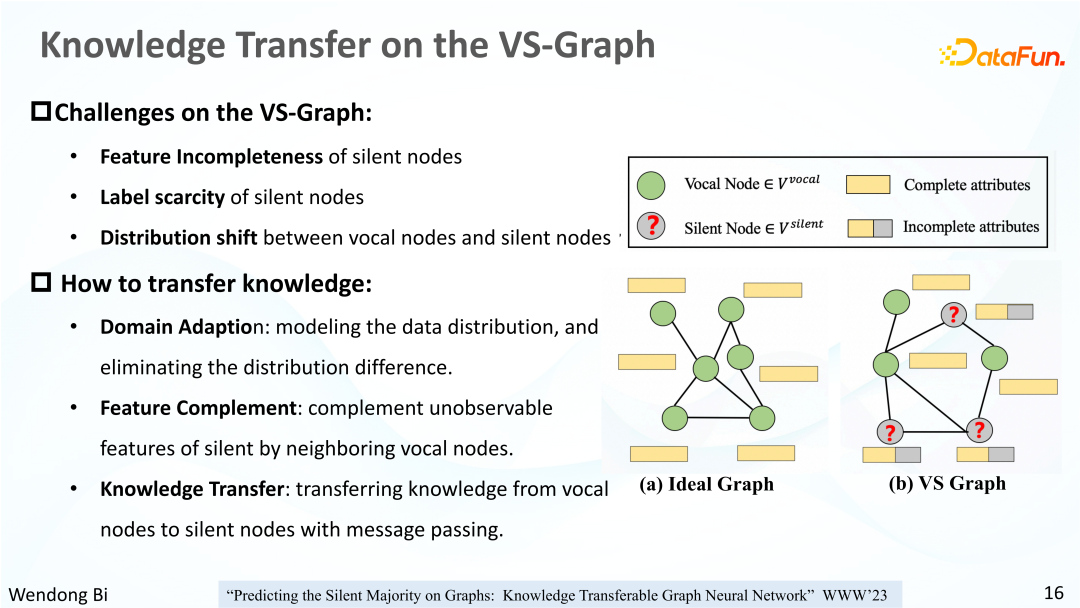

首先簡單總結一下 VS-Graph 的挑戰以及我們的目標。VS-Graph 上的挑戰可以總結為三點:

(1)小 v 節點屬性缺失或者不可觀測。

(2)小 v 節點的標簽很稀少。

(3)大 v 節點和小 v 節點之間存在天然的分布遷移問題,但卻通過邊相連構成了整個圖,所以它們之間并不是相互獨立的。

我們希望基于 VS-Graph 實現從大 v 節點向小 v 節點的知識遷移,從而使得模型能夠在小 v 節點的分類任務上的效果更好。針對上面提出的 3 個挑戰,我們總結了 3 個需要解決的問題以及它們的解決方案。

首先,由于大 v 節點和小 v 節點之間存在顯著的分布差異,應該考慮對數據分布的建模。這里我們通過領域自適應的方式,將大 v 節點和小 v 節點分別視為兩個不同的 domain,去建模它們的分布差異。其次,由于小 v 節點的部分屬性是不可觀測的,而這部分屬性對大 v 節點而言來又是可觀測的,所以希望基于大 v 節點的完全的特征來補全小 v 節點缺失的特征。最后則是要完成最后的知識遷移。以圖結構為媒介,可以將大 v 節點的知識以圖神經網絡中消息傳遞的形式遷移到小 v 節點,并且需要在消息傳遞的過程當中考慮每一條邊的原節點和目標節點之間的領域差異。

2、WWW2023:知識可轉移圖神經網絡

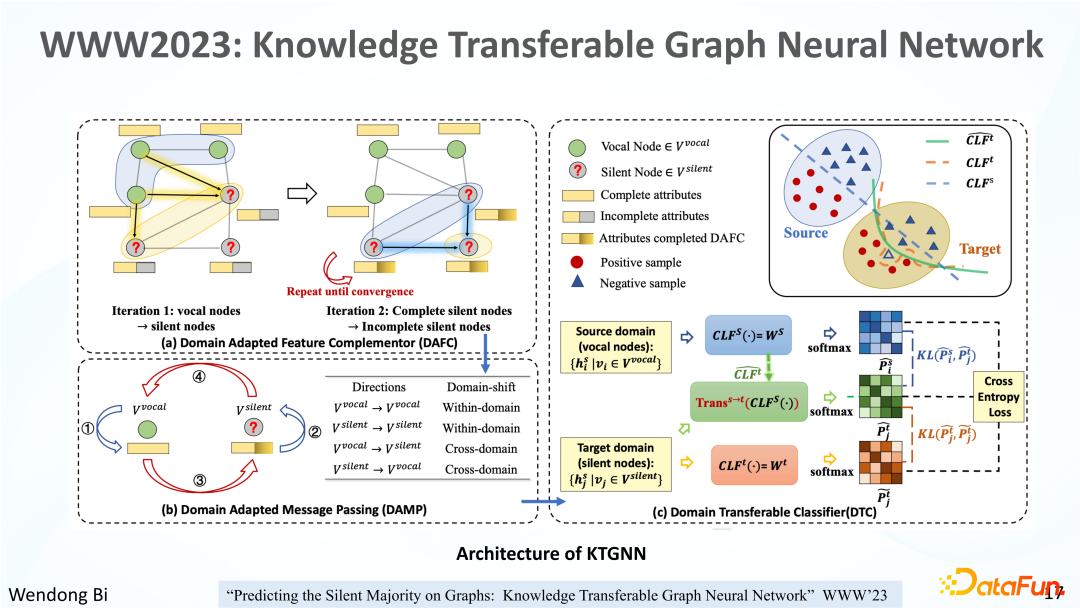

基于上述問題,我們設計了這樣一個知識可遷移的圖神經網絡 KTGNN 模型。上圖展示了 KTGNN 的整體結構。可以看到 KTGNN 的 pipeline 可以分為三個部分。在每一部分,都考慮了大 v 節點和小 v 節點之間的領域分布差異的建模。

第一步,考慮到小 v 節點相比大 v 節點存在部分不可觀測的特征,我們首先完成小 v 節點缺失屬性補全。

第二部分,進一步完成在 VS-Graph 上的消息傳遞,包括大 v 節點和大 v 節點之間、小 v 節點和小 v 節點之間的領域內消息傳遞,以及大 v 和小 v 節點之間的跨領域消息傳遞。在消息傳遞的過程當中,不同于之前遷移學習常用的不變性學習只保留了 domain invariant 的信息,我們的方法會保留不同領域節點的領域差異,而不是丟棄掉那些跟 domain 相關的信息,同時在保留不同領域節點的領域差異的情況下,去完成知識遷移。

第三部分,對來自不同領域的節點去訓練參數可遷移的分類器模塊。

接下來詳細介紹這三個部分。

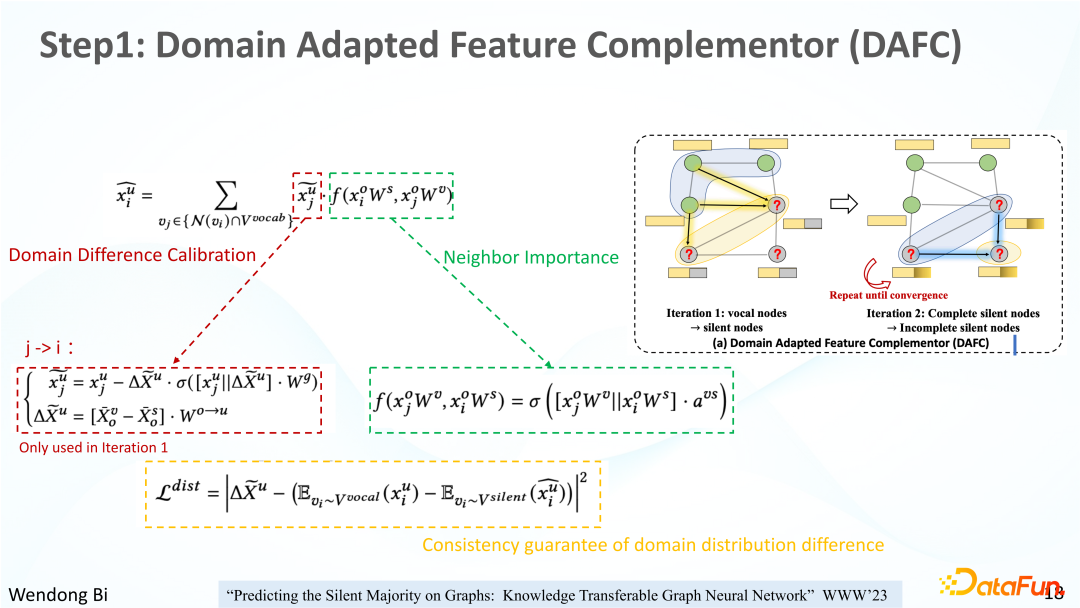

3、第一步:領域自適應特征補全(DAFC)

首先考慮到小 v 節點相比于大 v 節點的缺失了部分維度的屬性特征。比如像非上市公司,觀測不到其財務報表信息。所以要做的第一件事情就是通過特征完全的大 v 節點來補全圖中的小 v 節點缺失部分的特征。對此,我們設計了一個迭代的補全式算法。

具體而言,對于 VS-Graph 上的每一個小 v 節點,都通過從它的大 v 鄰居節點來向它遷移知識。在這個過程當中,考慮了兩方面的因素。一個是大 v 鄰居節點和小 v 節點之間存在一個數據分布的差異,所以需要先有一個領域差異矯正的過程,也就是消除原節點的領域分布差異,再把原節點的信息傳遞給目標節點。

領域差異矯正的計算過程在下面的紅框當中,首先會計算一個平均領域差異 Δx,再用大 v 節點的 feature 減去 rescale 后的領域差異變量 Δx。從而得到矯正后的原節點特征,用于補全目標節點的特征。同時也考慮到一個小 v 節點可能有多個大 v 節點鄰居,所以除了校正領域差異之外,還考慮了鄰居的重要性因子。通過大 v 原節點和小 v 目標節點共有的屬性,計算 attention 系數作為鄰居重要性因子,最終用鄰居重要性因子乘上矯正過后的大 v 原節點特征,再傳遞給小 v 目標節點,從而補全小 v 目標節點所缺失的那部分特征。但是也考慮到并不是所有的小 v 節點都會有大 v 鄰居節點,所以還會在此基礎上繼續去迭代。通過已經補全的小 v 節點繼續去補全剩余的還沒有補全的小 v 節點。只不過在從第二輪迭代開始的補全過程當中,由于原節點和目標節點已經都是小 v 節點了,所以也不再需要考慮領域遷移的問題,只需要考慮鄰居重要性因子這樣一個因素就可以了。

為了保證補全后的小 v 目標節點仍然是屬于小 v 節點的 domain,而不與大 v 節點的 domain 混淆,在這一步添加了領域分布差異的一致性保障損失,損失函數的計算過程在黃框當中,有關這一部分的詳細解釋,大家感興趣也可以去參考我們的原文。

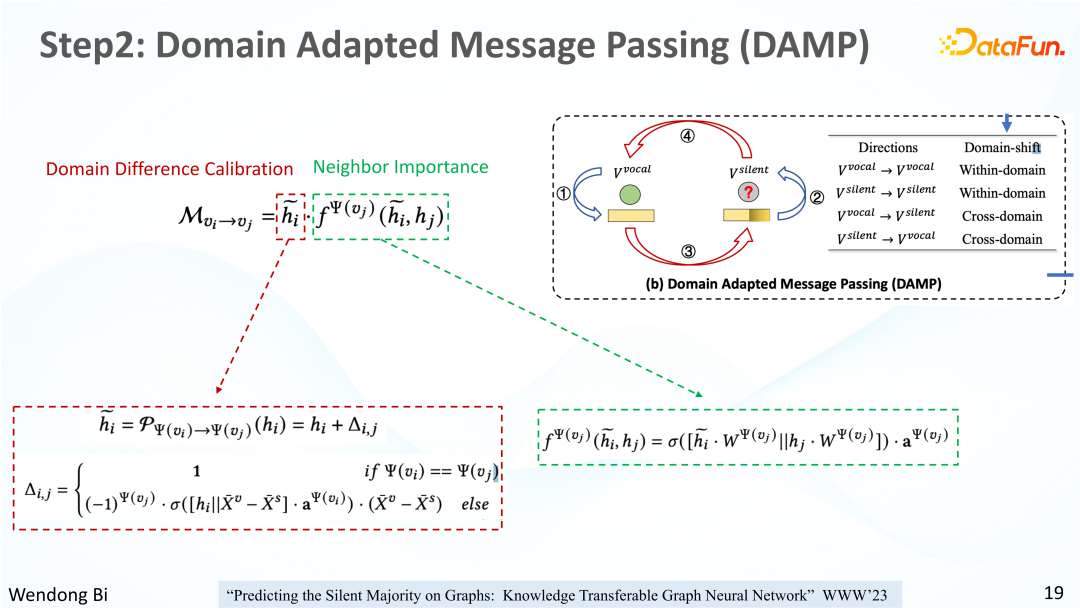

4、第二步:領域自適應消息傳遞(DAMP)

通過上面一步,在保留了大 v 節點和小 v 節點領域差異的情況下,已經補全了小 v 節點不可觀測的那部分特征。接下來將會以圖神經網絡消息傳遞的形式,進一步將大 v 節點的豐富知識傳遞給小 v 節點,從而增強小 v 節點的表示學習。

上一步中只考慮了從大 v 節點向小 v 節點去做知識遷移。而在消息傳遞模塊,消息傳遞方向可以分為 4 種,其中兩種是領域內的消息傳遞,包括大 v 節點到大 v 節點的消息傳遞,以及小 v 節點向小 v 節點的消息傳遞。另外兩種則是跨領域的消息傳遞,包括大 v 節點向小 v 節點的消息傳遞,以及小 v 節點向大 v 節點的消息傳遞。每次消息傳遞同樣也包括兩個因素,分別是領域差異的矯正和鄰居重要性因子。用矯正后的原節點特征乘以鄰居重要性因子之后,再將 message 傳遞給目標節點,從而去更新目標節點的向量表示。領域差異因子和鄰居重要性因子的計算過程,也分別列在了紅框和綠框當中。

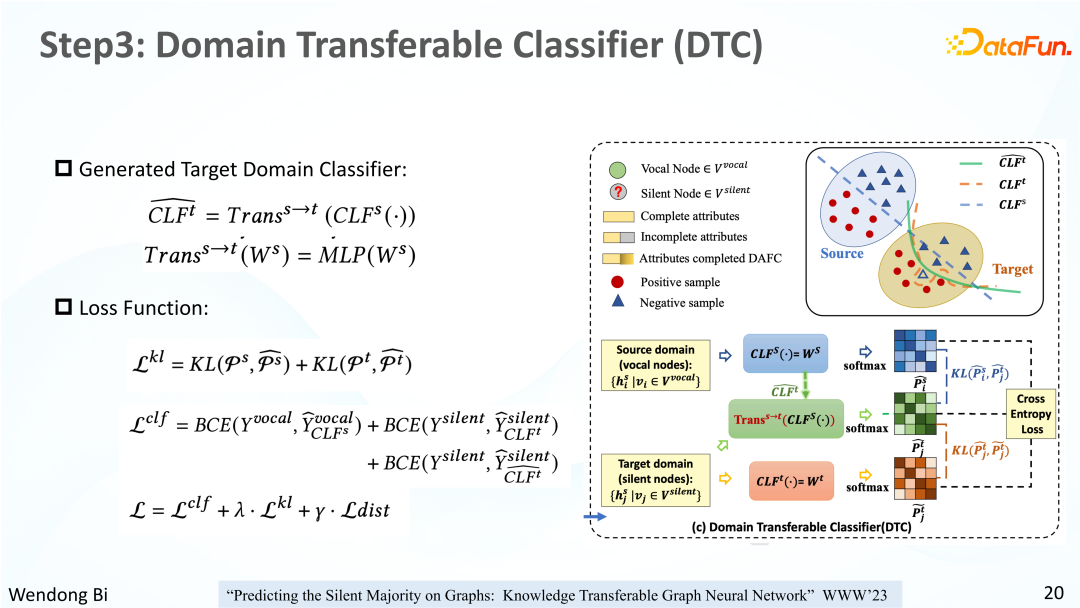

5、第三步:領域可遷移分類器(DTC)

在第二步當中每次消息傳遞的時候,就會先通過這樣一個領域差異校正完之后,再去傳遞給目標節點,這一過程依然保留了大 v 節點和小 v 節點的領域差異,又通過消息傳遞進一步將圖拓撲的信息編碼到了所學到的大 v 節點和小 v 節點的表示向量當中。

接下來最后一步,還需要訓練一個下游任務的分類器。我們最終的目標是對標簽稀少的小 v 節點去做節點分類。在這一步驟當中,將大 v 節點視為 source domain,而將小 v 節點視作 target domain。核心的 idea 在大 v 節點樣本上訓練一個好的分類器,再把分類器的參數遷移到 target domain。也就是站在巨人的肩膀上,在大 v 節點分類器的基礎上去生成一個小 v 節點的分類器,從而在標簽稀少的這樣小 v 節點上也能實現很好的分類效果。

如圖所示,首先會分別訓練一個大 v 節點分類器(藍色)和小 v 節點分類器(橙色)。在這樣一個過程當中,大 v 節點和小 v 節點分類器的訓練過程是互不影響的。同時還會有一個圖中綠色方塊所示的參數遷移模塊。通過對藍色的大 v 節點分類器的參數進行非線性變換,可以生成一個綠色的新的目標域分類器。同時這 3 個分類器都會通過分類損失作為進一步的指導。

為了保證圖中綠色的從源域分類器生成的目標域分類器能夠同時保留藍色的大 v 分類器和橙色的小 v 分類器各自的領域知識,我們對生成的目標域分類器的輸出分別與另外兩個分類器的輸出去計算 KL 散度損失,形成一個對抗和制衡的效果。最終會用綠色的這個新生成的分類器,去作為最終的小 v 節點的分類器,用于后續的評估任務。

這一過程不同于 feature-based 的遷移學習方法,這里是 parameter-based 的遷移學習方法。Feature-based 的遷移學習方法通常會學習一個 domain invariant 的 表示空間,并丟棄那些與 domain 相關的信息。而我們這里遷移的是分類器的參數。最終的損失函數由三部分構成,分別是分類損失、KL 損失,以及在第一步中用到的領域差異一致性的保障。從第一步到第三步,我們是采用端到端的訓練模式,并行地去優化模型各個模塊的參數。

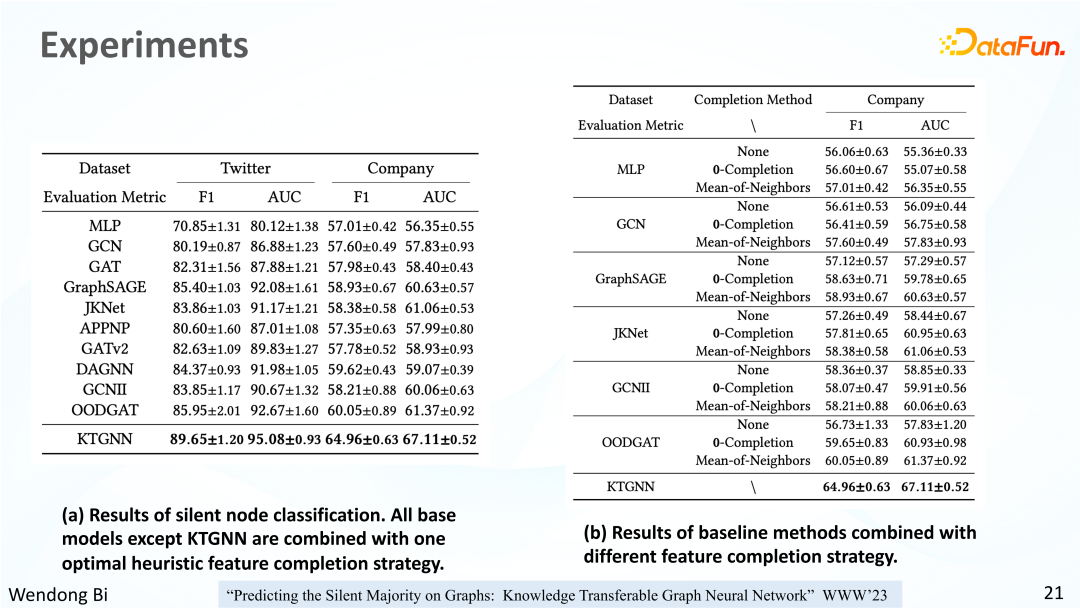

最終,我們的模型在 Twitter,社交網絡和 company 金融網絡當中都取得了顯著的效果提升。

第一張圖是模型最終的分類效果。以 F1 score 和 AUC 作為分類性能的指標,模型在這兩個數據集上比其它模型的效果都有了顯著的提升。在 Twitter 上提升了4%,在 company 上提升了 5%。

同時也考慮到很多 base 模型其實不能夠自動地去補全存在屬性缺失的節點。所以為了公平比較,我們也將這些 GNN 模型和一些啟發式的特征補全算法進行了結合。例如用 0 向量去補全,或者用鄰居特征的均值去進行補全,再去 train 一些這樣的 base GNN 模型。不同的 base 模型結合不同的特征補全方法的實驗結果也展示在了上圖當中。最終會為每個 base 模型選擇最佳的特征補全策略,再與我們的模型進行對比。

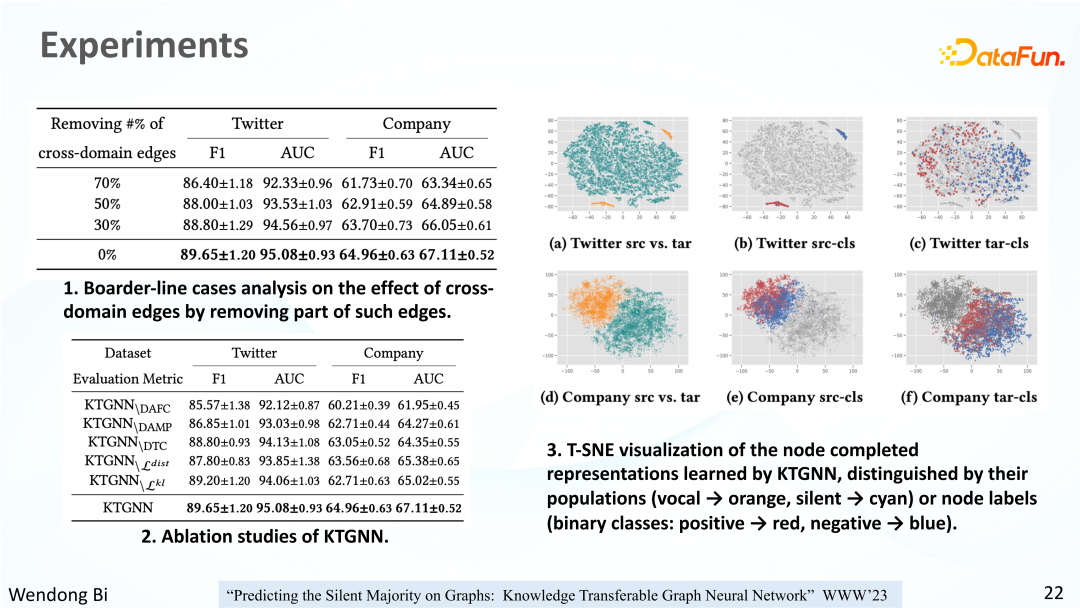

上圖中,表 1 展示了模型在對一些 borderline case 的驗證性實驗。考慮到我們的模型其實是借助跨領域的連邊,也就是大 v 節點和小 v 節點之間的連邊來實現知識遷移的,所以通過隨機刪除這種跨領域連邊,并逐漸增大刪除的跨領域連邊的比例,來驗證模型的魯棒性。在實驗結果中,即使是在刪除了 70% 的跨領域連邊的情況下,我們的 KTGNN 仍然能夠相比于其它模型有一定的提升。

表 2 當中顯示了我們的消融實驗的結果。通過刪除 KTGNN 中一些不同的子模塊,驗證刪除模塊后模型的分類效果。實驗結果表明,完整的 KTGNN 總能達到一個最優的效果。

右圖是模型學到的樣本特征進行 T-SNE 可視化的結果。子圖 (a) 和 (d) 當中的橙色點代表大 v 節點,青色點代表小 v 節點。KTGNN 學到的表示仍然保留了大 v 節點和小 v 節點的領域分布差異。對應在圖中分別是兩個不同的 cluster。在圖 (b) 和圖 (e) 當中,大 v 節點中的正負例區分情況也比原來的 RAW feature 有了一個很大的提升。KTGNN 學到的表示也可以較好地區分小 v 節點的正負例。即使小 v 節點的信息量比較少,學出來的小 v 節點表示仍然可以有一個比較好的正負例樣本之間的區分。

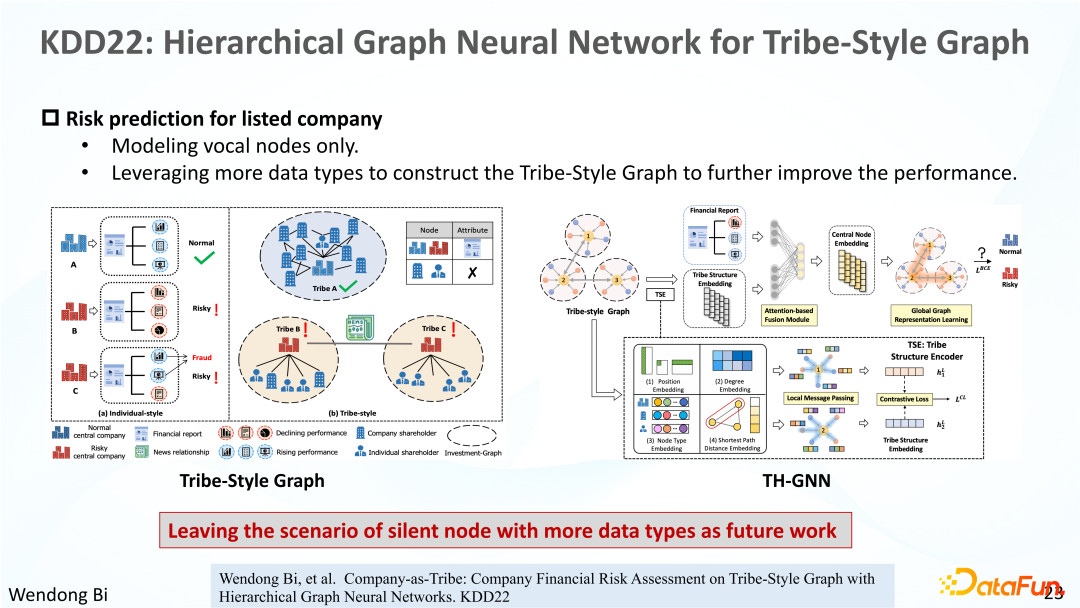

這里簡單介紹一下我們做的另外一個工作,也是在金融場景下,在公司風險評估任務上的一個嘗試。在這里考慮了上市公司更多的數據類型,但沒有考慮非上市公司,前文所介紹的工作,也是在這篇工作基礎上,發現了上市公司和非上市公司的數據存在顯著的分布偏移,所以才萌生了做圖上的遷移學習的任務。大家感興趣的話可以去閱讀這篇論文。

在這一工作中除了使用上市公司的財報數據之外,還使用了公司的股權網絡和新聞等多源異構數據,我們也把非上市公司,結合多源異構數據,同時考慮圖遷移學習工作,作為我們未來的工作之一。

四、總結與展望

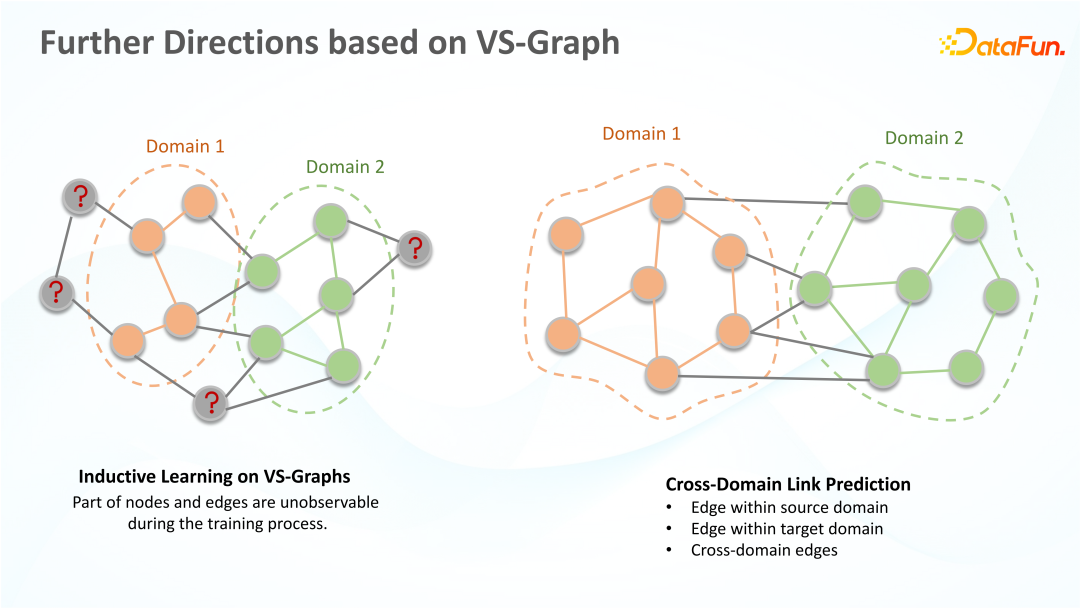

接下來分享對有關圖遷移學習未來可能的研究方向的一些看法。我們之前嘗試了 VS-Graph 上的 transductive learning 的場景,但在 VS-Graph 上的 inductive learning 其實也是很重要的。比如在實際部署模型當中,要考慮從來沒有在訓練集中出現過的節點。這些節點的信息量可能是更少的,而且模型在訓練過程當中從來沒有見到過這些節點,這樣的場景也是比較有挑戰的。

除此之外,之前的大多數圖遷移學習工作,以及我們之前對 VS-Graph 上的嘗試,討論的主要也是 graph level 和 node level 的遷移學習問題。有關圖上的邊級別的遷移學習任務,其實也是一個有待挖掘的領域。例如在 VS-Graph 的場景上,圖上的邊既有 source domain 的領域內連邊,也有 target domain 的領域內連邊,還有 source domain 和 target domain 之間的跨領域連邊。對于 graph 上,在做 link prediction 的時候,source node 和 target node 所屬的 domain 不同的情況也是很值得討論的。

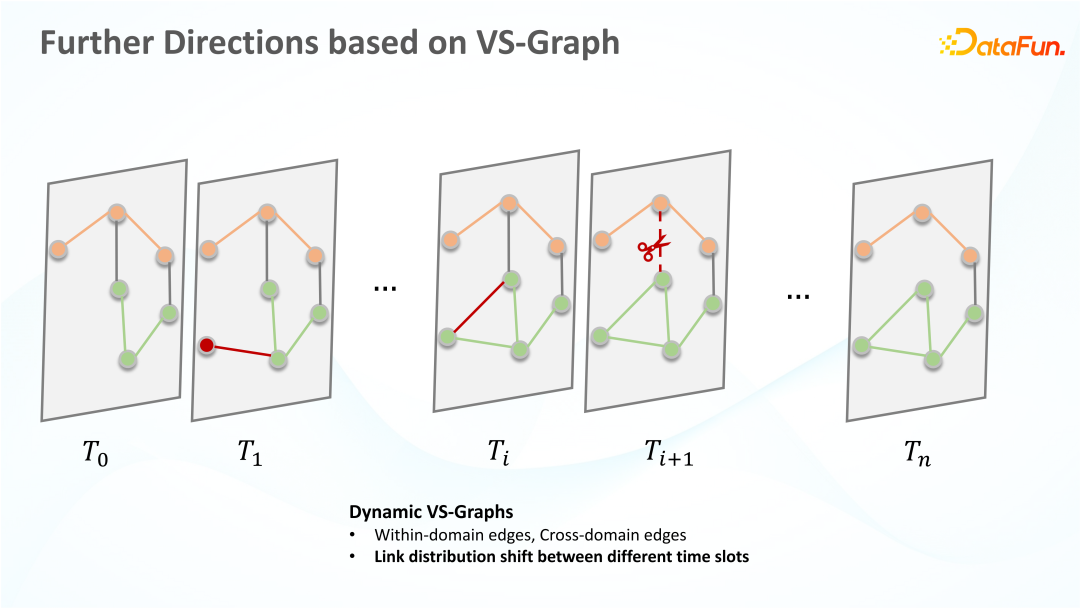

上述兩個問題都是定義在靜態圖的場景上面,也就是圖結構是不隨時間而變化的。但其實在很多真實的應用場景當中,圖結構可能是隨時間動態變化的。如何定義一個 dynamic 的 VS-Graph,在定義了這樣一個動態的 VS-Graph 之后,所有的 node level,edge level 或者 graph level 的遷移學習任務都要再額外考慮時間的因素。以及時間維度上,本身它可能也存在分布偏移的問題。比如在不同的時間段上,圖結構或者屬性變化的過程可能會發生改變。如何建模這些維度的數據分布的遷移,也是一個很有挑戰很有意思的任務。