10億參數模型進手機!15秒即可出圖,飛行模式也能用

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯(lián)系出處。

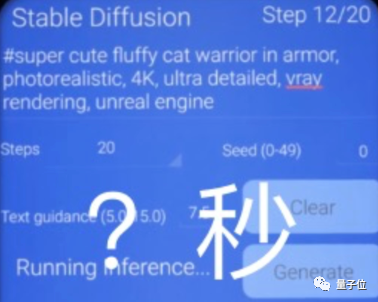

純靠手機跑Stable Diffusion,出一張圖需要多長時間?

答案是15秒以內。還是開飛行模式那種,完全不需要借助云服務器的算力!

不僅能生成動畫版鎧甲貓貓戰(zhàn)士,真人版《龍珠》cosplay大合照,也能迅速想象出來:

△圖源@TK Bay

當然,畫個中國風兔型剪紙圖像,也完全沒問題:

△圖源@TK Bay

此前,雖然已經有網友做出了一些能在手機上運行的Stable Diffusion項目,不過實際運行會發(fā)現,這些項目要么生成圖片的時間長、內存占用高、耗電量大,要么生成的圖像風格比較單一。

15秒內依靠手機算力出圖,風格還是多變的那種,究竟是怎么做到的?

手機15秒跑億級大模型

這個手機版15秒跑Stable Diffusion項目,是高通基于自己的手機芯片做的一個“演示”APP。

在前不久的MWC 2023上,高通現場展示了這個APP的生成效果,有不少線下參會的網友也體驗了一波,例如嘗試用它生成一群寶可夢:

△圖源@NewGadgets.de

迭代步數達到了20步,可以生成分辨率512×512的圖像。

據高通介紹,之所以相比其他項目,這個版本的Stable Diffusion能在手機上快速運行,是因為團隊專門基于移動端AI軟硬件技術,對開源模型進行了優(yōu)化。

其中,Stable Diffusion模型選用的是在Hugging Face上開源的FP32 version1-5版本。

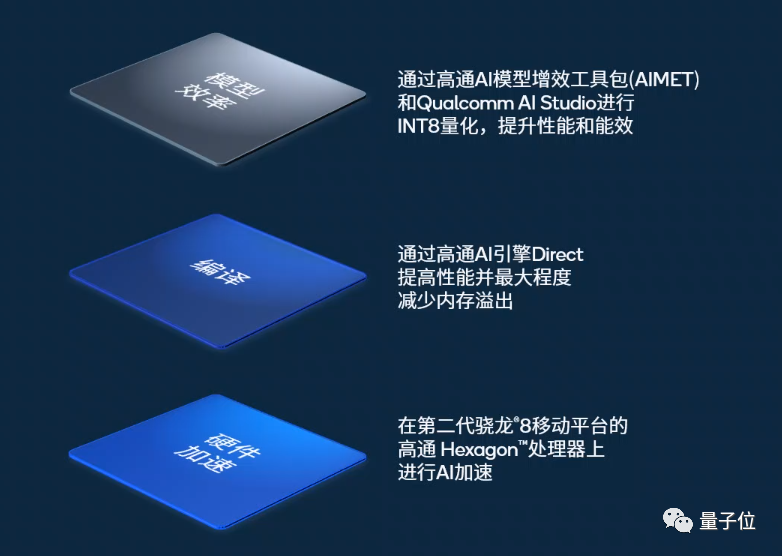

為了達到15秒“快速出圖”的效果,研究人員從硬件、框架和AI壓縮算法上入手,在確保出圖效果的同時,對模型大小和端側運行進行適配優(yōu)化:

- 硬件:第二代驍龍8移動平臺

- 框架:高通AI引擎Direct

- AI模型壓縮工具:AI模型增效工具包AIMET

首先,基于高通AI模型增效工具包AIMET,對訓練后的Stable Diffusion模型進行量化。AIMET中包括一些高通之前的量化研究算法如AdaRound等,能將模型精度從FP32壓縮到INT8,降低功耗的同時確保模型運行效果;

接下來,團隊基于高通的AI引擎Direct框架,對這一模型進行軟硬件協(xié)同優(yōu)化,讓它能更好地運行在AI計算專用的Hexagon處理器上,提升性能的同時最小化內存溢出;

最后,高通也采用了最新發(fā)布的第二代驍龍8移動平臺,支持一項名叫微切片推理(Micro Inferencing)的技術,能通過在時間軸上對網絡層進行切分,從而讓處理器始終處于高效運轉狀態(tài),提升效率。

不止是Stable Diffusion,其他生成式AI算法同樣如此。

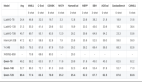

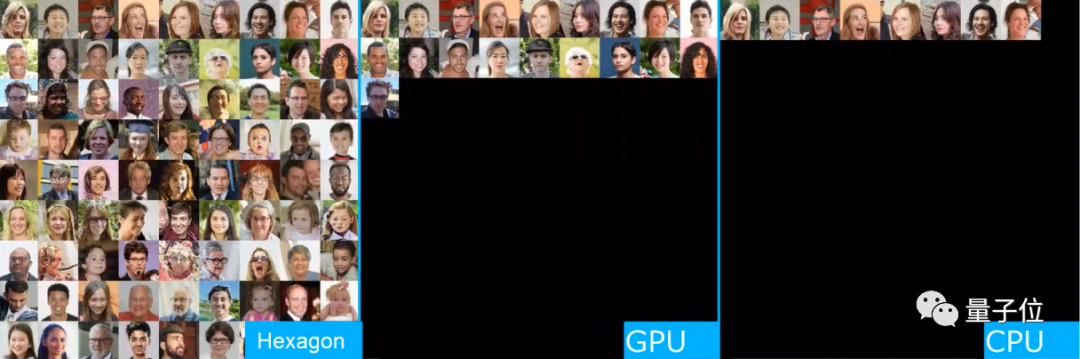

高通還展示了相比其他GPU和CPU,Hexagon處理器在移動端跑人臉生成算法的效率:

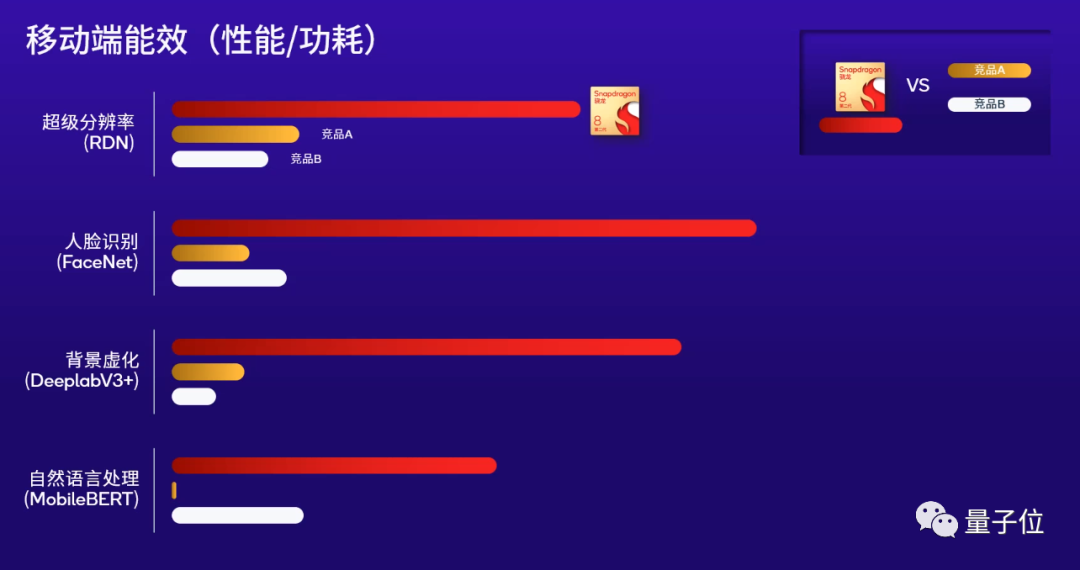

至于搭載Hexagon處理器的第二代驍龍8移動平臺,跑超分辨率(RDN)、背景虛化(DeeplabV3+)、人臉識別(FaceNet)和自然語言處理(MobileBERT)等算法上,性能同樣高出同行3~4倍:

而這也正是高通一直強調的“端側AI算力”性能。

據高通介紹,在這波生成式AI浪潮下,相比單純借助云端算力處理AI模型,端側的計算能力也同樣能被加以利用。

端側算力加速生成式AI落地

隨著這波大模型爆火,云端計算已經成為不少人受關注的技術。

然而,作為AI技術最直接的落地領域之一,同樣能提供算力的移動端,是否同樣會對這波生成式AI浪潮造成影響?

對此,高通技術公司產品管理高級副總裁兼AI負責人Ziad Asghar分享了他的看法。

Ziad Asghar認為,讓大模型這類生成式AI純粹在云端運行,存在幾個問題。

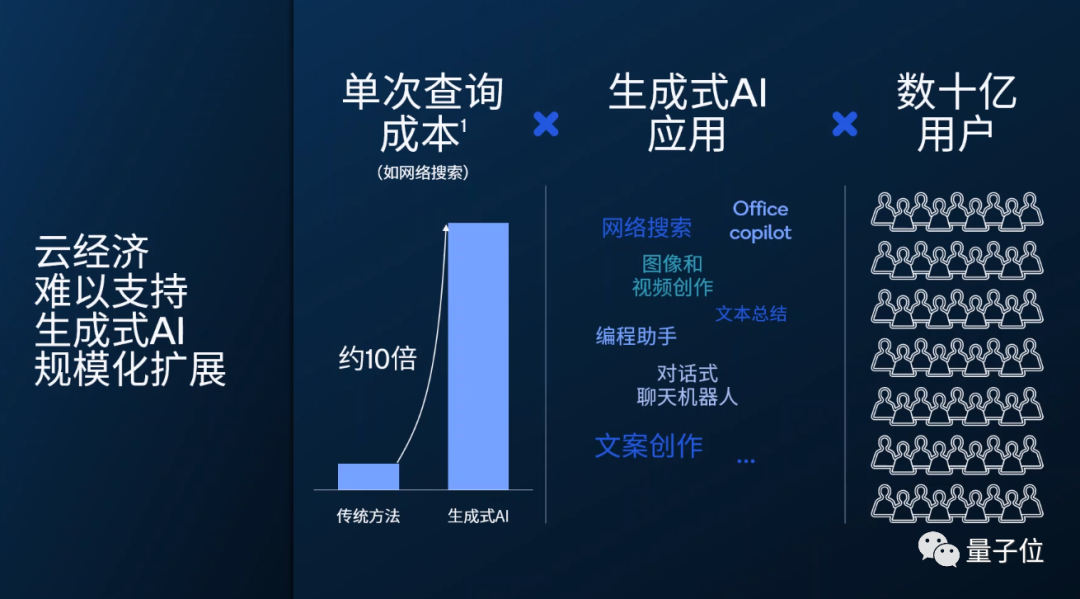

一方面,像網絡搜索這樣的算法,生成式AI的查詢效果雖然比傳統(tǒng)方法更好,但單次查詢成本也會更高。

隨著用戶數量的不斷增加,僅僅依靠云端算力,可能無法支持越來越多的生成式AI應用同時運行:

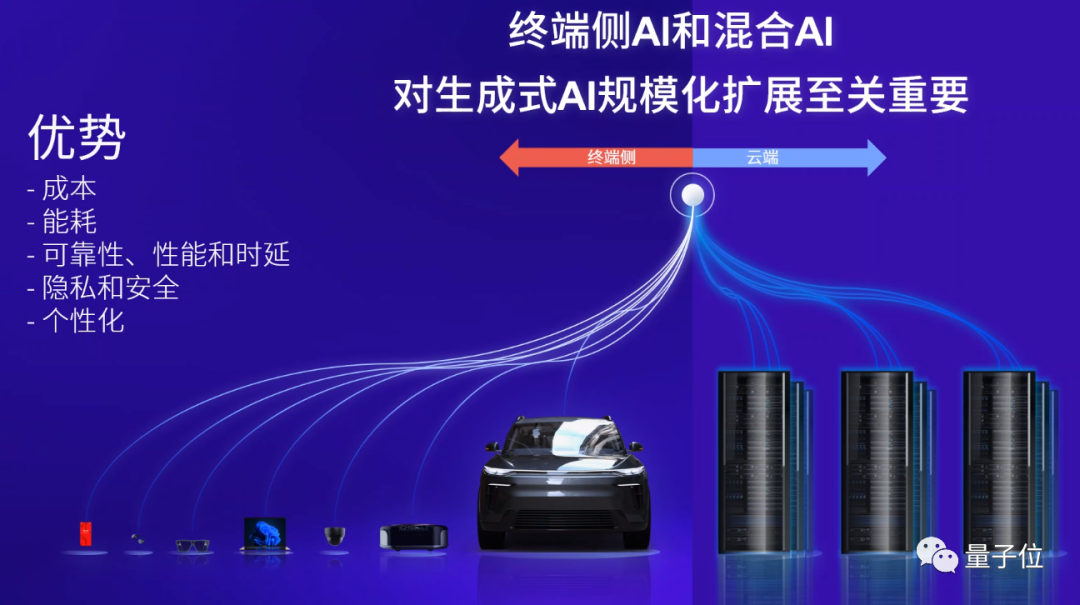

另一方面,雖然云端計算能力更大,但不少AI模型應用到端側時,在推理時還會面對處理用戶數據等涉及隱私安全方面的問題。

就拿個人搜索來說,要想使用AI算法更智能地搜索手機上的數據、同時又不上傳到云端處理,那么模型最終就得部署到端側,而非將用戶數據“聯(lián)網”上傳。

因此,要想讓生成式AI規(guī)模化落地,移動端也要從計算方式和應用途徑上作出對應的準備。

而這也是高通提出混合AI概念的原因,將一些AI模型放到終端側進行處理。

Ziad Asghar還表示,隨著移動端AI處理能力的不斷提升,未來幾個月內,我們就能看到100億參數的大模型在移動端運行:

到那個時候,或許手機上的AI助手就真能做到“專人定制”了。