南洋理工大學最新視覺語言模型綜述:預訓練、遷移學習和知識蒸餾啥都有

作為計算機視覺(CV)研究中長期存在的挑戰,視覺識別(如圖像分類、目標檢測和語義分割)是自動駕駛、遙感等眾多計算機視覺應用的基石。深度學習的出現使得視覺識別取得了巨大成功。然而,現有的視覺識別研究大多依賴于昂貴的標注數據進行深度神經網絡訓練,并且通常需要為每個任務訓練一個獨立的網絡,這導致了耗時費力的識別模式。

為了應對這些挑戰,大型視覺語言模型引起了廣泛關注并得到深入研究。通過學習互聯網上大量圖像-文本對之間豐富的視覺語言對應關系,現在可以使用一個視覺語言模型(如 CLIP、ALIGN)進行各種視覺識別任務的零樣本預測。

本綜述中,來自新加坡南洋理工大學的幾位研究者全面研究了針對視覺識別任務的大型視覺語言模型,總結了最近的發展。

首先,他們回顧了視覺識別的發展背景。接著介紹了視覺語言模型的基礎知識,包括廣泛采用的深度網絡架構、預訓練目標以及用于評估視覺語言模型的下游任務和常用數據集。在此基礎上,對視覺語言模型的預訓練方法進行了總結和分類。此外,還對基于視覺語言模型的遷移學習和知識蒸餾方法進行了系統分析。最后,對回顧的方法進行了基準測試、分析和討論,并提出了多個研究挑戰和未來視覺識別中可能的研究方向。本綜述將持續關注針對視覺識別任務的最新視覺語言模型相關工作。

圖片

圖片

- 論文地址:https://arxiv.org/pdf/2304.00685.pdf

- 項目地址:https://github.com/jingyi0000/VLM_survey

綜述動機

1. 視覺語言模型(如 CLIP)的出現顯著簡化了視覺識別任務的訓練模式,減少了對昂貴的精細標注數據的依賴。近年來,大量相關文章證明了研究者對視覺語言模型的濃厚興趣。

2. 目前缺乏全面的綜述來梳理基于視覺語言模型的視覺識別研究,以及面臨的挑戰和未來的研究方向。

因此,研究者認為有必要對視覺語言模型在各種視覺識別任務中的研究進行系統總結,以填補這一空白。

綜述特點

1. 系統性:本文從多個角度對基于視覺語言模型的視覺識別進行了系統總結,包括背景、基礎、數據集、方法、基準測試和未來研究方向。

2. 全面性:本文全面總結了相關工作,包括視覺語言模型的預訓練方法,以及視覺語言模型的遷移學習和知識蒸餾方法。

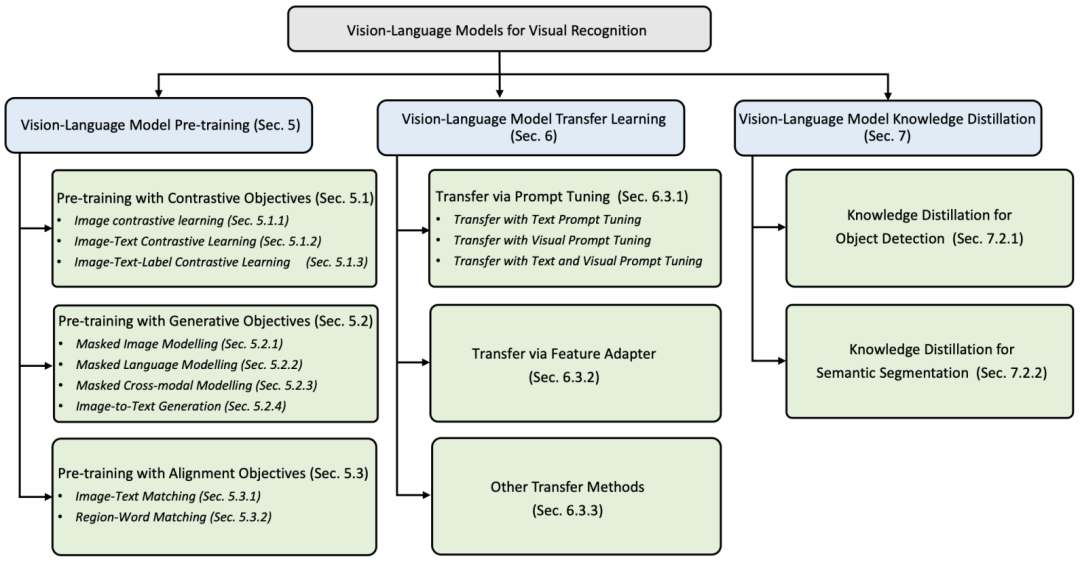

3. 詳細分類:對于每個方法類別,本文進行了詳細分類,總結類似方法的工作,并進行了對比分析。例如,對于視覺語言模型的預訓練方法,本文將其分為基于對比學習、基于生成目標和基于對齊目標的三大類,并在每個類別下進一步細(圖 1)。

圖 1. 綜述的分類總覽。

圖 1. 綜述的分類總覽。

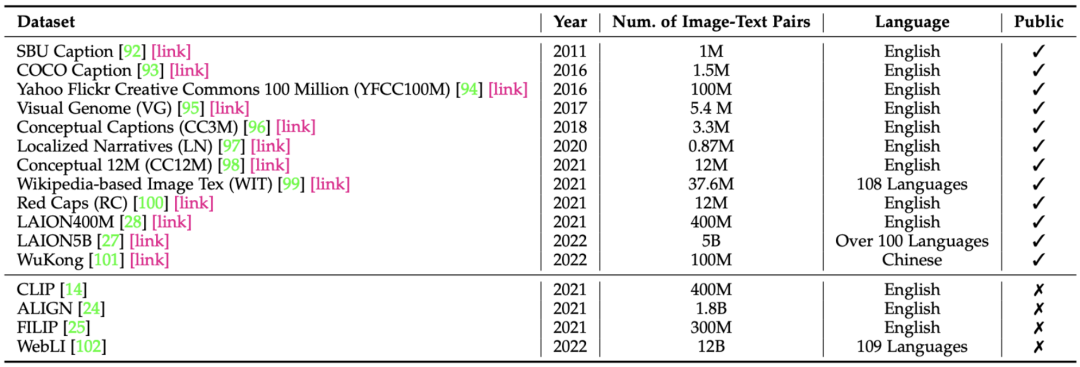

圖 2. 常用的視覺語言模型預訓練數據集總結。

視覺語言模型預訓練方法的總結與對比

本文首先對視覺語言模型的預訓練方法進行了總結和分類對比,分別為以對比學習為目的的方法、以生成任務為目的的方法和以對齊為目的的方法。

1. 基于對比學習的方法(Pre-Training with Contrastive Objectives)。對比目標通過在特征空間中將配對樣本拉近并將其他樣本推遠來訓練視覺語言模型學習具有識別力的特征。本章節根據對比學習的輸入,進一步將方法細分為基于圖像對比學習的方法,基于圖像-文字對比學習的方法和基于圖像-文字-標簽對比學習的方法。

2. 基于生成任務的方法(Pre-training with Generative Objectives)。基于生成任務的方法通過訓練網絡進行圖像生成、語言生成或跨模態生成來學習語義特征,進一步可細分為基于掩碼圖像建模的方法、基于掩碼語言建模的方法、基于掩碼跨模態建模的方法和基于圖像到文本生成的方法。

3. 基于對齊目的的方法(VLM Pre-training with Alignment Objectives)。對齊任務目的是在將圖像和文字的特征進行匹配,通常可以分為全局的圖像-文字匹配和局部的圖像區域-單詞匹配。

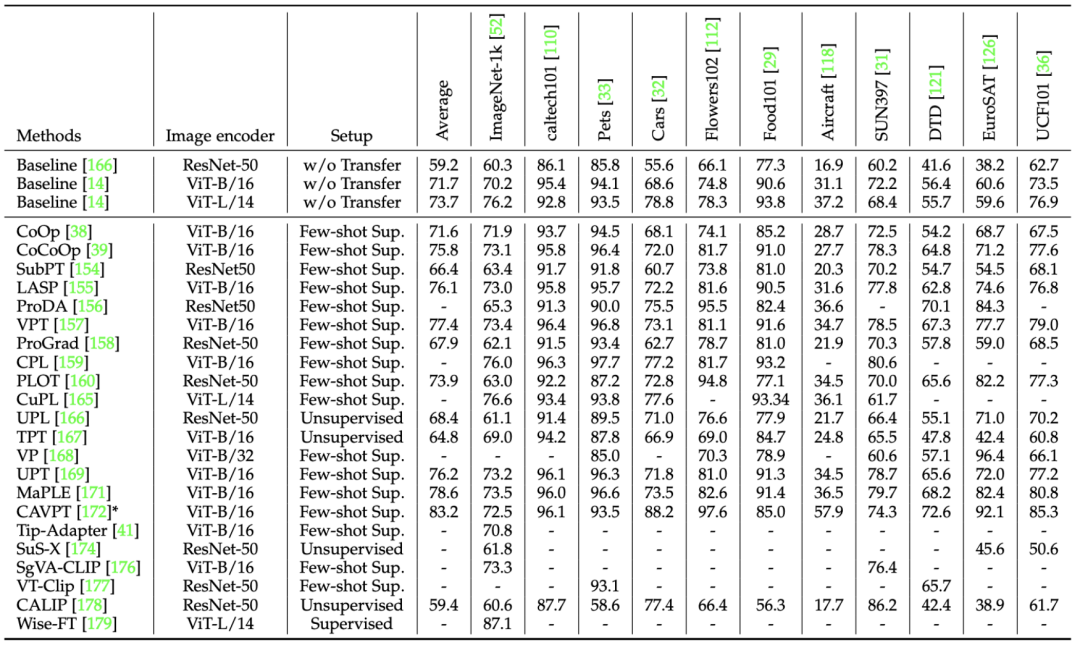

視覺語言模型遷移方法的總結與對比

除了直接將預訓練的視覺語言模型應用于下游任務的零樣本預測之外,視覺語言模型的遷移學習同樣吸引了大量的注意。遷移學習的目的是使得預訓練過的視覺語言模型可以更好地適應下游任務。

本文將視覺語言模型的遷移方法主要分為了三大類,分別為提示調整方法、特征適配器方法和其他方法。

1. 提示調整方法(Prompt Tuning)。受自然語言處理中「提示學習」的啟發,提示學習方法也被探索并且用于視覺語言模型的遷移中,通過尋找最佳的 prompt,并且不需要微調全部視覺語言模型的參數來適應下游任務。目前的提示調整方法進一步可以被分為文本提示調整、視覺提示調整和文本-視覺提示調整三種方法。

2. 特征適配器方法(Feature Adapter)。特征適配通過額外的輕量級特征適配器對視覺語言模型進行微調,以適應下游任務的圖像或文本特征。

3. 其他方法。除了提示調整方法和特征適配器方法,一些研究也通過其他方法對視覺語言模型進行遷移,比如進行對視覺語言模型直接進行微調、更改視覺語言模型的架構等。

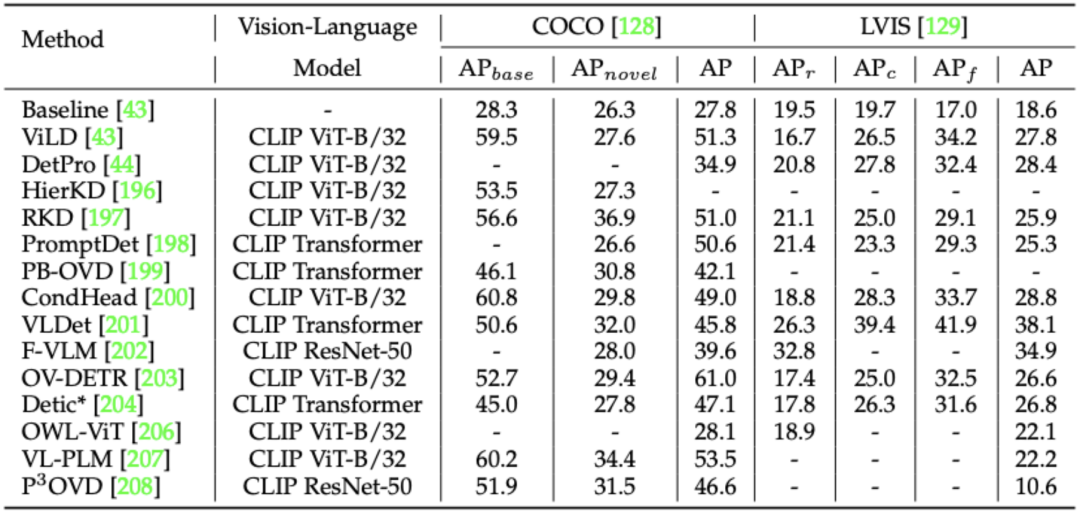

視覺語言模型知識蒸餾方法的總結與對比

視覺語言模型可以提取到視覺和文本概念的通用知識,因此一些研究探索了如何提煉通用視覺語言知識,來處理復雜的密集預測任務,例如目標檢測和語義分割。

與視覺語言模型遷移方法不同,對視覺語言模型進行知識蒸餾的方法通常不受視覺語言模型架構的限制,并且大部分研究會利用當前最先進的檢測或者分割架構的優勢來達到更好的性能。

本文根據任務的不同,將知識蒸餾方法分為了針對于開放詞匯目標檢測(open-vocabulary object detection)的知識蒸餾以及針對于開放詞匯語義分割(open-vocabulary semantic segmentation)的知識蒸餾。

實驗結果比較

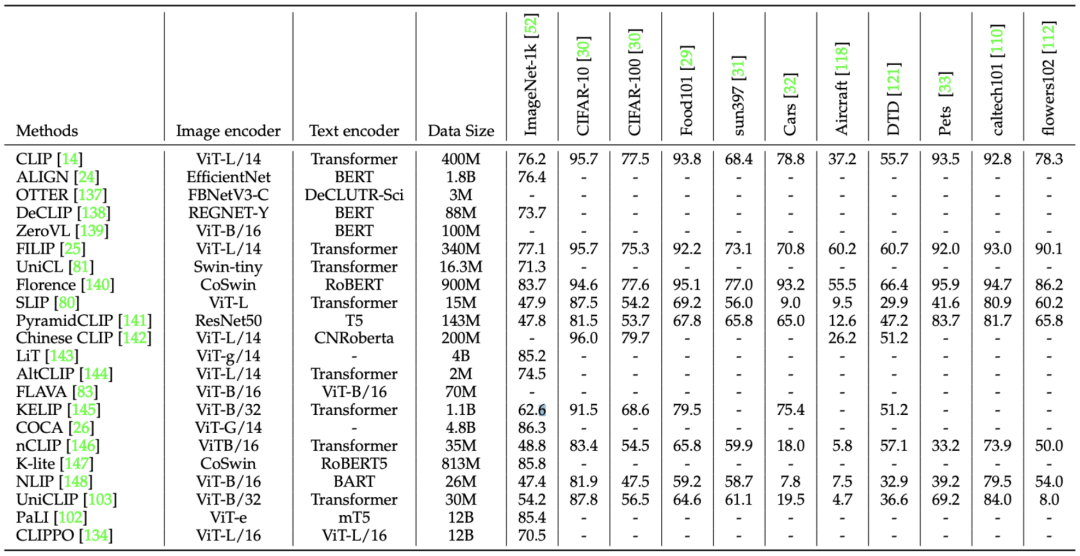

本文分別對視覺語言模型的預訓練方法、遷移方法和知識蒸餾方法在各自的評估任務上進行了比較,并且對結果進行了分析(圖 3-5)。

圖 3. 視覺語言模型預訓練方法在圖像分類任務中零樣本預測的性能

圖 3. 視覺語言模型預訓練方法在圖像分類任務中零樣本預測的性能

未來方向

最后,本文還分享了一些研究挑戰和潛在的研究方向,可以在未來的視覺語言模型研究中進行探索。

對于視覺語言模型的預訓練:

- 細粒度視覺語言關系建模:通過考慮局部的視覺語言相關性知識,視覺語言模型可以更好地識別圖像的區域和像素點,特別對于密集預測任務如目標檢測和語義分割,在各種視覺識別任務中起到重要作用。

- 統一視覺和語言學習的架構:Transformer 的出現使得圖像和文字可以通過相同的方式進行學習,這使得可以采用統一的 Transformer 架構處理圖像和文字。與現有采用兩個獨立網絡的視覺語言模型相比,統一視覺和語言學習可以實現跨模態的有效交流,并有效提升預訓練的效率。

- 多語言適應性的視覺語言模型預訓練:目前大多數視覺語言模型僅使用單一語言進行預訓練(如英語),限制了其在非英語地區的應用。通過采用多種語言文本進行預訓練,可以學習不同語言下相同單詞的文化視覺特征,從而使視覺語言模型能夠在不同語言環境下高效且有效地工作。

對于視覺語言模型的遷移:

- 無監督的視覺語言模型遷移:目前的遷移研究大多采用監督或少樣本監督學習,需要標記數據,而后者往往容易過擬合到少量樣本上。無監督的遷移可以探索大量未標記的數據,并且降低過度擬合的風險。

- 使用視覺提示 / 適配器進行遷移:目前的遷移研究主要集中在文本提示學習上。視覺提示學習或視覺適配器可以作為文本提示的補充,在各種密集預測任務中實現像素級的適應,從而獲得更好的效果。

對于視覺語言模型的知識蒸餾,可以從兩個方面進行進一步探索。第一,可以同時對多個視覺語言模型進行知識蒸餾,通過協調多個視覺語言模型的知識蒸餾來獲得更好的效果。第二,可以將知識蒸餾應用于其他視覺識別任務,例如實例分割、全景分割、行人重新識別等,以進一步擴展知識蒸餾的應用領域。