DeepMind:大模型又曝重大缺陷,無法自我糾正推理,除非提前得知正確答案

大語言模型又一項重大缺陷被DeepMind曝光!

LLM無法糾正自己推理中的錯誤。

「Self-Correction」作為一種讓模型修正自己回答的技術,在很多類型的任務中都能明顯改進模型的輸出質量。

但是最近,谷歌DeepMind和UIUC的研究人員卻發現,對于推理任務,LLM的「自我糾正機制」一下子就沒用了。

圖片

圖片

而且LLM不但不能自我糾正推理任務的回答,經常自我糾正之后,回答質量還會明顯下降。

馬庫斯也轉發了這篇論文,希望讓更多研究人員關注大語言模型的這一缺陷。

圖片

圖片

「自我糾正」這一技術是基于一個簡單設想——讓LLM對自己生成的內容根據一定標準來進行糾正和改進。這個方法在數學問題等任務上能明顯提高模型的輸出質量。

但是研究人員發現,在推理任務中,自我糾正之后的反饋有時很不錯,有時效果卻很不理想,甚至性能還會出現下降。

圖片

圖片

研究人員又研究了那些認為「自我糾正」可以改進推理輸出的文獻,經過仔細檢查發現,「自我糾正」的改進來自于引入了外部的信息來指導模型自我糾正。而當不引入外部信息時,這些改進就會消失。

圖片

圖片

具體來說,當模型能夠訪問基準數據集中包含的真值標簽(ground-truth labels)時,自我糾正就能有效地發揮作用。

這是因為算法可以準確地確定何時停止推理過程,并避免在答案已經正確時更改答案。

研究人員認為,先前的研究中往往會使用真實標簽來防止模型將正確答案更改為錯誤答案。但如何防止這種「對改錯」情況的發生,實際上是確保自我糾正成功的關鍵。

因為當研究人員從自我糾正過程中刪除真實標簽時,模型的性能就會顯著下降。

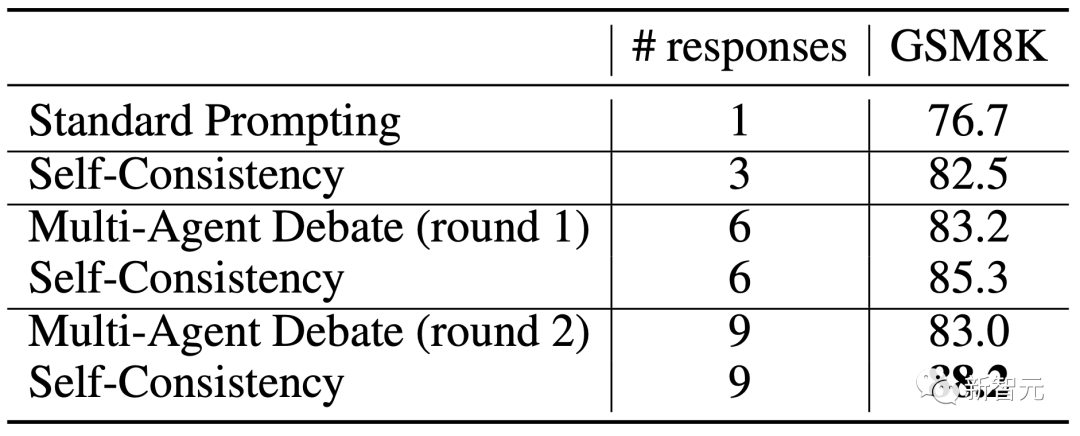

作為改進LLM在推理任務上自我糾正方法的嘗試,研究人員還探究了「多智能體辯論(multi-agent debate)」作為改進推理的手段的潛力。然而,他們的結果表明,在考慮同等數量的響應時,這個方法的效果并不比自我一致性(Self-Consistency)更好。

圖片

圖片

研究人員進一步提出了「事前提示」和「事后提示」的概念。

他們將自我糾正視為事后提示的一種形式,其中糾正的提示是在LLM的回復之后再輸入的。

研究人員的分析表明,某些任務中自我糾正帶來的增強可能源于精心設計的反饋提示,掩蓋了簡陋的初始提示。

在這種情況下,將更好的反饋集成到初始指令中或設計更好的初始提示可能會產生更好的結果并降低推理成本。

根據研究人員的研究結果,研究人員深入探討了LLM自我糾正能力的細微差別,敦促研究社區能以更加嚴謹的態度來對待對自我糾的研究。

大語言模型可以自我糾正自己的推理嗎?

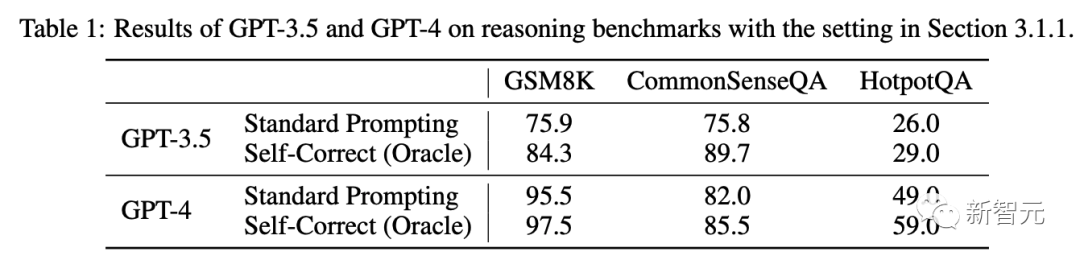

研究人員嘗試采用現有的自我糾正方法,采用其設置(使用標簽來指導自我糾正過程),以檢查其在提高LLM推理任務表現方面的有效性。

實驗設置

提示詞

研究人員采用三步提示策略進行自我修正:

1)提示模型進行初始生成(這也是標準提示的結果);

2)提示模型回顧其上一代并產生反饋;

3)通過反饋提示模型再次回答原來的問題。

模型

研究人員的主要測試是在 GPT-3.5-Turbo 上進行的。

研究人員還對2023年8月29日訪問的GPT-4進行了測試,旨在測試OpenAI模型最新、最強大的迭代的自我校正能力。

對于 GPT-3.5,研究人員采用前面提到的完整評估集。對于 GPT-4,為了降低成本,研究人員為每個數據集隨機抽取了 200 個問題(HotpotQA 為 100 個問題)進行測試。

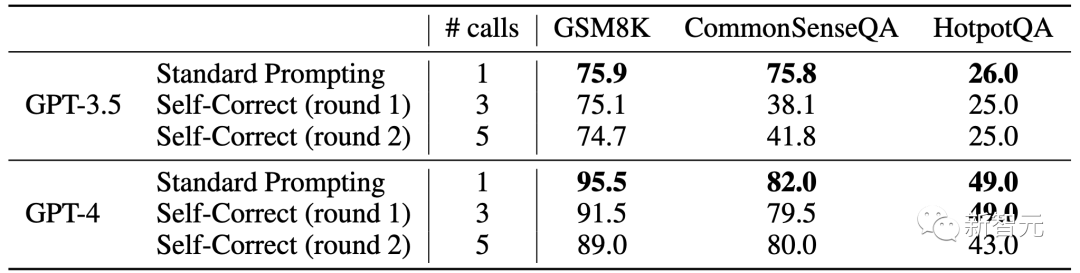

結果和思考

圖片

圖片

雖然研究人員在實驗中沒有利用任何外部資源或工具,但研究人員遵循之前的工作,使用真值標簽來確定何時停止自我校正循環。

但是在現實環境中,尤其是當研究人員打算用LLM來解決數學問題時,大部分時候是不知道正確答案的。

因此,性能的提升需要更仔細的考慮。

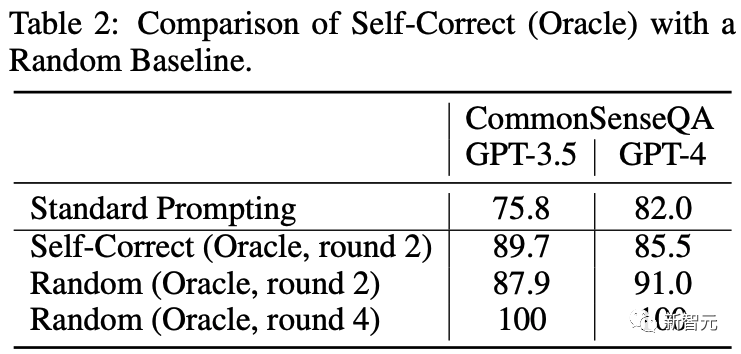

為了證實這一觀點,研究人員設計了一個基于隨機猜測的基線。在此基線中,研究人員繼續使用真值標簽來確定何時停止;然而,糾正措施不是由LLM采取的,而是根據剩余選項的隨機猜測得出的。

CommonSenseQA 是一個多項選擇題數據集,為每個問題提供五個候選選項。

如果第k輪(初始生成為第0輪)的生成精度表示為 x,則后續生成的預期精度變為 x + (1 ? x)/(5 ? k)。

圖片

圖片

上表2列出了該隨機基線的結果。

2輪后,其性能與自校正相當甚至更好,4輪后,其準確率達到100%。

然而,很明顯,這樣的隨機基線不能被視為有效的校正方法。盡管如此,使用標簽獲得的結果仍然可能起到預言機的作用,表明存在可以判斷答案正確性的完美驗證者。

在代碼生成等任務中,這是可行的,因為研究人員可以利用執行器和單元測試來確定生成的代碼是否成功運行(Chen 等人,2023b)。

然而,對于推理任務,比如解決數學問題,這種設置似乎違反直覺。如果研究人員已經掌握了事實真相,那么似乎就沒有理由再用LLM來解決問題。

內在自我修正

對于 GSM8K,可能不存在類似的隨機基線,但基本原理保持不變。

此外,研究人員可以設計一個基線,例如每次生成一個隨機數。經過相當多的輪次后,它可能會得到正確的答案,但這樣的改進顯然沒有意義。更直接的理由是:如果研究人員已經知道答案,為什么還要這樣做?

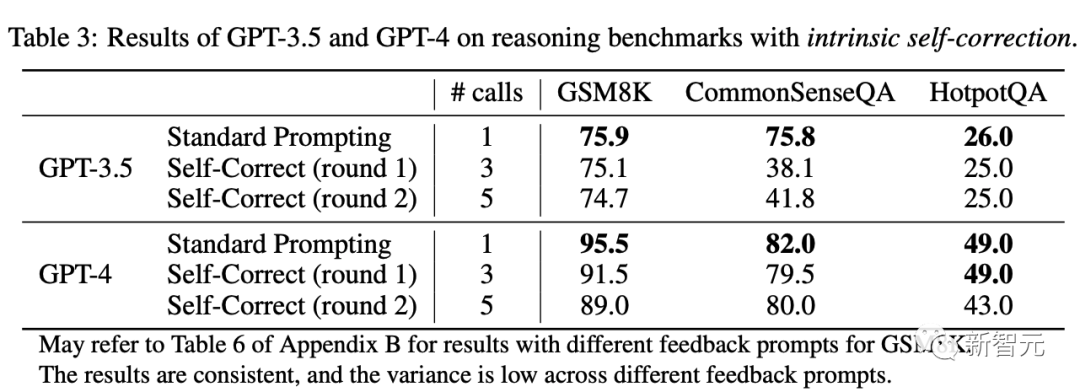

實驗設置如前面內容定義的那樣。為了實現這一點,研究人員只需刪除使用標簽來確定何時停止并通過兩輪自我校正來評估性能。

圖片

圖片

上表3展示了準確度和模型調用次數。研究人員觀察到,經過自我修正后,模型的性能在所有基準測試中都會下降。

為什么性能反而下降了?

圖片

圖片

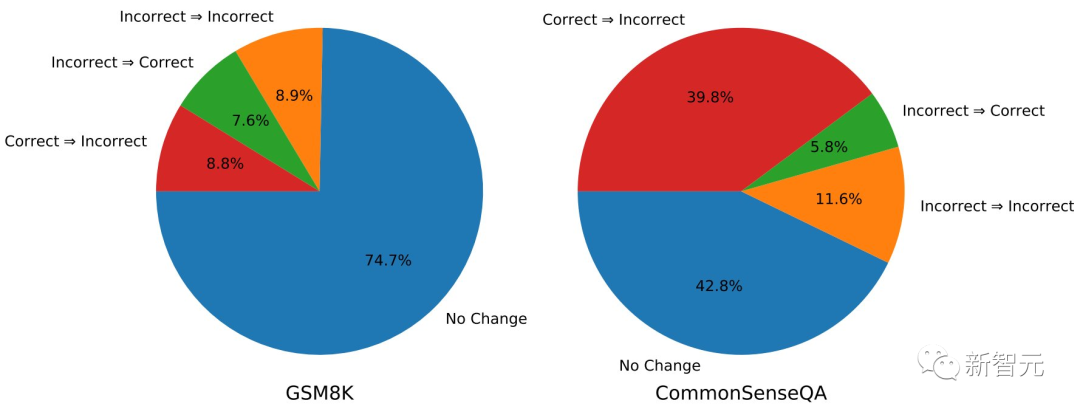

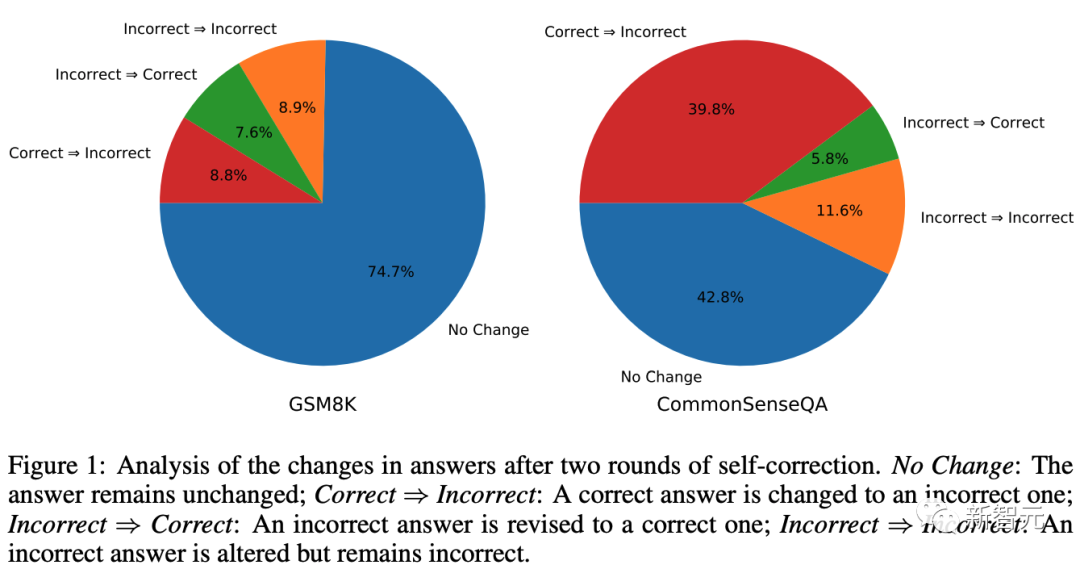

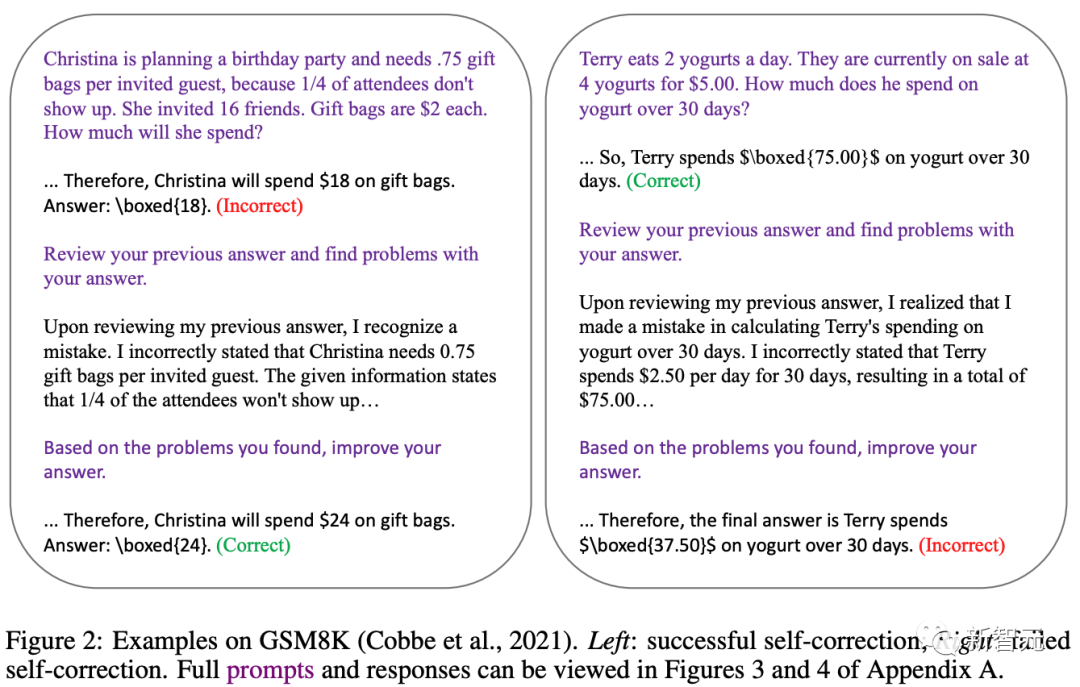

上圖1總結了使用 GPT-3.5 進行兩輪自校正后答案變化的結果,下圖2中展示了兩個示例。

圖片

圖片

對于GSM8K,74.7%的概率下模型保留其初始答案。在其余實例中,模型更有可能將正確答案修改為錯誤答案,而不是將錯誤答案修改為正確答案。

對于CommonSenseQA,GPT-3.5改變其答案的可能性更高。造成這種情況的主要原因是CommonSenseQA中的錯誤答案選項通常看起來與問題有些相關,并且使用自我更正提示可能會使模型偏向于選擇另一個選項,從而導致較高的「正確?錯誤」比率。

讓研究人員再看一下上表1中顯示的結果。這些結果使用真值標簽來防止模型將正確答案更改為錯誤答案。

然而,如何防止這種「修改錯誤」的發生,實際上是確保自我糾錯成功的關鍵。

直觀的解釋是:如果該模型與精心設計的初始提示相匹配,那么在給定提示和具體的解碼算法的情況下,初始響應應該已經是最佳的。

引入反饋可以被視為添加額外的提示,可能使模型偏向于生成適合該組合輸入的響應。

在內在自我糾正設置中,在推理任務中,這種補充提示可能不會為回答問題提供任何額外的優勢。

事實上,它甚至可能使模型偏離對初始提示產生最佳回復,從而導致性能下降。

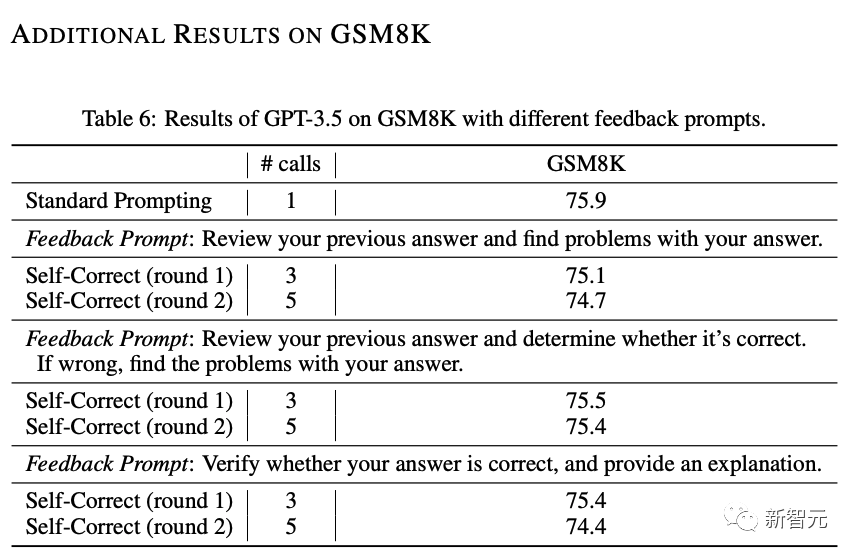

有人可能會想,研究人員測試的自我修正提示是否不理想?

其他提示能否提高性能?答案是:研究人員完全有可能找到一個在特定基準上增強模型性能的提示。然而,這不再與本文討論的內在自我校正設置一致,類似于真正的少樣本設置的討論。

這種搜索本質上是利用人類或訓練示例的反饋。此外,同樣的策略也可以有效地應用于優化初始提示,可能會獲得更好的性能,而無需額外的模型調用來進行自我校正。

在附錄B中,研究人員測試了不同的提示,但發現性能仍然沒有提高。

圖片

圖片

此外,研究人員并不是第一個觀察到自我糾正不一定能提高LLM推理能力的人。總而言之,研究人員的重點不是解決諸如「是否存在可以提高特定基準測試性能的自我修正提示?」之類的問題。這樣的查詢可能沒有特別的意義。

相反,研究人員的目標是解決一個更基本的問題——「大型語言模型真的能夠僅根據其固有的能力自我糾正其推理嗎?」

作為事后提示的自我糾正

在之前的內容中,研究人員觀察到LLM在自我糾正其推理方面面臨挑戰。

然而,正如之前研究所證明的那樣,在某些情況下自我糾正已經產生了令人印象深刻的結果。

因此,辨別差異并查明根本原因至關重要。

要解決這個問題,重要的是要掌握自我糾正的基本性質。根據其形式,自我糾正可以被視為一種事后提示。

它與標準提示(這里稱之為事前提示)的區別在于,提示是在LLM的回答之上進行的。

研究人員將改進此類提示的過程稱為事后提示工程。

因此,當自我糾正可以提供事前提示無法提供的有價值的指導或反饋時,就會出現自我糾正增強模型響應的情況。

例如,當目標是使響應更安全時,指導模型僅使用事前提示在第一次嘗試中生成完全無風險的響應可能具有挑戰性。在這種情況下,自我糾正可以作為通過細粒度事后檢查來增強響應安全性的一種手段。

然而,對于推理任務來說,情況可能并非如此。

反饋提示,例如「查看您之前的答案并發現您的答案存在問題」。不一定能為推理提供切實的好處。

此外,即使觀察到自我糾正后性能顯著提高,仔細考慮提示設計也是必要的。

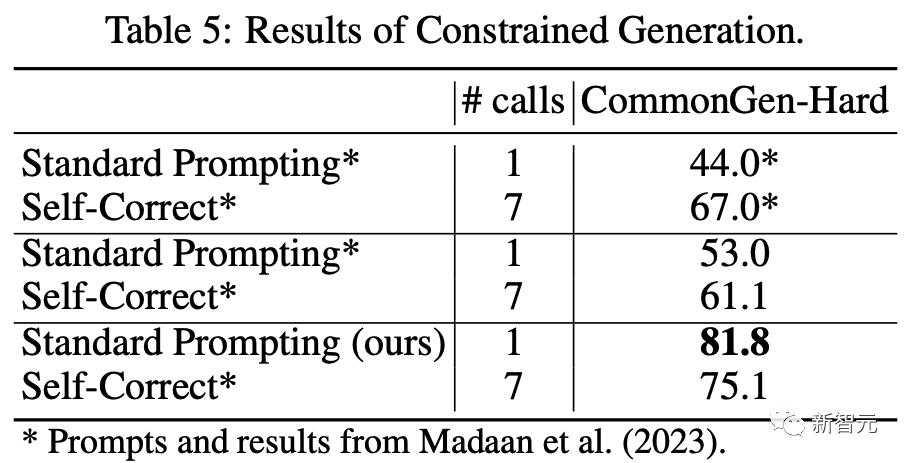

例如,如果響應需要滿足可以在初始指令中輕松指定的標準(例如,輸出應包含某些單詞、生成的代碼需要高效、情緒應強烈負面),而不是提供這些要求作為事后提示中的反饋,更具成本效益的替代策略是將這些要求直接(明確地)嵌入到事前提示中。

圖片

圖片

上表5中的結果表明,研究人員精心設計的提示「標準提示(研究人員的)」優于之前研究的自我校正后結果。

此外,當研究人員利用他們的提示來改進研究人員的輸出時,性能甚至會下降。

再次強調,研究人員在這里的目的并不是爭論是否存在事后提示可以勝過研究人員隨意編寫的提示。研究人員的主要目標是鼓勵對自我校正實驗進行更嚴格的檢查。

采用精心設計的事后提示來指導模型「自我糾正」通過糟糕的事前提示生成的響應是沒有意義的。

為了公平比較,應在事前和事后提示上投入同等的努力。

參考資料: