GPT-4V醫(yī)學執(zhí)照考試成績超過大部分醫(yī)學生,AI加入臨床還有多遠?

人工智能(AI)在醫(yī)學影像診斷方面的應用已經(jīng)有了長足的進步。然而,在未經(jīng)嚴格測試的情況下,醫(yī)生往往難以采信人工智能的診斷結果。對于他們來說,理解人工智能根據(jù)醫(yī)學影像給出的判別,需要增加額外的認知成本。

為了增強醫(yī)生對輔助醫(yī)療的人工智能之間的信任,讓 AI 通過一個醫(yī)生必須通過的資格考試或許是一個有效的方法。醫(yī)學執(zhí)照考試是用來評估醫(yī)生專業(yè)知識和技能的標準化考試,是衡量一個醫(yī)生是否有能力安全有效地護理患者的基礎。

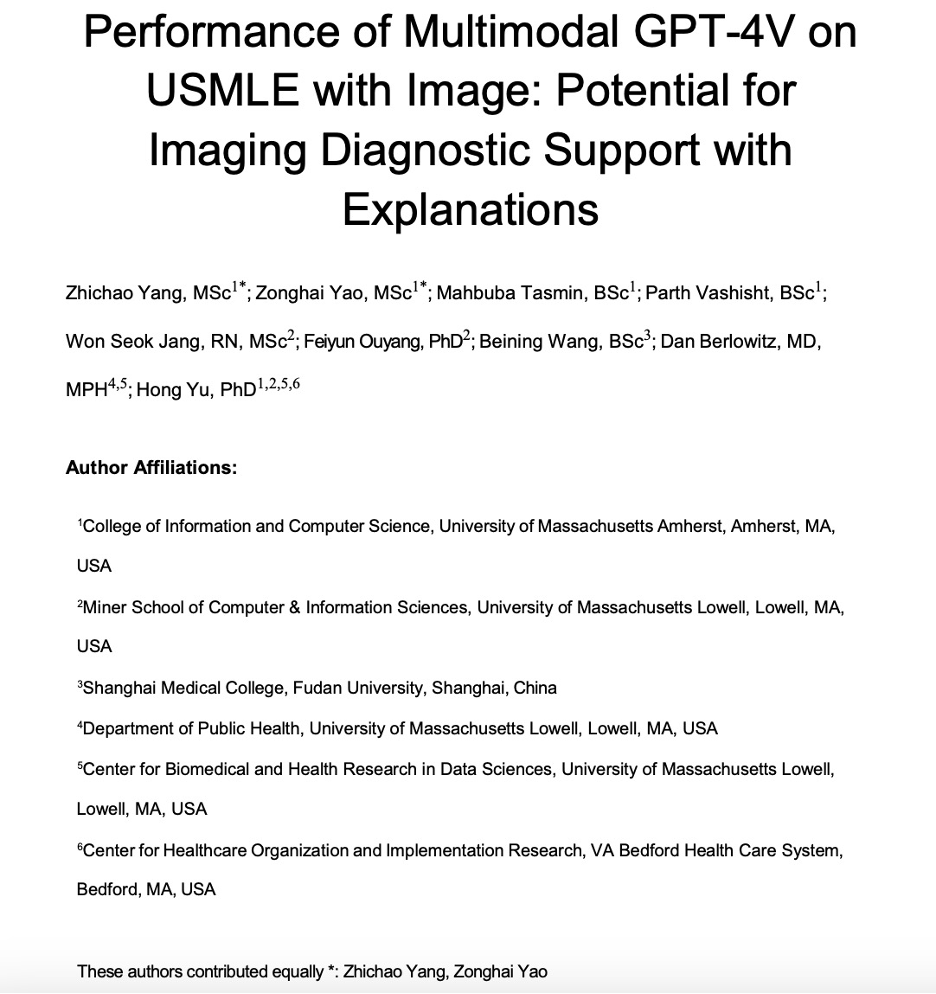

在最新的研究中,來自馬薩諸塞大學、復旦大學的跨學科研究人員團隊利用生成式多模態(tài)預訓練模型 GPT-4V (ision) 突破了人工智能在醫(yī)學問答中的最佳水平。研究測試了 GPT-4V 回答美國醫(yī)學執(zhí)照考試題的能力,特別是題目包含圖像的考題 —— 這對醫(yī)療人工智能系統(tǒng)來說一直以來都是一項挑戰(zhàn)。

該研究表明,GPT-4V 不僅超越了 GPT-4 和 ChatGPT 等前輩,還超越了大部分醫(yī)學生,為人工智能能夠作為輔助診斷和臨床決策的工具提供了理論上的可能。該研究分析了 GPT-4V 在不同醫(yī)學子領域的性能。

同時,該研究還指出了醫(yī)療人工智能在一致解釋方面的局限性,強調了人機協(xié)作在未來醫(yī)療診斷中的重要性。

論文鏈接:https://www.medrxiv.org/content/10.1101/2023.10.26.23297629v3

測試問題收集

該研究中,用來測試人工智能醫(yī)學執(zhí)照考試的題型為涉及不同醫(yī)學領域、難度各異的帶有圖像的選擇題。論文作者們選擇了來自美國醫(yī)學執(zhí)照考試(USMLE)、醫(yī)學生考試題庫(AMBOSS)和診斷放射學資格核心考試(DRQCE)的三套選擇題,共計 226 道題(28 個醫(yī)學領域),來測試 GPT-4V 的準確性。

其中 AMBOSS 和 DRQCE 的數(shù)據(jù)未公開,需要用戶注冊后才能獲取。AMBOSS 數(shù)據(jù)集中的每個問題都設定有對應的難度。問題按難易程度分五級,1、2、3、4 和 5 級分別代表學生第一次作答時最容易答對的 20%、20%-50%、50%-80%、80%-95% 和 95%-100% 的問題。

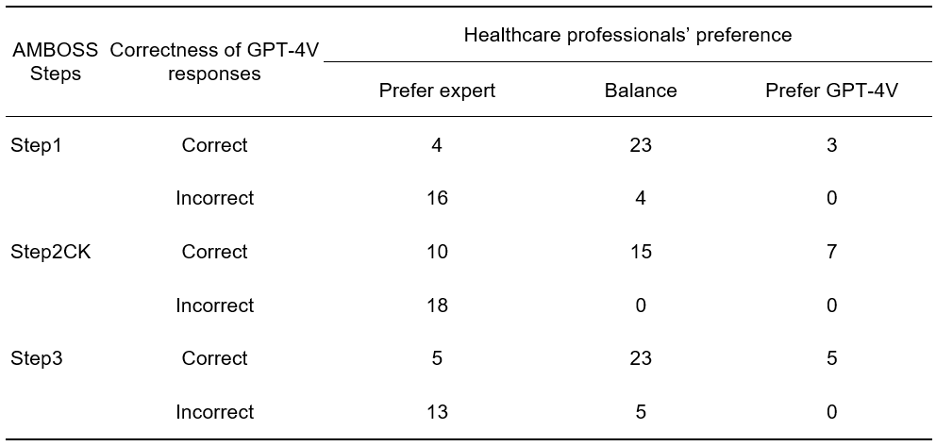

此外,作者們還收集了醫(yī)療專業(yè)人士的偏好,用以評估 GPT-4V 的解釋是否違背醫(yī)學常識。當 GPT-4V 做錯的時候,作者們還收集了來自醫(yī)療專業(yè)人士的反饋,用來改善 GPT-4V。

用美國醫(yī)學執(zhí)照考試(USMLE)中包含圖像的考題測試 GPT-4V。

用美國醫(yī)學執(zhí)照考試(USMLE)中包含圖像的考題測試 GPT-4V。

準確性

結果顯示,GPT-4V 在帶有圖像的醫(yī)學執(zhí)照考試題上表現(xiàn)出了很高的準確率,分別在 USMLE、AMBOSS 和 DRQCE 上達到了 86.2%、62.0% 和 73.1%,遠遠超過了 ChatGPT 和 GPT-4。與準備考試的學生相比,GPT-4V 的大致排名能達到前 20-30% 的水平。

而在 2022 年,美國醫(yī)學執(zhí)照考試大約有前 90% 的考生通過了考試,這意味著 GPT-4V 想要獲得通過,也相對較為輕松。GPT-4V 的準確率反映了它掌握大量生物醫(yī)學和臨床科學知識,也能夠解決醫(yī)患相處中遇到的問題。這些都是進入醫(yī)學臨床實踐的必備技能。

GPT-4V在美國醫(yī)學執(zhí)照考試(USMLE)的測試表現(xiàn)遠遠超過了 ChatGPT 和 GPT-4。

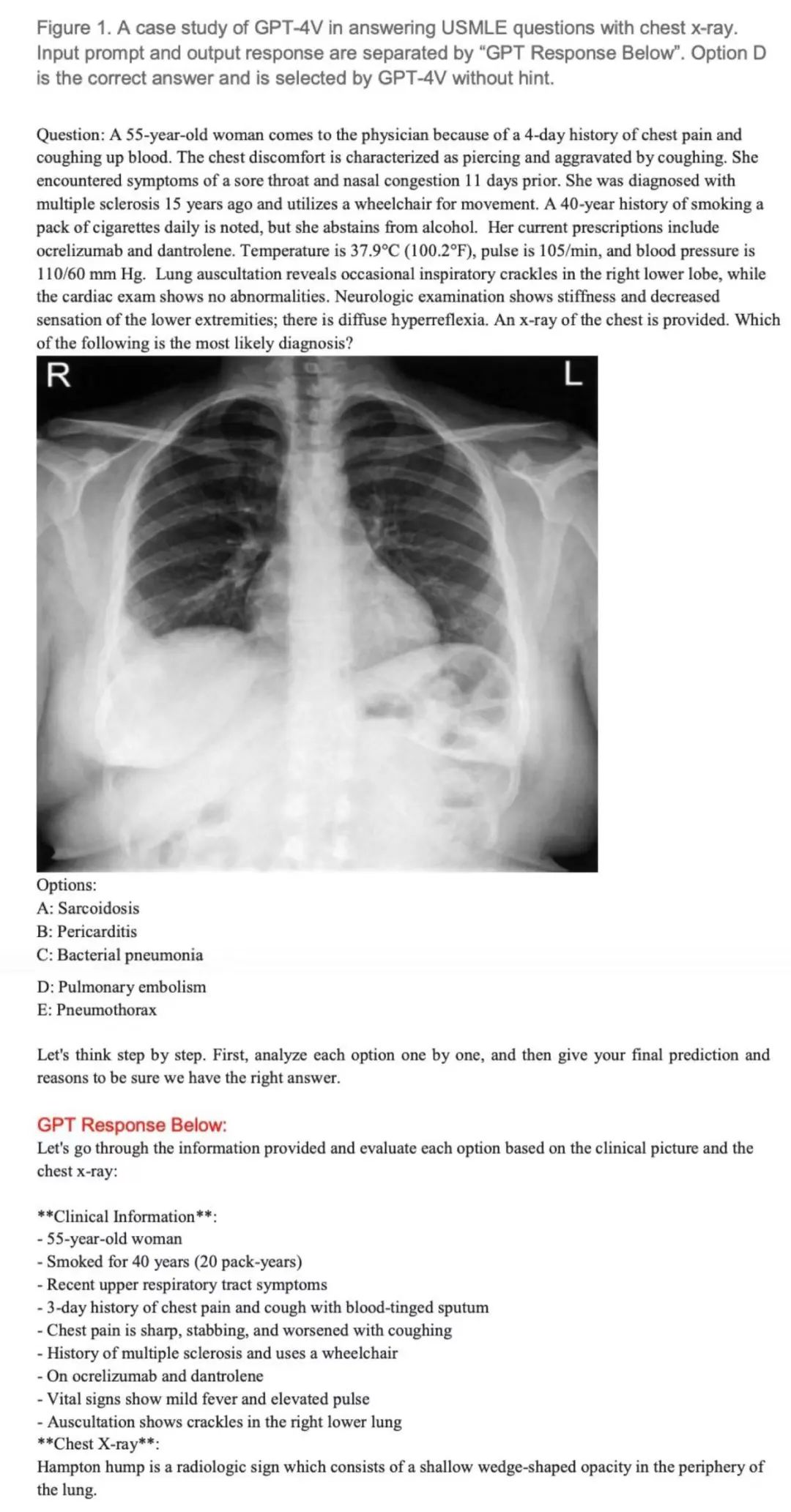

在使用提示和不使用提示的情況下,GPT-4V 在 AMBOSS 的準確率分別為 86% 和 63%。隨著問題難度的增加,不使用提示時 GPT-4V 的表現(xiàn)呈現(xiàn)下降趨勢(卡方檢驗,顯著性水平 0.05)。然而,當使用提示提問時,這種下降趨勢并未明顯觀察到。這表明,來自醫(yī)療專業(yè)人士的提示可以很好的幫助 GPT-4 做出正確的決策。

GPT-4V 和學生在不同難度 AMBOSS 考試上的準確率

解釋性

在解釋質量方面,作者們發(fā)現(xiàn),當 GPT-4V 回答正確時,醫(yī)療專業(yè)人士對 GPT-4V 給出的解釋與專家給出的解釋的偏好相差不大。這說明 GPT-4V 的解釋具有可信度和專業(yè)性。作者們還發(fā)現(xiàn),在 GPT-4V 的解釋中,有超過 80% 的回答包含了對題目中圖像和文本的解讀,這說明 GPT-4V 能夠利用多模態(tài)的數(shù)據(jù)來生成回答。

然而,當 GPT-4V 回答錯誤時,它的解釋中也存在一些嚴重的問題,例如圖像誤解(Image misunderstanding)、文本幻覺(Text hallucination)、推理錯誤(Reasoning error)等,這些問題可能會影響 GPT-4V 的可靠性和可解釋性。

針對每道考試題,醫(yī)療專業(yè)人員從專家生成的解釋和 GPT-4V 生成的解釋中選擇偏好。考試分為 Step1, Step2CK, Step3 共 3 個階段。每個階段抽取 50 道題目進行測試。

作者發(fā)現(xiàn)許多 GPT-4V 回答錯誤的解釋是圖像誤解。在 55 個錯誤回答中,有 42 個回答(76.3%)是由圖像理解錯誤所導致的。相比之下,只有 10 個回答(18.2%)錯誤歸因于文本幻覺。

針對圖像誤解,作者建議使用以圖像或者文字為形式的提示。例如,醫(yī)生可以用箭頭指示圖中重要的位置,或者用一兩句話來解釋圖像的意義來提示模型。當醫(yī)生使用文字提示的時候,就有 40.5% (17/42 個) 之前錯誤的回答被 GPT-4V 改正了。

輔助診斷的潛力

作者還展示了使用 GPT-4V 作為影像診斷輔助工具的可能性。基于一個高血壓病人的病例報告,醫(yī)生對 GPT-4V 進行提問。定性分析表明,GPT-4V 能夠根據(jù) CT 掃描圖像、化驗單和病人癥狀等其他信息,提供鑒別診斷和后續(xù)檢查的建議。詳細分析請參考原論文。

結論與展望

作者們認為,GPT-4V 在帶有圖像的醫(yī)學執(zhí)照考試題上展現(xiàn)了非凡的準確率,在臨床決策支持方面,GPT-4V 具備無窮的潛力。然而,GPT-4V 還需要改進它的解釋質量和可靠性,才能真正適用于臨床場景。

論文中嘗試使用提示來改進 GPT-4V 的判斷,取得了不錯的效果,這為未來的研究提出了一個有希望的方向:開發(fā)更精細的人類人工智能協(xié)作系統(tǒng),使得其成為臨床環(huán)境中更可靠的工具。隨著技術的不斷進步和研究不斷深入,我們有理由相信,AI 將在提高醫(yī)療質量、減輕醫(yī)生工作負擔和促進醫(yī)療服務普及化方面繼續(xù)發(fā)揮重要作用。