2024年AI趨勢看這張圖,LeCun:開源大模型要超越閉源

2023 年即將過去。一年以來,各式各樣的大模型爭相發布。當 OpenAI 和谷歌等科技巨頭正在角逐時,另一方「勢力」悄然崛起 —— 開源。

開源模型受到的質疑一向不少。它們是否能像專有模型一樣優秀?是否能夠媲美專有模型的性能?迄今為止,我們一直還只能說是某些方面接近。即便如此,開源模型總會給我們帶來經驗的表現,讓我們刮目相看。

開源模型的興起正在改變游戲規則。如 Meta 的 LLaMA 系列以其快速迭代、可定制性和隱私性正受到追捧。這些模型被社區迅速發展,給專有模型帶來了強有力的挑戰,能夠改變大型科技公司的競爭格局。

不過此前人們的想法大多只是來自于「感覺」。今天早上,Meta 首席 AI 科學家、圖靈獎獲得者 Yann LeCun 突然發出了這樣的感嘆:「開源人工智能模型正走在超越專有模型的路上。」

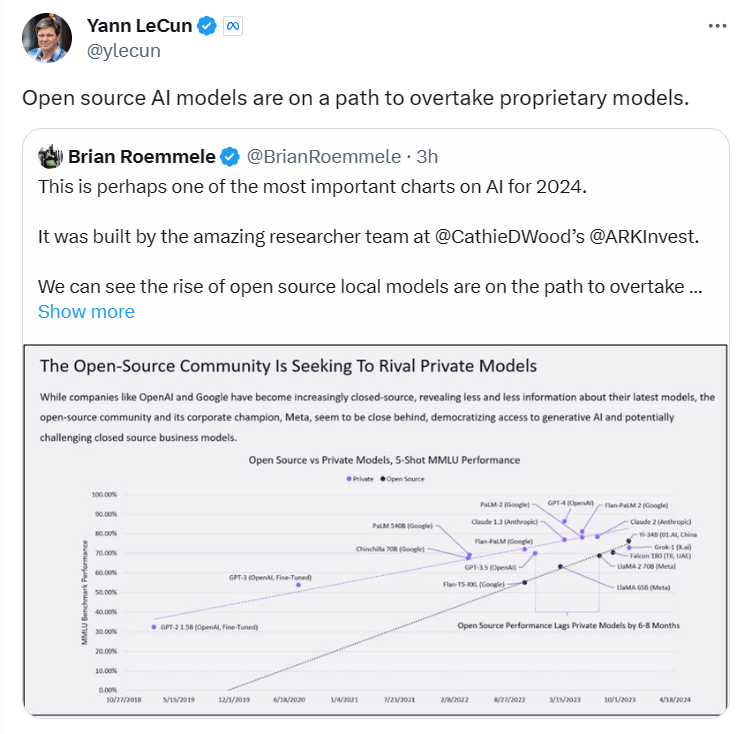

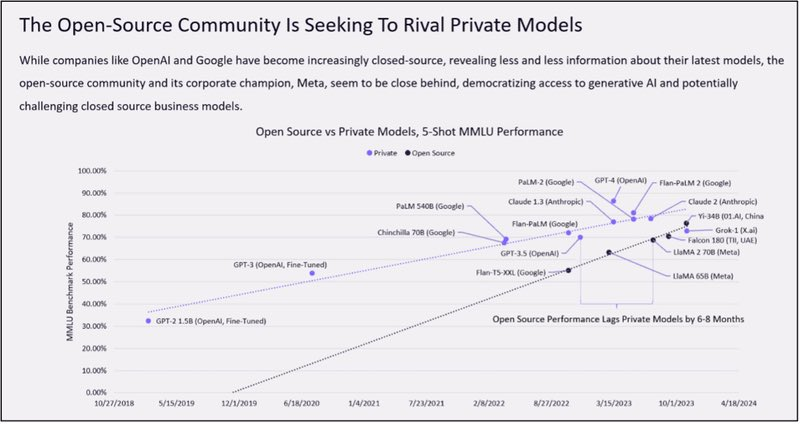

這張由方舟投資(ARK Invest)團隊制作的趨勢圖,被認為很有可能是對 2024 年 AI 發展做出了預測。它描繪了開源社區與專有模型在生成式 AI 上的發展。

隨著像 OpenAI 和 Google 這樣的公司變得越來越封閉,越來越少地公開他們的最新模型信息,開源社區及其企業支持者 Meta 似乎正緊隨其后,使得生成式 AI 的訪問更為民主化,這可能對專有模型的商業模式構成挑戰。

在這個散點圖中顯示了各種 AI 模型的性能百分比。專有模型用藍色表示,開源模型用黑色表示。我們可以看到不同的 AI 模型如 GPT-3、Chinchilla 70B(谷歌)、PaLM(谷歌)、GPT-4(OpenAI)和 Llama65B(Meta)等在不同時間點的性能。

Meta 最初發布 LLaMA 時,參數量從 70 億到 650 億不等。這些模型的性能非常優異:具有 130 億參數的 Llama 模型「在大多數基準上」可以勝過 GPT-3( 參數量達 1750 億),而且可以在單塊 V100 GPU 上運行;而最大的 650 億參數的 Llama 模型可以媲美谷歌的 Chinchilla-70B 和 PaLM-540B。

Falcon-40B 剛發布就沖上了 Huggingface 的 OpenLLM 排行榜首位,改變了 Llama 一枝獨秀的場面。

Llama 2 開源,再一次使大模型格局發生巨變。相比于 Llama 1,Llama 2 的訓練數據多了 40%,上下文長度也翻倍,并采用了分組查詢注意力機制。

最近,開源大模型宇宙又有了新的重量級成員 ——Yi 模型。它能一次處理 40 萬漢字、中英均霸榜。Yi-34B 也成為迄今為止唯一成功登頂 Hugging Face 開源模型排行榜的國產模型。

如散點圖所示,開源模型的性能在不斷追趕專有模型。這可能意味著在不久的將來,開源模型有望在性能上與專有模型平起平坐,甚至超越。

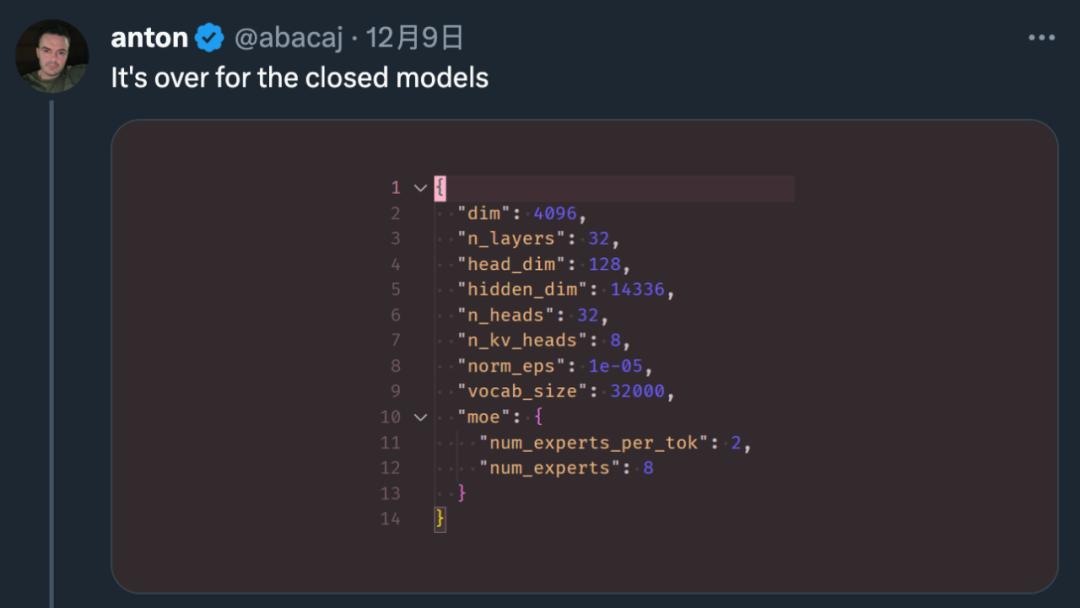

就在上周末,Mistral 8x7B 用最樸素的發布方式以及強大的性能,讓研究者評價道:「閉源大模型走到結局了。」

有網友已經開始預祝 「2024 年成為開源 Al 年」,「我們正在接近一個臨界點。以目前開源社區項目的發展速度,我們將在未來 12 個月內達到 GPT-4 的水平。」

接下來開源模型的未來是否坦途一片,又會有怎樣的表現,我們拭目以待。