無需文本標注,TF-T2V把AI量產視頻的成本打下來了!華科阿里等聯合打造

在過去短短兩年內,隨著諸如 LAION-5B 等大規模圖文數據集的開放,Stable Diffusion、DALL-E 2、ControlNet、Composer ,效果驚人的圖片生成方法層出不窮。圖片生成領域可謂狂飆突進。

然而,與圖片生成相比,視頻生成仍存在巨大挑戰。首先,視頻生成需要處理更高維度的數據,考慮額外時間維度帶來的時序建模問題,因此需要更多的視頻 - 文本對數據來驅動時序動態的學習。然而,對視頻進行準確的時序標注非常昂貴。這限制了視頻 - 文本數據集的規模,如現有 WebVid10M 視頻數據集包含 10.7M 視頻 - 文本對,與 LAION-5B 圖片數據集在數據規模上相差甚遠,嚴重制約了視頻生成模型規模化的擴展。

為解決上述問題,華中科技大學、阿里巴巴集團、浙江大學和螞蟻集團聯合研究團隊于近期發布了 TF-T2V 視頻方案:

論文地址:https://arxiv.org/abs/2312.15770

項目主頁:https://tf-t2v.github.io/

即將開源代碼地址:https://github.com/ali-vilab/i2vgen-xl (VGen 項目)

該方案另辟蹊徑,提出了基于大規模無文本標注視頻數據進行視頻生成,能夠學習豐富的運動動態。

先來看看 TF-T2V 的視頻生成效果:

文生視頻任務

提示詞:生成在冰雪覆蓋的土地上有一只冰霜般的大生物的視頻。

提示詞:生成一只卡通蜜蜂的動畫視頻。

提示詞:生成包含一輛未來幻想摩托車的視頻。

提示詞:生成一個小男孩快樂微笑的視頻。

提示詞:生成一個老人感覺頭疼的視頻。

組合式視頻生成任務

給定文本與深度圖或者文本與素描草圖,TF-T2V 能夠進行可控的視頻生成:

也可以進行高分辨率視頻合成:

半監督設定

在半監督設定下的 TF-T2V 方法還可以生成符合運動文本描述的視頻,如 「人從右往左跑」。

方法簡介

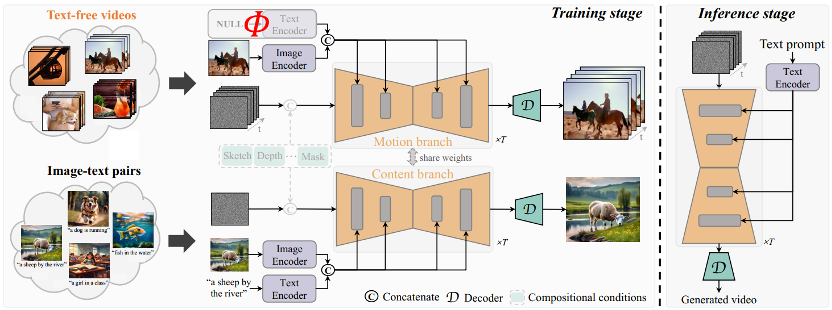

TF-T2V 的核心思想是將模型分為運動分支和表觀分支,運動分支用于建模運動動態,表觀分支用于學習視覺表觀信息。這兩個分支進行聯合訓練,最終可以實現通過文本驅動視頻生成。

為了提升生成視頻的時序一致性,作者團隊還提出了一種時序一致性損失,顯式地學習視頻幀之間的連續性。

值得一提的是,TF-T2V 是一種通用的框架,不僅適用于文生視頻任務,還能應用于組合式視頻生成任務,如 sketch-to-video、video inpainting、first frame-to-video 等。

具體細節和更多實驗結果可以參考原論文或者項目主頁。

此外,作者團隊還把 TF-T2V 作為教師模型,利用一致性蒸餾技術得到了 VideoLCM 模型:

論文地址:https://arxiv.org/abs/2312.09109

項目主頁:https://tf-t2v.github.io/

即將開源代碼地址:https://github.com/ali-vilab/i2vgen-xl (VGen 項目)

不同于之前視頻生成方法需要大約 50 步 DDIM 去噪步驟,基于 TF-T2V 的 VideoLCM 方法可以只需要進行大約 4 步推理去噪就生成高保真的視頻,極大地提升了視頻生成的效率。

一起來看看 VideoLCM 進行 4 步去噪推理的結果:

具體細節和更多實驗結果可以參考 VideoLCM 原論文或者項目主頁。

總而言之,TF-T2V 方案為視頻生成領域帶來了新思路,克服了數據集規模和標注難題帶來的挑戰。利用大規模的無文本標注視頻數據,TF-T2V 能夠生成高質量的視頻,并應用于多種視頻生成任務。這一創新將推動視頻生成技術的發展,為各行各業帶來更廣闊的應用場景和商業機會。