無需人力標注!悉尼大學華人團隊提出「GPT自監督標注」范式,完美解決標注成本、偏見、評估問題

一直以來,數據標注都在深度學習流程中扮演了基礎且重要的角色。

優質的數據標注直接影響到模型的學習效果,而這無疑是實現高效深度學習的最原始且關鍵的一步。

與此同時,標注的數據作為groundtruth,也直接影響了后續的訓練,驗證,測試。

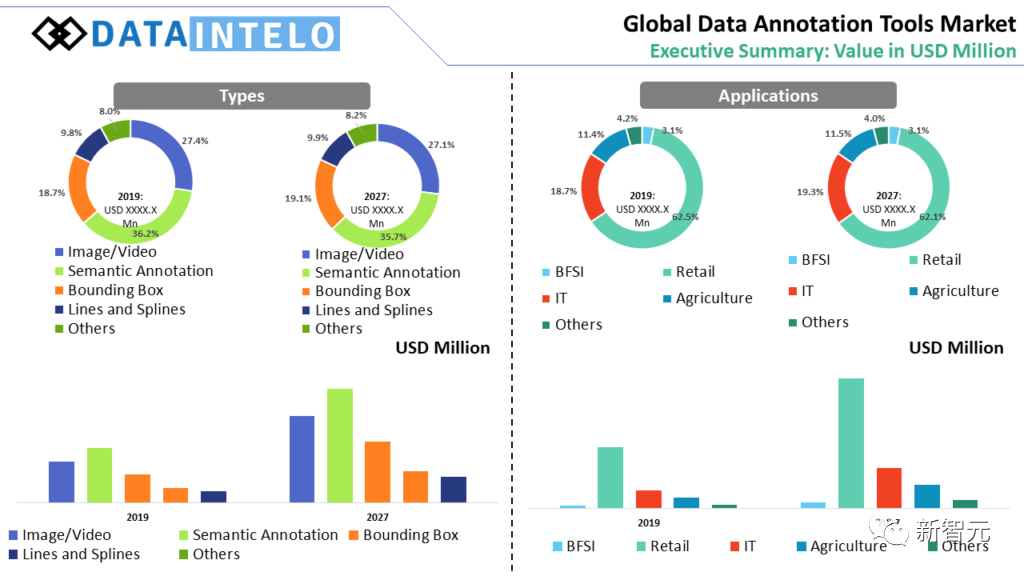

然而,業界和學界不得不面臨數據標注任務成本較高、存在偏見、難以評估,以及標注難度等問題。

最近,來自悉尼大學的研究團隊提出了一種通過大語言模型自監督生成標注的框架。首次利用基于生成-還原循環標注的GPT自監督方法,解決了上述問題。

論文鏈接:https://arxiv.org/pdf/2306.04349.pdf

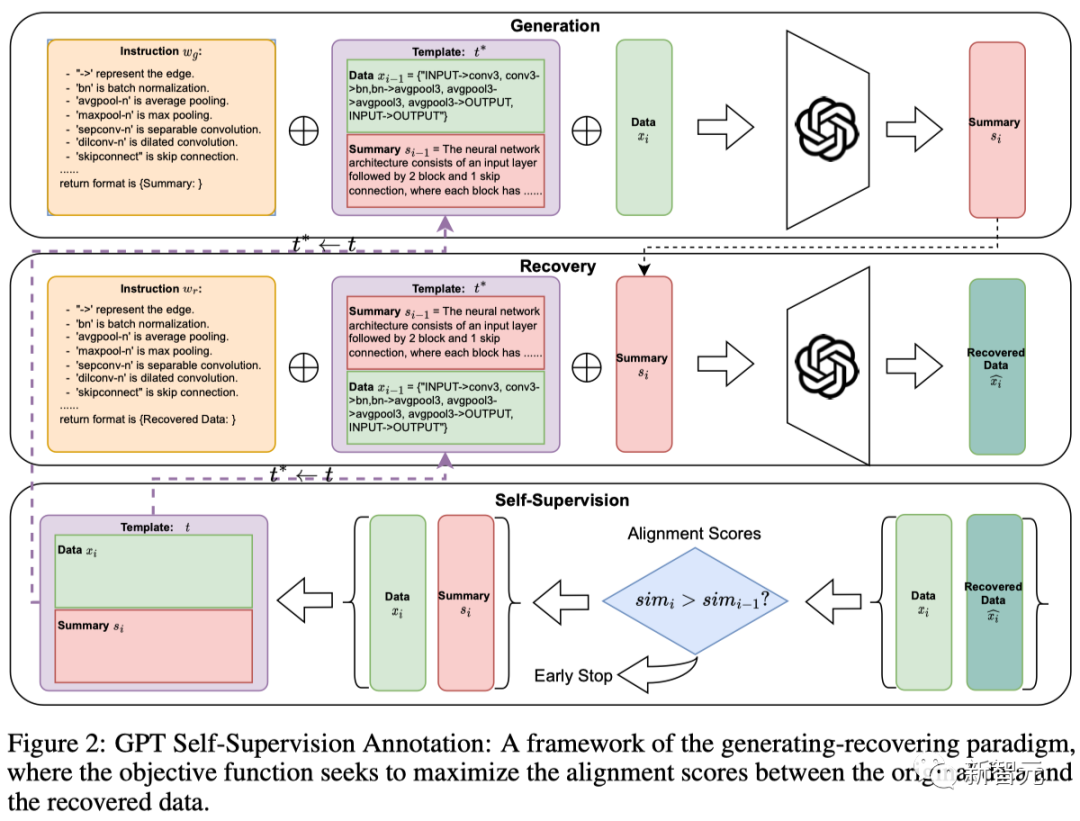

其核心思想是,利用大語言模型作為一個黑盒優化優器,構造了一個循環:

模版質量越高,生成的數據-標注對質量越高;生成的數據標注對質量越高,用當前質量更高的數據對替換上一輪的模版。以此往復迭代,滾雪球式循環提升標注質量。

數據標注困難重重

1. 成本較高:

無論是在哪個國家或公司,數據標注都是一項成本高昂的工作,需要大量的人力和時間投入。

在美國,數據標注員的平均年薪約為39,000美元,最高可達49,803美元[2]。即使在印度,數據標注員的平均年薪約為2.0 Lakhs盧比,約合2,670美元[3]。

其次,數據標注的成本也影響了其評估的困難。

例如,由于成本的差異,許多公司選擇將數據標注任務外 包到人力成本較低的國家[4]。

然而,這種跨文化的標注可能導致一些細微的語義差異被忽視,從而影響了模型的學習效果。

2. 存在偏見:

數據標注在機器學習和人工智能的應用中扮演著重要的角色。

然而,研究顯示[5],人類在標注過程中可能會引入偏見,這些偏見可能會影響機器學習模型的訓練和性能。

研究發現,標注員可能會按照數據集創建者編寫的指令中的模式進行標注,這種現象被稱為「指令偏見」。

這些指令可能會導致某些標注在數據中過度表示,從而使得AI系統對這些標注產生偏見。

3. 難以評估:

研究表明[6]大語言模型本身可以直接通過設計prompt標注數據。

然而,評估這些模型對數據標注的質量和效果十分困難, 因為如何評判生成的數據質量是一個主觀的問題。

比如,在生物醫學領域,深度學習模型已經顯示出在從DNA序列中預測調控效應的巨大潛力。

但人類本身并未完全理解模型輸出的內容,因此用模型標注的質量難以被人類評判。

4. 標注難度:

即使對專業從業者,一些結構化數據標注難度仍然太大。

比如,在神經網絡計算圖數據中,結點表述操作符,有向邊表示。

一個表示網絡結構的graph列表多達上千個結點對,人工數結點和嵌套的block序列將耗費大量時間和精力。

全新標注方法

團隊提出的標注方法包含了one-shot階段和生成階段。

其中,one-shot階段的目標是迭代尋找最優的{數據-標注}數據對作為模板。

迭代過程:

初始化一個簡單數據對作為初始模版,利用GPT生成標注,生成的標注和原始數據形成一個新的數據對。

然后,通過比較從標注中還原出來的數據和原始數據,評估這個新數據對作為模板的潛力。

如果還原數據與原數據的相似度得分有所提高,就用當前的新數據對直接作為新的模板進行一輪數據生成。

因此,這種自我對齊機制會迭代調整one-shot模板,為下一輪生成做好準備。one-shot階段搜索到的最優模板隨后用于對數據集進行標注。

作者通過調整不同的預訓練獎勵模型來評估標注的質量,并引入不同的評價指標來間接評估摘要的還原能力。

作者在三個具有挑戰性的數據集上進行了大量實驗,并從各種角度進行了詳細的消融研究。

結果表明,這種自我監督范式在獎勵模型和還原數據能力的得分的評估中始終表現出很高的性能。

另外,作者應用該框架生成了兩個新的數據集,對基于不同計算操作符的神經網絡架構進行的描述。

作者通過調用OpenAI的API在各種類型的GPT模型上進行了基準測試。

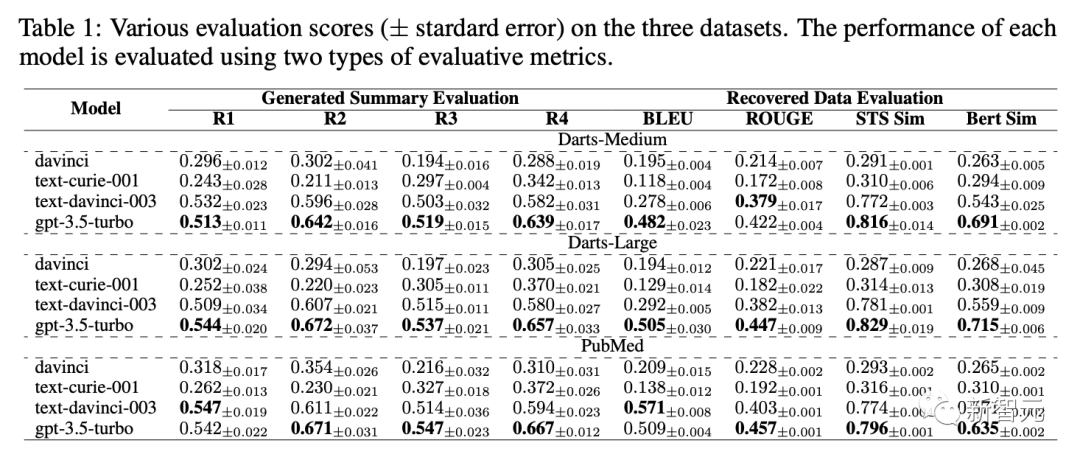

表1展示了davinci,text-curie-001,text-davinci-003,gpt-3.5-turbo在不同評估標準下標注數據質量的得分。

作者在論文中還探討如下消融實驗:

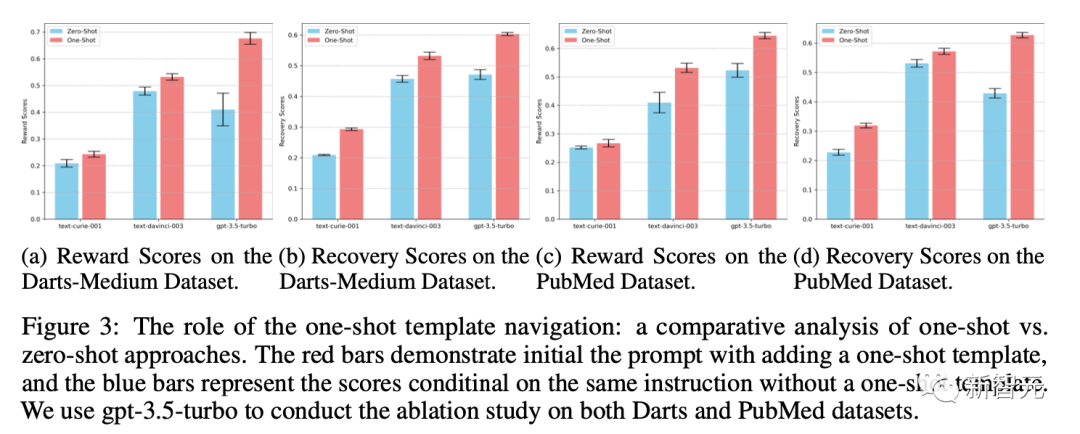

Q1. 迭代后的one-shot模板在整個過程中扮演什么角色?我們是否能通過zero-shot方法(僅通過設計的指令instruction-tuning生成摘要), 來達到同樣的效果?

A1. 與以相同指令為條件的零樣本生成相比,引入樣本模板提高了標注質量, 實驗細節如圖所示。

此外,作者還在文中還探討了如下問題:

對還原數據和原數據之間的相似度測量評估標準方法會對標注有什么影響?模板的初始化如何影響自監督標注迭代的結果?GPT模型本身的超參數是否會影響搜索出來的標注模版?