把圖像視為外語(yǔ),快手、北大多模態(tài)大模型媲美DALLE-3

當(dāng)前的大型語(yǔ)言模型如 GPT、LLaMA 等在自然語(yǔ)言處理領(lǐng)域取得了顯著進(jìn)展,能夠理解和生成復(fù)雜的文本內(nèi)容。但你是否想過,如果能夠?qū)⒋笳Z(yǔ)言模型這強(qiáng)大的理解和生成能力遷移到多模態(tài)數(shù)據(jù)上,就可以輕松理解海量的圖像與視頻,并輔助創(chuàng)作圖文并茂的內(nèi)容。近期,來自快手和北大合作的最新多模態(tài)大模型 LaVIT, 正在讓這個(gè)想法逐步變?yōu)楝F(xiàn)實(shí)。

- 論文標(biāo)題:Unified Language-Vision Pretraining in LLM with Dynamic Discrete Visual Tokenization

- 論文地址:https://arxiv.org/abs/2309.04669

- 代碼模型地址:https://github.com/jy0205/LaVIT

模型總覽

LaVIT 作為一個(gè)新型的通用多模態(tài)基礎(chǔ)模型,可以像語(yǔ)言模型那樣,既能夠理解也能生成視覺內(nèi)容。LaVIT 繼承了大語(yǔ)言模型成功的訓(xùn)練范式,即以自回歸的方式預(yù)測(cè)下一個(gè)圖像或文本 token。在訓(xùn)練完成后,其可以充當(dāng)一個(gè)多模態(tài)通用接口,無(wú)需進(jìn)一步的微調(diào),就可以執(zhí)行多模態(tài)理解和生成任務(wù)。例如,LaVIT 具有以下的能力:

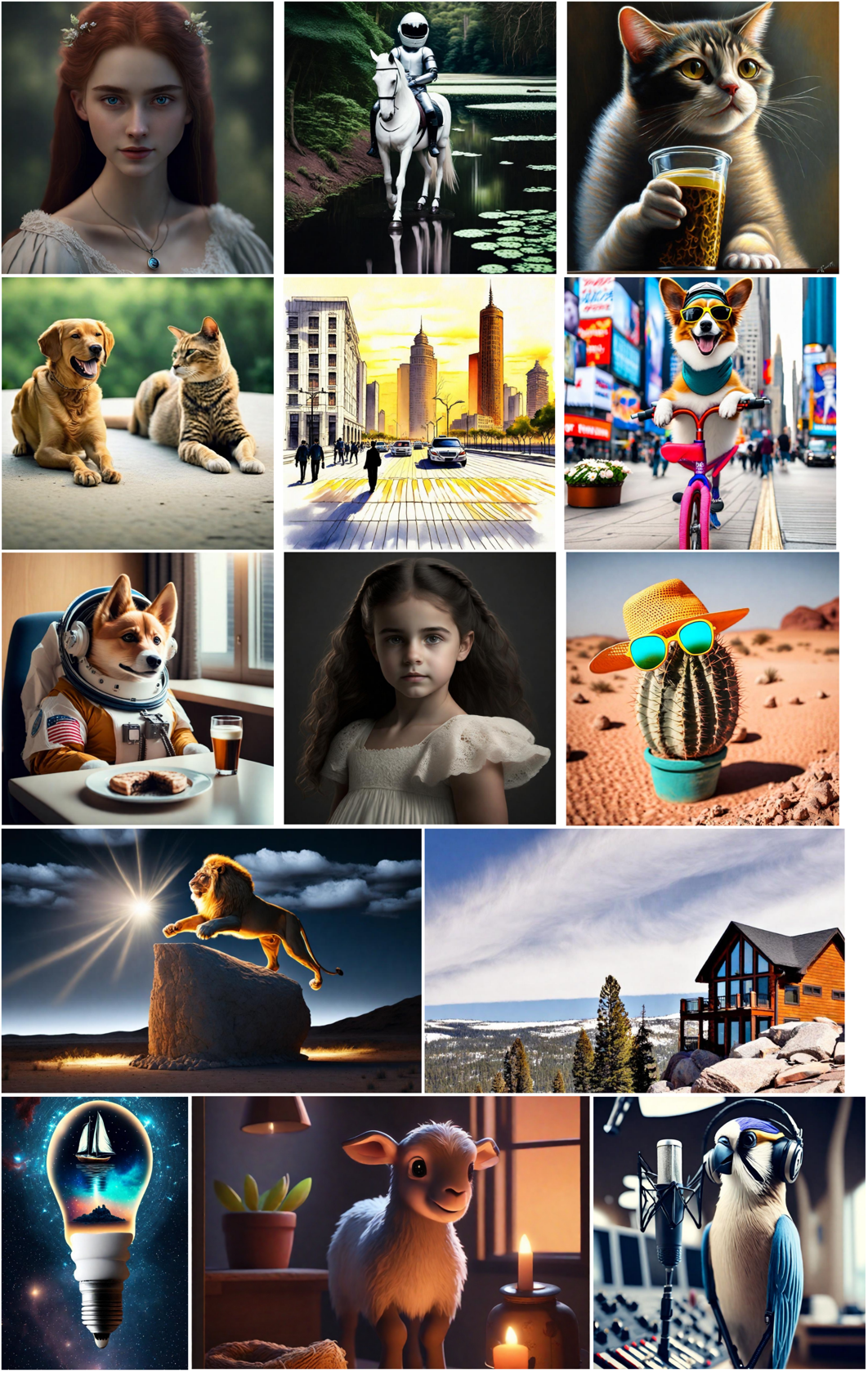

實(shí)現(xiàn)高質(zhì)量文本到圖像的生成:LaVIT 能夠根據(jù)給定的文本提示生成高質(zhì)量、多種縱橫比和高美感的圖像。其圖像生成能力與最先進(jìn)的圖像生成模型(如 Parti、SDXL 和 DALLE-3)相媲美。

根據(jù)多模態(tài)提示進(jìn)行圖像生成:由于在 LaVIT 中,圖像和文本都被統(tǒng)一表示為離散化的 token,因此其可以接受多種模態(tài)組合(例如文本、圖像 + 文本、圖像 + 圖像)作為提示,生成相應(yīng)的圖像,而無(wú)需進(jìn)行任何微調(diào)。

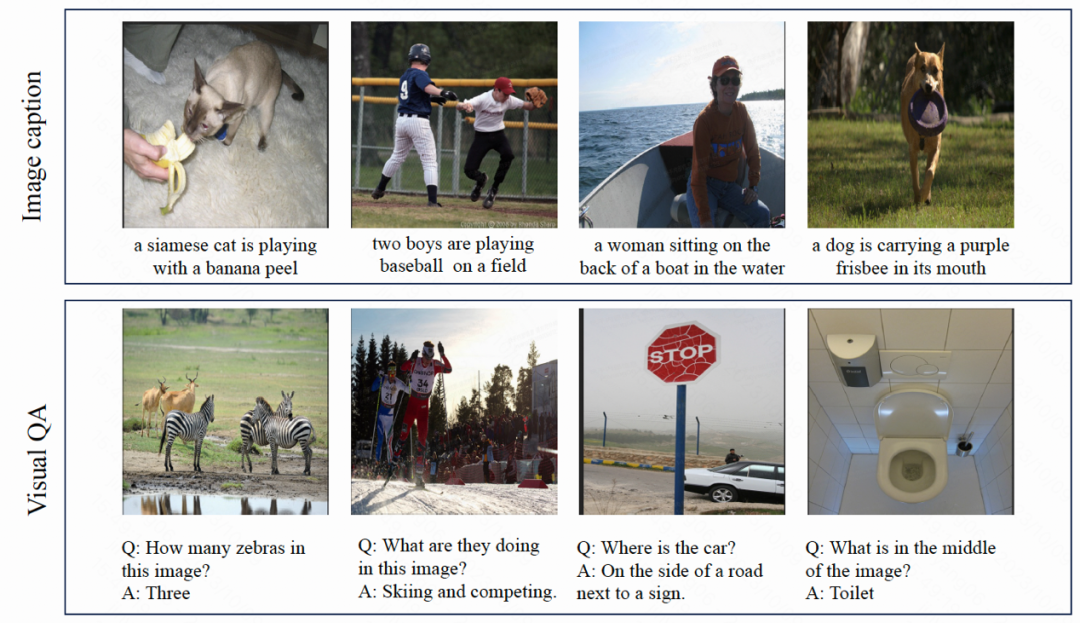

理解圖像內(nèi)容并回答問題:在給定輸入圖像的情況下,LaVIT 能夠閱讀圖像內(nèi)容并理解其語(yǔ)義。例如,模型可以為輸入的圖像提供 caption 并回答相應(yīng)的問題。

方法概覽

LaVIT 的模型結(jié)構(gòu)如下圖所示,其整個(gè)優(yōu)化過程包括兩個(gè)階段:

圖:LaVIT 模型的整體架構(gòu)

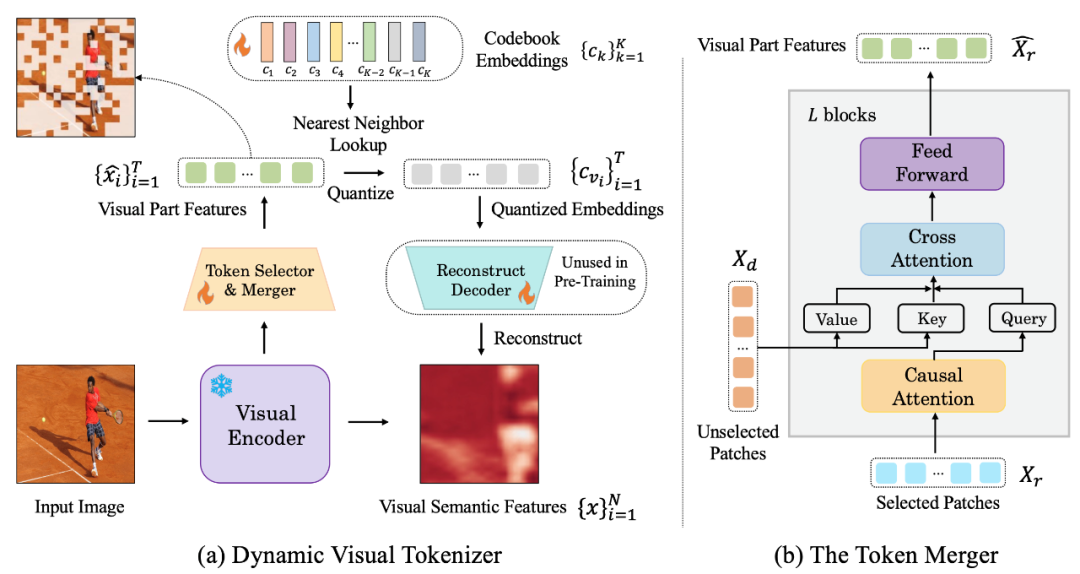

階段 1: 動(dòng)態(tài)視覺分詞器

為了能夠像自然語(yǔ)言一樣理解和生成視覺內(nèi)容,LaVIT 引入了一個(gè)設(shè)計(jì)良好的視覺分詞器,用于將視覺內(nèi)容(連續(xù)信號(hào))轉(zhuǎn)換為像文本一樣的 token 序列,就像 LLM 能夠理解的外語(yǔ)一樣。作者認(rèn)為,為了實(shí)現(xiàn)統(tǒng)一視覺和語(yǔ)言的建模,該視覺分詞器 (Tokenizer) 應(yīng)該具有以下兩個(gè)特性:

- 離散化:視覺 token 應(yīng)該被表示為像文本一樣的離散化形式。這樣對(duì)于兩種模態(tài)采用統(tǒng)一的表示形式,有利于 LaVIT 在一個(gè)統(tǒng)一的自回歸生成式訓(xùn)練框架下,使用相同的分類損失進(jìn)行多模態(tài)建模優(yōu)化。

- 動(dòng)態(tài)化:與文本 token 不同的是,圖像 patch 之間有著顯著的相互依賴性,這使得從其他圖像 patch 中推斷另一個(gè) patch 相對(duì)簡(jiǎn)單。因此,這種依賴性會(huì)降低原本 LLM 的 next-token prediction 優(yōu)化目標(biāo)的有效性。LaVIT 提出通過使用 token merging 來降低視覺 patch 之間的冗余性,其根據(jù)不同圖像語(yǔ)義復(fù)雜度的不同,編碼出動(dòng)態(tài)的視覺 token 數(shù)量。這樣對(duì)于復(fù)雜程度不同的圖像,采用動(dòng)態(tài)的 token 編碼也進(jìn)一步提高了預(yù)訓(xùn)練的效率,避免了冗余的 token 計(jì)算。

下圖是 LaVIT 所提出的視覺分詞器結(jié)構(gòu):

圖:(a) 動(dòng)態(tài)視覺 token 生成器 (b) token 合并器

該動(dòng)態(tài)視覺分詞器包括 token 選擇器和 token 合并器。如圖所示, token 選擇器用來選擇最具信息的圖像區(qū)塊,而 token 合并器則將那些 uninformative 的視覺塊的信息壓縮到保留下的 token 上,實(shí)現(xiàn)對(duì)冗余 token 的 merging。整個(gè)動(dòng)態(tài)視覺分詞器則通過最大限度地重構(gòu)輸入圖像的語(yǔ)義進(jìn)行訓(xùn)練。

Token 選擇器

Token 選擇器接收 N 個(gè)圖像區(qū)塊級(jí)的特征作為輸入,其目標(biāo)是評(píng)估每個(gè)圖像區(qū)塊的重要性并選擇信息量最高的區(qū)塊,以充分代表整個(gè)圖像的語(yǔ)義。為實(shí)現(xiàn)這一目標(biāo),采用輕量級(jí)模塊,由多個(gè) MLP 層組成,用于預(yù)測(cè)分布 π。通過從分布 π 中采樣,生成一個(gè)二進(jìn)制決策 mask,用于指示是否保留相應(yīng)的圖像區(qū)塊。

Token 合并器

Token 合并器據(jù)生成的決策掩碼,將 N 個(gè)圖像區(qū)塊劃分為保留 X_r 和舍棄 X_d 兩組。與直接丟棄 X_d 不同,token 合并器可以最大限度地保留輸入圖像的詳細(xì)語(yǔ)義。token 合并器由 L 個(gè)堆疊的塊組成,每個(gè)塊包括因果自注意力層、交叉注意力層和前饋層。因果自注意力層中, X_r 中的每個(gè) token 只關(guān)注其前面的 token,以確保與 LLM 中的文本 token 形式一致。與雙向自注意相比,這種策略表現(xiàn)更好。交叉注意力層將保留的 token X_r 作為 query,并根據(jù)它們?cè)谡Z(yǔ)義上的相似性合并 X_d 中的 token。

階段 2: 統(tǒng)一的生成式預(yù)訓(xùn)練

經(jīng)過視覺分詞器處理后的視覺 token 與文本 token 相連接形成多模態(tài)序列作為訓(xùn)練時(shí)的輸入。為了區(qū)分兩種模態(tài),作者在圖像 token 序列的開頭和結(jié)尾插入了特殊 token :[IMG] 和 [/IMG],用于表示視覺內(nèi)容的開始和結(jié)束。為了能夠生成文本和圖像,LaVIT 采用兩種圖文連接形式:[image, text] 和 [text; image]。

對(duì)于這些多模態(tài)輸入序列,LaVIT 采用統(tǒng)一的、自回歸方式來直接最大化每個(gè)多模態(tài)序列的似然性進(jìn)行預(yù)訓(xùn)練。這樣在表示空間和訓(xùn)練方式上的完全統(tǒng)一,有助于 LLM 更好地學(xué)習(xí)多模態(tài)交互和對(duì)齊。在預(yù)訓(xùn)練完成后,LaVIT 具有感知圖像的能力,可以像處理文本一樣理解和生成圖像。

實(shí)驗(yàn)

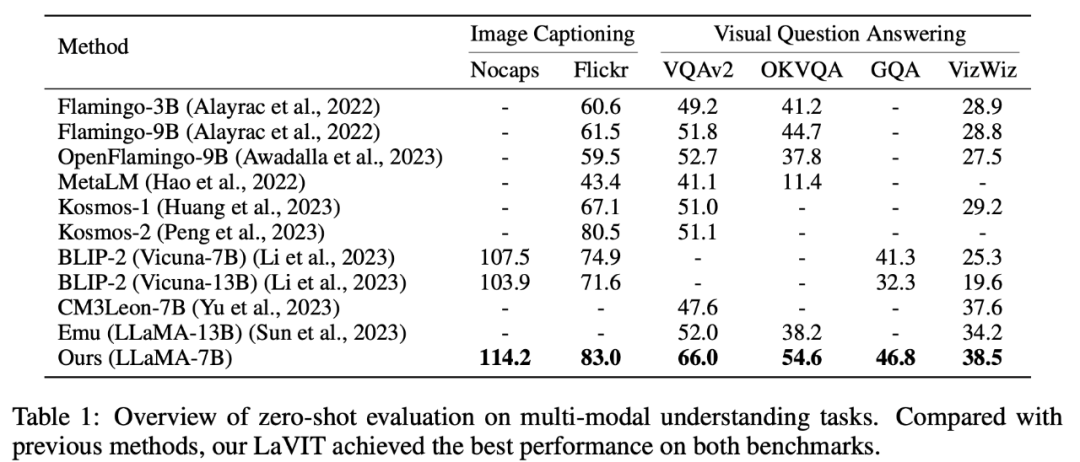

零樣本多模態(tài)理解

LaVIT 在圖像字幕生成(NoCaps、Flickr30k)和視覺問答(VQAv2、OKVQA、GQA、VizWiz)等零樣本多模態(tài)理解任務(wù)上取得了領(lǐng)先的性能。

表 1 零樣本的多模態(tài)理解任務(wù)評(píng)估

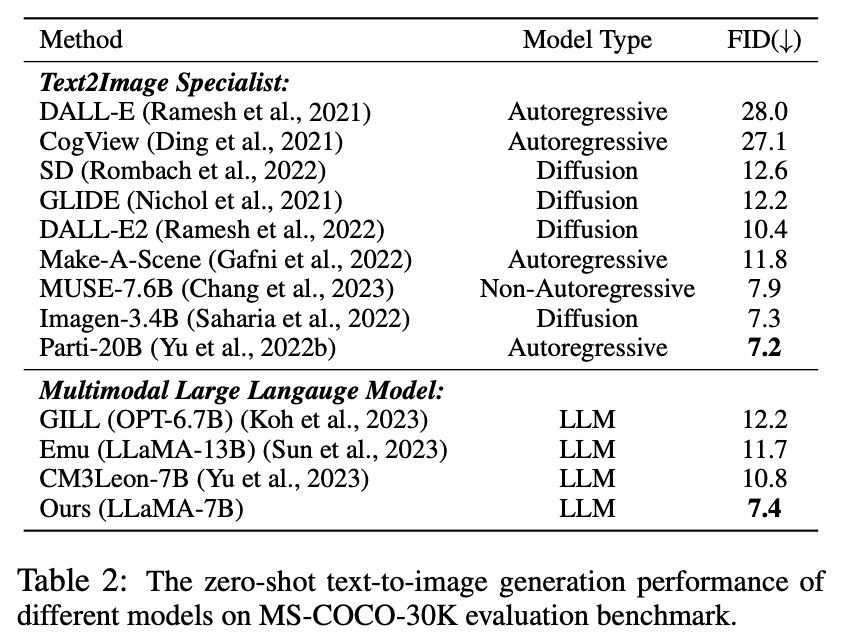

零樣本多模態(tài)生成

在這個(gè)實(shí)驗(yàn)中,由于所提出的視覺 tokenizer 能夠?qū)D像表示為離散化 token,LaVIT 具有通過自回歸生成類似文本的視覺 token 來合成圖像的能力。作者對(duì)模型進(jìn)行了零樣本文本條件下的圖像合成性能的定量評(píng)估,比較結(jié)果如表 2 所示。

表 2 不同模型的零樣本文本到圖像生成性能

從表中可以看出,LaVIT 的表現(xiàn)優(yōu)于所有其他多模態(tài)語(yǔ)言模型。與 Emu 相比,LaVIT 在更小的 LLM 模型上取得了進(jìn)一步改進(jìn),展現(xiàn)了出色的視覺 - 語(yǔ)言對(duì)齊能力。此外,LaVIT 在使用更少的訓(xùn)練數(shù)據(jù)的情況下,實(shí)現(xiàn)了與最先進(jìn)的文本到圖像專家 Parti 可比的性能。

多模態(tài)提示圖像生成

LaVIT 能夠在無(wú)需進(jìn)行任何微調(diào)的情況下,無(wú)縫地接受多種模態(tài)組合作為提示,生成相應(yīng)的圖像,而無(wú)需進(jìn)行任何微調(diào)。LaVIT 生成的圖像能夠準(zhǔn)確反映給定多模態(tài)提示的風(fēng)格和語(yǔ)義。而且它可以通過輸入的多模態(tài)提示修改原始輸入圖像。在沒有額外微調(diào)的下游數(shù)據(jù)的情況下,傳統(tǒng)的圖像生成模型如 Stable Diffusion 無(wú)法達(dá)到這種能力。

多模態(tài)圖像生成結(jié)果的示例

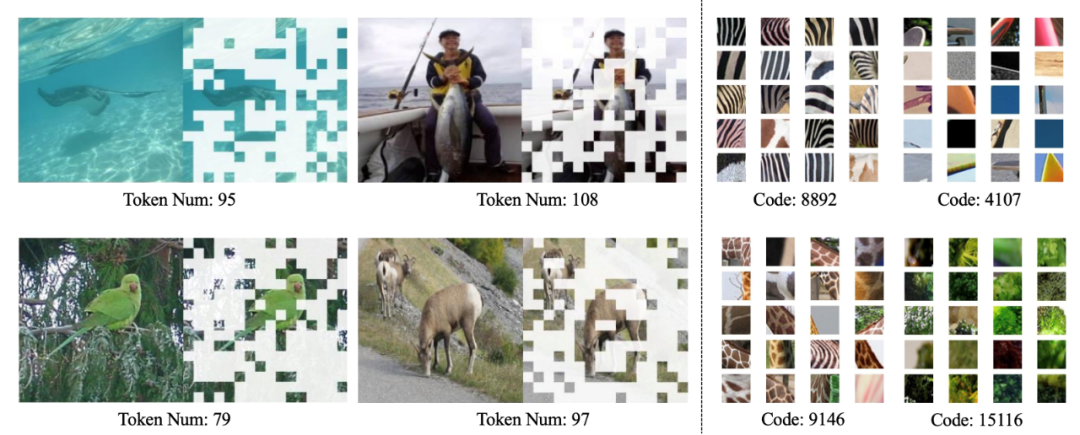

定性分析

如下圖所示,LaVIT 的動(dòng)態(tài)分詞器可以根據(jù)圖像內(nèi)容動(dòng)態(tài)選擇最具信息量的圖像塊,學(xué)習(xí)到的代碼本可以產(chǎn)生具有高層語(yǔ)義的視覺編碼。

動(dòng)態(tài)視覺分詞器(左)和學(xué)習(xí)到的 codebook(右)的可視化

總結(jié)

LaVIT 的出現(xiàn)為多模態(tài)任務(wù)的處理又提供了一種創(chuàng)新范式,通過使用動(dòng)態(tài)視覺分詞器將視覺和語(yǔ)言表示為統(tǒng)一的離散 token 表示,繼承了 LLM 成功的自回歸生成學(xué)習(xí)范式。通過在統(tǒng)一生成目標(biāo)下進(jìn)行優(yōu)化,LaVIT 可以將圖像視為一種外語(yǔ),像文本一樣理解和生成它們。這一方法的成功為未來多模態(tài)研究的發(fā)展方向提供了新的啟示,利用 LLM 強(qiáng)大的推理能力,實(shí)現(xiàn)更智能、更全面的多模態(tài)理解和生成打開新的可能性。