RV融合性能拉爆!RCBEVDet:Radar也有春天,最新SOTA!

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

寫在前面&筆者的個人理解

這篇論文關注的主要問題是3D目標檢測技術在自動駕駛進程中的應用。盡管環視相機技術的發展為3D目標檢測提供了高分辨率的語義信息,這種方法因無法精確捕獲深度信息和在惡劣天氣或低光照條件下的表現不佳等問題而受限。針對這一問題,論文提出了一種結合環視相機和經濟型毫米波雷達傳感器的多模態3D目標檢測新方法——RCBEVDet。

RCBEVDet的核心在于兩個關鍵設計:RadarBEVNet和Cross-Attention Multi-layer Fusion Module(CAMF)。RadarBEVNet旨在有效提取雷達特征,它包括雙流雷達主干網絡和RCS(雷達截面積)感知的BEV(鳥瞰圖)編碼器。這樣的設計利用點基和變換器基編碼器處理雷達點,通過交互更新雷達點特征,同時將雷達特定的RCS特性作為目標大小的先驗信息來優化BEV空間的點特征分布。而CAMF模塊通過多模態交叉注意力機制解決了雷達點的方位誤差問題,實現了雷達和相機的BEV特征圖的動態對齊以及通過通道和空間融合層的多模態特征自適應融合。

論文提出的新方法通過以下幾點實現對現有問題的解決:

- 高效的雷達特征提取器:通過雙流雷達主干和RCS感知的BEV編碼器設計,專門針對雷達數據的特性進行優化,解決了使用為激光雷達設計的編碼器處理雷達數據的不足。

- 強大的雷達-相機特征融合模塊:采用變形的交叉注意力機制,有效處理環視圖像和雷達輸入之間的空間不對齊問題,提高融合效果。

論文的主要貢獻如下:

- 提出了一種新穎的雷達-相機多模態3D目標檢測器RCBEVDet,實現了高精度、高效率和強魯棒性的3D目標檢測。

- 設計了針對雷達數據的高效特征提取器RadarBEVNet,通過雙流雷達主干和RCS感知BEV編碼器,提高了特征提取的效率和準確性。

- 引入了Cross-Attention Multi-layer Fusion模塊,通過變形交叉注意力機制實現了雷達和相機特征的精確對齊和高效融合。

- 在nuScenes和VoD數據集上達到了雷達-相機多模態3D目標檢測的新的最佳性能,同時在精度和速度之間實現了最佳平衡,并展示了在傳感器失效情況下的良好魯棒性。

詳解RCBEVDet

RadarBEVNet

RadarBEVNet是本論文提出的用于有效雷達BEV(鳥瞰圖)特征提取的網絡架構,主要包括兩個核心組成部分:雙流雷達主干網絡和RCS(雷達截面積)感知的BEV編碼器。

Dual-stream radar backbone

雙流雷達主干網絡由點基主干和變換器基主干組成。點基主干網絡通過多層感知機(MLP)和最大池化操作學習局部雷達特征,其過程可以簡化為以下公式:

這里的表示雷達點特征,通過MLP增加特征維度后,再通過最大池化操作提取全局信息并與高維特征連接。

變換器基主干則采用標準變換器塊,引入了距離調制的自注意力機制(DMSA),通過考慮雷達點之間的距離信息,優化模型聚集鄰近信息的能力,促進模型的收斂。DMSA機制調節的自注意力可以表示為:

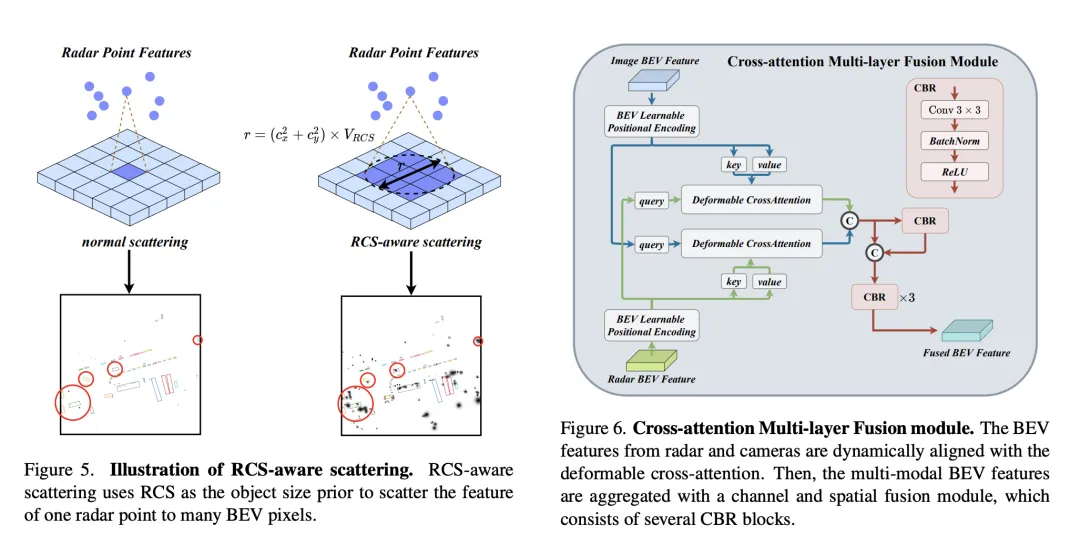

RCS-aware BEV encoder

為了解決傳統雷達BEV編碼器產生的BEV特征稀疏性問題,提出了RCS感知的BEV編碼器。它利用RCS作為目標大小的先驗信息,將雷達點特征散布到BEV空間中的多個像素上,而不是單一像素,以增加BEV特征的密度。該過程通過以下公式實現:

其中,為基于RCS的高斯式BEV權重圖,通過最大化所有雷達點的權重圖來優化。最終,將RCS散布得到的特征與連接并通過MLP處理,得到最終的RCS感知BEV特征。

整體而言,RadarBEVNet通過結合雙流雷達主干網絡和RCS感知的BEV編碼器,高效地提取雷達數據的特征,并通過RCS作為目標大小的先驗,優化了BEV空間的特征分布,為之后的多模態融合提供了強大的基礎。

Cross-Attention Multi-layer Fusion Module

Cross-Attention Multi-layer Fusion Module (CAMF)是一種用于動態對齊和融合多模態特征的高級網絡結構,特別針對雷達和相機生成的鳥瞰圖(BEV)特征的動態對齊和融合設計。這一模塊主要解決了由于雷達點云的方位誤差導致的特征不對齊問題,通過變形的交叉注意力機制(Deformable Cross-Attention),有效地捕獲雷達點的微小偏差,并減少了標準交叉注意力的計算復雜度。

CAMF利用變形交叉注意力機制來對齊相機和雷達的BEV特征。給定相機和雷達的BEV特征和,首先給和添加可學習的位置嵌入,然后將轉換為查詢和參考點,作為鍵和值。多頭變形交叉注意力的計算可以表示為:

其中表示注意力頭的索引,表示采樣鍵的索引,是總的采樣鍵數。表示采樣偏移,是由和計算得到的注意力權重。

在通過交叉注意力對齊相機和雷達的BEV特征之后,CAMF使用通道和空間融合層來聚合多模態BEV特征。具體地,首先將兩個BEV特征串聯為,然后將送入CBR(卷積-批歸一化-激活函數)塊并通過殘差連接獲得融合特征。CBR塊依次由一個的卷積層、一個批歸一化層和一個ReLU激活函數組成。之后,連續應用三個CBR塊以進一步融合多模態特征。

通過上述過程,CAMF有效地實現了雷達和相機BEV特征的精確對齊和高效融合,為3D目標檢測提供了豐富而準確的特征信息,從而提高了檢測性能。

相關實驗

在VoD驗證集上的3D目標檢測結果比較中,RadarBEVNet通過融合相機和雷達數據,在整個標注區域內和興趣區域內的平均精度(mAP)表現上均展現了優秀的性能。具體來說,對于整個標注區域,RadarBEVNet在汽車、行人和騎行者的檢測上分別達到了40.63%、38.86%和70.48%的AP值,將綜合mAP提升到了49.99%。而在興趣區域,即靠近本車的駕駛通道內,RadarBEVNet的表現更為突出,分別在汽車、行人和騎行者的檢測上達到了72.48%、49.89%和87.01%的AP值,綜合mAP達到了69.80%。

這些結果揭示了幾個關鍵點。首先,RadarBEVNet通過有效融合相機和雷達輸入,能夠充分利用兩種傳感器的互補優勢,提升了整體的檢測性能。相較于僅使用雷達的方法如PointPillar和RadarPillarNet,RadarBEVNet在綜合mAP上有明顯的提升,這表明多模態融合對于提高檢測精度尤為重要。其次,RadarBEVNet在興趣區域內的表現特別優秀,這對于自動駕駛應用來說尤為關鍵,因為興趣區域內的目標通常對即時駕駛決策影響最大。最后,雖然在汽車和行人的檢測上,RadarBEVNet的AP值略低于某些單一模態或其他多模態方法,但在騎行者檢測和綜合mAP表現上,RadarBEVNet展現了其綜合性能的優勢。RadarBEVNet通過融合相機和雷達的多模態數據,實現了在VoD驗證集上的優異表現,特別是在對自動駕駛至關重要的興趣區域內展現了強大的檢測能力,證明了其作為一種有效的3D目標檢測方法的潛力。

這個消融實驗展示了RadarBEVNet在逐步添加主要組件時,對3D目標檢測性能的持續改進。從基準模型BEVDepth開始,每一步增加的組件都顯著提高了NDS(核心度量標準,反映了檢測精度和完整性)和mAP(平均精確度,反映了模型對目標的檢測能力)。

- 添加時間信息:通過引入時間信息,NDS和mAP分別提升了4.4和5.4個百分點。這表明時間信息對于提高3D目標檢測的準確性和魯棒性非常有效,可能是因為時間維度提供了額外的動態信息,有助于模型更好地理解場景和目標的動態特性。

- 加入PointPillar+BEVFusion(基于雷達和相機的融合):這一步進一步提升了NDS和mAP,分別增加了1.7和1.8個百分點。這說明通過融合雷達和相機數據,模型能夠獲取更全面的場景理解,彌補了單一模態數據的局限。

- 引入RadarBEVNet:NDS和mAP分別再次提升2.1和3.0個百分點。RadarBEVNet作為一個高效的雷達特征提取器,優化了雷達數據的處理,提高了特征的質量和有效性,這對于整體檢測性能的提升至關重要。

- 添加CAMF(交叉注意力多層融合模塊):通過精細的特征對齊和融合,NDS增加了0.7個百分點,mAP稍微提升到45.6,顯示出在特征融合方面的有效性。這一步驟的改進雖然不如前幾步顯著,但依然證明了在多模態融合過程中,精確的特征對齊對于提高檢測性能的重要性。

- 加入時間監督:最后,引入時間監督后,NDS微增0.4個百分點至56.8,而mAP略有下降0.3個百分點至45.3。這表明時間監督能進一步提升模型在時間維度的性能,盡管對mAP的貢獻可能受到特定實驗設置或數據分布的影響而略顯限制。

總的來說,這一系列的消融實驗清晰地展示了RadarBEVNet中每個主要組件對于提高3D目標檢測性能的貢獻,從時間信息的引入到復雜的多模態融合策略,每一步都為模型帶來了性能上的提升。特別是,對雷達和相機數據的精細處理和融合策略,證明了在復雜的自動駕駛環境中,多模態數據處理的重要性。

討論

論文提出的RadarBEVNet方法通過融合相機和雷達的多模態數據,有效地提升了3D目標檢測的準確性和魯棒性,尤其在復雜的自動駕駛場景中表現出色。通過引入RadarBEVNet和Cross-Attention Multi-layer Fusion Module(CAMF),RadarBEVNet不僅優化了雷達數據的特征提取過程,還實現了雷達和相機數據之間精準的特征對齊和融合,從而克服了單一傳感器數據使用中的局限性,如雷達的方位誤差和相機在低光照或惡劣天氣條件下的性能下降。

優點方面,RadarBEVNet的主要貢獻在于其能夠有效處理并利用多模態數據之間的互補信息,提高了檢測的準確度和系統的魯棒性。RadarBEVNet的引入使得雷達數據的處理更為高效,而CAMF模塊確保了不同傳感器數據之間的有效融合,彌補了各自的不足。此外,RadarBEVNet在實驗中展現了在多個數據集上的優異性能,尤其是在自動駕駛中至關重要的興趣區域內,顯示了其在實際應用場景中的潛力。

缺點方面,盡管RadarBEVNet在多模態3D目標檢測領域取得了顯著成果,但其實現的復雜性也相應增加,可能需要更多的計算資源和處理時間,這在一定程度上限制了其在實時應用場景中的部署。此外,雖然RadarBEVNet在騎行者檢測和綜合性能上表現優秀,但在特定類別上(如汽車和行人)的性能仍有提升空間,這可能需要進一步的算法優化或更高效的特征融合策略來解決。

總之,RadarBEVNet通過其創新的多模態融合策略,在3D目標檢測領域展現了顯著的性能優勢。盡管存在一些局限性,如計算復雜度較高和在特定檢測類別上的性能提升空間,但其在提高自動駕駛系統準確性和魯棒性方面的潛力不容忽視。未來的工作可以聚焦于優化算法的計算效率和進一步提高其在各類目標檢測上的表現,以推動RadarBEVNet在實際自動駕駛應用中的廣泛部署。

結論

論文通過融合相機和雷達數據,引入了RadarBEVNet和Cross-Attention Multi-layer Fusion Module(CAMF),在3D目標檢測領域展現出顯著的性能提升,特別是在自動駕駛的關鍵場景中表現優異。它有效地利用了多模態數據之間的互補信息,提高了檢測準確性和系統的魯棒性。盡管存在計算復雜度高和在某些類別上性能提升空間的挑戰,\ours在推動自動駕駛技術發展,尤其是在提升自動駕駛系統的感知能力方面,展現了巨大的潛力和價值。未來工作可以關注于優化算法效率和進一步提升檢測性能,以便更好地適應實時自動駕駛應用的需求。