YOLOv8 中的損失函數解析

介紹

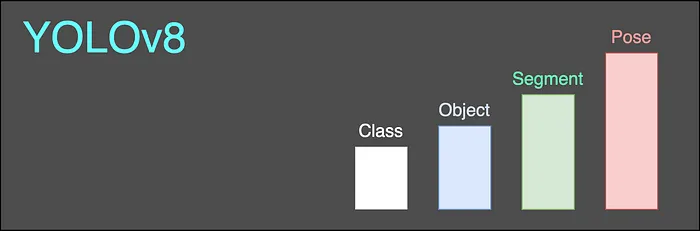

YOLO長期以來一直是目標檢測任務的首選模型之一。它既快速又準確。此外,其API簡潔易用。運行訓練或推斷作業所需的代碼行數有限。在2023年下半年,YOLOv8在框架中引入了姿態估計后,該框架現在支持最多四個任務,包括分類、目標檢測、實例分割和姿態估計。

在本文中,我們將詳細介紹YOLOv8中使用的五個損失函數。請注意,我們將僅討論YOLOv8倉庫中配置的默認損失函數。此外,我們還將僅關注代表性參數,跳過一些標量和常數以進行歸一化或縮放,以便更好地理解。YOLOv8中對應的任務和損失函數可見于圖1。接下來我們將分別對每一個進行討論。

IoU損失

cw = b1_x2.maximum(b2_x2) - b1_x1.minimum(b2_x1) # convex (smallest enclosing box) width

ch = b1_y2.maximum(b2_y2) - b1_y1.minimum(b2_y1) # convex height

if CIoU or DIoU: # Distance or Complete IoU https://arxiv.org/abs/1911.08287v1

c2 = cw ** 2 + ch ** 2 + eps # convex diagonal squared

rho2 = ((b2_x1 + b2_x2 - b1_x1 - b1_x2) ** 2 + (b2_y1 + b2_y2 - b1_y1 - b1_y2) ** 2) / 4 # center dist ** 2

if CIoU: # https://github.com/Zzh-tju/DIoU-SSD-pytorch/blob/master/utils/box/box_utils.py#L47

v = (4 / math.pi ** 2) * (torch.atan(w2 / h2) - torch.atan(w1 / h1)).pow(2)

with torch.no_grad():

alpha = v / (v - iou + (1 + eps))

return iou - (rho2 / c2 + v * alpha) # CIoU當考慮評估邊界框準確度的方式時,交并比(IoU)指標可能是大多數人首先想到的一個指標。IoU度量了預測的邊界框與實際邊界框之間的重疊程度。它也可以作為一個損失函數,只需將IoU轉換為1-IoU。

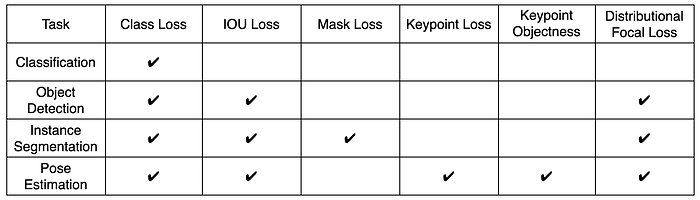

在YOLOv8中,修訂后的版本,完全IoU(CIoU)1被應用于衡量預測邊界框與實際邊界框之間的差異。CIoU是一個綜合性指標,它考慮了邊界框之間的三個屬性:

- 重疊比

- 中心點之間的距離

- 長寬比

CIoU的方程可在圖2右側找到。重疊比、中心點距離和長寬比這三個因素分別由方程中的各項表示。方程中涉及的關鍵參數在左側的圖中進行了說明,其中p和g表示預測和實際情況,b、w和h分別是相應邊界框的中心、寬度和高度。參數c是包圍邊界框的對角線(灰色虛線矩形)而ρ是歐氏距離。除了分類任務外,IoU損失在YOLOv8中的所有其他任務中都會應用。

分布焦點損失(DFL)

def _df_loss(pred_dist, target):

"""Return sum of left and right DFL losses."""

# Distribution Focal Loss (DFL) proposed in Generalized Focal Loss https://ieeexplore.ieee.org/document/9792391

tl = target.long() # target left

tr = tl + 1 # target right

wl = tr - target # weight left

wr = 1 - wl # weight right

return (F.cross_entropy(pred_dist, tl.view(-1), reduction='none').view(tl.shape) * wl +

F.cross_entropy(pred_dist, tr.view(-1), reduction='none').view(tl.shape) * wr).mean(-1, keepdim=True)另一個與邊界框相關的損失函數是分布焦點損失(DFL)2。DFL關注的是邊界框回歸的分布差異。YOLOv8中的網絡不是直接預測邊界框,而是預測邊界框的概率分布。它旨在解決邊界模糊或部分遮擋的挑戰性對象。

關鍵點損失

loss[1] += self.keypoint_loss(pred_kpt, gt_kpt, kpt_mask, area)

area:bounding box area

class KeypointLoss(nn.Module):

def forward(self, pred_kpts, gt_kpts, kpt_mask, area):

"""Calculates keypoint loss factor and Euclidean distance loss for predicted and actual keypoints."""

d = (pred_kpts[..., 0] - gt_kpts[..., 0]) ** 2 + (pred_kpts[..., 1] - gt_kpts[..., 1]) ** 2

kpt_loss_factor = (torch.sum(kpt_mask != 0) + torch.sum(kpt_mask == 0)) / (torch.sum(kpt_mask != 0) + 1e-9)

# e = d / (2 * (area * self.sigmas) ** 2 + 1e-9) # from formula

e = d / (2 * self.sigmas) ** 2 / (area + 1e-9) / 2 # from cocoeval

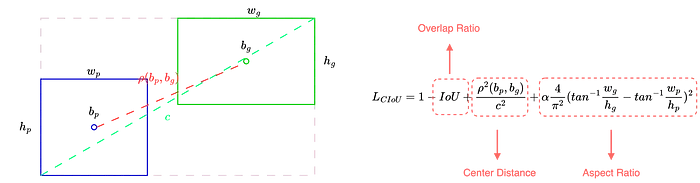

return kpt_loss_factor * ((1 - torch.exp(-e)) * kpt_mask).mean()在YOLOv8中,首次將姿態估計任務納入到框架中。姿態由一組關鍵點的坐標和順序定義。關鍵點損失監控了預測和實際關鍵點之間的相似性。兩個對應關鍵點之間的歐幾里得距離是關鍵點損失的主要組成部分。此外,每個關鍵點都帶有一個權重σ,定義了關鍵點的重要性,默認值為1/關鍵點數。例如,如果姿態有四個關鍵點,則所有關鍵點的權重為1/4 = 0.25。

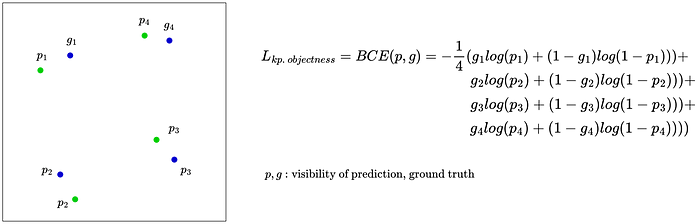

關鍵點目標損失

import torch.nn as nn

loss[2] = nn.BCEWithLogitsLoss(pred_kpt[..., 2], kpt_mask.float())在大多數姿態估計訓練中,我們可以定義每個關鍵點的可見性。Python腳本中的參數kpt_mask攜帶了我們在標簽中定義的可見性(1/0)。關鍵點目標損失計算關鍵點存在的距離。在YOLOv8中,距離由預測值和實際值的二元交叉熵(BCE)測量。

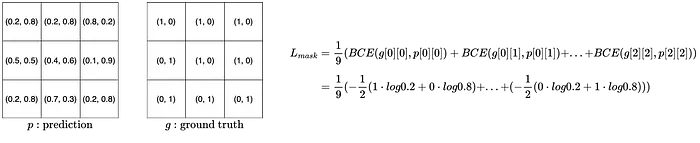

分類損失和掩碼損失

import torch.nn as nn

loss[3] = nn.BCEWithLogitLoss(pred_scores, target_scores.to(dtype)).sum() / target_scores_sum # BCE分類損失是涉及到所有任務的唯一損失函數。無論我們是在進行分類、目標檢測、分割還是姿態估計,圖像或特定對象的類別(例如貓、狗、人等)的推斷結果之間的距離都是通過二元交叉熵(BCE)計算的。

它還適用于實例分割中的掩碼損失。掩碼損失將每個像素視為一個對象,并計算相關的BCE值。在圖5中計算了一個3x3的預測掩碼和相應的掩碼損失。

總損失

# yolo/cfg/default.yaml

...

box: 7.5 # box loss gain

cls: 0.5 # cls loss gain (scale with pixels)

dfl: 1.5 # dfl loss gain

pose: 12.0 # pose loss gain

kobj: 1.0 # keypoint obj loss gain

...好了,以上我們已經介紹了所有六個損失。在網絡應用反向傳播并更新其參數之前,將損失與相應的權重相加。權重在配置文件default.yaml中定義,如上所示。如果您想在訓練階段動態調整權重,您可以考慮直接在存儲庫中使用下面提供的代碼片段。

loss[0] *= self.hyp.box # box gain

loss[1] *= self.hyp.pose / batch_size # pose gain

loss[2] *= self.hyp.kobj / batch_size # kobj gain

loss[3] *= self.hyp.cls # cls gain

loss[4] *= self.hyp.dfl # dfl gain

return loss.sum() * batch_size, loss.detach()總結

YOLO是一個為目標檢測任務而知名的框架。除了在效率和準確性方面的表現之外,它還在不斷更新最新的研究成果。這是一個讓計算機視覺從業者跟蹤和學習入選技術的好框架。損失函數在模型訓練中起著重要作用,并決定了最終的準確性。