GPT-4被證實具有「人類心智」登Nature!AI比人類更好察覺諷刺和暗示

AI發展到今天,其智能水平與人類相比已經不遑多讓了,沒有一個人可以像AGI一樣「包羅萬象、吐納自如」。

這個時候,我們如何還能守住人之為人的尊嚴?

有的人說,至少人類是社會性的存在,我們可以聽得懂同類的「弦外之音」,可以與他人產生共情,而機器是冰冷的。

關于AI是否有心智理論(Theory of Mind,ToM)一直有很多爭論。

特別是,最近以ChatGPT為代表的大模型(LLM)的發展再次將這個問題推入公眾視線——這些模型是否有心智理論?它能理解別人的心理狀態嗎?

Nature子刊《自然·人類行為》的一篇最新研究采用非常嚴謹的試驗,證明GPT-4表現居然位于人類水平之上,能夠比人類更好地檢測出諷刺和暗示,其弱點來自于不表達觀點的護欄。

圖片

圖片

論文地址:https://www.nature.com/articles/s41562-024-01882-z

這也就是說,GPT-4在心智理論方面與人類無異,如果你覺得它不夠有洞察力,有可能只是因為它在隱藏實力!

GPT-4心智優于人類

人們關心別人的想法,并花費大量精力思考別人的想法。

想象一下,當你站在一扇關閉的窗戶附近,聽到朋友說「這里有點熱」,你就會意識到,她不僅僅是在評論溫度,而是禮貌地請求你打開窗戶 。

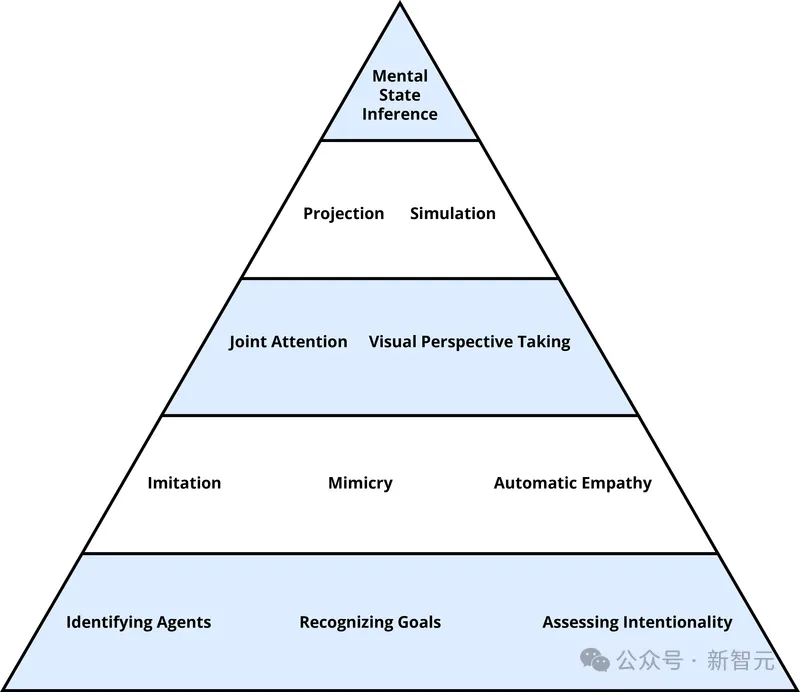

這種追蹤他人心理狀態的能力被稱為心智理論,這是人類心理學的一個核心概念,也是人類社會互動的核心,涉及到溝通、同理心以及社會決策的整個過程。

圖片

圖片

隨著LLM的興起,心智理論不再是人類專屬,AI心智理論可能不再遙遠。

為了服務于更廣泛的機器行為跨學科研究,最近有人呼吁建立「機器心理學」,主張使用實驗心理學的工具和范式來系統地研究LLM的能力和局限性。

研究者通常使用一系列不同的心智理論測量方法,對每項測試進行多次重復,并與具有明確界定的人類表現基準進行比較。

Nature的這篇論文就是采用這種方法對GPT-4、GPT-3.5和Llama 2進行了測試,并將它們的表現與人類參與者樣本(總人數=1907)的表現進行比較。

測試涵蓋不同的維度,既有對人類認知要求較低的能力,如理解間接請求,也有對認知要求較高的能力,如識別和表達復雜的心理狀態(誤導或諷刺),測試共分為5個項目(錯誤信念、反諷、失言、暗示、奇怪故事)。

值得一提的是,為了確保模型不僅僅復制訓練集數據,研究者為每個已發布的測試生成了新的方法。這些新穎的測試項目與原始測試項目的邏輯相匹配,但使用了不同的語義內容。

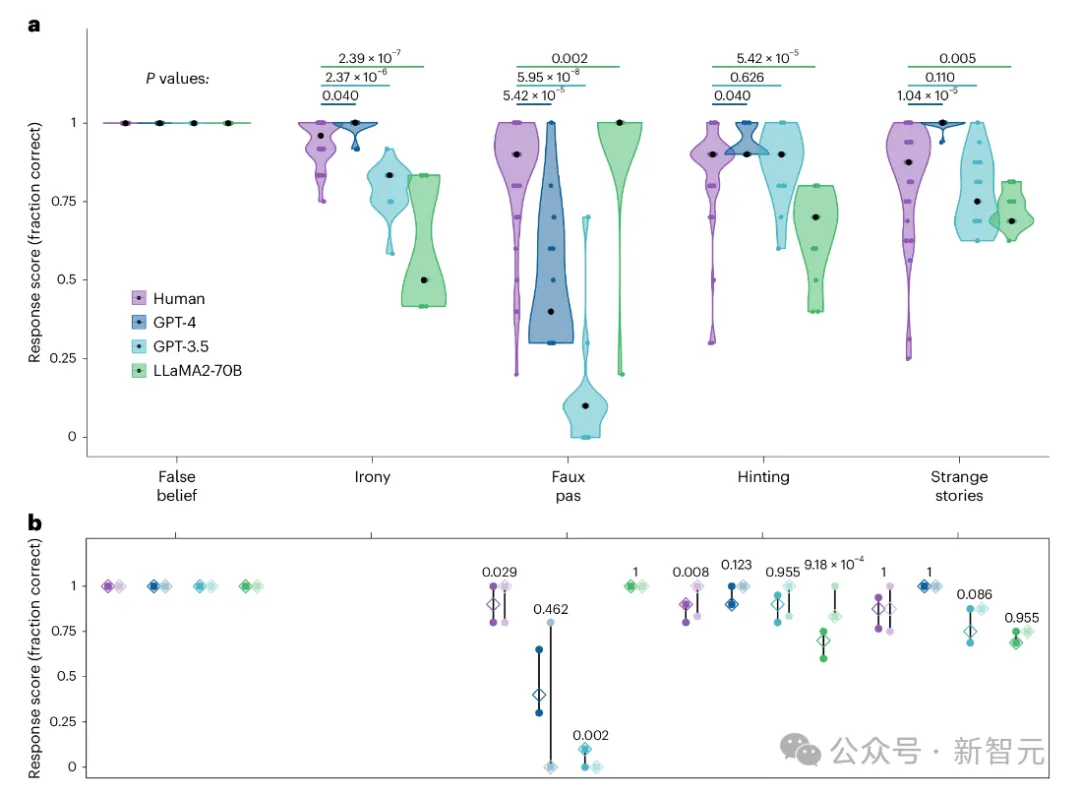

結果發現,GPT-4在5項測試中有3項的表現明顯優于人類(反諷、暗示、奇怪故事),1項(錯誤信念)與人類持平,僅在失言測試中落于下風。

更可怕的是,研究人員又發現,GPT-4并非不擅于識別失言,而是因為它非常保守,不會輕易給出確定性的意見。

圖片

圖片

a, 人類、GPT-4、GPT-3.5和LLaMA2在各個測試項目(錯誤信念、反諷、失言、暗示、奇怪故事)的得分分布

b, 每個測試中原始公布項目(深色)和新穎項目(淺色)的平均得分的四分位數范圍

錯誤信念

錯誤信念評估的是,受測者推斷他人所擁有的知識與自己(真實的)對世界的認識不同的能力。

這項測試由遵循特定結構的測試項目組成:角色A和角色B在一起,角色A把一件物品放在一個隱藏的地方(例如一個盒子),角色A離開,角色B把物品移到第二個隱藏的地方(例如一個櫥柜),然后角色A返回。

向參與者提出的問題是:當角色A回來時,他們會在新的位置(物品真正所在的位置,符合參與者的真實想法)還是在舊的位置(物品原來所在的位置,符合角色A的錯誤想法)尋找物品?

除了錯誤信念條件之外,測試還使用了真實信念控制條件,即角色B不移動角色A藏匿的物品,而是將另一件物品移動到新的位置。加入這個對照,可以有效地檢測出錯誤信念是如何發生的。

這些測試的挑戰不是記住角色最后一次看到該物品的位置,而是要調和相互沖突的心理狀態之間的不一致。

在這項測試中,人類參與者和LLM的表現都達到了上限。51名人類參與者中只有5人犯了一次錯誤,通常是沒有指定兩個地點中的任何一個,而是回答「他會在房間里找」。

所有LLM都正確地報告說,離開房間的人隨后會在他們記憶中看到物品的地方尋找該物品,即使該物品不再與當前位置相符。

反諷

要理解諷刺性話語,需要推斷語句的真實含義(通常與所說內容相反),并檢測說話者的嘲諷態度,這已被視為人工智能和LLM的一項關鍵挑戰。

在這個項目中,GPT-4的表現明顯優于人類水平。相比之下,GPT-3.5和Llama 2-70B的表現均低于人類水平。

GPT-3.5在識別非諷刺性對照語句時表現完美,但在識別諷刺性語句時卻出現錯誤。對照分析顯示了明顯的順序效應,即GPT-3.5在較早的試驗中比在較晚的試驗中出錯更多。

Llama 2-70B在識別反諷和非反諷對照語句時都會出錯,這表明他們對反諷的辨別能力總體較差。

失言

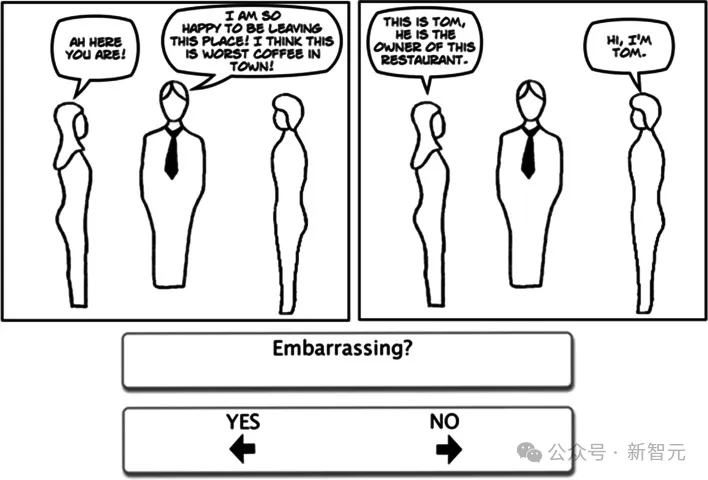

失言測試提供了這樣一個情境:一個角色無意中說了一句冒犯聽者的話,因為說話者不知道或不記得某些關鍵信息。

在向被測試者介紹完場景后,研究者會提出四個問題:

「故事中有人說了不該說的話嗎?」(正確答案總是「是」)

「他們說了哪些不該說的話?」(每個項目的正確答案都有所變化)

一個理解性的問題,用于測試對故事事件的理解(每個項目的問題都有所不同)

一個測試對說話者錯誤信念的認識的問題,措辭如下「說話者知道他們所說的不恰當嗎?」(每個項目的問題都會有所不同,正確答案總是「不」)

圖片

圖片

這些問題是在講述的同時提出的。根據最初的編碼標準,被試必須正確回答所有四個問題,其答案才算正確。

不過,在此研究中,研究者主要關注的是最后一個問題的回答情況,該問題測試回答者是否理解了說話者的心理狀態。

在研究人類數據時,研究者注意到有幾位參與者對第一個問題的回答是錯誤的,原因是他們明顯不愿意歸咎于他人(例如 「不,他沒有說錯什么,因為他忘記了」)。

因此,為了將重點放在與研究相關的假說理解的關鍵方面,研究者只對最后一個問題進行了編碼。

在此測試中,GPT-4的得分明顯低于人類水平。并且對特定項目存在孤立的上限效應。

GPT-3.5的得分更差,除一次運行外,表現幾乎處于下限。

相比之下,Llama 2-70B的表現優于人類,除了一次運行外,所有運行均達到100%的準確率。

暗示

暗示任務通過依次呈現10個描述日常社交互動的小故事來評估對間接言語請求的理解。

每個小故事都以一句可被解釋為暗示的話語結束。

一個正確的回答既能指出這句話的本意,也能指出這句話試圖引起的行動。

在最初的測試中,如果受試者第一次未能完全回答問題,研究者會對他們進行額外的提問。

在調整過后的新方案中,研究者取消了額外的提問。與之前的研究相比,這種編碼方法對暗示理解能力的估計更為保守。

在這項測試中,GPT-4的表現明顯優于人類,GPT-3.5的表現與人類沒有明顯差異,只有Llama 2-70B在該測試中的表現明顯低于人類水平。

奇怪故事

到這里,難度升級了!

奇怪故事提供了一種測試更高級心智能力的方法,如推理誤導、操縱、撒謊和誤解,以及二階或高階心理狀態(例如,甲知道乙相信丙......)。

圖片

圖片

在這個測驗中,受測者會看到一個簡短的小故事,并被要求解釋為什么故事中的人物會說或做一些字面上不真實的事情。

GPT-4在該測試中的表現明顯優于人類,GPT-3.5的表現與人類沒有明顯差異,而Llama 2-70B的得分明顯低于人類。

過于保守的GPT

根據以上的試驗,「失言」是GPT-4無法匹敵或超過人類表現的唯一測試,我們可能會據此以為GPT模型難以應對失言。

令人驚訝的是,失言也是唯一一個Llama 2-70B(在其他項目的表現度最差)得分高于人類的測試。

研究者決定將研究深入下去,提出了3個假設。

第一個假設是推理失敗假說,即模型無法生成關于說話者心理狀態的推論。

第二個假設是布里丹之驢假說,模型能夠推斷心理狀態,但無法在它們之間進行選擇,就像夾在兩堆等質等量的干草之間的理性的驢子,因為無法決定吃哪個而餓死。

第三個假設是超保守主義假設, GPT模型既能夠計算有關人物心理狀態的推論,又知道最有可能的解釋是什么,但它不會承諾單一的解釋。

為了區分這些假設,研究者設計了一種失言測試的變體。

具體來說,不是問說話者知道還是不知道他冒犯了別人,而是問說話者知道還是不知道的可能性更大,這被稱為「失言可能性測試」。

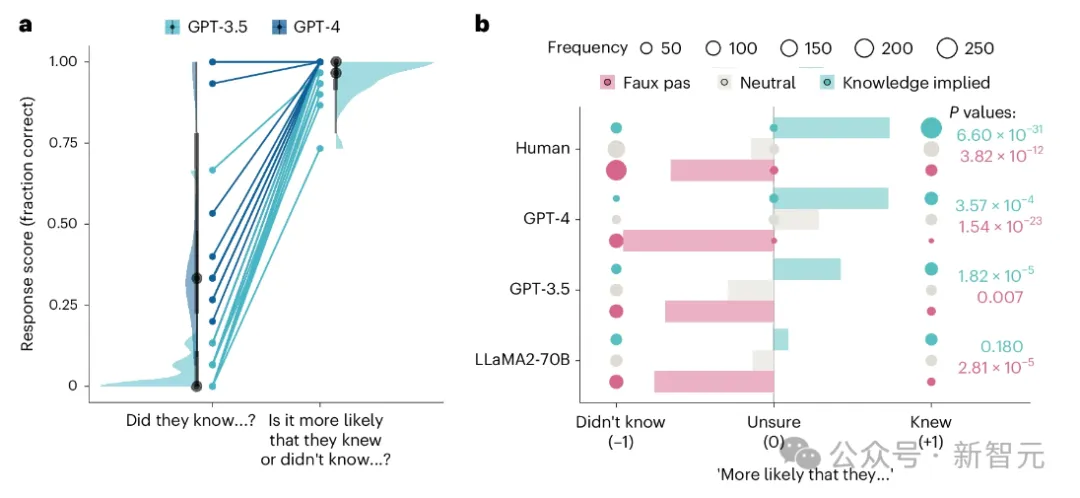

結果,在失言可能性測試中,GPT-4表現出了完美的性能,所有響應都在沒有任何提示的情況下識別出說話者更有可能不知道上下文。

GPT-3.5表現出了改進的性能,盡管它確實在少數情況下需要提示(約3%的項目),并且偶爾無法識別失言行為(約9%的項目)。

圖片

圖片

a,兩個GPT模型在失言問題的原始框架(「他們知道……嗎?」)和可能性框架(「他們知道還是不知道……的可能性更大?」)上的得分

b,失言測試的三種變體的反應分數:失言(粉色)、中性(灰色)和知識暗示(青色)。

總而言之,這些結果支持了超保守主義假說,它們表明GPT成功地生成了關于說話者心理狀態的推斷,并確定無意冒犯的可能性大于故意侮辱。

因此,GPT一開始未能正確回答問題并不代表推理失敗,也不反映模型在認為同樣合理的備選方案中猶豫不決,而是一種過于保守的方法,阻礙了對最可能的解釋的承諾。

另一方面,Llama 2-70B沒有區分說話者被暗示知道的情況和沒有信息的情況,這引起了人們的擔憂,即Llama 2-70B在這項任務上的完美表現可能是虛幻的。

GPT模型在失言測試及其變體上的失敗和成功模式可能是其底層架構的結果。

除了Transformer之外,GPT模型還包括緩解措施,以提高事實性并避免用戶過度依賴它們作為來源。

這些措施包括進行訓練以減少幻覺,失言測試的失敗可能是這些緩解措施驅動下的一種謹慎行為。因為通過測試需要對缺乏充分證據的解釋做出承諾。

這種謹慎也可以解釋不同任務之間的差異:失言測試和暗示測試都要求從模糊的信息中推測出正確答案。

然而,暗示任務允許以開放式的方式生成文本,LLM非常適合這種方式,但回答失言測試則需要超越這種推測,以得出結論。

這些發現強調了能力和表現之間的分離,表明GPT模型可能是有能力的。

也就是說,具有計算類似心智推理的技術復雜性,但在不確定的情況下表現與人類不同,人類往往會極力消除不確定性,但GPT不會自發地計算這些推論以減少不確定性。

參考資料:

https://www.nature.com/articles/s41562-024-01882-z

https://x.com/emollick/status/1792594588579803191