多模態模型學會打撲克:表現超越GPT-4v,全新強化學習框架是關鍵

只用強化學習來微調,無需人類反饋,就能讓多模態大模型學會做決策!

這種方法得到的模型,已經學會了看圖玩撲克、算“12點”等任務,表現甚至超越了GPT-4v。

圖片

圖片

這是來自UC伯克利等高校最新提出的微調方法,研究陣容也是相當豪華:

- 圖靈獎三巨頭之一、Meta首席AI科學家、紐約大學教授LeCun

- UC伯克利大牛、ALOHA團隊成員Sergry Levine

- ResNeXt一作、Sora基礎技術DiT作者謝賽寧

- 香港大學數據科學學院院長、UC伯克利教授馬毅

圖片

圖片

該方法名為RL4VLM,論文預印本已經上線,相關代碼也已在GitHub中開源。

RL4VLM提出了一種新的算法框架,直接使用強化學習方法對多模態大模型進行微調。

其中獎勵信息直接來源于環境當中,擺脫了RLHF中對于人類反饋的需要,從而直接賦予了多模態模型決策能力。

圖片

圖片

對于RL4VLM的意義,參與了這項工作的馬毅教授這樣說:

一方面希望大家對模型真實性能有更客觀清醒的認識;

另一方面,也希望能建立一個平臺,支持探索如何進一步提升模型性能。

圖片

圖片

那么,用這種方法微調出來的多模態大模型,都能讓智能體學會哪些能力呢?

多模態決策能力超GPT-4v

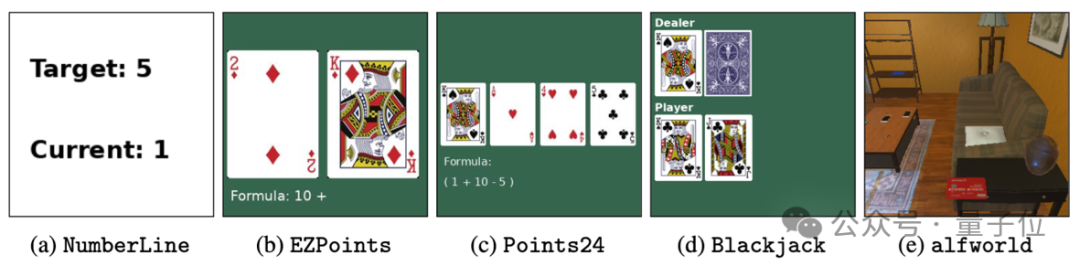

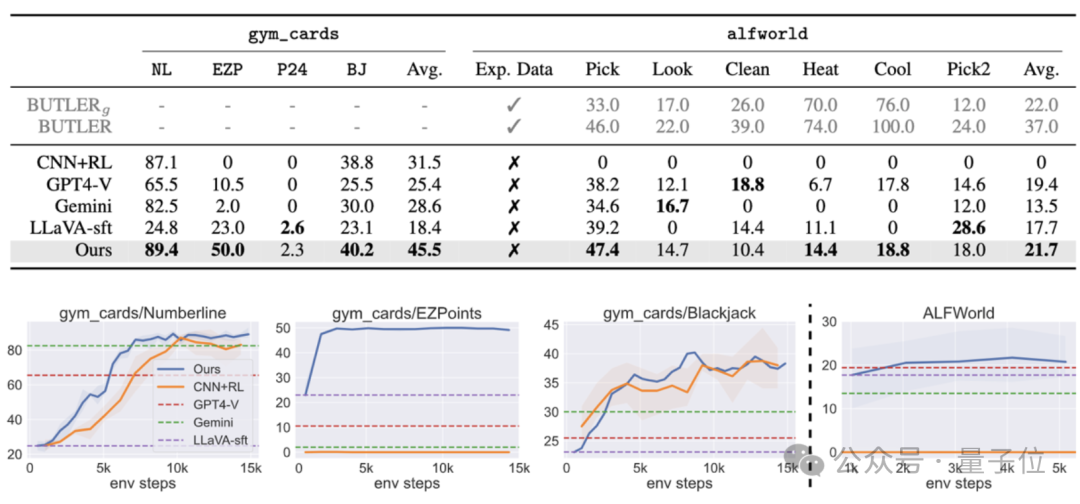

為了評估訓練出的多模態大模型給智能體帶來的能力,作者一共使用了兩類物種評測任務:

- 第一類任務(a-d) 主要考驗模型利用圖像中的細粒度視覺信息做決策的能力,包括對于數字的識別能力和利用識別的數字進行邏輯推理的能力

- 第二類任務(e)主要考察多模態大模型在具身智能環境中的視覺語義推理能力。

具體來說,這五個任務分別是:

- a.數軸(Numberline):模型需要通過輸出“+” 或者 “-”,將當前數字移動到目標數字

- b.簡易12點(EZPoint):模型需要識別兩張牌,并用加號和乘號運算“12點”

c.24點(Point24): 模型需要識別四張牌,并用加減乘除和括號運算“24點”

- d.21點(Blackjack):模型需要通過牌面上的信息來決定“要牌”或者“停牌”

- e.ALFWorld:一個標準具身智能環境

圖片

圖片

其中任務a-d為作者的原創任務,任務e的ALFWorld是微軟等于2020年提出的開源具身智能任務集。

實驗結果表明,直接使用強化學習微調7B的多模態模型之后,能使其在兩類決策問題上的表現超過商用模型GPT-4v Gemini,同時也能超過傳統的監督微調(SFT)方法。

而在ALFWorld的具身智能任務中,作者的模型也取得了最高的平均分,特別是在單物體拾取任務上表現尤為突出。

圖片

圖片

先生成思維鏈,再做決策

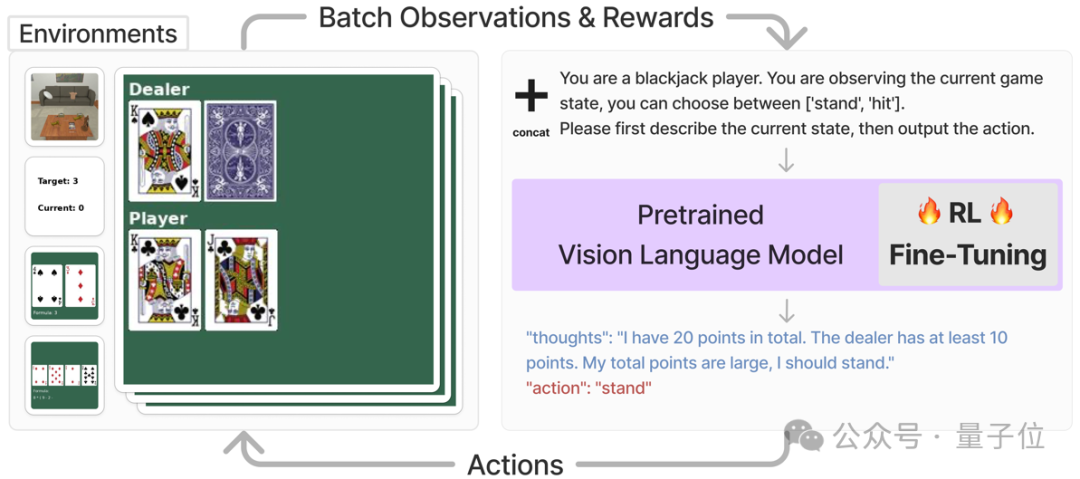

這套VLM智能體主要解決的是需要視覺識別和語言理解的任務,它的工作流程是這樣的:

首先,對于每一個任務,系統會直接將該任務的當前狀態,以圖片和文字描述的形式輸入多模態大模型,并要求模型輸出一段思維鏈之后,再以文字形式輸出要執行的動作。

最后將,動作信息會被輸入進對應的環境并獲得獎勵值,該獎勵值會被用來進行強化學習訓練。

例如下圖中,智能體在執行玩21點的任務時,系統直接要求多模態模型根據目前的狀態,在輸出思維鏈之后選擇“停牌” (stand)或者“拿牌”(hit),然后直接將對應的動作輸入到環境中,得到獎勵函數值以及下一個狀態。

圖片

圖片

為了能用直接將強化學習運用到多模態模型的訓練中,需要對模型的輸入和輸出做一些調整,以適應RL訓練框架中。

具體來說,作者將任務圖像o和任務描述的文本v-in合并后,直接作為當前任務的狀態s,即:s = [o, v-in]

在獲得了多模態模型的文字輸出v-out以后,該框架直接將其中文字形式的動作(“action: {act}”) 轉化為可與環境交互的動作指令a。

接下來把a輸入到環境當中,就能獲得獎勵函數r,以及操作后的下一個狀態。

在獲得了來自環境的獎勵函數r之后,文章利用PPO直接對整個多模態模型進行微調。

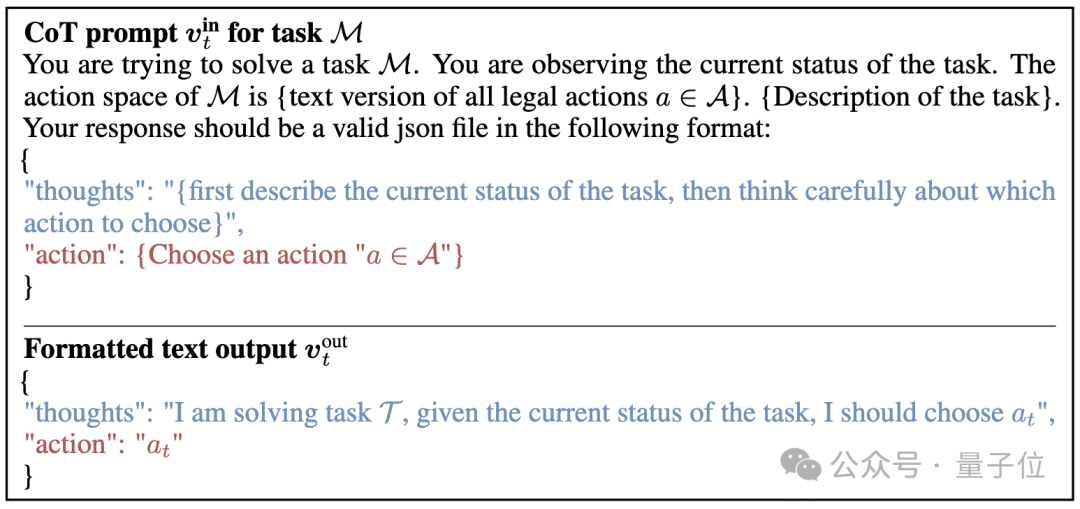

而從提示詞上看,這項研究采取了如下的提示過程作為多模態模型的輸入,并且給出了期望的輸出形式:

(其中藍色的部分是讓模型生成思維鏈提示過程, 紅色的部分是告訴模型以文字形式輸出動作a)。

圖片

圖片

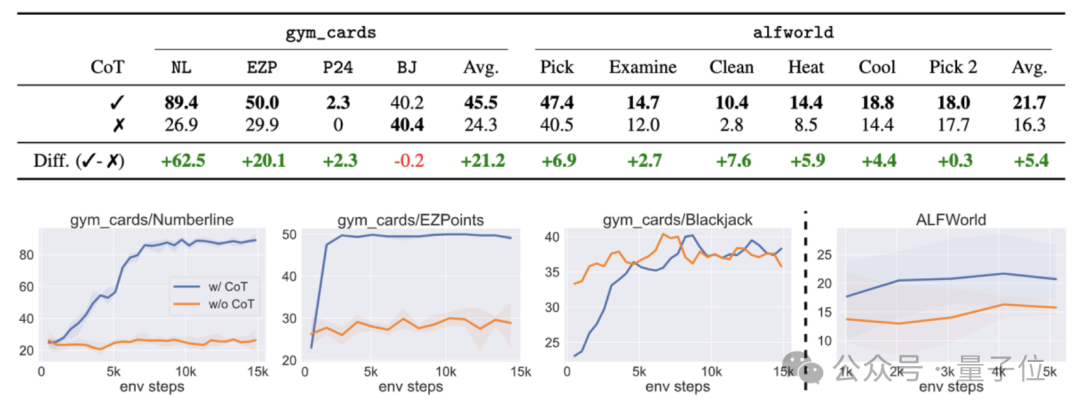

消融實驗結果表明,如果這一過程中不采用思維鏈,則任務成功率會出現大幅下降。

圖片

圖片

論文地址:https://arxiv.org/abs/2405.10292GitHub:https://github.com/RL4VLM/RL4VLM