1.2萬人朝圣CVPR,華人學者奪最佳論文!Sora舵手火爆演講成大型追星現場

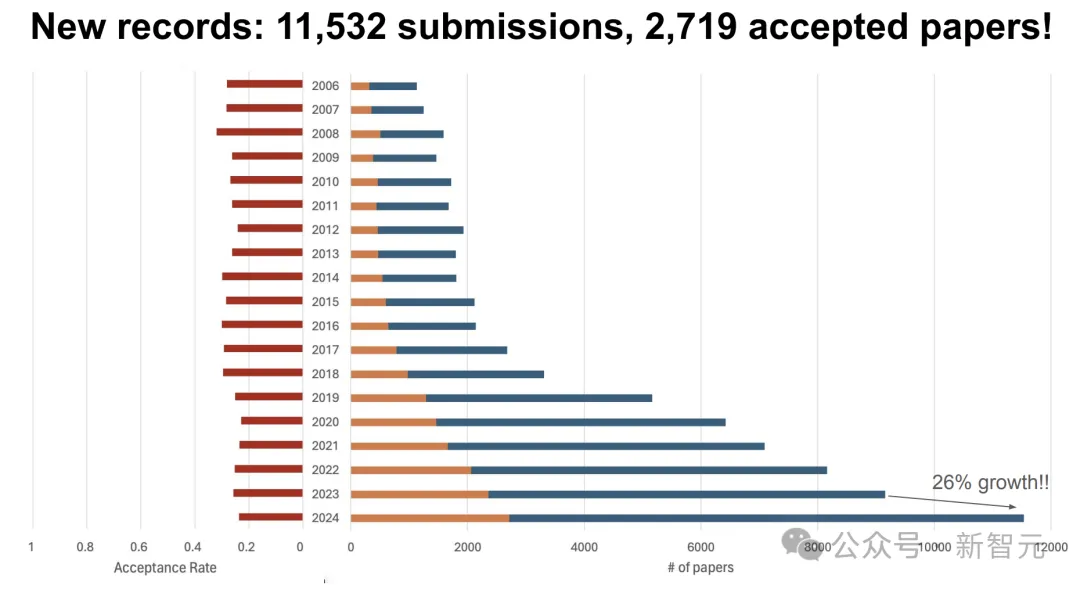

2024年CVPR會議將在美國西雅圖拉開帷幕,根據官方的公告,本屆會議已經成為CVPR歷史上規模最大、參與人數最多的一屆,截止6月19日,現場參會人數已超過1.2萬人。

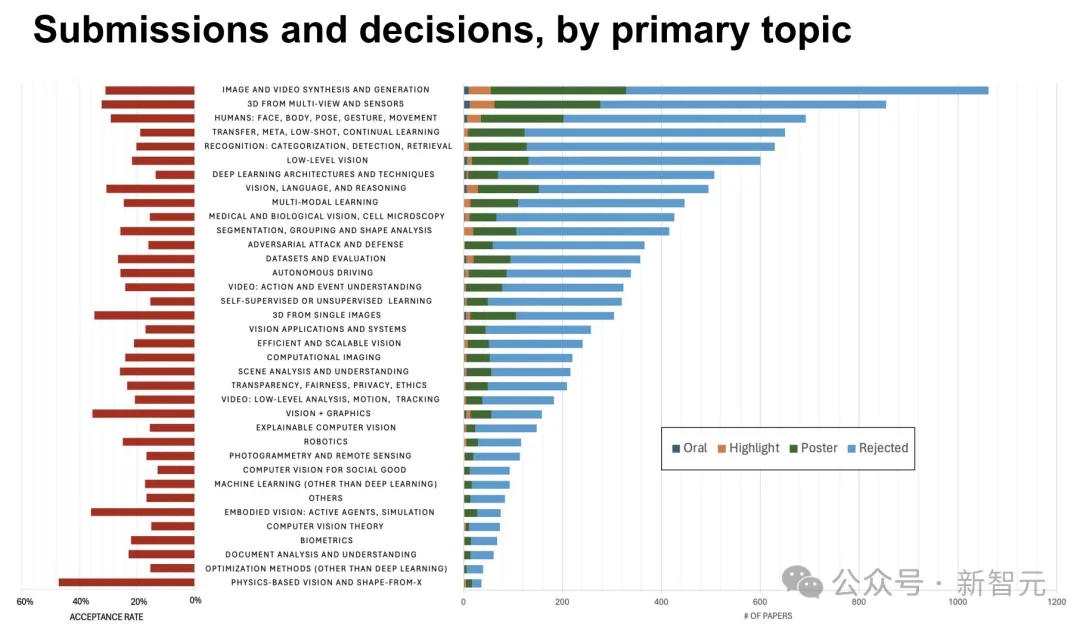

此外,近年來的論文接收數量也水漲船高,共有11532篇提交論文,錄用率為23.58%,比去年的9155篇論文多出了2000多篇。

由于開年Sora模型帶起的視頻生成的熱潮,今年CVPR接收論文數量最多的領域就是「圖像視頻的合成與生成」,緊隨其后的兩個領域分別是「多視角和傳感器的3D」以及「人體:面部、軀體、姿勢、手勢和移動」。

從會議現場的照片中,也能肉眼感受到CVPR的熱烈程度。

揭秘Sora訓練技巧

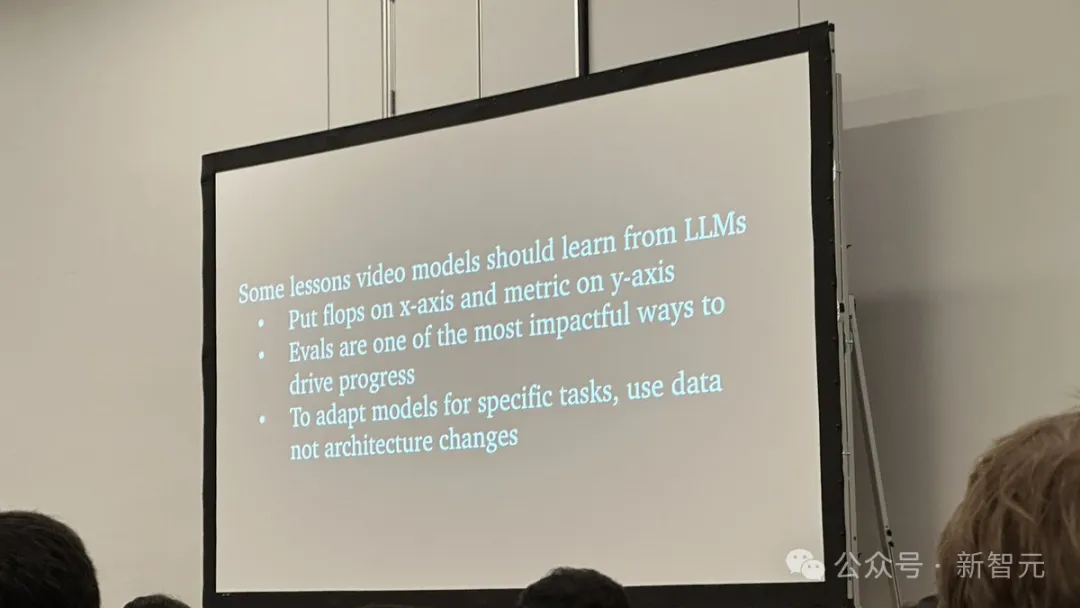

Sora研究團隊的負責人Tim Brooks也在研討會上發表了演講,揭秘了Sora模型的一些訓練技巧以及視頻生成模型未來的新功能。

演講中,Brooks表示自己看好Transformer架構的可擴展性,如果算力足夠,我們有望借此實現世界模擬器。

此外他也分享了一些訓練模型的心得,比如不要為了某個特定任務去調整模型架構,而是先考慮讓數據適應任務。

比如,Sora在訓練時的技巧就多與數據有關,包括使用不同比例的圖像和視頻,以及搭配字幕訓練。

有推特網友表示,Brooks的演講堪比追星現場,都差點擠不進去。

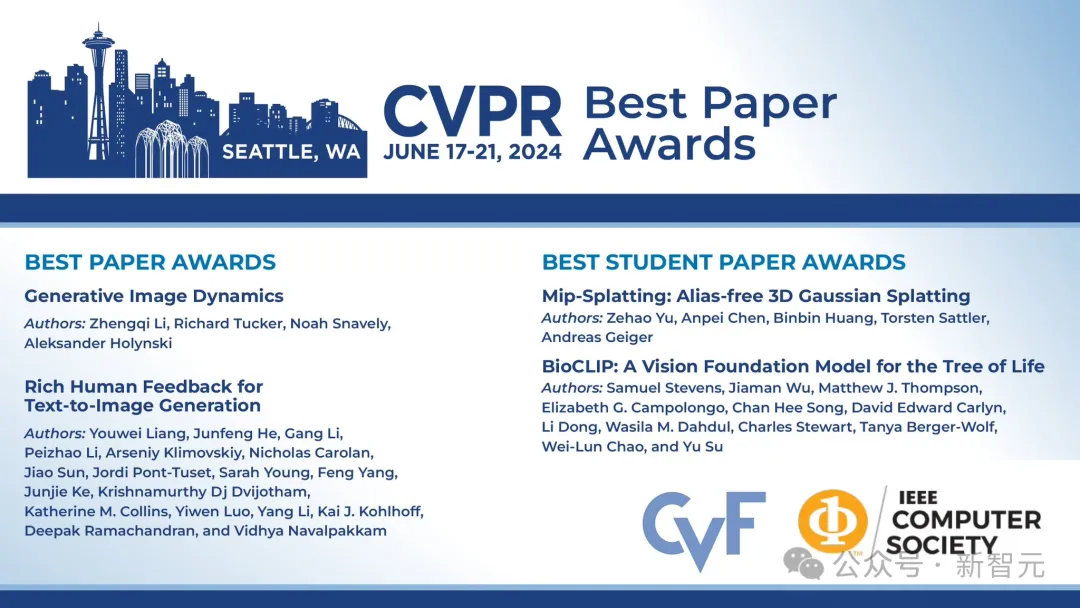

當然,最重磅的還是CVPR在今天凌晨的大會開幕演講上。正式官宣了2024年最佳論文、最佳學生論文等大獎的得主。

該獎項每年都會表彰在計算機視覺、人工智能(AI)、機器學習(ML)、增強現實、虛擬現實和混合現實(AR/VR/MR)、深度學習等領域的頂尖研究。

今年,CVPR從超過11,500篇論文提交中,選出了以下10篇最佳論文——是2023年的兩倍之多。

最佳論文

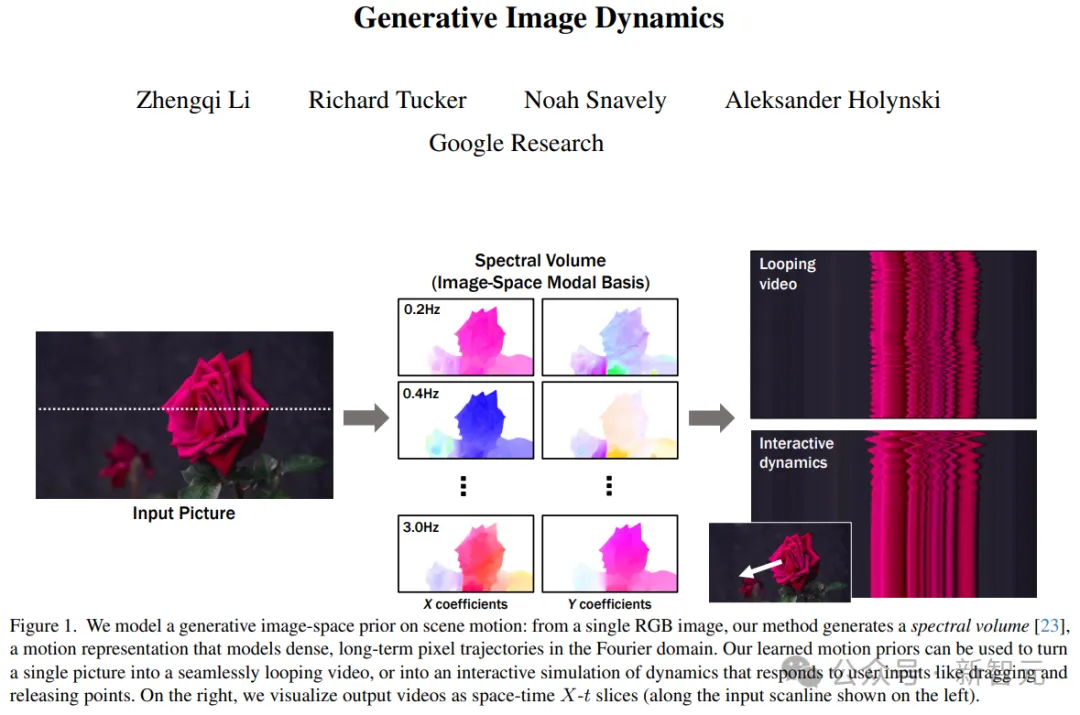

題目:Generative Image Dynamics

作者:Zhengqi Li, Richard Tucker, Noah Snavely, Aleksander Holynsk

機構:谷歌研究院

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Li_Generative_Image_Dynamics_CVPR_2024_paper.pdf

在這項工作中,作者提出了一種從單張靜態圖片中建模自然振蕩動態效果的新方法。該方法能夠從單張圖片生成照片般真實的動畫,并顯著優于現有的基準方法。此外,他們還展示了在多個后續應用中的潛力,例如創建無縫循環或交互式圖像動態效果。

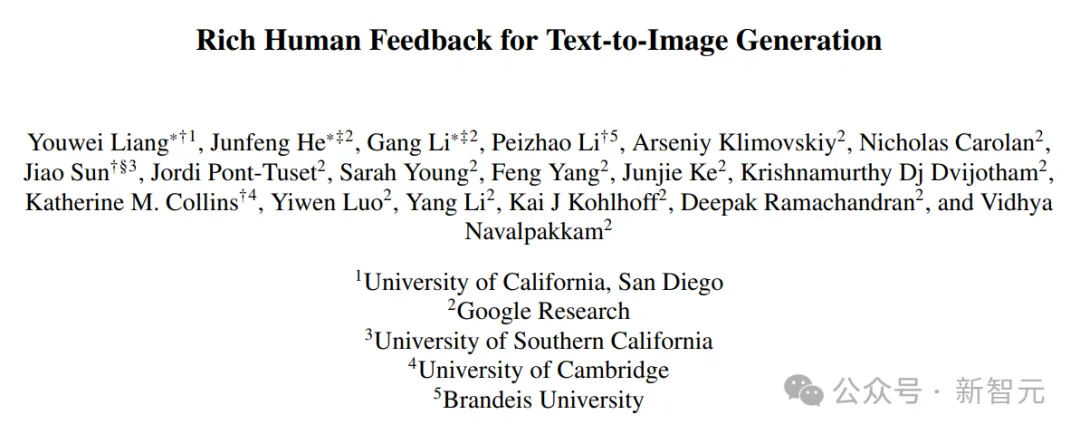

題目:Rich Human Feedback for Text-to-Image Generation

作者:Youwei Liang, Junfeng He, Gang Li, Peizhao Li, Arseniy Klimovskiy, Nicholas Carolan, Jiao Sun, Jordi Pont-Tuset, Sarah Young, Feng Yang, Junjie Ke, Krishnamurthy Dj Dvijotham, Katherine M. Collins, Yiwen Luo, Yang Li, Kai J. Kohlhoff, Deepak Ramachandran, Vidhya Navalpakkam

機構:,加利福尼亞大學圣地亞哥分校,谷歌研究院,南加利福尼亞大學,劍橋大學,布蘭迪斯大學

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Liang_Rich_Human_Feedback_for_Text-to-Image_Generation_CVPR_2024_paper.pdf

在這項工作中,作者提出了第一個詳盡的用于圖像生成的人類反饋數據集。具體來說,他們設計并訓練了一個多模態Transformer來預測這些詳盡的人類反饋,并展示了一些改進圖像生成的實例。

這篇論文的共同一作分別是華南農業大學校友Youwei Liang、清華校友Junfeng He、武大及港中文校友Gang Li。

榮譽提名

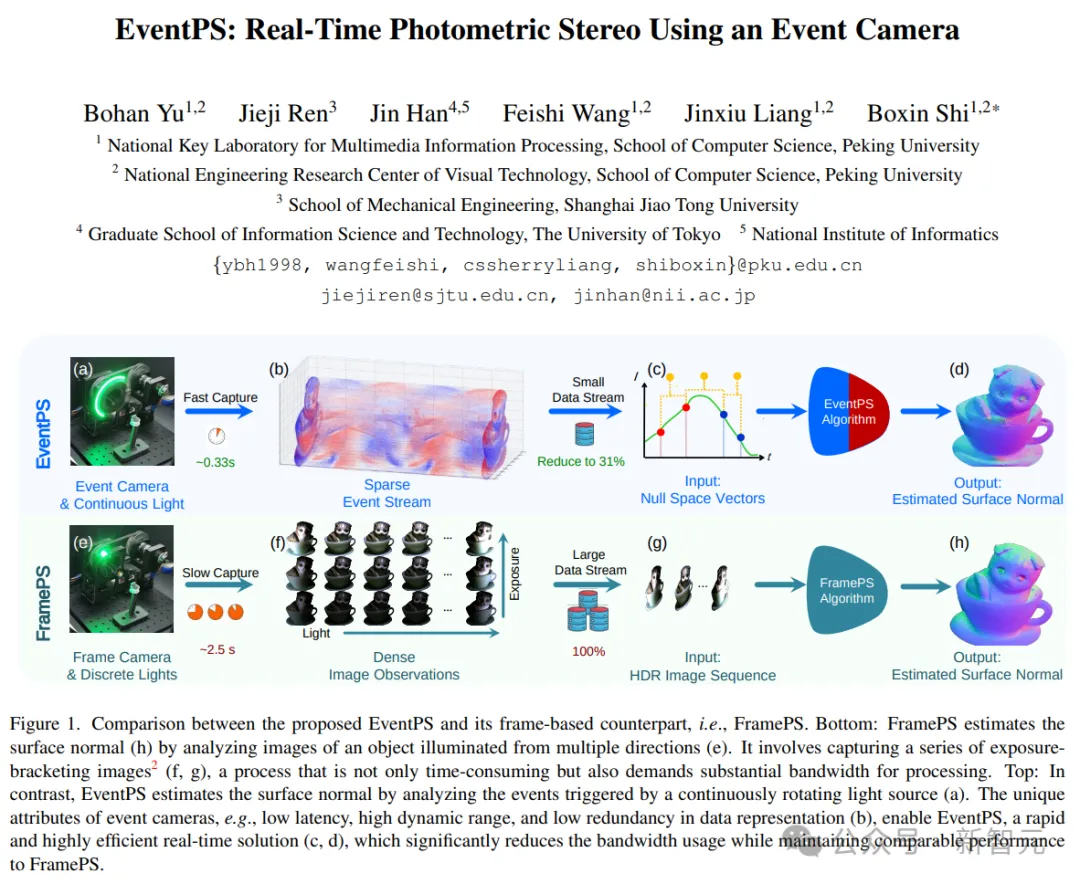

題目:EventPS: Real-Time Photometric Stereo Using an Event Camera

作者:Bohan Yu, Jieji Ren, Jin Han, Feishi Wang, Jinxiu Liang, Boxin Shi

機構:北京大學,上海交通大學,東京大學,國立情報學研究所

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Yu_EventPS_Real-Time_Photometric_Stereo_Using_an_Event_Camera_CVPR_2024_paper.pdf

題目:pixelSplat: 3D Gaussian Splats from Image Pairs for Scalable Generalizable 3D Reconstruction

作者:David Charatan, Sizhe Lester Li, Andrea Tagliasacchi, Vincent Sitzmann

機構:麻省理工學院,西門菲莎大學,多倫多大學

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Charatan_pixelSplat_3D_Gaussian_Splats_from_Image_Pairs_for_Scalable_Generalizable_CVPR_2024_paper.pdf

最佳學生論文

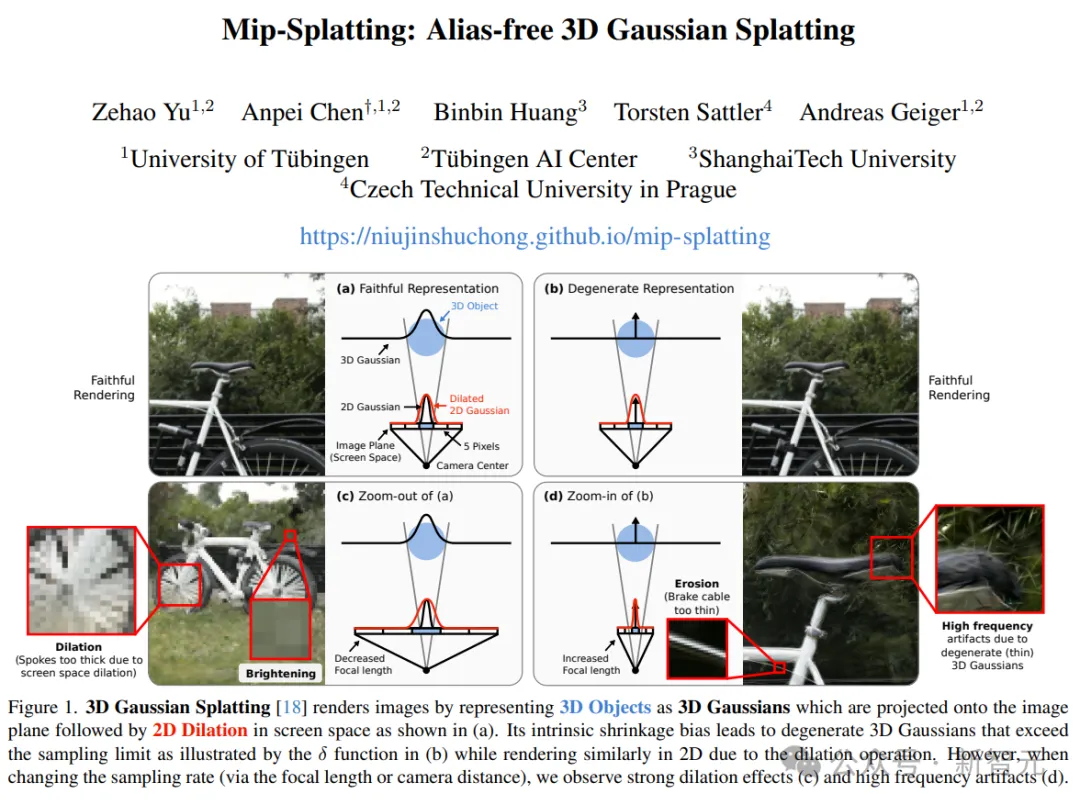

題目:Mip-Splatting: Alias-free 3D Gaussian Splatting

作者:Zehao Yu, Anpei Chen, Binbin Huang, Torsten Sattler, Andreas Geiger

機構:圖賓根大學,圖賓根AI中心,上海科技大學,捷克理工大學

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Yu_Mip-Splatting_Alias-free_3D_Gaussian_Splatting_CVPR_2024_paper.pdf

在這項工作中,作者提出了一種通過3D平滑濾波器和2D Mip濾波器改進3D高斯潑濺(3DGS)的全新方法Mip-Splatting,用于在任何尺度上進行無鋸齒渲染。該方法在分布外測試場景中顯著優于當前最先進的方法,當測試采樣率與訓練采樣率不同的時候,能夠更好地適應分布外的相機姿態和縮放因子。

值得一提的是,論文的三位一作Zehao Yu、Anpei Chen(陳安沛)、Binbin Huang,都是上海科技大學在讀或畢業生。

題目:BioCLIP: A Vision Foundation Model for the Tree of Life

作者:Samuel Stevens, Jiaman Wu, Matthew J. Thompson, Elizabeth G. Campolongo, Chan Hee Song, David Edward Carlyn, Li Dong, Wasila M. Dahdul, Charles Stewart, Tanya Berger-Wolf, Wei-Lun Chao, and Yu Su

機構:俄亥俄州立大學,微軟研究院,加利福尼亞大學爾灣分校,倫斯勒理工學院

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Stevens_BioCLIP_A_Vision_Foundation_Model_for_the_Tree_of_Life_CVPR_2024_paper.pdf

在這項工作中,作者提出了TREEOFLIFE-10M和BIOCLIP,分別是一個大規模多樣化的生物圖像數據集和一個用于生命之樹的基礎模型。研究表明,BIOCLIP是一個強大的細粒度生物分類器,在零樣本和少樣本設置中有著出色的表現。

榮譽提名

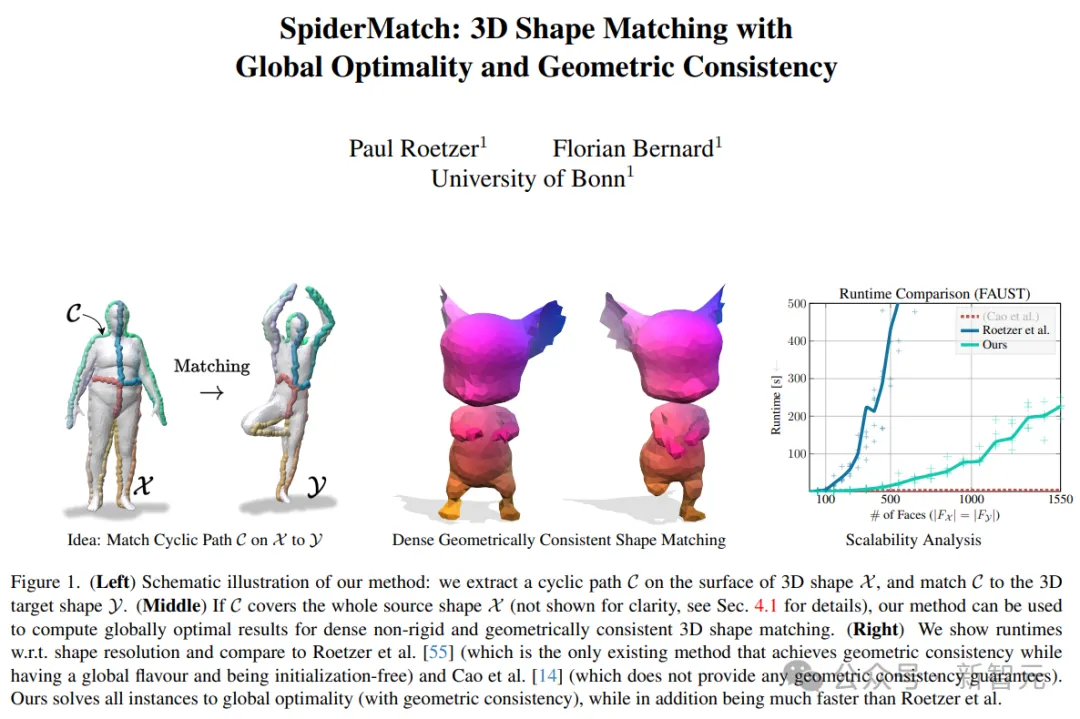

題目:SpiderMatch: 3D Shape Matching with Global Optimality and Geometric Consistency

作者:Paul Roetzer, Florian Bernard

機構:波恩大學

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Roetzer_SpiderMatch_3D_Shape_Matching_with_Global_Optimality_and_Geometric_Consistency_CVPR_2024_paper.pdf

題目:Image Processing GNN: Breaking Rigidity in Super-Resolution

作者:Yuchuan Tian, Hanting Chen, Chao Xu, Yunhe Wang

機構:北京大學,華為諾亞方舟實驗室

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Tian_Image_Processing_GNN_Breaking_Rigidity_in_Super-Resolution_CVPR_2024_paper.pdf

題目:Objects as Volumes: A Stochastic Geometry View of Opaque Solids

作者:Bailey Miller, Hanyu Chen, Alice Lai, Ioannis Gkioulekas

機構:卡內基梅隆大學

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Miller_Objects_as_Volumes_A_Stochastic_Geometry_View_of_Opaque_Solids_CVPR_2024_paper.pdf

題目:Comparing the Decision-Making Mechanisms by Transformers and CNNs via Explanation Methods

作者:Mingqi Jiang, Saeed Khorram, Li Fuxin

機構:俄勒岡州立大學

論文地址:https://openaccess.thecvf.com/content/CVPR2024/papers/Jiang_Comparing_the_Decision-Making_Mechanisms_by_Transformers_and_CNNs_via_Explanation_CVPR_2024_paper.pdf

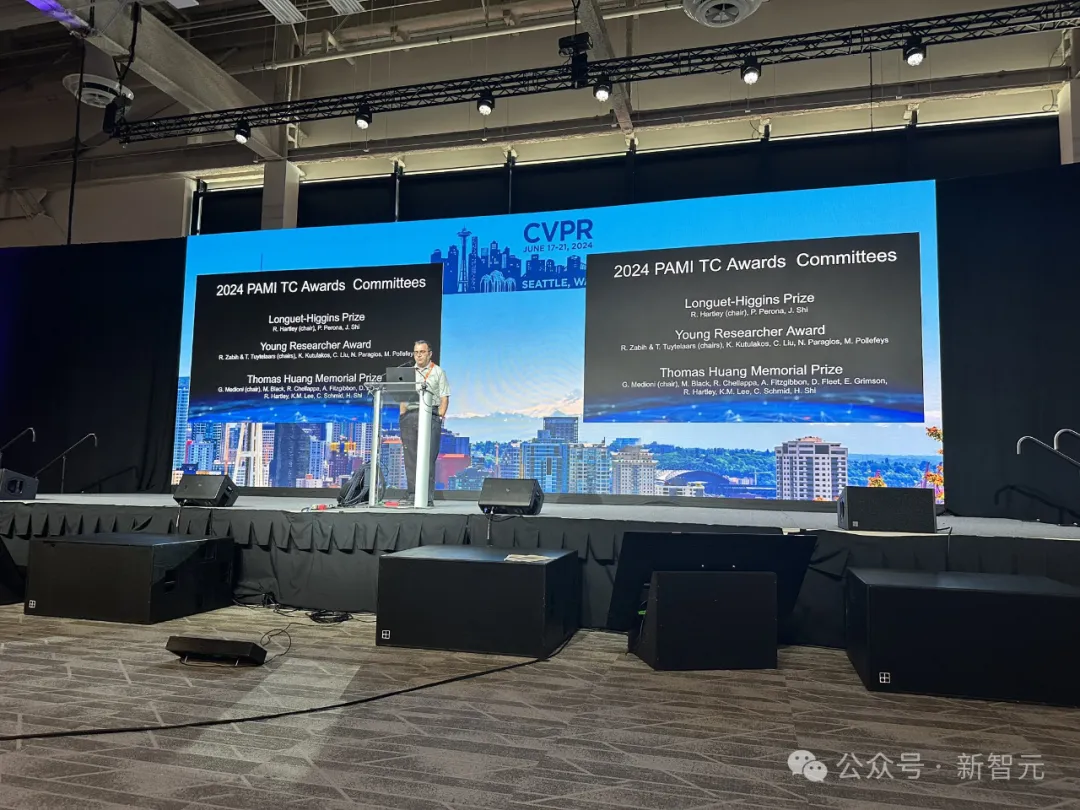

此外,CVPR的主辦方電氣和電子工程師學會計算機協會(IEEE Computer Society, CS),也正式宣布了模式分析和機器智能技術社區(TCPAMI)的獎項。

Longuet-Higgins獎

該獎項授予那些經得起時間檢驗的論文,2024年的Longuet-Higgins獎表彰了2014年在CVPR上發表的最具影響力的論文。

2024年獲獎者:Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation(2014)

作者:Ross Girshick, Jeff Donahue, Trevor Darrell, Jitendra Malik

機構:加利福尼亞大學伯克利分校,ICSI

論文地址:https://www.cv-foundation.org/openaccess/content_cvpr_2014/papers/Girshick_Rich_Feature_Hierarchies_2014_CVPR_paper.pdf

在這項工作中,作者通過(1)標記圖像中不合理或與文本不匹配的區域,以及(2)注釋文本提示中被誤表示或缺失的詞語,來豐富反饋信號。

具體來說,他們在1.8萬張生成圖像(RichHF-18K)上收集了豐富的人類反饋,并訓練了一個多模態Transformer來自動預測這些反饋。

實驗結果展示了預測的豐富人類反饋可以用于改進圖像生成,例如,通過選擇高質量的訓練數據來微調生成模型,或者通過創建帶有預測熱圖的掩碼來修補問題區域。

值得注意的是,這些改進不僅適用于生成反饋數據的模型(如Stable Diffusion變體),還可以推廣到其他模型上(如Muse)。

年輕研究員獎

該獎項表彰在獲得博士學位七年內對計算機視覺領域作出杰出研究貢獻的一到兩名研究人員。

2024年獲獎者:Angjoo Kanazawa, Carl Vondrick

Angjoo Kanazawa是加利福尼亞大學伯克利分校電氣工程與計算機科學系的助理教授,領導BAIR下的Kanazawa AI Research(KAIR)實驗室,并在Wonder Dynamics的顧問委員會任職。

此前,她在馬里蘭大學帕克分校完成了計算機科學博士學位,導師是David Jacobs。之后,來到UC伯克利的BAIR做博士后研究,導師是Jitendra Malik、Alexei A. Efros和Trevor Darrell。此外,還曾在Google Research擔任研究科學家。

眾所周知,我們生活在一個動態的3D世界中,人和動物不斷與環境互動。那么,我們該如何構建一個系統,從日常的照片和視頻中捕捉、感知并理解這個4D世界?又該如何從圖像和視頻的觀測中學習4D世界的先驗知識呢?

Angjoo Kanazawa的研究方向涵蓋了計算機視覺、計算機圖形學和機器學習,并致力于回答上面這些問題。

Carl Vondrick是哥倫比亞大學計算機科學系的教授,研究方向主要集中在計算機視覺、機器學習及其應用。

此前,他于2011年在加利福尼亞大學爾灣分校獲得學士學位,導師是Deva Ramanan。之后,于2017年在MIT獲得博士學位,導師是Antonio Torralba。此外,還曾在谷歌的機器感知團隊擔任研究科學家,并在Cruise擔任訪問研究員。

具體來說,他的研究通過訓練機器觀察和與環境互動,旨在創建穩健且多功能的感知模型。實驗室經常研究如何利用大量未標記數據進行任務和模態遷移。其他研究方向包括場景動態、聲音和語言、可解釋模型以及機器人感知等。

Thomas Huang紀念獎

該獎項于2020年設立,以紀念Thomas S. Huang,他是其時代計算機視覺、模式識別和人機交互領域的杰出人物。該獎項旨在表彰和致敬在計算機視覺社區中長期服務、研究和指導的杰出個人。

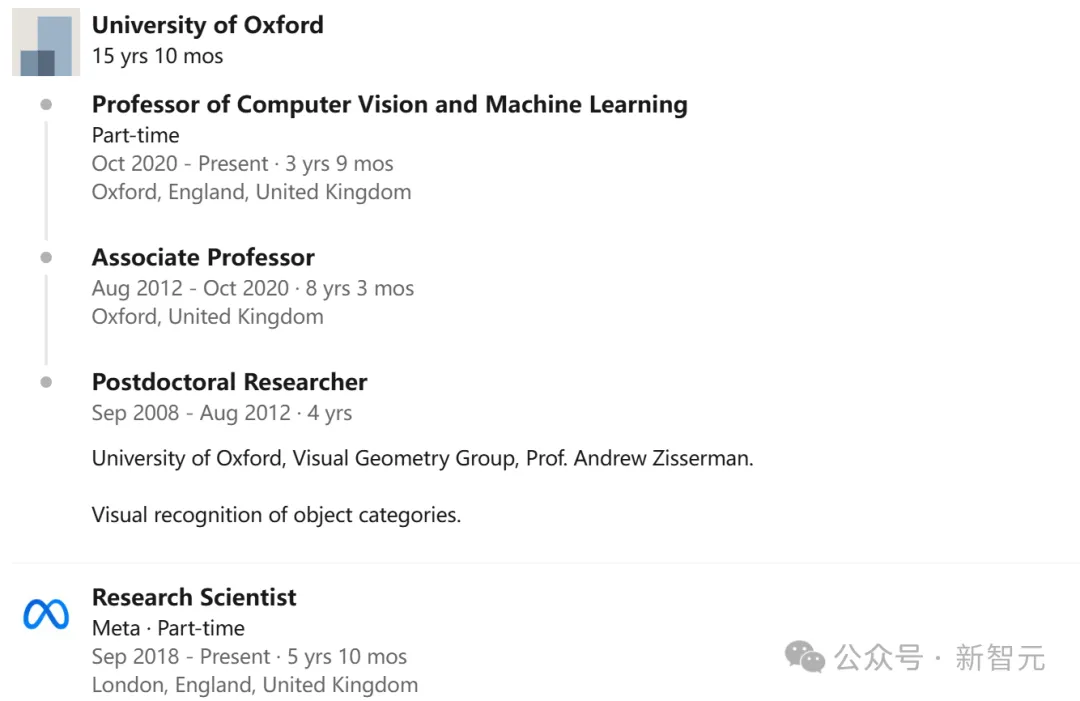

2024年獲獎者:Andrea Vedaldi

Andrea Vedaldi是牛津大學工程科學系計算機視覺和機器學習專業的教授,同時擔任VGG小組的聯合負責人。

他主要研究計算機視覺和機器學習方法,目標是自動理解圖像和視頻的內容,并且幾乎不需要人工監督,特別關注語義和3D幾何。

此前,他在帕多瓦大學獲得學士學位,并在加利福尼亞大學洛杉磯分校獲得碩士和博士學位。