超越擴散模型!自回歸新范式僅需2.9秒就生成高質量圖像,中科大哈工大度小滿出品

超越擴散模型!自回歸范式在圖像生成領域再次被驗證——

中科大、哈工大、度小滿等機構提出通用文生圖模型STAR。

僅需2.9秒就可生成高質量圖像,超越當前一眾包括SDXL在內(nèi)擴散模型的性能。

此外在生成圖像真實度、圖文一致性和人類偏好上均表現(xiàn)優(yōu)秀。

來看看具體是如何做到的?

自回歸通用文生圖模型STAR

擴散模由于其高質量和多元的生成,一度在文生圖領域占有主導地位。

它通過逐步的去噪過程,為圖像生成提供了更強的穩(wěn)定性和可控性,然而也導致生成過程極其耗時。

而自回歸模型的潛力,在受到大語言模型啟發(fā)下,開始在這一領域逐漸被探索。

比如VAR指出是因為自回歸模型逐個預測token的行為不符合圖像模態(tài)的特點,提出“next-scale prediction”范式,將視覺自回歸建模為逐個預測更大尺度scale的token map。這一方式避免了原始基于next-token的自回歸方案難以建模圖像模態(tài)的問題,重新為視覺生成定義了新的自回歸范式,從而使得生成的圖像具有更高的真實度,不過仍然有很多局限,性能仍落后于擴散模型。

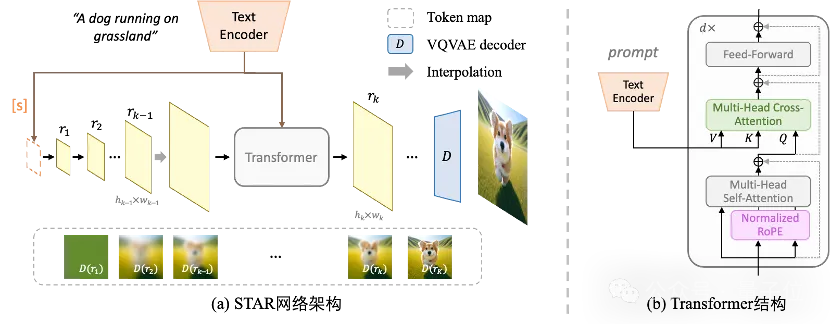

作者提出基于尺度的文生圖自回歸模型STAR,重新思考VAR中的“next-scale prediction”范式。

具體來說,所提出的STAR包括兩部分:

增強的文本引導和改進的位置編碼,以高效地實現(xiàn)高質量圖像生成。

增強的文本引導

為了更好地處理各種復雜的文本描述并生成相應的圖像,研究者提出幾項關鍵解決方案:

1、文本特征作為起始token map,根據(jù)起始token map生成更高分辨率的token map這不僅增強了模型對新文本場景的適應性,確保模型可以泛化到新的文本提示,從整體上保證了文本描述與生成圖像之間的一致性

2、在每個transformer層引入交叉注意力機制,從更精細的粒度控制圖像生成,使得生成的圖像更加精確地貼合文本。

具體網(wǎng)絡格式如下:

歸一化旋轉位置編碼(Normalized RoPE)

對于next-scale prediction范式,如何利用同一個transformer生成不同尺度的token map是一個重要的問題,隨之而來的是如何編碼這些token map中的tokens的位置。

傳統(tǒng)的正余弦編碼難以處理不同尺度的token map,同時編碼多個尺度容易導致尺度之間的混淆。

可學習的絕對位置編碼需要為每個尺度的token map學習對應的位置編碼,導致額外的學習參數(shù),提升了訓練難度,尤其是大尺度情況下的訓練變得更加困難;除此之外固定個數(shù)的位置編碼限制了更大分辨率圖像生成的可能。

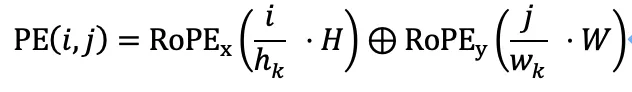

研究者提出二維的歸一化旋轉位置編碼(Normalized RoPE)

任意token間的相對位置被歸一化到統(tǒng)一的尺度,從而確保了對不同尺度的token map中的相對位置有統(tǒng)一的理解,避免對不同尺度位置同時編碼的混淆,更好地適配scale-prediction任務。

除此之外,這一新的位置編碼不需要額外的參數(shù),更易于訓練,為更高分辨率圖像生成提供了潛在的可能。

訓練策略

研究者選擇先在256*256圖像上以較大的batch size訓練生成,隨后在512*512圖像上微調,以獲得512的生成結果。由于歸一化位置編碼,模型很快收斂,僅需少量微調即可生成高質量512分辨率圖像。

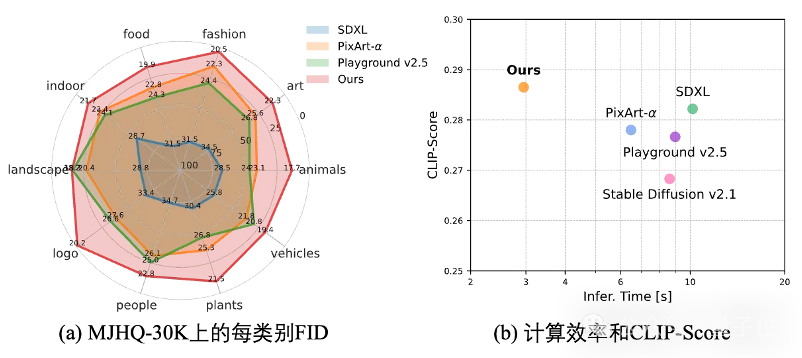

相比目前的方法,所提出的STAR在FID,CLIP score和ImageReward上表現(xiàn)優(yōu)異,體現(xiàn)了STAR良好的生成真實度,圖文一致性和人類偏好。除此之外,STAR生成一張512分辨率的高質量圖像僅需約2.9秒,相比現(xiàn)有的擴散文生圖模型具有顯著優(yōu)勢。

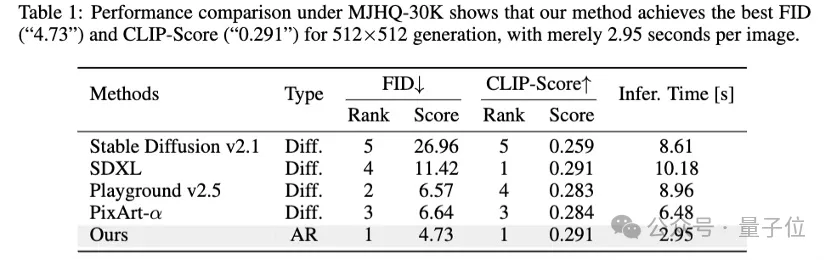

具體地,在MJHQ-30k上的FID達到4.73,超越了PixArt-α等模型;CLIP score達到0.291,與SDXL相當:

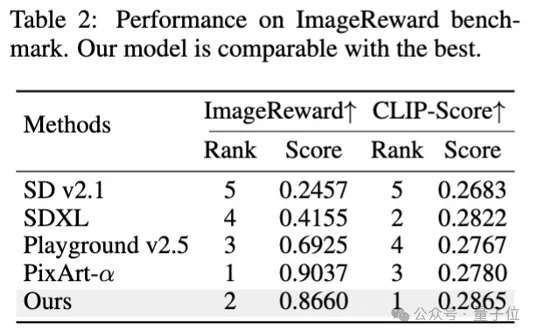

在ImageReward benchmark上,STAR達到了0.87的image reward,與領先的PixArt-α相當:

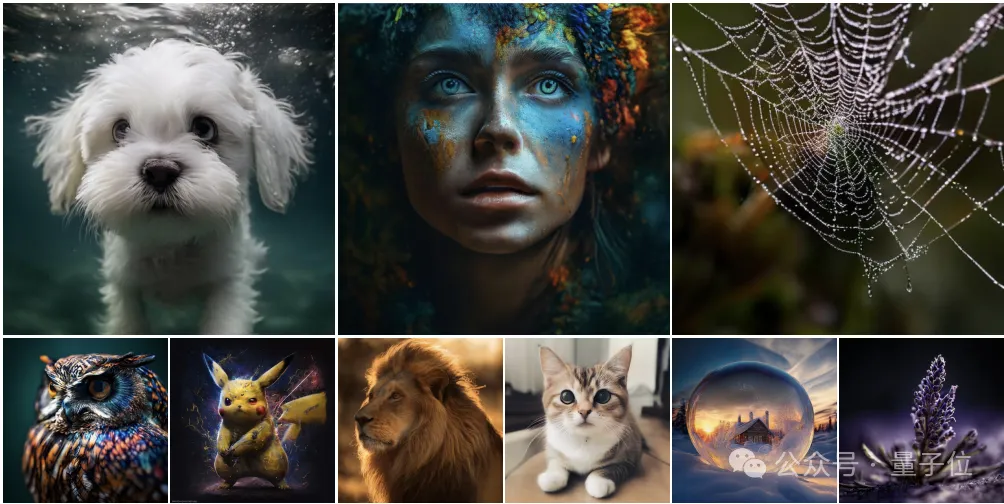

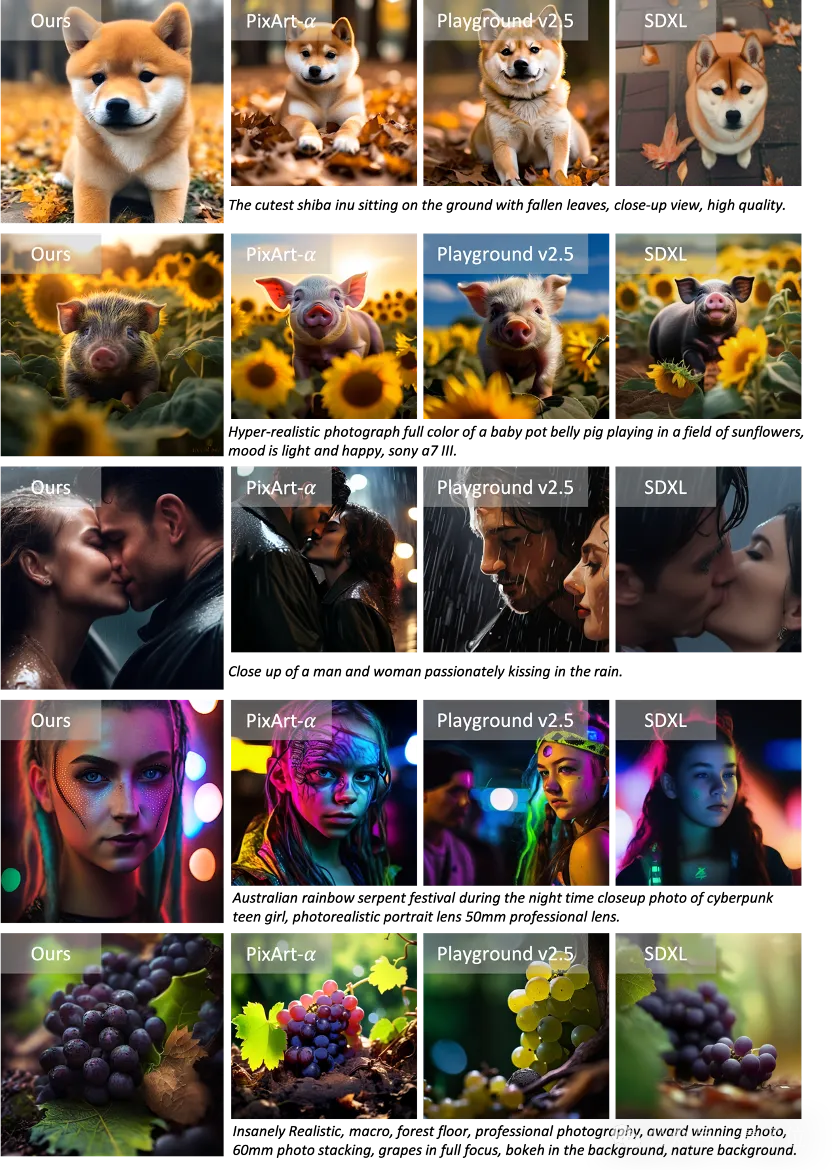

相比現(xiàn)有的方法,STAR可以生成多元的圖像類型。

在人物攝影、藝術繪畫、靜物、風景等場景下均能獲得很好的效果,生成的人臉、毛發(fā)、材質達到了令人驚嘆的細節(jié):

總的來說,STAR基于scale-wise自回歸的方式,解決了VAR中存在的引導條件有限、位置編碼不合理的問題,實現(xiàn)了更高效、性能更好的文本引導圖像生成。

廣泛的實驗證明,所提出的方法在生成圖像真實度、圖文一致性和人類偏好上均表現(xiàn)優(yōu)秀。僅需約2.9秒的時間內(nèi),在512分辨率圖像生成上,實現(xiàn)超越先進的文生圖擴散模型(PixArt-α、Playground、SDXL等)的性能。

基于自回歸的STAR為目前diffusion支配的文本控制圖像生成領域提供了新的可能。

項目網(wǎng)站:https://krennic999.github.io/STAR/

論文鏈接:https://arxiv.org/pdf/2406.10797