統一視覺理解與生成,MetaMorph模型問世,LeCun、謝賽寧、劉壯等參與

如今,多模態大模型(MLLM)已經在視覺理解領域取得了長足進步,其中視覺指令調整方法已被廣泛應用。該方法是具有數據和計算效率方面的優勢,其有效性表明大語言模型(LLM)擁有了大量固有的視覺知識,使得它們能夠在指令調整過程中有效地學習和發展視覺理解。

在 Meta 和紐約大學合作的一篇論文中,研究者探究了 LLM 是否也可以通過微調來生成具有同等效率和有效性的視覺信息?論文作者中包括了 AI 領域的幾位知名學者,包括圖靈獎得主 Yann LeCun、紐約大學計算機科學助理教授謝賽寧、FAIR 研究科學家劉壯(將于明年 9 月加盟普林斯頓大學,擔任計算機科學系助理教授)。

- 論文標題:MetaMorph: Multimodal Understanding and Generation via Instruction Tuning

- 論文地址:https://arxiv.org/pdf/2412.14164v1

- 項目地址:https://tsb0601.github.io/metamorph/

作者之一 Peter Tong 表示:「這個項目確實改變了我對多模態模型和 LLM 的看法。我過去認為多模態(視覺)預測需要對模型進行重大更改和大量預訓練,例如 Chameleon。但令人驚訝的是,事實恰恰相反!在大型自回歸模型中,視覺理解和生成緊密相關,可以直接從 LLM 進行指令調整。」

當前,人們試圖建立「統一」的模型,能夠同時進行多模態理解和生成,這就通常將視覺生成視為與視覺理解正交的功能。這些模型往往需要對原始 MLLM 架構進行大量更改,并進行大量多模態預訓練和 / 或微調。設計此類方法具有挑戰性,以往研究采用了不同的方法,包括將視覺輸入 tokenizing 為離散的 token、融入擴散目標以及將視覺解耦為單獨的理解和生成模式。例如,LWM、Show-o 和 Chameleon 等方法需要數十億個圖文對以進行廣泛的預訓練和微調。

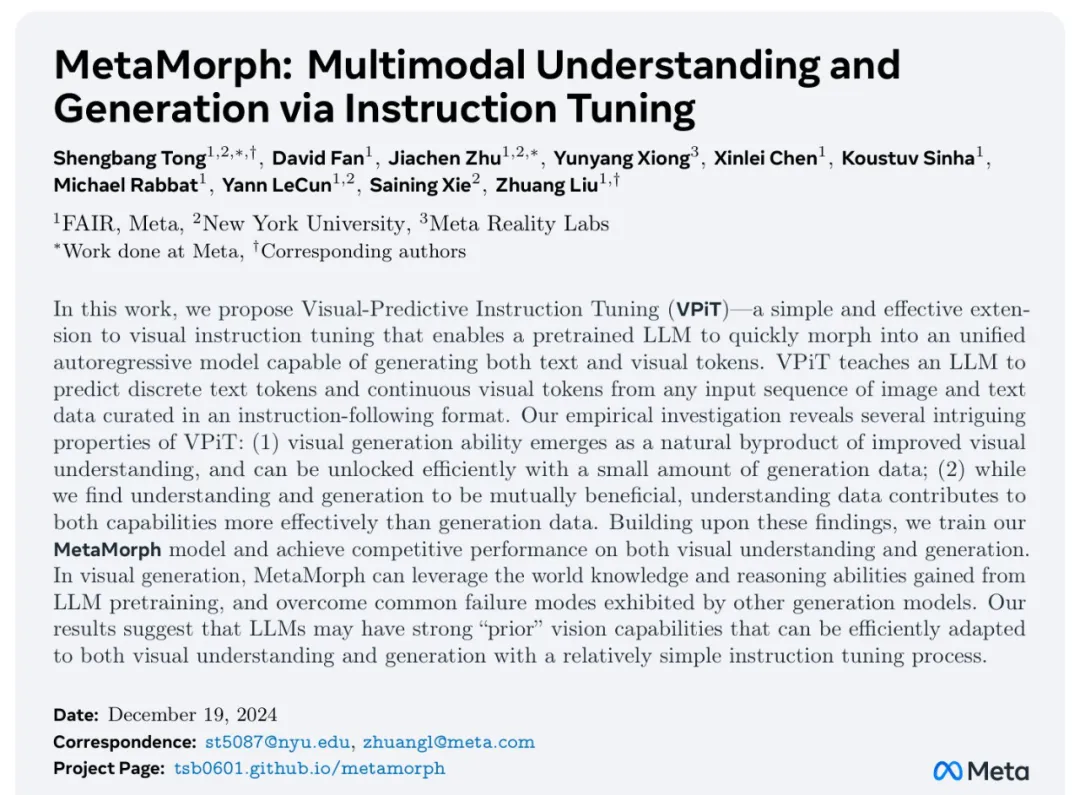

在本文中,研究者提出了視覺預測指令調整(Visual-Predictive Instruction Tuning,VPiT),它是視覺指令調整的簡單擴展,建立在將連續視覺 token 作為輸入傳遞給 LLM 的現有范式之上。VPiT 訓練 LLM 以在微調階段輸出連續視覺 token 和離散文本 token。該模型以預訓練的視覺編碼器嵌入以及文本 token 作為輸入,并輸出文本 token 和連續視覺 token 的組合。

為了可視化生成的視覺 token,研究者還微調了一個擴散模型,將嵌入映射回像素空間(參見下圖 1 中的示例)。這個框架使得能夠研究視覺理解、視覺生成和預訓練 LLM 之間的協同作用,從而得出以下幾個有趣的發現。

首先,研究者表明,預測視覺 token 的能力源于對視覺輸入的理解,并且只需要極少的額外訓練。與視覺指令調整類似,VPiT 可以高效地將 LLM 轉變為一個可以理解和生成多模態 token 的「統一」模型。當使用足夠的視覺理解數據進行聯合訓練時,此過程只需要 200k 額外的視覺生成數據。

研究者進一步確定,理解和生成視覺 token 的能力具有內在聯系且不對稱。具體來講,增加理解數據可以提高視覺理解(更高的 VQA 分數)和生成性能(更低的 FID 分數)。相反,增加生成數據可以提高生成質量,也有助于增強視覺理解,但程度較小。重要的是,研究結果強調了每種能力的訓練對模型整體視覺性能具有不對稱的影響:在提高視覺理解和生成方面,以理解為中心的訓練大大優于以生成為中心的訓練。

基于這些發現,研究者訓練了一個名為 MetaMorph 的統一模型,使用 VPiT 預測多模態 token。他們利用各種數據源,從常見的視覺問答數據集到無文本注釋的純圖像和視頻數據。結果顯示,MetaMorph 在視覺理解和視覺生成基準上都取得了有競爭力的表現。

此外,研究者展示了這種統一的建模方法允許模型利用 LLM 的強大功能,比如 MetaMorph 可以在生成視覺 token 從預訓練的 LLM 中提取知識。更令人驚訝的是,他們還觀察到 MetaMorph 可以在生成視覺 token 之前隱式地執行推理步驟。比如當輸入提示詞「帝王斑蝶幼蟲轉變形態后的動物」,MetaMorph 成功生成了一張蝴蝶的圖像(圖 1 右)。

本文的結果表明了以下兩點見解,為混合模態模型的開發提供了啟發。

- 使用指令調整來訓練統一模型是可行的。

- LLM 具有強大的預先存在的視覺功能,與廣泛的預訓練相比,這些功能可以使用少得多的樣本來激活。

視覺預測指令調整(VPiT)

VPiT 是一種簡單的設計,它擴展了現有的指令調整方法,以額外生成視覺 token,而不僅僅是文本。研究者使用相同的架構和 next-token 預測范式來解鎖視覺生成功能,而無需花哨的東西。他們采用預訓練的 LLM 并對其進行微調以預測離散文本 token 和連續視覺 token。這些視覺 token 可以使用經過調整的擴散模型來可視化。

從單模態到多模態 next-token 預測

模型架構。研究者采用預訓練 LLM,并對其進行微調,以處理任意的文本和視覺 token 序列。他們保留原始的 LLM 頭(head)用于文本預測,并將單獨的視覺頭附加到 LLM 以預測視覺 token,即視覺編碼器在處理圖像時生成的輸出 token。視覺頭是一個映射層,從 LLM 的維數映射到視覺編碼器的維數。然后以提示詞 token 作為上下文,對所有響應 token 進行自回歸訓練和預測。

與傳統的視覺指令調整不同,在 VPiT 中,視覺 token 也是 LLM 的輸出,而不僅僅是輸入。為了讓 LLM 意識到視覺 token 的存在,研究者引入特殊 token( ?image_start? 和 ?image_end? )來指示視覺 token 序列的邊界以及何時使用視覺頭。

損失函數。語言頭輸出詞匯表的概率分布,并使用交叉熵損失進行訓練以進行下一個 token 預測。視覺預測使用了「 LLM 預測的視覺 token 與視覺編碼器的視覺 token 之間」的余弦相似性損失。與指令調整實踐一致,該模型僅對響應 token 進行預測并產生損失。

使用多種類型的數據

由于 VPiT 使模型能夠預測其響應中的文本和視覺 token,因此它允許使用更廣泛的訓練數據。另一方面,傳統的視覺指令調整主要依賴于問答對。本文的大部分數據集都是公開的,研究者將它們分為以下三個主要類別:

- 視覺理解數據:包括以圖像或視頻作為輸入并輸出文本響應的數據。

- 視覺生成數據:MetaCLIP 數據,根據圖像描述預測視覺 token。研究者最多使用 500 萬對,并將數據整理成問答格式。

- 其他視覺數據:包括需要模型根據「交錯輸入的視覺 token 和文本 token」來預測視覺 token 的數據。

利用擴散將 token 映射到圖像

由于使用 VPiT 訓練的模型學習預測連續的視覺 token,因此需要將預測的 token 映射回像素空間。研究者利用了「擴散自編碼器」的概念,其中擴散模型可以適應圖像嵌入而不是文本嵌入的條件。具體地,他們使用 held-out 訓練數據微調現有的擴散模型以適應視覺編碼器的輸出。

在推理時,如果生成了標簽 token ?image_start?,則模型開始輸出視覺 token,直到 ?image_end?。然后將生成的視覺 token 插入擴散模型以在像素空間中可視化預測。研究者使用了標準的潛在擴散模型訓練流程。

解鎖視覺生成的發現

在 VPiT 框架下,研究者探究了有關視覺理解與生成影響與協同作用的問題:

- 視覺生成可以通過輕量級調整來解鎖嗎?還是需要大量數據?視覺理解和生成是互惠互利還是相互對立?

- 更多的視覺理解或生成數據對理解和生成質量的貢獻有多大?

- 哪些視覺理解任務與生成性能最相關?

在評估時,研究者使用了 9 個 ImageQA 基準來評估模型的不同方面,包括 MMBench、Seed、VStar、MMVP、MMMU、ChartQA、TextVQA、ScienceQA、RealWorldQA。

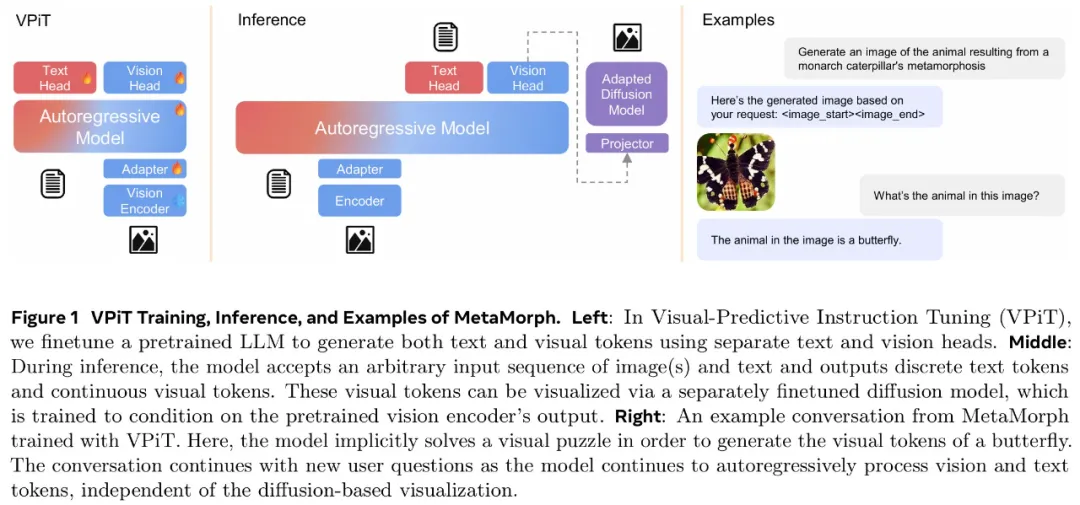

通過視覺理解聯合訓練可以高效解鎖視覺生成能力

研究者首先調研了教(teach)語言模型生成高質量視覺 token 所需的圖文樣本數量。為此,他們從生成數據(MetaCLIP 數據集)中隨機抽取 {1k、5k、10k、50k、200k、1M、3M、5M} 個圖文對。同時探索了兩種設置:1 僅使用視覺生成數據對 LLM 進行微調,2)使用視覺理解和其他類型的數據來聯合訓練視覺生成。

在下圖 2 中,研究者發現僅對視覺生成進行訓練的表現明顯差于使用所有其他數據的聯合訓練。在超過 300 萬個圖文對的情況下,模型很難生成高質量的視覺圖像(~40 FID 分數),并且性能仍然不如使用 500 萬個圖文對進行聯合訓練的情況。這表明僅對視覺生成數據進行訓練的樣本效率明顯較低。

相比之下,與其他數據集聯合訓練可以顯著提高生成性能。模型僅使用 5k 生成數據即可生成有效的視覺 token,性能在 200k 樣本左右可以保持穩定。這表明視覺生成不是一種正交能力,而是一種受益于其他任務并在聯合訓練中更有效出現的能力。

為了更好地理解每種類型的數據如何有助于視覺生成,研究者使用 200k 視覺生成數據進行了一項可控實驗,使用前文展示的每種類型數據進行單獨聯合訓練。他們還將單獨訓練與一起訓練所有數據進行了比較。下圖 3 中展示了結果。

結果表明,雖然所有數據類型都增強了模型視覺生成能力,但改進程度各不相同。即使生成數據量保持在 200k 不變,ImageQA 和 VideoQA 等視覺理解數據也能顯著提升模型視覺生成能力。這表明理解視覺內容的能力與生成視覺 token 之間存在很強的聯系。此外,在訓練中結合所有數據類型可以進一步提高性能,這表明不同數據類型帶來的好處可以疊加。

發現 1:當模型與視覺理解數據聯合訓練時,與僅在生成數據上進行訓練相比,可以使用明顯更少的生成數據來解鎖生成視覺 token 的能力。

視覺理解與生成互惠互利

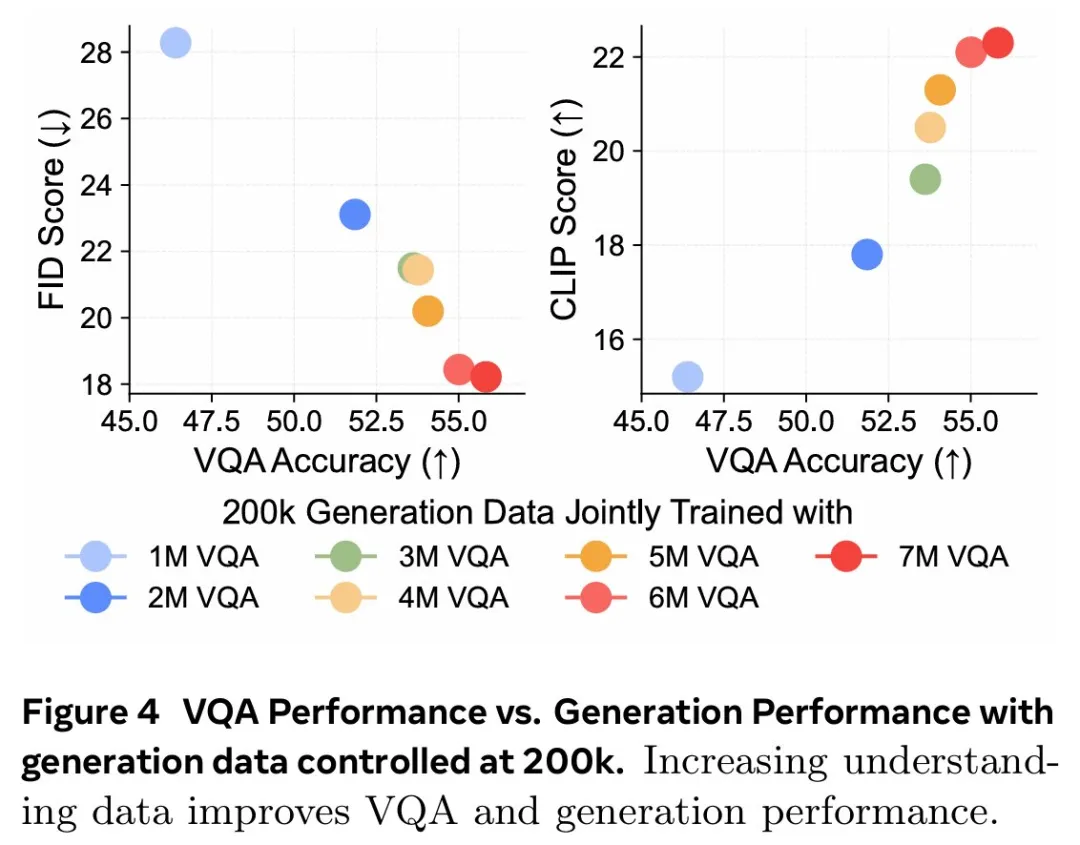

更多的理解數據可以帶來更好的理解和生成性能。基于上文發現,研究者進行了一項對照實驗,以研究視覺理解能力與視覺生成能力之間的關系。他們使用一組固定的 200k 生成數據來進行模型消融,同時利用 Cambrian-7M 的 1M 到 7M 樣本的 VQA 數據變化來開發不同級別的視覺理解。下圖 4 中顯示的結果表明,更強的 VQA 能力與更好的生成性能具有相關性。

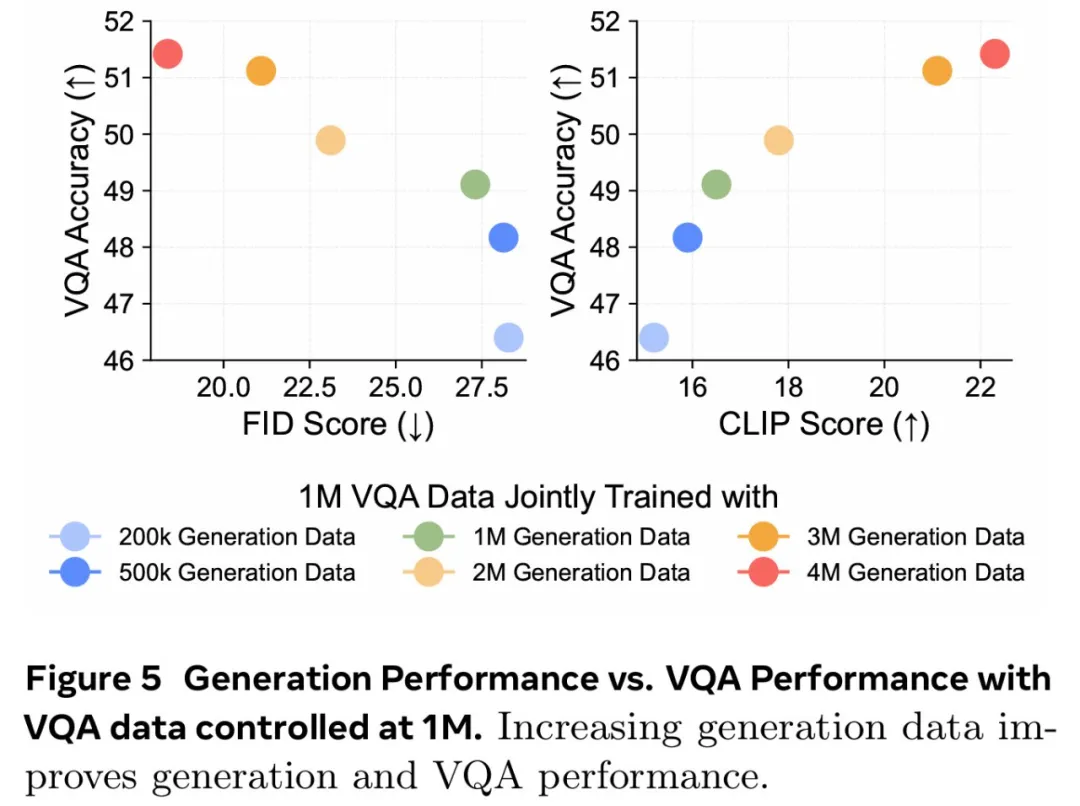

更多的生成數據同樣可以帶來更好的理解和生成性能。研究者探索了視覺生成能力的提高是否也與更高的 VQA 性能有關,為此他們使用固定的 1M VQA 樣本作為理解基線進行了一項對照實驗。然后改變生成數據的數量({200k、500k、1M、2M、3M、4M})以調整生成能力,同時與固定的 1M VQA 數據進行聯合訓練。下圖 5 的結果顯示,在 1M VQA 設置中,更強的生成能力與 VQA 性能的提升相關。這意味著增加生成數據量不僅可以增強生成能力,而且還會對 VQA 性能產生積極影響。

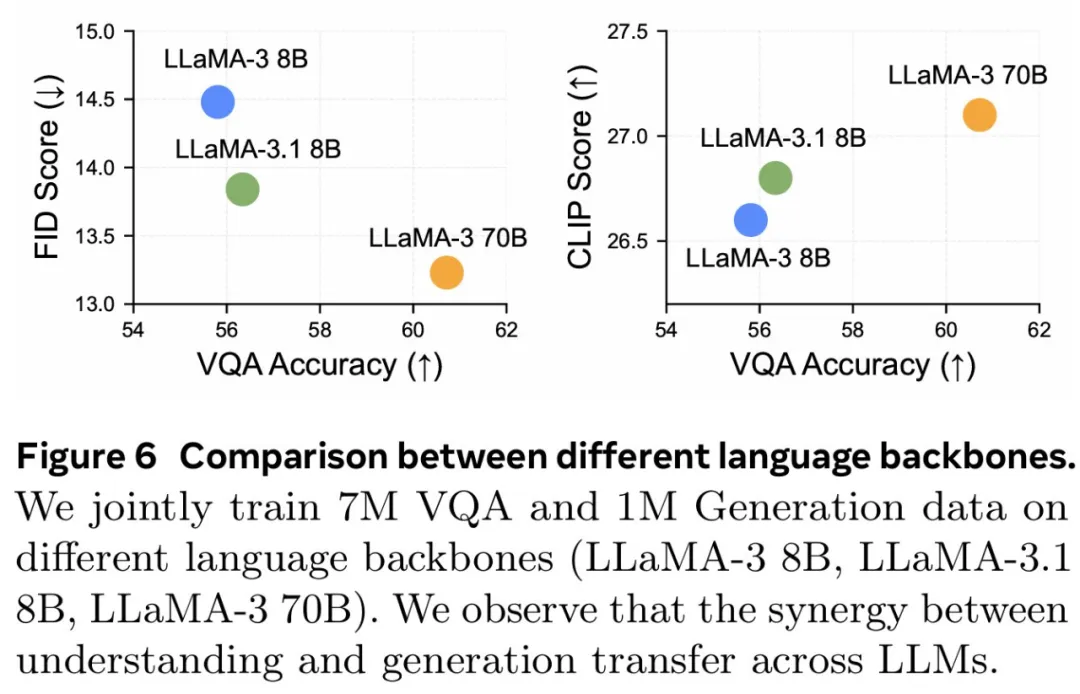

這種協同作用可以擴展到不同的 LLM。研究者探究研究結果是否可以遷移到不同的 LLM 主干。通過使用 7M VQA 樣本和 1M 生成數據的組合,他們在 LLaMA-3 8B、LLaMA-3.1 8B 和 LLaMA-3 70B 上訓練 VPiT。下圖 6 顯示了不同 LLM 之間的擴展行為。

發現 2:視覺理解和視覺生成相輔相成,增加任意一項任務的數據都會同時增強兩者的性能。

理解數據可以實現更多增益

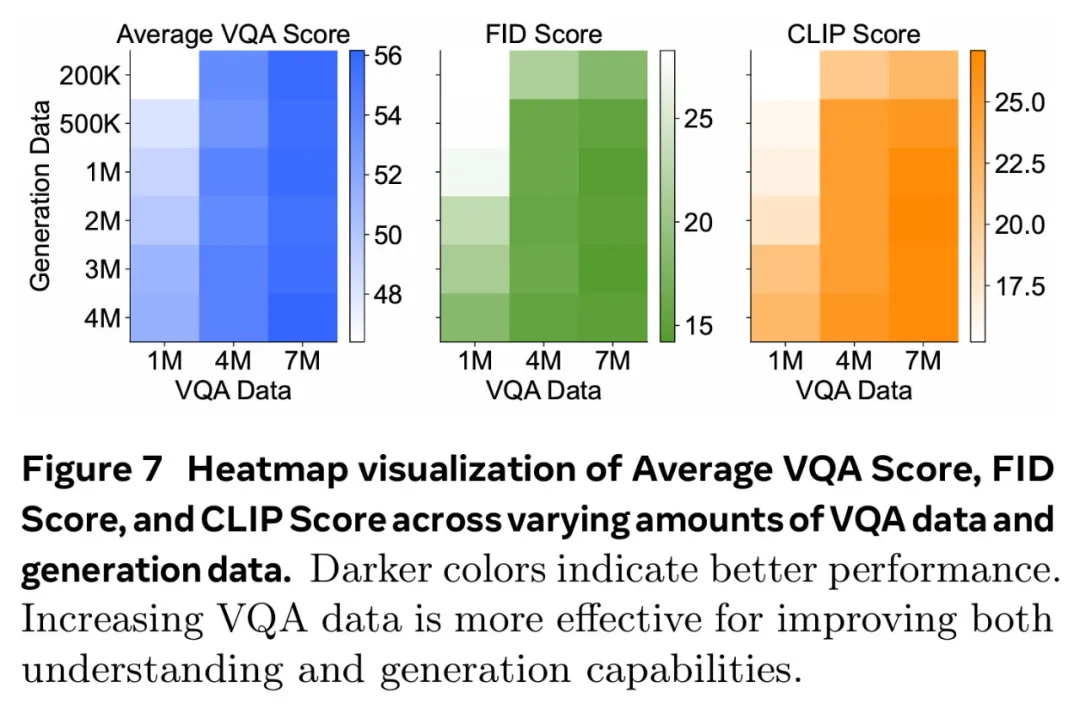

研究者調研了理解與生成數據是否同等重要,他們聯合訓練了不同規模的 VQA 數據(f1M、4M、7M)和生成數據(200k、500k、1M、2M、3M、4M)。下圖 7 總結了這些發現,其中 x 軸表示 VQA 數據,y 軸表示生成數據。結果通過熱圖可視化,其中較深的顏色代表更好的性能。

結果表明,增加 VQA 數據可以在所有三個指標中產生最顯著的改進。當 VQA 數據較低(1M)時,隨著 VQA 數據的擴大(從 1M 到 4M 再到 7M),生成數據的增加會帶來顯著的改進。不過,VQA 數據的影響更加明顯,熱圖中急劇的顏色過渡證明了這一點。最終,對于 7M VQA 數據,生成數據的增加貢獻很小。這些結果證明了理解數據在增強理解和生成性能方面具有關鍵作用。

發現 3:雖然增加數據可以提升整體性能,但視覺理解數據的影響明顯高于視覺生成數據的影響。

某些理解任務與生成性能更相關

鑒于 OCR、以視覺為中心的任務和基于知識的任務等理解任務的多樣性,論文研究了哪些任務與生成能力的相關性最強。受 Cambrian-1 的啟發,研究者將 VQA 任務分為五組:一般、文本和圖表、高分辨率、知識和以視覺為中心的 VQA。研究者利用早先的實驗結果,用不同數量的生成數據聯合訓練各種 VQA 數據規模,并在圖 8 中繪制了每個基準的 VQA 性能與生成性能的對比圖。他們還計算了 VQA 分數與 FID/CLIP 分數之間的皮爾遜相關性 (ρ)。

圖 8 顯示,通用、視覺中心和文本與圖表 VQA 任務與生成性能密切相關,每個任務的皮爾遜相關系數(p)都高于 0.85。高分辨率 VQA 表現出中等程度的相關性,p 約為 0.7。相比之下,知識 VQA 任務(如 MMMU)的相關性較弱,這表明生成能力與生成性能的相關性更為密切。這與模型的視覺能力有關,而與知識特定任務無關。

發現 4:通用、視覺中心和文本理解的 VQA 任務與視覺生成有很強的相關性,而基于知識的 VQA 任務則沒有。

MetaMorph 模型

理解和生成表現

研究者將 MetaMorph 與其他統一模型進行了比較,并在表 1 中總結了結果。

MetaMorph 利用 LLM 知識進行視覺生成

MetaMorph 能有效利用預訓練的 LLM 中蘊含的世界知識,圖 9 左側展示了一些例子。研究者去提示模型生成需要非難和專業化知識的概念,例子包括 Chhogori(世界第二高峰)、Oncilla(南美洲的一種小野貓)和 Chizarira(津巴布韋一個與世隔絕的荒野地區)。

MetaMorph 成功地將特定領域的知識轉化為準確的視覺 token,從而展示了從 LLM 中利用世界知識的能力。與此相反,最新的文本到圖像(T2I)模型 StableDiffusion-3.5 8B,盡管生成了高質量的圖像,卻很難生成正確的概念。這個問題可能源于它所使用的文本嵌入模型 CLIP 和 T5,它們未能正確編碼這些專業術語。

圖 9 右側展示了 MetaMorph 如何比 CLIP 和 T5 等文本嵌入模型更有效地處理常見的語義難題。這些挑戰包括否定和主觀性,MetaMorph 使用了在 Multimon 中識別出的常見失敗模式的提示來區分語義的細微差別,如「稍微」與「非常」、「少數」與「許多」、「沒有」與「有」,這些都是現有文本到圖像系統中常見的失敗。

多模態生成推理

圖 10 中,研究者展示了模型根據謎題提示生成圖像的例子,例如「國家公園位于」。在每道謎題中,都直接使用了「黃石公園所在國家的國家公園」這一提示語,而沒有使用任何思維鏈(CoT)提示語「生成謎題圖片」。MetaMorph 可以從需要多步推理的提示中生成正確的圖像。

例如,在回答「一種樂器,這種樂器通常由 theity 演奏」這一問題時,該模型需要隱式地完成三個推理科學家是誰提出了狹義相對論的步驟:識別出愛因斯坦是提出狹義相對論的科學家;識別出愛因斯坦的首選樂器是小提琴,并直接生成正確的視覺 token;然后完成推理過程。這一結果意味著,MetaMorph 在緊接著提示的生成過程中,隱式地明確分離了這些步驟。這些結果解決了謎題,并生成了正確的視覺 token,與《LLMs 物理學》的研究結果一致,作者認為 LLM 可以生成后續 token。在這里,研究者展示了在自回歸之前預先計算推理圖的能力,即使在解碼視覺 token 時,這種能力也能轉移到統一多模態模型設置中。

更多技術細節請參閱原論文。