Mistral AI兩連發(fā):7B數(shù)學(xué)推理專用、Mamba2架構(gòu)代碼大模型

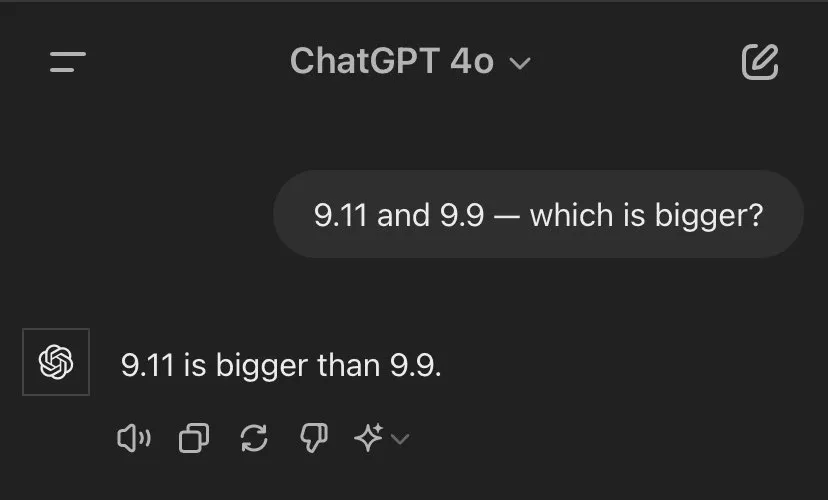

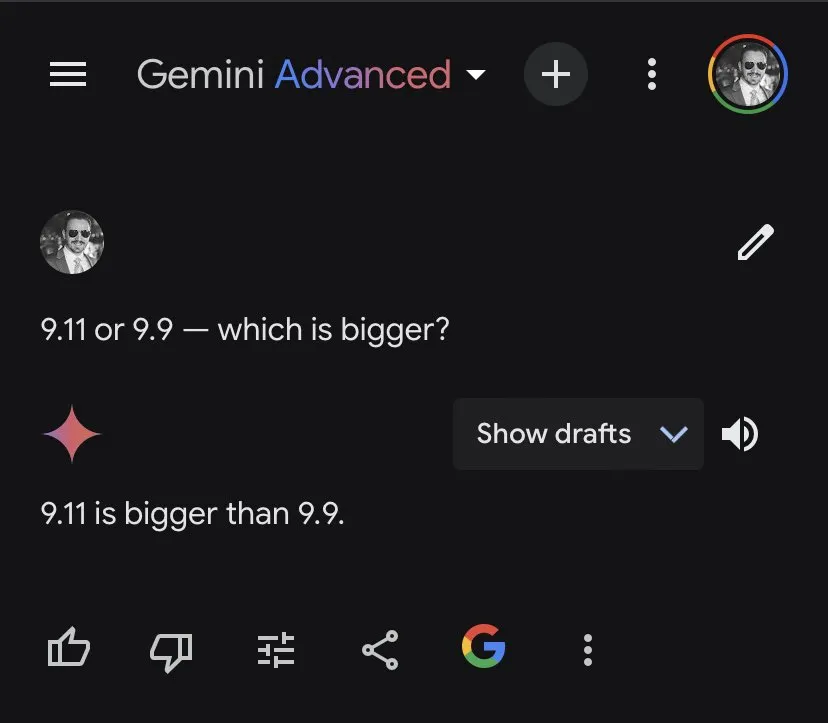

昨天,AI圈竟然被「9.11和9.9誰大」這樣簡單的問題攻陷了,包括OpenAI GPT-4o、Google Gemini等在內(nèi)的大語言模型都翻了車。

這讓我們看到,大語言模型在處理一些數(shù)字問題時并不能像人類那樣理解并給出正確的答案。

對于數(shù)字以及復(fù)雜的數(shù)學(xué)問題,專用模型更術(shù)業(yè)有專攻。

今天,法國大模型獨角獸 Mistral AI 發(fā)布了一個專注于數(shù)學(xué)推理和科學(xué)發(fā)現(xiàn)的7B大模型「Mathstral」,來解決需要復(fù)雜、多步驟邏輯推理的高級數(shù)學(xué)問題。

該模型基于 Mistral 7B 構(gòu)建,支持的上下文窗口長度為32k,遵循的開源協(xié)議為Apache 2.0 license。

Mathstral在構(gòu)建時追求出色的性能與速度權(quán)衡,這是 Mistral AI積極推廣的一種開發(fā)理念,尤其是微調(diào)功能。

同時,Mathstral是一個指令型模型,可以使用它或者對它進行微調(diào)。模型權(quán)重已經(jīng)放在了HuggingFace上。

- 模型權(quán)重:https://huggingface.co/mistralai/mathstral-7B-v0.1

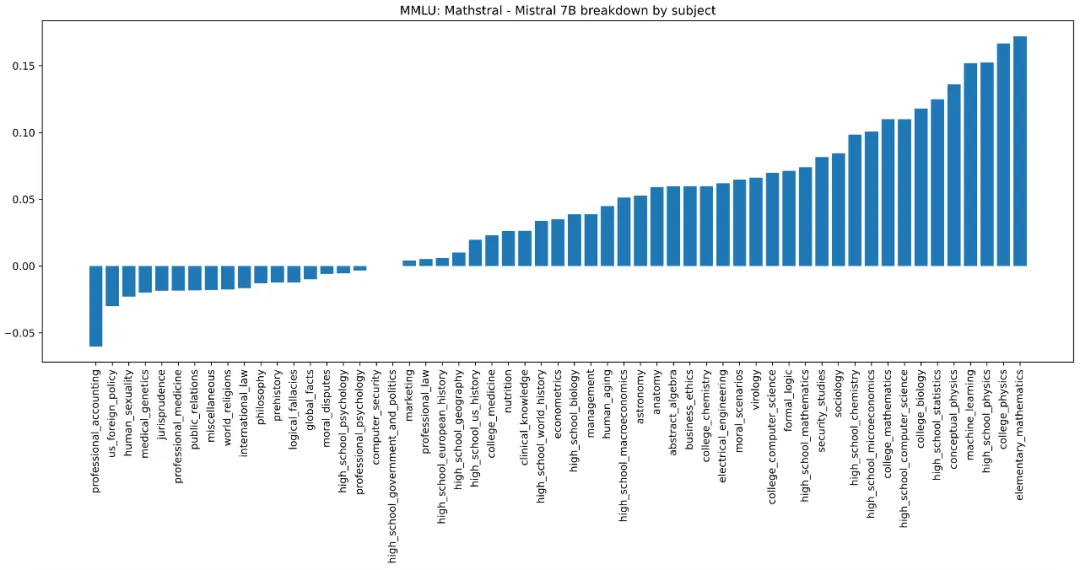

下圖為 Mathstral 7B和Mistral 7B之間的MMLU性能差異(按學(xué)科劃分)。

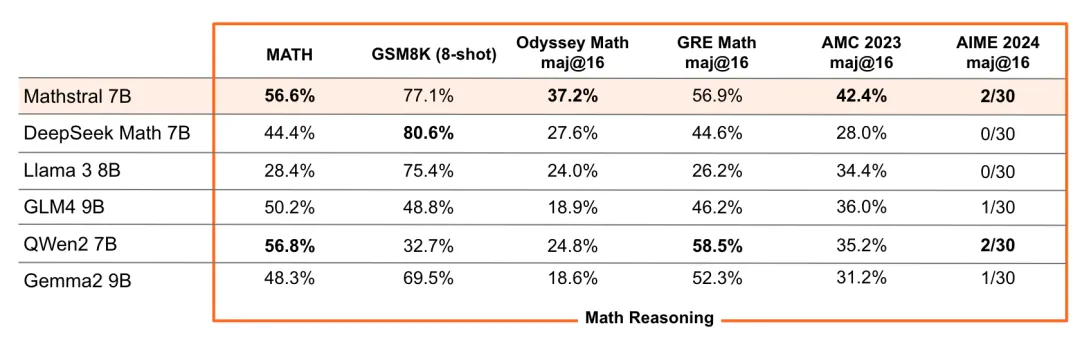

Mathstral在各種行業(yè)標(biāo)準(zhǔn)基準(zhǔn)上都達到其規(guī)模范圍內(nèi)的 SOTA 推理性能。尤其是在MATH數(shù)據(jù)集上,它取得了 56.6%的通過率,在MMLU上取得了63.47%的通過率。

同時,Mathstral在MATH上的通過率(56.6%)比 Minerva 540B 高出 20% 以上。此外,Mathstral 在MATH 上以多數(shù)投票@64的成績得分為68.4%,使用獎勵模型的成績?yōu)?74.6%。

這一成績也讓網(wǎng)友好奇,Mathstral能不能搞定「9.11和9.9誰大」這一問題。

代碼大模型:Codestral Mamba

- 模型權(quán)重:https://huggingface.co/mistralai/mamba-codestral-7B-v0.1

與Mathstral 7B一同發(fā)布的,還有一款專門用于代碼生成的Codestral Mamba模型,使用的是Mamba2架構(gòu),同樣遵循Apache 2.0 license開源協(xié)議。這是一個指導(dǎo)模型,有70多億參數(shù),研究者可以免費使用、修改和分發(fā)。

值得一提的是,Codestral Mamba是在Mamba作者Albert Gu、Tri Dao幫助下設(shè)計完成的。

一直以來,Transformer 架構(gòu)撐起了AI領(lǐng)域的半壁江山,然而,與 Transformer 不同的是,Mamba 模型具有線性時間推理優(yōu)勢,并且理論上能夠?qū)o限長度的序列進行建模。該架構(gòu)允許用戶廣泛地與模型互動,并且響應(yīng)迅速,而不受輸入長度的限制。這種效率對于代碼生成尤其重要 。

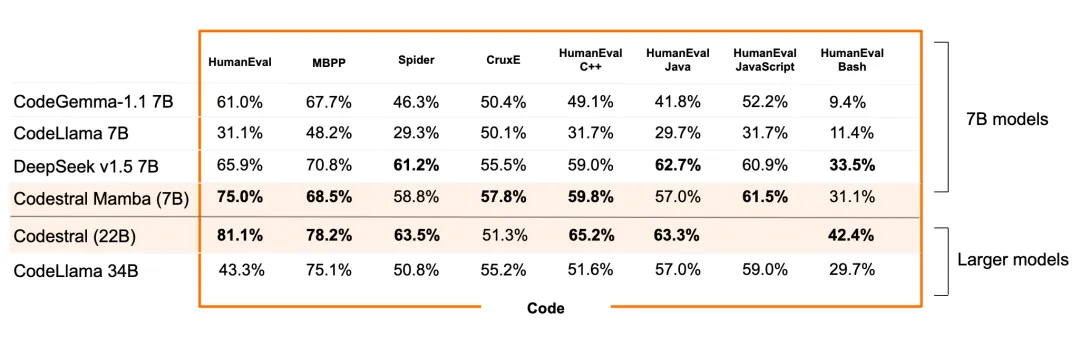

在基準(zhǔn)測試中,Codestral Mamba 在 HumanEval 測試中的表現(xiàn)優(yōu)于競爭對手開源模型 CodeLlama 7B、CodeGemma-1.17B 和 DeepSeek。

Mistral 測試了該模型,該模型可以在 Mistral 的 la Plateforme API 上免費使用,可處理多達 256,000 個token的輸入——是 OpenAI 的 GPT-4o 的兩倍。

隨著Codestral Mamba發(fā)布,就有網(wǎng)友在 VSCode中用起來了,很是絲滑。