OpenAI掀小模型血戰!蘋果DCLM強勢登場,碾壓Mistral 7B全開源

小模型的戰場,打起來了!

繼GPT-4o mini、Mistral NeMo發布之后,蘋果也入局了。

DCLM小模型包含兩種參數規模——70億和14億,發布即開源。最大70億參數超越了Mistral-7B ,性能接近Llama 3、Gemma。

根據蘋果ML小組研究科學家Vaishaal Shankar(也是DCLM研發人員)的說法,這是迄今為止性能最好的「真正開源」的模型,不僅有權重和訓練代碼,而且是基于開放數據集DCLM-Baseline。

相比模型性能,DCLM做出的「真正開源」的典范更加引人關注。

對比大部分科技巨頭只搞閉源模型,或「猶抱琵琶半遮面」,只開源代碼或權重的做法,大方的蘋果獲得了網友的好評。

此外,Shankar還預告說,之后會繼續上線模型中間檢查點和優化器狀態。

難道,這就是LLM開源社區的春天了嗎?

DCLM系列全開源

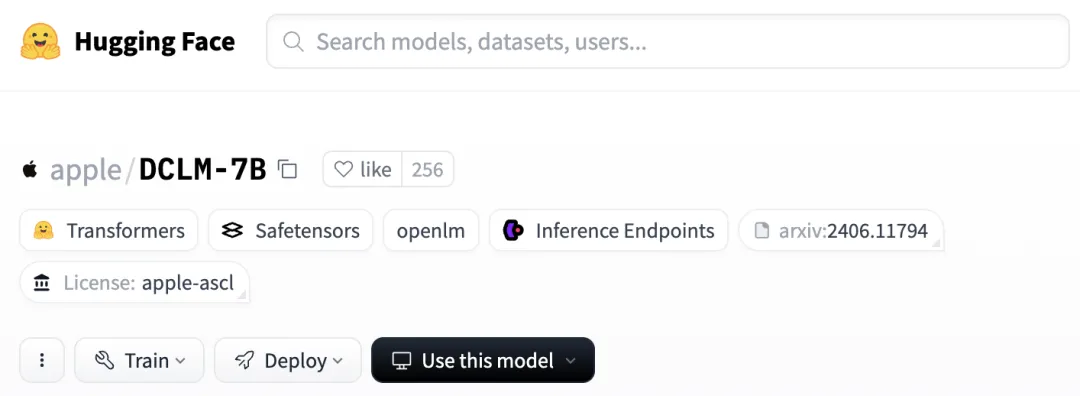

目前,HuggingFace上已經發布了全部模型權重,其中的模型卡已經基本涵蓋了關鍵信息。

https://huggingface.co/apple/DCLM-7B

DCLM-7B同樣采用了decoder-only的架構,使用PyTorch和OpenLM框架進行預訓練。

總共4T token的DCLM-baseline數據集來自于總量240T的DCLM,DCLM-7B模型又進一步過濾出其中的2.5T用于訓練。

上下文長度為2048,小于Mistral 7B和Gemma 2 9B的8k長度。

性能方面,作者直接使用評估套件LLM Foundry,測試了模型在53個基準任務上的分數。

與其他模型進行比較時,除了MMLU分數,作者還自定義了兩個指標——「核心準確率」(core)和「擴展準確率」(extended)。

前者是包括HellaSwag和ARC-E在內的22個任務中心準確率的均值,后者則涵蓋全部53個任務。

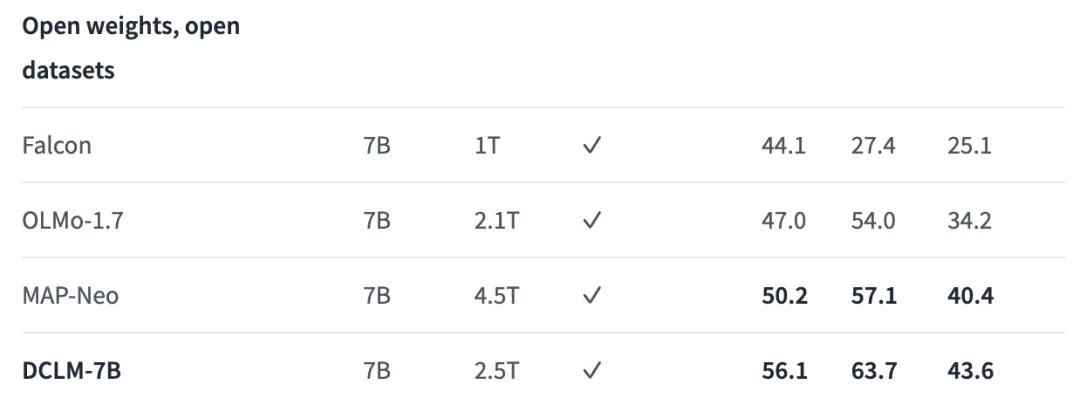

與雖然使用的數據不是最多,但與其他同等大小的開放數據模型(權重與數據集都開源)相比,DCLM在全部3個指標上的性能都達到了最佳。

三列基準分數從左到右分別是:核心、MMLU、擴展

相比之前的SOTA MAP-Neo模型,DCLM-7B在5-shot的MMLU任務準確率達到63.7%,提升了6.6個百分點,同時訓練所需的計算量減少了40%。

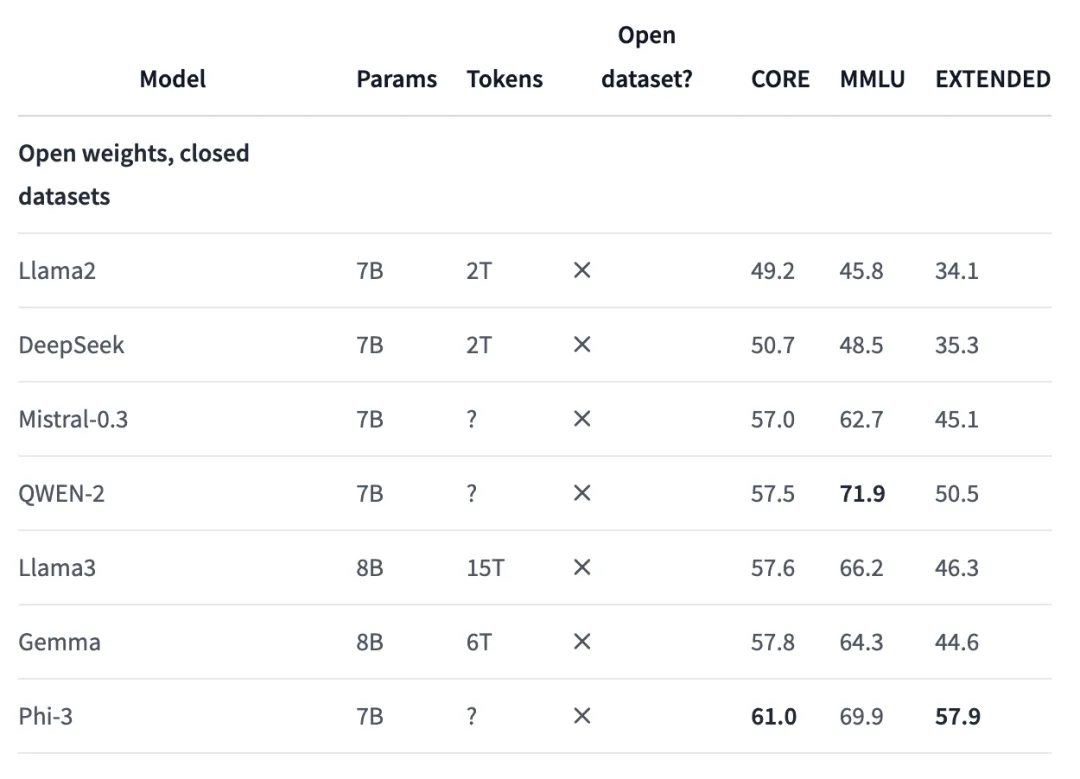

然而,如果和權重開源、數據集閉源的模型相比,效果就不盡如人意了。

DCLM在各個指標上都與Phi-3存在不小差距,與Mistral-7B-v0.3或Gemma 8B的分數大致相當。

研究人員發現,如果使用同一數據集中額外的100B數據進行訓練,并將上下文長度擴展到8k時,模型在核心和擴展基準上的分數還會進一步提升,但MMLU結果沒有變化。

這個結果,就全面超過了Mistral 7B-v0.3的分數。

此外,HuggingFace上還發布了7B模型的指令微調版本,在數學推理任務GSM8K上的性能實現大規模提升,分數由原來的2.1直接飆到52.5。

https://huggingface.co/apple/DCLM-7B-8k

除了7B版本,1.4B版本也同步上線。神奇的是,訓練數據量相比7B版本不降反增,多了0.1T。

https://huggingface.co/TRI-ML/DCLM-1B

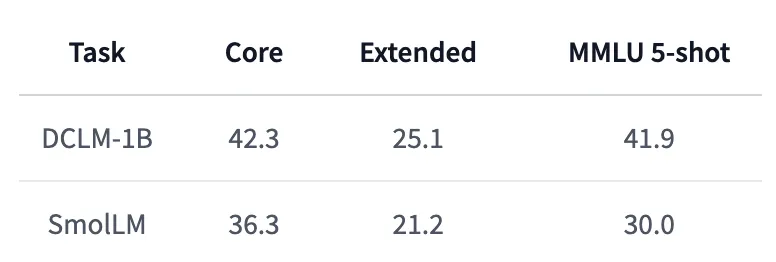

相比HuggingFace最近發布的SmolLM,DCLM-1B的性能顯著更優,尤其是5-shot MMLU分數,比SmolLM提升了11.9%。

不僅如此,DCLM-1B在MMLU上41.9的得分也同樣高于Qwen-1.5B的37.87和Phi-1.5B的35.90。

7B模型落后的事情,反而讓1.4B模型反超了,果然小模型才是蘋果的看家本領。

值得注意的是,7B模型僅能在Appl240萬億巨量數據被洗出,足夠訓出18個GPT-4!全球23所機構聯手,清洗秘籍公開e的示例代碼許可(ASCL)下使用,但1.4B版本在Apache 2.0下發布,允許商業使用、分發和修改。

既然說到這次發布的DCLM系列模型,就不得不提它們的重要基礎——DataComp基準。

論文地址:https://arxiv.org/pdf/2406.11794

DataComp這篇論文首發于6月17日,共同一作Jeffrey Li、Alex Fang和共同最后作者Vaishaal Shankar,也同樣都是蘋果DCLM的研發人員。

文章不僅對數據集的構建過程進行了詳細闡述,也提到了關于DCLM模型的部分內容。

Vaishaal Shankar表示,將很快發布這篇論文的更新版,提供更多有關模型預訓練的技術細節。

相比于對同一數據集修改模型,DataComp的思路反其道而行之——測評所用的模型是固定的,任務是在總共240T的數據池中過濾、處理出最好的數據。

可以說,這種做法與科技巨頭們的研發思路非常一致——對于LLM的性能而言,預訓練數據正在成為比模型架構和權重更重要的因素。

畢竟,Llama、Gemma、Phi等一系列「開源」模型都是只放權重、不公布數據。

既要Scaling Law,又要SLM

對于AI科技巨頭來說,有時模型不是越大越好。

其實一直以來,AI社區中,并不缺少小模型,比如微軟Phi系列模型多次迭代,以及6月末谷歌剛剛更新的Gemma 2 7B。

這周,OpenAI突然發布GPT-4o mini,Mistral AI聯手英偉達發布Mistral NeMo,HuggingFace的SmoLLM等小模型的發布,為小模型的領域再次添了一把火。

正如OpenAI研究員所言,「雖然我們比任何人都更喜歡訓練大模型,但OpenAI也知道如何訓練小模型」。

小模型,優勢在于成本低、速度快、更專業,通常只使用少量數據訓練,為特定任務而設計。

大模型變小,再擴大規模,可能是未來發展的趨勢之一。

前兩天,在GPT-4o mini發布時,Andrej Karpathy也發表長推表達了類似的觀點。

他認為,模型尺寸的競爭將會「反向加劇」,不是越來越大,反而是比誰更小更輕巧。

當前的LLM之所以逐漸變成「巨獸」,是因為訓練過程仍然非常浪費,我們基本上是在要求模型記住整個互聯網的內容(而且實際上,LLM的記憶能力還相當不錯,質量上比人類好很多)。

但對于小模型來說,訓練目標已經改變。關鍵問題是,AI系統如何從更少的數據中學到更多。

我們需要模型先變得更大,再變得更小,因為我們需要「巨獸」將數據重構、塑造為理想的合成形式,逐漸得到「完美的訓練集」,再喂給小模型。

馬斯克也表示同意這個觀點。Karpathy所描述的這個模型改進階梯,正是現實中特斯拉曾走過的路。

23年4月,Sam Altman曾宣布了AI大模型時代終結。最近采訪中,他還確認了數據質量是進一步AI訓練的關鍵成功因素。

微軟研究人員在開發Phi模型時,就提出了這樣的假設。Hugging Face的AI研究人員最近也證實了這一假設,并發布了一個高質量的訓練數據集。

就以GPT-4為例,開發和使用超一萬億參數的成本超過了1億美元。

而小模型,比如專在法律數據集上完成訓練,可能使用不到100億參數,成本不到1000萬美元,使用更少算力響應每個查詢,因此成本較低。

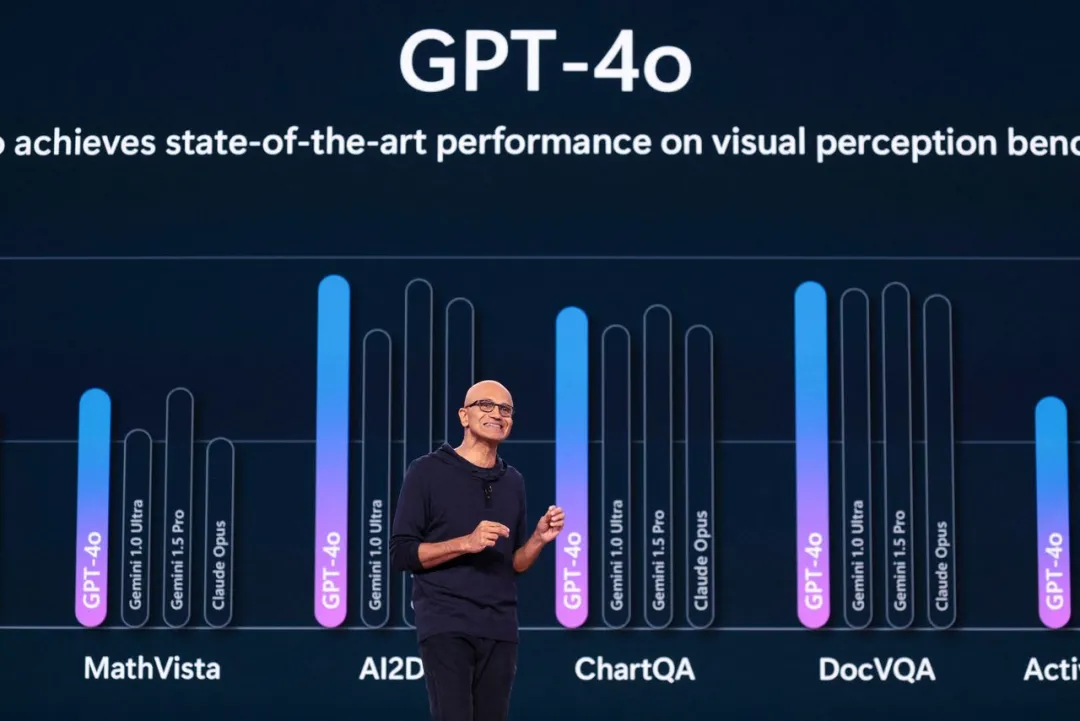

納德拉曾表示,Phi?型模型系列規模僅為OpenAI背后免費模型1/100,而且在許多任務上的表現幾乎同樣出色。

除此以外,谷歌以及AI初創公司Mistral、Anthropic、Cohere今年也發布了規模較小的模型。

6月,蘋果曾公布了自己的AI發展路線圖,計劃使用小型模型,這樣就可以完全在手機上運行軟件,使其更快速和更安全。

對于許多任務來說,比如總蘋果為什么要用「小模型」?結文檔或生成圖像,大模型可能有點大材小用。

Transformer開山之作背后作者Illia Polosukhin表示,計算2+2不應該需要進?千萬億次運算。

不過,科技巨頭們也并沒有放棄大模型。蘋果在今年WWDC大會上,曾宣布了在Siri助手中植入ChatGPT,以執行撰寫電子郵件等復雜任務。

畢竟通往終極AGI/ASI,參數規模的擴大和智能的增長成正比。