北航推出TinyLLaVA-Video,有限計算資源優于部分7B模型,代碼、模型、訓練數據全開源

近年來,隨著多模態大模型的崛起,視頻理解技術取得了顯著進展。但是目前主流的全開源視頻理解多模態模型普遍具有 7B 以上的參數量,這些模型往往采用復雜的架構設計,并依賴于大規模訓練數據集。受限于高昂的計算資源成本,模型訓練與定制化開發對于資源有限的科研人員而言仍存在顯著的門檻。

近日,北京航空航天大學的研究團隊基于 TinyLLaVA_Factory 的原項目,推出小尺寸簡易視頻理解框架 TinyLLaVA-Video,其模型,代碼以及訓練數據全部開源。在計算資源需求顯著降低的前提下,訓練出的整體參數量不超過 4B 的模型在多個視頻理解 benchmark 上優于現有的 7B + 模型。同時,由于 TinyLLaVA-Video 衍生自 Tinyllava_Factory 代碼庫,因此項目仍然具有組件化與可擴展性等優點,使用者可以根據自身需求進行定制與拓展研究。

- 論文地址:https://arxiv.org/abs/2501.15513

- Github 項目:https://github.com/ZhangXJ199/TinyLLaVA-Video

全開源項目,支持定制與拓展

區別于眾多僅開源模型權重的項目,TinyLLaVA-Video 秉承了 TinyLLaVA_Factory 全面開源的理念。該項目不僅公開了完整的模型權重、訓練代碼和訓練數據集,也延續了原有的模塊化設計架構,研究人員可根據具體實驗需求,靈活替換語言模型、視覺編碼器等核心組件,并可自定義訓練策略。這種開放性設計不僅降低了小規模研究團隊進入視頻理解研究領域的門檻,還為未來的輕量級視頻理解模型的訓練范式與架構創新探索提供了實驗平臺。

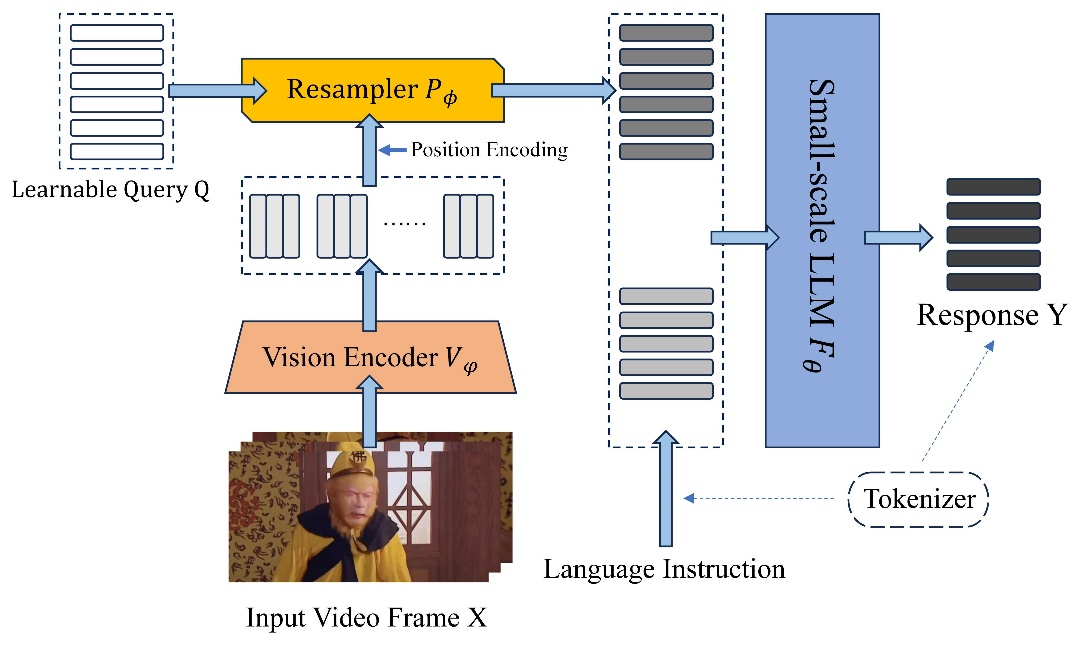

在模型架構方面,TinyLLaVA-Video 沿用 LLaVA 類多模態模型常見的 Vision Tower+Connector+LLM 框架,并同樣保持預訓練對齊與監督微調的兩階段訓練策略。項目中采用的所有預訓練模型組件均遵循開源協議,包括如 Qwen2.5-3B 等語言模型和 SigLIP 等視覺編碼器此類核心模塊,確保了實驗的可復現性,為研究者提供了可靠的基準參考。同時,研究人員可以方便地替換模型組件,更改訓練策略,定制符合自身需求的視頻理解模型。

在訓練數據方面,TinyLLaVA-Video 基于開源的 LLaVA-Video-178K 和 Valley 數據集進行實驗。同時,為進一步精簡數據集,提高訓練數據的質量并控制計算資源成本,項目對訓練數據進行了多步篩選與過濾,最終得到 397k 的預訓練數據與 491k 的監督微調數據。這使得研究者即便僅具備有限的計算資源,也能在合理的訓練時間內復現實驗結果并開展進一步研究。經過處理的數據標注信息(annotation)也已經完整公開于 HuggingFace 平臺,這也為后續研究提供了高質量的數據基礎。

小尺寸簡易框架,依然保持高性能

以往的視頻理解方法受限于語言模型的輸入長度限制,往往面臨兩難選擇:要么通過設計復雜的模型架構來處理長序列信息,要么犧牲視頻信息的完整性而限制采樣幀數。因此,如何處理長時序視覺序列,并平衡計算資源與性能之間的矛盾,成為輕量級視頻理解模型亟待解決的問題。

為在保持模型結構輕量化的同時解決長序列信息處理的問題,TinyLLaVA-Video 對于經過 Vision Tower 處理后的整體視頻序列,使用簡單的視頻級 Resampler 作為 Connector 來對齊視覺和語言,從而能極大地減少輸入至語言模型的 Visual Token 的數量。這種處理方式可以使得模型支持靈活的視頻采樣策略,研究者可以根據視頻類型與使用需求進行 fps 采樣或均勻幀采樣,設置不同的視頻采樣幀數。

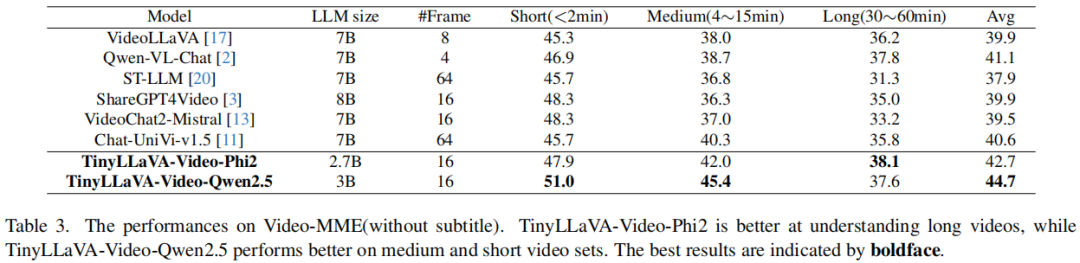

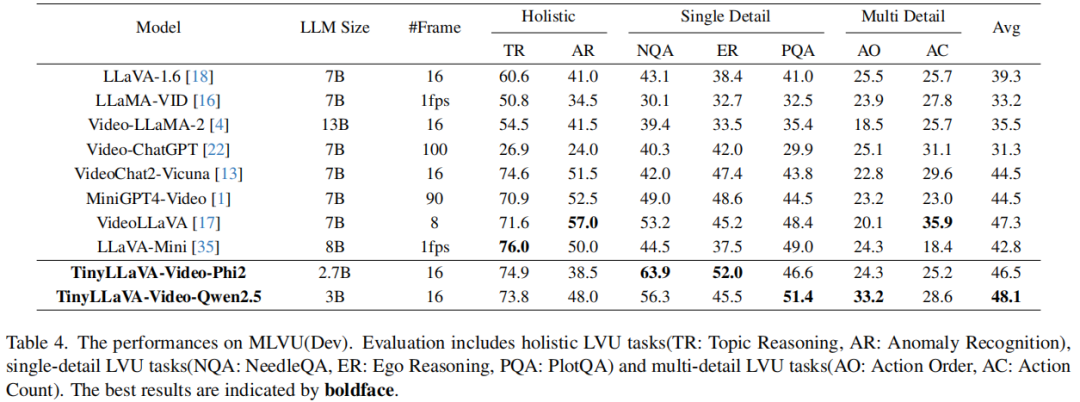

雖然簡化模型架構并控制訓練數據的規模,但是 TinyLLaVA-Video 的表現依然非常可觀。實驗結果表明,整體參數不超過 4B 的模型在包含 MLVU、Video-MME 在內的多個視頻理解基準測試集上的表現優于同等訓練數據量級下的 7B + 模型,充分驗證了該框架的有效性。

此外,該研究也進行了大量實驗,系統性地探索了不同配置下的模型性能,包括選擇不同的語言模型、視覺編碼器以及采樣不同的幀數等設置的影響(實驗設置與結果詳見技術報告)。這些實驗結果揭示了在不同參數設定下,模型在視頻理解任務中的表現,為研究者提供了優化模型結構的實證數據。這些探索不僅提升了 TinyLLaVA-Video 的適用性,也為后續研究提供了重要的參考依據。

TinyLLaVA-Video 的研究表明,小尺寸視頻理解模型在計算成本有限的環境下仍具有廣闊的發展空間。未來,計算資源有限的研究者們可以基于該工作,進一步優化模型結構和訓練策略,以推動小尺寸視頻理解模型的持續發展,為資源受限環境下的多模態研究提供更多可能性。

TinyLLaVA 系列項目始終致力于在有限計算資源下研究小尺寸模型的訓練與設計空間,堅持完全開源原則,完整公開模型參數、源代碼及訓練數據。同時,項目采用模塊化設計理念,確保項目的可拓展性,方便資源有限的研究者們通過實踐來理解與探索多模態大模型。