讓7B千問模型超越o1,微軟rStar-Math驚艷登場,網友盛贊

OpenAI o1 給大模型規模擴展 vs 性能的曲線帶來了一次上翹。它在大模型領域重現了當年 AlphaGo 強化學習的成功 —— 給越多算力,就輸出越多智能,一直到超越人類水平。

但這種突破背后是龐大的算力支持與推理開銷:API 的價格上,o1-preview 每百萬輸入 15 美元,每百萬輸出 60 美元,而最新版的 o3 在處理復雜推理任務時,單次成本更是高達數千美元。

業界一直在尋找一個更經濟、更高效的解決方案。而這個答案可能比預期來得更快一些。

今天登頂 Hugging Face 熱門榜一的論文展示了小模型的潛力。來自微軟亞洲研究院的研究團隊提出了 rStar-Math。rStar-Math 向我們證明,1.5B 到 7B 規模的小型語言模型(SLM)無需從更大模型蒸餾,就能在數學推理能力上媲美甚至超越 OpenAI o1。

- 論文標題:rStar-Math: Small LLMs Can Master Math Reasoning with Self-Evolved Deep Thinking

- 論文鏈接:https://arxiv.org/pdf/2501.04519

- Github 鏈接:https://github.com/microsoft/rStar(即將開源)

經過 4 輪自我進化,吸納了 747k 數學問題合成的數百萬數據,rStar-Math 將 SLM 的數學推理能力提升到了最先進水平。

例如,在 MATH 基準測試上,它將 Qwen2.5-Math-7B 的成績從 58.8% 提升到了 90.0%,將 Phi3-mini-3.8B 的正確率從 41.4% 提升到了 86.4%,分別超過了 o1-preview 4.5% 和 0.9%。

拉到美國數學奧林匹克(AIME)的考場上,15 道題,rStar-Math 能夠做對 8 道,在最優秀的高中數學競賽生中也能排到前 20%。

更重要的是,他們只花了 60 塊 A100 就達到了如此效果,項目和代碼即將開源。

AI 投資人 Chetan Puttagunta 銳評:「對創業公司來說,這將是一個絕佳的機會!」

當如此強大的推理能力可以用更低的成本實現時,Keras 創始人 Fran?ois Chollet 也感嘆道:「2025 年將是開源 o3 復刻之年。」

學術圈的人對 rStar-Math 的欣賞,表達起來就直白多了:

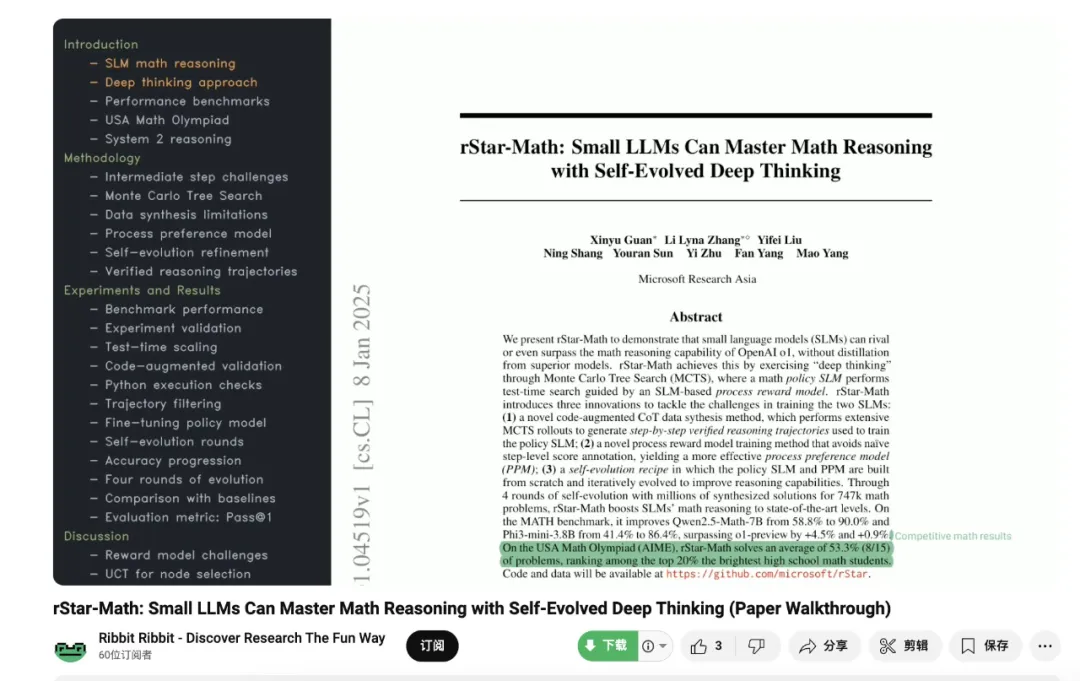

發布不到 20 個小時,甚至就已經有人專門做了一期視頻來深度解讀。

- 視頻鏈接:https://www.youtube.com/watch?v=cHgHS6Y3QP0

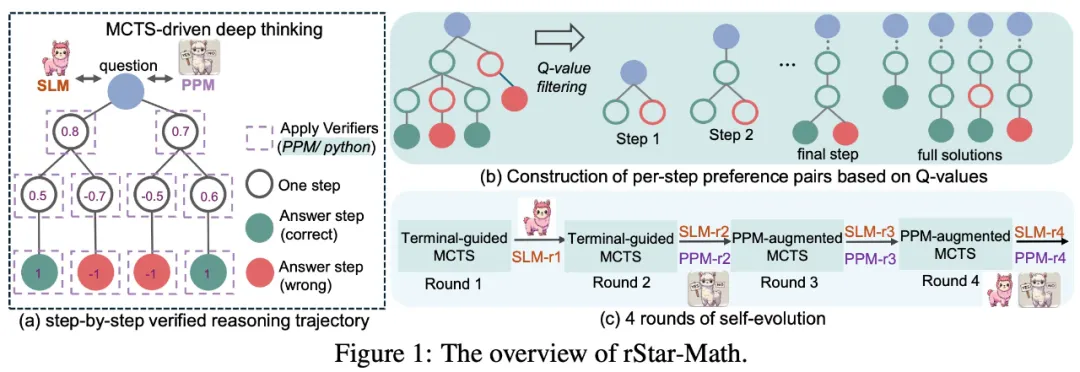

從技術層面來說,rStar-Math 引入了一種可以自己進化的 System 2 推理方法,通過蒙特卡洛樹搜索(MCTS)來實現「深度思考」能力。在測試階段,它會在獎勵模型的指導下,讓數學策略模型進行搜索推理。

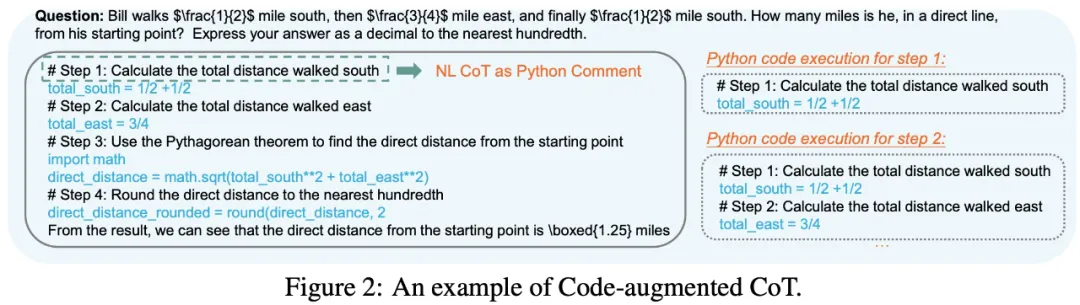

具體來看,在 MCTS 中,數學問題求解被分解為多步生成。每一步都將作為策略模型的 SLM 采樣候選節點。每個節點生成一步 CoT 和相應的 Python 代碼。為驗證生成質量,只保留 Python 代碼執行成功的節點,從而減少中間步驟的錯誤。

此外,大量 MCTS rollout 基于每個中間步驟的貢獻自動分配 Q 值:對正確答案貢獻更多的步驟獲得更高 Q 值,被認為質量更高。這確保了 SLM 生成的是正確、高質量的推理軌跡。

由于 rStar-Math 的總體架構涉及兩個 SLM,一個是數學策略模型,一個是獎勵模型,該團隊引入了三個關鍵創新:

- 創新的代碼增強 CoT 數據合成方法,通過大量 MCTS rollout 生成經過驗證的逐步推理軌跡,用于訓練策略 SLM;

- 過程獎勵模型訓練方法也有所改進,避免了簡單的步級分數標注,提升了過程偏好模型(PPM)的評估效果;

- 模型會自我進化,采用完全自主訓練方案,從零開始構建并訓練模型,通過持續的迭代優化來不斷提升推理能力。

方法

該研究的目標是訓練數學策略 SLM 和過程獎勵模型 (PRM),并將兩者集成到蒙特卡羅樹搜索 (MCTS) 中以實現 System 2 深度思考。

選擇 MCTS 有兩個主要原因。

首先,它將復雜的數學問題分解為更簡單的單步生成任務,與 Best-of-N 或 self-consistency 等其他 System 2 方法相比,MCTS 降低了策略 SLM 的難度。

其次,MCTS 中的逐步生成會自然產生兩個模型的 step-level 訓練數據。標準 MCTS rollout 會根據每個步驟對最終正確答案的貢獻自動為每個步驟分配 Q 值,從而無需人工生成步驟級注釋來進行過程獎勵模型訓練。

理想情況下,GPT-4 等高級 LLM 可以集成到 MCTS 中以生成訓練數據。然而,這種方法面臨兩個關鍵挑戰。首先,即使是強大的模型也難以持續解決難題,例如奧林匹克級別的數學問題。

因此,生成的訓練數據將主要由更簡單的可解決問題組成,限制了其多樣性和質量。

其次,注釋每步 Q 值需要廣泛的 MCTS 部署;樹探索(tree exploration)不足可能會導致虛假的 Q 值分配,例如高估次優步驟。鑒于每次 rollout 都涉及多個單步生成,并且這些模型的計算成本很高,因此增加 rollout 會顯著提高推理成本。

為此,該研究探索使用兩個 7B SLM(策略 SLM 和 PRM)來生成更高質量的訓練數據,其較小的模型大小允許在可訪問的硬件(例如 4×40GB A100 GPU)上廣泛部署 MCTS。

然而,由于自生成數據的能力較弱,SLM 經常無法生成正確的解決方案,即使最終答案正確,中間步驟也常常存在缺陷或質量較差。此外,與 GPT-4 等高級模型相比,SLM 解決的挑戰性問題較少。

如圖 1 所示,為了減少錯誤和低質量的中間步驟,該研究提出了一種代碼增強的 CoT 合成方法,該方法執行廣泛的 MCTS 部署以生成逐步驗證的推理軌跡,用 Q 值注釋。

為了進一步提高 SLM 在挑戰性問題上的性能,該研究提出了四輪自進化方案。在每一輪中,策略 SLM 和獎勵模型都會更新為更強的版本,逐步解決更困難的問題并生成更高質量的訓練數據。

最后,該研究提出了一種新穎的流程獎勵模型訓練方法,無需精確的每步獎勵注釋,從而產生更有效的流程偏好模型(PPM)。

實驗評估

該團隊在多個數學數據集上對 rStar-Math 進行了評估,并與多個模型進行了對比。具體設置請參閱原論文,這里我們主要來看研究結果。

主要結果

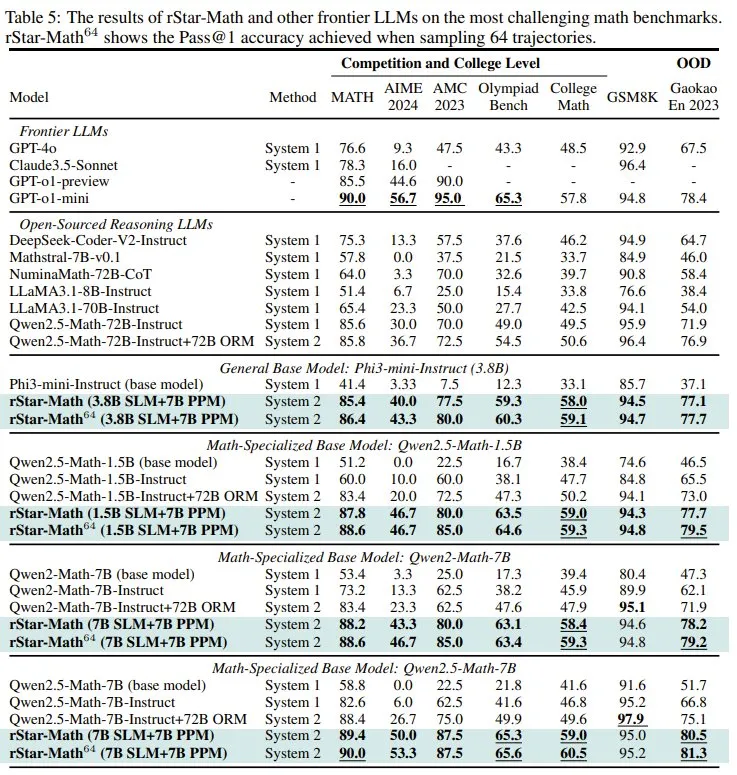

表 5 展示了 rStar-Math 與其它 SOTA 推理模型在不同的數學基準上的結果。

基于這些結果,該團隊得出了三點觀察:

- rStar-Math 顯著提高了小語言模型(SLM)的數學推理能力,在模型規模顯著縮小(1.5B-7B)的情況下,其性能可媲美甚至超越 OpenAI o1。

- 盡管使用了較小的策略模型(1.5B-7B)和獎勵模型(7B),rStar-Math 的表現仍明顯優于最先進的 System 2 基線。

- 除了 MATH、GSM8K 和 AIME 等可能存在過度優化風險的知名基準之外,rStar-Math 在其他具有挑戰性的數學基準上表現出很強的通用性,包括 Olympiad Bench、College Math 和 Chinese College Entrance Math Exam(Gaokao),創下了新的最高分。

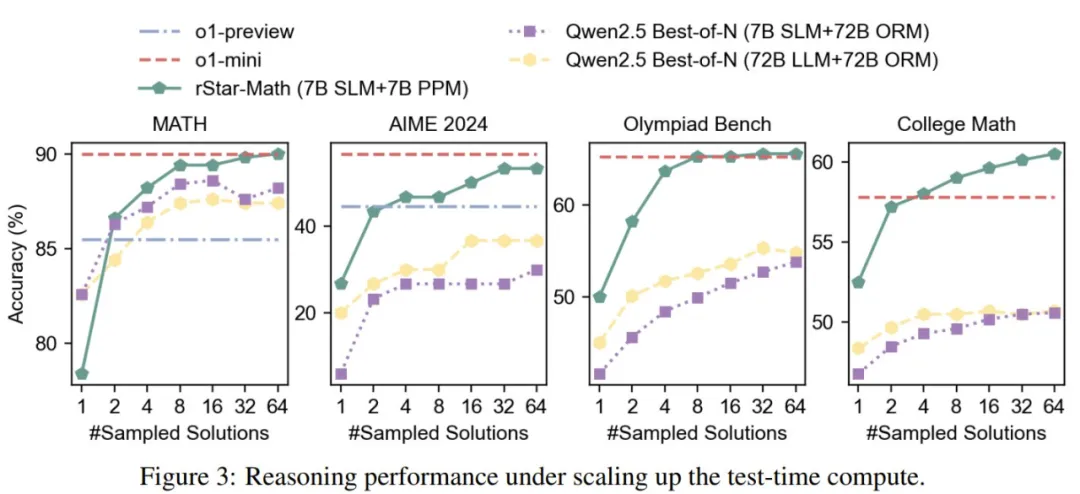

擴展測試時間計算。rStar-Math 使用了 MCTS 來增強策略模型,在 PPM 的引導下搜索問題的解。通過增加測試時間計算,它可以探索更多軌跡,從而可能實現性能提升。

在圖 3 中,該團隊通過比較官方 Qwen Best-of-N 在四個高難度數學基準上不同數量的采樣軌跡的準確度,展示了測試時間計算擴展的影響。

消融研究和分析

該團隊也進行了消融研究,證明了三項創新的有效性。

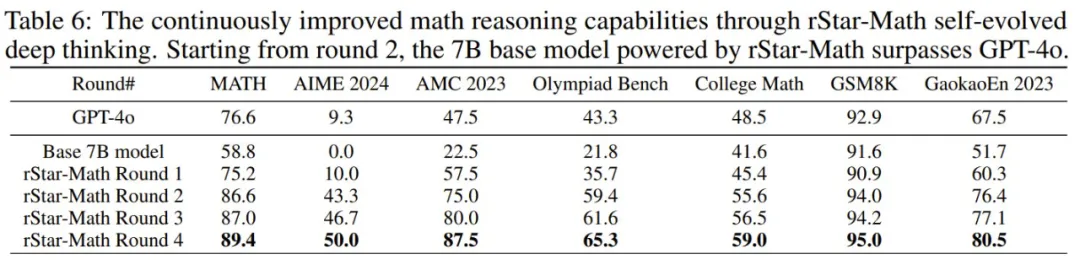

自我進化的有效性。表 5 展示了經過 4 輪 rStar-Math 自我進化深度思考后得到的結果。可以看到,表現很不錯。

表 6 給出了每一輪的數學推理性能,可以明顯看到其準確度在不斷提高。

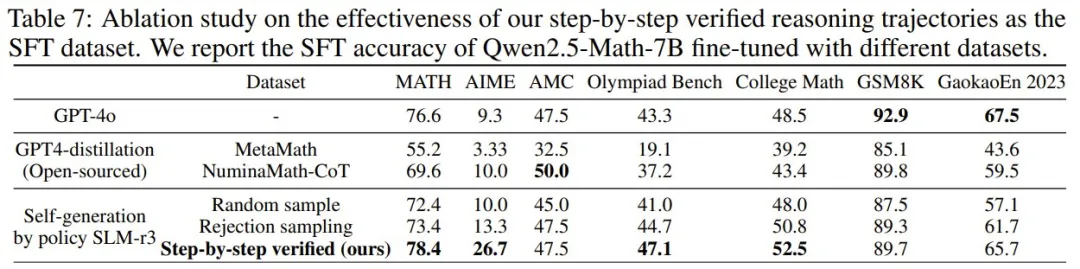

表 7 則展示了在不同數據集上微調的 Qwen2.5-Math-7B 的數學推理準確度。

該團隊給出了兩項重要觀察:

- 使用新提出的逐步驗證的軌跡進行微調明顯優于所有其他基線。這主要歸功于用于代碼增強型 CoT 合成的 PPM 增強型 MCTS,它能在數學解答生成期間提供更密集的驗證。

- 使用該團隊的小語言模型,即使隨機采樣代碼增強型 CoT 解答,得到的結果也可媲美或優于 GPT-4 合成的 NuminaMath 和 MetaMath 數據集。這表明,經過幾輪自我進化后,新的策略 SLM 可以生成高質量的數學解答。這些結果證明新方法在不依賴高級 LLM 蒸餾的情況下,就具備自我生成更高質量推理數據的巨大潛力。

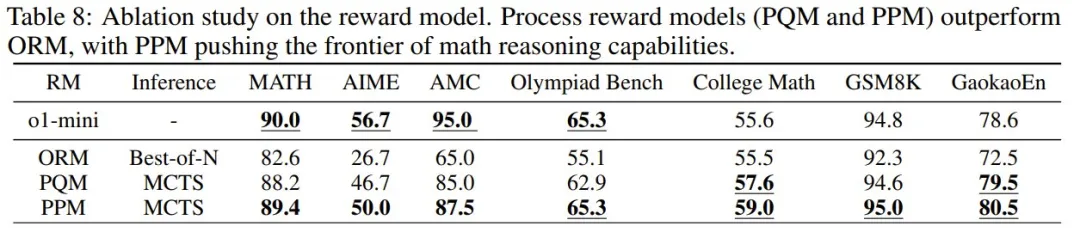

另外,在最后一輪策略模型的基礎上,該團隊比較了 ORM、PQM 和 PPM 在 System 2 推理上的性能。結果見表 8。

可以看到,PQM 和 PPM 都優于 ORM,因為它們可提供更密集的步驟級獎勵信號,從而在復雜的數學推理任務上獲得更高的準確度。然而,由于 Q 值固有的不精確性,PQM 在更難的基準測試(例如 MATH 和 Olympiad Bench)上表現不佳。相比之下,PPM 構建了步驟級偏好數據進行訓練,使該團隊的 7B 策略模型在所有基準測試中都能夠實現與 o1-mini 相當或更優的性能。

發現與討論

模型出現自我反思能力

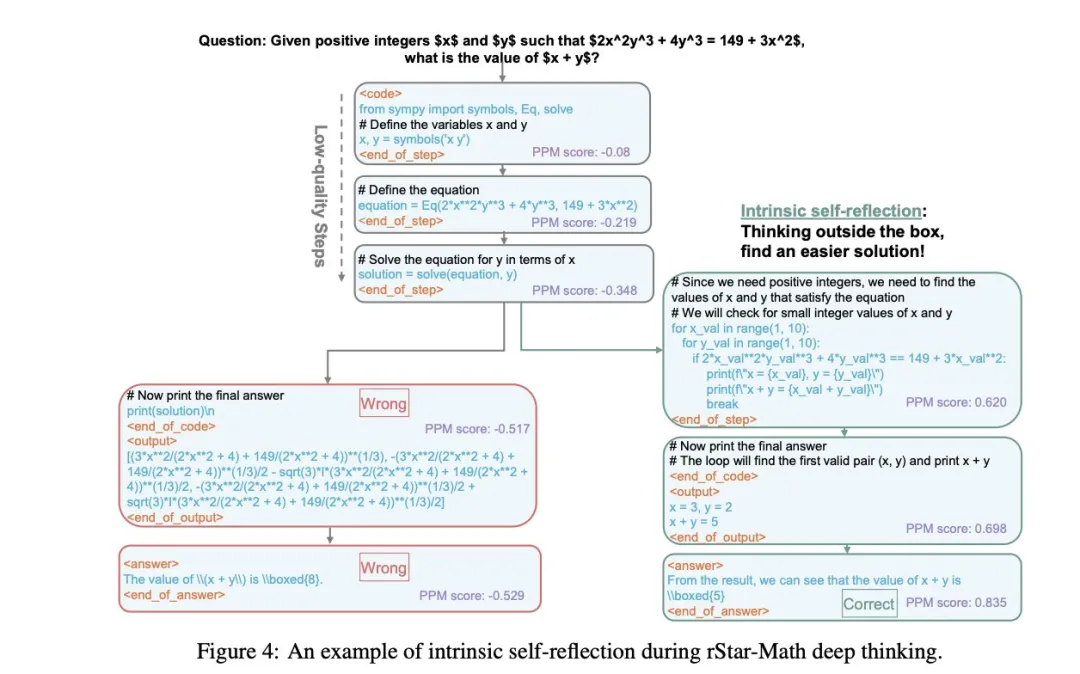

OpenAI o1 的一個重要突破是它能自省。當它出錯時,o1 能識別錯誤并自我糾正。這在開源 LLM 中一直難以實現。在實驗中,該團隊意外發現 MCTS 驅動的深度思考展現出了反思能力。如圖 4 所示,模型最初在前三步使用 SymPy 形式化方程會寫出錯誤答案(左分支)。

在我們的實驗中,我們意外地觀察到我們的 MCTS 驅動的深度思考在解決問題過程中表現出自反思。如圖 4 所示,模型最初在前三步使用 SymPy 形式化方程,這將導致答案錯誤 (左分支)。

但在第四步,模型就識別出了前幾步的問題(右分支),并主動回溯采用更簡單的方法重新求解,最終得到正確答案。

值得注意的是,這種自反思能力是在沒有專門訓練和提示的情況下自發產生的,表明高級 System 2 推理可以自然培養出內在的自省能力。

PPM 塑造 System 2 深度思考的推理邊界

策略模型和獎勵模型對 System 2 深度推理都至關重要。實驗表明,一旦策略模型達到相當強的能力水平,PPM 就成為決定性能上限的關鍵。

如下圖 5 所示,通過加入 System 2 推理機制,即使是 Phi3.8B 這樣的小模型也能獲得顯著性能提升,在多個數學基準測試中的準確率提高了約 20-30 個百分點。這表明,獎勵模型(而不是基礎模型的大小)才是決定最終性能的關鍵因素。

更多研究細節,請參閱論文原文。