電腦平板組AI集群,在家就能跑400B大模型,GitHub狂攬2.5K星?

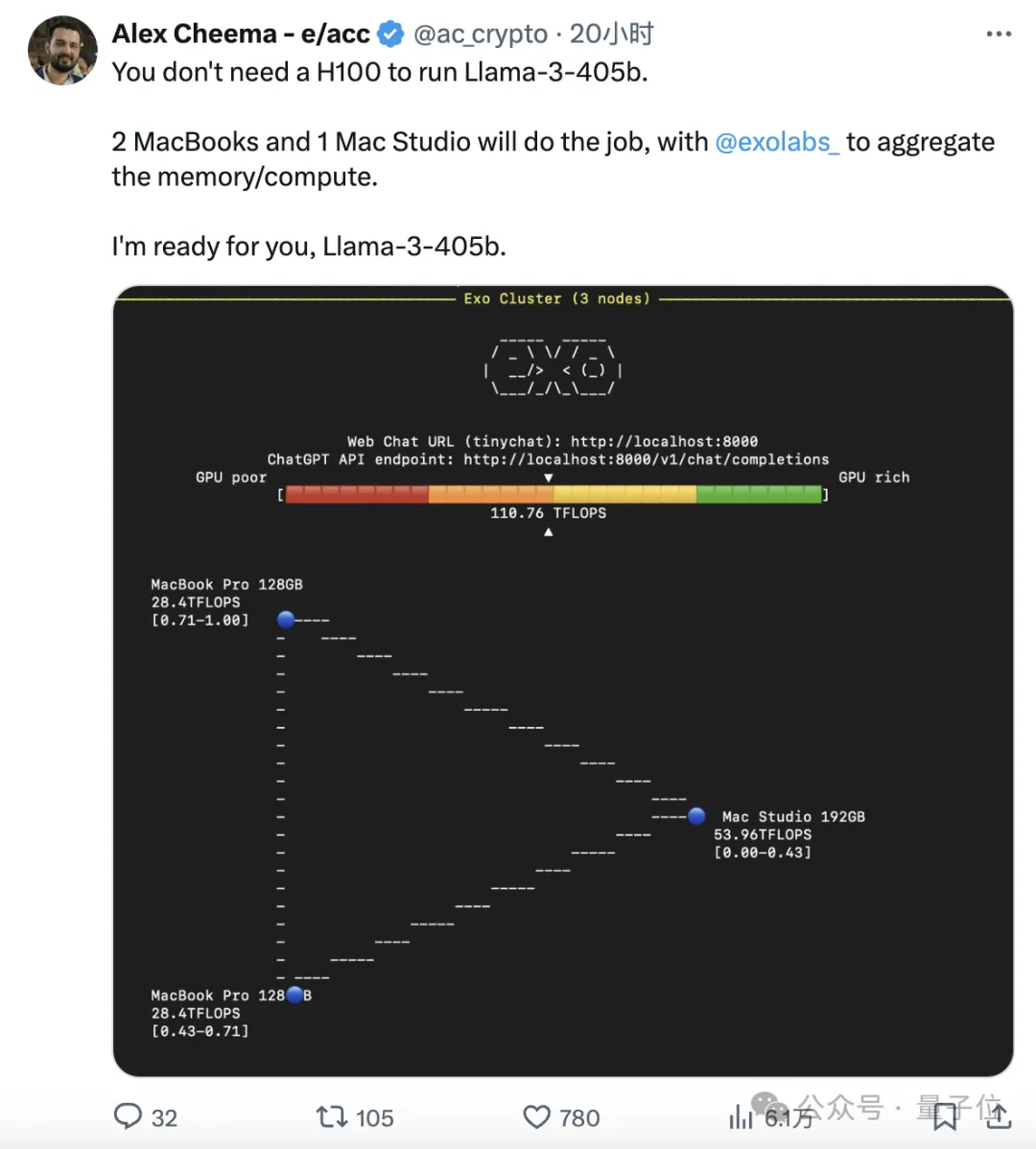

不用H100,三臺蘋果電腦就能帶動400B大模型。

背后的功臣,是GitHub上的一個開源分布式AI推理框架,已經斬獲了2.5k星標。

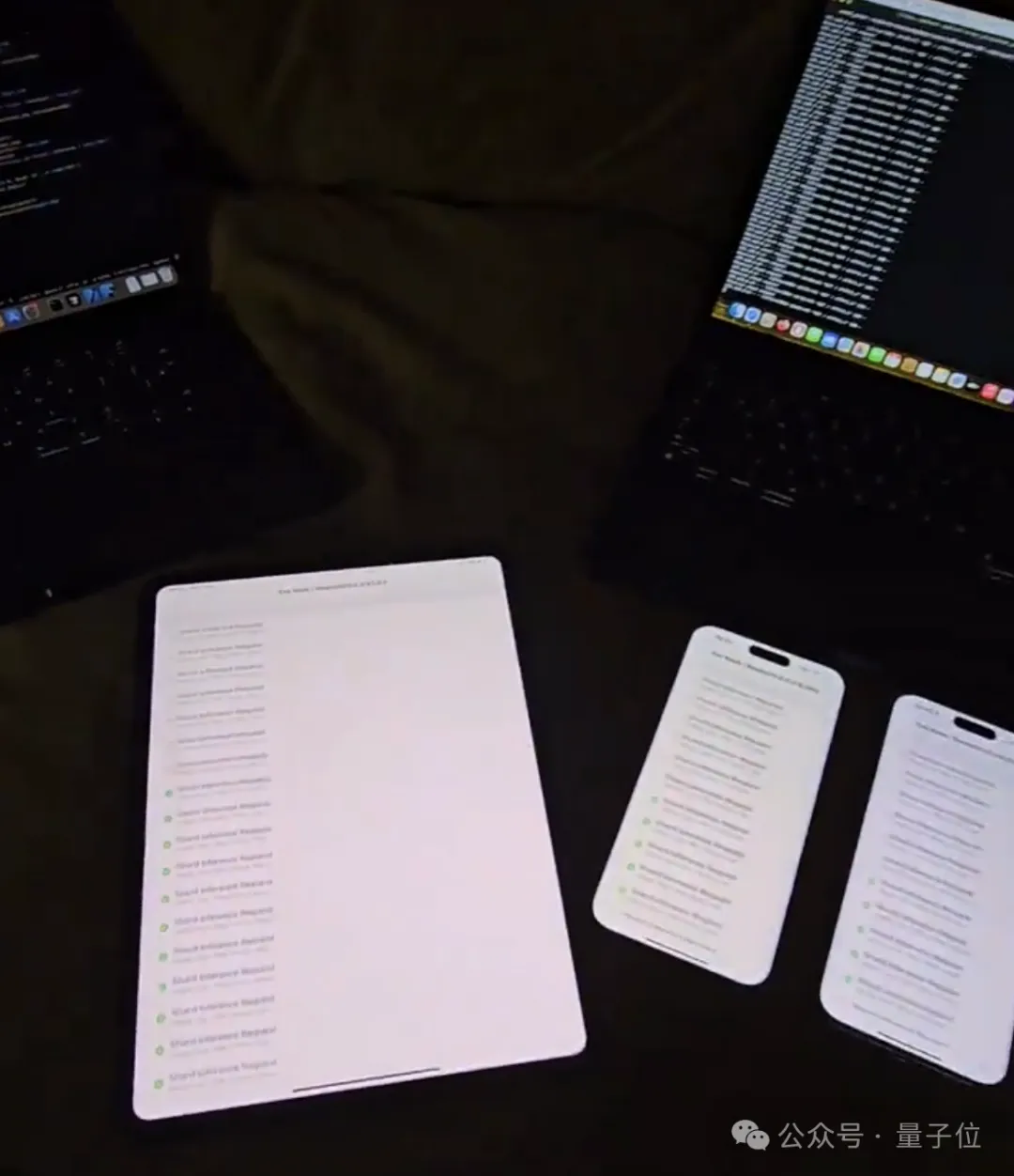

利用這個框架,幾分鐘就能用iPhone、iPad等日常設備構建出自己的AI算力集群。

這個框架名叫exo,不同于其他的分布式推理框架,它采用了p2p的連接方式,將設備接入網絡即可自動加入集群。

開發者使用exo框架連接了兩臺MacBook Pro和一臺Mac Studio,運算速度達到了110TFLOPS。

同時這位開發者表示,已經準備好迎接即將到來的Llama3-405B了。

exo官方也放話稱,將在第一時間(day 0)提供對Llama3-405B的支持。

而且不只是電腦,exo可以讓iPhone、iPad等設備也加入本地算力網絡,甚至Apple Watch也同樣能夠吸納。

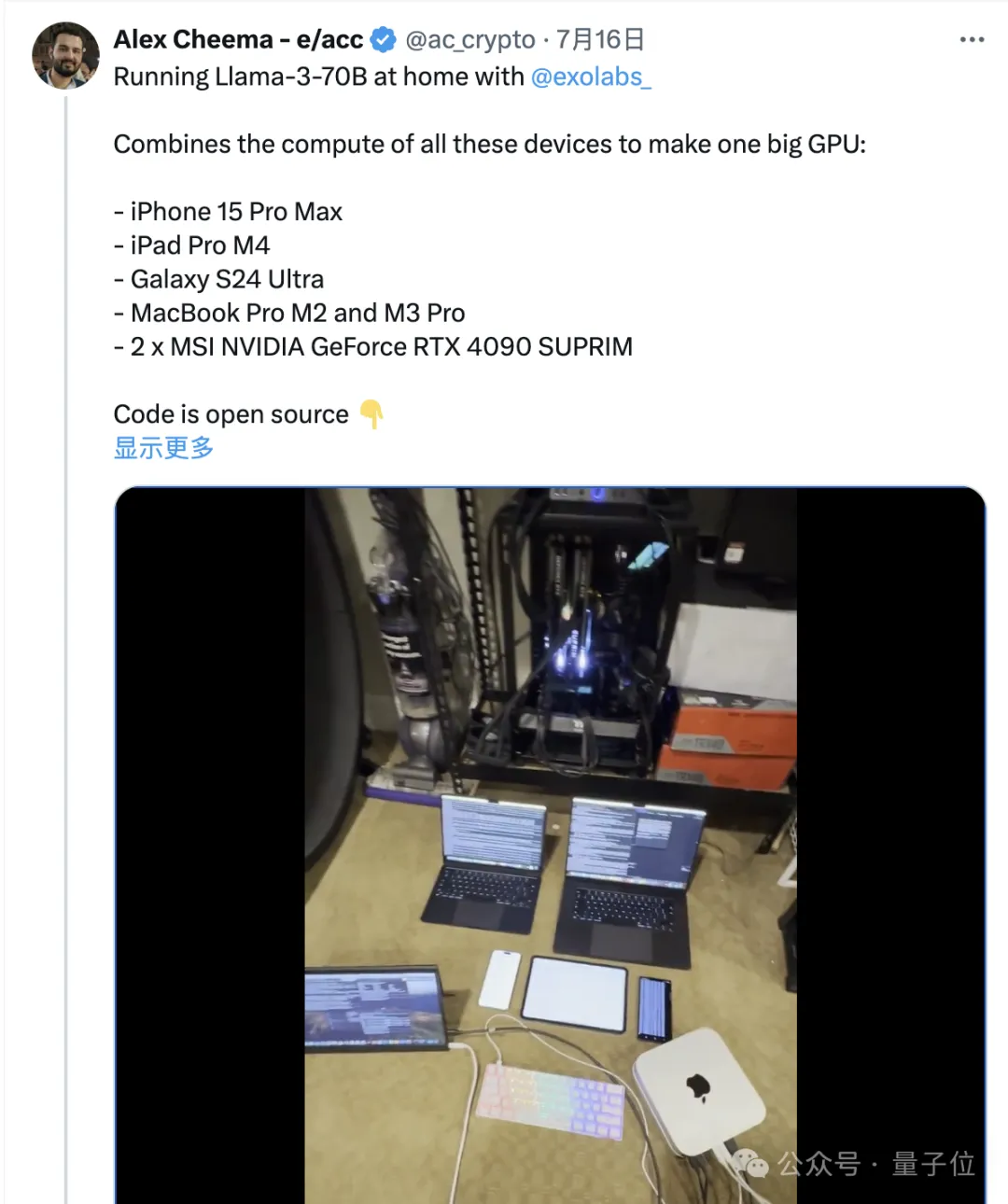

隨著版本的迭代,exo框架也不再是蘋果限定(起初只支持MLX),有人把安卓手機和4090顯卡也拉進了集群。

最快60秒完成配置

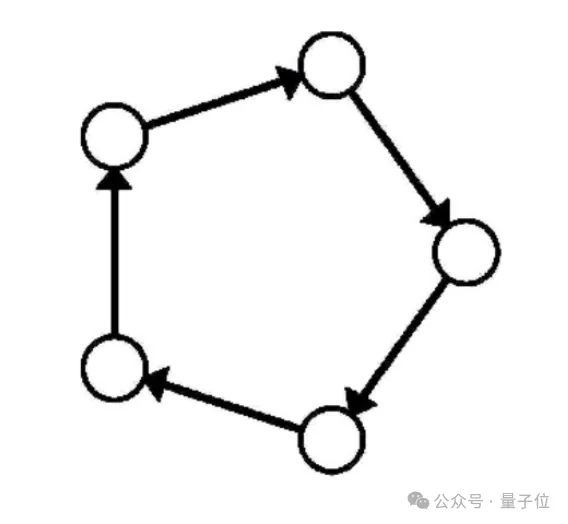

與其他分布式推理框架不同,exo不使用master-worker架構,而是點對點(p2p)地將設備進行連接。

只要設備連接到相同的局域網,就可以自動加入exo的算力網絡,從而運行模型。

在對模型進行跨設備分割時,exo支持不同的分區策略,默認是環內存加權分區。

這會在環中運行推理,每個設備分別運行多個模型層,具體數量與設備內存成比例。

而且整個過程幾乎無需任何手動配置,安裝并啟動之后系統就會自動連接局域網內運行的設備,未來還會支持藍牙連接。

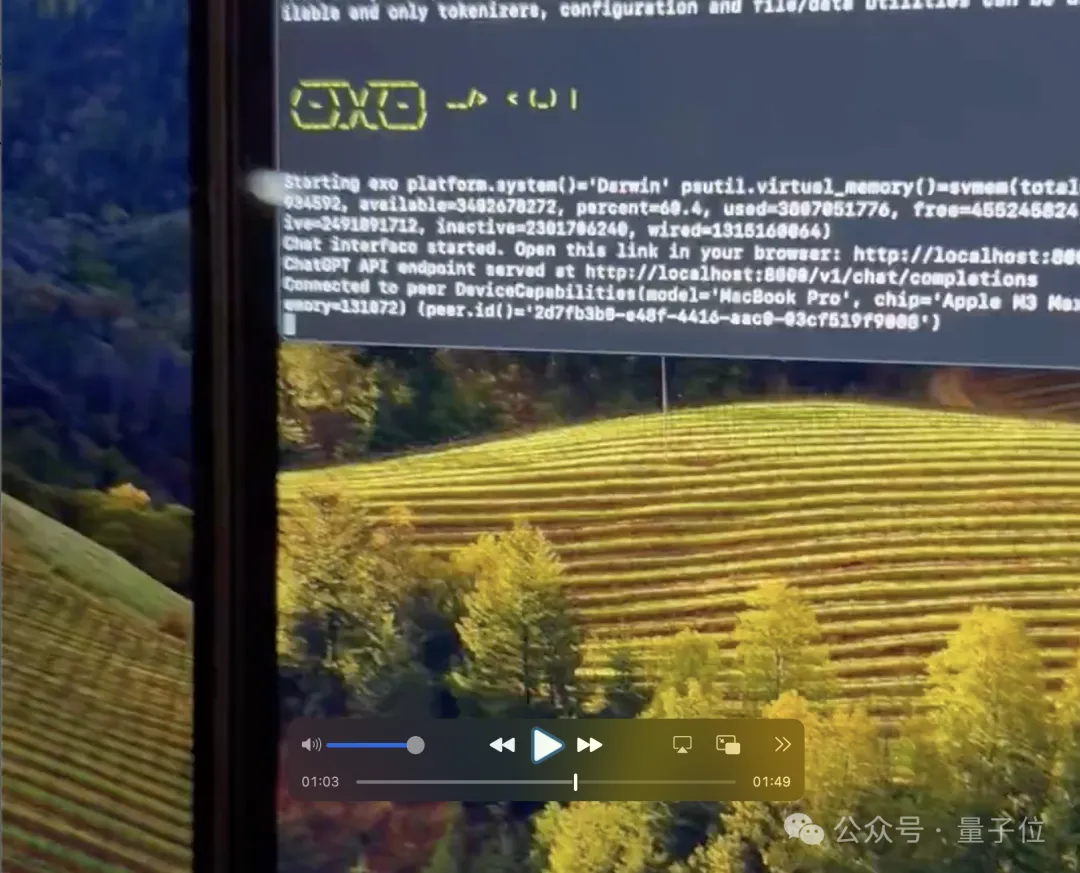

在作者的一段視頻當中,只用了60秒左右就在兩臺新的MacBook上完成了配置。

,時長01:48

可以看到,在60秒左右時,程序已然開始在后臺運行。

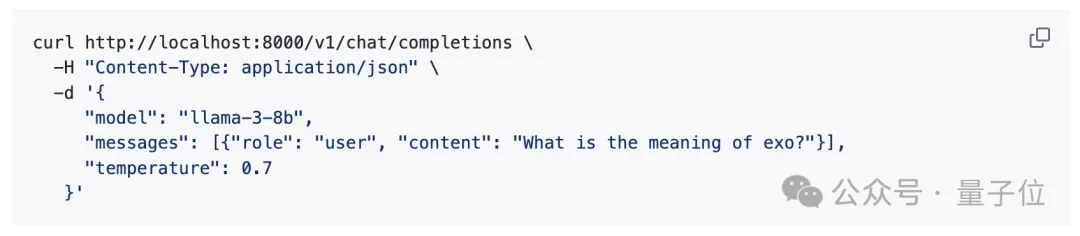

另外從上面這張圖中還能看出,exo還支持tiny chat圖形化界面,同時還有兼容OpenAI的API。

不過,這樣的操作只能在集群中的尾節點(tail node)上實現。

目前,exo支持蘋果MLX框架和開源機器學習框架tinygrad,對llama.cpp的適配工作也正在進行。

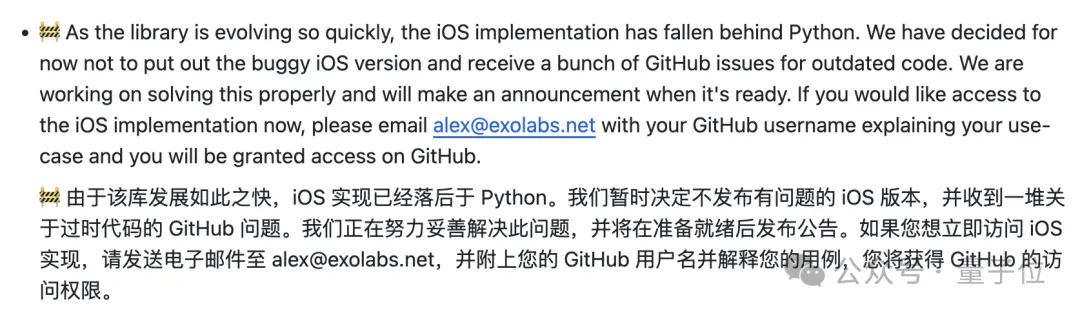

美中不足的是,由于iOS實現更新跟不上Python,導致程序出現很多問題,作者把exo的手機和iPad端進行了暫時下線,如果確實想嘗試,可以給作者發郵件索取。

網友:真有那么好用?

這種利用本地設備運行大模型的方式,在HakerNews上也引發了廣泛的討論。

本地化運行的優點,一方面是隱私更有保障,另一方面是模型可以離線訪問,同時還支持個性化定制。

也有人指出,利用現有設備搭建集群進行大模型運算,長期的使用成本要低于云端服務。

但針對exo這個具體的項目,也有不少人表達了心中的疑問。

首先有網友指出,現有的舊設備算力水平無法與專業的服務商之間差了數量級,如果是出于好奇玩一玩還可以,但想達到尖端性能,成本與大型平臺根本無法比較。

而且還有人表示,作者演示用的設備都是高端硬件,一個32GB內存的Mac設備可能要價超過2000美元,這個價格還不如買兩塊3090。

他甚至認為,既然涉及到了蘋果,那可以說是和“便宜”基本上不怎么沾邊了。

這就引出了另一個問題——exo框架都兼容哪些設備?難道只支持蘋果嗎?

網友的提問則更加直接,開門見山地問支不支持樹莓派。

作者回復說,理論上可以,不過還沒測試,下一步會進行嘗試。

除了設備自身的算力,有人還補充說,網絡傳輸的速度瓶頸,也會限制集群的性能。

對此,框架作者親自下場進行了解釋:

exo當中需要傳輸的是小型激活向量,而非整個模型權重。

對于Llama-3-8B模型,激活向量約為10KB;Llama-3-70B約為32KB。

本地網絡延遲通常很低(<5ms),不會顯著影響性能。

作者表示,目前該框架已經支持tinygrad,因此雖然測試主要在Mac設備上展開,(理論上)支持能運行tinygrad的所有設備。

目前該框架仍處于實驗階段,未來的目標是把這個框架變得像Dropbox(一款網盤)一樣簡單。

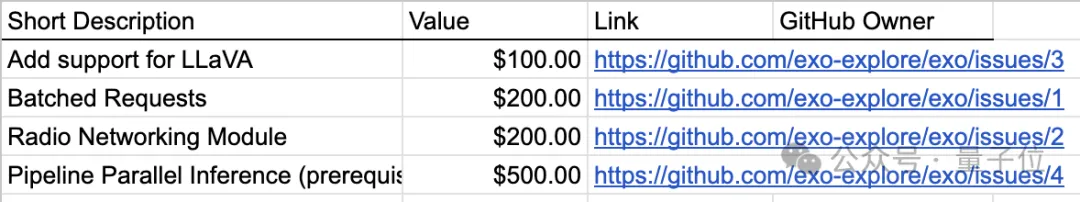

BTW,exo官方也列出了一些目前計劃解決的缺點,并進行了公開懸賞,解決這些問題的人將獲得100-500美元不等的獎金。

GitHub:https://github.com/exo-explore/exo