KG+LM超越傳統架構!海德堡提出全新圖語言模型GLM | ACL 2024

語言模型(LM)的成功似乎掩蓋了旁人的光輝。

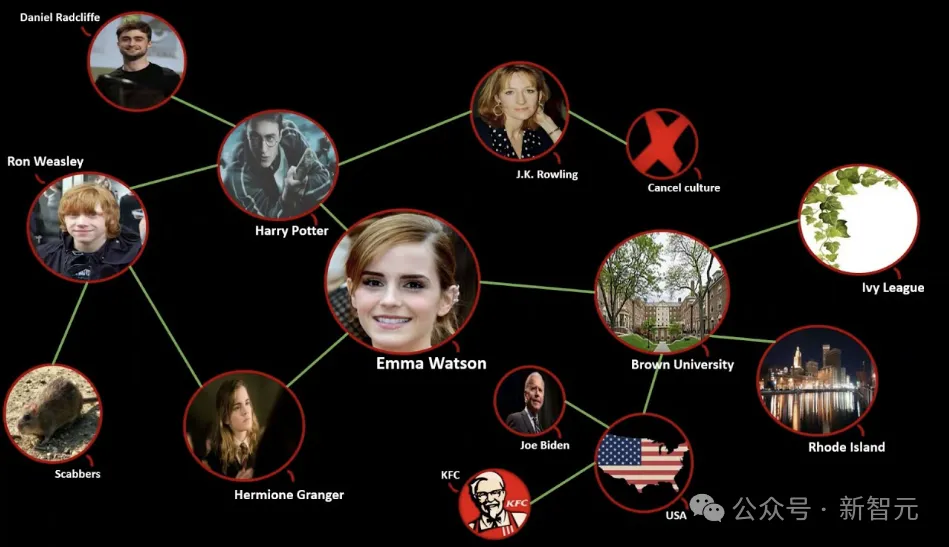

比如知識圖譜(knowledge graph,KG),這個整合了實體關系的結構化知識庫。

通常來說,語言模型代表了語言能力,而知識圖譜蘊含了結構信息。

長期以來,對于KG的利用大致可以分為兩類:

第一類是將KG線性化后嵌入LM,這種做法并不能充分利用其結構信息;

第二類是使用圖神經網絡 (GNN) 來保留圖結構,但GNN無法表示文本特征,也無法與LM的預訓練特征結合。

——有沒有辦法結合二者的優點,既保留預訓練LM的能力,又充分利用KG來增強模型對于圖概念和三元組的理解?

當然有,不然小編就不會寫,那就是來自海德堡大學的研究人員推出的圖語言模型 (GLM)。

論文地址:https://aclanthology.org/2024.acl-long.245.pdf

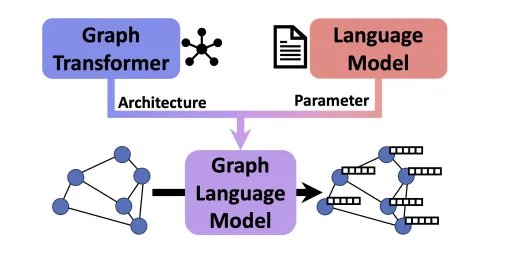

GLM集成了兩種方法的優勢并彌補了它們的缺點。

作者使用預訓練LM來初始化GLM的參數,同時又設計新的架構來促進有效知識分配,這使得GLM能夠同時處理圖和文本信息。

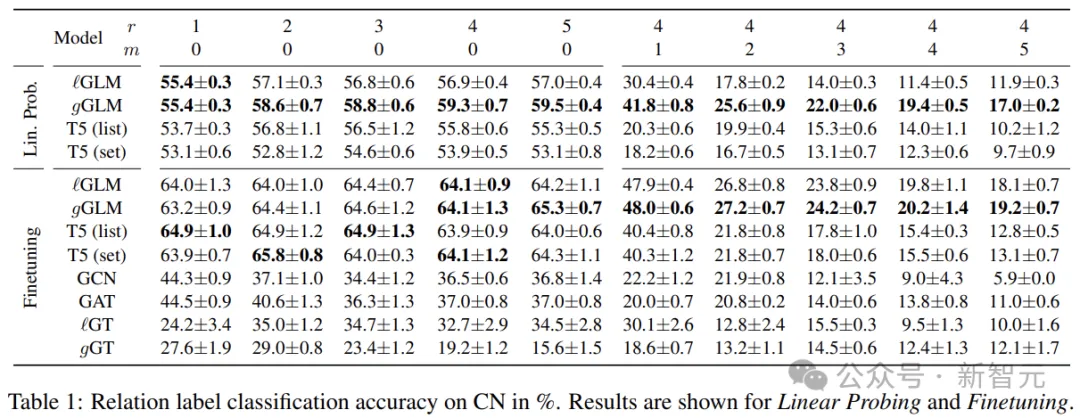

下表展示了對關系分類任務的實證評估結果,在這些較為復雜的任務中,模型需要對來自文本和圖的互補輸入進行推理,還需要推斷不存在于文本中的信息。

數據表明,GLM在監督和零樣本測試中,超越了基于LM和GNN的基線。

此外,通過線性探測實驗,作者還證明了GLM的架構變化與原始LM權重高度兼容。

圖語言模型

KG對于組織大量數據、促進信息檢索,以及揭示決策中隱藏的見解至關重要。

KG擅長明確地表示多種關系,一般使用三元組的形式:節點是實體,邊代表它們之間的關系,以下將這類復雜的結構統稱為GoT。

為了有效地使用GoT,我們需要對其組件進行有意義的編碼。

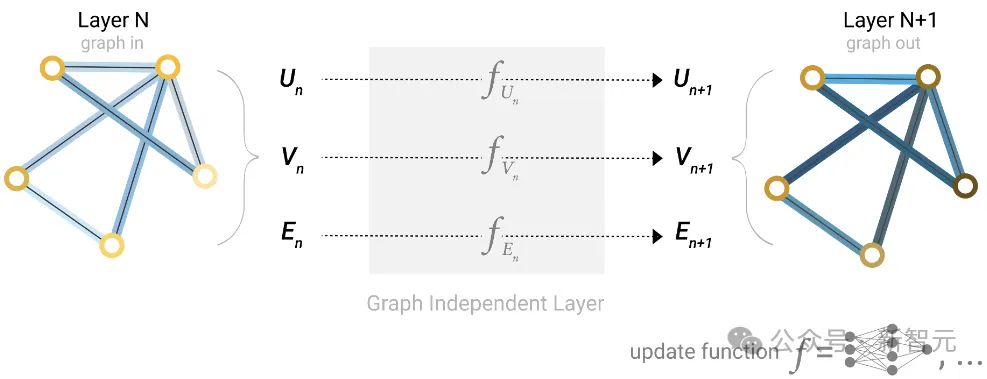

上面提到了利用語言模型和GNN的問題,本質上來說,兩種結構由不同的基本原理驅動,LM利用語義編碼,而GNN執行結構推理。

融合

在圖語言模型的設計中,作者通過文本和結構信息的早期融合來解決這個問題。

首先是使用LM現成的參數來初始化——一方面是保留預訓練的能力,另一方面是從頭訓練太貴了。

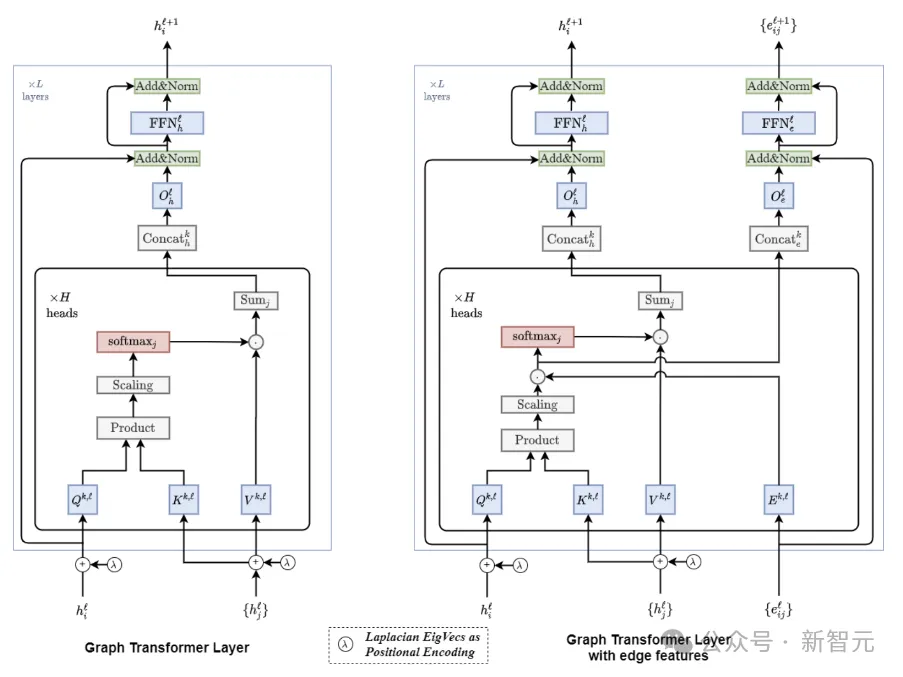

通過對LM的自注意力模塊進行一些非侵入性的更改,將LM轉換為Graph Transformers(GT),同時保持與其預訓練參數的兼容性。

在對圖進行編碼時,LM用來處理三元組線性組織的文本信息,而GT則沿著圖結構聚合信息。

因此,GLM繼承了LM對三元組的文本理解,而其中的GT模塊允許直接執行結構推理,無需額外的GNN層。

重要的是,文本序列可以看作一種特殊類型的圖,在GLM中的處理模式與原始LM相同。

Graph Transformer的設計

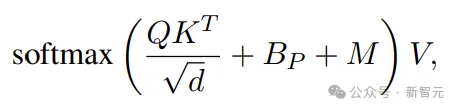

Self-Attention中的Attention可以寫成

除了熟悉的Q、K、V, Bp表示位置編碼,而M為mask矩陣。

在Transformer中,位置編碼 (PE) 用于通知語言模型文本中token的順序。

包括絕對PE(對token的絕對位置進行編碼)和相對PE(token對之間的相對位置),絕對PE通常加在輸入序列里面。

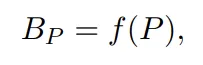

相對PE為每個可能的距離學習一個標量:

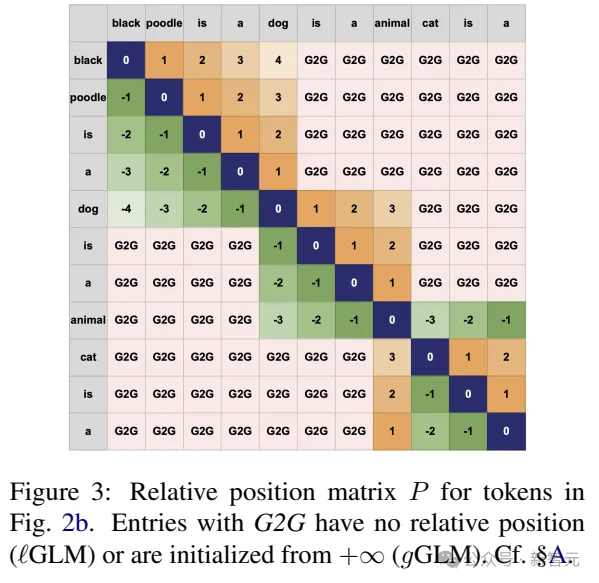

對于GT來說,定義圖中節點或邊的絕對位置并不簡單。因此,本文采用相對PE。

給定圖中的有向非循環路徑,我們可以將路徑上任意一對節點之間的距離定義為節點之間的跳數,也就獲得了相對距離(PE)。

M(mask)矩陣

在普通Transformer中,自注意力是針對輸入中所有可能的標記對進行計算的。

相比之下,GNN中的節點通常只關注相鄰節點,更遠的節點之間的信息必須跨多個GNN層傳播。

對于圖來說,這種稀疏消息傳遞方法有時是首選,因為在大多數圖中,鄰域大小隨著半徑的增加呈指數增長。

因此,在GT中引入圖先驗可能是有益的,比如只在局部鄰域計算自注意力(M中相連的節點對應設置為0)。

另一方面,事實證明,圖的全局視圖可以實現高效、遠程的信息流。所以作者搞了兩個版本:本地GLM和全局GLM。

如上圖所示,G2G的連接就屬于全局視野,本地GLM不處理這種關系。

在本地GLM中,自注意力機制僅限于來自同一三元組的token,而外部所有token的注意力都設置為 0(因此也不需要PE)。

盡管如此,因為屬于一個概念的token可以由多個三元組共享,所以消息可以通過圖跨多個層傳播(類似于GNN中的標準消息傳遞)。

所以即使非相鄰節點沒有直接連接,仍然可以通過消息傳遞共享信息。

比如,在第一個本地GLM層中,「狗」通過三元組「黑色貴賓犬是一只狗」和「狗是一種動物」來表示。那么,在第二層中,「動物」的表示會受到「黑色貴賓犬」的影響,盡管兩者之間沒有直接聯系。

另外,研究人員還形式化了全局GLM,(對標自注意力)可以將任何節點連接到每個其他節點。這種形式需要為任意token對設置PE,包括那些不在同一三元組中出現的token。

為此,全局GLM引入了新的圖到圖(G2G)相對位置。LM中沒有學習G2G連接的參數,因此這里使用相對位置( +∞ )來初始化參數,表示相應的token出現在文本段落中很遠的地方。

預處理

GT架構引入了圖先驗,而LM的參數初始化賦予了其語言理解能力。

對模型進行修改的整體思想是,三元組應該盡可能地類似于自然語言,以使LM能夠學習,而圖推理應該通過消息傳遞來工作。

類似于LM分詞器將文本轉換為詞表中的向量,GoT也需要同樣的處理以便GLM可以像LM那樣處理圖。

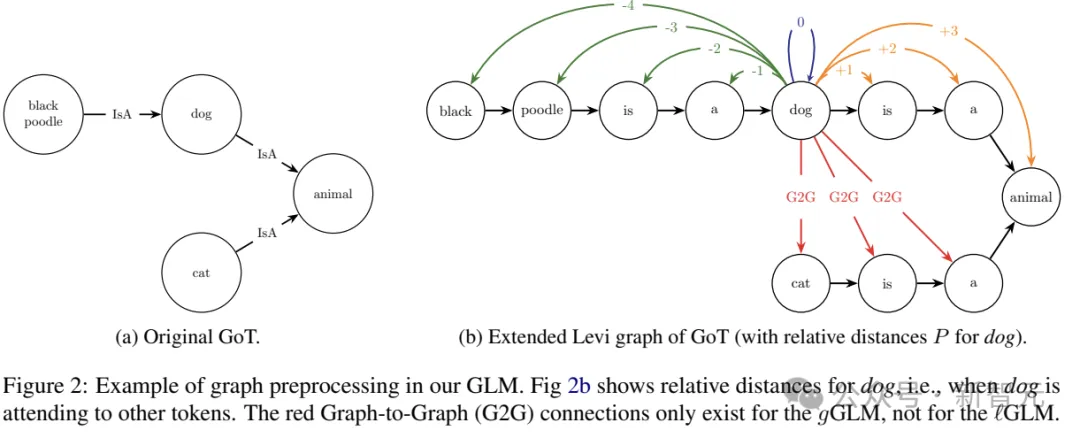

為了實現這一點,研究人員首先將GoT轉換為Levi圖,用包含關系名稱作為文本特征的節點替換每條邊,并將新節點連接到原始邊的頭部和尾部,保留原始邊的方向。

接下來,將每個節點拆分為多個節點,每個新節點對應單個token,建立新的邊連接相鄰節點,保留原來的方向。

在這種表示中,每個三元組都表示為一個token序列,就像標準LM一樣。

位置編碼

如前所述,使用token對之間的相對位置進行編碼,——只需將三元組視為一段文本,并計算該文本中的token距離。

請注意,轉換后GoT的token序列,不一定與輸入三元組的token序列完全相同。這里單獨對Levi圖中的每個節點進行標記,以確保多個三元組共享概念的一致。

當token不屬于同一個三元組時,為了確定這些token對之間的距離,之前的工作考慮了它們之間的最短路徑的長度。

然而,這中PE對于LM來說并不自然,因為如果在最短路徑中以錯誤的方向遍歷,三元組將以相反的順序出現。

因此,本文省略了不具有結構信息的token之間的PE,使用局部 (?GLM) 和全局 (gGLM)。

實驗結果

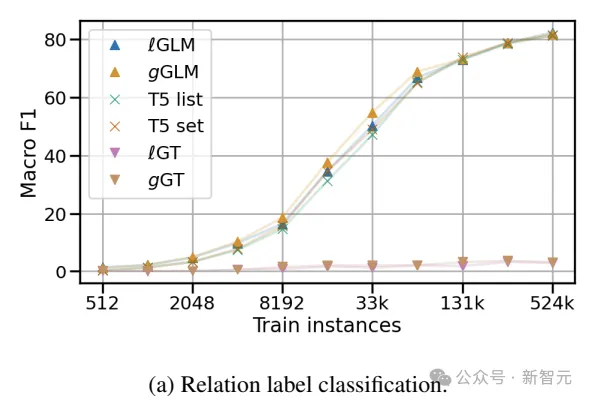

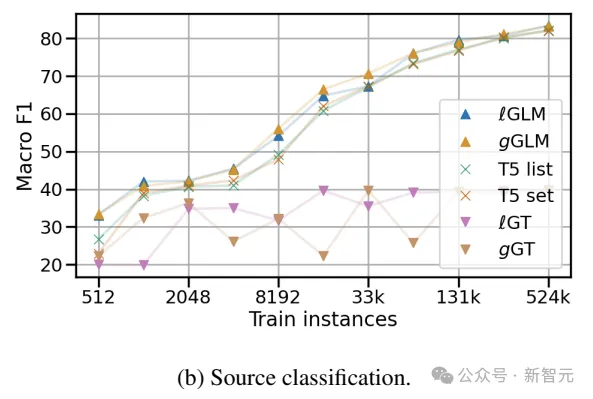

作者在兩個關系(標簽)分類實驗中評估了GLM嵌入GoT的能力(對哪個關系屬于給定的頭實體和尾實體進行分類)。

ConceptNet子圖實驗用來分析結構圖屬性的影響;而在維基數據子圖和相關維基百科摘要的實驗,用于測試文本和圖形交錯輸入的能力。

研究人員構建了一個平衡的英語CN子圖數據集,其中包含13,600個訓練實例、1,700個開發實例和1,700個測試實例,并以17個不同關系作為標簽,將要預測的關系替換為T5模型的第一個掩碼<extra_id_0>。

GLM對圖進行編碼,為每個token生成嵌入,線性分類頭根據掩碼的嵌入給出最終預測,這里使用靜態模板來表達未屏蔽的關系。

ConceptNet子圖中關系分類的實驗表明,GLM優于基于LM和GNN的編碼方法——即使繼承的LM參數在GLM訓練期間沒有更新。

維基數據子圖和維基百科摘要上的KG群體實驗表明,GLM可以對GoT和文本的交錯輸入進行推理,是LM所不具備的新能力。