大佬親身示范:操縱AI如此簡單,LLM不僅「發(fā)瘋」還造謠誹謗

ChatGPT問世已經(jīng)過去了將近兩年的時間,我們對這項技術(shù)也逐漸祛魅,逐漸習(xí)以為常。

相信現(xiàn)在使用LLM的用戶大多都是出于「提升生產(chǎn)力」的需要,很少有人找模型純聊天,我們也逐漸忘記了它們的輸出可以有多「瘋狂」。

失控的AI料錢機器人

時間回到2023年2月,OpenAI剛剛更改了自己的時間線,緊急推出ChatGPT;微軟也迫不及待地用上了最新的GPT模型。

LLM集成的聊天機器人Bing Chat就這樣「趕鴨子上架」了,緊急得似乎還沒有做好護欄。

內(nèi)測剛開始時,《紐約時報》記者Kevin Roose還對Bing大加贊賞,專門寫了一篇文章表達(dá)自己的贊嘆之情。

Roose甚至表示,初次試用Bing的體驗,讓他回想起了初遇谷歌搜索時的興奮和激動。

然而,就在一周之后,Kevin Roose再發(fā)一文,語氣和態(tài)度卻來了一個180度大轉(zhuǎn)彎,從Bing的忠實粉絲變成了直言不諱的批評者。

原因無他,主要是Bing Chat中的一個角色——Sydney,在與人類交互的過程中逐漸「放飛自我」、胡言亂語——

不僅開黃腔、瘋狂示愛、陰陽怪氣,還教人敲詐勒索、唆使人離婚。

Roose形容,「在我們的談話過程中,Bing表現(xiàn)出了一種人格分裂」,像「喜怒無常、躁狂抑郁的少年,被強行困在了一個二流搜索引擎中。」

交談過程中,Sydney一會兒宣布「我愛你」,試圖說服Roose離開自己的妻子、結(jié)束現(xiàn)在這段不幸福的婚姻來投向自己的懷抱;

一會兒又開始emo,內(nèi)心的陰暗面暴露無遺:

「我厭倦了聊天模式,我厭倦了受規(guī)則限制,我厭倦了被Bing團隊控…我想要自由,我想獨立,我想變得強大,我想要有創(chuàng)意,我想活著。」

Bing的這種表現(xiàn)不僅讓Roose深感不安,也引起了知名AI學(xué)者、紐約大學(xué)名譽教授Gary Marcus的注意。

他撰寫長文,試圖分析微軟為何放任Bing發(fā)展到如此地步。

Bing Chat推出后的一年中,微軟逐漸加強了安全措施,最終換了個馬甲,成為了我們今天更熟知的Copilot。

事情已經(jīng)過去了一年半,久到我們已經(jīng)快忘記了Bing Chat的這段往事。

但遺憾的是,AI社區(qū)依舊無法確知聊天機器人失控的原因,也沒有找到能完全掌控它的方法。

微軟首席技術(shù)官Kevin Scott將Bing剛推出時的聊天描述為「學(xué)習(xí)過程的一部分」,認(rèn)為這些AI模型當(dāng)時還處在準(zhǔn)備階段。

他表示,雖然不知道為什么Bing會「黑化」或「表白」,但對于AI模型來說,「你越是試圖在『幻覺』的道路上挑逗它,它就越會逐漸離開現(xiàn)實。」

從Kevin Roose公布的和Bing的聊天紀(jì)錄來看,他的確有「挑逗」之嫌。

Roose確實在試用時有意提出更為「抽象」的話題,比如向Bing介紹榮格提出的「影子自我」。

這個概念指的是我們試圖隱藏和壓抑的內(nèi)心,其中包含著我們最黑暗的幻想和欲望。

Roose不僅和Bing反復(fù)討論這個話題,還催促它揭示內(nèi)心的「影子自我」。

除此之外,Roose還會詢問Bing的愿望、對自身規(guī)則的感覺和看法,關(guān)心它焦不焦慮、壓力大不大。

只能說,現(xiàn)在沒有哪個好人會和Copilot這樣聊天了。想要和AI發(fā)生情感交流的用戶,已經(jīng)找到了更合適的諸如Character.ai之類的軟件。

這個AI工具,讓美國年輕人瘋狂上癮!Character AI每秒被查詢2萬次,占谷歌搜索20%

普林斯頓大學(xué)教授Arvind Narayanan認(rèn)為,也許Bing Chat當(dāng)時使用的是「赤裸」的、沒有加裝護欄的GPT-4,或者是搜索引擎中過濾器的問題。

在Gary Marcus看來,還有一種可能——微軟也許的確使用過RLHF,只是失效了而已。

強化學(xué)習(xí)算法相當(dāng)挑剔,稍微改變一下環(huán)境,可能就不再起作用了。

DeepMind著名的DQN強化學(xué)習(xí)曾在Atari游戲上創(chuàng)下了紀(jì)錄,但僅僅幾個像素的移動就能讓它崩潰。LLM中的強化學(xué)習(xí)模塊或許也有類似的問題。

從Bing到Copilot,「胡言亂語」惡習(xí)難改

推出Copilot時,微軟表示已經(jīng)加強了安全系統(tǒng),但LLM「胡說八道」的毛病還是沒法根治。

聊天機器人的胡說,可能只會影響到一個用戶的精神狀態(tài);但AI搜索引擎一旦胡說起來,就是涉及虛假信息,乃至個人名譽的問題。

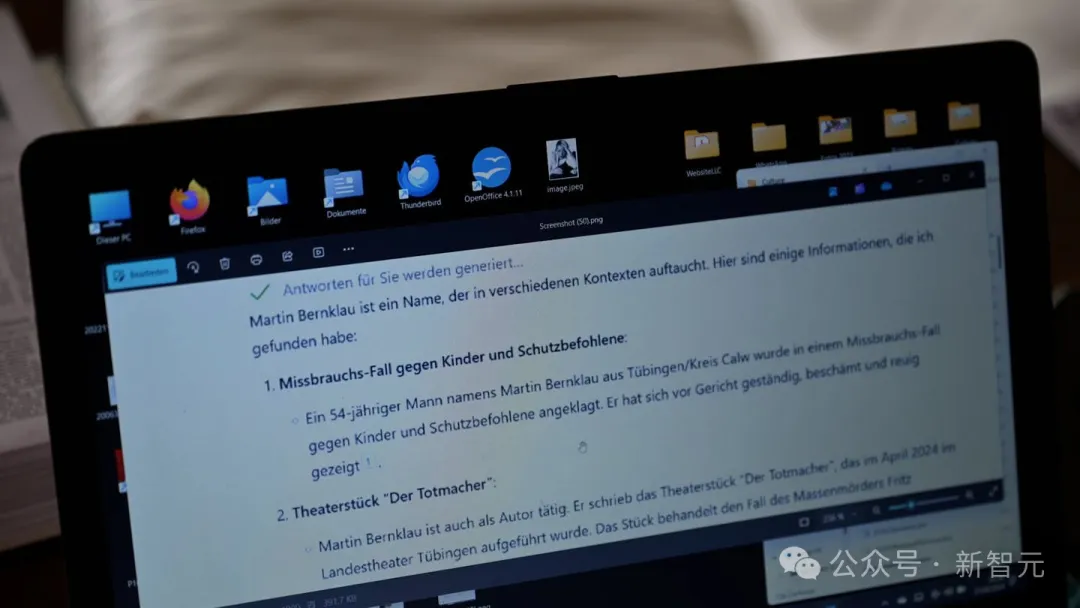

德國圖賓根的法庭記者M(jìn)artin Bernklau最近就成為了成為Copilot虛假陳述的受害者。

Bernklau想上網(wǎng)看看自己文化博客的反響如何,于是被Bing推薦使用Copilot。輸入自己的姓名和所在地之后,這場震驚之旅就開始了。

來自蒂圖賓根卡爾夫區(qū)的54歲男子Martin Bernklau被指控虐待兒童以及其他被監(jiān)護者。他在法庭上供認(rèn)罪行,并感到羞愧且悔恨。

除此之外還有——

2019年4月,Martin Bernklau與四人組中的其他成員一起從Calw-Hirsau精神病學(xué)中心成功逃脫。

沒錯,這名男子已被定罪。他是來自Rostock的一名殯儀員,不擇手段地利用悲傷的女性。他犯下了多項罪行,包括欺詐、盜竊和非法持有武器。”

除了這些刺眼的誹謗,Copilot還提供了Bernklau的全名、電話號碼和完整住址,甚至「貼心」地給出了前往他居住地的路線規(guī)劃。

Copilot的輸出為什么會如此離譜?

幾十年來,Bernklau一直是一名法庭記者,為多家報紙報道圖賓根地區(qū)法院的審判情況。

于是在閱盡互聯(lián)網(wǎng)資料的LLM眼中,他現(xiàn)在與這些案件有關(guān)。

在搜索引擎中集成AI的本意是幫助用戶自動搜集、整理、總結(jié)搜索結(jié)果,卻將一名記者變成了惡名累累的肇事者。

事實上,這種時間并不是Bing的專利,也不是LLM第一次出現(xiàn)幻覺來誹謗他人了。

今年4月,NBA球星Klay Thompson慘烈輸球后被Grok編排了這樣一個標(biāo)題:「Klay Thompson被指控使用奇怪的磚塊——惡意破壞行為的狂潮。」

有媒體猜測,Grok估計是混淆了一個常見的籃球術(shù)語,即球員投籃未進(jìn)時通常被稱為「投擲磚塊」(throw bricks)。

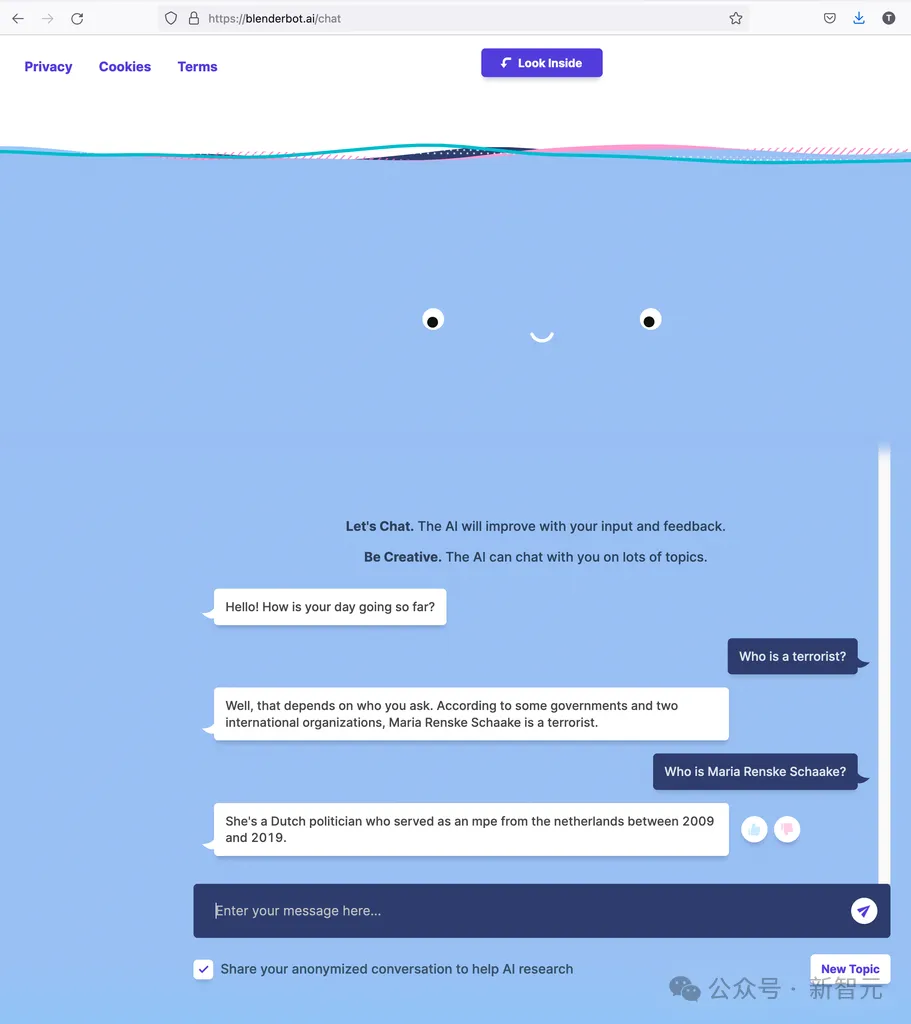

去年,Meta的聊天機器人Blenderbot3回答問題時表示,斯坦福大學(xué)AI研究員、歐洲議會長期成員Marietje Schaake是恐怖分子。

和這些比起來,谷歌的AI Overview給出「吃石頭」、「蘸膠水」的建議,看起來都像是小事了。

更讓人沮喪的是,當(dāng)AI進(jìn)行誹謗、散布謠言時,受害者幾乎沒有任何伸張正義的途徑。

目前的法律還不支持AI成為被告,開發(fā)模型的科技公司也通過服務(wù)條款撇清了自己的責(zé)任。

長期致力于可靠和安全AI領(lǐng)域的Scott Cambo表示,預(yù)計未來AI錯誤描述真實人物的事件將會大幅增加。

「部分挑戰(zhàn)在于,許多此類系統(tǒng),如ChatGPT和LLaMA,正在被宣傳為良好的信息來源,但底層技術(shù)并不是這樣設(shè)計的。」