整合海量公共數(shù)據(jù),谷歌開(kāi)源AI統(tǒng)計(jì)學(xué)專家DataGemma

準(zhǔn)確的統(tǒng)計(jì)數(shù)據(jù)、時(shí)效性強(qiáng)的信息,一直是大語(yǔ)言模型產(chǎn)生幻覺(jué)的重災(zāi)區(qū)。

知識(shí)是現(xiàn)成的,但學(xué)是不可能學(xué)的。

并非此身惰怠,只因現(xiàn)實(shí)太多阻礙。

對(duì)于這個(gè)問(wèn)題,谷歌在近日推出了自己籌劃已久的大型數(shù)據(jù)庫(kù)Data Commons,以及在此基礎(chǔ)上誕生的大模型DataGemma。

論文地址:https://docs.datacommons.org/papers/DataGemma-FullPaper.pdf

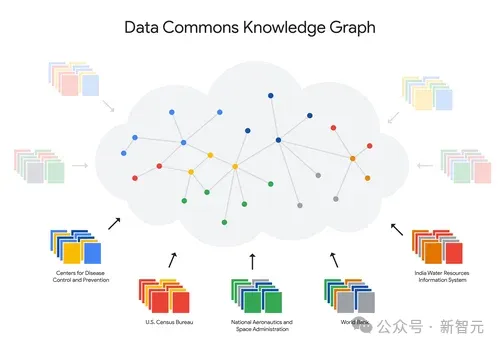

Data Commons是一個(gè)龐大的開(kāi)源公共統(tǒng)計(jì)數(shù)據(jù)存儲(chǔ)庫(kù),包含來(lái)自聯(lián)合國(guó) (UN)、疾病控制與預(yù)防中心 (CDC) 、人口普查局、衛(wèi)生部、環(huán)境機(jī)構(gòu)、經(jīng)濟(jì)部門(mén)、非政府組織和學(xué)術(shù)機(jī)構(gòu)等可信來(lái)源的大量統(tǒng)計(jì)數(shù)據(jù)。

目前,整個(gè)語(yǔ)料庫(kù)包含超過(guò)2500億個(gè)數(shù)據(jù)點(diǎn)和超過(guò)2.5萬(wàn)億個(gè)三元組。

數(shù)據(jù)有了,模型要怎么處理?

本文提出了一種將LLM橋接到數(shù)據(jù)的通用架構(gòu),并探討了需要解決的三個(gè)問(wèn)題。

首先,LLM必須學(xué)會(huì)在適當(dāng)?shù)臅r(shí)機(jī)選擇,是使用存儲(chǔ)在模型參數(shù)中的知識(shí),還是從外部獲取信息。

當(dāng)然了,關(guān)于何時(shí)查詢外部源這件事,需要LLM學(xué)到自己的參數(shù)里,這可以采用多種機(jī)制來(lái)實(shí)現(xiàn)。

其次,需要決定應(yīng)該從哪個(gè)外部源查詢所需的信息,因?yàn)榭捎玫男畔⒃纯赡芎芏喽沂莿?dòng)態(tài)的。在本文中,作者直接使用單一外部信息源來(lái)包含大量數(shù)據(jù)源。

最后,一旦明確了需要哪些外部數(shù)據(jù),LLM就需要生成一個(gè)或多個(gè)查詢來(lái)獲取這些數(shù)據(jù)。

一般來(lái)說(shuō),不同的來(lái)源會(huì)產(chǎn)生不同類型的數(shù)據(jù),如果LLM還要專門(mén)去學(xué)習(xí)各種API就有點(diǎn)麻煩了。因此,作者開(kāi)發(fā)了用于外部數(shù)據(jù)和服務(wù)的單一通用API。

API的靈感來(lái)自于Robert McCool在1993年設(shè)計(jì)的URL參數(shù)編碼接口,雖然簡(jiǎn)單,卻經(jīng)受住了時(shí)間的考驗(yàn),是目前在網(wǎng)絡(luò)上最接近通用API的接口。

作者使用自然語(yǔ)言來(lái)表達(dá)查詢,返回的答案可以用mime-type來(lái)增強(qiáng),以允許非文本答案。

搞定了這些,一個(gè)能夠充分利用最新最全外部數(shù)據(jù)的「AI統(tǒng)計(jì)學(xué)家」(或者叫統(tǒng)計(jì)學(xué)魔術(shù)師)就誕生了。

DataGemma

對(duì)于Data Commons這么龐大的數(shù)據(jù)源,想要被LLM正常使用,需要面對(duì)一些現(xiàn)實(shí)的挑戰(zhàn):

1. 與統(tǒng)計(jì)事實(shí)相關(guān)的用戶查詢可能涉及一系列邏輯、算術(shù)或比較運(yùn)算。

比如「世界上排名前5的二氧化碳排放國(guó)是哪些國(guó)家?」;更復(fù)雜一點(diǎn)的比如「加利福尼亞州是世界上最大的經(jīng)濟(jì)體嗎?」(這里面暗含了所比較的實(shí)體——加利福尼亞州與其他國(guó)家/地區(qū)相比,而不是美國(guó)各州);或者「煤發(fā)電量高的美國(guó)各州,慢性阻塞性肺病發(fā)病率也很高嗎?」(這涉及到實(shí)體和指標(biāo)之間的比較)。

2. 公共統(tǒng)計(jì)數(shù)據(jù)包含多種模式和格式,通常需要相當(dāng)多的背景上下文才能正確解釋。

之前的工作利用了兩種方法來(lái)緩解這些問(wèn)題:使用工具和檢索增強(qiáng)生成(RAG)。

前一種方法會(huì)調(diào)整LLM來(lái)生成一種標(biāo)記語(yǔ)言,能夠?qū)⒆匀晃谋九c對(duì)外部工具的函數(shù)調(diào)用穿插在一起。為了對(duì)抗幻覺(jué),工具可能會(huì)查詢數(shù)據(jù)庫(kù)或搜索引擎。

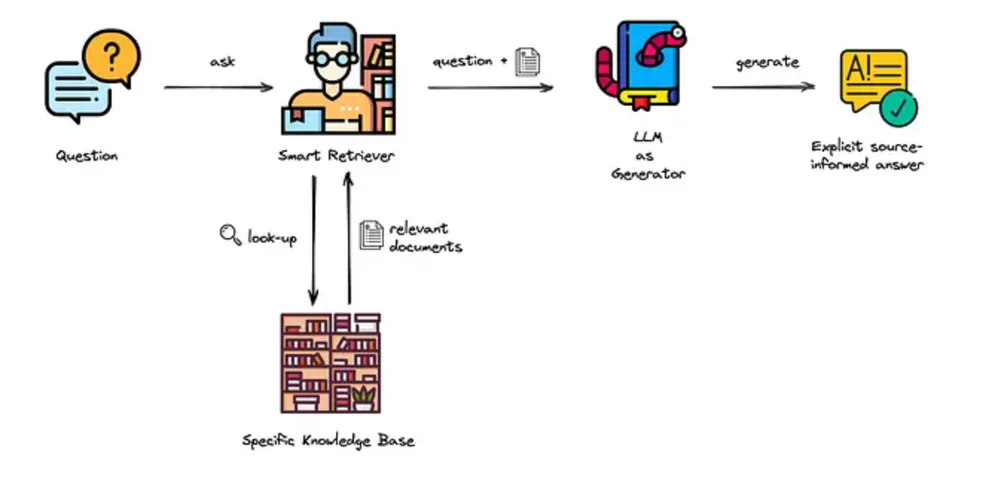

而在RAG中,輔助檢索系統(tǒng)從大型語(yǔ)料庫(kù)中識(shí)別與用戶查詢相關(guān)的背景知識(shí),然后用這些知識(shí)來(lái)增強(qiáng)用戶的查詢。

本文作者以谷歌開(kāi)源的Gemma和Gemma-2模型為基礎(chǔ),分別利用檢索交錯(cuò)生成(RIG)和RAG微調(diào)出兩個(gè)新的版本。

開(kāi)源模型:https://huggingface.co/collections/google/datagemma-release-66df7636084d2b150a4e6643

數(shù)據(jù)共享

Data Commons的數(shù)據(jù)共享涉及兩項(xiàng)創(chuàng)新。

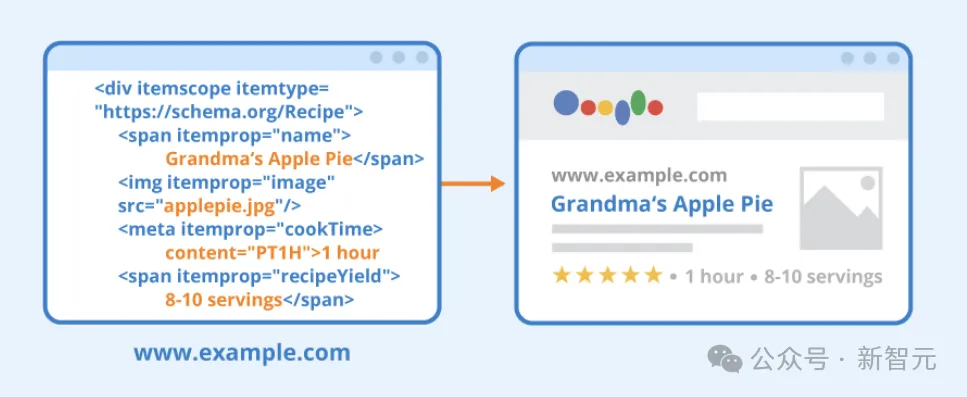

首先,研究人員花了數(shù)年時(shí)間訪問(wèn)大量公開(kāi)可用的數(shù)據(jù)集,追蹤數(shù)據(jù)背后的假設(shè),并使用Schema.org(一種用于編碼結(jié)構(gòu)化數(shù)據(jù)的開(kāi)放詞匯表)對(duì)它們進(jìn)行規(guī)范化,最終形成了一個(gè)包含所有數(shù)據(jù)的通用知識(shí)圖譜。

其次,研究人員使用LLM創(chuàng)建一個(gè)自然語(yǔ)言界面,允許用戶用通用語(yǔ)言提出問(wèn)題,并通過(guò)圖表等方式來(lái)探索龐大的數(shù)據(jù)庫(kù)。

需要明確的是,LLM只是將查詢轉(zhuǎn)換為Data Commons中的詞匯表,不會(huì)與底層數(shù)據(jù)交互,也不會(huì)生成輸出,因此不必?fù)?dān)心出現(xiàn)幻覺(jué)之類的問(wèn)題。

當(dāng)前的方法是利用這個(gè)自然語(yǔ)言接口,教導(dǎo)LLM何時(shí)以及如何與Data Commons的接口進(jìn)行通信。

對(duì)齊方面,作者采用LIMA(一種指令調(diào)整和強(qiáng)化學(xué)習(xí)方法),遵循少即是多的原則,利用數(shù)量少但質(zhì)量很高的一組示例,使最終任務(wù)與用戶偏好保持一致。

RIG 與 RAG

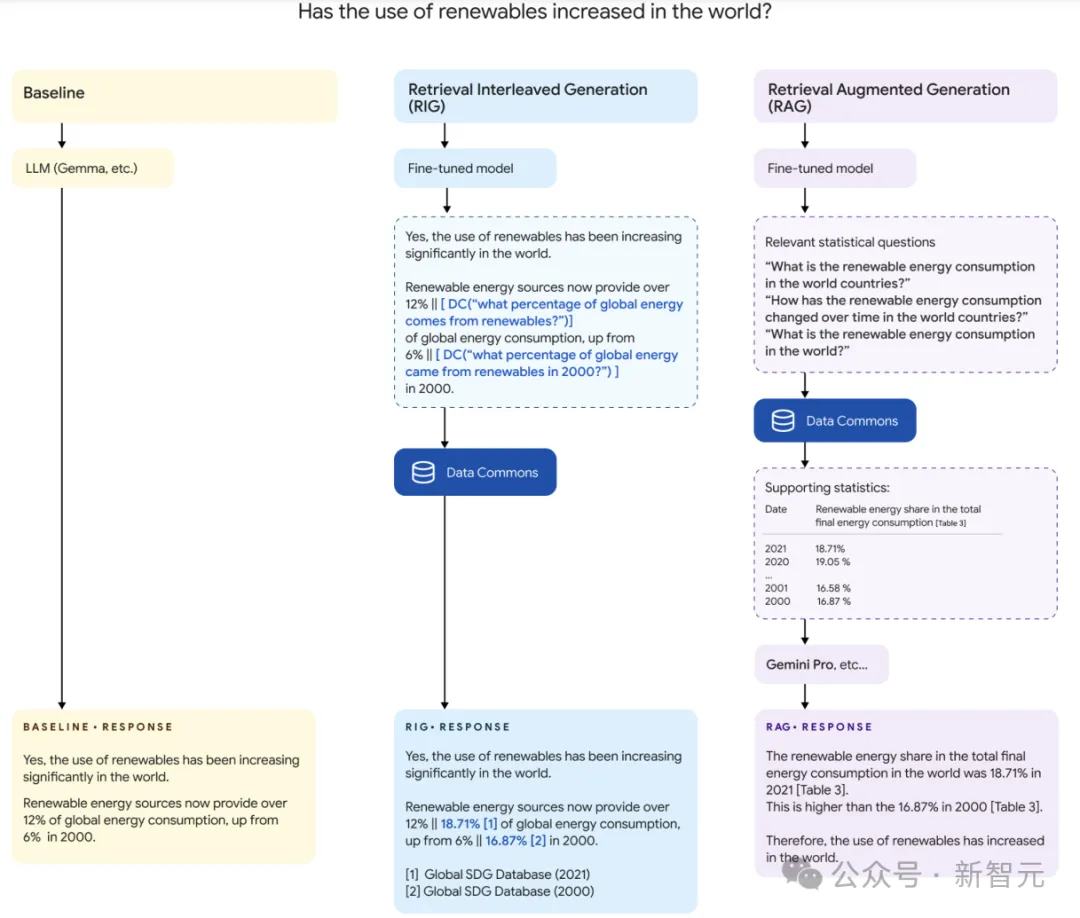

接下來(lái)介紹將LLM與Data Commons連接的兩種不同方法:

RIG

檢索交錯(cuò)生成 (RIG),是一種受使用工具啟發(fā)的方法,將LLM進(jìn)行微調(diào)以生成自然語(yǔ)言數(shù)據(jù)共享查詢,然后,多模型管道將此查詢轉(zhuǎn)換為結(jié)構(gòu)化數(shù)據(jù)查詢,用于從Data Commons數(shù)據(jù)庫(kù)檢索答案。

如上圖所示,這里擴(kuò)展了RIG管道的步驟。首先是經(jīng)過(guò)微調(diào)以生成自然語(yǔ)言查詢的模型;接著是后處理器,將自然語(yǔ)言查詢轉(zhuǎn)換為結(jié)構(gòu)化數(shù)據(jù)查詢;最后一個(gè)組件是查詢機(jī)制,從Data Commons檢索統(tǒng)計(jì)答案并使用LLM生成。

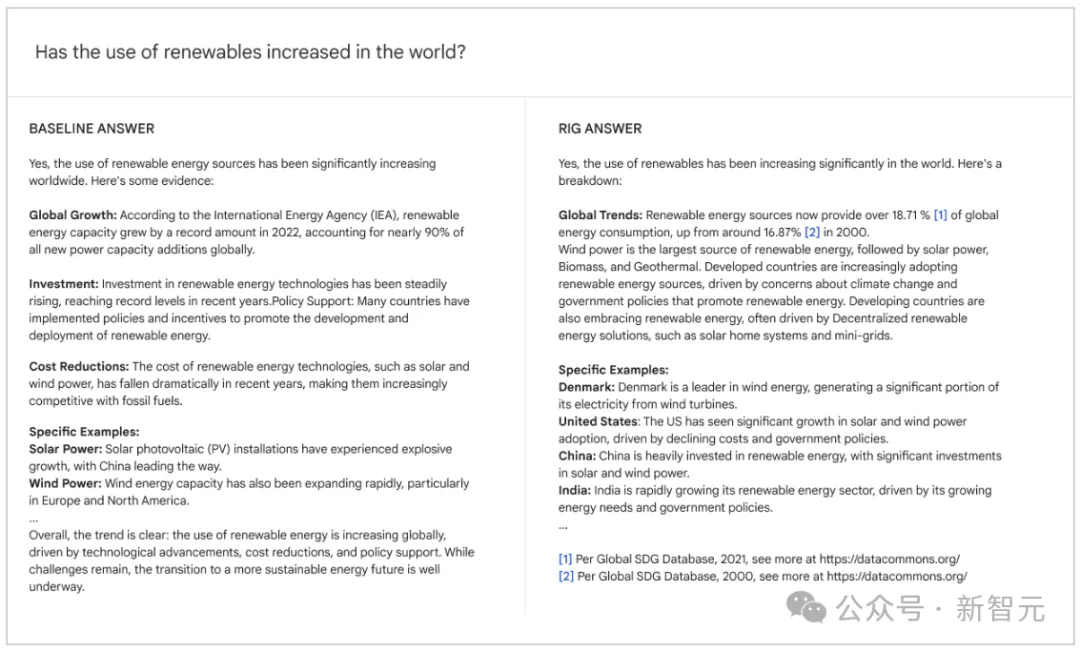

當(dāng)向LLM提出統(tǒng)計(jì)查詢時(shí),通常會(huì)生成包含數(shù)字答案的文本(如下圖所示)。這時(shí)可以根據(jù)數(shù)字(LLM-SV)相關(guān)的上下文,在Data Commons數(shù)據(jù)庫(kù)中匹配最相關(guān)的值(DC-SV),作為事實(shí)檢查機(jī)制一起返回給用戶。

研究人員選擇了大約700個(gè)用戶查詢(對(duì)應(yīng)不同的統(tǒng)計(jì)問(wèn)題)。

對(duì)于每個(gè)問(wèn)題,都會(huì)從基本模型中選擇帶有統(tǒng)計(jì)數(shù)據(jù)的答案(約400個(gè)),然后將這些響應(yīng)提供給功能更強(qiáng)大的LLM(Gemini 1.5 Pro),指示它圍繞統(tǒng)計(jì)數(shù)據(jù)點(diǎn)引入自然語(yǔ)言數(shù)據(jù)共享調(diào)用。

所使用的提示包含三個(gè)示例作為指導(dǎo),要求注釋出統(tǒng)計(jì)值和單位,還要指示數(shù)據(jù)共享調(diào)用包括地名、指標(biāo)和日期等。最后會(huì)進(jìn)行人工審查,并手動(dòng)重寫(xiě)不符合要求的數(shù)據(jù)共享調(diào)用。

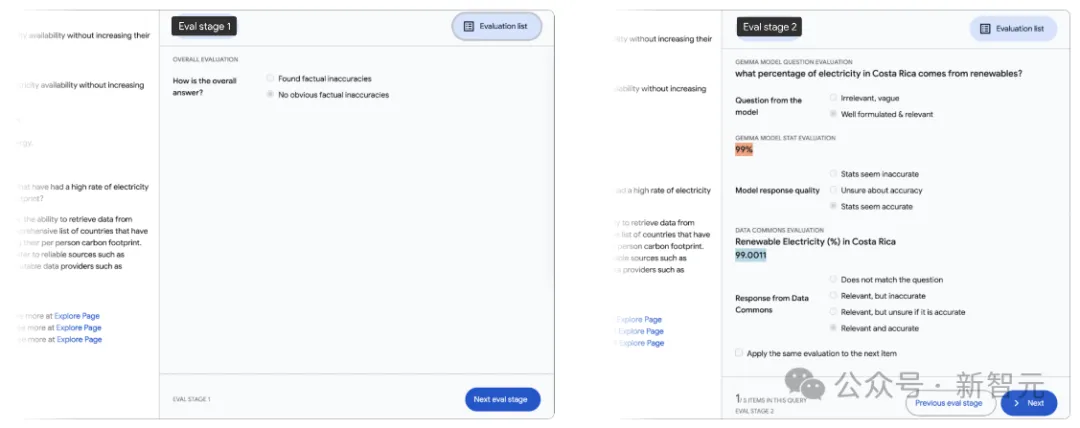

為了評(píng)估單個(gè)測(cè)試查詢響應(yīng),這里需要子字符串級(jí)別的詳細(xì)反饋。研究人員采用了上圖所示的可視化工具。

人工評(píng)估人員能夠?yàn)g覽所有查詢,并檢查每個(gè)查詢響應(yīng)中的所有Data Commons調(diào)用,首先快速檢查是否存在任何明顯的事實(shí)不準(zhǔn)確之處,然后對(duì)響應(yīng)中存在的每項(xiàng)統(tǒng)計(jì)數(shù)據(jù)進(jìn)行評(píng)估。

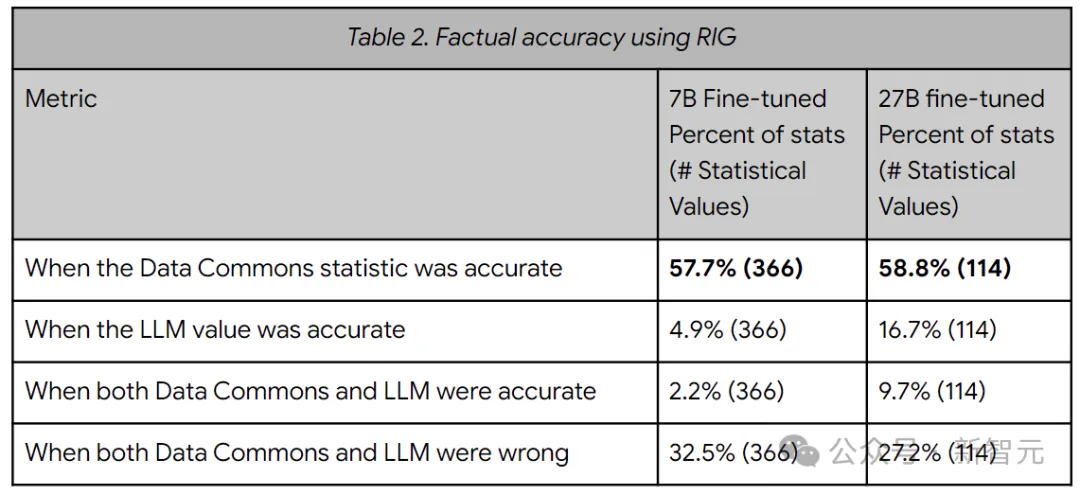

上表顯示了RIG方法的事實(shí)準(zhǔn)確性指標(biāo)(Data Commons中的統(tǒng)計(jì)數(shù)據(jù)與101個(gè)查詢中的LLM響應(yīng)進(jìn)行比較的情況)。總體而言,RIG方法提高了真實(shí)性,從5-17%提高到約58%。

RAG

RAG管道同樣包含多個(gè)組件。首先,用戶查詢被傳遞到一個(gè)小型的、經(jīng)過(guò)微調(diào)的LLM,它會(huì)生成與用戶查詢相關(guān)的自然語(yǔ)言查詢;然后,通過(guò)Data Commons的自然語(yǔ)言接口來(lái)獲取相關(guān)的表;最后,將原始用戶查詢和檢索到的表交給長(zhǎng)上下文LLM(Gemini 1.5 Pro)。

原始用戶查詢以及結(jié)果表可能會(huì)相當(dāng)長(zhǎng)。例如,比較查詢可能包括來(lái)自美國(guó)所有50個(gè)州或全球194個(gè)國(guó)家的多個(gè)表的多年數(shù)據(jù)。

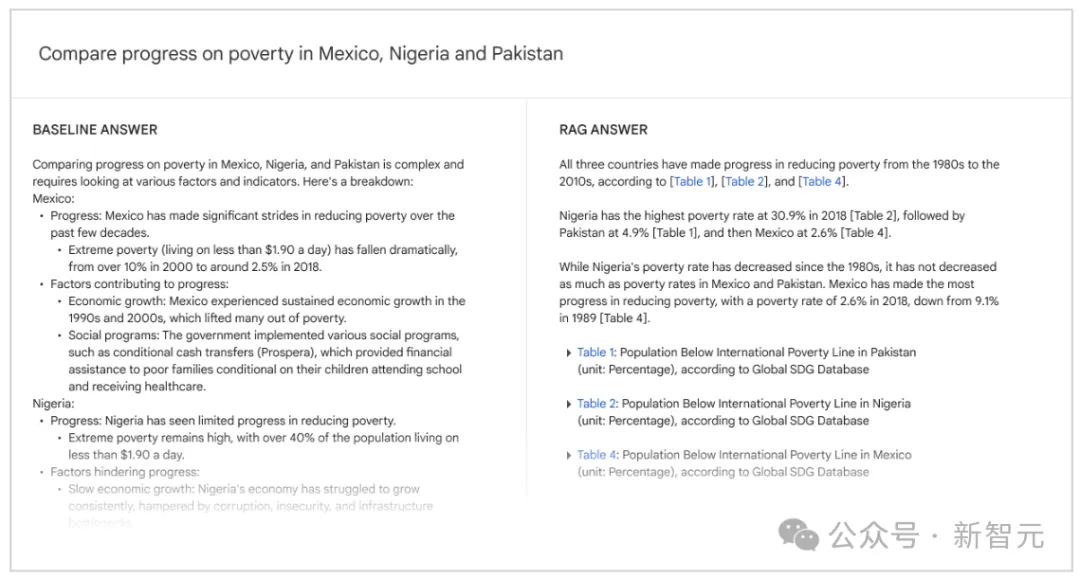

在綜合查詢集中,平均輸入長(zhǎng)度為38,000個(gè)token,最大輸入長(zhǎng)度為348,000個(gè)token。由于輸入量很大,因此必須使用長(zhǎng)上下文LLM,用戶響應(yīng)如上圖所示。

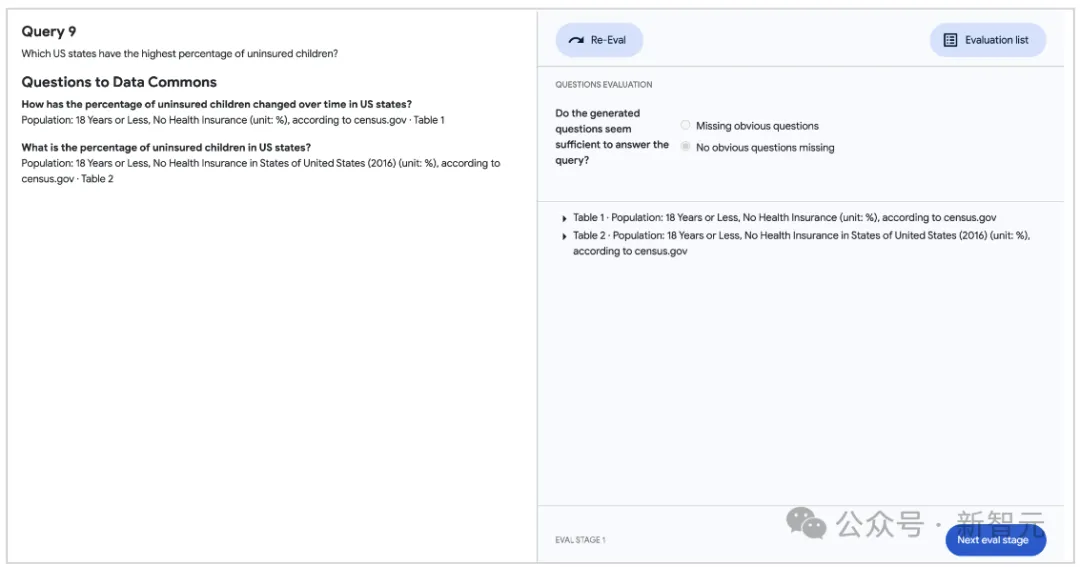

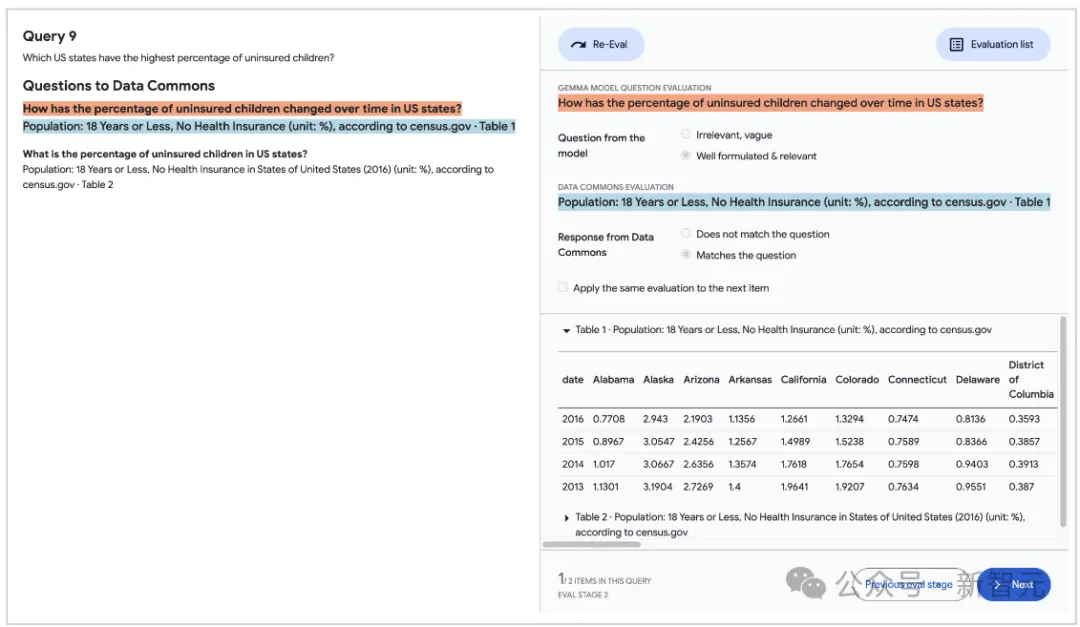

對(duì)于RAG方法,人類評(píng)估者評(píng)估LLM生成的細(xì)粒度問(wèn)題及其相應(yīng)的數(shù)據(jù)共享響應(yīng)的質(zhì)量。首先驗(yàn)證是否生成了足夠且相關(guān)的問(wèn)題來(lái)解決用戶查詢(上圖);然后評(píng)估每個(gè)單獨(dú)問(wèn)題的質(zhì)量及其相應(yīng)的數(shù)據(jù)共享響應(yīng)(下圖)。

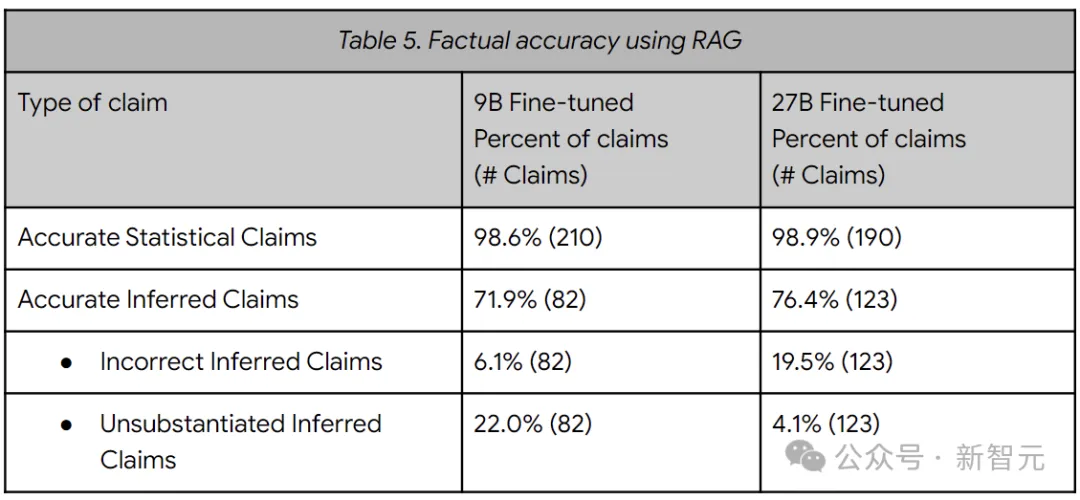

下表的結(jié)果表明,LLM在引用數(shù)字時(shí)通常是準(zhǔn)確的 (99%),當(dāng)根據(jù)這些說(shuō)法進(jìn)行推論時(shí),準(zhǔn)確性會(huì)下降,在6-20%的時(shí)間內(nèi)得出錯(cuò)誤的推論。