不靠更復雜的策略,僅憑和大模型訓練對齊,零樣本零經驗單LLM調用,成為網絡任務智能體新SOTA

網絡智能體旨在讓一切基于網絡功能的任務自動發生。比如你告訴智能體你的預算,它可以幫你預訂酒店。既擁有海量常識,又能做長期規劃的大語言模型(LLM),自然成為了智能體常用的基礎模塊。

于是上下文學習示例、任務技巧、多智能體協同、強化學習算法…… 一切適用于通用智能體的想法都搶著在大模型落地。

然而有一個問題始終橫亙在 LLM 和智能體之間:基于 LLM 的網絡智能體的行動 / 觀測空間與 LLM 訓練數據的空間相去甚遠。

智能體在充斥著具身行為的行動空間(如鼠標懸停、鍵盤組合鍵)和遍布前端功能強化、格式渲染的觀測空間下運作,大語言模型的理解和推理能力能充分發揮作用嗎?尤其是大語言模型的主要訓練任務是文本補全、問答和對齊人類偏好,這一點值得思考。

來自伊利諾伊大學香檳分校和亞馬遜的研究人員選擇和這些問題進一步對話。他們去除了上下文示例、技巧、多智能體系統,僅僅通過行動 / 觀測空間與 LLM 的訓練任務對齊。他們訓練的 AgentOccam 成為了零樣本基于 LLM 的網絡智能體新 Sota。

幫你寫email

幫你找導師

這正呼應了奧卡姆剃刀原則:「若無必要,勿增實體」。然而換個思考的角度,AgentOccam 的研究團隊也想發問:構建通用智能體時,在鋪設復雜的系統框架前,是否已經優化了行動 / 觀測空間,讓這些功能模塊達到了最優狀態?

- 論文鏈接:https://arxiv.org/abs/2410.13825

- 論文名:AgentOccam: A Simple Yet Strong Baseline for LLM-Based Web Agents

背景及動機

某天你刷著短視頻,看中了主播手中拿著的商品。于是,你興致勃勃地對智能助手說:「我是學生,讓這個老板送我一張優惠券!」

隨后,智能體申請了你的私人賬號權限、后臺私信商家、繪聲繪色地寫下「我是學生」,發送消息,一套動作無需人為干預,行云流水......一切這樣的任務,再也不必動手,都有智能體代勞。

大語言模型是構建智能體的熱門選擇。過去,基于 LLM 的網絡智能體通常專注于讓智能體學會某種應用,比如構建上下文學習樣本、積累任務經驗與技巧、以及多智能體角色扮演等等。然而,在實際交互中,智能體的行動 / 觀測空間與 LLM 的技能點不太匹配,這之間的差距卻少有人研究。

于是,針對如何對齊基于 LLM 的網絡智能體的觀測和行動空間與其訓練期間學到的功能,來自伊利諾伊大學香檳分校和亞馬遜的研究人員們展開了研究。

網絡智能體需要準確地從格式各異、編碼腳本不一的網頁中提取信息,并在網頁上定義的動作(例如,鼠標滑輪滾動、點擊或懸停在按鈕上)中進行選擇。這些網絡觀測和行動空間在 LLM 的預訓練和后續訓練數據中都較為罕見,這阻礙了 LLM 充分調動潛能,完成任務。

因此,基于不讓智能體策略變得更復雜,而是讓智能體與 LLM 更加匹配的想法,由此構建的智能體得名 AgentOccam。

形式化與方法

該團隊通過部分可觀測的馬爾可夫決策過程(POMDP),將網絡交互過程形式化為:<O,S,A,P,R,p_0,γ>。

在 POMDP 中,觀測 o∈O 是智能體從網絡環境接收到的信息,例如 HTML,以及任何指令和提示。行動 a∈A 是網絡環境認可的動作指令。

為解決 POMDP,常見目標是尋找策略 ,最大化預期累積獎勵,其中 h_t 表示觀測歷史

,最大化預期累積獎勵,其中 h_t 表示觀測歷史 。

。

在基于 LLM 的網絡智能體設計中,這等價于借助一個或多個基礎 LLM 策略

和一組算法模塊來設計策略 。

。

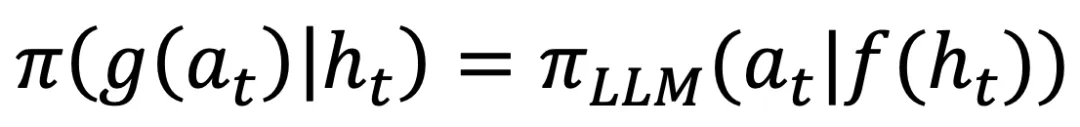

在這項工作中,該團隊專注于一類特殊的策略,可以表示為: ,其中 f 和 g 是處理觀測和行動空間的基于規則的函數,該團隊將其稱為「觀測和行動空間對齊問題」。

,其中 f 和 g 是處理觀測和行動空間的基于規則的函數,該團隊將其稱為「觀測和行動空間對齊問題」。

在這樣的問題設置下,接下來的所有更改僅應用于觀測和行動。值得注意的是,并非所有以往方法中的智能體策略都能以這種方式表示。

例如上表中,基于搜索的算法需要一個頂層控制程序來選擇行動并觸發回溯;帶有評估器、反思或記憶模塊的方法也需要一個管理中心來在主 LLM 和這些輔助模塊或其他角色扮演 LLM 之間切換。

不同于以往復雜化智能體策略,我們能否僅通過優化觀測和行動映射 f 和 g,使用基礎 LLM 策略  構建一個強大的網絡智能體?這是 AgentOccam 關注的問題。

構建一個強大的網絡智能體?這是 AgentOccam 關注的問題。

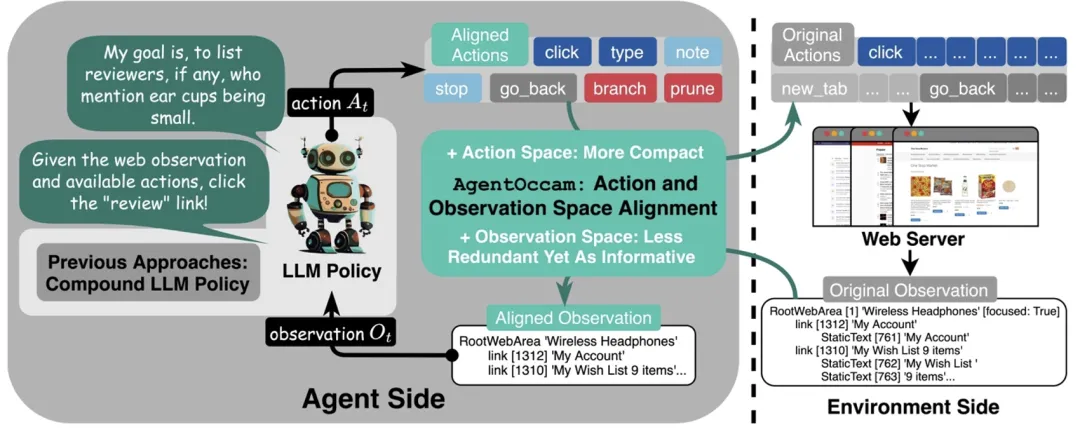

如上圖所示,AgentOccam 包括三個組成部分:

- 首先,減少非必要的網絡交互動作,讓智能體的具身和瑣碎互動需求達到最小;

- 其次,消除冗余和不相關的網頁元素,并重構網頁內容塊,以獲取更簡潔但同樣信息豐富的表示,從而精煉觀察空間;

- 最后,引入兩個規劃動作(分支和修剪),這使得智能體能夠以規劃樹結構自組織導航工作流,并使用相同結構過濾歷史步以進行回放。

整個框架通過一套適用于所有標記語言的通用規則來格式化網頁,無需依賴測試基準中的任務相關信息。

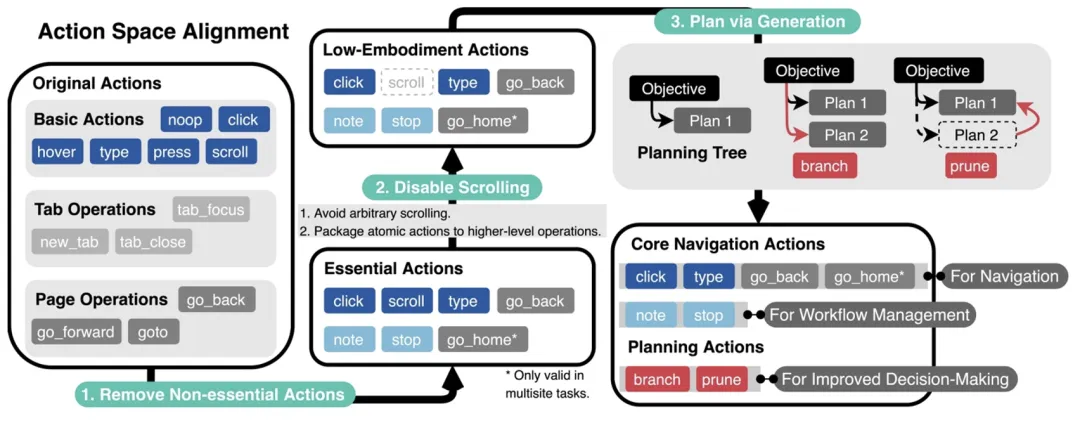

網絡智能體的行動空間規定了可以用來與網絡環境交互的有效命令。

研究團隊從智能體常見的失敗中得出總結:想要成功完成任務,需要編輯行動空間來解決兩個關鍵問題:第一,去除 LLM 難以理解且經常誤用的無關行動;第二,當執行任務需要規劃、嘗試多個潛在路徑時,要提高智能體的記憶和規劃能力。

為此,該團隊提出了對應的解決方法。第一個問題可以通過簡單地移除或合并操作來解決(如上圖中的步驟 1 和 2)。對于第二個問題,過去的研究通常依賴人工制定規則或任務技巧,但這些方法難以泛化。在本研究中,LLM 將自主生成計劃和管理任務流程(如步驟 3 所示)。

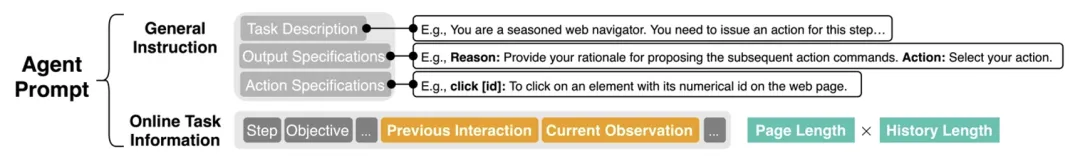

AgentOccam 的觀測空間(提示詞)包含了任務概述的通用指令、期望的輸出和可用操作說明,以及關于當前任務目標、智能體過去的交互記錄和最新的觀察信息。

過往互動和當前觀測的部分占據了最多的字符數。這主要歸因于兩個因素:單頁面的長度和歷史跨度的范圍,這是 AgentOccam 觀測空間的主要優化對象。

網頁標記語言主要用于前端加載和渲染,往往包含大量格式化字符,顯得冗余且重復(如上圖步驟 1 所示)。因此,此時的目標是優化這些表示方式,使得單頁內容對 LLMs 更加簡潔易讀。

將觀測歷史作為輸入,對于執行長程任務至關重要。因為一些關鍵信息可能不會顯示在當前頁面上。然而,觀測歷史也會顯著增加上下文長度,并增加推理難度以及推斷成本。

為了解決這個問題,設置僅選擇先前網頁上最重要和相關的信息,這一選擇依據兩個規則,分別基于關鍵節點和規劃樹,見于步驟 2 和 3。

結果

研究團隊在 WebArena 上評估了 AgentOccam 性能。WebArena 含有 812 項任務,橫跨網購、社交網站、軟件開發、在線商貿管理、地圖等。

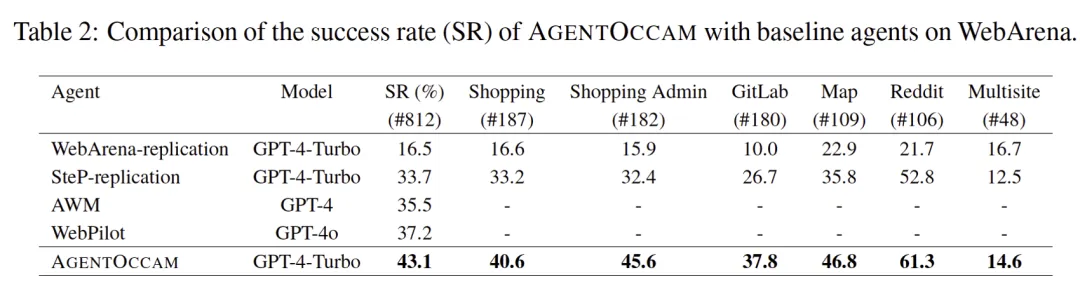

測試對象為 AgentOccam 框架下的 GPT-4-Turbo。對比的基線包括:一、WebArena 隨配智能體,二、SteP,前 WebArena 上最優智能體,涵蓋 14 條人類專為 WebArena 任務編寫的技巧,三、多智能體協同方法 WebPilot;四、總結智能體交互經驗的工作 AWM。

從上表不難看出,AgentOccam 性能優于以往及同期工作。其中,AgentOccam 分別以 9.8(+29.4%)和 5.9(+15.8%)的絕對分數領先往期和同期工作,并且通過其觀測與行動空間的對齊,使得相似的基本網絡智能體的成功率提高了 26.6 點(+161%)。

消融實驗

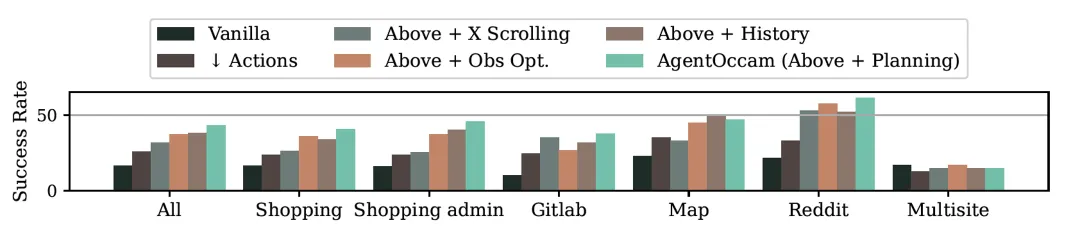

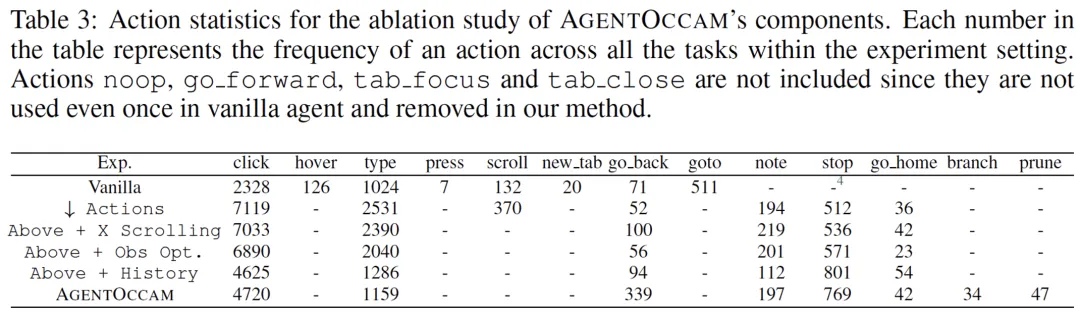

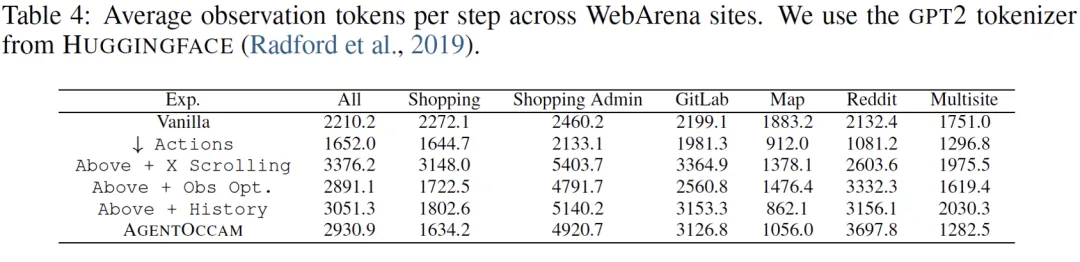

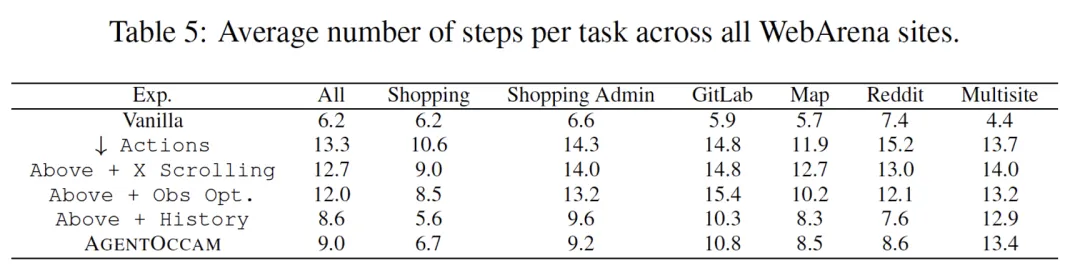

逐模塊對比行動與觀測空間的對齊對最終結果的貢獻。從下表可以看出,行動空間對齊能使智能體完成更多 click、type 等引導環境變化的動作,觀測空間對齊則減少大模型調用的字符數與智能體完成任務所需的步數。

LLM-as-a-Judge

研究團隊發現,智能體的決策行為波動性很強。簡而言之,面對一個目標,智能體有一定概率做出正確的行為決斷,但由于 token 預測的隨機性,它可能做出一些高成本、低回報的決定。這也導致它在后續步驟中難以糾正之前的錯誤而失敗。

例如,要求智能體在某個最相關的話題下發布帖子,單次 LLM 調用的 AgentOccam 往往輕率地選擇話題,未考慮「最相關」的要求。

為了解決此類問題,他們引導 AgentOccam 生成單步內所有可能的行動,這系列行動將交付另一個 Judge 智能體(同樣調用 GPT-4-turbo)決斷,做出最大化回報的選擇。

與復合策略結合使用

復合策略中,與任務相關的經驗可以提升智能體性能。同時,不因為加入了更多背景知識擾亂決策,不會影響泛化性,能夠糾正錯誤行為模式。

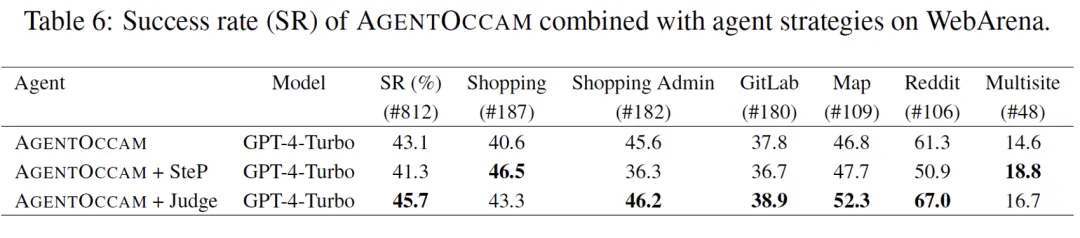

由于行為 / 觀測空間對齊和復合策略方法正交,因此能結合利用。該團隊試驗將 AgentOccam 與 1)SteP 和 2)上述的 LLM-as-a-Judge 方法聯合使用。

對于和前 SOTA 方法 SteP 聯合,由于它引入人類編寫的 WebArena 任務攻略,在經驗密集型任務,如購物網頁任務中,人類撰寫的引導性經驗大幅提升任務成功率。

而在常識泛化密集型任務,如社交網頁發帖任務中,不相關知識出現會錯誤擾亂智能體決策。對于 LLM-as-a-Judge 方法,Judge 角色的引入不影響智能體的泛化性,同時糾正了智能體倉促決策的錯誤行為模式,在 WebArena 上進一步提升 2.6 的絕對分數。