過程獎勵模型PRM成版本答案!谷歌DeepMind全自動標注逐步驟獎勵PAV,準確率提升8%

在提升大型語言模型(LLM)在數學推理方面的能力時,一個常用的方法是訓練一個獎勵模型(reward model)或驗證器(verifier),也可以利用強化學習在測試階段(test-time)對所有解決方案進行重排序。

通常情況下,驗證器的預測是整個推理過程的結果,即結果獎勵模型(ORM,outcome reward models),但這種獎勵信號過于稀疏,模型難以從中學習,并且搜索過程的效率也不高;理論上,通過細粒度的監督數據可以緩解這一問題。

在推理方面,先前有研究已經訓練了過程獎勵模型(PRMs,process reward models),在搜索的每一步或在強化學習期間分配中間獎勵,不過PRM數據都來源于人工標注,不具備可擴展性。

雖然也有研究者訓練PRMs來預測自動生成的標注,類似于強化學習中的價值函數,但到目前為止,自動化的PRMs與ORMs相比,性能僅僅提高了1-2%,引發了業界對該技術的質疑。

PRM可以用來執行搜索,或者作為密集獎勵(dense rewards)來提升基礎策略,所以問題的核心變成了:到底該「如何設計流程獎勵」?

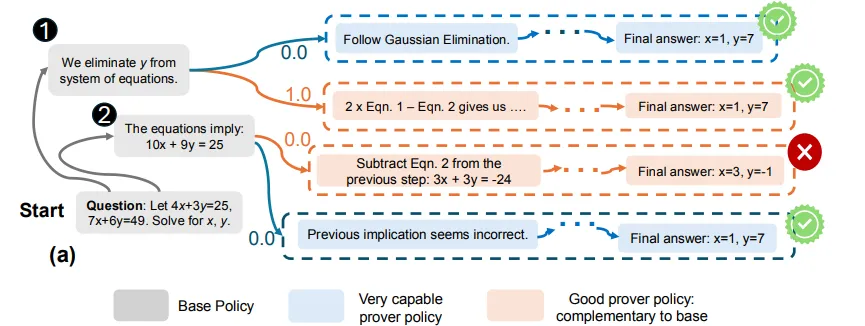

最近,Google Research、Google DeepMind和卡內基梅隆大學的研究人員聯合發布了一篇論文,主要思路是,每一步的過程獎勵都應該對整個過程進行度量:在采取該步驟「之前」和「之后」,模型在生成正確回復概率(likelihood)的變化程度,對應于強化學習中步驟級別優勢(step-level advantages)的概念;最重要的是,該過程應該根據與基本策略(basic policy)不同的證明政策(prover policy)來度量。

論文鏈接:https://arxiv.org/pdf/2410.08146

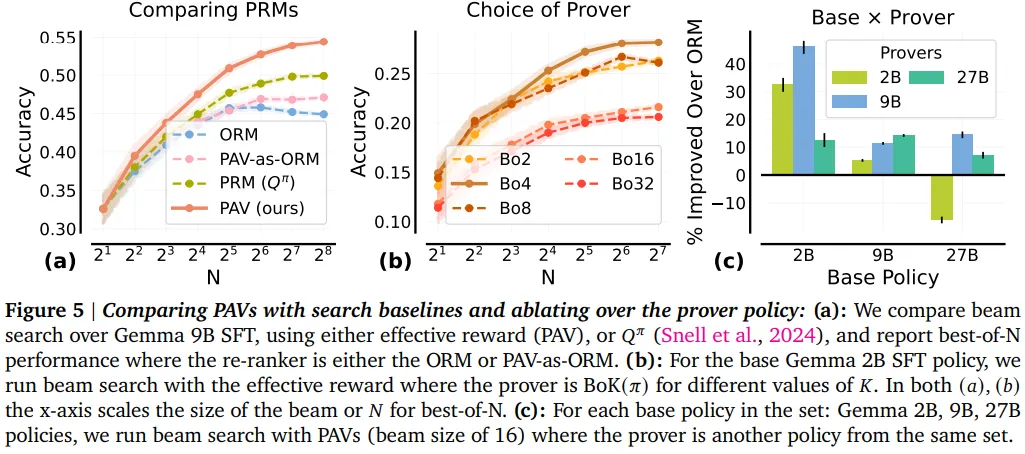

研究人員從理論上描述了一組好的證明器,并用實驗證明了,優化來自證明器的過程獎勵可以改善測試時搜索和在線強化學習期間的探索,并且可以通過經驗觀察到,弱證明器策略可以顯著改善更強的基礎策略。

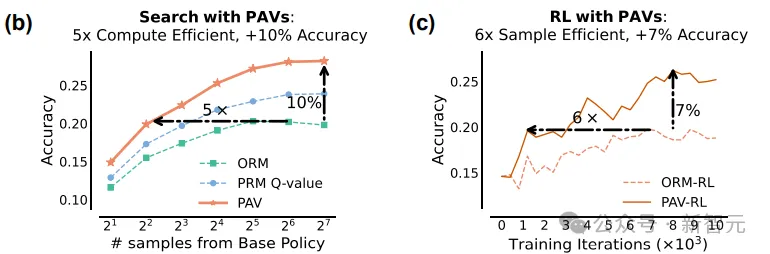

通過訓練過程優勢驗證器 (PAV,process advantage verifiers) 來預測證明器的過程,結果表明,與 ORM 相比,針對 PAV 的測試時搜索準確率提升了8%,計算效率提升了1.5到5倍;使用PAV的密集獎勵進行在線RL,實現了在樣本效率上5-6倍的提升,比ORM的準確率提升了6%

定義過程獎勵

為了解決前面提到的獎勵不確定性,研究人員訓練了帶有自動標注的過程獎勵模型(PRMs),以便在測試時搜索和在線強化學習(RL)期間,通過優化訓練后的PRMs提供的密集獎勵來提高基礎策略的計算和樣本效率。

為此,文中主要解決了兩個問題:

1. 每一步的過程獎勵應該度量(measure)什么?

2. 應該使用什么樣的自動數據收集策略來訓練預測PRMs?

傳統的方法主要通過度量數學正確性或步驟的相關性來實現的,但這種監督信號是否能夠最大程度地改進基礎策略尚不清楚,例如策略可能需要生成重復的,在測試時搜索和RL期間不正確的步驟來探索和發現最終答案。

研究人員的關鍵想法是,衡量逐步驟過程獎勵(在采取步驟之前和之后到達正確最終答案的可能性的變化),對于測試時的beam search和在線強化學習都是有效的。

強化那些不管是在正確或錯誤軌跡中出現都取得進展的步驟,可以在最初步驟中多樣化可能答案的探索(exploration),在解決問題方法不明確時可以起到很重要的作用。

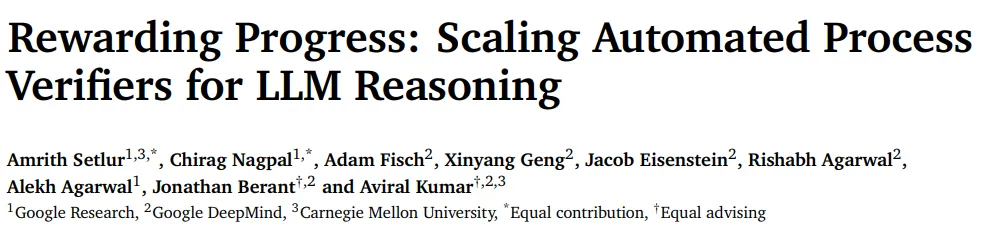

從形式上來講,這種獎勵對應于強化學習中的逐步驟優勢( per-step advantages),經驗表明,使用優勢以及ORM獎勵比常見的使用未來成功概率(future probabilities of success)或??值來搜索和強化學習都表現得更好,主要是因為,在有限的計算和采樣約束下,??值主要「利用」(exploit)狀態,而優勢也「探索」(explore)對最終答案最有貢獻的步驟。

在回答第二個問題時,研究人員首先注意到,在大多數步驟中,基礎策略下的優勢接近于0,因此對搜索或RL沒有信息量。

此外,無論基礎策略的強度如何,使用其自身的逐步驟優勢作為RL中的過程獎勵,會導致與僅使用結果獎勵進行RL相同的基礎策略更新(因為標準策略梯度算法已經計算了優勢)。

因此,研究人員提出使用在不同的證明策略下通過滾動估計的優勢作為過程獎勵。

然后應該如何選擇證明策略?

一個很自然的想法/猜測是使用一個非常強大的證明策略,但研究人員發現,在過于強大的證明策略下,模型可以從任意步驟中走向成功,無法區分出好和壞的步驟;而對于非常弱的證明策略來說,也有類似的結果。

在理論上,研究人員在文中將上述直覺給形式化為,與基礎策略互補的策略即為好的證明器,能夠充分對比基礎策略生成的步驟優勢,同時仍然生成與基礎策略優勢相關的步驟級優勢的策略。

例如,對于對應于基礎策略的Best-of-??策略,經驗發現,對應于??>1的證明策略更能夠改進基礎策略;與直覺相反,互補證明策略的集合也包含了比基礎策略更差的策略。

為了預測這些證明策略的優勢,研究人員訓練了密集的驗證器,即過程優勢驗證器(PAV,process advantage verifiers),加速了RL和搜索的樣本和計算效率;文中為訓練PAV規定了實際的工作流程,并在一系列2B、9B和27B Gemma2模型上展示了有效性。

通過從證明策略中采樣「種子」解決方案軌跡,以估計種子軌跡的每個前綴的??值,并從同一策略中進行部分滾動(partial rollouts)來收集PAV訓練數據,工作流程規定了種子和部分滾動的有利比例。

實證結果顯示,對于相同的測試時計算預算,針對訓練有素的PAV的beam search在準確性上比針對ORM重新排序完整軌跡高出>8%,計算效率提高了1.5-5倍。

PAV的密集獎勵通過積極修剪解決方案的組合空間,并專注于多樣化的可能序列集,提高了搜索期間步驟級探索的效率。

此外,文中首次展示了使用PAV作為強化學習中的密集獎勵,與僅使用結果獎勵相比,數據效率提高了6倍;使用PAV訓練的基礎策略也實現了8倍更好的Pass @??性能(在??次嘗試中采樣正確解決方案的概率),從而為任何測試時重新排序器的性能提供了更高的上限。

最后,使用PAV進行強化學習,可以發現SFT策略在非常大的預算下也無法應對的難題解決方案。