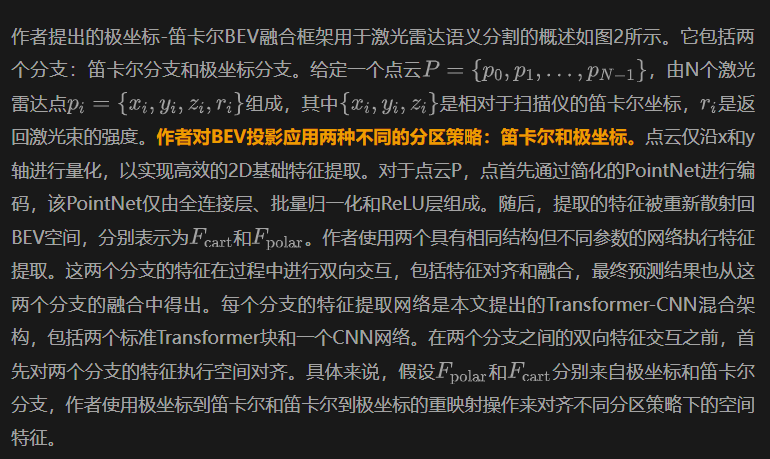

PC-BEV:巧用多坐標系融合策略,實現點云分割170倍加速,精度顯著提升!

本文經3D視覺之心公眾號授權轉載,轉載請聯系出處。

論?題目:PC-BEV: An Efficient Polar-Cartesian BEV Fusion Framework for LiDAR Semantic Segmentation

論文作者:Shoumeng Qiu, Xinrun Li, Xiangyang Xue, Jian Pu

論文地址:https://arxiv.org/pdf/2412.14821

1.背景介紹

激光雷達點云分割是自動駕駛領域的核心任務,其目標在于精細地理解周圍環境的語義信息。目前,該領域的方法主要分為三類:基于點的方法、基于體素的方法和基于投影的方法。

其中,基于投影的方法因其能夠利用2D卷積神經網絡(CNN)高效處理投影點云而受到青睞。但是,相比于計算量大的基于體素方法,從3D到2D的投影過程中不可避免地丟失信息,這限制了這種算法的性能。

為了縮小這一性能差距,多視圖融合技術應運而生,通過整合不同投影技術捕獲的互補信息。近期的多視圖融合方法,如AMVNet、GFNet和CPGNet,通過基于點的特征交互增強了表示學習。

然而,由于缺乏視圖間的固定對應關系,這些方法需要進行高成本的網格采樣和散射操作,影響了實時性能。此外,特征融合通常僅限于點存在的區域,可能會忽略周圍區域中有價值的上下文信息。

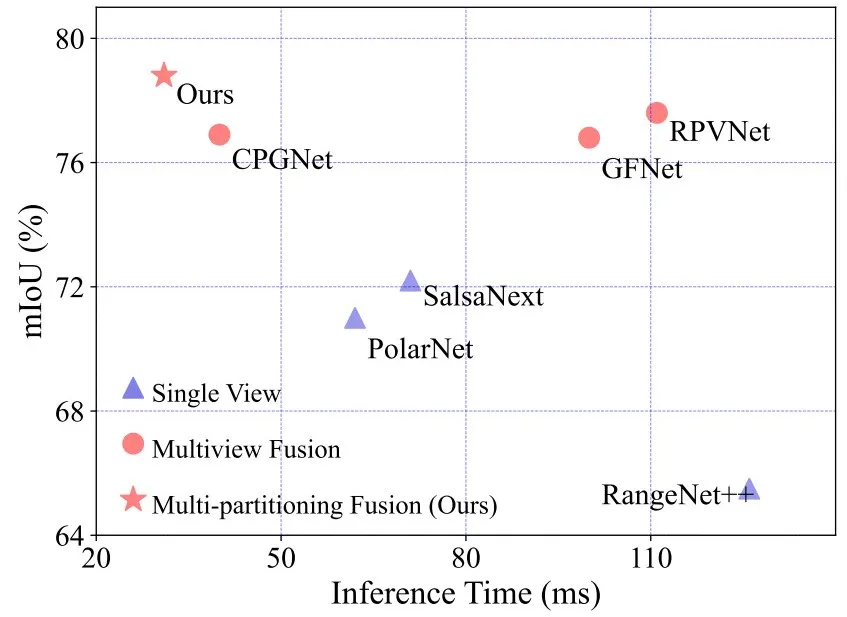

▲圖1 | 與其他基于投影的方法比較,結果展示了本文方法在性能和速度方面的優越性。??【深藍AI】編譯

2.方法提出

為了克服這些限制,作者提出了一種創新的多分區特征融合框架,完全在BEV空間內操作,充分利用了極坐標和笛卡爾分區方案之間的固定對應關系。該方法受到BEV中極坐標分區與范圍視圖中球坐標分區相似性的啟發,并且實驗表明不同分區方法的性能具有互補性。

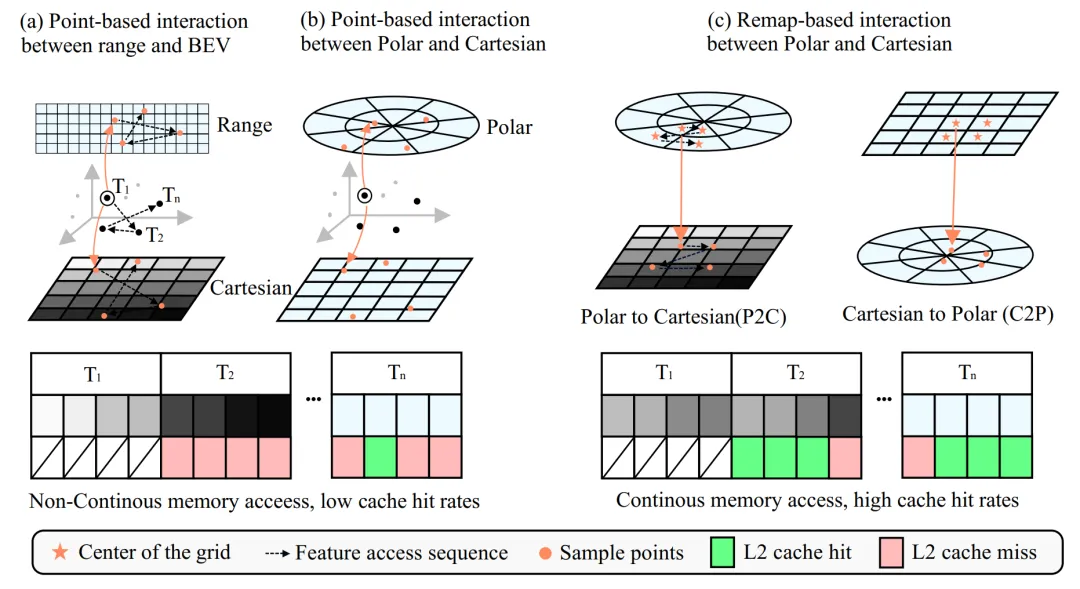

為了促進極坐標和笛卡爾分支之間的特征融合,作者引入了一種高效且有效的基于重映射的融合方法。利用極坐標和笛卡爾空間分區在相同BEV空間內固有的固定坐標對應關系,預先計算對應參數,再通過精心設計的重映射操作實現高效特征融合。這種方法比以往的基于點的特征交互方法快170倍。此外,所有的特征融合在BEV空間位置操作,不僅實現了密集融合,還保留了比以往基于點的方法更多的寶貴上下文信息。

作者還提出了一種混合Transformer-CNN架構,用于BEV特征提取。Transformer塊中的自注意力捕獲全局場景信息,然后是一個輕量級的U-net樣式CNN用于詳細特征提取。實驗結果表明,這種架構在保持實時推理能力的同時增強了模型性能。

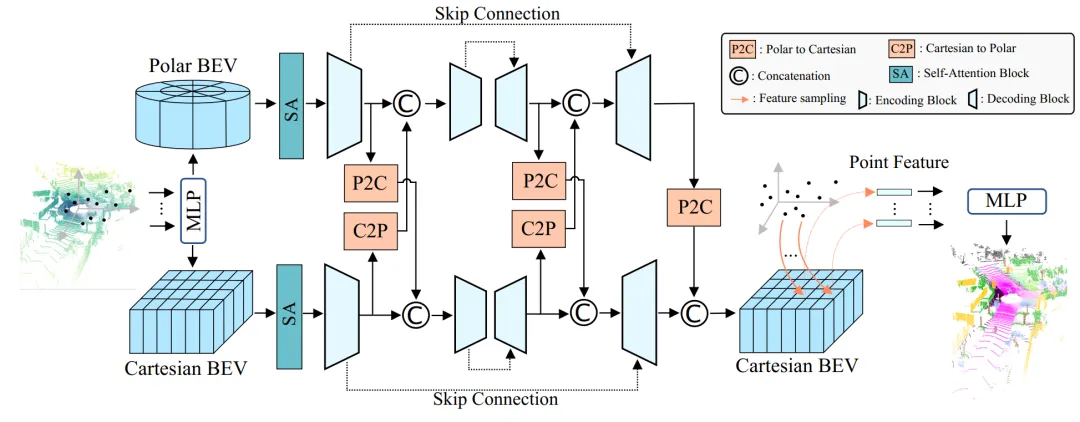

▲圖2 | 極坐標-笛卡爾BEV融合框架用于3D點云語義分割任務的流程圖。??【深藍AI】編譯

3.方法詳解

3.1. 極坐標-笛卡爾BEV融合框架

對于最終的語義預測,由于本方法的目標是為場景中的每個點提供語義預測,因此需要獲取每個點在投影空間中用于類別預測的特征。對于從不同分支提取了特征,以前方法中的常見做法是通過網格采樣(GS)操作檢索每個點的相應特征。然后從不同分支采樣的特征被融合。最后,融合的特征用于獲得最終的語義預測結果。以前的基于點的輸出融合可以表示為(這里作者假設使用連接操作進行融合):

為了進一步加速模型推理,作者使用重映射操作對一個分支的特征與另一個分支對齊,這使模型能夠僅對重映射分支執行一次網格采樣。在論文中,作者選擇將從極坐標分支提取的特征與笛卡爾空間對齊,因為作者實驗發現這比相反的方式表現略好。作者將重映射的極坐標特征與笛卡爾特征連接,然后使用網格采樣獲得每個點的BEV位置特征。因此,作者方法中的最終點級特征輸出可以表示為:

▲圖3 | 在不同設置下,比較先前的基于點的方法和基于重映射的方法的特征交互操作過程。??【深藍AI】編譯

3.2. 特征融合通過重映射

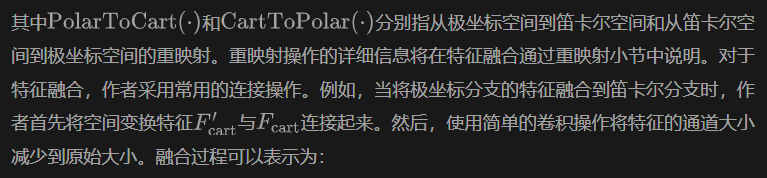

與以前的多視圖融合方法在不同投影空間中操作,由于投影過程中的信息丟失導致動態網格到網格的對應關系不同,本設計的方法從兩個分區分支在同一BEV空間下的固定位置對應關系中受益,這為本設計提供了改進特征融合過程效率的機會。

具體來說,作者采用重映射技術來對齊兩種不同分區方法下的特征。鑒于兩個分支之間網格對應關系是固定的,重映射參數可以預先計算,以實現高效特征融合。作者提供了重映射操作的詳細步驟,突出了基于重映射的交互相對于基于點的交互的優勢。以從極坐標空間到笛卡爾空間的重映射過程為例,注意從笛卡爾到極坐標空間的重映射遵循相同的原則。

到目前為止,建立了笛卡爾和極坐標分支之間的坐標對應關系,這是固定的,所以可以預先計算融合。可以將網格中心視為一個點,并應用以前的基于點的方法進行特征融合;然而,作者的實驗表明,這種方法在實踐中是低效的。

為了更高效和有效地進行特征融合,作者開發了一種基于重映射的特征融合操作,顯著提高了兩個分支之間的特征對齊速度。傳統的基于點的方法之所以慢,主要是因為網格采樣操作和散射回操作。它們將每個點單獨視為點級并行處理,導致實驗中的緩存未命中率高。

與基于點的方法不同,作者的基于重映射的操作考慮了空間位置的連續性,使過程更友好于內存訪問,并顯著加快了計算速度。圖3比較了不同特征融合方法。需要注意的是,并非一個分支中的每個網格在另一個分支中都有對應的區域,由于空間占用模式的變化。

如果一個分支中的空間位置在另一個分支中不可用,則簡單地對該位置應用零填充。更詳細的效率分析可以在補充材料中找到。基于重映射的融合方法通過在融合過程中整合更多的上下文信息提供了額外的優勢。

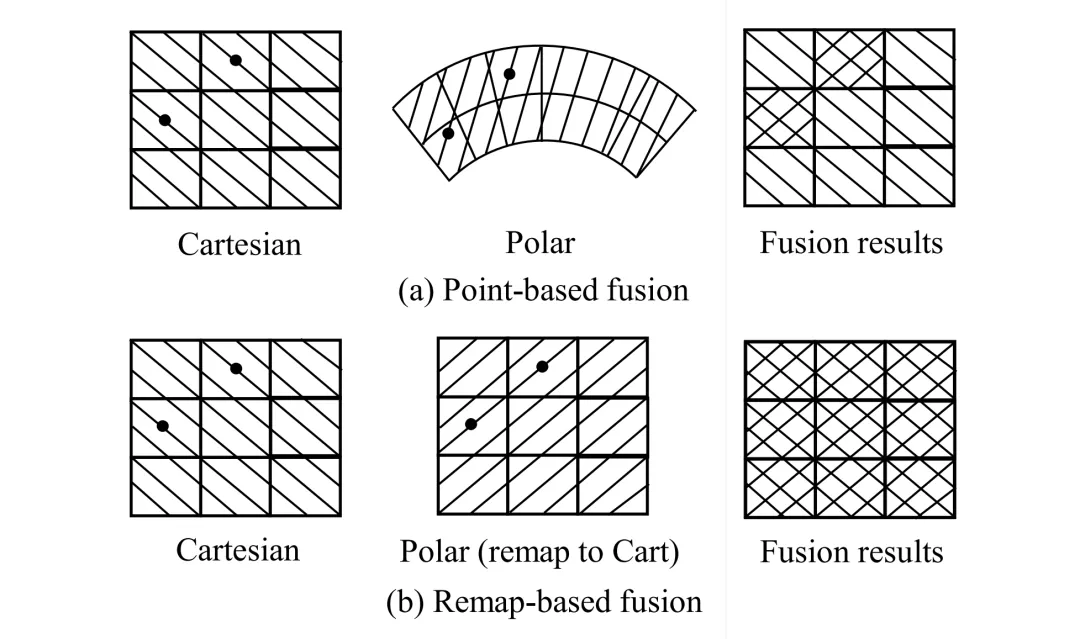

如圖4所示,基于點的方法僅在存在點的區域進行融合,丟棄了沒有點的特征,作者稱之為稀疏融合。相比之下,基于重映射的方法使整個BEV空間內的融合成為可能,實現了密集融合,豐富了來自另一分支的特征信息。

▲圖4 | 基于點的交互結果與基于重映射的交互結果之間的比較。??【深藍AI】編譯

3.3. Transformer-CNN混合架構

由于注意力機制缺乏區分輸入序列中位置信息的能力,作者引入了正弦位置編碼PE到特征中。最終的塊嵌入輸入自注意力可以表示為:

富含全局信息的特征然后被送入一個高效的CNN模型進行進一步提取。作者使用了一個U-net架構的CNN。實驗表明,本文的Transformer-CNN混合架構在性能和推理速度方面都提供了優勢。

4.實驗結果

作者在SemanticKITTI和nuScenes數據集上進行了廣泛的實驗,證明了本方法以更快的推理速度實現了最先進的性能。

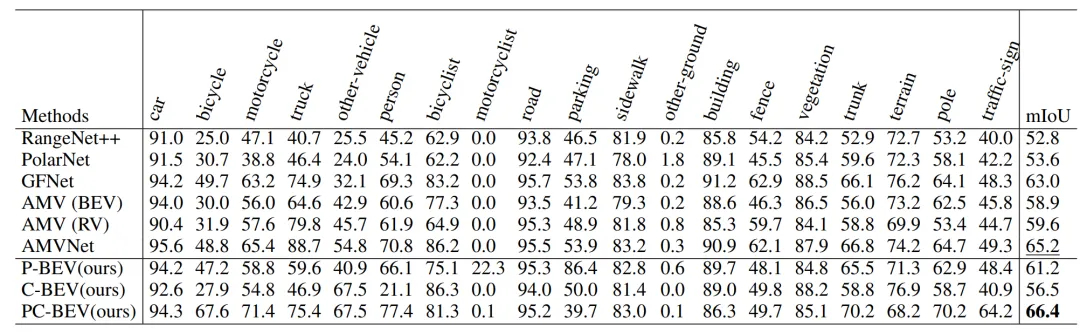

▲表1 | 在SemanticKITTI 測試集的定量比較。??【深藍AI】編譯

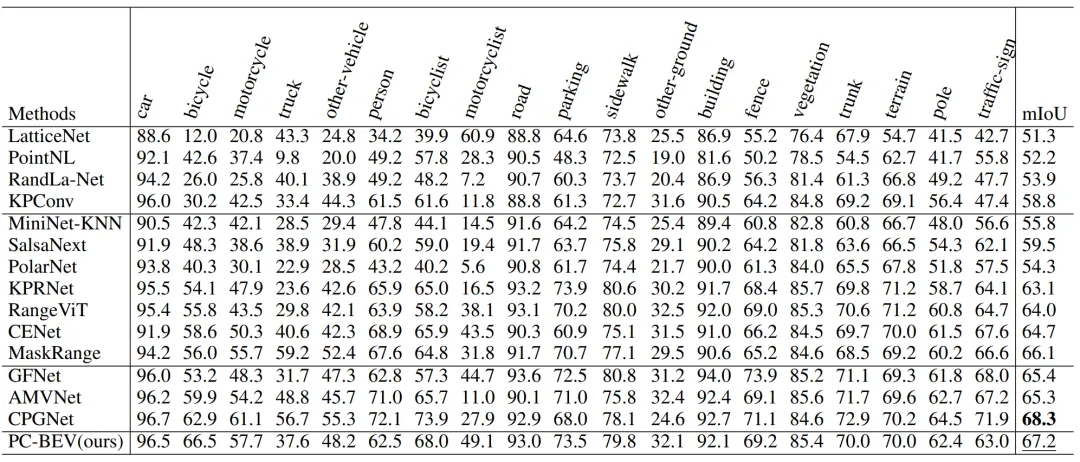

▲表2 | 在SemanticKITTI 驗證機的定量比較。??【深藍AI】編譯

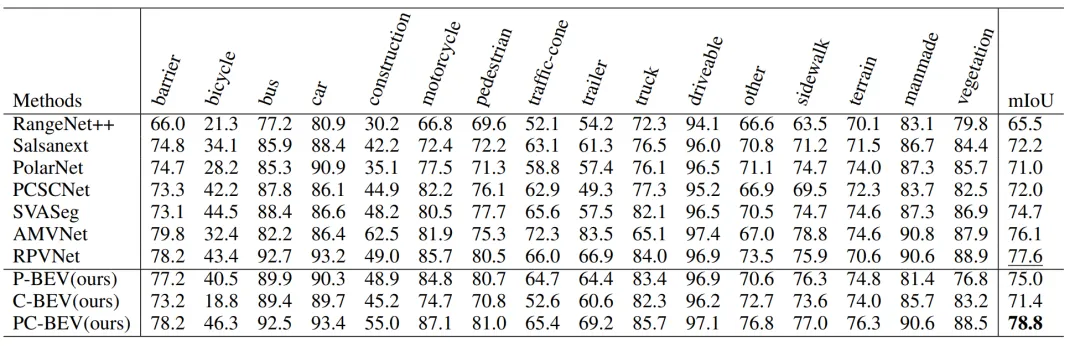

▲表3 | 在nuScenes測試集定量比較。??【深藍AI】編譯

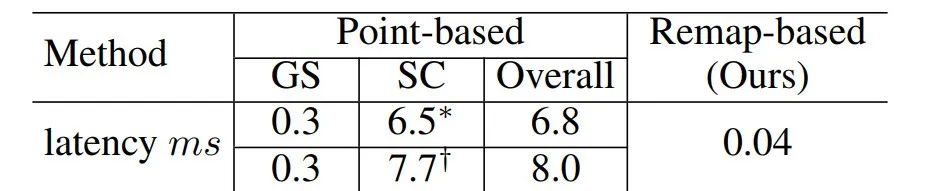

▲表4 | 基于重映射的交互效率的對比。??【深藍AI】編譯

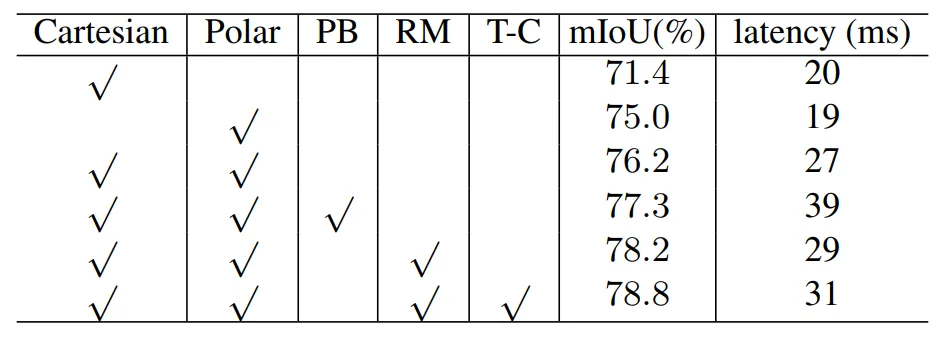

▲表5 | 在nuScenes驗證集上的消融研究。??【深藍AI】編譯

5.本文總結

本文介紹了一種新穎的實時激光雷達點云分割方法。該技術采用作者研發的高效重映射空間對齊融合策略,通過優化內存連續性,不僅大幅提升了處理速度,而且在性能上超越了傳統的基于點的交互方法,同時還能保留更為詳盡的上下文信息。

此外,文章中還介紹了一種Transformer-CNN混合架構,該架構在維持實時處理能力的基礎上,進一步增強了模型的整體性能。通過在SemanticKITTI和nuScenes數據集上進行的廣泛實驗,充分驗證了該方法的有效性和高效率。

展望未來,研究者可以會進一步探索將此技術應用于由多相機圖像數據生成的BEV(鳥瞰圖)表示,以拓展其應用范圍。