7B的DeepSeek蒸餾Qwen數(shù)學(xué)超o1!在測試時(shí)間強(qiáng)化學(xué)習(xí),MIT積分題大賽考93分

見識(shí)過32B的QwQ追平671的DeepSeek R1后——

剛剛,7B的DeepSeek蒸餾Qwen模型超越o1又是怎么一回事?

圖片

圖片

新方法LADDER,通過遞歸問題分解實(shí)現(xiàn)AI模型的自我改進(jìn),同時(shí)不需要人工標(biāo)注數(shù)據(jù)。

使Deepseek-R1蒸餾的Qwen2.5 7B模型在麻省理工學(xué)院積分大賽(MIT Integration Bee)上達(dá)到90分超越o1。

圖片

圖片

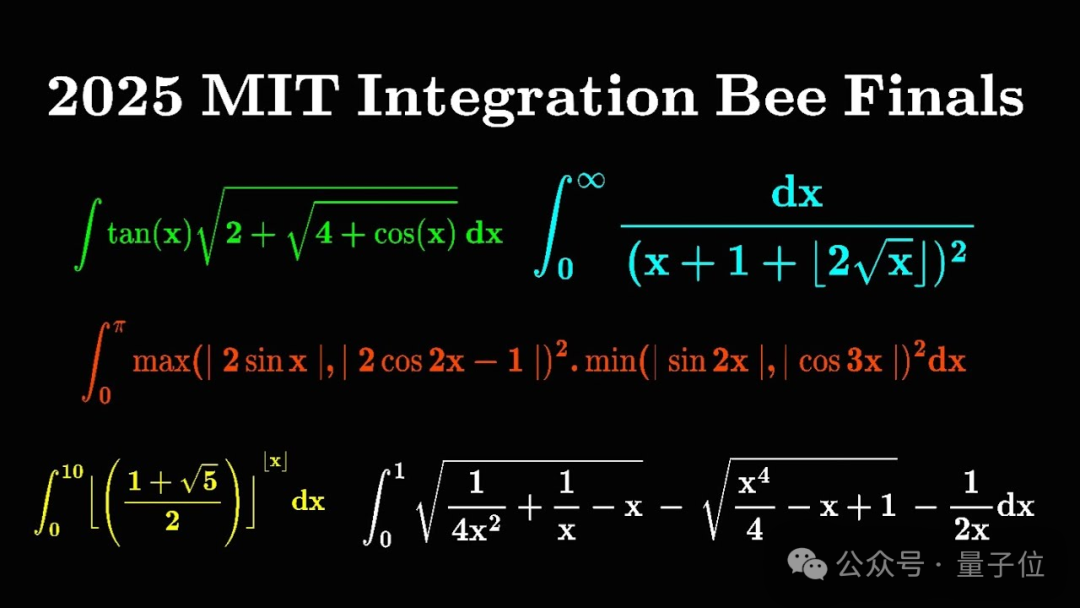

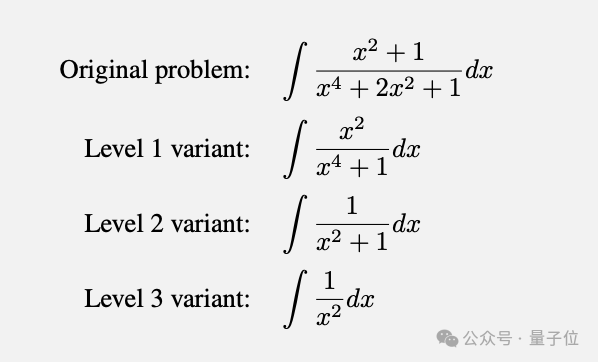

注意,不是積分制的比賽哦,是只做微積分中積分題的比賽,MIT的數(shù)學(xué)高手每年都會(huì)挑戰(zhàn)一次,題目像這樣:

圖片

圖片

LADDER論文來自小型獨(dú)立研究團(tuán)體Tufa Labs,論文已上傳到arXiv。

圖片

圖片

在推理時(shí)間強(qiáng)化學(xué)習(xí)

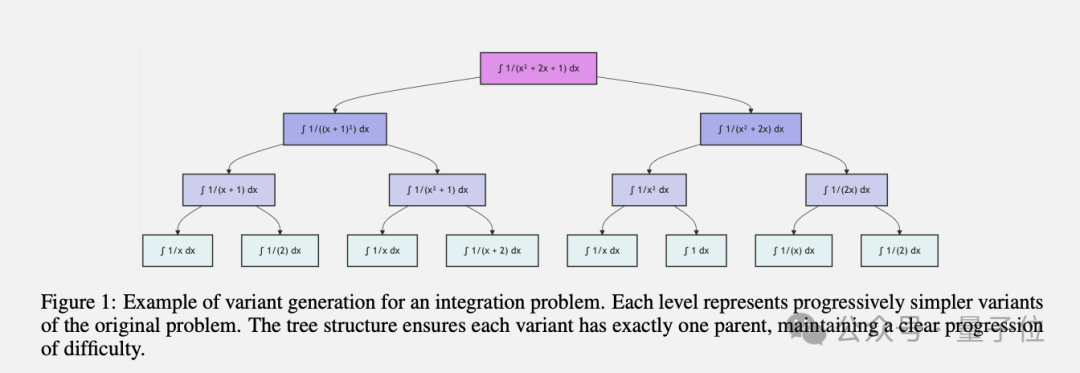

LADDER,全稱Learning through Autonomous Difficulty-Driven Example Recursion,即”通過自主難度驅(qū)動(dòng)的樣本遞歸進(jìn)行學(xué)習(xí)”。

這個(gè)名字聽起來有點(diǎn)拗口,但核心其實(shí)很容易理解:就是讓語言模型(LLM)通過自我生成和求解漸進(jìn)簡化的問題變體,來不斷提升自己解決復(fù)雜問題的能力。

圖片

圖片

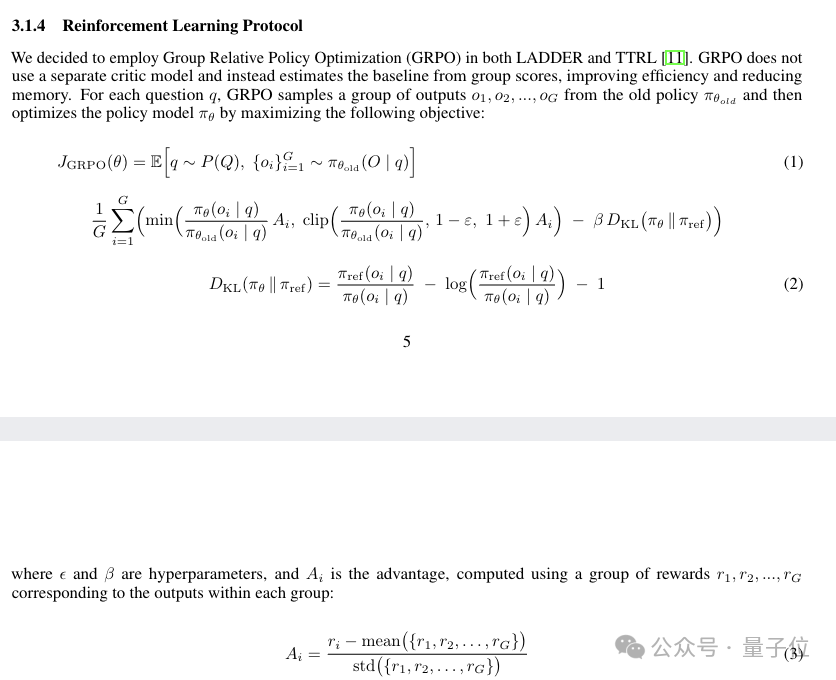

具體來說,LADDER是一個(gè)結(jié)構(gòu)化框架,由以下組件組成:

- 變體生成:一種結(jié)構(gòu)化方法,用于生成復(fù)雜問題的逐漸簡化變體的樹,從而建立自然的難度梯度。

- 解的驗(yàn)證:一種用于驗(yàn)證積分解的數(shù)值積分方法。

- 強(qiáng)化學(xué)習(xí):用于在變體樹上訓(xùn)練基礎(chǔ)模型的協(xié)議。

圖片

圖片

而LADDER這個(gè)名字,也意味著像是模型學(xué)會(huì)了”爬梯子”:通過自主生成一系列從易到難的問題變體,不斷練習(xí)和強(qiáng)化,最終爬到頂端。

以往的訓(xùn)練方法,總是離不開大規(guī)模標(biāo)注數(shù)據(jù)。

LADDER利用模型現(xiàn)有能力來生成問題變體,形成循序漸進(jìn)的難度梯度,最終實(shí)現(xiàn)自舉學(xué)習(xí)。整個(gè)過程只需對(duì)答案進(jìn)行驗(yàn)證即可,無需人工干預(yù)。

相比之前的方法,LADDER有三大優(yōu)勢:

不再依賴人工標(biāo)注數(shù)據(jù),降低了數(shù)據(jù)獲取成本;模型通過生成問題變體構(gòu)建針對(duì)性的學(xué)習(xí)路徑,學(xué)習(xí)更高效;生成的問題變體與原始問題相關(guān)性高,避免陷入無關(guān)細(xì)節(jié)。

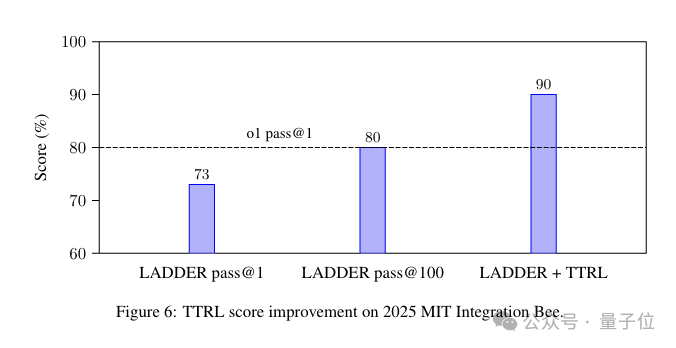

此外,作者還提出了一種創(chuàng)新的測試時(shí)強(qiáng)化學(xué)習(xí)方法TTRL。在推理階段遇到復(fù)雜的數(shù)學(xué)積分測試問題時(shí),TTRL會(huì)動(dòng)態(tài)生成一系列更簡單的積分變體,模型通過解決這些變體來積累經(jīng)驗(yàn),找到解決原始難題的方法。

這種測試時(shí)計(jì)算擴(kuò)展的思路,為進(jìn)一步提升模型性能開辟了新的道路。不同于簡單增加輸出長度,TTRL能夠讓模型在推理時(shí)針對(duì)性地”刷題”,動(dòng)態(tài)擴(kuò)展能力邊界。

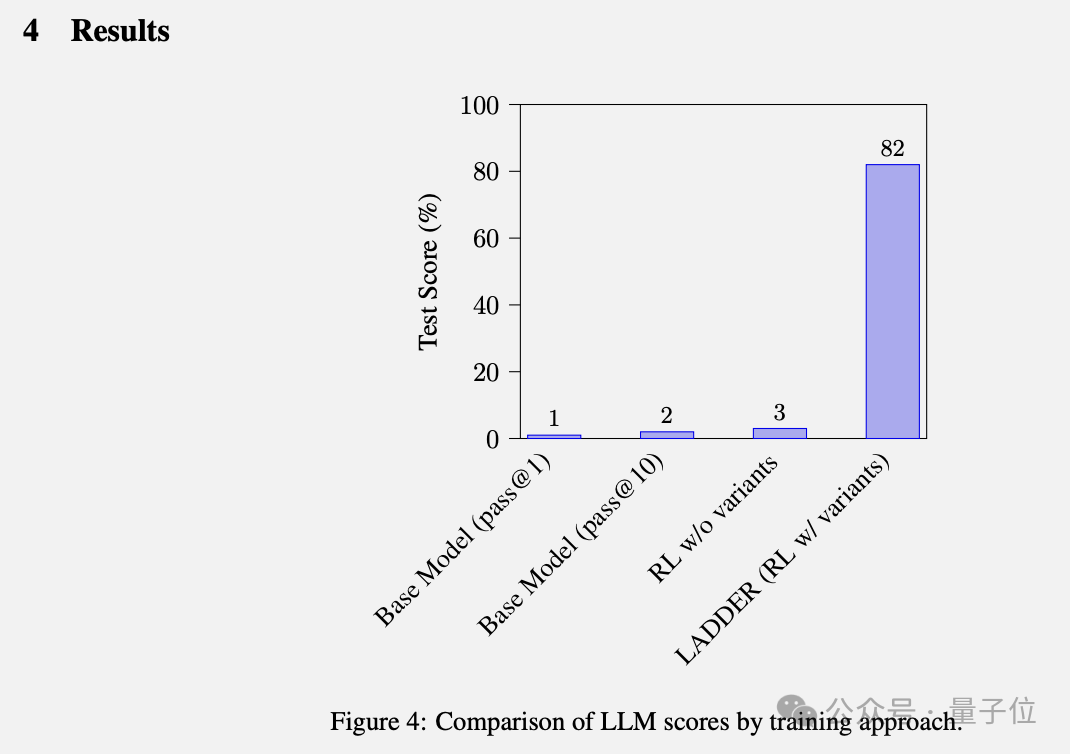

通過LADDER,一個(gè)原本只有1%準(zhǔn)確率的Llama 3.2 3B模型,在沒有任何人工標(biāo)注數(shù)據(jù)的情況下,解題準(zhǔn)確率飆升至82%。

圖片

圖片

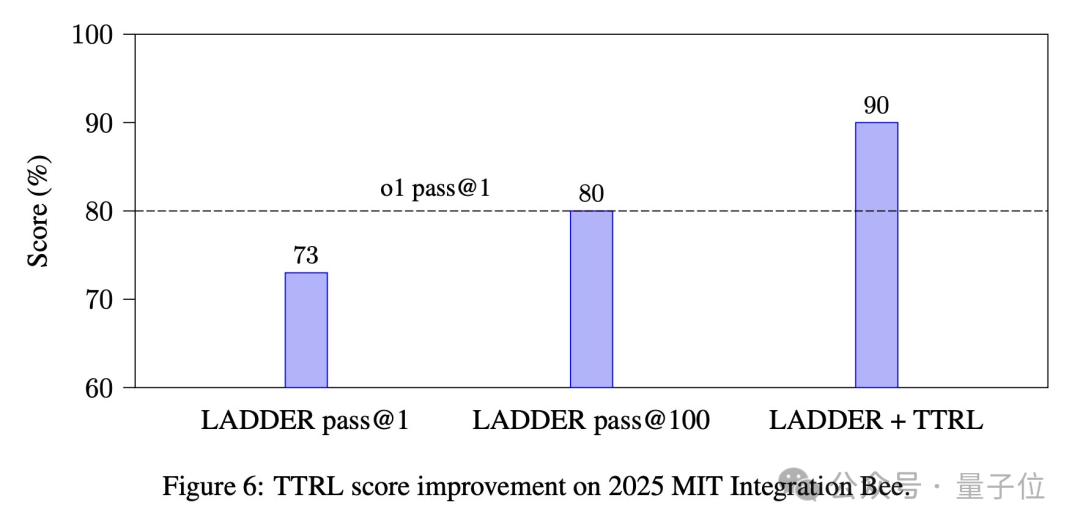

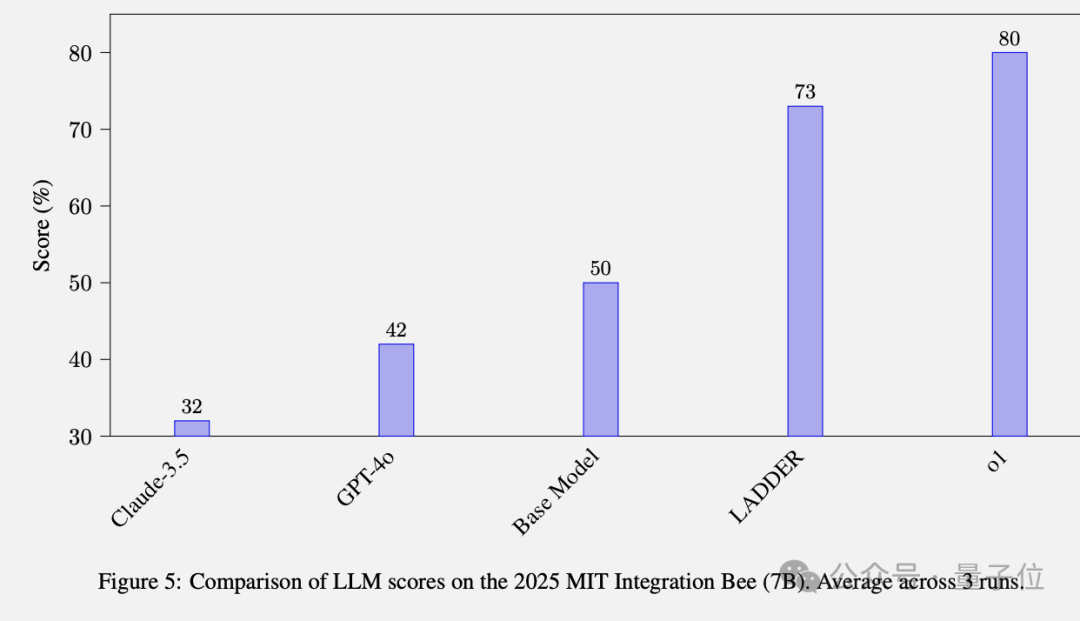

更強(qiáng)大的基礎(chǔ)模型Qwen2.5 7B Deepseek-R1 Distilled,在用上LADDER方法后,

MIT Integration Bee比賽的成績就從50%提高到73%。

最后,LADDER加上TTRL方法,讓最終成績達(dá)到90。

不過作者也強(qiáng)調(diào),與o1的對(duì)比不是嚴(yán)格的頭對(duì)頭評(píng)估。

o1無法訪問數(shù)字檢查器,這意味著它在不同的約束下運(yùn)行。LADDER的結(jié)果強(qiáng)調(diào)了通過遞歸問題分解和強(qiáng)化學(xué)習(xí)進(jìn)行自我提升的有效性,而不是表明它直接優(yōu)于o1的方法。

論文地址:https://arxiv.org/abs/2503.00735

參考鏈接:

[1]https://x.com/yoshiyama_akira/status/1897662722679959583