港科大提出端側文生圖模型SnapGen,參數僅SD十分之一,1.4秒內生成1024分辨率圖像

本文經AIGC Studio公眾號授權轉載,轉載請聯系出處。

這項工作提出了一種新穎且高效的 T2I 模型SnapGen,SnapGen 是第一個可以在1.4秒內在移動設備上合成高分辨率圖像(1024x1024 ) 的圖像生成模型(379M ) ,并在 GenEval 指標上 達到0.66。該模型全面超越了許多現有的數十億參數模型,例如 SDXL、Lumina-Next 和 Playgroundv2。

相關鏈接

- 論文鏈接:https://arxiv.org/abs/2412.09619

- 項目主頁:https://snap-research.github.io/snapgen/

論文介紹

介紹

現有的文本到圖像 (T2I) 傳播模型面臨一些限制,包括模型尺寸大、運行時間慢以及移動設備上的低質量生成。本文旨在通過開發一種極小且快速的 T2I 模型來解決所有這些挑戰,該模型可在移動平臺上生成高分辨率和高質量的圖像。我們提出了幾種實現這一目標的技術。首先,我們系統地檢查網絡架構的設計選擇,以減少模型參數和延遲,同時確保高質量的生成。其次,為了進一步提高生成質量,我們從更大的模型中采用跨架構知識提煉,使用多層次方法從頭開始指導我們的模型訓練。第三,我們通過將對抗性指導與知識提煉相結合來實現幾步生成。我們的模型 SnapGen 首次展示了在移動設備上大約 1.4 秒內生成 10242 像素圖像。在 ImageNet-1K 上,我們的模型只有 372M 個參數,在 2562 像素生成中實現了 2.06 的 FID。在 T2I 基準測試(即 GenEval 和 DPG-Bench)上,我們的模型僅有 379M 個參數,但尺寸卻明顯較小(例如,比 SDXL 小 7 倍,比 IF-XL 小 14 倍),超越了具有數十億個參數的大型模型。

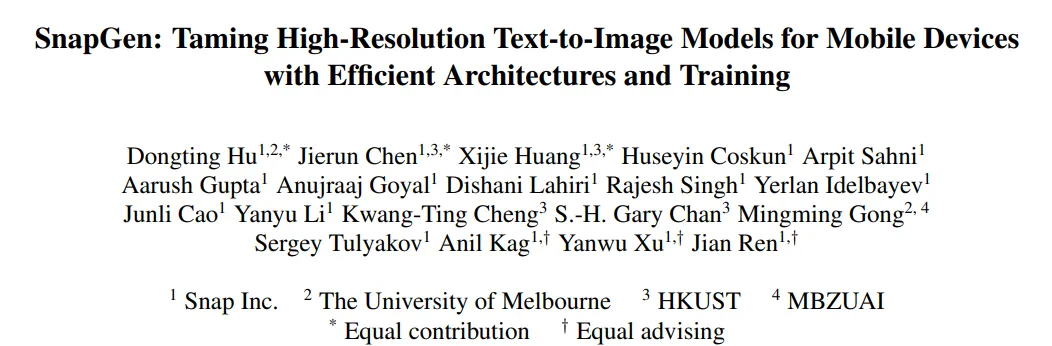

高效的架構

我們對網絡架構進行了深入研究,包括去噪 UNet 和自動編碼器 (AE),以在延遲和性能之間取得最佳平衡。與之前優化和壓縮預訓練擴散模型的工作不同,我們直接關注宏觀和微觀層面的設計選擇,以實現一種新穎的架構,大大減少模型大小和計算復雜度,同時保持高質量的生成。

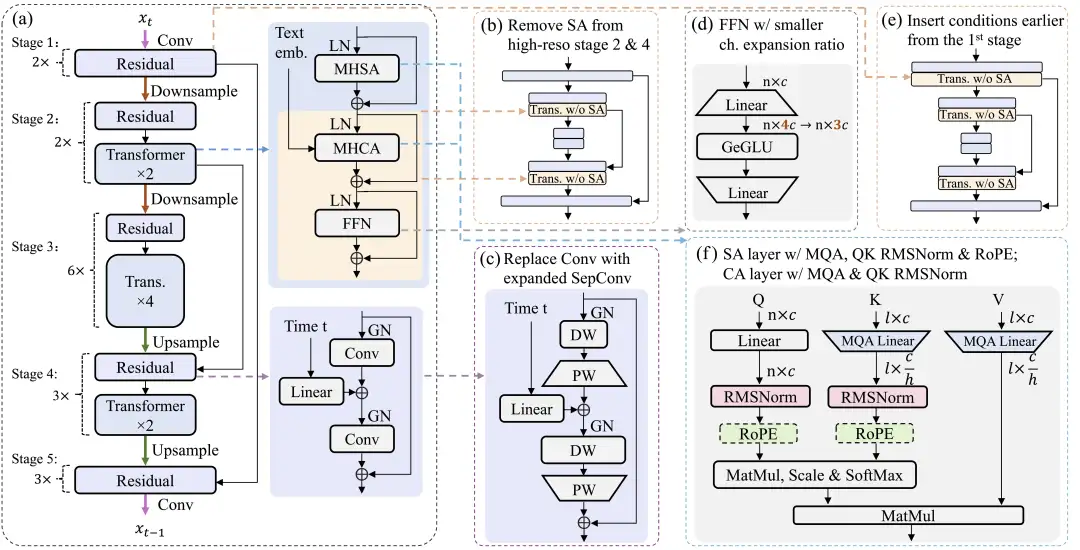

高效訓練

我們引入了多項改進,從頭開始訓練緊湊型 T2I 模型。我們提出了一種多級知識蒸餾方法,該方法結合了時間步長感知縮放,結合了多個訓練目標。我們結合對抗性訓練和使用少步教師模型的知識蒸餾方法,對我們的模型進行分步蒸餾。

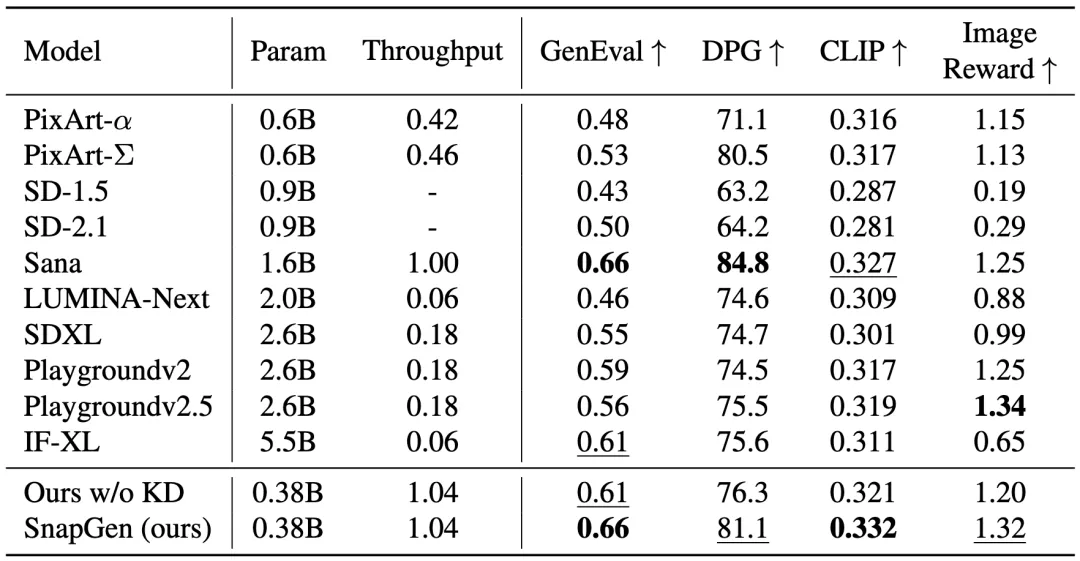

定量比較

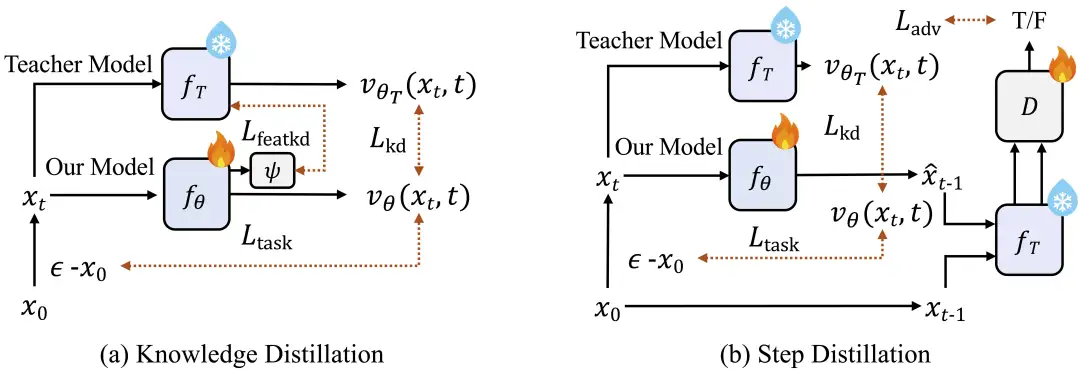

人工評估與 SDXL、SD3-Medium 和 SD3.5-Large 的對比:

與各種基準中的現有 T2I 模型的比較:

與各種基準中的現有 T2I 模型的比較:

定性結果

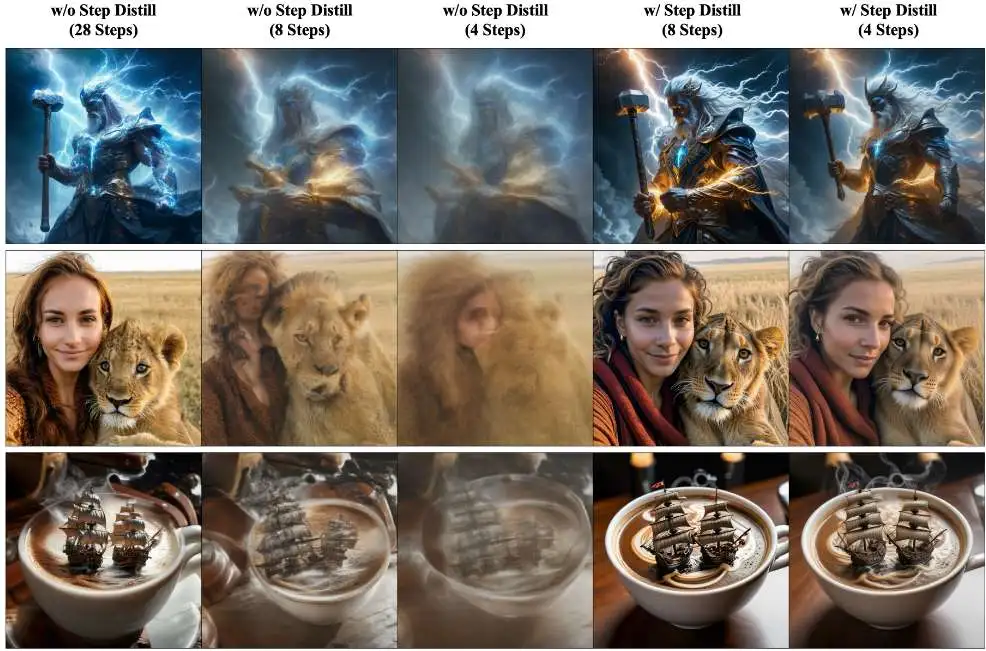

幾步可視化

總結

這項工作提出了一種新穎且高效的 T2I 模型,用于在手機上生成高分辨率圖像。論文系統地詳細介紹了獲得微小的 379M 參數 UNet 架構以及高效潛在解碼器的過程。設計了一種新穎的訓練方法,包括多階段預訓練,然后從大型教師那里進行知識提煉和對抗性步驟提煉。借助這些論文實現了一個極其高效的 T2I 模型,該模型全面超越了許多現有的數十億參數模型,例如 SDXL、Lumina-Next 和 Playgroundv2。