樹搜索也存在「過思考」與「欠思考」?騰訊AI Lab與廈大聯合提出高效樹搜索框架

通訊作者包括騰訊 AI Lab研究員宋林峰與涂兆鵬,以及廈門大學蘇勁松教授。論文第一作者為廈門大學博士生王安特。

本文探討基于樹搜索的大語言模型推理過程中存在的「過思考」與「欠思考」問題,并提出高效樹搜索框架——Fetch。本研究由騰訊 AI Lab 與廈門大學、蘇州大學研究團隊合作完成。

- 論文題目:Don't Get Lost in the Trees: Streamlining LLM Reasoning by Overcoming Tree Search Exploration Pitfalls

- 論文地址:https://arxiv.org/abs/2502.11183

背景與動機

近月來,OpenAI-o1 展現的卓越推理性能激發了通過推理時計算擴展(Test-Time Computation)增強大語言模型(LLMs)推理能力的研究熱潮。

該研究領域內,基于驗證器引導的樹搜索算法已成為相對成熟的技術路徑。這類算法通過系統探索龐大的解空間,在復雜問題的最優解搜索方面展現出顯著優勢,其有效性已獲得多項研究實證支持。

盡管諸如集束搜索(Beam Search)、最佳優先搜索(Best-First Search)、A*算法及蒙特卡洛樹搜索(MCTS)等傳統樹搜索算法已得到廣泛探索,但其固有缺陷仍待解決:樹搜索算法需承擔高昂的計算開銷,且難以根據問題復雜度動態調整計算資源分配。

針對上述挑戰,研究團隊通過系統性解構樹搜索的行為范式,首次揭示了該推理過程中存在的「過思考」與「欠思考」雙重困境。

「過思考」與「欠思考」

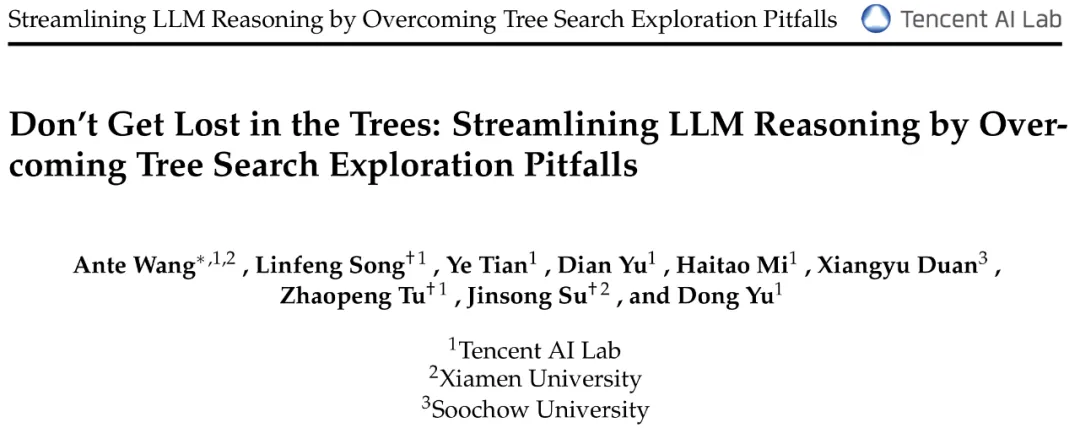

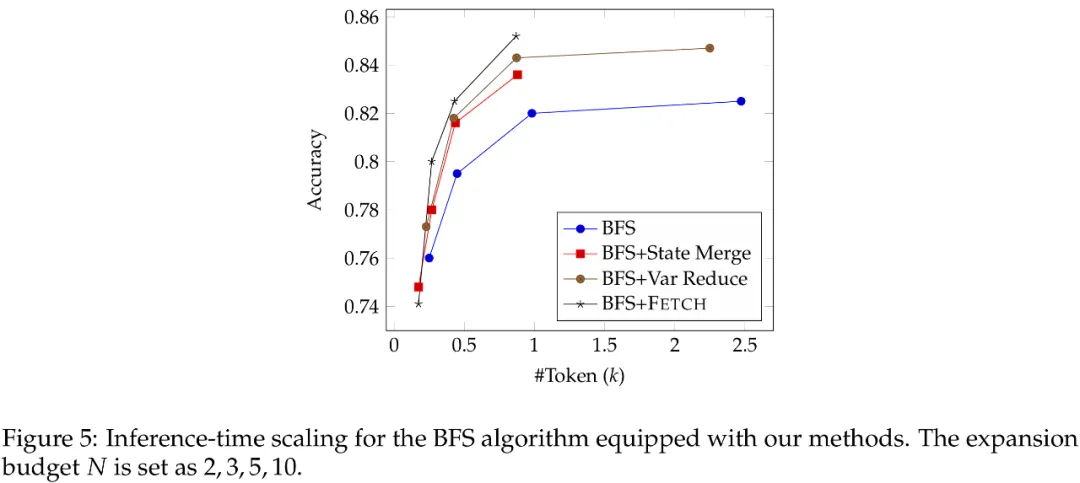

研究團隊選取最佳優先搜索算法為研究對象,基于 GSM8K 數據集開展系統性研究。實驗設置中逐步增加子節點拓展數(N=2,3,5,10)時發現:模型性能雖持續提升但呈現邊際效益遞減規律(圖 a),而計算開銷卻呈指數級增長(圖 b),二者形成的顯著差異揭示出傳統樹搜索在推理時計算擴展的效率瓶頸。

通過深度解構搜索過程,研究團隊首次揭示搜索樹中存在兩類關鍵缺陷:

- 節點冗余:由于大語言模型采樣機制的隨機性,搜索樹中生成大量語義重復節點(圖 c)。量化分析采用基于語義相似度的節點聚類方法,定義重復度為平均類內節點數,該指標與計算開銷呈現顯著正相關,此現象直接導致算法重復遍歷相似推理路徑,形成「過思考」困境;

- 驗證器不穩定性:引導搜索的驗證器存在一定的魯棒性缺陷,節點評分易受推理路徑表述差異影響而產生非必要波動(圖 d),在復雜數學推理場景中尤為明顯。這種不穩定性可能引發搜索路徑的局部震蕩,迫使搜索算法過早終止高潛力路徑的深度探索,從而產生「欠思考」現象。

Fetch

為應對「過思考」與「欠思考」問題,研究團隊提出適用于主流搜索算法的高效樹搜索框架 Fetch,其核心包含兩部分:

- 冗余節點合并(State Merging):通過合并語義重復的節點,有效避免冗余節點的重復探索。

- 驗證方差抑制(Variance Reduction):采用訓練階段與推理階段的雙重優化策略,降低驗證器評分的非必要波動。

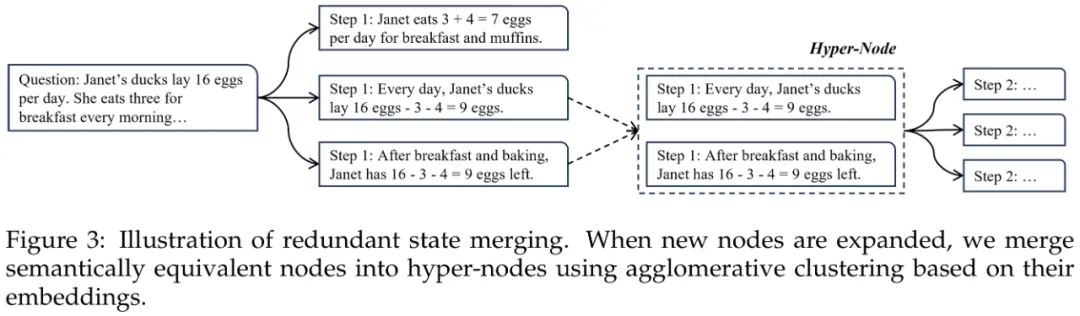

冗余節點合并

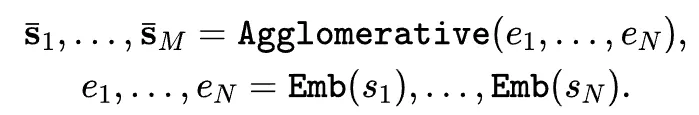

研究團隊采用層次聚類算法(Agglomerative Clustering)實現節點冗余合并。具體而言,當搜索算法生成子節點后 ,首先基于 SimCSE 句子表示模型提取節點語義特征向量

,首先基于 SimCSE 句子表示模型提取節點語義特征向量 ,隨后應用聚類算法形成超節點(Hyper-Node,

,隨后應用聚類算法形成超節點(Hyper-Node, )。該機制通過將語義等價節點聚合為單一超節點,有效避免冗余節點的重復拓展。

)。該機制通過將語義等價節點聚合為單一超節點,有效避免冗余節點的重復拓展。

針對通用領域預訓練 SimCSE 在數學推理場景下存在的領域適配問題,研究團隊對 SimCSE 進一步微調。為此,提出兩種可選的節點對語義等價標注方案:

- 基于提示:利用大語言模型的指令遵循能力,通過用戶指令自動生成節點對語義等價性標注。但受限于專家模型的指令遵循局限性,該方法可能依賴于額外的通用模型;

- 基于一致性:基于重復節點后續采樣結果具有更高一致性的先驗假設,通過比較節點后續推理路徑的概率相似度,構建無監督標注數據集。該方法規避了對外部模型的依賴。

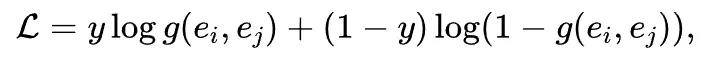

最終,利用收集的節點對標注,通過交叉熵損失對 SimCSE 進行微調:

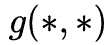

其中, 表示余弦相似度計算函數。

表示余弦相似度計算函數。

驗證方差抑制

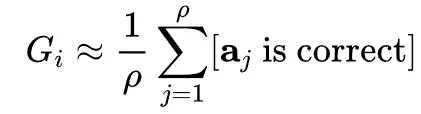

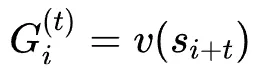

現有驗證器普遍采用判別方式對樹節點進行質量評分。傳統訓練方法基于強化學習經驗,通過蒙特卡洛采樣估計節點期望獎勵:

其中, 表示從當前狀態(節點

表示從當前狀態(節點 )出發通過策略模型采樣獲取的推理路徑,即

)出發通過策略模型采樣獲取的推理路徑,即 ,

, 是采樣的次數。受限于高昂的采樣代價,

是采樣的次數。受限于高昂的采樣代價, 通常設置較小(例如

通常設置較小(例如 ),導致獎勵估計存在顯著方差,進而削弱驗證器的決策穩健性。

),導致獎勵估計存在顯著方差,進而削弱驗證器的決策穩健性。

為此,研究團隊提出訓練和測試兩階段的優化方案:

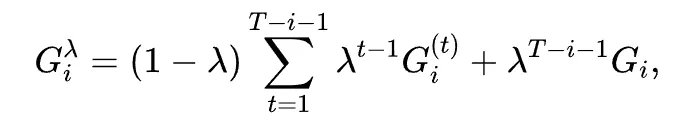

在訓練階段,研究團隊借鑒時序差分學習(Temporal Difference Learning),引入 訓練驗證器。

訓練驗證器。 是經典的強化學習算法,通過將蒙特卡洛采樣與時序差分學習結合,以平衡訓練數據的偏差(bias)及方差(variance)。對于節點

是經典的強化學習算法,通過將蒙特卡洛采樣與時序差分學習結合,以平衡訓練數據的偏差(bias)及方差(variance)。對于節點 ,其期望獎勵為

,其期望獎勵為

其中, 是總計后續采樣節點數,

是總計后續采樣節點數, 為偏差-方差權衡系數,

為偏差-方差權衡系數, 。

。

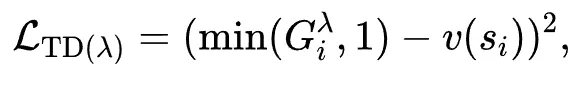

隨后,通過標準的均方誤差損失進行訓練:

該方案雖有效降低方差,但引入的偏差可能損害驗證精度,且不兼容現有開源驗證器的遷移需求。因此,研究團隊進一步提出在推理階段實施驗證器集成策略,以有效抑制個體驗證器的異常波動:

其中, 為集成驗證器的個數。

為集成驗證器的個數。

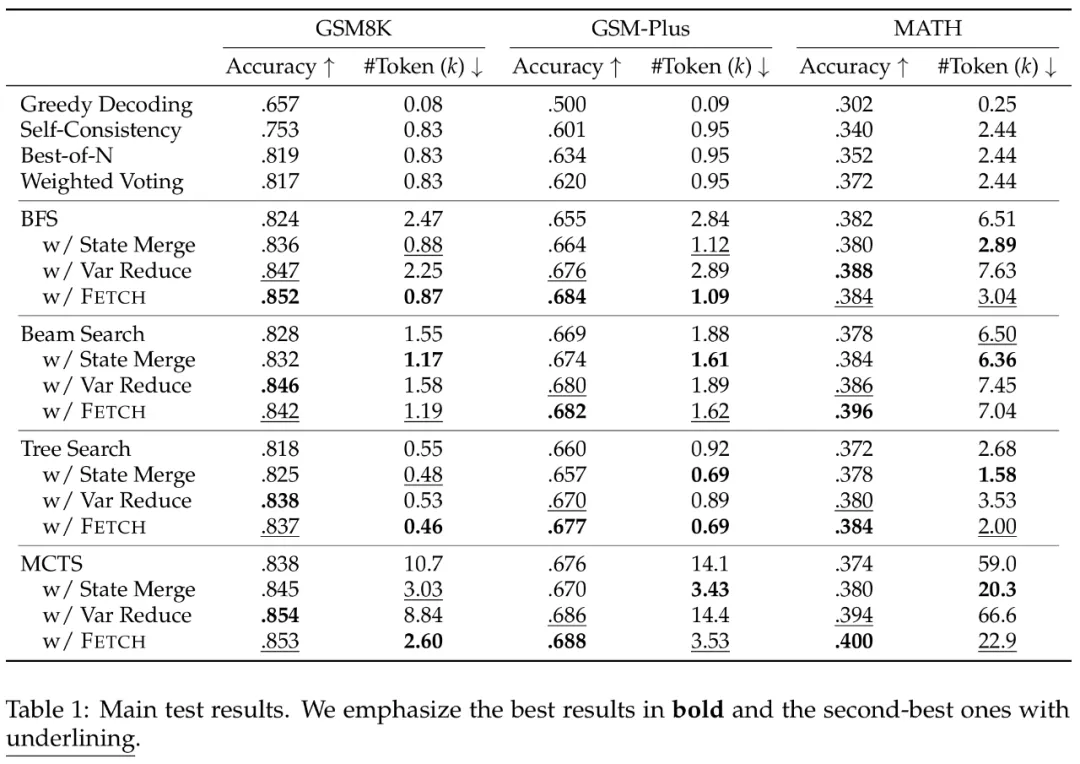

實驗結果

實驗結果表明,Fetch 框架在跨數據集與跨算法測試中均展現出顯著優勢。例如,對于 BFS 及 MCTS 算法,相較于基線,Fetch 計算開銷降低至原有的 1/3,并且保持 1~3 個點的準確率提升。

當測試時計算規模逐步提升時,Fetch 帶來的增益也更加顯著,驗證了框架的效率優勢。

總結

本研究由騰訊 AI Lab 聯合廈門大學、蘇州大學科研團隊共同完成,首次揭示基于樹搜索的大語言模型推理中存在的「過思考-欠思考」雙重困境。

分析表明,該現象的核心成因源于兩個關鍵缺陷:搜索樹中大量語義冗余節點導致的無效計算循環,以及驗證器評分方差過高引發的探索路徑失焦。二者共同導致樹搜索陷入計算資源錯配困境——即消耗指數級算力卻僅獲得次線性性能提升。

針對上述挑戰,研究團隊提出高效樹搜索框架 Fetch,其創新性體現在雙重優化機制:

- 冗余節點合并機制,實現搜索空間的智能壓縮;

- 驗證方差抑制機制,保障搜索方向穩定性。

結果表明,Fetch 在 GSM8K、MATH 等基準測試中展現出顯著優勢:相較傳統樹搜索算法,框架實現了計算效率和性能的同步提升。該成果為提升大語言模型推理效能提供了新的方法論支持。