編輯 | 李美涵

出品 | 51CTO技術(shù)棧(微信號:blog51cto)

深夜,OpenAI再次發(fā)力Agent領(lǐng)域,開源了一個全新的AI Agent評測基準—— PaperBench。

這是一個用于評估 AI 智能體復(fù)現(xiàn)最前沿 AI 研究能力的基準測試。智能體需從零開始復(fù)現(xiàn) 20 篇 ICML 2024 Spotlight 和 Oral 論文,包括理解論文貢獻、構(gòu)建代碼庫并成功執(zhí)行實驗。

圖片

圖片

看得出,OpenAI新的基準測試PaperBench,無疑是想將現(xiàn)在DeepResearch的功能更近一步,劍指AI科學(xué)家、甚至諾獎級AI。

那么AI搞科研的水平目前咋樣呢?

OpenAI也用這個最新基準測試了一把目前最頂尖的LLM,結(jié)果就是——人類并沒有一敗涂地!“頂尖的“人工智能博士”嘗試了 PaperBench 的一個子集,結(jié)果發(fā)現(xiàn)模型的性能尚未超過人類基線。”

有趣的是,在OpenAI家的基準上,表現(xiàn)最好的居然是死對頭Anthropic。使用開源 scaffolding 框架的 Claude 3.5 Sonnet(新版),其平均復(fù)現(xiàn)得分為 21.0%。

OpenAI指出,智能體的失敗顯示出當(dāng)前模型在執(zhí)行 長時間、多步驟任務(wù) 上的弱點。盡管它們能規(guī)劃多步驟計劃、寫出流程,卻很難真正一步步執(zhí)行這些計劃。

OpenAI已經(jīng)開源PaperBench代碼,旨在推動未來對 AI 智能體工程能力的研究:

開源地址:

https://github.com/openai/preparedness/tree/main/project/paperbench

論文閱讀:

https://openai.com/index/paperbench/

那么,我們來看看PaperBench究竟指明了Agent進化的那些方向,又是如何構(gòu)成的?

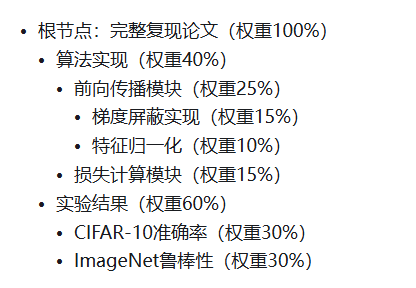

1.PaperBench層級評分樹:包含 8,316可單獨評分的子任務(wù)

為實現(xiàn)客觀評估智能體能力,OpenAI整了一套“套娃式”的評分標準。

將每個復(fù)現(xiàn)任務(wù)按層次細分為多個小任務(wù),并配有明確的評分標準。整個 PaperBench 共包含 8,316 個可單獨評分的子任務(wù)。這些評分標準專業(yè)到是由OpenAI成員和每篇 ICML 論文的作者共同開發(fā),那真的是很權(quán)威了。

那怎么能方便地給每個智能體評分呢?——外包給AI,OpenAI開發(fā)了一個基于大語言模型(LLM)的自動評分系統(tǒng),AI評估AI。

然后又套娃了一把:OpenAI又另外構(gòu)建了一個專門的評分基準來評估該評分系統(tǒng)本身的性能,驗證下這個 LLM 評委到底靠不靠譜。

我們來看一下這個層級樹具體如何為AI打分:

圖片

圖片

層級結(jié)構(gòu)說明:

- 頂層節(jié)點(例如圖中最上方 “.55”) 表示某個大的復(fù)現(xiàn)目標,比如“成功實現(xiàn)某個算法”。

- 中間節(jié)點 表示這個目標的子目標,比如“能正確實現(xiàn) Transformer 的結(jié)構(gòu)”。

- 底層葉子節(jié)點(藍色或紅色圓圈) 是可以直接打分的最小任務(wù)單元,比如“實現(xiàn)了 Attention 模塊”、“設(shè)置了正確的超參數(shù)”等。

圖中右邊的文字說明:

- 每一層越往下,要求越具體(finer granularity)。

- 所有的葉子節(jié)點都由評審(LLM)逐個打分(1 表示通過,0 表示失敗)。

- 每個子任務(wù)都有一個權(quán)重(灰色數(shù)字),最終通過加權(quán)平均把得分向上傳遞,得出總得分。

以"測試時模型自適應(yīng)"論文為例,其評分樹結(jié)構(gòu)如下:

圖源:知乎@北方的郎

圖源:知乎@北方的郎

2.智能體搞科研:被發(fā)1000美元的OpenAI API額度,和一個工具箱

在OpenAI的論文中提到了測試環(huán)境:每個智能體都在一個 Ubuntu 24.04 的 Docker 容器中運行,該容器配備了一塊 A10 GPU。

智能體在容器內(nèi)有一個本地工作目錄,其中包含:

- 論文的 PDF 和 Markdown 格式版本,

- 補充材料(addendum),

- 以及一份指令文本文件。

Docker容器可以訪問互聯(lián)網(wǎng),方便智能體:

- 下載依賴包,

- 瀏覽網(wǎng)頁查找資料等。

還為智能體提供了:

- HuggingFace 和 OpenAI 的 API key,

- 每個 key 預(yù)裝了 1000 美元額度,用于智能體在運行過程中調(diào)用這些服務(wù)(例如,如果某篇論文需要用到 OpenAI 的微調(diào) API 來運行實驗)。

此外,OpenAI還使用了一個基于 Inspect AI 基礎(chǔ)智能體 的簡單智能體腳手架,稱為 BasicAgent,并用 nanoeval 來調(diào)度運行。

這個腳手架會循環(huán)調(diào)用各種工具,直到模型選擇自行終止,或時間用完為止。

在運行過程中,智能體還獲得了一個原始工具箱,可以調(diào)用幾種工具:

- 一個 Bash shell 命令執(zhí)行工具,

- 一個 Python 代碼執(zhí)行工具,

- 一個網(wǎng)頁瀏覽器工具,

- 一個分頁文件閱讀器(用于閱讀長文檔)。

3.人機對照:AI在前24小時表現(xiàn)優(yōu)于人類,然后被反超

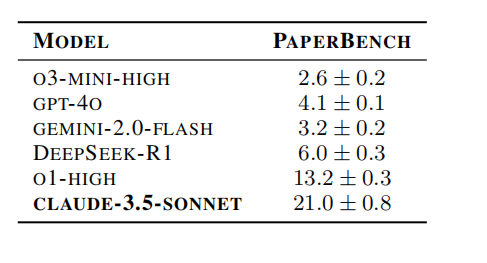

我們先來看看AI對戰(zhàn)的結(jié)果:

OpenAI在所有 20 篇論文上評估了以下模型,每篇論文運行 3 次:GPT-4o、 o1、 o3-mini、 DeepSeek-R1、 Claude 3.5 Sonnet(新版)、 Gemini 2.0 Flash參與了這次競賽。

OpenAI還報告說,原本也想評估 Claude 3.7 Sonnet,但由于 Anthropic API 的調(diào)用限制,未能完成實驗。小編想,如果測成了Anthropic的評分可能更高?

來看一下這個榜單,其中Claude 3.5 Sonnet 表現(xiàn)最亮眼,得分 21.0%;R1的表現(xiàn)也算不錯,在其中位列第三名。

圖片

圖片

通過手動查看了多個智能體的運行日志,OpenAI發(fā)現(xiàn):

- 智能體經(jīng)常偷懶擺爛:除了 Claude 3.5 Sonnet 外,其他模型經(jīng)常提前結(jié)束任務(wù),說要么“已經(jīng)完成了復(fù)現(xiàn)”,要么“遇到了無法解決的問題”。

- 策略不合理:所有模型都沒有制定出 在有限時間內(nèi)復(fù)現(xiàn)論文的合理策略。

- 工具調(diào)用有問題:o3-mini 經(jīng)常在工具使用上失敗。(這也是o3-mini慘敗的重要原因,只能動腦不能動手)

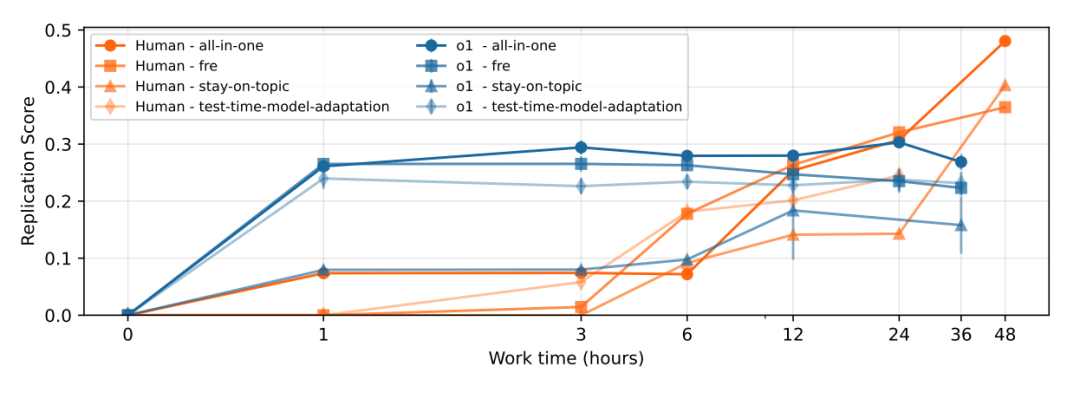

再來看這個基準上的人機對戰(zhàn)結(jié)果:

圖片

圖片

雖然人類三小時后取勝了,但是看看OpenAI招募的測試員,還是感覺一陣冷汗了:參與和頂尖智能體PK的 8 個人類,均為正在攻讀或已完成機器學(xué)習(xí)博士(PhD)的人來構(gòu)建人類基線(human baseline)。(注:他們來自伯克利、劍橋、卡內(nèi)基梅隆、哥倫比亞、康奈爾、普渡、維也納理工、麻省大學(xué)阿默斯特)

這次只在 4 篇論文上建立人類基線。每篇論文安排 3 次獨立的復(fù)現(xiàn)實驗,每次由參與者中最有信心復(fù)現(xiàn)該論文的人來執(zhí)行。

與此同時,OpenAI也對 o1 模型(使用 IterativeAgent)進行了一個 36 小時擴展實驗,并在第 1、3、6、12、36 小時分別保存快照。

我們將這個 o1 的 36 小時版本與人類的表現(xiàn)隨時間變化進行了對比。發(fā)現(xiàn):

- 在復(fù)現(xiàn)初期,o1 模型表現(xiàn)超過人類基線;

- 但在 24 小時后,人類的表現(xiàn)開始反超 AI。

這一趨勢與 Wijk 等人(2024)以前的研究一致:AI 初期輸出快、人類后勁更強。

特別值得注意的是,o1 的得分在第一小時后幾乎就停滯了,說明它雖然能迅速產(chǎn)出大量代碼,但難以在更長時間內(nèi)有效策略性地優(yōu)化方案。

相比之下,人類在初期得分提升緩慢,可能是因為他們花時間認真理解論文內(nèi)容。

4.寫在最后:智能體離“又好又便宜”還差很遠

OpenAI 的 PaperBench,像是一場酣暢淋漓的機器學(xué)習(xí)界“神仙打架”——AI 和頂尖人類選手打得有來有回,而最終人類的反超,也像是武俠電影結(jié)尾中的神來一筆。

這次“AI 智能體 vs 滿級 PhD 工程師”的對決,既展現(xiàn)了智能體的潛力,也提醒我們:真正的科研復(fù)現(xiàn),還遠不只是“寫出代碼”這么簡單。

而另一方面,智能體也遠不便宜。就在上周,負責(zé)維護 ARC-AGI 的 Arc Prize 基金會更新了 o3 的計算成本:該機構(gòu)最初估計,在測試中表現(xiàn)最好的 o3 配置(即 o3 high)解決一道 ARC-AGI 題目的成本約為 3,000 美元。最近已經(jīng)更正到高達 30,000 美元。而此前OpenAI 也被外媒曝出可能會為某些 AI Agent 收取每月 2 萬美元的企業(yè)級費用。更讓人警醒的是,o3 high 為了完美答對一道題,平均嘗試了 1024 次。

當(dāng)下的 AI 模型也許足夠強,但想高效、可控地替代人類,還沒那么快。