37項SOTA!全模態預訓練范式MiCo:理解任何模態并學習通用表示|港中文&中科院

GPT-4o掀起一股全模態(Omni-modal)熱潮,去年的熱詞多模態仿佛已經不夠看了。

要構建全模態智能,意味著能夠理解任何模態并學習通用表示 (Universal Representations)。

現在,港中文、中科院等提出了一種大規模的全模態預訓練范式,稱為多模態上下文MiCo(Multimodal Context),它可以在預訓練過程中引入更多的模態,數據量,模型參數。

借助 MiCo,團隊預訓練的模型在多模態學習中表現出極為令人印象深刻的性能,在目前主流的三大類任務上的評估結果顯示出:

- 10種不同模態的單模態感知基準。

- 25種跨模態理解任務,包括檢索、問答、描述。

- 18種多模態大型語言模型基準,MiCo取得了37項最強性能的記錄。

大規模全模態預訓練

在AI的發展歷程中, 大規模的預訓練已經逐漸成為一種非常有前景的途徑來實現通用智能(譬如大規模訓練的GPT-4o, LLaMA, Stable Diffusion)。

其中圖文對比學習是社區最有影響力的預訓練方法之一,比如,CLIP構建起了數百萬的圖文數據對來實現跨模態的對比學習。

研究者將這樣的對比學習范式推廣到了更多的數據模態上(音頻,點云)同時也實現了更深入的語義理解(LLaVA, VideoChat)。

但是在這多模態與AIGC的時代里,越來越多的數據模態(比如,音頻,3D內容等)被廣泛使用時,僅限于圖文預訓練的基礎模型帶來了包括多模態錯位、誤解、幻覺和偏見放大等問題,這些難題都阻礙了連貫的多模態理解(coherent multimodal understanding)。

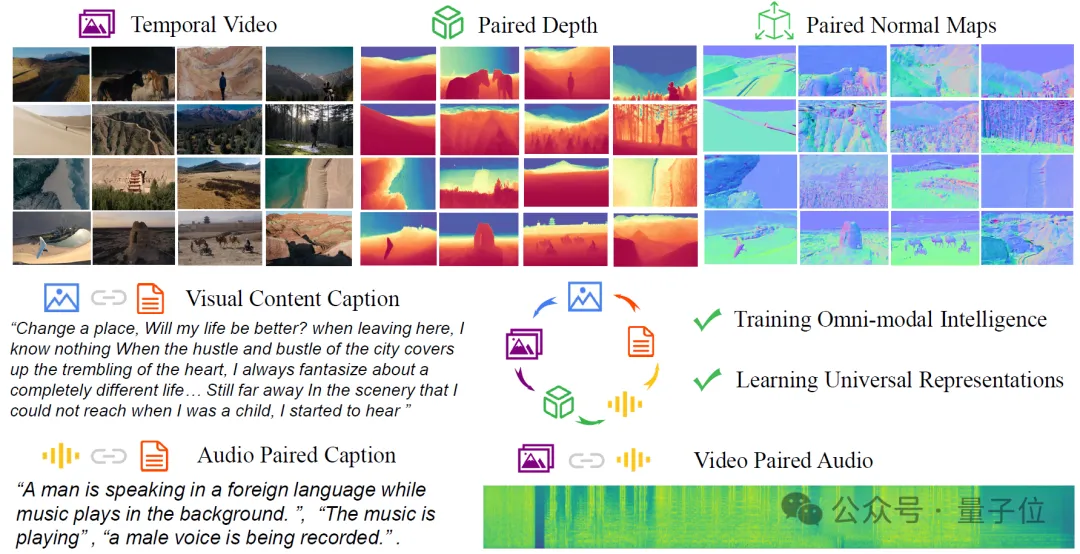

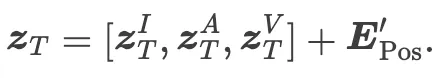

因此,團隊希望提出一種能適用于全模態(不局限于僅圖文音視頻3D內容)的大規模預訓練方法,如圖所示,團隊將視頻與相配對的音頻、文字描述、深度還有法線進行聯合預訓練。

如何設計全模態預訓練中的神經網絡結構?

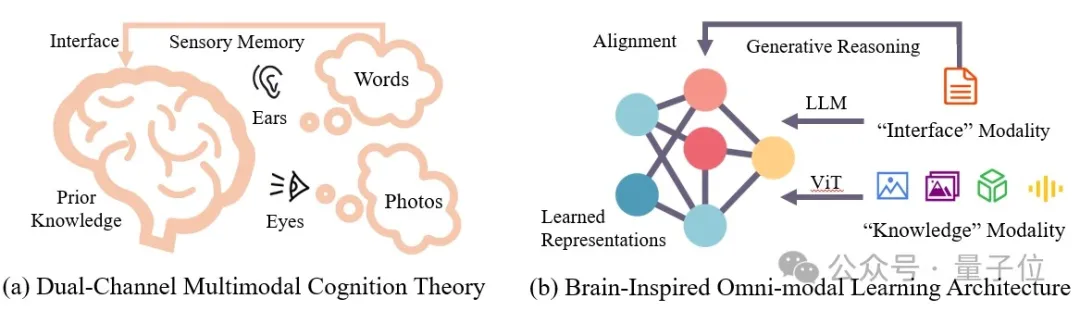

參考人腦中多模態認知的過程,如下圖所示,根據理查德·梅耶的多媒體學習認知理論(Richard E Mayer. Multimedia learning. In Psychology of learning and motivation, volume 41,305 pages 85–139. Elsevier, 2002.),人腦對耳朵和眼睛的感知內容(圖/文/視頻/音頻/3D)有兩個不同的通道來處理他們的感覺記憶。

感覺記憶通過文字將這些多模態信號與先驗知識整合在一起,將新的多媒體信息轉化為長期記憶。

由此團隊能推斷:1)大腦中的多媒體信號共享感知通道,2)文字在大腦中充當推理接口。

受此啟發,團隊將不同的模態分為兩類:“知識模態”和“接口模態”。

知識模態主要來自原始傳感器,以不同的形式貢獻知識。例如,圖像和深度圖提供視覺知識,而音頻和視頻提供聽覺和時空知識。人類語言模態本質上更為抽象,自然地作為了接口模態,促進大腦學習、推理和知識的協調。

為此,團隊設計了一個全模態學習架構(詳細嚴謹的結構設計見文3.2),如上圖 (b) 所示,它有兩個不同的分支:一個用于知識模態,一個用于接口模態,即自然語言。知識和界面模態通過一種新穎的生成推理方法進行對齊(見方法3.4)。

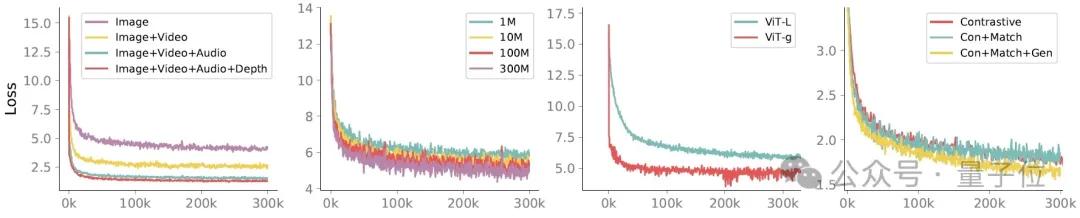

大規模的全模態預訓練算法:多模態上下文與多模態尺度定律(Scaling Law)

“上下文”這一概念在本文指的是在注意力機制為序列中的每個標記分配一個唯一向量來強化了位置之間的潛在關聯。

不同的模態(例如,文本、圖像、音頻)提供了互補信息,因此學習多模態的上下文可以更全面、細致地理解數據,還可以利用每種模態的優勢,引導模型理解不同類型信息之間的交互。因此,團隊尋求構建跨越不同模態的上下文關系,使得模態之間能夠相互增強(見下圖)并將學習能力擴展到全模態。

多模態配對數據中的多模態上下文

首先團隊構建了多模態配對數據的數據集 (圖像,深度,法線,圖像的配對文字,音頻,音頻配對文字,視頻,視頻配對文字)。

然后使用一個全模態編碼器(ViT) 提取多模態特征,然后使用文本編碼器提取文本特征。通過自上而下的設計構建多模態上下文關系:

- 對于整個多模態Embeddings,它們共享一套位置編碼,以構建跨越不同模態的融合上下文關系。

2.然后,對于每個特定模態的上下文,它們通過不同的模態標記來指示模態類別。 - 在同一模態上下文中,團隊使用單獨的上下文編碼構建單一模態上下文關系(詳見原文)上下文編碼取決于特定模態的樣本長度。

同時,不同模態的配對文本內容可以簡單的拼接起來,其位置編碼同樣是共享的:

多數據集中的多模態上下文:圖-文/音頻-文字/視頻-文字等

團隊提出的范式還可以利用現有的大規模文本-圖像、文本-音頻和文本-視頻數據集,共同預訓練模型來學習通用表征。給定數據集 圖文/音頻-文字/視頻-文字數據集,每對數據擁有局部的簡單的上下文,例如,圖文數據對在CLIP中僅對應一個簡單的上下文,這可能會限制模型學習表征(工程中增大Batch Size來緩解)。團隊提出通過跨數據集的聯合采樣,使用采樣編碼(Sampling Embeddings) 標記同一個數據集的配對數據,再層次化地在多數據之間構建多模態上下文。

通過這種方式,團隊成功地結合了現有的多種跨模態數據集,通過構建更通用和復雜的多模態上下文(見上述公式)來預訓練模型,從而實現更好的泛化學習能力、更完善的模態擴展性和數據擴展性來超越現有的預訓練方法。

實驗結果

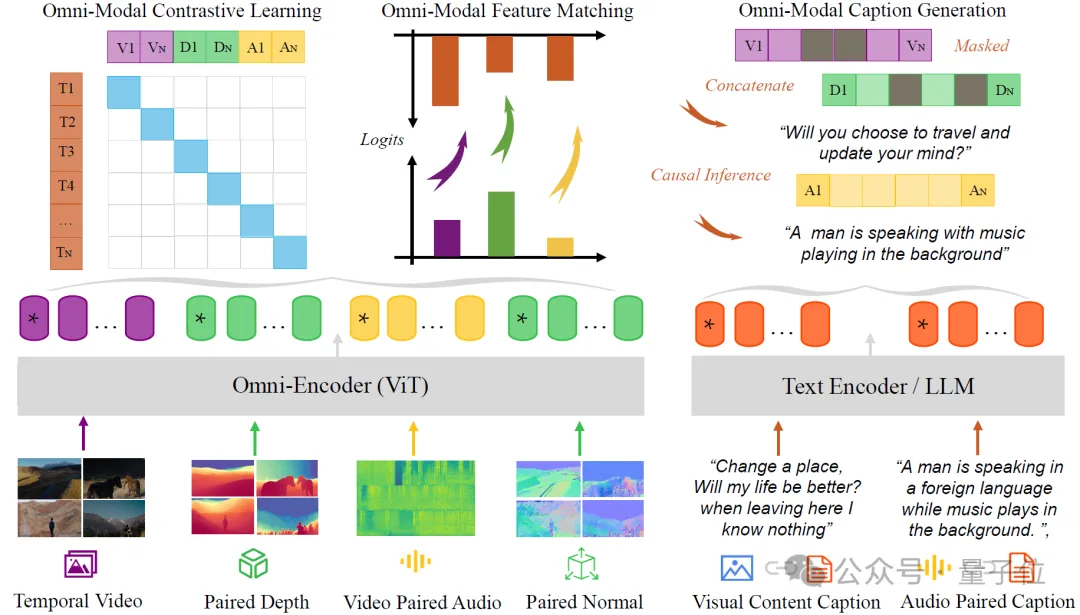

10種單模態感知基準: 7項SOTA

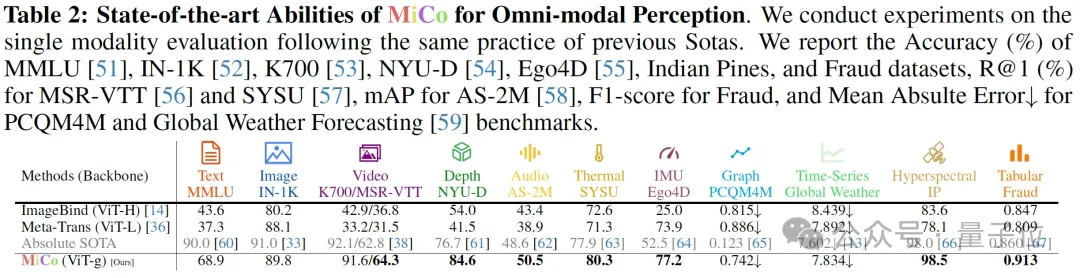

25種跨模態檢索、問答、描述基準: 20項SOTA

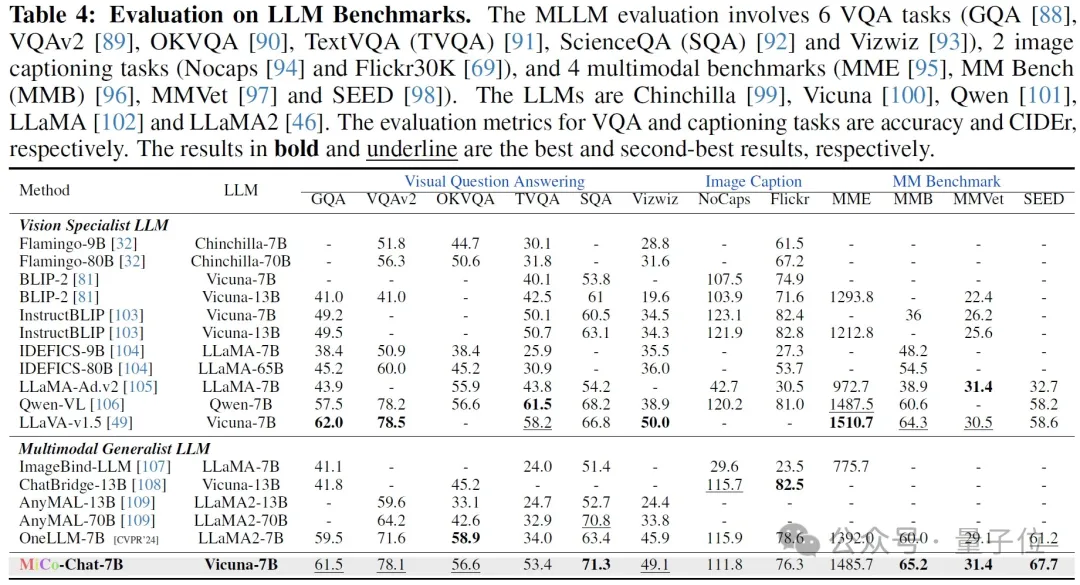

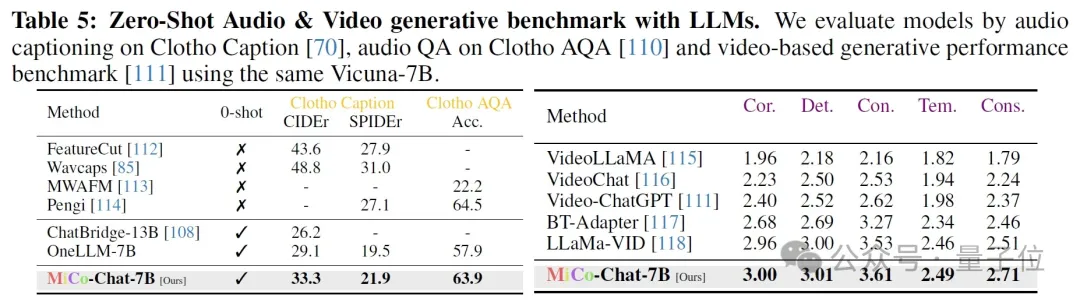

18種多模態大模型問答基準:10項SOTA

結論

在本文中,團隊提出了一個新的大規模預訓練框架 MiCo,用于訓練具有全模態理解能力的基礎模型。通過大規模的實驗,團隊得出結論,全模態學習的關鍵是模擬人腦的多模態認知過程。在 MiCo中,團隊使用RGB圖像、深度和法線圖來模擬人類視覺認知的基本視覺感知能力、距離空間感知和幾何感知。

此外,文字描述、音頻和視頻提供先驗知識、聽覺感知,時空感知能力,有效地提升了模型的對于多模態信息的理解能力,在未來的工作中,團隊計劃通過結合其他更多模態來繼續增強全模態聯合預訓練,包括光流、IMU 數據和事件文件等。

團隊相信MiCo中多模態上下文預訓練算法是人工智能模擬人腦多模態認知的重要嘗試,團隊期待它能夠啟發未來的工作,開發更強大的全模態基礎模型。

項目網站:??https://invictus717.github.io/MiCo/???

開源代碼:???https://github.com/invictus717/MiCo???

Hugging Face模型:???https://huggingface.co/Yiyuan/MiCo-ViT-g-14-omnimodal-300k-b64K??

本文轉自 量子位 ,作者:量子位