大語言模型自動思維鏈提示 原創

摘要:大型語言模型(LLMs)可以通過生成中間推理步驟來執行復雜推理。為提示演示提供這些步驟被稱為思維鏈(CoT)提示。CoT提示有兩種主要范式。一種利用簡單的提示,如“讓我們一步一步地思考”,以促進在回答問題之前逐步思考。另一種使用一些手動演示,每個演示由一個問題和一個推理鏈組成,該鏈導致一個答案。第二種范式的優越性能依賴于逐個手工制作任務特定的演示。我們展示了通過利用LLMs使用“讓我們一步一步地思考”的提示來生成推理鏈,以逐個生成演示,即,讓我們不僅一步一步地思考,還要逐個思考。然而,這些生成的鏈經常伴隨著錯誤。為了減輕這些錯誤的影響,我們發現多樣性對于自動構建演示至關重要。我們提出了一種自動CoT提示方法:Auto-CoT。它以多樣性采樣問題,并生成推理鏈來構建演示。在GPT-3的十個公共基準推理任務中,Auto-CoT始終匹配或超過了需要手動設計演示的CoT范式的性能。代碼可在 ??https://github.com/amazon-research/auto-cot ???上獲取。

1 引言

大型語言模型(LLMs)[Brown等人,2020年,Thoppilan等人,2022年,Rae等人,2021年,Chowdhery等人,2022年]通過將多步驟問題分解為中間步驟,然后產生答案,在復雜推理任務上表現出色。這種推理過程是通過一種非常新的技術激發的:思維鏈(CoT)提示[Wei等人,2022a]。

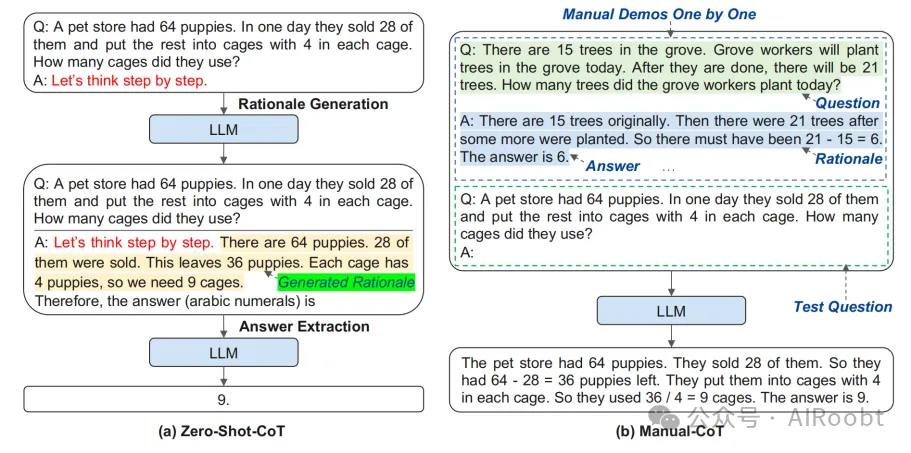

CoT提示可以分為兩大范式。一種是在測試問題后添加一個簡單的提示,如“讓我們一步一步地思考”,以促進LLMs中的推理鏈[Kojima等人,2022年]。由于這種提示范式是任務不可知的,不需要輸入輸出演示,因此被稱為零樣本CoT(圖1左側)。有了零樣本CoT,LLMs已經顯示出是不錯的零樣本推理者。另一種范式是使用手動推理演示的少量提示[Wei等人,2022a]。每個演示都有一個問題和一個推理鏈。推理鏈由理由(一系列中間推理步驟)和預期答案組成。所有演示都是手工設計的,這種范式被稱為手動CoT(圖1右側)。

圖1:零樣本CoT [Kojima等人,2022年](使用“讓我們一步一步地思考”的提示)和手動CoT [Wei等人,2022a](逐個使用手動設計的演示)以及LLM的示例輸入和輸出。

在實踐中,手動CoT的性能比零樣本CoT更強[Wei等人,2022a,Kojima等人,2022年]。然而,這種優越的性能依賴于手工起草有效演示的努力。具體來說,手工起草涉及在設計問題及其推理鏈的演示方面的非平凡努力。此外,設計任務特定演示的人力工作甚至更多:不同的任務,如算術[Roy和Roth,2015年]和常識推理[Talmor等人,2019年],需要不同的演示方式。

為了消除這種手工設計,我們提倡另一種自動CoT范式,以自動構建帶有問題和推理鏈的演示。具體來說,自動CoT利用LLMs使用“讓我們一步一步地思考”的提示,逐個生成推理鏈,即,讓我們不僅一步一步地思考,還要逐個思考。

然而,我們發現這個挑戰不能通過簡單的解決方案有效解決。例如,給定數據集的測試問題,檢索語義相似的問題并調用零樣本CoT生成推理鏈將會失敗。盡管LLMs是不錯的零樣本推理者,但它們并不完美:零樣本CoT在推理鏈中仍然可能出錯。

為了減輕零樣本CoT推理鏈錯誤的影響,我們的分析表明,演示問題的多樣性是關鍵。基于這一洞見,我們提出了一種自動CoT方法來自動構建演示。自動CoT由兩個主要步驟組成。首先,將給定數據集的問題劃分為幾個簇。其次,從每個簇中選擇一個代表性問題,并使用簡單的啟發式方法使用零樣本CoT生成其推理鏈。

我們在十個基準推理任務上評估了自動CoT,包括:(i)算術推理(MultiArith[Roy和Roth,2015年],GSM8K[Cobbe等人,2021年],AQUA-RAT[Ling等人,2017年],SVAMP[Patel等人,2021年]);(ii)常識推理(CSQA[Talmor等人,2019年],StrategyQA[Geva等人,2021年]);(iii)符號推理(最后字母串聯,硬幣翻轉)[Wei等人,2022a]。實驗結果表明,使用GPT-3,自動CoT始終匹配或超過需要手工設計的手動CoT的性能。這表明LLMs可以通過自動構建演示來執行CoT推理。

2 相關工作

本節回顧了構成這項工作基礎的兩條研究線:用于多步推理的思維鏈(CoT)提示和通過示例引導LLMs學習的上下文學習。

2.1 思維鏈提示

CoT提示是一種無需梯度的技術,用于引導LLMs產生導致最終答案的中間推理步驟。Wei等人[2022a]正式研究了語言模型中的CoT提示主題。這項技術激發了LLMs生成一系列連貫的中間推理步驟,這些步驟導致問題最終的答案。研究表明,LLMs可以通過零樣本提示(Zero-Shot-CoT)[Kojima等人,2022年]或手動編寫的少量示例(Manual-CoT)[Wei等人,2022a]執行CoT推理。

零樣本CoT。Kojima等人[2022年]表明,LLMs是不錯的零樣本推理者,其生成的理由已經反映了CoT推理。這一發現激發了我們的工作,利用自生成的理由進行演示。在最近的一項工作中,LLMs生成理由被證明是實用的[Zelikman等人,2022年]。在他們的工作中,LLMs被提示生成理由,并選擇那些導致正確答案的理由。

選擇需要一個帶有注釋答案的問題的訓練數據集。相比之下,我們的工作考慮了一個更具挑戰性的場景,即只給定一組測試問題(沒有訓練數據集),遵循Wei等人[2022a]和Kojima等人[2022年]的CoT提示研究。

手動CoT。通過有效的手動演示,手動CoT通過激發CoT推理能力實現了更強的性能。推理過程的演示是手動設計的。然而,設計問題及其推理鏈的人力工作并非易事。與解決這一限制不同,最近的研究主要關注手工制作更復雜的演示或利用類似集成的方法。一種趨勢是問題分解。在最少到最多的提示[Zhou等人,2022年]中,復雜問題被簡化為子問題,然后按順序解決子問題。另一種趨勢是為測試問題投票多個推理路徑。Wang等人[2022a]引入了一種自我一致性解碼策略,以采樣LLMs的多個輸出,然后對最終答案進行多數投票。Wang等人[2022b]和Li等人[2022年]在輸入空間引入了隨機性,以產生更多樣化的輸出進行投票。他們使用手動設計的演示作為種子集,并生成額外的理由:留下種子集中的一個問題,并使用其余的演示通過LLMs為這個問題生成理由。與依賴手動設計演示的前述研究線不同,我們的工作旨在以競爭性能消除手動設計。

2.2 上下文學習

CoT提示與上下文學習(ICL)[Radford等人,2019年,Brown等人,2020年]密切相關。ICL通過將一些提示示例作為輸入的一部分,使LLMs能夠執行目標任務。ICL不進行梯度更新,允許單一模型普遍執行各種任務。有各種研究線來提高ICL的性能:(i)檢索與測試實例相關的演示,其中流行的實踐是動態檢索給定測試輸入的相關訓練示例[Rubin等人,2022年,Su等人,2022年];(ii)通過添加細粒度信息進行增強,例如整合任務指令[Mishra等人,2022年,Wei等人,2022b,Sanh等人,2022年];(iii)操作LLMs的輸出概率而不是直接計算目標標簽的可能性[Holtzman等人,2021年,Zhao等人,2021年,Min等人,2022a]。

(注釋:為了提高上下文學習的效果,研究人員采取了幾種策略:

1. 檢索相關演示:這種方法類似于我們在準備考試時,會查找和當前題目類似的過往題目來幫助理解。在機器學習中,這意味著動態地找到與當前測試輸入相關的訓練示例,以幫助模型更好地理解和解決問題。

2. 添加細粒度信息:這就像是在解題時,除了題目本身,我們還會提供一些額外的指導信息,比如題目的解題步驟或者注意事項,幫助模型更精確地完成任務。

3. 操作輸出概率:這涉及到調整模型輸出的概率,而不是直接計算目標標簽的可能性。可以類比為在投票選舉中,不是簡單地計算每個候選人的得票數,而是通過一些策略來影響最終的投票結果。)

盡管ICL取得了成功,但研究[Liu等人,2022a,Lu等人,2022年]表明,ICL的強度可能會因上下文演示的選擇而大相徑庭[Liu等人,2022b]。具體來說,提示的格式,如措辭或演示的順序,可能導致性能波動[Webson和Pavlick,2022年,Zhao等人,2021年]。最近的一項工作[Min等人,2022b]甚至質疑了真實輸入輸出映射的必要性:在示例中使用錯誤的標簽只會略微降低性能。然而,現有的ICL分析主要基于具有簡單<input→output>映射的標準分類和多項選擇數據集。我們發現,這些發現可能不適用于具有更復雜<input→rationale→output>映射的CoT提示場景。例如,無論是<input→rationale>映射還是<rationale→output>映射中的錯誤都會導致性能急劇下降(附錄A.1)。

3 自動CoT的挑戰

正如剛剛討論的,ICL的性能依賴于手工制作的示例演示。如在手動CoT [Wei等人,2022a]中報告的,使用不同注釋者編寫的演示在符號推理任務中帶來了高達28.2%的準確度差異,而改變演示的順序在大多數任務中導致不到2%的變化。這表明自動CoT的關鍵挑戰在于自動構建具有好問題及其推理鏈的演示。

回想一下,手動CoT手工制作了一些(例如,8個)演示中的問題。基于相似性的檢索方法被廣泛采用來提示LLMs [Rubin等人,2022年,Su等人,2022年],一個有希望的候選解決方案是使用基于相似性的檢索來采樣演示問題。我們遵循CoT研究中更具挑戰性的假設[Wei等人,2022a,Kojima等人,2022年],即只給定一組測試問題(沒有訓練數據集)。

按照Liu等人[2022a]的做法,我們使用Sentence-BERT [Reimers和Gurevych,2019]對問題進行編碼。對于測試數據集中的每個問題qtest,我們從其余問題中采樣演示問題qidemo(i = 1,...,k)。

我們設計了一個檢索Q-CoT方法,根據余弦相似度檢索top-k(例如,k = 8)相似的問題。

為了與這種基于相似性的方法進行比較,我們還測試了一個相對更基于多樣性的方法:隨機Q-CoT,它為每個測試問題隨機采樣k個其他測試問題。

檢索Q-CoT和隨機Q-CoT都調用零樣本CoT [Kojima等人,2022年]為每個采樣的問題qidemo生成推理鏈cdemoi(理由和答案),因為LLMs是不錯的零樣本推理者[Kojima等人,2022年]。除非另有說明,我們使用具有175B參數的GPT-3 [Brown等人,2020](text-davinci-002)作為LLM。

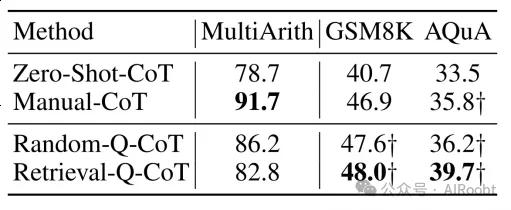

在高層次上,檢索Q-CoT和隨機Q-CoT都以qidemo,cdemoi對(i = 1,...,k)和qtest的串聯作為輸入,以預測qtest的推理鏈,該鏈最終包含答案(如圖1右側所示)。令我們驚訝的是,檢索Q-CoT在算術數據集MultiArith [Roy和Roth,2015](表1)上的表現不如隨機Q-CoT。請注意,檢索方法最初是在有注釋標簽的任務中提出的[Rubin等人,2022年,Su等人,2022年],然而,調用零樣本CoT并不能保證完全正確的推理鏈。因此,我們假設檢索Q-CoT的較差性能是由零樣本CoT的錯誤推理鏈引起的。為了測試這個假設,我們在另外兩個有帶注釋推理鏈的訓練集的數據集GSM8K [Cobbe等人,2021]和AQuA [Ling等人,2017]上進行了檢索Q-CoT的實驗。結果在表1中用?顯示。在有注釋推理鏈的設置下,檢索Q-CoT甚至超過了手動CoT。結果表明,當有人工注釋可用時,檢索Q-CoT是有效的。

表1:不同抽樣方法的準確率(%)。符號?表示使用帶有標注推理鏈的訓練集。

盡管人工注釋很有用,但這種手工努力并非易事。然而,通過零樣本CoT自動生成推理鏈的表現不如手動CoT,特別是當沒有解決問題采樣的挑戰時。為了設計更有效的自動CoT,我們需要更好地理解其挑戰。

3.1 檢索-Q-CoT因相似性誤導而失敗

由于檢索-Q-CoT使用像手冊-CoT中那樣的少量提示性示例,檢索-Q-CoT預期也將表現出競爭力。然而,在檢索-Q-CoT中,推理鏈(包括理由和答案)是由零樣本-CoT生成的:它們可能存在錯誤,導致錯誤的答案。讓我們簡單地將帶有錯誤答案的示例稱為錯誤示例。直觀地說,在檢索到與測試問題相似的問題后,由零樣本-CoT引起的錯誤示例可能會誤導相同的大型語言模型(LLM)以錯誤的答案(例如,復制錯誤)進行類似的推理。我們將這種現象稱為相似性誤導。我們將研究相似性誤導是否導致檢索-Q-CoT性能不佳的原因。

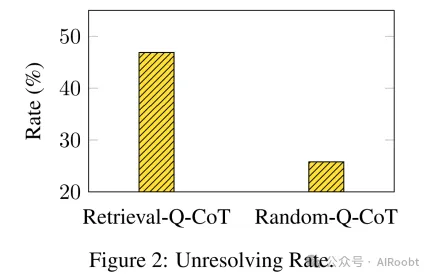

首先,我們在MultiArith數據集的所有600個問題上調用零樣本-CoT。其中,我們收集了128個問題(記為Q),在這些問題上零樣本-CoT生成了錯誤的答案(錯誤率:21.3% = 128/600)。正如我們提到的,有了額外的示例,檢索-Q-CoT和隨機-Q-CoT預期會比零樣本-CoT表現得更有競爭力。在零樣本-CoT失敗的Q中,我們稱檢索-Q-CoT或隨機-Q-CoT仍然失敗的那些問題為它們的未解決的問題。我們將未解決的問題數量除以128(Q中問題的數量)來計算未解決率。更高的未解決率意味著一種方法更可能像零樣本-CoT一樣仍然犯錯誤。

圖2顯示,檢索-Q-CoT(46.9%)的未解決率遠高于隨機-Q-CoT(25.8%)。這表明,在為測試問題抽樣相似問題時,檢索-Q-CoT受到相似性誤導的負面影響。

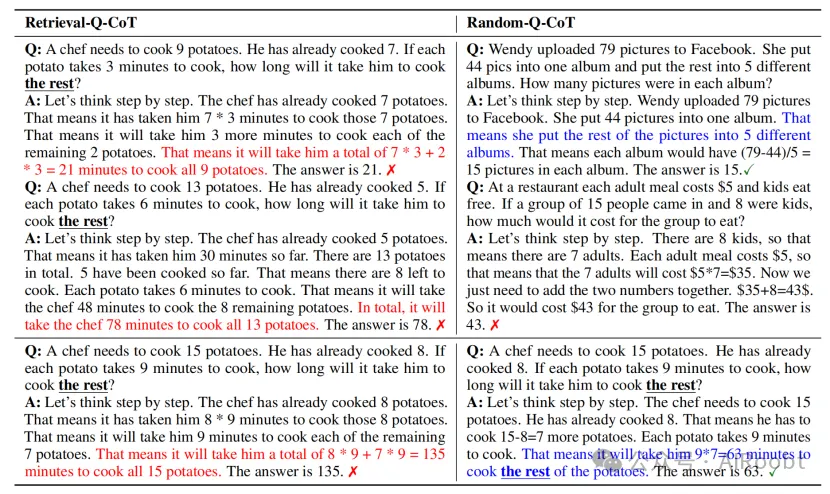

為了證明檢索-Q-CoT的未解決問題傾向于相似,我們在表2中展示了一個案例研究。在左側部分,檢索到的示例問題與測試問題相似,并詢問“他還需要多長時間才能煮熟剩下的?”由零樣本-CoT生成的推理鏈產生的答案涉及“總數”而不是“剩下的”。遵循示例,檢索-Q-CoT也因誤解“剩下的”的含義而失敗。相比之下,隨機-Q-CoT在沒有在示例中犯類似錯誤的情況下,更好地正確理解了“剩下的”,這得益于相對多樣化(隨機)的示例。

3.2 錯誤頻繁出現在同一個簇中

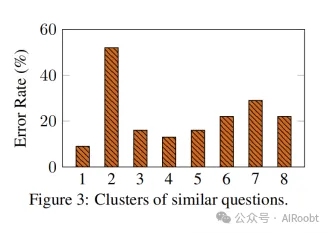

受表2觀察結果的啟發,我們使用k-means將所有600個測試問題分成k=8個簇,每個簇包含相似的問題。有了這些簇和零樣本-CoT(在3.1節中)生成的推理鏈,現在我們好奇某些簇是否包含零樣本-CoT經常失敗的問題。因此,我們計算每個簇的錯誤率(零樣本-CoT答案錯誤的問題數/總問題數)。

表2:檢索-Q-CoT和隨機-Q-CoT構建示例和預測的示例。上半部分包含自動構建的示例,下半部分包含測試問題以及預測的推理鏈。

如圖3所示,存在一個簇(簇2)零樣本-CoT錯誤頻繁(52.3%)。這種現象可能是普遍的,因為零樣本-CoT可能缺乏解決目標任務中某些常見問題的技能。為了方便描述,讓我們將錯誤率最高的簇稱為頻繁錯誤簇(例如,圖3中的簇2)。因此,以零樣本方式生成的推理鏈的不完美性質,使用基于相似性的方法檢索多個頻繁錯誤簇內的類似問題存在風險。對于頻繁錯誤簇中的測試問題,檢索-Q-CoT更容易構建包含多個類似錯誤的示例。結果,檢索-Q-CoT經常像零樣本-CoT一樣犯類似的錯誤,這一點在圖2中的更高未解決率中得到了重申。

3.3 多樣性可能減輕相似性誤導

到目前為止的分析有力地表明,LLMs(大型語言模型)仍然不是完美的零樣本推理器;因此,我們的目標是減輕它們的零樣本-CoT錯誤的影響,特別是減輕Auto-CoT設計中的相似性誤導。

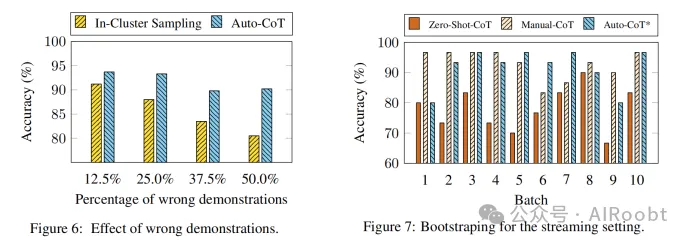

正如我們稍后將展示的(第5.5節),展示一小部分錯誤(例如,8個中的1或2個錯誤示例)不會損害測試問題的整體推理性能。假設所有錯誤示例的問題都落入同一個頻繁錯誤簇;那么從每個不同的簇中抽取一個問題將導致構建所有8個正確示例的機會超過7/8 = 87.5%。由于不同的簇反映了問題的多樣性語義,這種基于聚類的抽樣方法可以被視為基于多樣性的,與基于相似性的檢索-Q-CoT形成鮮明對比。一方面,以多樣性抽樣問題可能減輕相似性誤導的影響(第3.1節)。另一方面,如果我們將每個示例視為一種技能,多樣化的示例似乎涵蓋了更多解決目標問題的替代技能:即使示例中仍然存在一小部分(例如,1/8)的錯誤,性能也不會受到負面影響(將在圖6中展示)。

盡管如此,基于聚類的抽樣方法可能仍然會構建一小部分錯誤的示例,例如來自頻繁錯誤簇中的問題。正如我們稍后將展示的,這些錯誤示例中的一些可能通過啟發式方法被排除。例如,錯誤的示例通常伴隨著長問題和長理由。使用簡單通用的啟發式方法,例如只考慮帶有較短理由的較短問題,進一步幫助減輕零樣本-CoT能力的不完美(附錄C.2)。

4 自動CoT:自動構建思維鏈提示

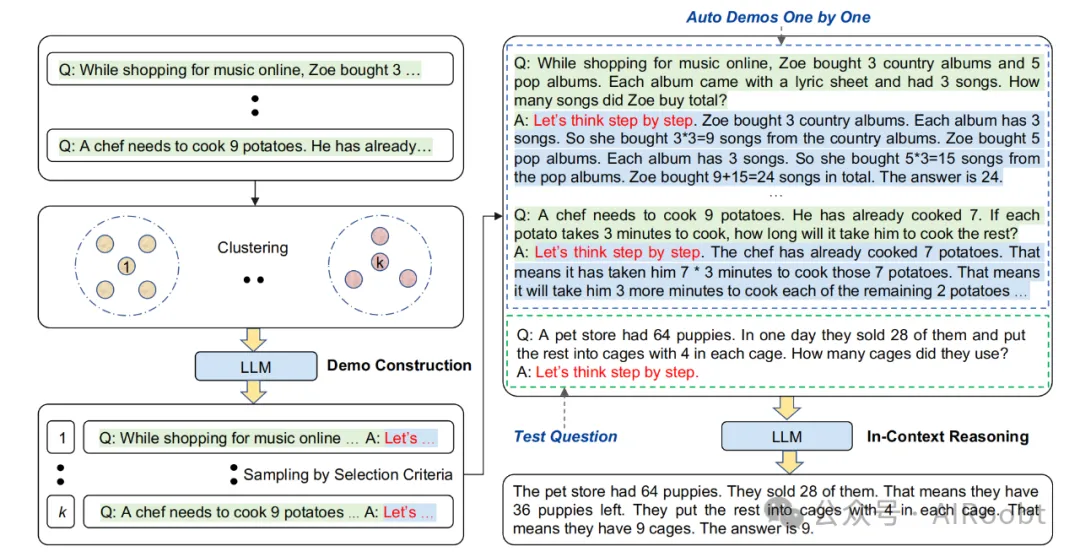

基于第3節中的觀察和考慮,我們提出了一種自動CoT(Auto-CoT)方法,用于自動構建包含問題和推理鏈的示例。自動CoT由兩個主要階段組成:(i)問題聚類:將給定數據集的問題劃分為幾個簇;(ii)示例抽樣:從每個簇中選擇一個代表性問題,并使用簡單的啟發式方法通過零樣本CoT生成其推理鏈。整個過程在圖4中進行了說明。

圖4:自動CoT方法的概覽。與圖1中的手動CoT不同,示例(右側)是使用帶有“讓我們一步一步思考”提示的LLM逐個自動構建的(總數:k)。

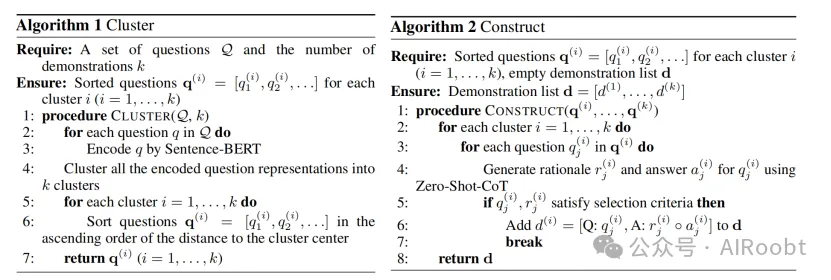

4.1 問題聚類

因為基于多樣性的聚類可能減輕相似性誤導(第3.3節),我們對給定的問題集Q執行聚類分析。我們首先通過Sentence-BERT[Reimers和Gurevych,2019]為Q中的每個問題計算一個向量表示。上下文化的向量被平均化以形成一個固定大小的問題表示。然后,通過k-means聚類算法處理問題表示,以產生k個問題簇。對于每個簇i中的問題,將它們按距離簇i中心的升序排列成一個列表q(i) = [q(i)1, q(i)2, ...]。這個問題聚類階段在算法1中進行了總結。

4.2 示例抽樣

在第二階段,我們需要為這些抽樣問題生成推理鏈,然后抽樣滿足我們選擇標準的示例。

更具體地說,我們為每個簇i(i = 1, ..., k)構建一個示例d(i)(問題的串聯,一個理由和答案)。對于簇i,我們在排序列表q(i) = [q(i)1, q(i)2, ...](由算法1獲得)中迭代問題,直到滿足我們的選擇標準。換句話說,更靠近簇i中心的問題會被更早地考慮。假設正在考慮第j個最近的問題qj(i)。一個提示輸入被制定為:[Q: qj(i). A: [P]],其中[P]是一個單一提示“讓我們一步一步地思考”。這個形成的輸入被輸入到LLM中,使用零樣本CoT[Kojima等人,2022]輸出由理由rj(i)和提取的答案aj(i)組成的推理鏈。然后,通過串聯問題、理由和答案構建第i個簇的候選示例dj(i):[Q: qj(i), A: rj(i)?aj(i)]。

類似于Wei等人[2022a]中手工制作示例的標準,我們的選擇標準遵循簡單的啟發式方法,以鼓勵抽樣更簡單的問題和理由:如果它有一個問題qj(i),不超過60個token和一個理由rj(i),不超過5個推理步驟,則將選定的示例d(i)設置為dj(i)。

正如算法2所總結的,在對所有k個簇進行示例抽樣后,將構建k個示例[d(1), ..., d(k)]。構建的示例用于增強測試問題qtest的上下文學習。具體來說,輸入是所有示例[d(1), ..., d(k)]的串聯,然后是[Q: qtest. A: [P]]。這個輸入被輸入到LLM中,以獲得qtest的最終答案的推理鏈(圖4右側)。

5 實驗

我們簡要描述實驗設置,并展示主要的實驗結果。更多的實驗細節和結果可以在附錄中找到。

5.1 實驗設置

任務和數據集。我們的方法在來自三個推理任務類別的十個基準數據集上進行了評估:

(i)算術推理(MultiArith [Roy和Roth, 2015], GSM8K [Cobbe等人, 2021], AddSub [Hosseini等人, 2014], AQUA-RAT [Ling等人, 2017], SingleEq [Koncel-Kedziorski等人, 2015], SVAMP [Patel等人, 2021]);(ii)常識推理(CSQA [Talmor等人, 2019], StrategyQA [Geva等人, 2021]);(iii)符號推理(最后字母串聯,硬幣翻轉)[Wei等人, 2022a]。

實現。我們使用公共的GPT-3 [Brown等人, 2020] 文本davinci-002版本,擁有175B參數作為LLM [Ouyang等人, 2022],除非另有說明。我們選擇這個LLM是因為它在公共LLM中擁有最強的CoT推理性能,如Kojima等人 [2022] 和Wei等人 [2022a] 報告的。我們還評估了Codex模型 [Chen等人, 2021] (code-davinci-002) 作為LLM。按照Wei等人 [2022a],示例的數量k是8,除了AQuA和Letter (4),CSQA (7),和StrategyQA (6)。

基線。我們將我們的方法與四種基線方法進行比較:零樣本 [Kojima等人, 2022],零樣本CoT [Kojima等人, 2022],少樣本 [Wei等人, 2022a],和手動CoT [Wei等人, 2022a]。零樣本CoT和手動CoT在圖1中進行了說明。零樣本基線將測試問題與提示“答案是”串聯作為LLM輸入。少樣本基線與手動CoT的LLM輸入相同,除了從所有示例中移除了理由。

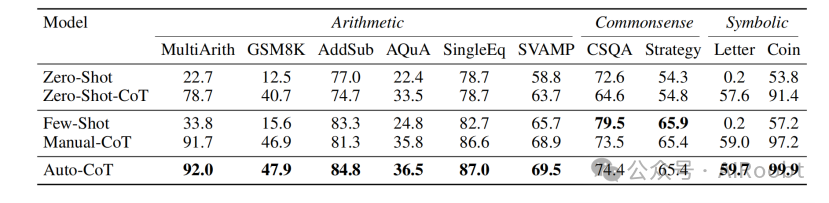

5.2 自動CoT在十個數據集上的競爭性能

表3比較了來自三個推理任務類別的十個數據集上的準確性。零樣本和零樣本CoT的結果取自Kojima等人[2022],少樣本和手動CoT的結果取自Wei等人[2022a],自動CoT的結果是在三次隨機運行中平均得出的。總體而言,自動CoT始終匹配或超過了需要手動設計示例的CoT范式的表現。由于手動設計的成本,手動CoT可能會為多個數據集設計相同的示例(例如,5/6的算術數據集)。相比之下,自動CoT更加靈活和任務適應性:每個單獨的數據集都獲得了自動構建的自己的示例。

表3:來自三個推理任務類別的十個數據集上的準確性

5.3 問題聚類的可視化

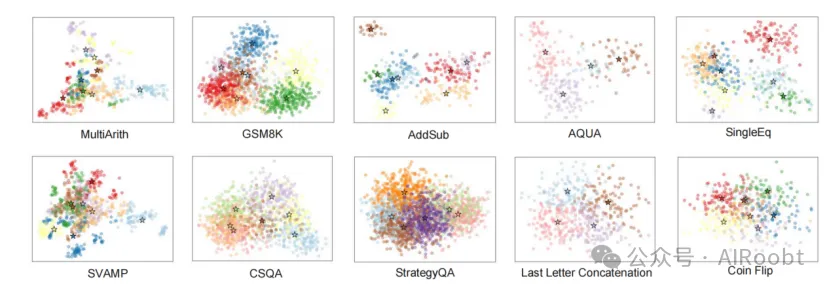

圖5通過PCA投影可視化了十個數據集上的問題聚類。圖示表明存在通用模式,不同的模式可能由不同簇中的問題所特征化。我們在附錄D中展示了自動CoT構建的示例。

圖5:在十個推理任務數據集上的問題聚類。星號表示簇中心。

5.4 使用Codex LLM的普遍有效性

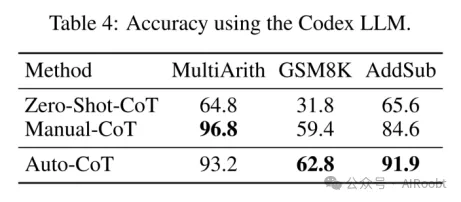

為了評估使用不同LLM的自動CoT的普遍有效性,這里我們將LLM更改為Codex模型[Chen等人, 2021]。如表4所示,與使用GPT-3(text-davinci-002)LLM的表3相比,Codex LLM在手動CoT上帶來了性能提升。盡管如此,使用Codex LLM,自動CoT的整體性能與手動CoT相比仍然具有競爭力,為自動CoT的有效性提供了額外的經驗證據。

5.5 錯誤示例的影響

回想我們在第3.3節中的討論,可能會有錯誤的示例(其答案是錯誤的)。為了看看多樣性是否減輕了這種影響,我們設計了一個In-Cluster Sampling基線,它通過從包含測試問題的同一簇中隨機抽樣問題來構建示例。圖6比較了在MultiArith上不同錯誤示例數量下的準確性。與In-Cluster Sampling相比,auto-CoT(使用基于多樣性的聚類)受錯誤示例的影響較小:即使在呈現50%錯誤示例時,其性能仍然沒有顯著下降。

5.6 更具挑戰性的流式設置

CoT(Chain of Thought,思維鏈)研究通常假設給定了一個帶有測試問題的完整數據集[Wei等人, 2022a, Kojima等人, 2022]。基于給定的數據集,自動CoT會抽樣問題來構建示例。盡管如此,現在我們考慮一個更具挑戰性的流式設置,其中一小批測試問題(比如說m個問題)一次到來,就像在數據流中一樣。

為了應對這一挑戰,我們將自動CoT擴展為自舉版本自動CoT*:(i)初始化一個空集M0;(ii)當第一批問題q1(1), ..., qm(1)到達時,調用零樣本CoT(由于m很小,不進行聚類)為每個qi(1)獲得其推理鏈c(1)i。將問題-推理鏈對(q1(1), c(1)1), ..., (qm(1), c(1)m)添加到M0中,并稱新集合為M1;(iii)當第b批(b > 1)問題q(b)1, ..., q(b)m到達時,在Mb?1中使用現有問題和推理鏈構建示例(像自動CoT一樣),并使用這些示例對每個qi(b)進行上下文推理。將問題-推理鏈對(q(b)1, c(b)1), ..., (q(b)m, c(b)m)添加到Mb?1中,并稱新集合為Mb。

圖7比較了在這個流式設置中每個批次(m = 30)在MultiArith上的準確性(擴展版本:附錄中的圖11)。正如預期的那樣,對于第一批,自動CoT*和零樣本CoT獲得相同的準確性。從第二批開始,自動CoT*的表現與手動CoT相當。這一結果表明,我們的方法在更具挑戰性的流式設置中仍然有效。

6 結論

LLMs(大型語言模型)已經通過CoT(思維鏈)提示顯示出推理能力。手動CoT的優越性能依賴于手工制作的示例。為了消除這種手工設計,我們提出了自動CoT來自動構建示例。它通過抽樣多樣性的問題并生成推理鏈來構建示例。在十個公共基準推理數據集上的實驗結果表明,使用GPT-3,自動CoT始終匹配或超過了需要手工設計示例的CoT范式的表現。

Zhang Z, Zhang A, Li M, et al. Automatic chain of thought prompting in large language models[J]. arXiv preprint arXiv:2210.03493, 2022.

Shanghai Jiao Tong University, ?Amazon Web Services

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/iDGJLvKgaydJbCi3ySo1QQ??