多模態CoT思維鏈架構來了,現已開源|來自廈大&騰訊優圖

多模態大模型,也有自己的CoT思維鏈了!

廈門大學&騰訊優圖團隊提出一種名為“領唱員(Cantor)”的決策感知多模態思維鏈架構,無需額外訓練,性能大幅提升。

在 ScienceQA 上,基于GPT-3.5的Cantor準確率達到了82.39%,相比基于GPT-3.5的思維鏈方法提升了4.08%。

在更具挑戰性的MathVista上,基于Gemini的Cantor準確率比原始Gemini提高了5.9%。

目前Cantor論文已上傳arXiv,代碼也已經開源。(地址在文末領取)

多模態專屬思維鏈

思想鏈(Chain-of-Thought, CoT)是一種廣泛應用的提示方法,通過添加中間推理步驟,可以顯著增強大模型的推理能力。

然而,在視覺推理任務中,模型不僅需要把握問題背后的總體邏輯,還需結合圖像信息進行具體分析。

多模態思維鏈應運而生。

現有的多模態思維鏈方法通常將問題分解為多個相關的子任務,并調用各種外部工具依次處理。

然而,由于視覺信息不足和低級感知工具的局限性,這種范式在決策中面臨潛在的“決策幻覺”,以及低級感知工具無法提供高級推理信息的挑戰。

Cantor架構賦予多模態大語言模型(MLLM)或大語言模型(LLM)像合唱團中的領唱員一樣的協調能力:

首先使MLLM或LLM同時處理視覺和文本上下文,形成全面的理解并進行決策感知,避免決策幻覺。

隨后,將具體任務分配給MLLM 扮演的“專家”,以獲得高級的認知信息以進一步輔助推理。

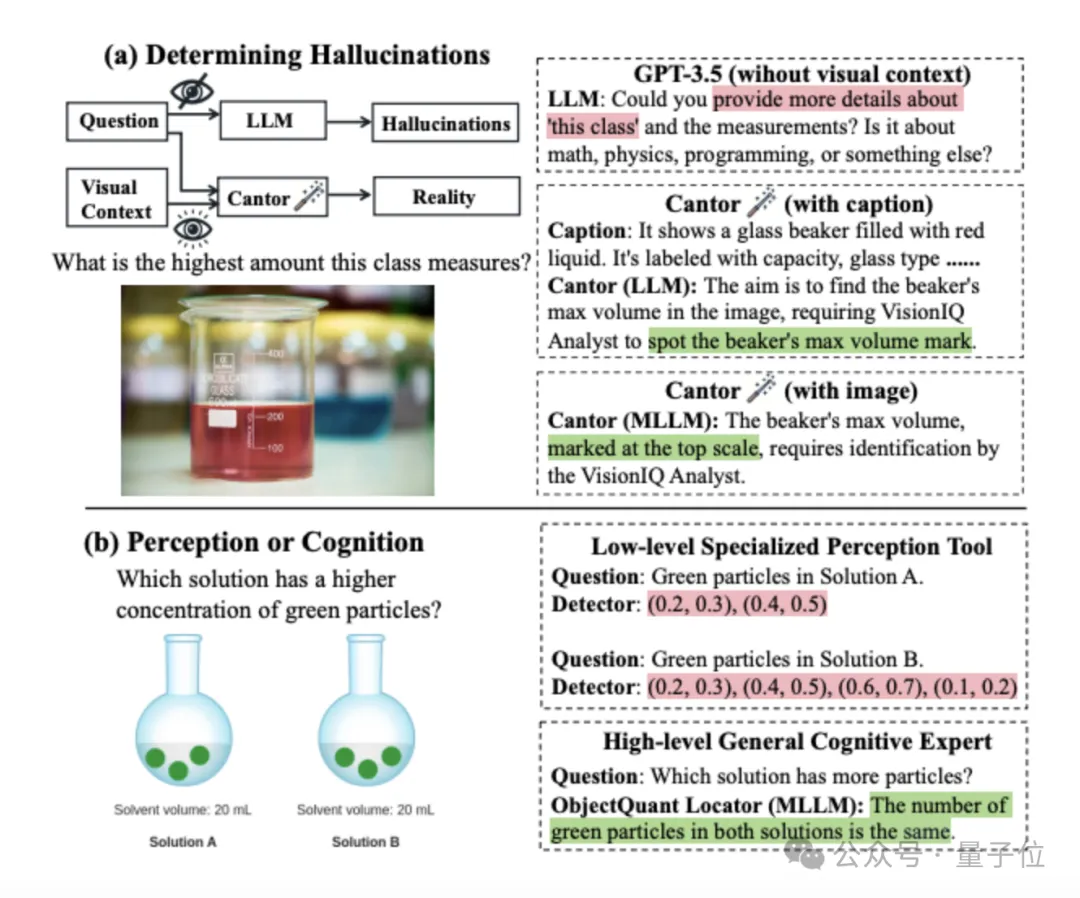

圖中(a)展示了不同視覺信息對決策的影響:

- 在沒有視覺上下文的情況下,詢問GPT-3.5燒杯的最大刻度,會由于缺乏圖像信息而無法回答,出現決策幻覺,要求提供更多信息。

- 基于LLM的Cantor通過字幕引入了視覺語境,避免了決策幻覺,提出了合理的解決方法。

- 基于MLLM的Cantor通過圖像加強了視覺語境,進一步提高了決策質量,將子任務具體化。

圖中(b)展示了不同視覺工具的比較:

- 對于目標檢測相關的子任務,傳統方法使用的低級感知工具(如檢測器)只能獲得基本數據(如坐標)。這些低級線索需要后續的進一步整合才能得到有用信息,這會增加推理負擔。

- 由MLLM扮演的高級認知專家可以直接獲得高級推理信息(如目標的相對數量關系),有助于后續推理。

決策生成+執行兩步驟

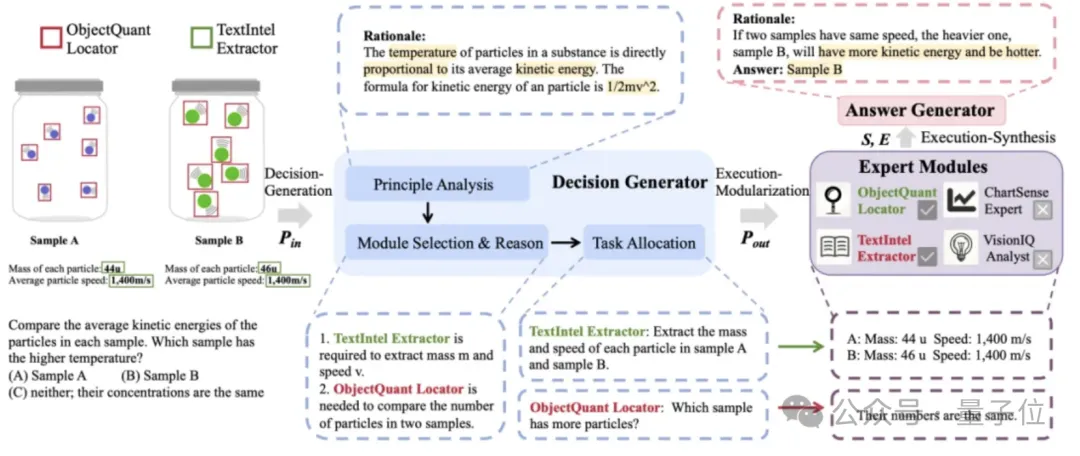

Cantor的架構如下,它包含兩個主要步驟:決策生成和執行。

前者對問題進行分析與解耦,結合各種專家模塊特性,生成合理的決策。

后者調用各種專家模塊執行子任務,并匯總信息加以思考,生成最終答案。

團隊具體設計了四種專家模塊:

- TextIntel Extract:此模塊會按要求針對性地提取圖像中的文本。它對于包含文本和圖形元素混合的圖像特別有用。

- ObjectQuant Locator:此模塊用于識別并定位圖像中的對象。它在比較數量和識別空間關系等方面有優勢。

- VisionIQ Analyst:此模塊用于處理和解釋視覺數據,它能夠處理任何與圖像內容相關的查詢,善于分析圖像。

- ChartSense Expert:此模塊專門分析和解釋圖表中的信息。它可以提取數據點,了解趨勢,并識別圖表中的標題、軸、標簽和圖例等關鍵組件。

決策生成部分讓MLLM或LLM扮演決策生成器,也就是充當決策大腦,先對問題進行分析,并結合各專家模塊特點,分配子任務,并給出分配理由。

例如要比較兩瓶溶液的溫度大小時,Cantor會先分析粒子溫度與粒子動能的關系,分析粒子動能的表達式為1/2mv^2。并結合圖像信息與專家模塊特點,為TextIntel Extractor和ObjectQuant Locator分別分配子任務:

1、提取樣品A和樣品B中每個顆粒的質量和速度。

2、哪個樣品的粒子數量更多?

該步驟有以下特點:

最初,LLM或MLLM被用作決策生成器,充當決策的大腦。

接下來,團隊提供多個專家模塊,以完成各種類型的子任務,充當決策的四肢。這種集成確保了決策生成既全面又精細,能夠充分利用了每個模塊的優勢。

此后,決策生成器根據從原理分析中獲得的見解,為選定的專家模塊量身定制任務,這種動態的任務分配提高了Cantor的效率和性能。

執行又分為模塊化執行和匯總執行兩步:

一是模塊化執行:

在這個階段Cantor通過調用各種專家模塊來完成決策生成階段分配的子任務,以獲得補充信息。

值得注意的是,團隊只使用MLLM來扮演各種專家模塊,以獲得高級的認知信息輔助推理(如數量的大小關系,位置的相對關系)。

例如,對應上一步分配的子任務,TextIntel Extractor和ObjectQuant Locator分別獲得以下答案:

1、樣品A:質量44u,速度1,400m/s。樣品B:質量46u,速度1,400m/s。

2、兩個樣品的粒子數量相同。

?

二是匯總執行:

在這個階段Cantor匯總子任務和子答案的信息,并結合基本原理,生成最終答案。

其中包括了三個關鍵,首先通過提示,讓MLLM或LLM扮演一個知識淵博并且善于整合信息的答案生成器,這既保證他的專業性,能對問題有基本判斷,又保證他能更好地整合信息。

其次為了可解釋性,展示模型的思維過程并提高其思維能力,要求它先生成為答案的基本原理,然后生成相應的選項。

最后要求Cantor保持理性與批判性,不要完全依賴模塊執行獲得的信息。

免訓練也能超越微調方法

Cantor分為兩個版本,Cantor(GPT-3.5)將GPT-3.5作為決策生成器和答案生成器,以及Cantor(Gemini)將Gemini Pro 1.0作為決策生成器和答案生成器。

團隊在ScienceQA和MathVista兩個復雜的視覺推理數據集上進行了實驗。

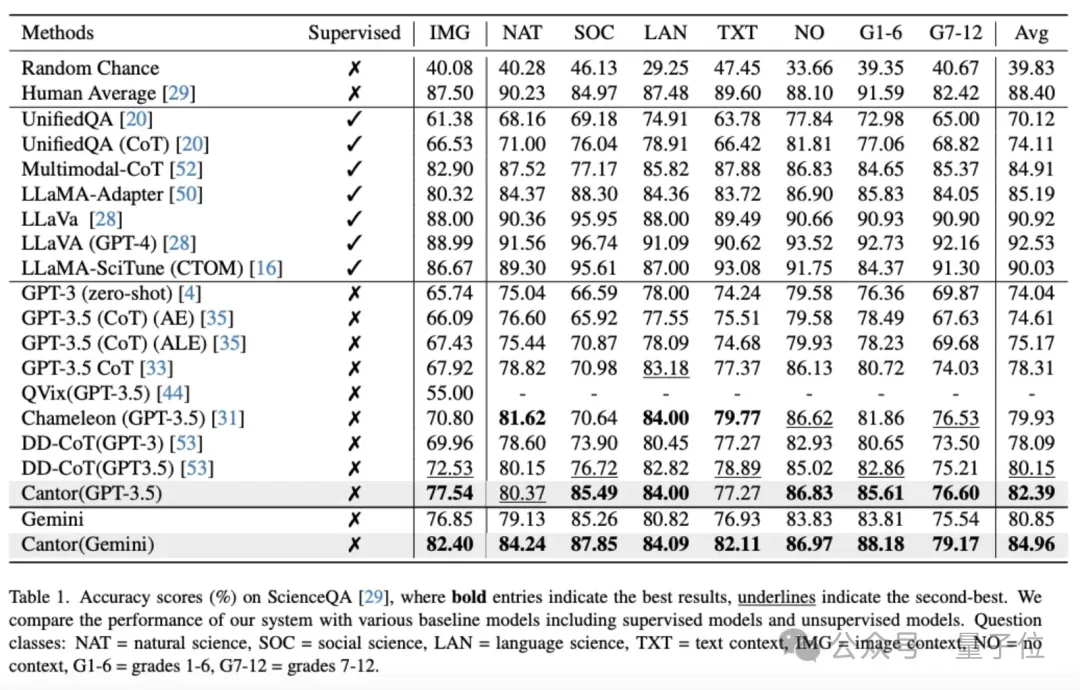

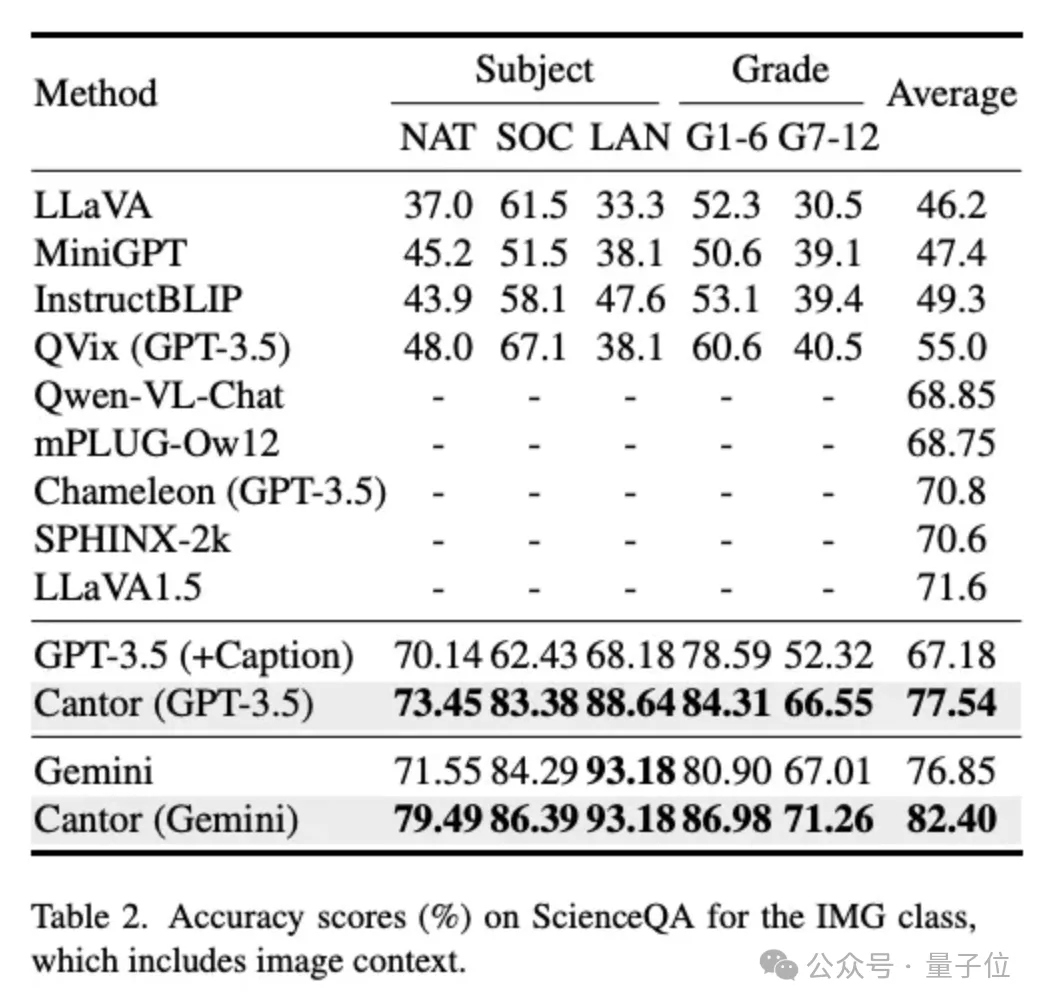

在ScienceQA上的實驗結果如下:

結果顯示使用GPT-3.5作為基本LLM進行決策和回答,Cantor的準確率達到82.39%,比GPT-3.5提示的思想鏈(CoT)提高了4.08%。

使用Gemini作為決策生成器和答案生成器,Cantor的準確率達到84.96%,大大超過了所有免訓練方法,甚至優于UnifiedQA(CoT)和MM-CoT等微調方法。

團隊進一步展示了ScienceQA中IMG類的性能,該類的所有問題都包括了圖像上下文。

可以看出,基于GPT-3.5的Cantor在各種問題上都顯著超過了基線,甚至超過了一些著名的MLLMs,如SPHINX和LLaVA-1.5。

Cantor(Gemini)性能相比于基線也得到了顯著增長。

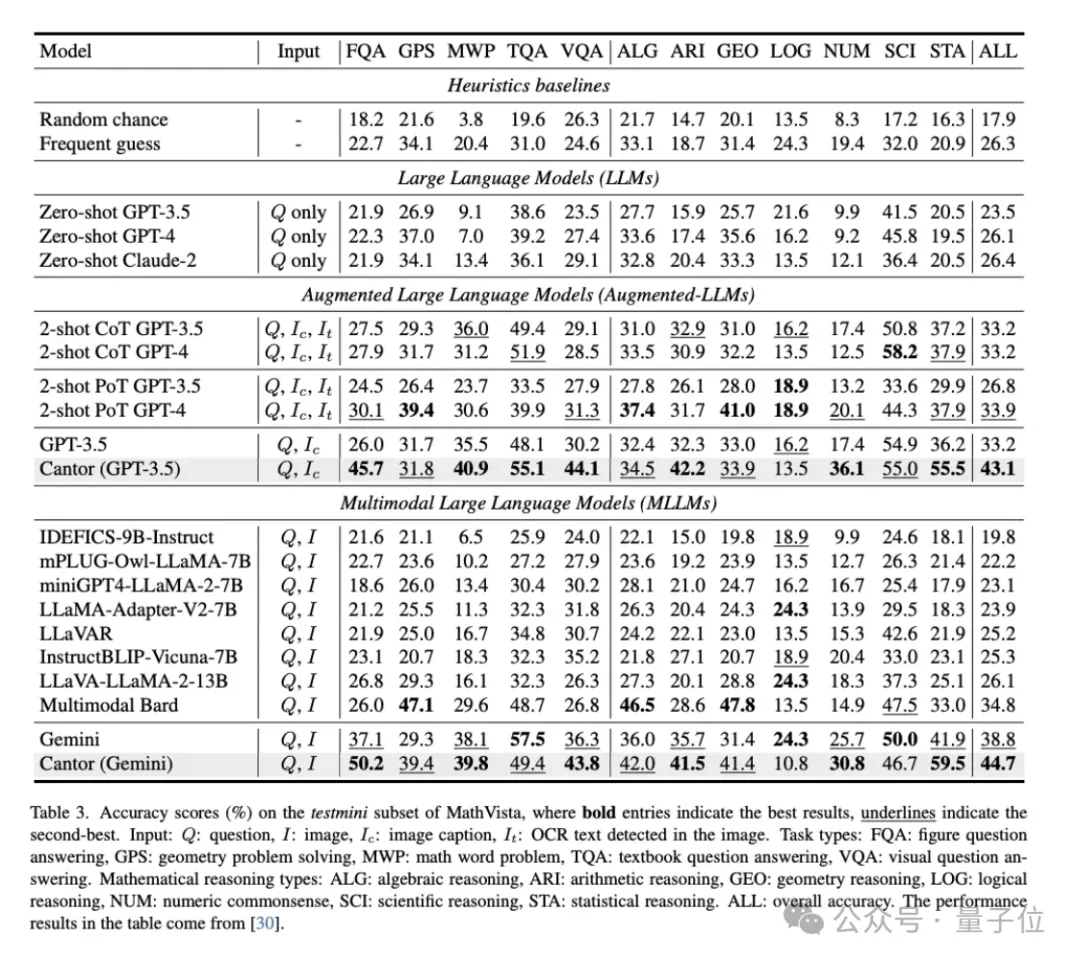

MathVista是一個具有挑戰性的數據集,它將各種數學推理任務與可視化任務集成在一起。

上表比較了不同方法的性能。從一般的視覺問題回答到專業的數學問題,Cantor在幾乎所有類型的問題中都大大超過了基線。

這表明,正確的決策和模塊化專家可以激發他們細粒度、深入的視覺理解和組合推理能力。

值得注意的是,Cantor(GPT-3.5)甚至超過了基于CoT和PoT的GPT-4。

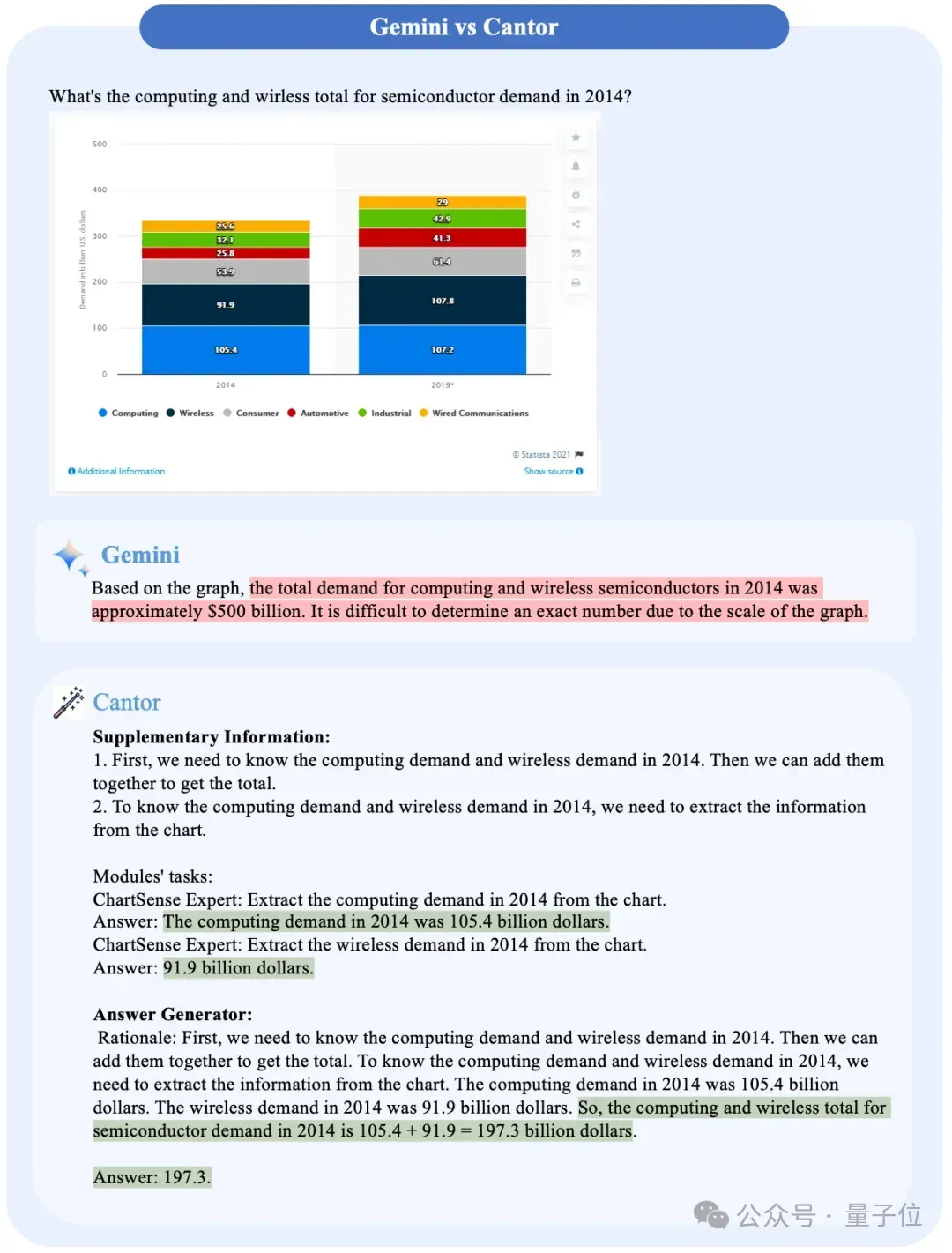

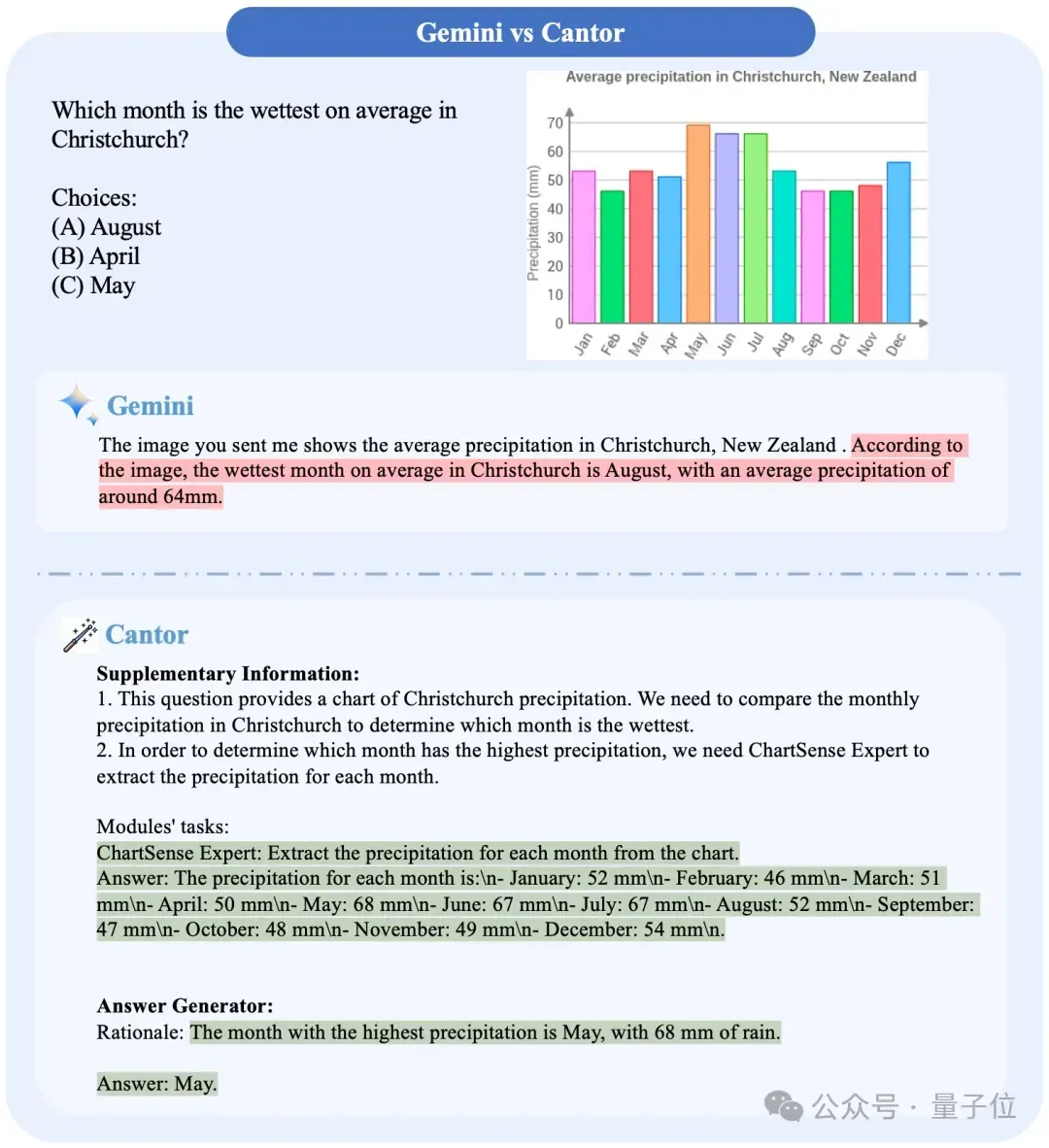

團隊進一步展示了Gemini與Cantor(Gemini)的具體例子比較:

可以看出Cantor通過任務分配,以及讓Gemini進行角色扮演,做到了原來難以做到的事情,并且正確得出了答案。

值得注意的是,即使Gemini在一些問題上答對了,但是它的推理過程其實是有問題的,相比之下Cantor沒有出現這個問題。

論文地址:??https://arxiv.org/abs/2404.16033???

項目地址:???https://ggg0919.github.io/cantor/??

本文轉自 量子位 ,作者:量子位