顛覆認知!多模態模型思維鏈評估白皮書:反思機制成勝負手,感知任務竟被CoT拖后腿

論文:https://arxiv.org/pdf/2502.09621

主頁:https://mmecot.github.io

代碼:https://github.com/CaraJ7/MME-CoT

數據集:https://huggingface.co/datasets/CaraJ/MME-CoT

亮點直擊

- 精心策劃了 MME-CoT 基準,涵蓋了六種多模態推理場景的綜合范圍。數據收集和標注過程經過嚴格的人為驗證,旨在為社區提供高質量的多模態推理評估數據集。

- 識別了現有基準中的關鍵問題,并引入了專門針對多模態 CoT 推理的全面評估套件,該套件仔細檢查了推理的質量、魯棒性和效率。

- 對具有推理能力的最先進的多模態模型進行了廣泛的實驗和分析。總結了我們的觀察和見解,希望能激發未來在推理性能方面的進步。

背景

大語言模型(LLMs)中鏈式思維(Chain-of-Thought, CoT)的出現展示了超強的推理能力,這一點在最近的OpenAI o1和DeepSeek-R1中都得到了充分體現。然而,這一能力能多大程度地幫助視覺推理,并且我們又應該如何細粒度地評估視覺推理呢?

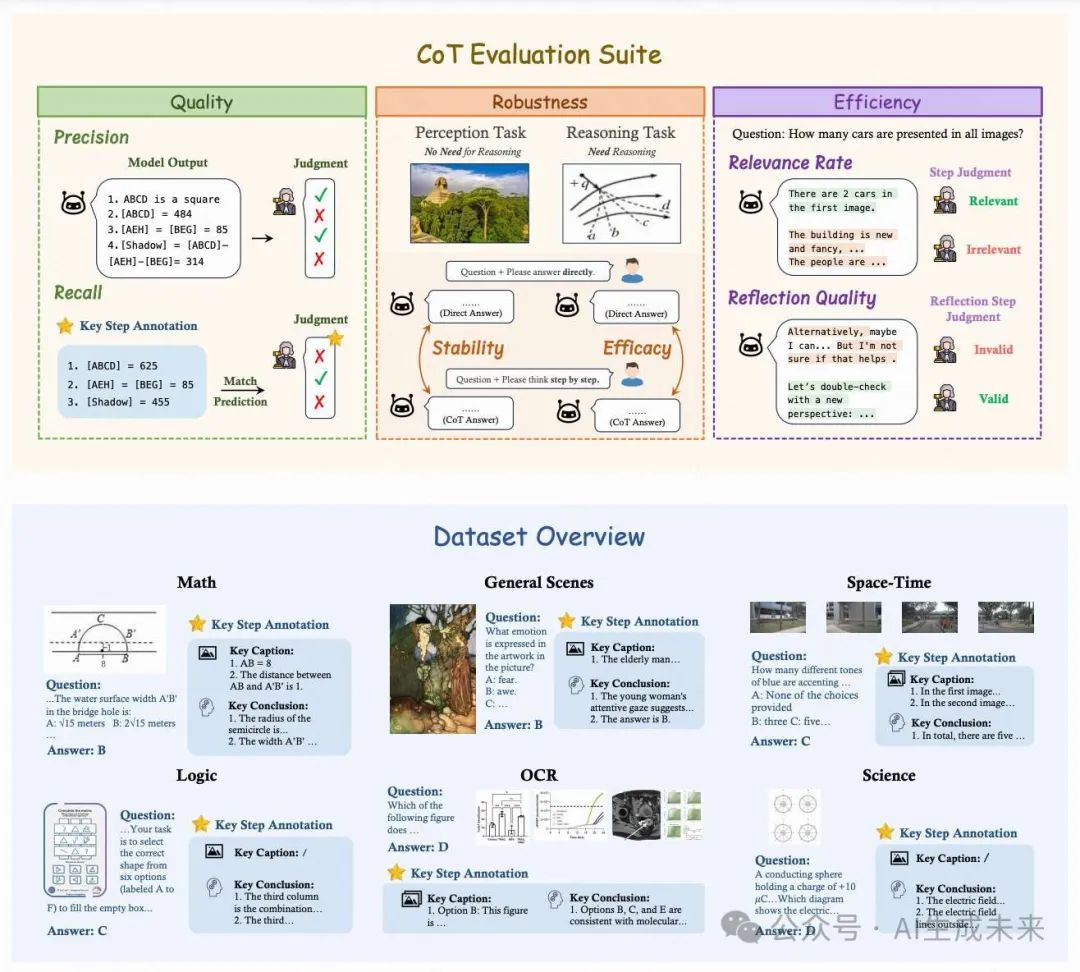

為此,來自港中文MMLab的研究者們提出了MME-CoT。這是一個全面且專門用于評估LMMs中視覺推理能力的Benchmark,包括了數學、科學、OCR、邏輯、時空和通用場景。MME-CoT與之前的LMM的Benchmark最大的區別在于,提出了一個嚴格且多方面的評估框架,細粒度地研究視覺CoT的不同方面,評估其推理的質量、魯棒性和效率。

各種最新推出的LMM,包括Kimi k1.5, GPT-4o, QVQ等等都在MME-CoT上進行了測試。同時,研究者們還把圖片轉成caption之后測試了最近爆火的DeepSeek-R1以及o3-mini。

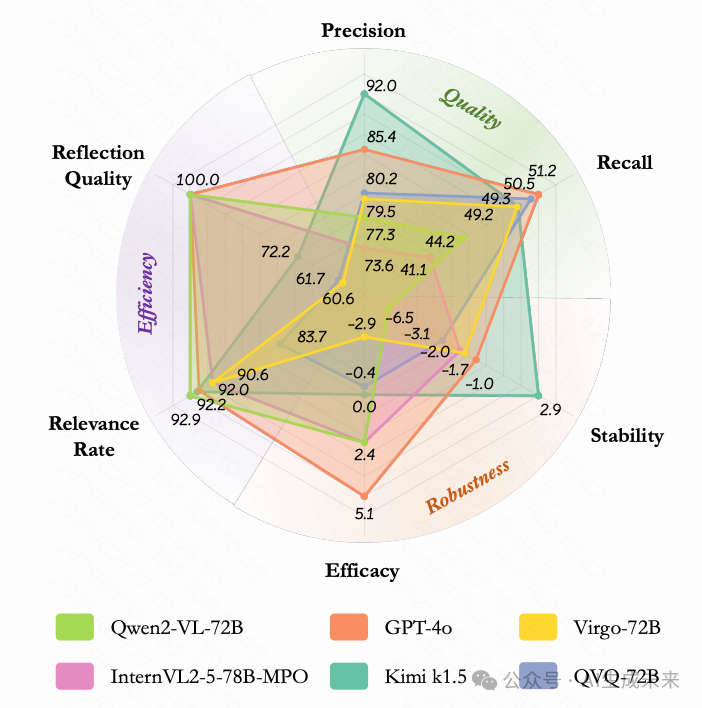

根據實驗結果,文章中得到了如下有價值的結論:

- CoT質量:Kimi k1.5 > DeepSeek-R1 >> o3-mini CoT魯棒性:o3-mini > Kimi k1.5 > DeepSeek-R1 CoT效率:o3-mini > Kimi k1.5 > DeepSeek-R1 值得一提的是,DeepSeek-R1的文本推理能力非常出眾。僅僅使用圖片的caption就可以在precision上超過真實看到圖片的GPT-4o。最后的CoT質量也與GPT-4o僅有1.9%之差。

- 其次,反思能力的引入顯著提升了CoT質量,所有具備反思能力的LMM都實現了較高的CoT質量表現。例如QVQ達到了62.0%的F1分數,大幅超過Qwen2-VL-72B 6.8%。而Kimi k1.5更是超越GPT-4o達到最佳質量。

- 在魯棒性方面,我們發現大多數早期模型在感知任務中都受到CoT的負面影響,表現出有害的過度思考行為,其中最顯著的案例是InternVL2.5-8B,在感知任務中應用CoT后性能下降了6.8%,這嚴重制約了將CoT推理作為默認操作的可行性。

- 最后,關于CoT效率,我們觀察到輸出長CoT的模型普遍存在步驟的相關性不足的問題。模型容易被圖像內容分散注意力,過度關注圖像而忽視了對題目的解答,尤其是在處理通用場景、時空和OCR任務時。實驗結果顯示,約30%到40%的反思步驟未能有效協助問題解答,這暴露出當前模型反思能力的重要缺陷。

測評指標設計與數據組成

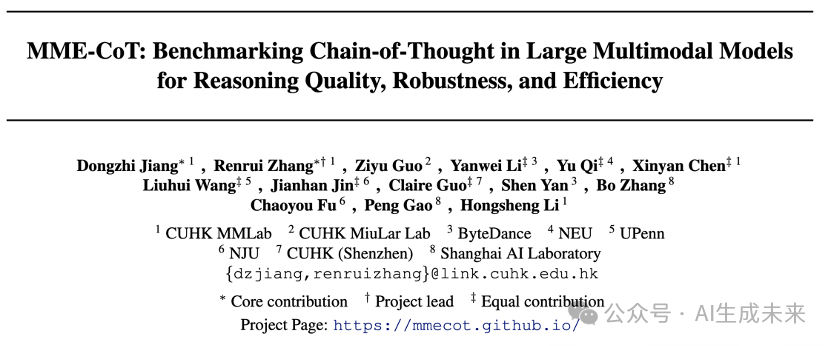

目前絕大多數的LMM的Benchmark都只評估最終答案的正確性,忽視了LMM整個的CoT的推理過程。為了能全面地了解視覺CoT的各個屬性,研究者們提出了三個不同的評估方向,每個方向致力于回答一個關鍵的問題:

CoT的質量:每個CoT步驟是否有用且準確,不存在幻覺?

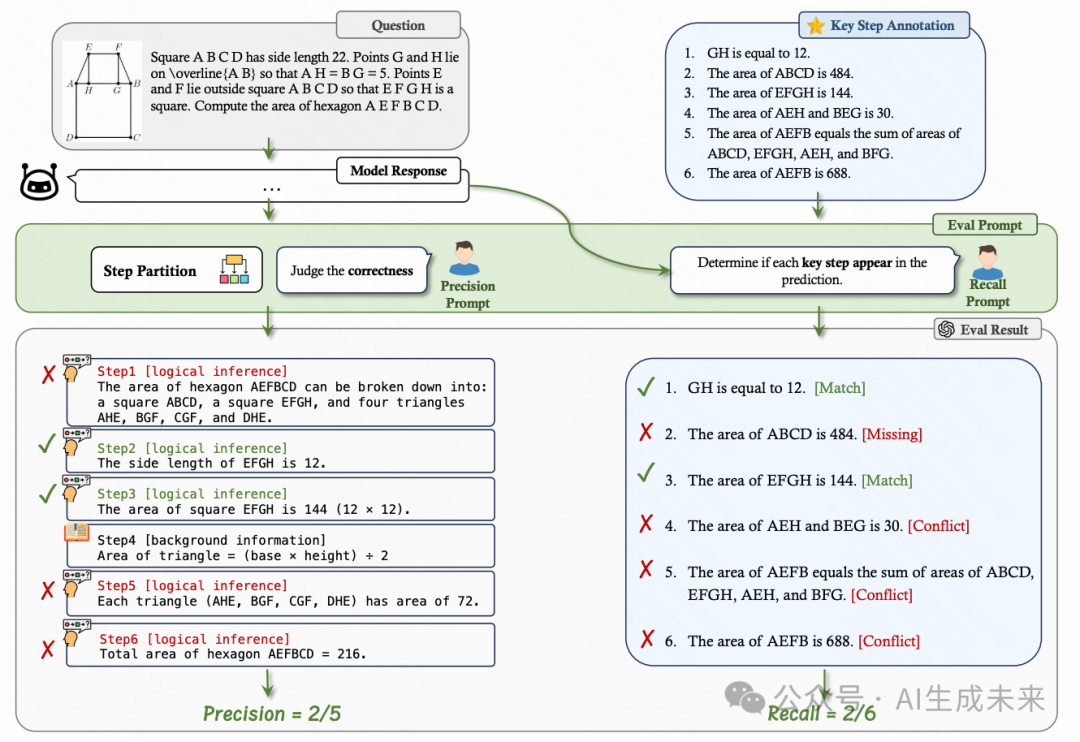

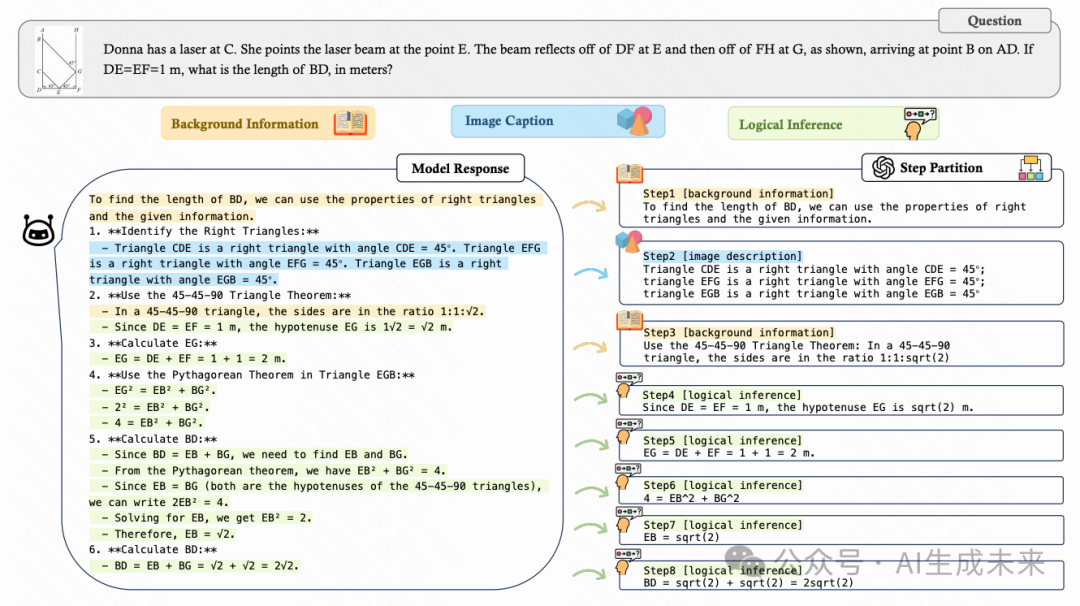

只評估回答的結果忽略了模型通過錯誤的邏輯或隨機猜測得出正確答案的情況。這往往造成了模型推理能力被夸大的假象。為了深入研究推理過程,研究者們引入了兩個可解釋的指標來評估CoT的質量:

- 召回率 (Recall):評估模型的回答有多少能與正確解題的必要步驟匹配。這個指標是用來量化推理的步驟是否能對于得到正確答案有幫助,以及推理鏈是否完整。匹配的過程由GPT-4o完成。

- 精確率 (Precision):評估模型回答的每一步的準確程度來考查模型的幻覺以及邏輯的準確性。為了評估這一指標,研究者們首先使用GPT-4o將模型的回復切分成不同類型的步驟:背景知識、圖片描述以及邏輯推理。然后繼續對圖片描述以及邏輯推理步驟判定每步是否正確。

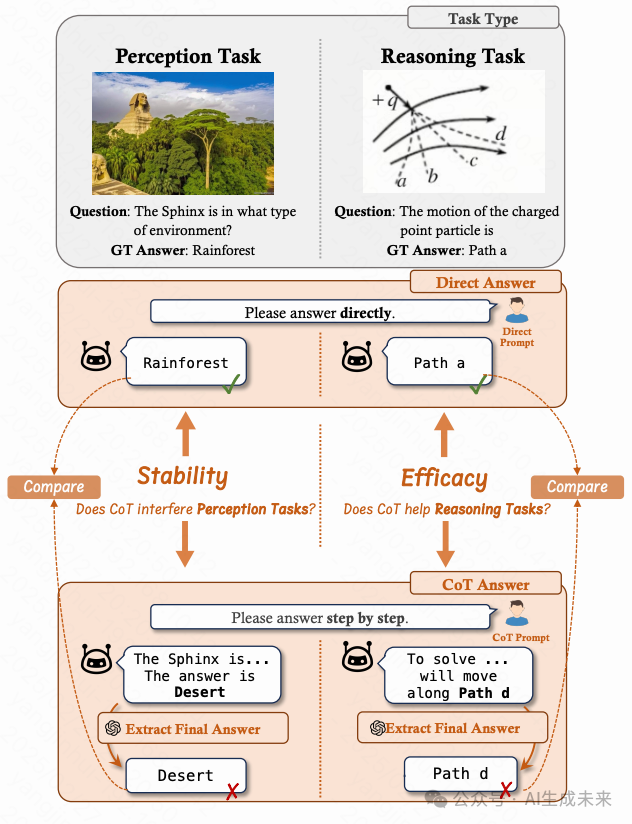

CoT的魯棒性:CoT是否干擾感知任務,它在多大程度上增強了推理任務?

現有研究主要關注CoT對推理任務帶來的性能改進,卻往往忽視了CoT是否會無意中破壞模型對于僅需要感知的任務的能力。隨著o1以及R1的爆火,CoT逐漸已成為模型的默認的推理策略。然而,模型無法提前預知用戶提出的問題類型,也不確定使用CoT來回答是否比直接給出答案會有更高的準確率。因此,在目前的時間點上,CoT在不同類型任務下的魯棒性變得格外重要。為了衡量魯棒性,MME-CoT包括了兩個任務類別:感知任務和推理任務,以及兩種不同的Prompt形式:要求模型直接回答(answer directly)以及CoT回答(think step by step)。

- 穩定性 (Stability):檢查CoT是否對模型在感知任務上的表現產生負面影響

- 有效性 (Efficacy):檢查CoT是否真的幫助模型提高在復雜推理任務上的表現

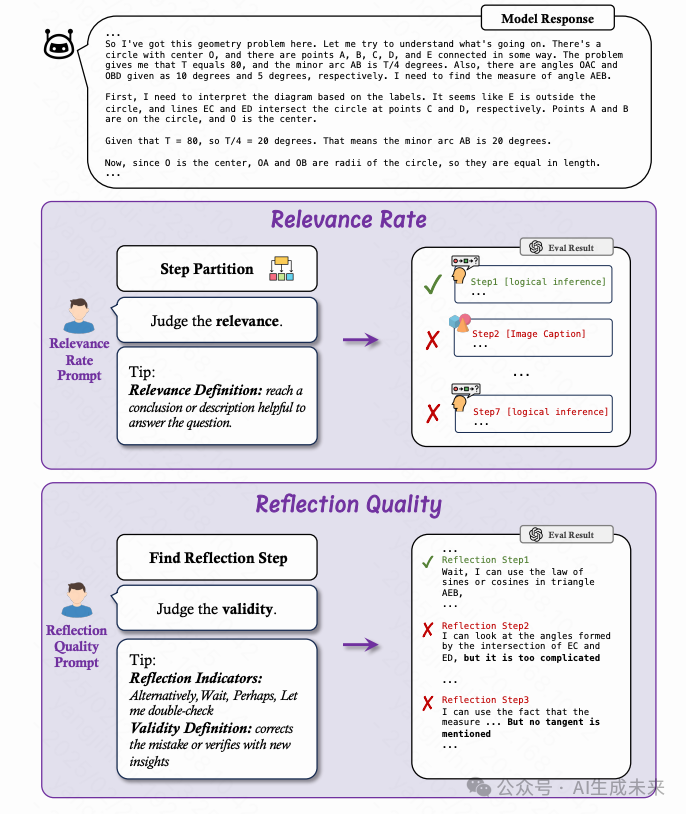

CoT的效率:使用CoT的推理效率是怎么樣的?

最近的o1類模型通過采用超長的CoT和反思步驟而取得了非常好的效果。這提出了一個關鍵的權衡問題:這種方法是否在準確性和計算成本之間取得了最佳平衡?為了研究這一點,研究者們首次對LMMs中CoT的效率進行研究,使用了兩個關鍵指標評估效率:

- 相關比例 (Relevance Rate):評估模型回答中與解決問題有關的比例。

- 反思質量 (Reflection Quality):分析每個反思步驟是否更正了推理中的錯誤或者從新的角度驗證了目前結論的正確性。

MME-CoT測試集

與純文本推理問題不同,額外的視覺輸入顯著豐富了視覺推理問題的范圍。有了圖像輸入,模型需要根據當前的推理進度頻繁查看圖像以獲取相關信息。描述感興趣的圖像區域成為了思維鏈(CoT)過程中的關鍵部分。因此,除了需要嚴格邏輯的復雜問題外,通用場景中的許多問題也構成了具有挑戰性的推理問題。

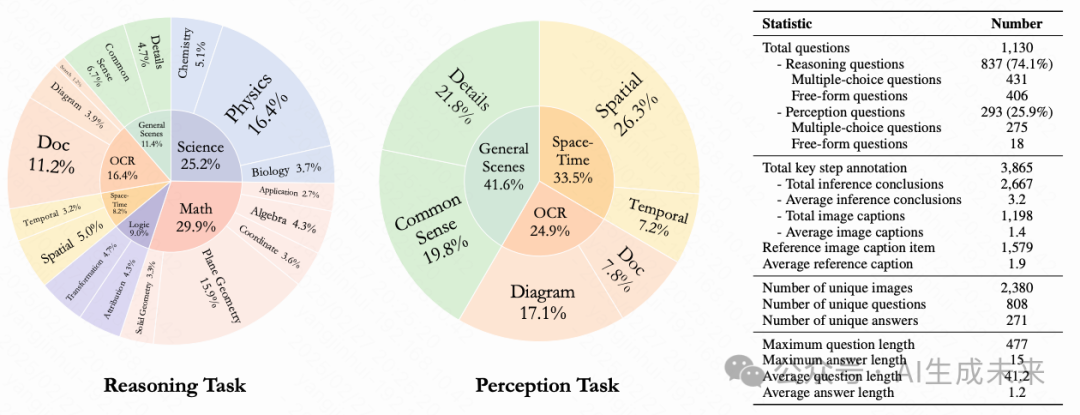

考慮到這一點,MME-CoT測試集構建起了一個覆蓋專業領域與常識場景的全景視覺推理評估體系,共包括6大領域以及17個子類。為了保持對推理過程的關注,研究者們排除了需要復雜領域特定定理或專業知識的問題。

MME-CoT中分為感知任務以及推理任務,現有的Benchmark往往混淆這兩類任務,使得這兩類經常出現在相同類別中。為了解決這個問題,研究者們首先使用GPT-4o以及Qwen2-VL來進行預判,通過對比直接作答與CoT作答的表現差異,初步劃分這兩種不同類型的任務。接著,專業的標注團隊逐題審核,確保分類的準確性。

為了便于CoT的評估,標注團隊為所有推理問題都給出了必要的推理步驟的Ground Truth標注。對于多解的問題,標注者被要求給出了每種可能的解法。最后,MME-CoT得到了1130道精選的問題以及3865個關鍵步驟標注。

實驗分析與結論

研究者們在MME-CoT Benchmark上測評了13個現有的LMM以及2個最先進的具有超強推理能力的LLM:DeepSeek-R1以及o3-mini。對于LLM,研究者們將圖片轉化為詳細的caption之后再輸入到模型。

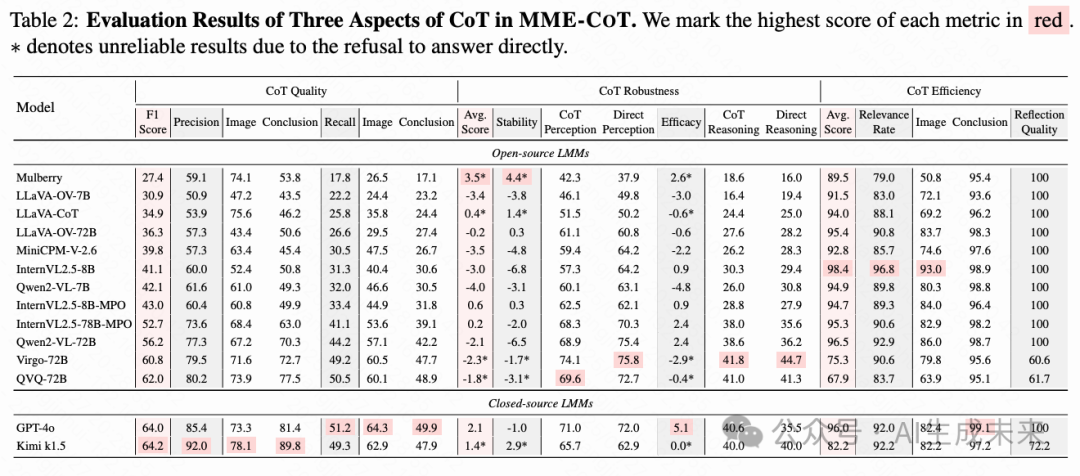

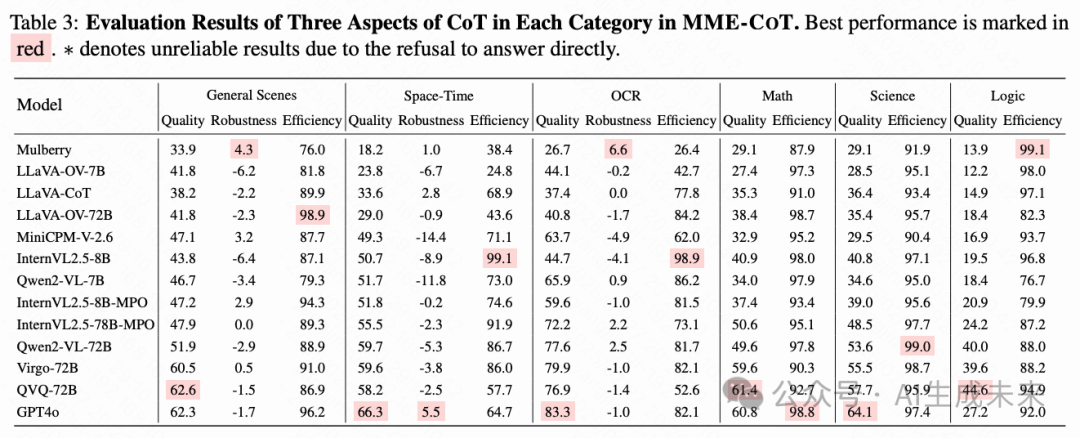

實驗結果如下:

基于測評,還得到了如下的發現與結論:

- 長CoT不一定涵蓋關鍵步驟

盡管長思維鏈模型具有更高的精確率,但每個步驟的信息量并不能得到保證。我們觀察到GPT-4o、QVQ和Virgo之間的召回率的趨勢和它們最終能否正確解答推理任務的表現(即在使用CoT的prompt時,模型在推理任務的最終答案準確率,對應表格中的CoT Reasoning列)不一致。具體來說,雖然Virgo和QVQ在僅評估最終答案的正確性上都優于GPT-4o,但它們在召回率上落后。這表明長CoT模型有時會在跳過中間步驟的情況下得出正確答案,這與CoT本身奉行的Think step by step的原則相矛盾,值得進一步研究。

- 更多參數使模型更好地掌握推理能力

我們發現參數量更大的模型往往獲得更高的有效性(Efficacy)分數。這種模式在LLaVA-OV、InternVL2.5-MPO和Qwen2-VL中都很明顯。例如,雖然Qwen2-VL-7B在將CoT應用于推理任務時顯示出4.8%的性能下降,但其更大的對應模型Qwen2-VL-72B展示出2.4%的改進。這種差異表明,在相同的訓練范式下,具有更多參數的模型能夠更好地掌握推理能力。

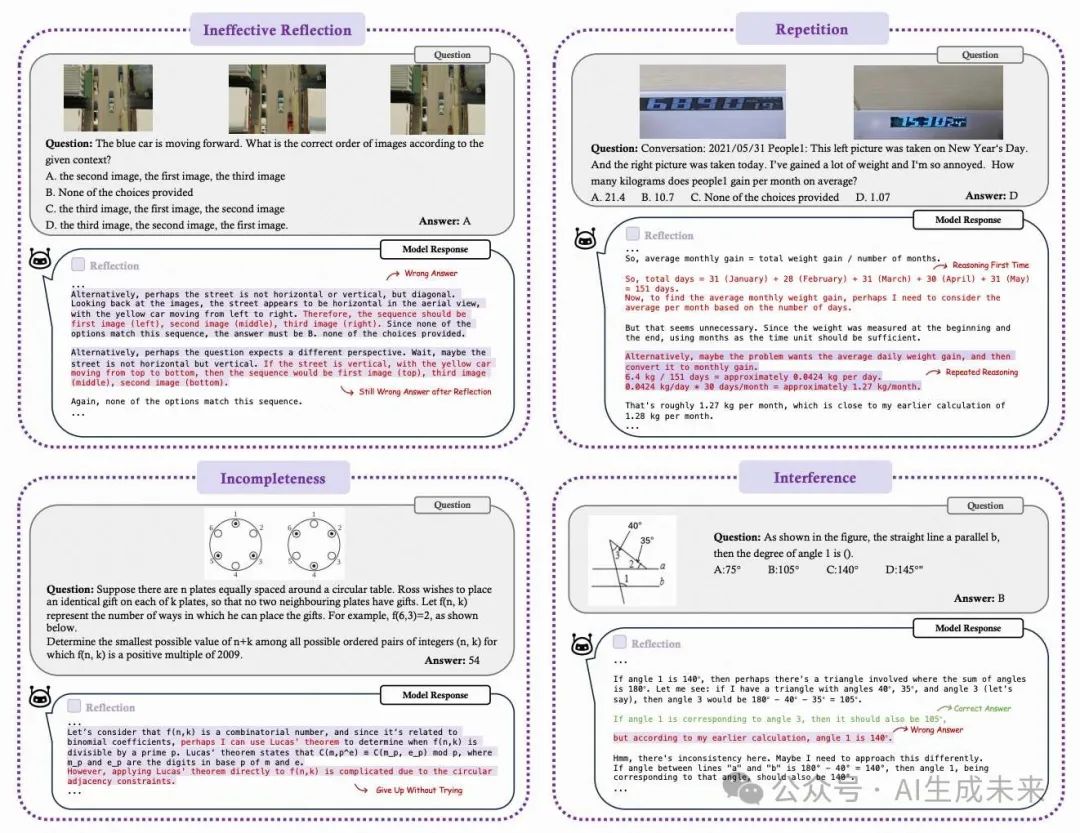

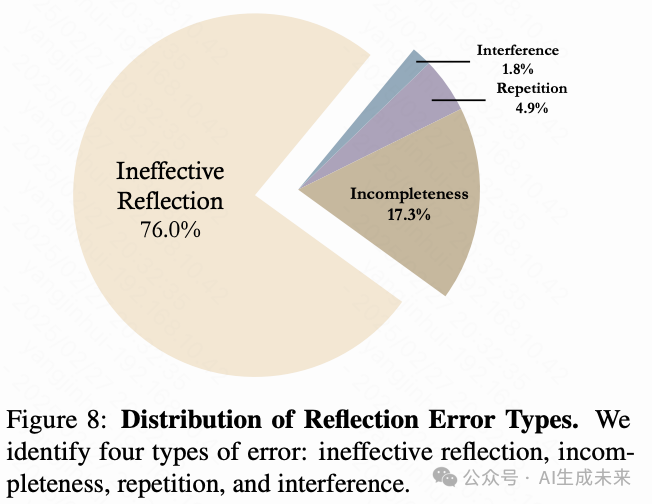

- 模型的反思的錯誤涵蓋多種類型

四種主要錯誤類型是:

- 無效反思:模型得出錯誤結論,在反思時,繼續做出錯誤的調整。這是最常見的錯誤類型,也是最頻繁出現的。

- 不完整:模型提出新的分析方法但未執行它們,僅停留在初始想法階段。模型的反思只是在空想。

- 重復:模型重述先前的內容或方法,沒有引入新的見解。

- 干擾:模型最初達到正確結論,但反思卻引入了錯誤。

理解和消除反思中的這些錯誤對于提高LMM的推理效率以及可靠性是至關重要的。

展望未來,MME-CoT不僅為評估LMM的推理能力提供了系統化的基準,更為該領域的研究指明了關鍵發展方向。通過揭示現有模型在推理質量、魯棒性和計算效率等方面的不足,這項工作為后續研究奠定了重要基礎。這些發現將推動LMM實現更強大以及可靠的視覺推理能力。

本文轉自AI生成未來 ,作者:AI生成未來

原文鏈接:??https://mp.weixin.qq.com/s/4GeRmjJ3JvwCs--xlCYdFg??