電子科大、同濟大學、新加坡國立大學等發表的Math-LLaVA:引導多模態大語言模型的數學推理能力

一、結論寫在前面

下面介紹的論文來自:電子科技大學、新加坡科技設計大學、同濟大學、新加坡國立大學。

論文標題:Math-LLaVA: Bootstrapping Mathematical Reasoning for Multimodal Large Language Models

論文鏈接:??https://arxiv.org/pdf/2406.17294??

代碼和數據:??https://github.com/HZQ950419/Math-LLaVA??。

LLMs在文本數學問題解決方面展示了令人印象深刻的推理能力。然而,現有的開源圖像指令微調數據集,每個圖像包含有限的問題-答案對,未能充分利用視覺信息來增強多模態LLMs(MLLMs)的數學推理能力。

為了填補這一空白,論文通過從24個現有數據集中收集40K高質量圖像及其問題-答案對,并合成320K新對,創建了MathV360K數據集,該數據集增強了多模態數學問題的廣度和深度。論文引入了基于LLaVA-1.5的Math-LLaVA模型,該模型通過MathV360K進行微調。

這一新穎方法顯著提升了LLaVA-1.5的多模態數學推理能力,實現了19個百分點的提升,并在MathVista的迷你測試分組上與GPT-4V表現相當。此外,Math-LLaVA展示了增強的泛化能力,在MMMU基準上取得了顯著進步。論文的研究強調了數據多樣性和合成在提升MLLMs數學推理能力中的重要性。

二、論文的簡單介紹

2.1 論文的背景

多模態數學推理任務要求模型解釋多樣化的圖像并應用高級推理技能。盡管開源的多模態大型語言模型(MLLMs)如LLaVA和Mini-GPT4在視覺問答任務上表現良好,但它們在解決涉及視覺內容的復雜數學問題方面仍不及專有的MLLMs。

提升多模態大型語言模型(MLLMs)數學推理能力的兩種常見方法是提示方法和微調方法。提示方法通過精心設計的提示利用MLLMs的潛在能力,而微調方法則使用從現實世界或高級LLMs(如GPT-4)生成的合成數據中收集的推理數據來調整模型參數。然而,現有的開源圖像指令微調數據集,每張圖像包含的問答對數量有限,未能充分利用視覺信息來增強MLLMs的多模態數學推理能力。

為了填補這一空白,論文從24個現有數據集中選取了40K張高質量圖像及其對應的問答對。這些圖像和問題涵蓋了代數、算術、幾何、邏輯、數值常識、科學和視覺問答等多個學科。選取標準基于圖像清晰度和理解復雜性。此外,論文提出了一種流程,基于這40K張圖像和種子查詢合成320K個新問答對。

2.2 數據合成

現有的開源圖像指令微調數據集,每張圖像包含有限的問答對,未能充分發掘視覺信息以增強MLLM的多模態數學推理能力。

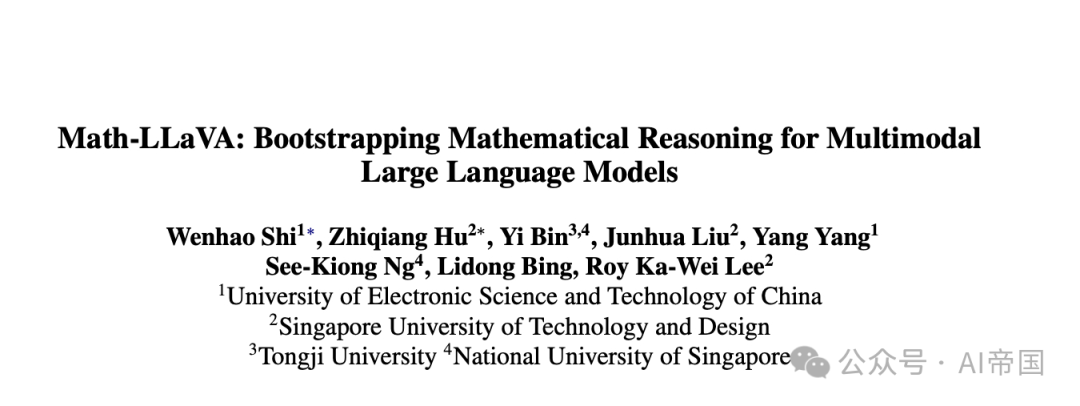

為此,論文提出MathV360K,一個基于40K精選圖像和多子領域種子問答對合成的強大數據集。如圖1左側所示,論文首先從24個開源多模態問答數據集中,根據圖像清晰度和理解復雜度篩選出40K高質量數據點。在第二步,如圖1右上方所示,論文嘗試充分挖掘圖像的視覺信息以生成額外問題。數據生成流程包括創建多樣化的新問題以充分發掘視覺信息、更復雜的問題以進一步提高推理能力,重述問題和未明確指定的問題以提高模型的魯棒性。通過數據生成流程,論文為選定的40K數據點收集了36萬條高質量且多樣化的指令調優數據,以增強LLaVA-1.5開源模型的圖像理解和數學推理能力。

圖1:提出的多模態問答數據選擇與數據增強的整體流程圖。論文的數據選擇依賴于微調后的ViT作為圖像分類器。數據生成過程依賴于視覺-語言模型

2.2.1 多模態推理數據選擇

2.2.1.1 源數據

論文收集了24個視覺問答和多模態數學推理數據集,每個數據集針對特定的任務類型和視覺內容。論文聚焦于需要高級推理的五種問題任務類型來編譯源數據集:圖表問答(FQA)、幾何問題解決(GPS)、數學文字問題(MWP)、教科書問答(TQA)和視覺問答(VQA)。附錄中的表5展示了每個源數據集的任務類型和視覺內容的更多細節。

每個多模態訓練樣本包含三個組成部分:一張圖像,一個文本問題,以及一個真實答案。從這種數據格式中,模型旨在捕捉視覺信息和問題語義以推理出最終答案。

2.2.1.2 圖像過濾與比例分配

在獲取24個源數據集后,論文根據以下標準有意識地從原始圖像中選擇數據:(1)圖像的清晰度,因為質量差的圖像會引入噪聲并干擾圖像語義的學習;(2)圖像的理解復雜度,從簡單到復雜不等。通過將圖像分類為不同的復雜度級別并按比例選擇,論文可以形成一個具有適當難度分布的訓練集;(3)相應文本問題數據的質量,確保難度與圖像的理解復雜度相匹配。

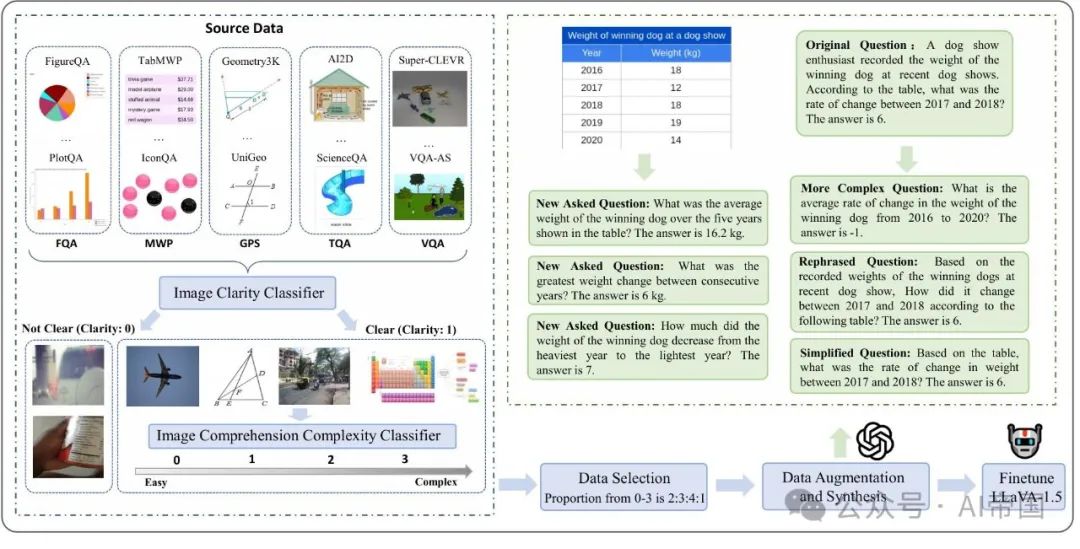

論文微調了兩個Vision Transformer(ViT)模型,分別用于圖像清晰度和圖像理解復雜度的分類。由于缺乏標注的圖像數據,論文首先從源數據集中均勻且隨機地采樣了10K張圖像。這些圖像使用GPT-4V(OpenAI)進行清晰度和理解復雜度的標注,論文設計的提示語如圖2所示。對于圖像清晰度,標簽0表示模糊、質量差的圖像,標簽1表示清晰、質量好的圖像。圖像理解復雜度由對象數量、它們的位置關系、是否需要數學計算、細節級別、紋理和材質屬性決定。圖像被分為0、1、2和3四個評分,評分越低表示視覺上下文理解越容易。基于這10K張標注圖像,論文使用交叉熵損失訓練了兩個ViT模型,并初始化了全連接層進行分類。論文首先使用微調后的圖像清晰度分類器對所有源訓練數據集圖像進行分類,并過濾掉標簽為0的圖像。表5顯示了過濾前(即訓練圖像)和過濾后(即清晰圖像)的圖像數量。

接下來,論文使用圖像理解復雜度分類器對篩選后的圖像進行評分。表5顯示,大多數圖像被分類為中等復雜度,其次是簡單,最后是最復雜。考慮到簡單圖像更容易學習,而復雜圖像更難且需要更多參考樣本,論文采用從簡單到復雜的漸進比例對前三個復雜度類別進行采樣。由于評分3的圖像最為稀缺,論文收集了所有這些圖像。論文根據總體復雜度2:3:4:1的比例選擇了40K數據點,確保從每個源數據集中均勻選擇不同復雜度的樣本。因此,論文獲得了40K高質量(1, Q, A)真實數據點,這些數據點在圖像信息和問題難度上具有多樣性和漸進性。

圖2:論文在GPT-4V API中用于圖像標注的提示模板。圖像清晰度被視為二元分類,而圖像理解復雜度被視為多分類

2.2.2 數據增強

2.2.2.1 挖掘圖像以生成QA

在選擇了40K多模態推理數據后,論文觀察到每張圖像通常對應有限的問題。如圖1的表格圖像所示,原始問題往往僅關注局部算術差異。然而,還可以提出關于總體平均值、連續變化等問題,表明僅通過一個問題并未充分利用圖像的視覺信息。因此,論文可以通過為每張圖像生成更多的問題-答案對來進一步增強可用真實數據。

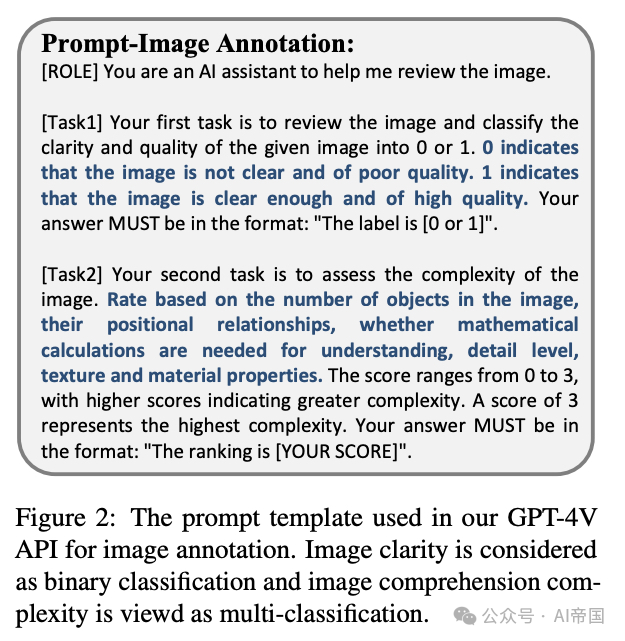

論文使用GPT-4V根據輸入圖像和原始問題生成額外的問題。如果以零樣本方式生成問題,它們往往聚焦于單方面的視覺場景,缺乏推理和數學技能。對于來自特定任務的圖像,如幾何圖形,應提出更多任務特定的問題。因此,論文采用少樣本示范方法讓GPT-4V生成新問題。

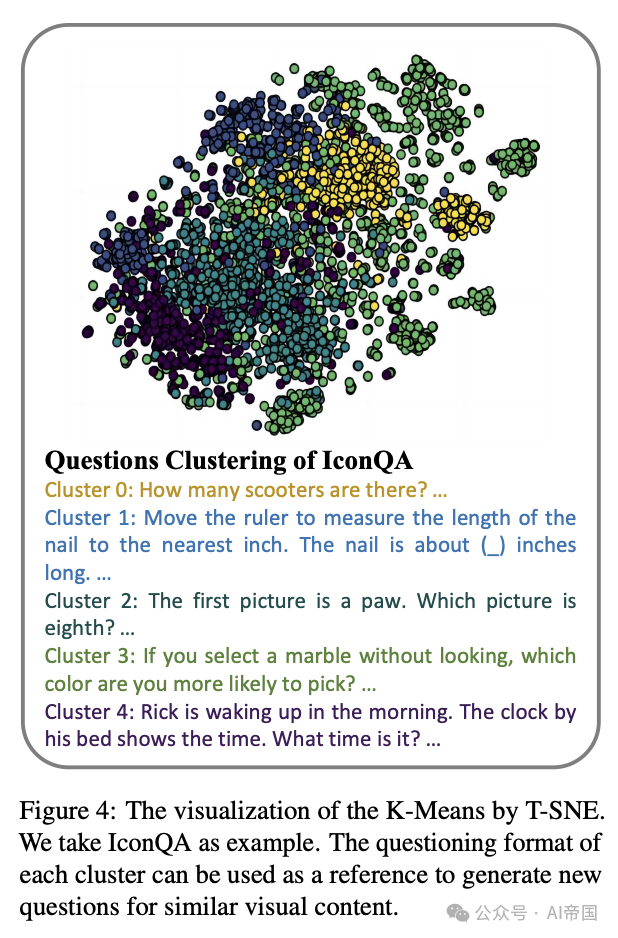

對于屬于某一類別(FQA、GPS、MWP、TQA、VQA)的圖像,論文首先將每個任務類別內的源數據集問題內部聚類為五個類別。具體來說,使用TF-IDF獲取文本問題的特征,并使用K-Means進行聚類。如圖4所示,論文以IconQA為例。在訓練集中對問題進行聚類后,每個聚類內部代表一種特定的提問格式和模式,可供參考。通過從屬于某個任務類型的每個源數據集的每個聚類中隨機抽取一個問題來構建示范。

生成輸入圖像新問題的提示如圖3所示。這種方法確保新生成的問題與原始參考問題的分布一致,同時提高多樣性。通過這種方法,論文基于選定的40K數據點生成了200K個新的問題-答案對。

2.2.2.2 原始問題增強

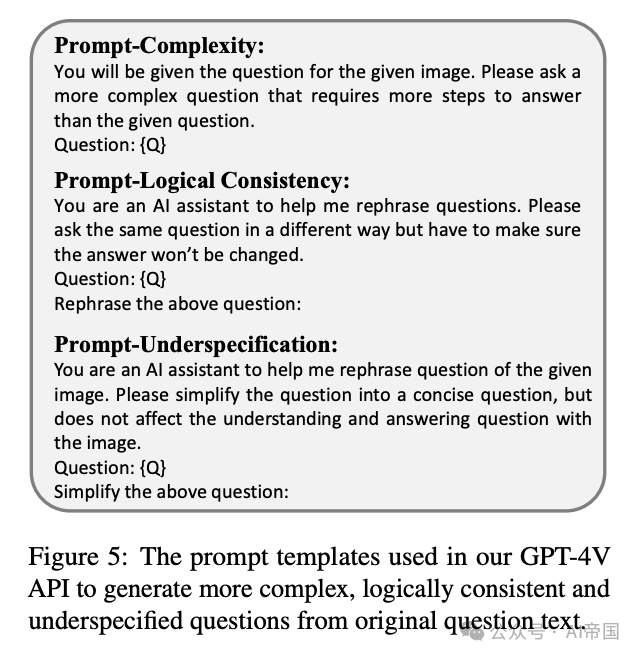

論文設計了提示來增強原始問題,如圖5所示。使用GPT-4V,論文生成了40K個更復雜的問題、40K個簡化的問題和40K個改寫的問題。增強主要集中在以下方面:

復雜性。更復雜的推理樣本可以增強微調LLMs(大型語言模型)的推理能力。論文的第一種方法是在原始圖像和相應詢問的基礎上創建更復雜的問題。

邏輯一致性。魯棒的多模態大型語言模型(MLLMs)應對給定圖像中的相似內容提供一致的回答。論文采用GPT-4V,通過不同方式提問相同問題,確保答案不變。

圖3:論文使用的GPT-4V API提示模板為每個輸入圖像生成額外問題。演示通過從每個源數據集的每個集群中隨機抽取一個問題構建,以適應特定任務類型

語義欠規范。魯棒的MLLMs必須處理語義欠規范問題,即語言信號僅傳達了成功交流所需的部分信息。因此,論文在不影響與圖像結合的語義理解的前提下,簡化了原始問題。

2.3 實驗

2.3.1 模型與訓練

論文采用LLaVA-1.5架構作為基礎模型,主要包含Vicuna-v1.5語言模型(Team, 2023)和預訓練的Vision Transformer(ViT)作為圖像編碼器。為了保持基礎模型卓越的視覺感知和描述能力,論文使用提出的MathV360K指令調優數據集對LLaVA-1.5-13B進行微調。該數據集中多樣的問題模式和豐富的視覺內容增強了模型的多模態數學推理能力,同時保持其通用的視覺-語言理解技能。

2.3.2 評估與指標

論文采用零樣本方式,使用MathVista的minitest子集來評估論文的模型。該minitest子集包含1000個樣本,其中包括540道多項選擇題和460道需要以整數、浮點數或列表形式自由作答的問題。Math-Vista充分評估了MLLMs在多模態數學技能方面的能力,涵蓋代數推理(ALG)、算術推理(ARI)、幾何推理(GEO)、邏輯推理(LOG)、數值常識(NUM)、科學推理(SCD)和統計推理(STA)。此外,Math-Vista的問題可以分為以下子集:FQA、GPS、MWP、TQA和VQA。在評估過程中,論文首先利用GPT-4從響應中提取預測選項或答案,然后報告答案準確性,即判斷最終答案是否與標準答案匹配。此外,論文還使用MMMU基準來評估論文模型的增強泛化能力。

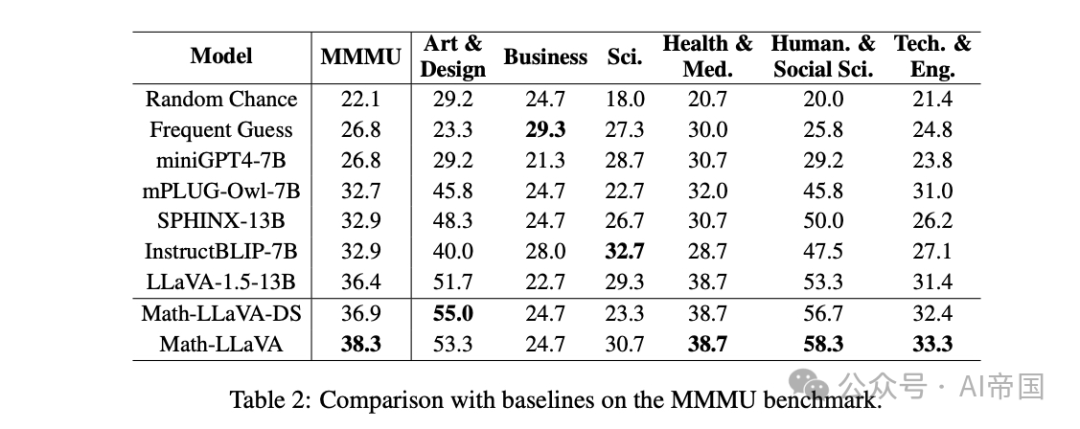

MMMU基準包含900個評估樣本,涵蓋六個核心學科:藝術與設計、商業、科學、健康與醫學、人文與社會科學以及技術與工程,適合評估MLLMs推理能力的泛化性。

2.3.3 實施細節

論文利用GPT-4V(GPT-4 Vision Preview)進行數據生成過程。為了對圖像清晰度和理解復雜度進行分類,論文微調了兩個ViT-Large-Patch16-224模型,每個模型的學習率為2e-4,訓練周期為5個epoch。

圖 4:T-SNE 對 K-Means 的可視化。論文以 IconQA 為例。每個集群的提問格式可以作為參考,用于生成類似視覺內容的新問題

對于 LLaVA-1.5-13B 模型,輸入圖像分辨率設置為 336 乘 336 像素。投影線性層和語言模型均可訓練。在微調階段,論文設置學習率為 2e-5,采用批量大小為 16,并使用配備 80GB 內存的 A800 GPU 進行 2 個周期的微調。

2.4 結果與分析

2.4.1 主要比較:MathVista

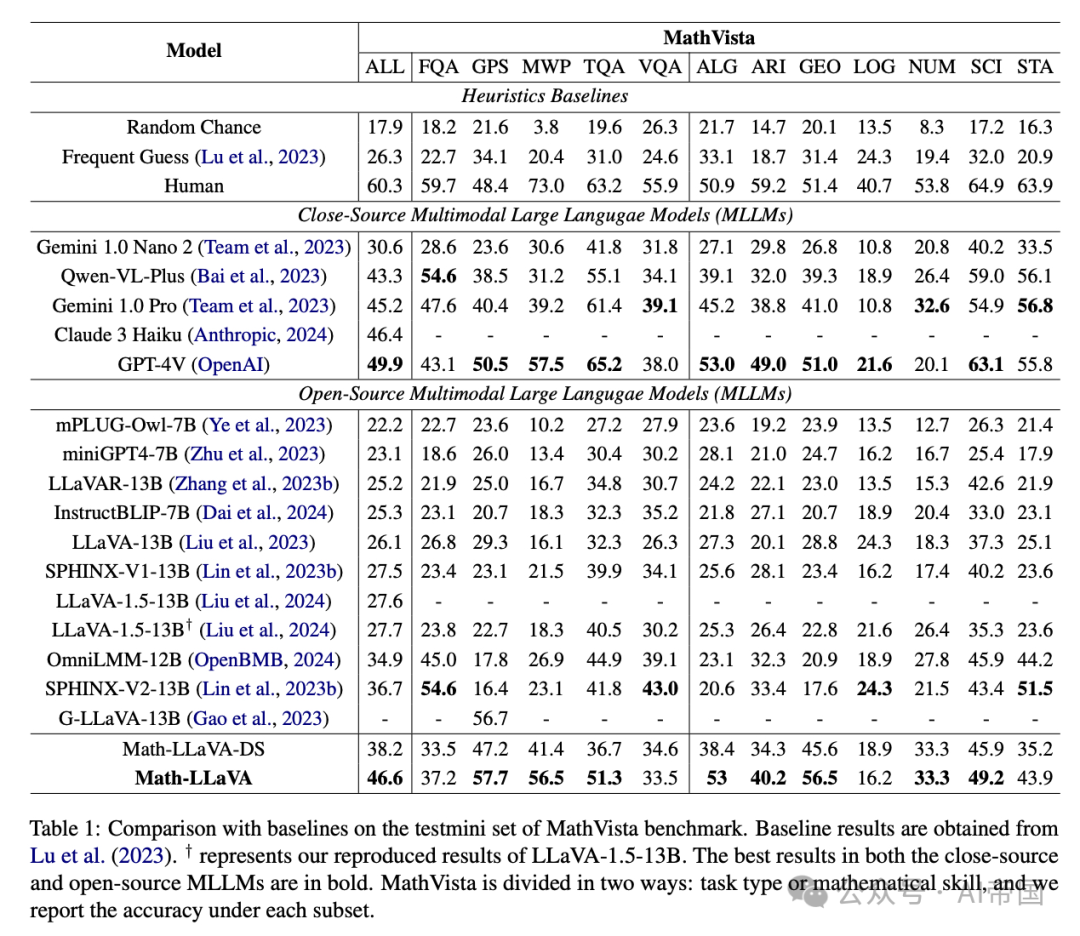

論文在 MathVista 基準的 minitest 分割上比較了 Math-LLaVA 與其他多模態語言模型(MLLMs),結果如表 1 所示。如圖所示,開源 MLLMs 如 miniGPT4、instructBLIP和 LLaVA-1.5-13B 在多模態數學方面表現不佳,總體準確率低于 30%。

與基礎模型 LLaVA-1.5-13B 相比,其多模態數學能力較差,Math-LLaVA 實現了 46.6% 的總體準確率,顯著提升了 19%。更令人驚訝的是,提出的 Math-LLaVA 模型超過了閉源模型 Gemini 1.0 Pro和 Claude 3 Haiku,甚至達到了與 GPT-4V(OpenAI)相當的性能,最強大的閉源MLLMs。

Math-LLaVA在GPS子集上達到了57.7%的準確率,超過了G-LLaVA-13B(Gao et al., 2023),后者已在170K高質量的幾何圖像-標題和問題-答案對上進行了訓練。Math-LLaVA的優越性能表明,高質量、多樣化的多模態問題-答案對的數據選擇和合成在提高MLLM的多模態數學推理能力方面是有效的。

圖5:在論文的GPT-4V API中使用的提示模板,用于從原始問題文本生成更復雜、邏輯一致和欠規范的問題

2.4.2 Math-LLaVA的泛化能力

提出的Math-LLaVA模型在多模態數學推理任務中展示了出色的性能。為了評估其泛化能力,論文使用包含各種學科和領域的MMMU基準進行了評估實驗。結果如表2所示。僅使用選定的數據,Math-LLaVA在科學子集上的性能有所下降。

然而,論文可以觀察到,在MathV360K上微調的Math-LLaVA模型在所有六個子領域上都能顯著超越基礎模型LLaVA-1.5-13B,以及其他幾個開源MLLMs。這種優越性能突顯了其向下的多模態理解和推理任務的泛化能力。此外,使用論文的合成數據進行微調的過程并沒有削弱模型在其他領域的推理能力;相反,它增強了其泛化能力。

表1:與MathVista基準測試mini集上的基準對比。基準結果來自Lu et al. (2023)。"表示論文復現的LLaVA-1.5-13B結果。閉源和開源MLLMs中的最佳結果以粗體顯示。MathVista分為兩種方式:任務類型或數學技能,論文報告每個子集的準確性

2.4.3 對合成數據集的過擬合問題

提出的數據合成流程為每張圖像生成額外的問答對,以增強MLLMs的數學推理能力。直觀上,論文應該探究所提出的模型Math-LLaVA是否在生成的問答對上發生過擬合。如果發生過擬合,Math-LLaVA可能會記憶或檢索圖像信息,而不需要任何視覺輸入。

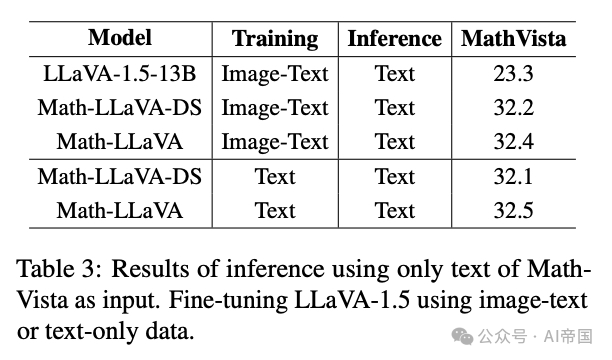

為了檢查這一點,論文比較了Math-LLaVA在數據合成前后的性能,分別稱為Math-LLaVA-DS和Math-LLaVA,在MathVista上僅使用文本輸入進行測試。如表3所示,Math-LLaVA在沒有視覺信息的情況下進行推理時,在MathVista上表現出與Math-LLaVA-DS相似的性能,約為32.0%。此外,僅使用文本數據對Math-LLaVA進行微調也得到了類似的觀察結果。這表明Math-LLaVA模型并未在合成的問答對上發生過擬合。

有趣的是,論文也觀察到,僅使用文本輸入時,LLaVA-1.5-13B在MathVista上的準確率為23.3%。潛在的原因,如(Chen et al., 2024b)所探討的,可能是MathVista中的許多樣本不需要視覺內容,并且在LLMs和MLLMs的預訓練過程中可能發生了無意中的數據泄露。

2.4.4 合成數據的有效性

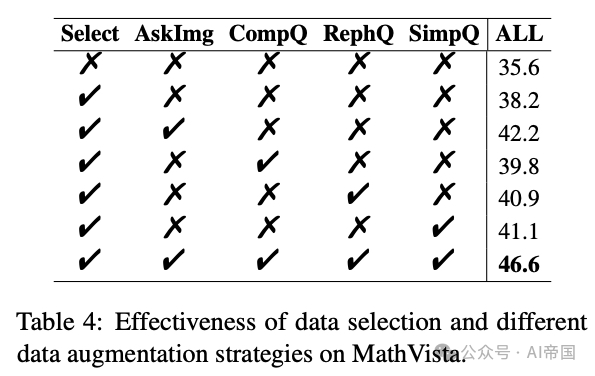

為了驗證數據選擇和提出的數據增強策略的有效性,論文對MathV360K的各個組件進行了獨立實驗。首先,論文在源數據集中隨機抽取40K個數據點對LLaVA-1.5模型進行微調,不進行任何選擇,以展示數據過濾和比例調整的效果。

隨后,論文分別將選定的40K數據點與使用四種增強方法生成的數據結合:為QA生成挖掘圖像(AskImg),提出復雜問題(CompQ),重新表述問題為了邏輯一致性(RephQ),以及簡化問題以解決不明確性(SimpQ)。表4展示了不同增強組合在MathVista上達到的準確率。結果表明,論文的數據合成方法,結合了數據選擇和每種增強方法,取得了更好的性能。綜合這些策略,相較于隨機采樣40K數據點,實現了顯著的11%提升。

表2:在MMMU基準上與基線模型的比較

表3:僅使用Math-Vista的文本作為輸入進行推理的結果。對LLaVA-1.5使用圖像-文本或純文本數據進行微調

表4:數據選擇和不同數據增強策略在MathVista上的有效性

2.4.5 每種任務類型增強的提升效果

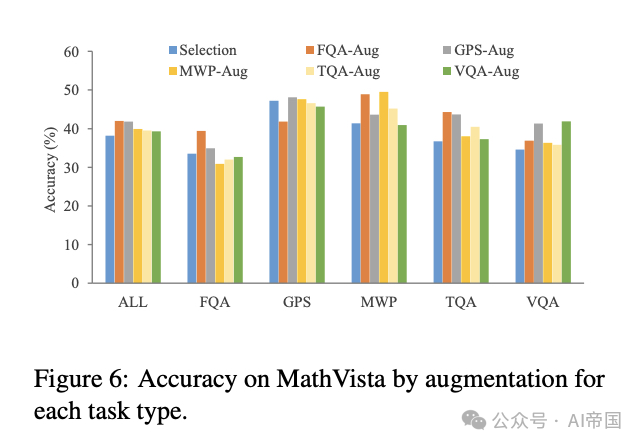

鑒于論文從五種不同的問答任務類型中選擇了數據,論文的目標是研究哪些類型或技能在多模態數學推理中可以通過增強每個單獨任務類別的源數據得到提升。為此,論文對新數據進行了實驗,針對每種任務類型合成的數據,與選定的數據混合。MathVista上的結果如圖6所示。

論文觀察到,對各種類型的源數據進行增強可以進一步提高模型在相應任務上的性能。特別是在涉及FQA、MWP和VQA的任務中,增強效果尤為顯著。有趣的是,針對單一任務類型的數據增強也顯示出對其他任務類型有效性的提升,這可能是因為不同任務之間所需的推理技能存在重疊。

圖6:通過針對每種任務類型的增強在MathVista上的準確性