只需一張圖片!實現任意3D/4D場景生成!港科大&清華&生數發布DimensionX

文章鏈接:https://arxiv.org/pdf/2411.04928

項目鏈接:https://chenshuo20.github.io/DimensionX/

亮點直擊

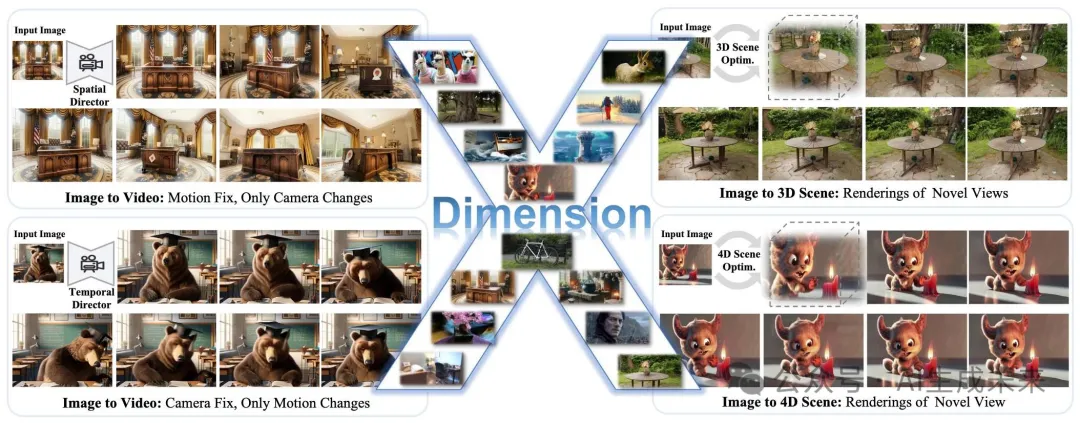

- 提出了DimensionX框架,通過可控的視頻擴散技術,僅使用單張圖像生成逼真的3D和4D場景。

- 提出了ST-Director,通過學習(空間和時間)維度感知模塊,并結合我們精心挑選的數據集,解耦視頻擴散模型中的空間和時間先驗。進一步通過基于視頻擴散去噪過程本質的訓練無關組合方法,增強了混合維度控制。

- 為了彌合視頻擴散與真實場景之間的差距,設計了一個軌跡感知機制用于3D生成,并提出了一種保持身份的去噪方法用于4D生成,從而實現更真實且可控的場景合成。

- 廣泛的實驗表明,相較于基準方法,DimensionX在視頻、3D和4D生成方面表現出色。

總結速覽

解決的問題

本文提出了DimensionX框架,旨在從單張圖像生成具有視頻擴散效果的逼真3D和4D場景。現有的視頻擴散模型在直接恢復3D/4D場景時存在限制,尤其是在生成過程中缺乏空間和時間的可控性。

提出的方案

本文提出了ST-Director,通過從維度變化的數據中學習維度感知的LoRAs,解耦視頻擴散中的空間和時間因素。這種可控的視頻擴散方法使得空間結構和時間動態的精確操控成為可能,從而能夠從連續幀中重建3D和4D表示。

應用的技術

- ST-Director:通過解耦空間和時間因素,利用維度感知的LoRAs技術進行視頻擴散。

- 軌跡感知機制:用于3D生成,幫助填補生成視頻與真實世界場景之間的差距。

- 保持身份的去噪策略:用于4D生成,確保生成視頻中的身份保持一致。

達到的效果

DimensionX在控制視頻生成以及3D和4D場景生成方面表現出色,通過廣泛的實驗驗證,在多個真實和合成數據集上相比之前的方法,DimensionX取得了更好的結果。

方法

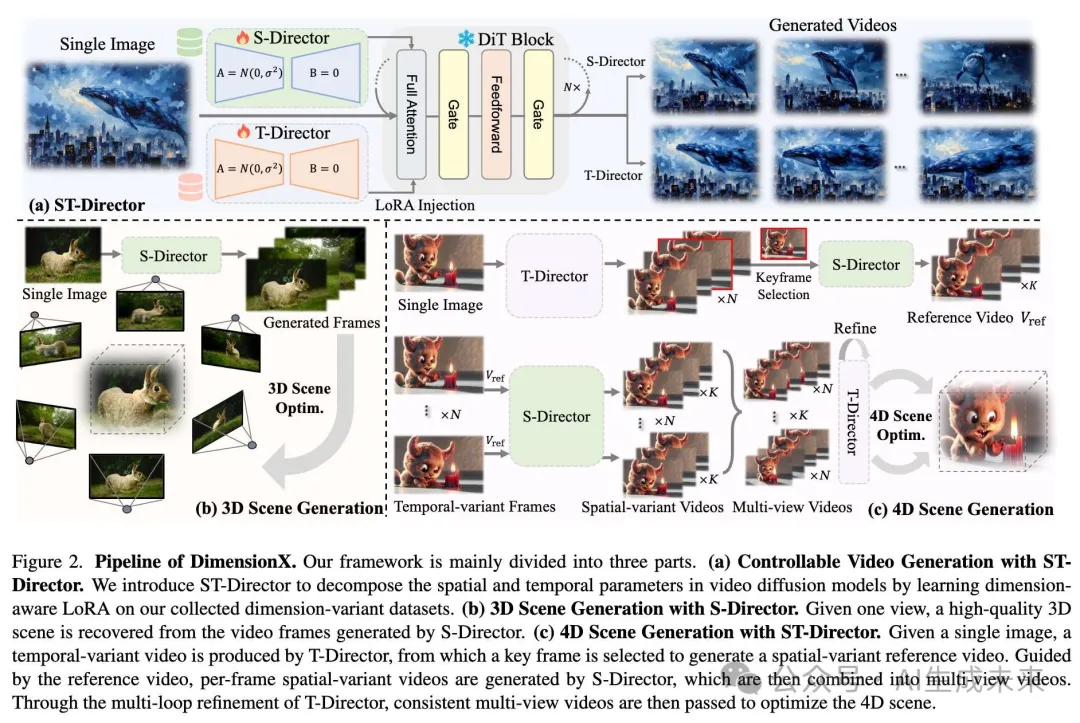

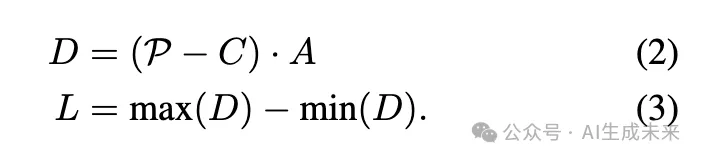

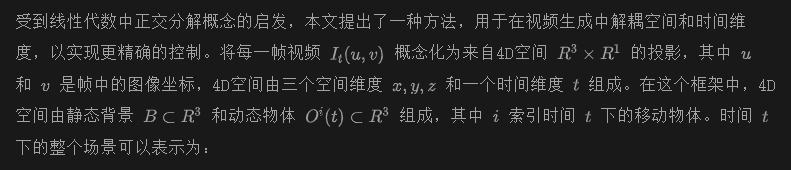

本文的目標是,給定一張圖像,通過可控的視頻擴散生成高質量的3D和4D場景。為了在空間和時間維度上實現有效的控制,首先開發了一個系統化框架來構建維度變化數據集。借助精心挑選的數據集,引入了ST-Director,通過維度感知的LoRA解耦空間和時間基礎,實現精確的維度感知控制。還探索了視頻生成過程中的去噪機制,并引入了一種訓練無關的維度感知組合方法,以實現有效的混合維度控制。為了更好地利用可控的視頻擴散生成高質量的場景,設計了一個軌跡感知機制用于3D生成,并提出了一種保持身份的去噪方法用于4D生成。

構建維度變化數據集

為了在視頻擴散中解耦空間和時間參數,提出了一個框架來從開源數據集中收集空間和時間變化的視頻。本文為空間變化數據采用了軌跡規劃策略,并為時間變化數據引入了流引導。

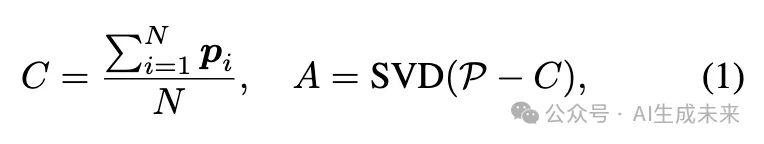

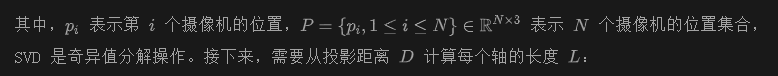

空間變化數據的軌跡規劃。為了獲取空間變化數據集,本文提出了重建逼真3D場景并渲染與我們空間變化一致的視頻。為了方便渲染路徑的選擇和規劃,需要計算攝像機在整個場景中的覆蓋范圍。給定場景中的N個攝像機,首先通過主成分分析(PCA)技術計算中心C和沿x、y、z方向的主軸A:

基于上述計算,已經確定了攝像機在整個場景中的分布。為了應對不同的場景,建立了以下規則來篩選符合條件的數據:

- 攝像機分布:計算場景的中心,并判斷攝像機如何圍繞場景進行捕捉。

- 邊界框長寬比:邊界框的長寬比應滿足各種S-Director的要求。例如,x軸和y軸的長寬比不應差異過大,這有助于選擇合適的360度全景視頻。

- 攝像機與邊界框的距離:計算每個攝像機位置到邊界框最近平面的距離,并優先選擇總距離較小的數據,以確保攝像機的合理布置。

在篩選出數據集后,需要計算場景內的占據場,以幫助我們規劃渲染攝像機的可行區域。在從多視角圖像重建整個場景的3DGS后,渲染多視角圖像及其對應的深度圖,然后使用TSDF從RGB-D數據中提取場景的網格。

時間變化數據的流引導。為了實現時間控制,旨在篩選時間變化數據,以微調視頻擴散模型。利用光流來篩選時間變化的視頻。對于時間變化的視頻,光流圖通常會顯示大量的白色區域,這可以作為有效的選擇標準。

ST-Director用于可控視頻生成

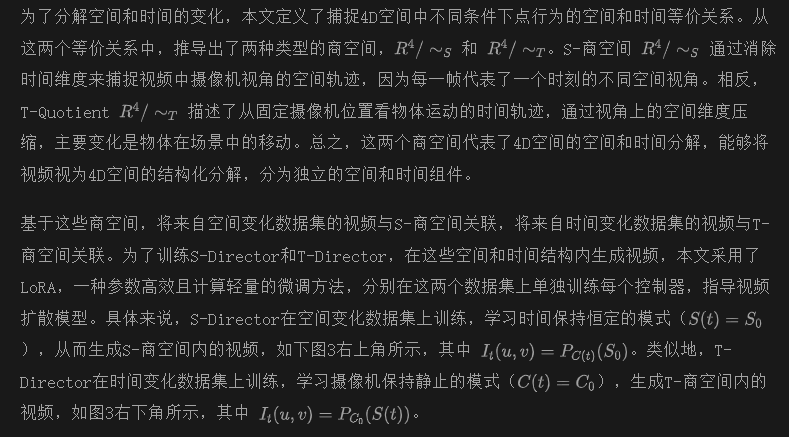

維度感知分解

無需調優的維度感知合成

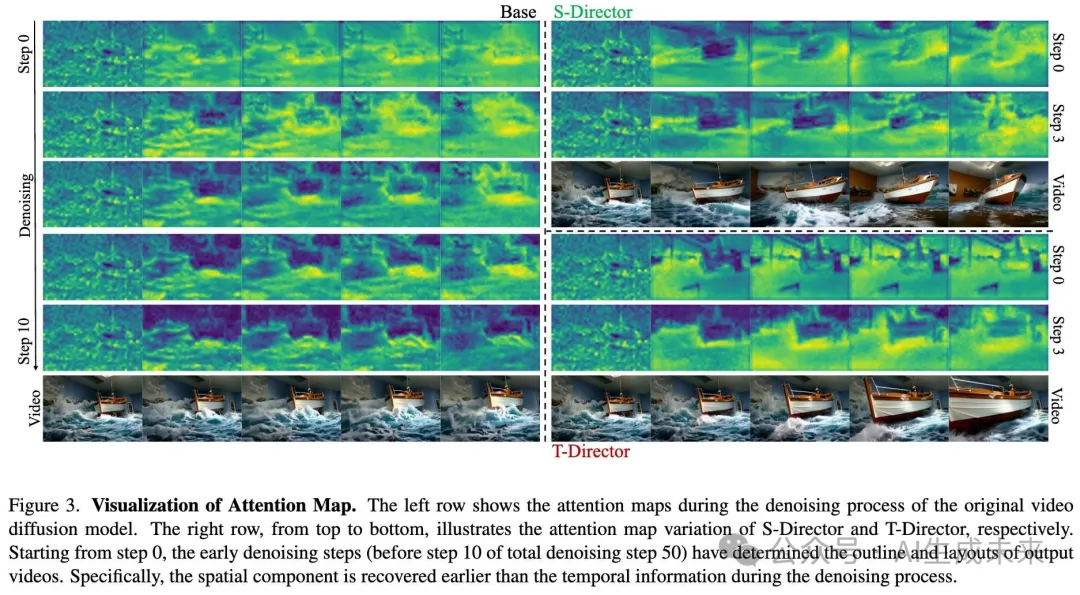

觀察1:去噪過程的初期步驟對生成視頻至關重要

從注意力圖中可以觀察到,在去噪過程的初期步驟中,基礎模型和兩個控制器都建立了與最終生成結果緊密對齊的基礎輪廓。這些初步的輪廓捕捉了空間和時間的基本結構,實際上為剩余的去噪步驟設定了方向。此外,還注意到這些變化展開的方式有明顯不同:在基礎模型中,時間和空間的變化同時發生,導致兩個維度的統一演化。相比之下,當使用S-Director和T-Director時,每次只有一個維度發生變化——是時間維度還是空間維度,取決于具體使用的控制器。

觀察2:空間信息比時間信息更早構建

類似于Motionclone的發現,觀察到,在去噪過程的初期階段,物體運動的合成仍未完全發展。具體來說,在使用S-Director時,注意力圖表明,最終視頻的結構性輪廓比時間控制提前出現。前面圖3顯示,在去噪循環的第0步和第3步時,物體在T-Director的引導下保持靜止,而S-Director已經開始引導攝像機在場景中移動。

基于S-Director的3D場景生成

基于S-Director,視頻擴散模型能夠從單一圖像生成長時間一致的幀,從而重建逼真的場景。為了更好地推廣到現實世界場景,其中空間變化多樣且攝像機軌跡高度靈活,引入了軌跡感知機制來處理不同的攝像機運動。具體來說,為了覆蓋各種攝像機軌跡模式C(t),我們訓練了多種類型的S-Directors,每種S-Director都針對特定的攝像機運動。 在3D世界中,攝像機的運動由6個自由度(DoF)定義,每個自由度允許在平移和旋轉的正負方向上進行運動,形成12種不同的運動模式。此外,我們還訓練了軌道運動類別的S-Director,其中攝像機沿著一個平滑的圓形路徑繞主體運動,捕捉到超越標準自由度運動的獨特視角。通過多樣化且可控的S-Directors,在單視圖和稀疏視圖設置中都采用了軌跡感知機制,從而使得能夠生成具有廣泛適應性的現實世界3D場景。

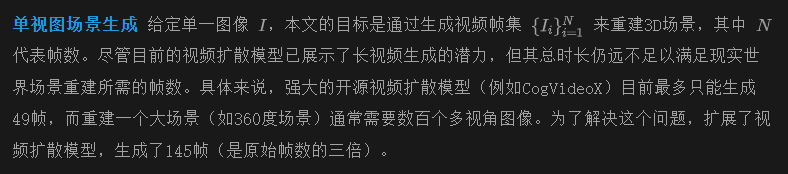

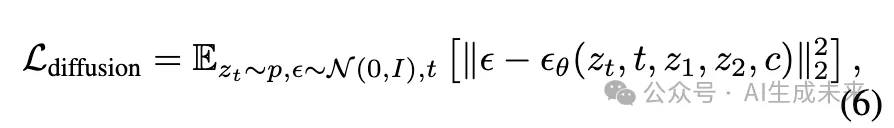

稀疏視圖場景生成在3D場景生成的應用中,精度和細節至關重要,使用稀疏視圖輸入可以顯著提高生成內容的逼真。在這種設置下,提出了結合視頻插值模型和自適應S-Director的方案,以實現稀疏視圖之間的平滑和一致的過渡。開發了一個視頻擴散模型來生成高質量的插值視頻,該模型以兩張圖像作為起始和結束幀。

本文采用了兩種關鍵策略,以充分利用S-Directors攜帶的指導信息:早期停止訓練和自適應軌跡規劃。研究發現,在訓練S-Director的早期階段,足夠的軌跡指導已被獲得,在此階段,相機運動可以根據輸入視點的變化靈活調節。此外,為了處理稀疏視圖的各種視點插值,提出根據輸入圖像之間的坐標關系,動態選擇合適的S-Director。

借助本文提出的長視頻擴散模型和多樣化的S-Directors,可以直接從生成的視頻中重建廣泛的場景。特別是,給定稀疏視圖(例如只有一張)圖像和選定的相機運動類型(可以是基本軌跡或這些運動原語的組合),擴散模型能夠沿著指定路徑生成一致的長視頻。

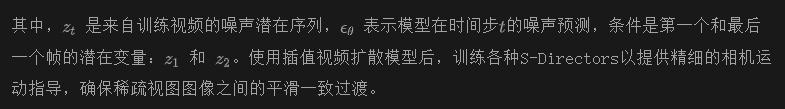

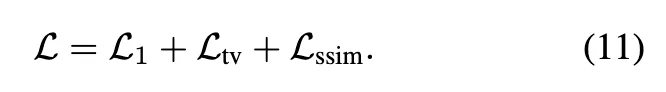

為了減輕生成視頻中的不一致性,采用了一種自信度感知的高斯點云濺射程序來重建3D場景。該程序使用DUSt3R提供的點云和估計的相機姿態進行初始化,3D高斯點云濺射通過額外的LPIPS損失和從DUSt3R獲得的置信度圖進行優化。采用以下3DGS損失:

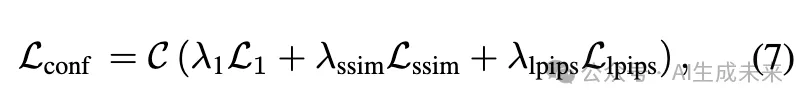

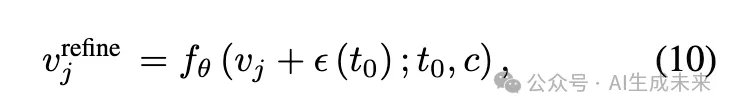

4D 場景生成與 ST-Director

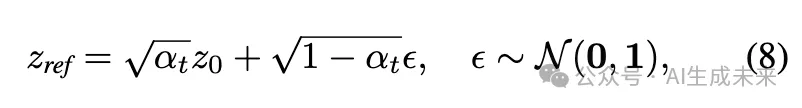

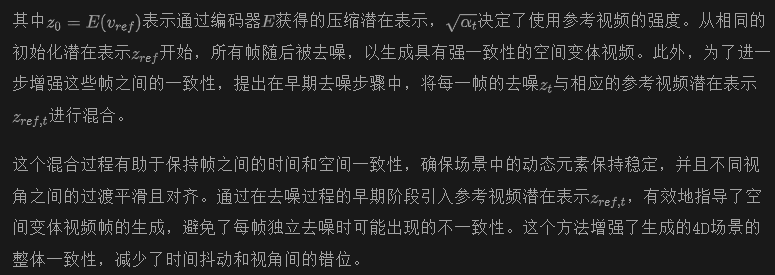

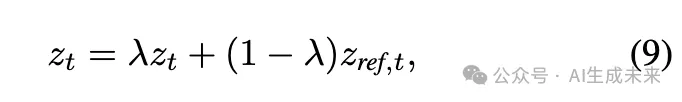

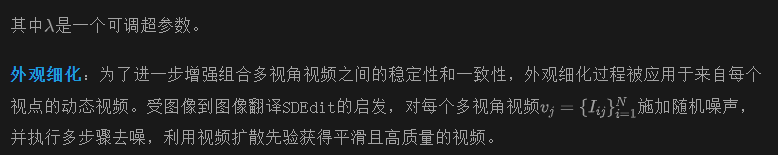

通過配備空間和時間控制的視頻擴散,可以從單一圖像恢復高質量的4D動態場景。直接的方法是將為每個時間幀生成的空間變化視頻拼接成多視圖視頻,然后用這些視頻重建4D場景。然而,這種方法面臨一個關鍵挑戰:3D一致性。在空間變化的視頻之間保持背景和物體外觀的一致性是一個挑戰,導致4D場景中出現嚴重的抖動和不連續性。為了解決上述問題,我們提出了一種保持身份一致性的去噪策略,包括參考視頻潛在共享和外觀精煉過程,以增強所有空間變化視頻的一致性。

實驗

本節對真實世界和合成數據集進行了廣泛的實驗,以評估DimensionX的可控性,以及使用ST-Director進行3D和4D場景生成的能力。我們首先全面說明實驗細節。然后提供了可控視頻生成的定量和定性評估。接著,我們報告了在各種場景下(包括單視角和稀疏視角3D生成)與其他基線方法的定量和定性結果。隨后,展示了本文方法的4D場景生成結果。最后進行了各種消融研究,以評估本文設計的有效性。

實驗設置

數據集。整個框架中的視頻擴散模型主要在三個數據集上進行訓練:DL3DV-10K、OpenVid和RealEstate-10K。OpenVid-1M是一個高質量的開源視頻數據集,包括100萬個視頻片段,具有多樣的運動動態和相機控制。DL3DV-10K是一個廣泛收集的3D場景數據集,包含高分辨率的多視角圖像,包括各種室內和室外場景。RealEstate-10K是一個來自YouTube的數據集,主要包含室內場景的捕捉。通過應用我們設計的數據收集框架,我們從DL3DV-10K和OpenVid構建了維度變化數據集。我們選擇了OpenVid中的100個高質量時變視頻來訓練T-Director。對于每種S-Director類型,渲染100個視頻,根據特定的相機軌跡來訓練相應的LoRA。為了擴大視頻幀,我們篩選了來自RealEstate-10K和OpenVid的超過145幀的高質量視頻,以完全微調視頻擴散模型。使用相同的數據集,我們通過第一幀和最后一幀的引導微調視頻插值模型。為了進一步驗證DimensionX的3D生成能力,將本文的方法與其他基線方法在Tank-and-Temples、MipNeRF360、NeRF-LLFF和DL3DV-10K上進行了比較。

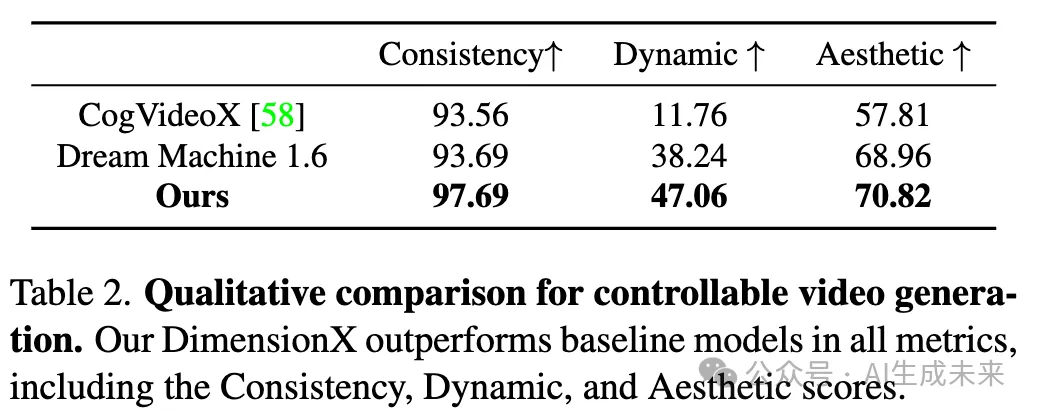

可控視頻生成

基線和評估指標。將DimensionX與原始的CogVideoX(開源)和Dream Machine 1.6(閉源產品)進行了比較。收集了數百張圖像作為評估數據集。根據先前的基準VBench,評估了生成視頻的主題一致性、動態度和美學得分作為我們的評估指標。

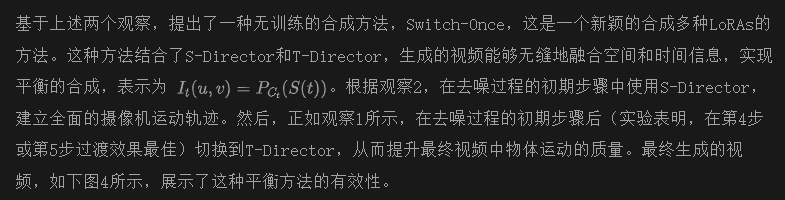

定量和定性比較。下表2中的定性結果展示了本文方法的出色表現,包括更好的視覺質量和3D一致性。如前面圖4所示,可以觀察到,DimensionX有效地分解了視頻擴散模型的空間和時間參數,而Dream Machine無法解耦維度感知控制,即便使用了相機運動和提示約束。此外,對于包括空間和時間運動在內的混合維度控制,相較于Dream Machine,DimensionX生成了更加生動和動態的視頻。定量和定性結果都表明,本文的方法能夠生成可控視頻,同時保持動態運動和主題一致性。

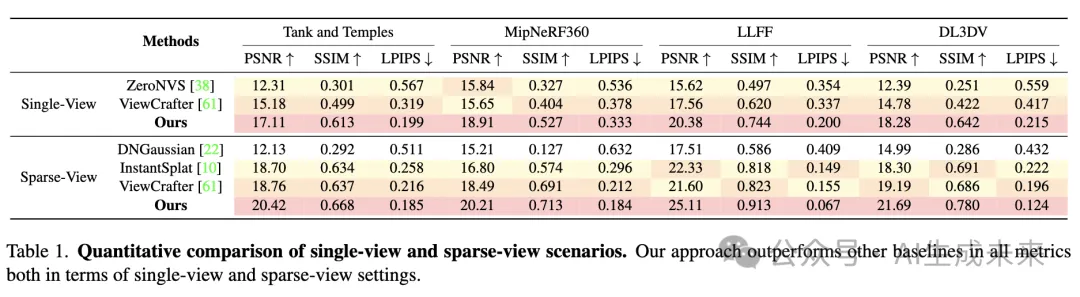

3D場景生成

基線和評估指標。在單視角設置中,將本文的方法與兩種生成方法進行了比較:ZeroNVS和ViewCrafter。對于稀疏視角場景,選擇了兩種稀疏視角重建方法和一種稀疏視角生成基線,包括:DNGaussian 、InstantSplat和ViewCrafter。采用PSNR、SSIM和LPIPS作為定量結果的評估指標。具體來說,在單視角和稀疏視角設置中,首先從給定的圖像重建3D場景,然后通過從新視角渲染計算指標。

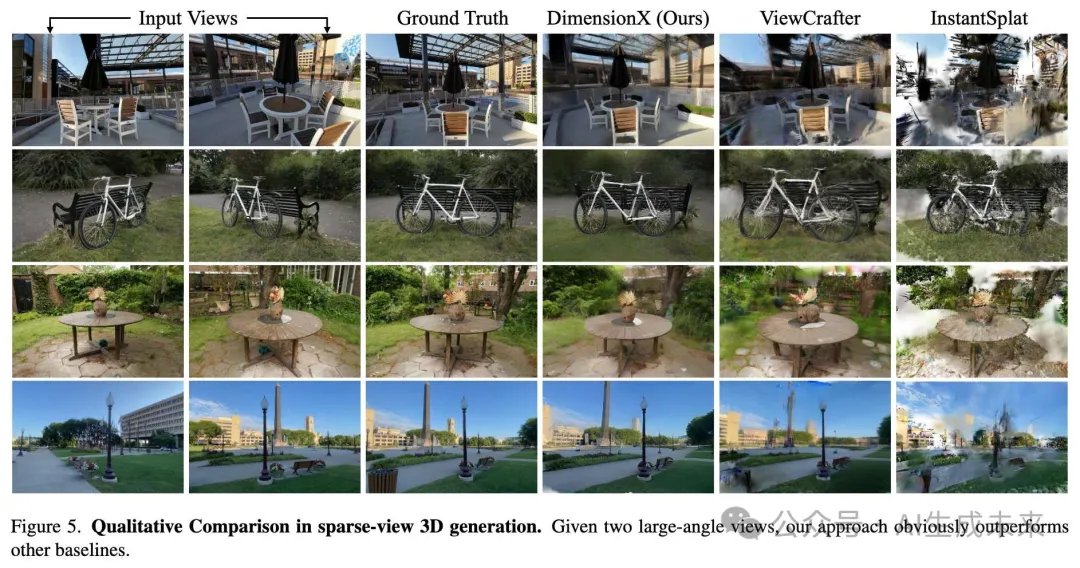

定量和定性比較。定量比較結果見下表1。DimensionX在所有指標上均優于基線,展示了本文方法的出色表現。如下圖5所示,在單視角(更多細節可見于附錄)和稀疏視角設置中,本文的方法能夠重建高質量的3D場景,而其他基線無法處理具有挑戰性的案例。

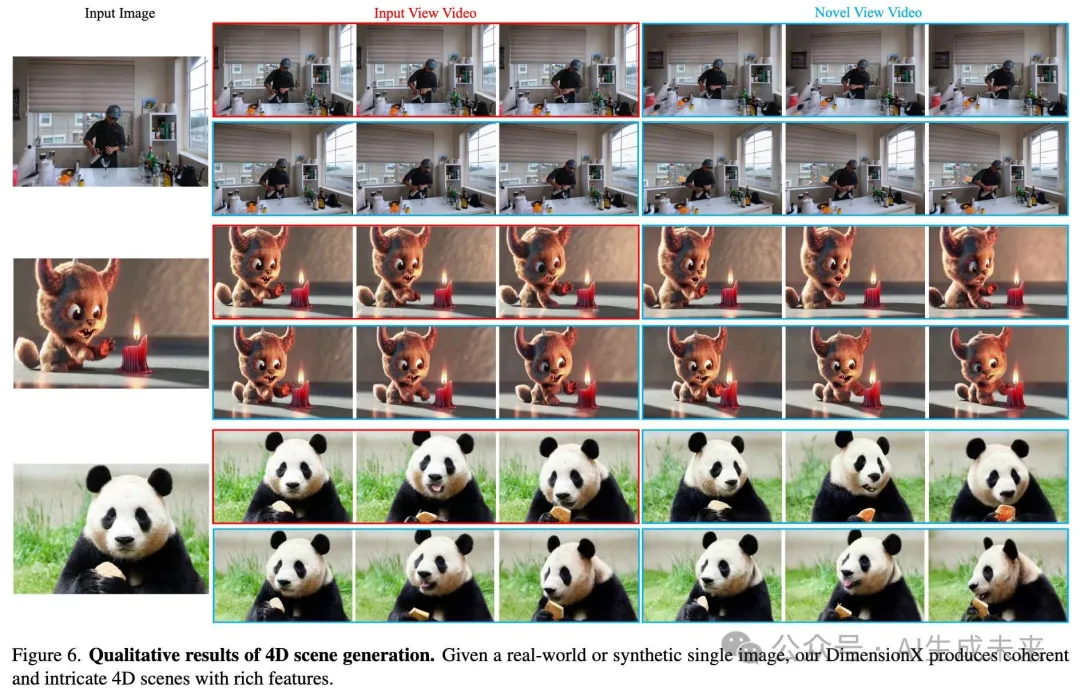

4D場景生成

在真實世界和合成數據集上評估了DimensionX。具體來說,采用了Neu3D ,該數據集包含不同場景的高分辨率多視角視頻,以驗證本文方法在真實世界視頻到4D生成的表現。如下圖6所示,給定一張單一圖像,DimensionX能夠從大角度新視角生成高度一致的動態視頻。

消融實驗

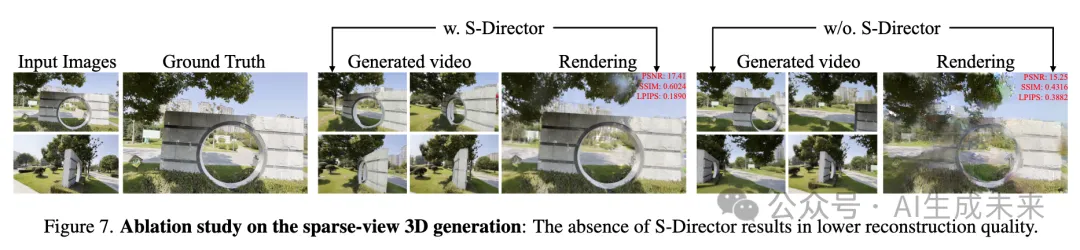

3D生成的軌跡感知機制。在稀疏視角的3D生成中,利用S-Director來指導視頻插值模型。如下圖7所示,在處理大角度稀疏視角時,缺乏S-Director通常會導致“賈努斯問題”,即生成多個頭部,從而顯著降低重建質量。

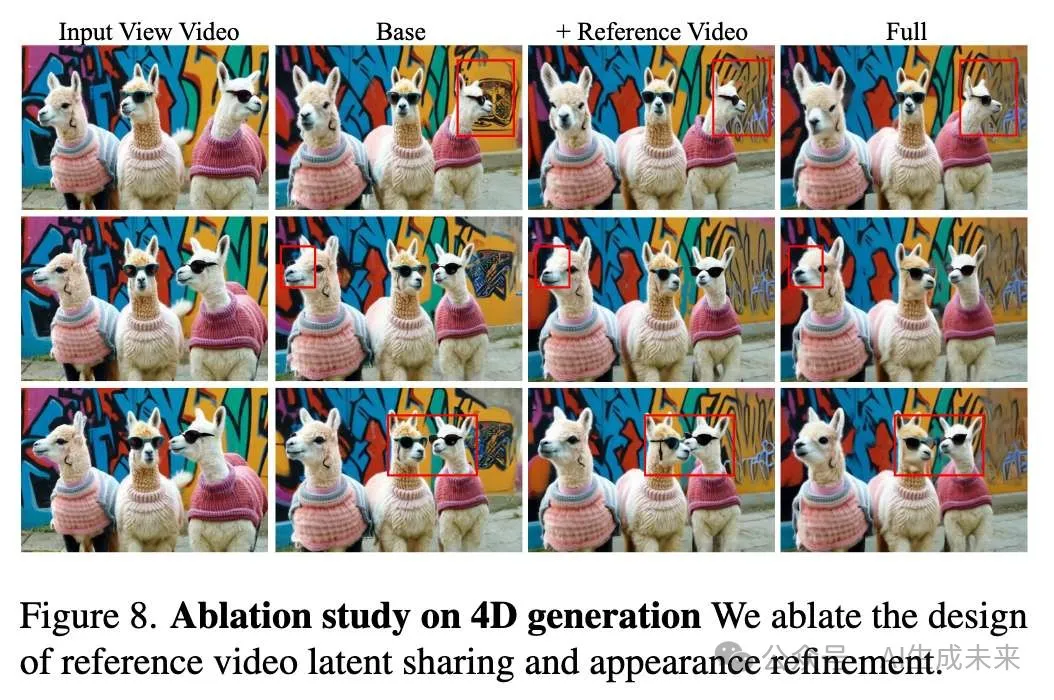

4D生成的身份保持去噪策略。在4D場景生成中,在真實世界圖像上進行實驗,分析我們在4D場景生成中的身份保持去噪策略。如下圖8所示,對參考視頻潛在共享和外觀精細化的設計進行了消融實驗,具體分析了新視角中不同幀之間的一致性。可以觀察到,直接將每幀視頻組合在一起會導致嚴重的不一致性,包括背景和主題形狀。通過參考視頻潛在共享,全球背景和外觀在不同幀之間表現出高度一致性。在參考視頻潛在共享的基礎上,外觀精細化增強了外觀細節的一致性。

結論

本文介紹了DimensionX框架,能夠僅從單張圖像生成具有可控視頻擴散的逼真3D和4D場景。核心思路是引入ST-Director,通過學習基于維度變化的數據集上的維度感知LoRA,解耦視頻擴散模型中的空間和時間先驗。還研究了視頻擴散的去噪過程,并引入了一種無需調優的維度感知組合方法,實現了混合維度控制。通過可控的視頻擴散,能夠從順序生成的視頻幀中恢復準確的3D結構和4D動態。為了進一步增強DimensionX在真實場景中的泛化能力,為3D場景生成量身定制了軌跡感知策略,為4D場景生成設計了身份感知機制。通過在各種真實世界和合成數據集上的廣泛實驗,證明了本文的方法在可控視頻生成以及3D和4D場景生成方面達到了最先進的性能。

本文轉自AI生成未來 ,作者:AI生成未來

原文鏈接:??https://mp.weixin.qq.com/s/lwj239Obzisp3MDl2gaplA??