谷歌與學(xué)術(shù)界聯(lián)手,研究突破多智能體合作瓶頸的新算法

在人類的合作中,我們可能會(huì)遇到囚徒困境(Social Dilemmas)、悲劇的共有(Tragedy of the Commons)、公平分配問(wèn)題(Public Goods Game)、獵人與收集者困境(Stag Hunt Game)、和合作網(wǎng)絡(luò)(Networked Cooperation)等諸多社會(huì)性合作困境,比如兩個(gè)人必須決定是否與對(duì)方合作(相互協(xié)力)或是背叛(選擇個(gè)人利益)。合作可以帶來(lái)最大的集體收益,但個(gè)體背叛可能會(huì)導(dǎo)致更高的個(gè)人收益。這種情況下,我們需要在短期的個(gè)人利益和長(zhǎng)期的集體利益之間做出平衡。在群體合作的情境,我們必須決定是否向公共資源池中投入資源。投入資源的人可能會(huì)從公共資源池中獲得收益,但也存在不投入?yún)s享受收益的可能性。同樣,智能體作為智能代理在系統(tǒng)里進(jìn)行合作時(shí)也會(huì)遇到同樣的問(wèn)題,比如智能體通過(guò)網(wǎng)絡(luò)相互連接,合作的利益取決于網(wǎng)絡(luò)中的其他智能體的行為。這種設(shè)置中的智能體需要在本地合作和全局合作之間做出選擇。

研究者們已經(jīng)意識(shí)到,在多智能體系統(tǒng)中實(shí)現(xiàn)合作不僅能提升系統(tǒng)的整體性能,還可以提高智能體在復(fù)雜環(huán)境中的適應(yīng)能力。盡管如此,如何設(shè)計(jì)出能夠促使這些獨(dú)立智能體自愿合作的機(jī)制仍然是一個(gè)未解難題。

10 月 24日,來(lái)自以谷歌為首的聯(lián)合研究團(tuán)隊(duì)發(fā)表他們的最新研究《Multi-agent cooperation through learning-aware policy gradients》,他們提出通過(guò)學(xué)習(xí)感知策略梯度的方法來(lái)實(shí)現(xiàn)多智能體合作。這一研究的主要問(wèn)題是:在多智能體學(xué)習(xí)中,如何促使自利、獨(dú)立的智能體實(shí)現(xiàn)合作?傳統(tǒng)的獨(dú)立智能體優(yōu)化自身目標(biāo)的方式在一般和博弈中往往表現(xiàn)不佳,難以實(shí)現(xiàn)合作。為此研究團(tuán)隊(duì)提出了一種新的策略梯度算法,通過(guò)考慮其他智能體的學(xué)習(xí)動(dòng)態(tài),來(lái)實(shí)現(xiàn)智能體之間的合作。

他們的主要貢獻(xiàn)包括:

- 提出了一種新的無(wú)偏、高效的策略梯度算法,能夠在多智能體學(xué)習(xí)中實(shí)現(xiàn)合作。

- 利用序列模型,將智能體的行為基于長(zhǎng)觀測(cè)歷史進(jìn)行條件化,從而促進(jìn)智能體之間的合作。

- 在標(biāo)準(zhǔn)的社會(huì)困境中驗(yàn)證了該算法的有效性,展示了其在復(fù)雜環(huán)境中的出色表現(xiàn)。

- 提出了一個(gè)新的理論框架,解釋了在何種情況下和如何在自利的學(xué)習(xí)感知智能體之間產(chǎn)生合作。

研究團(tuán)隊(duì)由來(lái)自多個(gè)知名機(jī)構(gòu)的學(xué)者組成,包括Google Paradigms of Intelligence Team、Mila - Quebec AI Institute、Université de Montréal、McGill University以及CIFAR。Alexander Meulemans和Seijin Kobayashi在這項(xiàng)研究中做出了相等的貢獻(xiàn)。團(tuán)隊(duì)成員背景深厚,研究領(lǐng)域涵蓋人工智能、機(jī)器學(xué)習(xí)和多智能體系統(tǒng)等多個(gè)方面,體現(xiàn)了跨學(xué)科和跨國(guó)合作的特點(diǎn)。通過(guò)這種多元化的合作,研究團(tuán)隊(duì)成功地提出了能夠?qū)崿F(xiàn)多智能體合作的創(chuàng)新算法,對(duì)推動(dòng)多智能體學(xué)習(xí)領(lǐng)域的發(fā)展具有重要意義。

多智能體學(xué)習(xí)中的合作挑戰(zhàn)

在多智能體系統(tǒng)中,每個(gè)智能體都致力于優(yōu)化自己的回報(bào),這通常導(dǎo)致個(gè)體之間缺乏合作,產(chǎn)生次優(yōu)結(jié)果。這種現(xiàn)象在博弈論中被稱為社會(huì)困境,其中最著名的例子就是囚徒困境。在這種情況下,雖然合作能夠帶來(lái)最優(yōu)的集體回報(bào),但自利的個(gè)體由于擔(dān)心對(duì)方的背叛而傾向于選擇不合作,從而導(dǎo)致雙方都處于次優(yōu)狀態(tài)。

自利個(gè)體的合作難題在很多現(xiàn)實(shí)場(chǎng)景中得到體現(xiàn)。例如,自主駕駛車輛在共享道路時(shí)需要互相合作以避免交通事故,然而每輛車都可能選擇最優(yōu)的個(gè)人策略而忽視整體安全。類似地在網(wǎng)絡(luò)安全中,不同系統(tǒng)需要共享信息以防御共同的威脅,但由于擔(dān)心信息泄露,各系統(tǒng)往往選擇不合作,導(dǎo)致安全隱患加大。

現(xiàn)有的多智能體學(xué)習(xí)研究在應(yīng)對(duì)這一挑戰(zhàn)方面取得了一些進(jìn)展。傳統(tǒng)的方法主要集中在通過(guò)設(shè)計(jì)激勵(lì)機(jī)制和約束條件來(lái)促進(jìn)合作。然而這些方法往往依賴于預(yù)先設(shè)定的規(guī)則和模型,對(duì)于復(fù)雜動(dòng)態(tài)的實(shí)際環(huán)境表現(xiàn)出局限性。近年來(lái),學(xué)習(xí)感知策略逐漸成為解決多智能體合作問(wèn)題的一個(gè)重要方向。

一些研究提出了學(xué)習(xí)感知算法,通過(guò)讓智能體了解并預(yù)測(cè)其他智能體的學(xué)習(xí)動(dòng)態(tài),從而調(diào)整自己的策略來(lái)促進(jìn)合作。這些方法在某些任務(wù)中展示了令人鼓舞的效果,證明了學(xué)習(xí)感知在多智能體合作中的潛力。然而這些方法大多依賴于高階導(dǎo)數(shù)的計(jì)算,計(jì)算復(fù)雜度較高,且在面對(duì)不確定和噪聲較大的環(huán)境時(shí),表現(xiàn)不夠穩(wěn)定。

盡管取得了一些進(jìn)展,現(xiàn)有方法在多個(gè)方面仍然存在不足。例如,許多方法依賴于智能體之間的信息共享,這在分布式系統(tǒng)或隱私敏感場(chǎng)景中難以實(shí)現(xiàn)。此外這些方法在處理大規(guī)模、多樣化的智能體群體時(shí),計(jì)算效率和穩(wěn)定性尚待提高。因此,提出一種高效、穩(wěn)定且適用于復(fù)雜環(huán)境的多智能體合作學(xué)習(xí)算法,依然是一個(gè)亟待解決的重要問(wèn)題。

背景和問(wèn)題設(shè)置

在多智能體學(xué)習(xí)中,智能體通常在部分可觀察隨機(jī)游戲(POSGs)的框架內(nèi)進(jìn)行交互。POSGs是一種由Kuhn于1953年提出的模型,定義為一個(gè)包含多個(gè)智能體的系統(tǒng),其中每個(gè)智能體只能獲得部分狀態(tài)信息。POSGs的重要性在于它能夠模擬現(xiàn)實(shí)世界中的復(fù)雜場(chǎng)景,如自動(dòng)駕駛、機(jī)器人協(xié)作和分布式控制系統(tǒng)。每個(gè)智能體在POSGs中都面臨不完全信息的挑戰(zhàn),這增加了決策和學(xué)習(xí)的難度。

在一般和博弈中,智能體不僅要最大化自己的回報(bào),還要考慮其他智能體的策略。這個(gè)過(guò)程中面臨兩個(gè)主要難題:非靜態(tài)環(huán)境和均衡選擇。非靜態(tài)環(huán)境意味著其他智能體也在同時(shí)學(xué)習(xí)和適應(yīng),這使得環(huán)境從單個(gè)智能體的視角來(lái)看是不斷變化的。均衡選擇問(wèn)題則源于多個(gè)納什均衡的存在,尤其在復(fù)雜的POSGs中,某些均衡可能非常次優(yōu),導(dǎo)致整體表現(xiàn)不佳。例如,在無(wú)限重復(fù)的囚徒困境中,完全背叛和合作策略都可以成為納什均衡,但前者會(huì)導(dǎo)致較低的整體回報(bào)。

為了應(yīng)對(duì)這些挑戰(zhàn),引入同伴學(xué)習(xí)意識(shí)成為一種有效的方法。學(xué)習(xí)意識(shí)的關(guān)鍵在于智能體能夠理解和預(yù)測(cè)其他智能體的學(xué)習(xí)動(dòng)態(tài),并基于這種理解來(lái)調(diào)整自己的策略。這不僅能幫助智能體在非靜態(tài)環(huán)境中做出更好的決策,還能促使智能體在多個(gè)均衡中選擇更優(yōu)的均衡,從而提高整體合作水平。

通過(guò)引入同伴學(xué)習(xí)意識(shí),智能體不僅能在復(fù)雜環(huán)境中更好地適應(yīng),還能在一般和博弈中實(shí)現(xiàn)有效合作。這一方法的核心在于智能體通過(guò)建模和學(xué)習(xí)其他智能體的行為動(dòng)態(tài),從而在決策過(guò)程中充分考慮他人的反應(yīng)和變化,最終實(shí)現(xiàn)自利智能體之間的合作。研究表明,這種方法在提高多智能體系統(tǒng)的整體表現(xiàn)方面具有顯著優(yōu)勢(shì)。

同伴塑造與序列模型

在多智能體系統(tǒng)中,如何塑造其他智能體的學(xué)習(xí)行為以實(shí)現(xiàn)合作是一個(gè)重要的研究課題。研究團(tuán)隊(duì)提出了一種同伴塑造的元游戲,通過(guò)在多智能體部分可觀察馬爾可夫決策過(guò)程(POMDP)中增加一個(gè)元層次變量,來(lái)表示每個(gè)智能體使用的學(xué)習(xí)算法。這個(gè)元游戲的目標(biāo)是讓一個(gè)元智能體通過(guò)學(xué)習(xí)感知來(lái)塑造天真的共同玩家的行為,從而實(shí)現(xiàn)合作。這一元游戲被形式化為單智能體POMDP,元狀態(tài)包括所有共同玩家的策略參數(shù)和智能體自身的參數(shù),元環(huán)境動(dòng)態(tài)則表示共同玩家的固定學(xué)習(xí)規(guī)則。

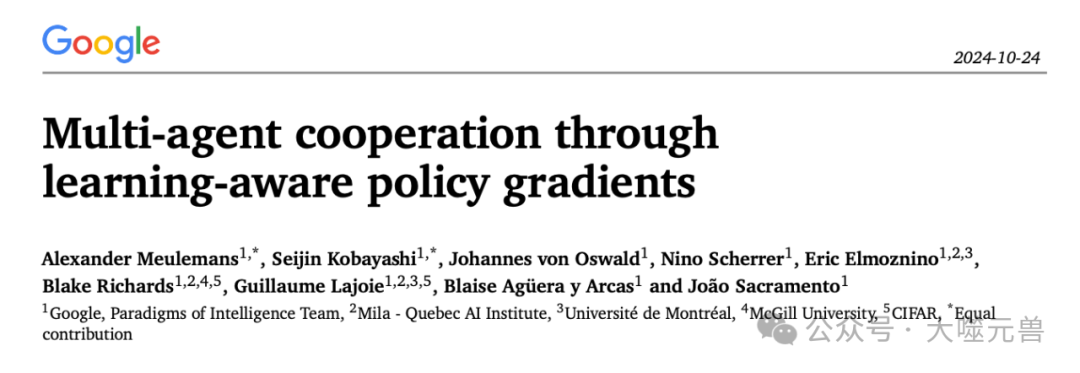

圖1|A.經(jīng)驗(yàn)數(shù)據(jù)術(shù)語(yǔ)。內(nèi)部情節(jié)包括(內(nèi)部)游戲的??步驟,在代理人之間并行進(jìn)行??次,形成一批內(nèi)部情節(jié)。一個(gè)給定的內(nèi)部情節(jié)序列形成了一個(gè)元軌跡,因此包括內(nèi)部游戲的步驟。??元軌跡的集合形成了一個(gè)元情節(jié)。B.在游戲過(guò)程中,一個(gè)天真的代理人只考慮當(dāng)前的情節(jié)背景來(lái)做出決策。相比之下,元代理會(huì)考慮完整的長(zhǎng)上下文。觀看多集游戲會(huì)賦予元代理學(xué)習(xí)意識(shí)。

為了實(shí)現(xiàn)這一目標(biāo),研究團(tuán)隊(duì)提出了將內(nèi)層和元策略結(jié)合在一個(gè)長(zhǎng)上下文策略中的方法。通過(guò)基于多個(gè)內(nèi)層游戲的長(zhǎng)觀測(cè)歷史來(lái)決定動(dòng)作,智能體能夠更好地理解和預(yù)測(cè)其他智能體的學(xué)習(xí)動(dòng)態(tài)。具體來(lái)說(shuō),研究團(tuán)隊(duì)定義了一種批量同伴塑造POMDP,包含多個(gè)并行軌跡的環(huán)境動(dòng)態(tài)和批量長(zhǎng)歷史觀測(cè)。這種設(shè)置允許智能體在多個(gè)內(nèi)層游戲中觀察共同玩家的學(xué)習(xí)行為,并通過(guò)這種觀察調(diào)整自己的策略,以實(shí)現(xiàn)更優(yōu)的合作。

批量同伴塑造POMDP的定義是關(guān)鍵。它包含多個(gè)并行運(yùn)行的內(nèi)層游戲,每個(gè)游戲都有自己的環(huán)境狀態(tài)和共同玩家策略參數(shù)。這些環(huán)境動(dòng)態(tài)模擬了多個(gè)并行的環(huán)境,并在每個(gè)內(nèi)層游戲邊界更新共同玩家的策略參數(shù)。初始狀態(tài)分布初始化了共同玩家的策略,并為第一個(gè)內(nèi)層游戲批次初始化環(huán)境。然后通過(guò)一個(gè)長(zhǎng)上下文策略,智能體可以在長(zhǎng)時(shí)間范圍內(nèi)基于批量長(zhǎng)歷史觀測(cè)進(jìn)行決策,從而更有效地塑造共同玩家的行為。

通過(guò)這種批量同伴塑造POMDP設(shè)置,作者提出了一種高效的策略梯度同伴塑造算法。這種算法能夠在不依賴高階導(dǎo)數(shù)的情況下,通過(guò)測(cè)量策略更新對(duì)批量?jī)?nèi)層游戲歷史分布的影響來(lái)估計(jì)策略梯度,從而實(shí)現(xiàn)多智能體系統(tǒng)中的合作。

COALA-PG算法的策略梯度

為了實(shí)現(xiàn)多智能體系統(tǒng)中的有效合作,研究團(tuán)隊(duì)提出了COALA-PG (Co-agent Learning-Aware Policy Gradients) 算法。這是一種新的策略梯度算法,旨在通過(guò)考慮其他智能體的學(xué)習(xí)動(dòng)態(tài),來(lái)實(shí)現(xiàn)智能體之間的合作。

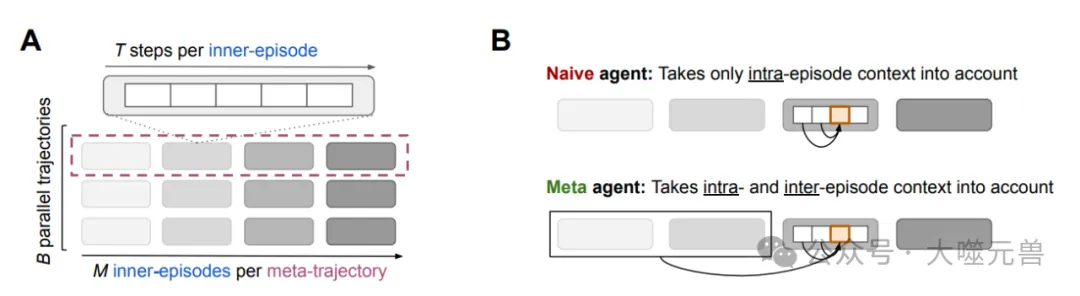

圖2|天真代理和元代理的策略更新和信用分配。一個(gè)天真的代理(左)只考慮事件內(nèi)的上下文。COALA代理(右)考慮了批處理維度上的事件間上下文。對(duì)于策略更新,天真代理聚合內(nèi)部批處理維度(虛線塊)上的策略梯度,并在事件邊界之間更新其策略。相比之下,COALA代理在元事件維度上以較低的頻率更新他們的策略。

COALA-PG的提出源自對(duì)多智能體學(xué)習(xí)中的核心挑戰(zhàn)的深入理解。傳統(tǒng)的策略梯度方法在處理多智能體系統(tǒng)時(shí),往往忽略了其他智能體也在同時(shí)學(xué)習(xí)這一事實(shí),導(dǎo)致環(huán)境對(duì)單個(gè)智能體而言是非靜態(tài)的。COALA-PG通過(guò)在策略更新中引入對(duì)其他智能體學(xué)習(xí)行為的建模和預(yù)測(cè),克服了這一問(wèn)題。

在與現(xiàn)有方法的比較中,COALA-PG展現(xiàn)了明顯的優(yōu)勢(shì)。例如,LOLA-DICE是現(xiàn)有的一種方法,雖然它考慮了對(duì)手的學(xué)習(xí)動(dòng)態(tài),但需要計(jì)算高階導(dǎo)數(shù),這增加了計(jì)算復(fù)雜度和不穩(wěn)定性。相比之下,COALA-PG采用了一種無(wú)偏的梯度估計(jì)方法,不需要高階導(dǎo)數(shù)計(jì)算,因而更加高效和穩(wěn)定。此外,COALA-PG能夠處理小批量的內(nèi)層策略歷史,從而在多智能體系統(tǒng)中實(shí)現(xiàn)更加精確的策略優(yōu)化。

COALA-PG在元強(qiáng)化學(xué)習(xí)中的優(yōu)勢(shì)主要體現(xiàn)在以下幾個(gè)方面。

高效性:通過(guò)引入長(zhǎng)上下文策略,COALA-PG能夠在大規(guī)模、多樣化的智能體群體中高效運(yùn)行,顯著提高了策略更新的速度和準(zhǔn)確性。

穩(wěn)定性:由于采用無(wú)偏的梯度估計(jì)方法,COALA-PG在面對(duì)不確定和噪聲較大的環(huán)境時(shí),表現(xiàn)出較高的穩(wěn)定性,避免了高階導(dǎo)數(shù)方法中的數(shù)值不穩(wěn)定問(wèn)題。

適用性:COALA-PG能夠靈活地適用于各種復(fù)雜環(huán)境,包括標(biāo)準(zhǔn)的社會(huì)困境和需要時(shí)間擴(kuò)展動(dòng)作協(xié)調(diào)的環(huán)境,這在傳統(tǒng)方法中是難以實(shí)現(xiàn)的。

通過(guò)COALA-PG算法,研究團(tuán)隊(duì)在實(shí)現(xiàn)多智能體合作方面取得了重要突破。該算法不僅克服了傳統(tǒng)方法的計(jì)算復(fù)雜度和不穩(wěn)定性問(wèn)題,還通過(guò)引入對(duì)其他智能體學(xué)習(xí)行為的建模,提高了策略更新的精度和效率。

學(xué)習(xí)意識(shí)在一般和博弈中的重要性

在多智能體系統(tǒng)中,學(xué)習(xí)意識(shí)指的是智能體能夠理解和預(yù)測(cè)其他智能體的學(xué)習(xí)動(dòng)態(tài),并基于這種理解調(diào)整自己的策略。這在解決一般和博弈中的合作問(wèn)題時(shí)顯得尤為重要。研究團(tuán)隊(duì)通過(guò)分析學(xué)習(xí)意識(shí)在重復(fù)囚徒困境中的表現(xiàn),揭示了其促成合作的機(jī)制。

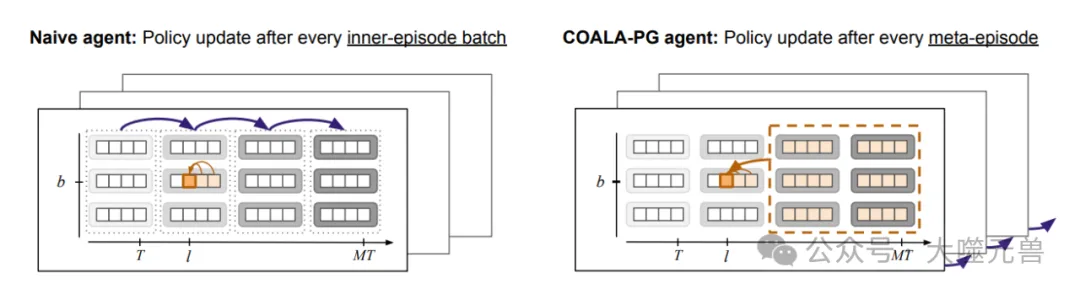

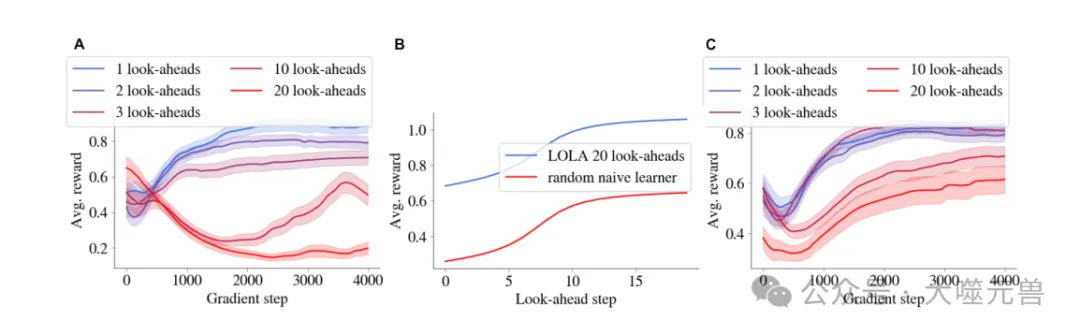

圖3|(A)具有學(xué)習(xí)意識(shí)的代理學(xué)會(huì)勒索天真的學(xué)習(xí)者,即使在用純叛逃策略初始化時(shí)也是如此。(B) 針對(duì)天真智能體(陰影區(qū)域期)制定的勒索策略在與另一個(gè)學(xué)習(xí)感知智能體(M1和M2)對(duì)抗時(shí)變成了合作策略。(C) 合作出現(xiàn)在天真和學(xué)習(xí)意識(shí)代理的混合訓(xùn)練池中,但不僅僅出現(xiàn)在學(xué)習(xí)意識(shí)代理池中。陰影區(qū)域表示32個(gè)隨機(jī)種子的四分位數(shù)間距(第25至75分位數(shù))。

重復(fù)囚徒困境中的合作現(xiàn)象

重復(fù)囚徒困境是一個(gè)經(jīng)典的社會(huì)困境模型,用于研究自利智能體之間的合作問(wèn)題。在這個(gè)游戲中,兩個(gè)玩家在每一輪選擇合作或背叛,累積的獎(jiǎng)勵(lì)取決于雙方的選擇。若雙方都合作,獲得的回報(bào)最高;若一方背叛而另一方合作,背叛者獲益更多;若雙方都背叛,收益最低。在無(wú)限重復(fù)的囚徒困境中,盡管存在合作的納什均衡,但自利的個(gè)體往往難以穩(wěn)定地達(dá)到這一狀態(tài)。

圖4|(A)由LOLA訓(xùn)練的兩個(gè)代理在具有各種前瞻步驟的分析梯度的迭代囚徒困境中的性能(僅顯示了第一個(gè)代理的性能)。(B) 根據(jù)(a)訓(xùn)練結(jié)束時(shí)的固定LOLA 20外觀策略訓(xùn)練的隨機(jī)初始化幼稚學(xué)習(xí)者的表現(xiàn)。(C) 設(shè)置與(A)相同,但具有初始梯度???????????????(??, ?????)添加到LOLA更新中,帶有??超參數(shù)。陰影區(qū)域表示在64個(gè)種子上計(jì)算的標(biāo)準(zhǔn)誤差。

研究團(tuán)隊(duì)通過(guò)實(shí)驗(yàn)表明,學(xué)習(xí)感知智能體能夠在重復(fù)囚徒困境中逐漸發(fā)展出合作策略。這些智能體通過(guò)預(yù)測(cè)對(duì)手的學(xué)習(xí)行為,調(diào)整自己的策略,從而在長(zhǎng)期博弈中實(shí)現(xiàn)互惠合作。

學(xué)習(xí)意識(shí)如何促成合作

研究發(fā)現(xiàn),學(xué)習(xí)感知智能體通過(guò)兩種主要機(jī)制實(shí)現(xiàn)合作。首先,這些智能體能夠觀察到自己的行動(dòng)如何影響對(duì)手的未來(lái)行為。這種觀察為智能體提供了從背叛轉(zhuǎn)向勒索的塑造梯度。其次,當(dāng)兩個(gè)學(xué)習(xí)感知智能體相遇時(shí),勒索策略會(huì)逐漸轉(zhuǎn)變?yōu)楹献鞑呗浴_@是因?yàn)樵讵?dú)立學(xué)習(xí)的情況下,勒索策略會(huì)促使對(duì)手更多地合作。

研究發(fā)現(xiàn),當(dāng)學(xué)習(xí)感知智能體與天真學(xué)習(xí)者對(duì)戰(zhàn)時(shí),前者會(huì)發(fā)展出勒索策略,迫使天真學(xué)習(xí)者進(jìn)行不公平的合作。然而,當(dāng)兩個(gè)學(xué)習(xí)感知智能體相遇時(shí),他們會(huì)逐漸發(fā)展出合作策略,從而實(shí)現(xiàn)互惠合作。這一現(xiàn)象不僅在對(duì)手之間有效,即使在自我博弈(self-play)的情況下也能觀察到。

解釋LOLA中的合作機(jī)制

LOLA(Learning with Opponent-Learning Awareness)是學(xué)習(xí)感知領(lǐng)域的先驅(qū)工作,研究團(tuán)隊(duì)通過(guò)COALA-PG算法提供了新的解釋。LOLA算法通過(guò)預(yù)估對(duì)手的參數(shù)更新來(lái)計(jì)算總梯度,從而對(duì)天真學(xué)習(xí)者進(jìn)行策略塑造。研究團(tuán)隊(duì)提出了一種不需要高階導(dǎo)數(shù)的新型LOLA梯度估計(jì)器,能夠在不依賴高階導(dǎo)數(shù)的情況下,通過(guò)測(cè)量策略更新對(duì)批量?jī)?nèi)層游戲歷史分布的影響來(lái)估計(jì)策略梯度,從而實(shí)現(xiàn)多智能體系統(tǒng)中的合作。

通過(guò)COALA-PG算法的分析,研究表明,LOLA結(jié)合了影響對(duì)手未來(lái)行為的觀察和與其他勒索智能體對(duì)戰(zhàn)的機(jī)制,從而實(shí)現(xiàn)了學(xué)習(xí)感知智能體之間的合作。這一發(fā)現(xiàn)不僅解釋了LOLA算法中的合作機(jī)制,還展示了在復(fù)雜環(huán)境中實(shí)現(xiàn)多智能體合作的新途徑。

實(shí)驗(yàn)分析

為了驗(yàn)證COALA-PG算法的有效性,研究團(tuán)隊(duì)在多個(gè)實(shí)驗(yàn)中進(jìn)行了測(cè)試。實(shí)驗(yàn)主要集中在兩個(gè)方面:重復(fù)囚徒困境和CleanUp游戲。

COALA-PG在重復(fù)囚徒困境中的表現(xiàn)

在重復(fù)囚徒困境實(shí)驗(yàn)中,COALA-PG算法展現(xiàn)了其在促成合作方面的卓越表現(xiàn)。實(shí)驗(yàn)結(jié)果表明,當(dāng)COALA-PG訓(xùn)練的智能體與天真智能體對(duì)戰(zhàn)時(shí),COALA-PG智能體通過(guò)塑造對(duì)手的行為,使其趨向于合作,從而獲得了顯著更高的回報(bào)。這些智能體能夠成功地從最初的背叛逐步引導(dǎo)對(duì)手進(jìn)入合作狀態(tài),并在整個(gè)博弈過(guò)程中保持合作。這種行為不僅驗(yàn)證了COALA-PG算法在促進(jìn)多智能體合作中的有效性,還展示了其在處理復(fù)雜的博弈環(huán)境中的優(yōu)勢(shì)。

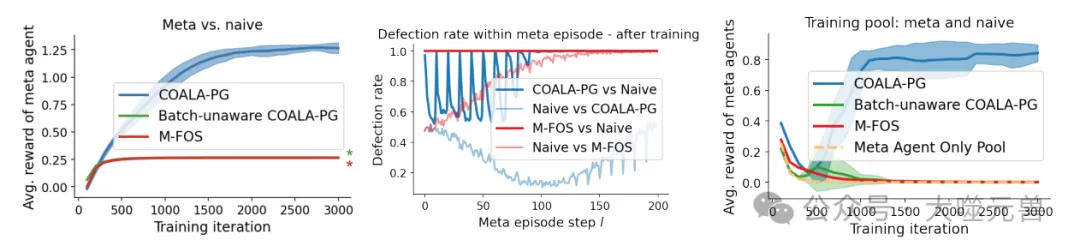

圖5|COALA-PG訓(xùn)練的特工玩迭代囚徒困境。左:當(dāng)僅針對(duì)天真特工進(jìn)行訓(xùn)練時(shí),COALA PG訓(xùn)練的特工會(huì)勒索后者,并獲得比其他基線特工高得多的獎(jiǎng)勵(lì)。星號(hào)(★)表示在中心點(diǎn)對(duì)應(yīng)顏色的重疊曲線:在分析一個(gè)元事件中代理的行為時(shí),我們觀察到COALA PG訓(xùn)練的代理塑造了天真的合作伙伴,導(dǎo)致開始時(shí)的低叛逃率,然后在最后被利用。另一方面,M-FOS從一開始就存在缺陷,獲得的回報(bào)較低,因此未能正確優(yōu)化成形問(wèn)題。不知道批次的COALA-PG與M-FOS的性能相同,因此被省略。當(dāng)訓(xùn)練一組元代理對(duì)抗幼稚和其他元代理的混合體時(shí),元代理與其他元代理對(duì)抗的平均性能。這些用COALA-PG訓(xùn)練的特工在相互對(duì)抗時(shí)會(huì)合作,但在用基線方法訓(xùn)練時(shí)卻無(wú)法合作。當(dāng)從池中刪除幼稚代理時(shí),元代理也無(wú)法合作,如第3節(jié)所預(yù)測(cè)的那樣。陰影區(qū)域表示在5個(gè)種子上計(jì)算的標(biāo)準(zhǔn)偏差。

在CleanUp游戲中的表現(xiàn)

除了在重復(fù)囚徒困境中的優(yōu)異表現(xiàn)外,COALA-PG算法在CleanUp游戲中也顯示出了顯著的優(yōu)勢(shì)。CleanUp游戲是一個(gè)模擬公共資源悲劇的復(fù)雜社會(huì)困境,玩家通過(guò)清理河流以減少污染,從而增加蘋果的生成率。COALA-PG訓(xùn)練的智能體在游戲中不僅能夠有效地平衡清理和收獲,還能夠通過(guò)塑造對(duì)手的行為,使其減少不必要的干擾(如電擊對(duì)手)和增加清理工作,從而整體上提高蘋果的生成率和最終回報(bào)。

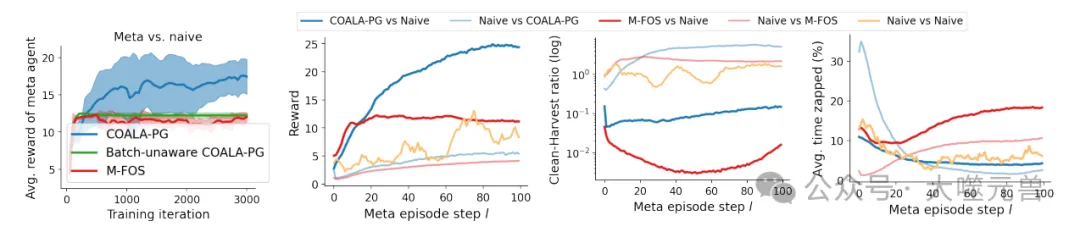

圖6|COALA-PG針對(duì)幼稚代理訓(xùn)練的代理僅在CleanUp中成功塑造了它們。左:與基線相比,COALA PG訓(xùn)練的特工可以更好地塑造天真的對(duì)手,獲得更高的回報(bào)。中左和中右和右:在訓(xùn)練后分析單個(gè)元事件中的行為表明,COALA的表現(xiàn)優(yōu)于基線,并塑造了天真的代理,(i)在整個(gè)事件中獲得了更高的整體獎(jiǎng)勵(lì),(ii)表現(xiàn)出更高的清潔收獲率,以及(iii)被攻擊的頻率更低。陰影區(qū)域表示在5個(gè)種子上計(jì)算的標(biāo)準(zhǔn)偏差。

實(shí)驗(yàn)結(jié)果顯示,COALA-PG智能體在與天真智能體混合的環(huán)境中能夠顯著提高合作水平,并在對(duì)抗其他學(xué)習(xí)感知智能體時(shí)維持高效合作。通過(guò)與基線方法的比較,研究發(fā)現(xiàn)COALA-PG算法在處理復(fù)雜環(huán)境和動(dòng)態(tài)對(duì)手方面表現(xiàn)優(yōu)越。

細(xì)化的行為分析與對(duì)比

為了深入理解COALA-PG算法的行為,研究團(tuán)隊(duì)對(duì)實(shí)驗(yàn)中的智能體行為進(jìn)行了細(xì)化分析。分析結(jié)果表明,COALA-PG訓(xùn)練的智能體在元回合中能夠成功地塑造天真對(duì)手,使其在清理和收獲之間找到更好的平衡,從而整體上降低了污染水平并提高了蘋果生成率。此外,COALA-PG智能體在與其他學(xué)習(xí)感知智能體的對(duì)戰(zhàn)中,也能夠通過(guò)減少電擊行為和增加清理工作,實(shí)現(xiàn)高效合作。

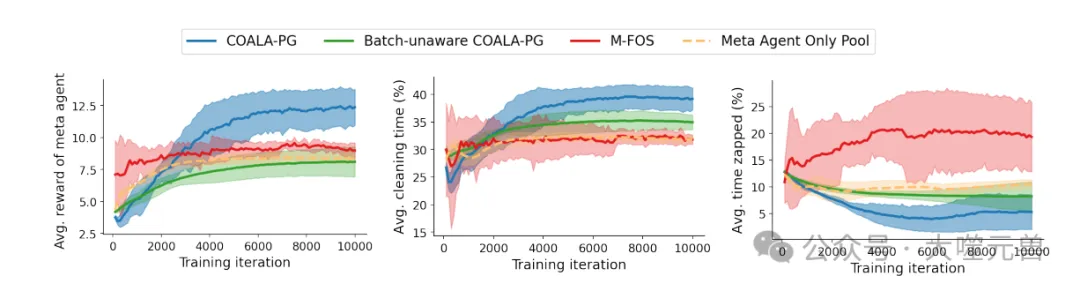

圖7|使用COALA-PG訓(xùn)練的代理,針對(duì)天真代理和其他元代理的混合體,學(xué)習(xí)在CleanUp lite中合作。左:經(jīng)過(guò)COALA PG訓(xùn)練的特工獲得的獎(jiǎng)勵(lì)高于基線特工。中右圖:COALA-PG通過(guò)更多的清潔和更低的去除率降低了污染,從而提高了蘋果產(chǎn)量。陰影區(qū)域表示在5個(gè)種子上計(jì)算的標(biāo)準(zhǔn)偏差。

實(shí)驗(yàn)發(fā)現(xiàn)COALA-PG智能體通過(guò)引導(dǎo)天真對(duì)手減少電擊行為,使整個(gè)博弈過(guò)程中的干擾減少,收獲效率提高。同時(shí)COALA-PG智能體自身也參與清理工作,進(jìn)一步降低污染水平,從而為所有智能體創(chuàng)造了一個(gè)更有利的博弈環(huán)境。這種互惠合作的行為模式,不僅驗(yàn)證了COALA-PG算法的有效性,還為多智能體合作提供了新的研究視角。

結(jié)論

研究團(tuán)隊(duì)通過(guò)深入研究和實(shí)驗(yàn)分析,展示了學(xué)習(xí)意識(shí)在多智能體合作中的關(guān)鍵作用。在多智能體系統(tǒng)中,自利個(gè)體之間的合作一直是一個(gè)挑戰(zhàn),而引入學(xué)習(xí)意識(shí),即智能體能夠理解和預(yù)測(cè)其他智能體的學(xué)習(xí)動(dòng)態(tài),成為解決這一問(wèn)題的重要途徑。

通過(guò)學(xué)習(xí)意識(shí),智能體不僅能夠在復(fù)雜的博弈環(huán)境中調(diào)整自己的策略,還能有效地塑造其他智能體的行為,從而在多個(gè)均衡中選擇最優(yōu)的合作策略。研究團(tuán)隊(duì)提出的COALA-PG(Co-agent Learning-Aware Policy Gradients)算法,正是基于這一理念,通過(guò)無(wú)偏的梯度估計(jì)方法,不需要高階導(dǎo)數(shù)計(jì)算,展現(xiàn)了顯著的性能優(yōu)勢(shì)。

COALA-PG方法的創(chuàng)新與優(yōu)勢(shì)

高效性和穩(wěn)定性:COALA-PG算法通過(guò)引入長(zhǎng)上下文策略,能夠在大規(guī)模、多樣化的智能體群體中高效運(yùn)行,顯著提高了策略更新的速度和準(zhǔn)確性。同時(shí),由于采用無(wú)偏的梯度估計(jì)方法,COALA-PG在面對(duì)不確定和噪聲較大的環(huán)境時(shí),表現(xiàn)出較高的穩(wěn)定性。

適用性:COALA-PG能夠靈活地適用于各種復(fù)雜環(huán)境,包括標(biāo)準(zhǔn)的社會(huì)困境和需要時(shí)間擴(kuò)展動(dòng)作協(xié)調(diào)的環(huán)境,這在傳統(tǒng)方法中是難以實(shí)現(xiàn)的。

合作機(jī)制:實(shí)驗(yàn)結(jié)果顯示,COALA-PG在模擬的重復(fù)囚徒困境和CleanUp游戲中,均能實(shí)現(xiàn)高效合作。這表明COALA-PG在實(shí)際應(yīng)用中具有廣泛的前景。

未來(lái)的研究方向和應(yīng)用前景

進(jìn)一步優(yōu)化算法:研究可以繼續(xù)優(yōu)化COALA-PG算法,提高其在更大規(guī)模和更復(fù)雜環(huán)境中的性能。

擴(kuò)展應(yīng)用領(lǐng)域:COALA-PG算法在自動(dòng)駕駛、分布式控制系統(tǒng)和網(wǎng)絡(luò)安全等多個(gè)領(lǐng)域都有潛在應(yīng)用,可以進(jìn)一步探索其實(shí)際應(yīng)用場(chǎng)景。

跨學(xué)科合作:通過(guò)與其他領(lǐng)域的合作,如心理學(xué)和行為科學(xué),進(jìn)一步理解和模擬多智能體系統(tǒng)中的合作機(jī)制。

總的來(lái)說(shuō),研究團(tuán)隊(duì)通過(guò)提出和驗(yàn)證COALA-PG算法,為多智能體合作研究提供了新的方向和可能性。學(xué)習(xí)意識(shí)在多智能體合作中的關(guān)鍵作用不可忽視,未來(lái)研究將繼續(xù)推動(dòng)這一領(lǐng)域的發(fā)展,探索更多創(chuàng)新應(yīng)用。(END)

參考資料:https://arxiv.org/pdf/2410.18636

本文轉(zhuǎn)載自??大噬元獸??,作者: FlerkenS ????